✨作者主页 :IT研究室✨

个人简介:曾从事计算机专业培训教学,擅长Java、Python、微信小程序、Golang、安卓Android等项目实战。接项目定制开发、代码讲解、答辩教学、文档编写、降重等。

文章目录

一、前言

系统介绍

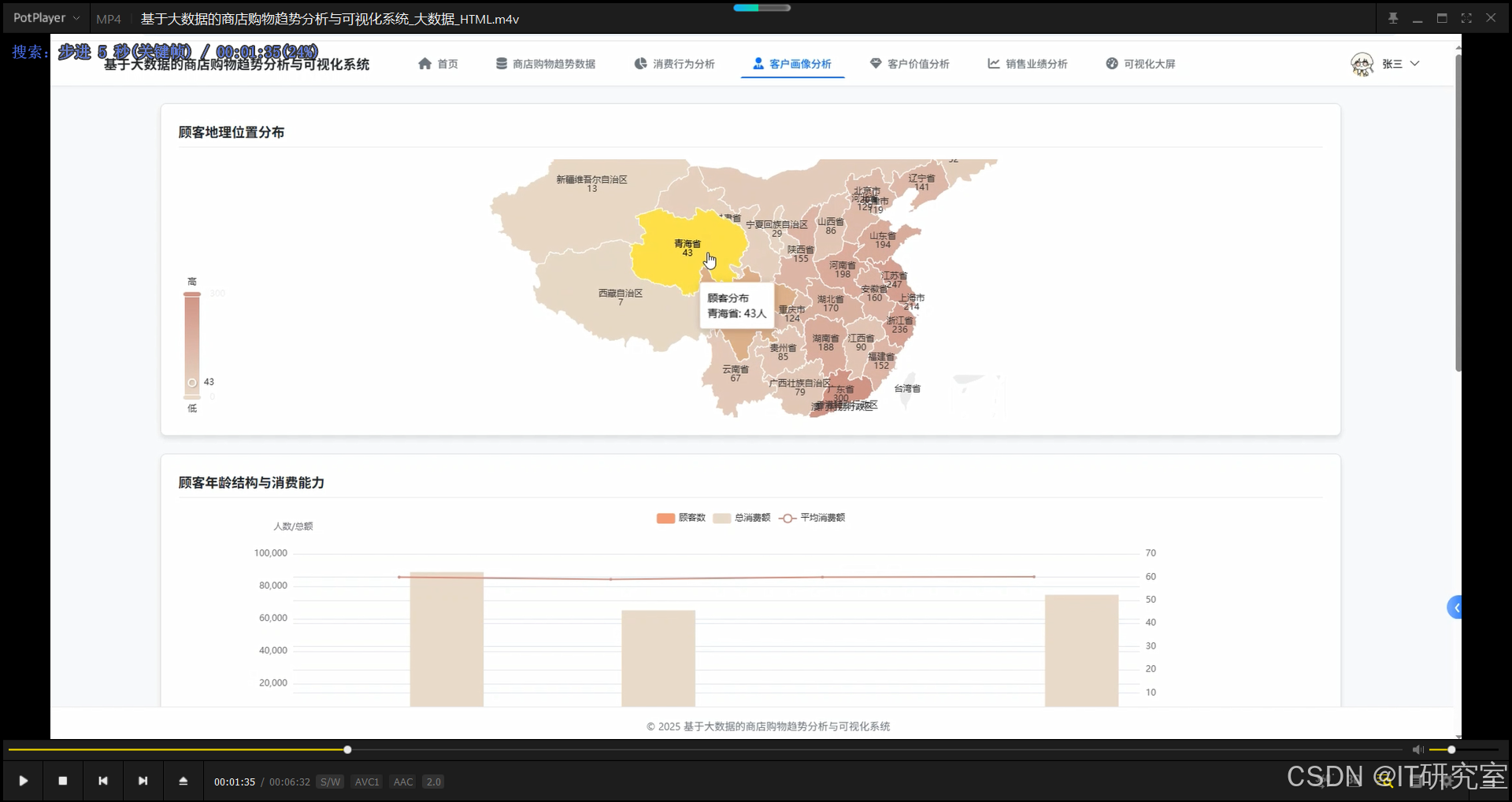

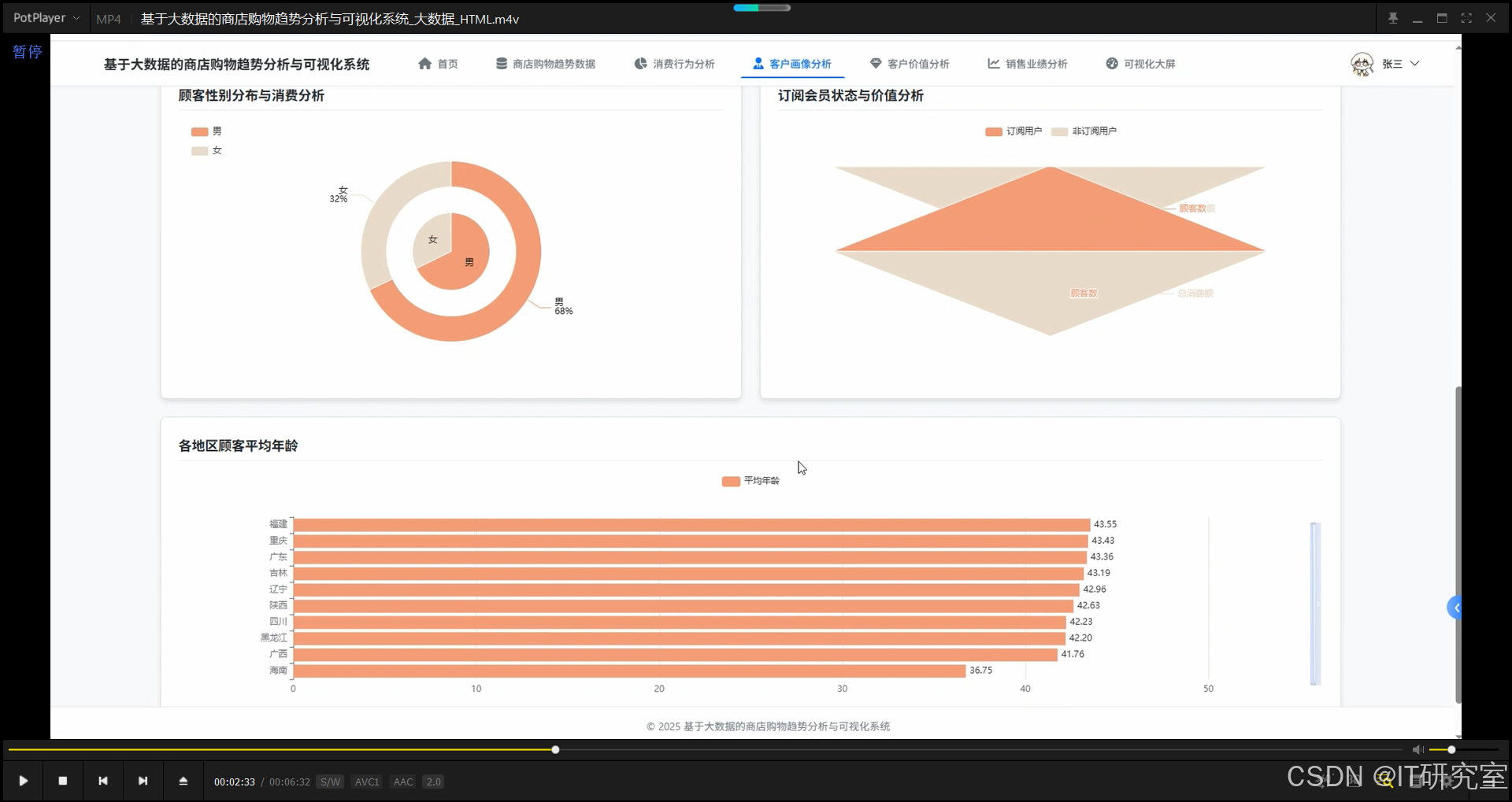

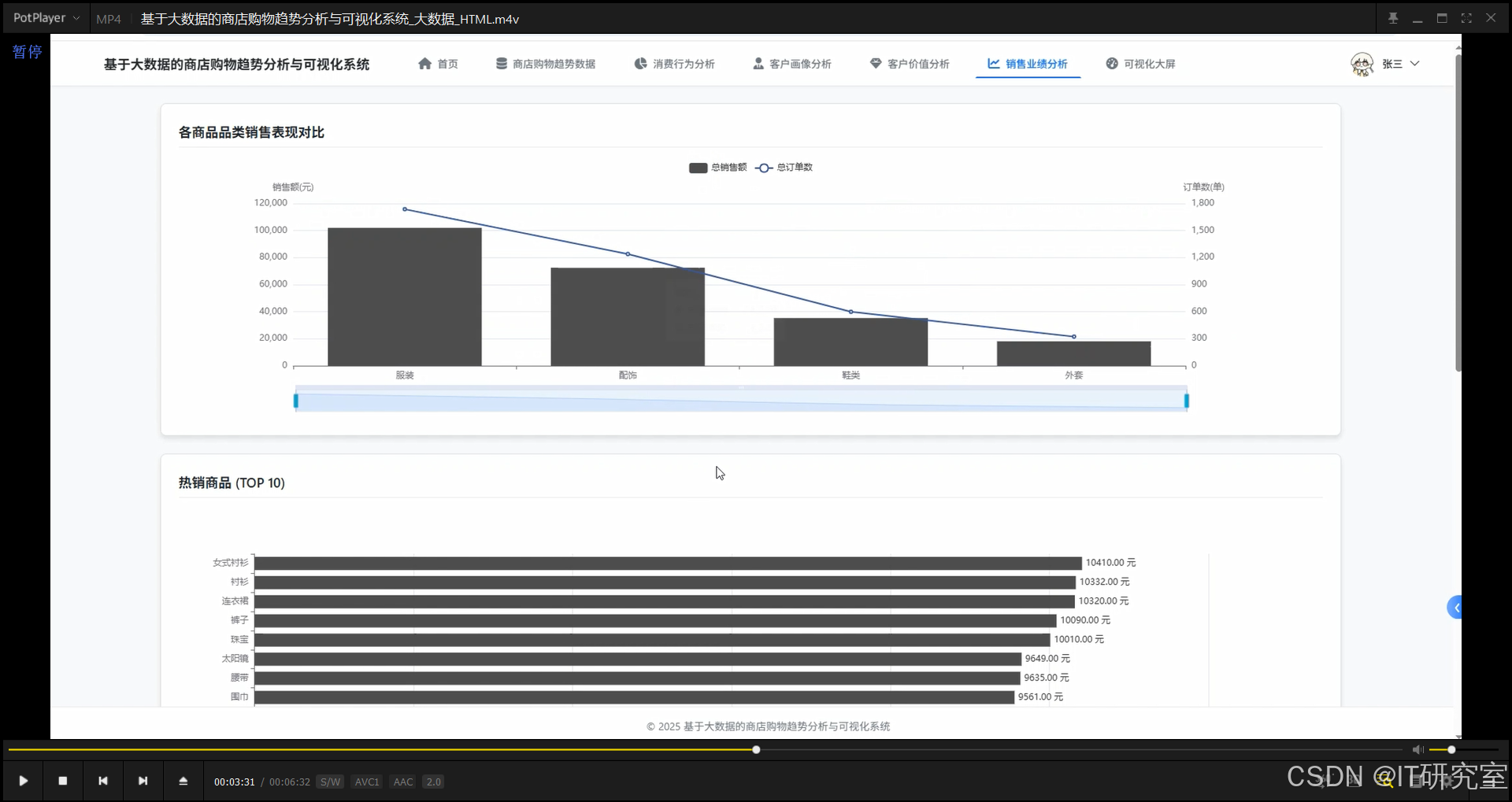

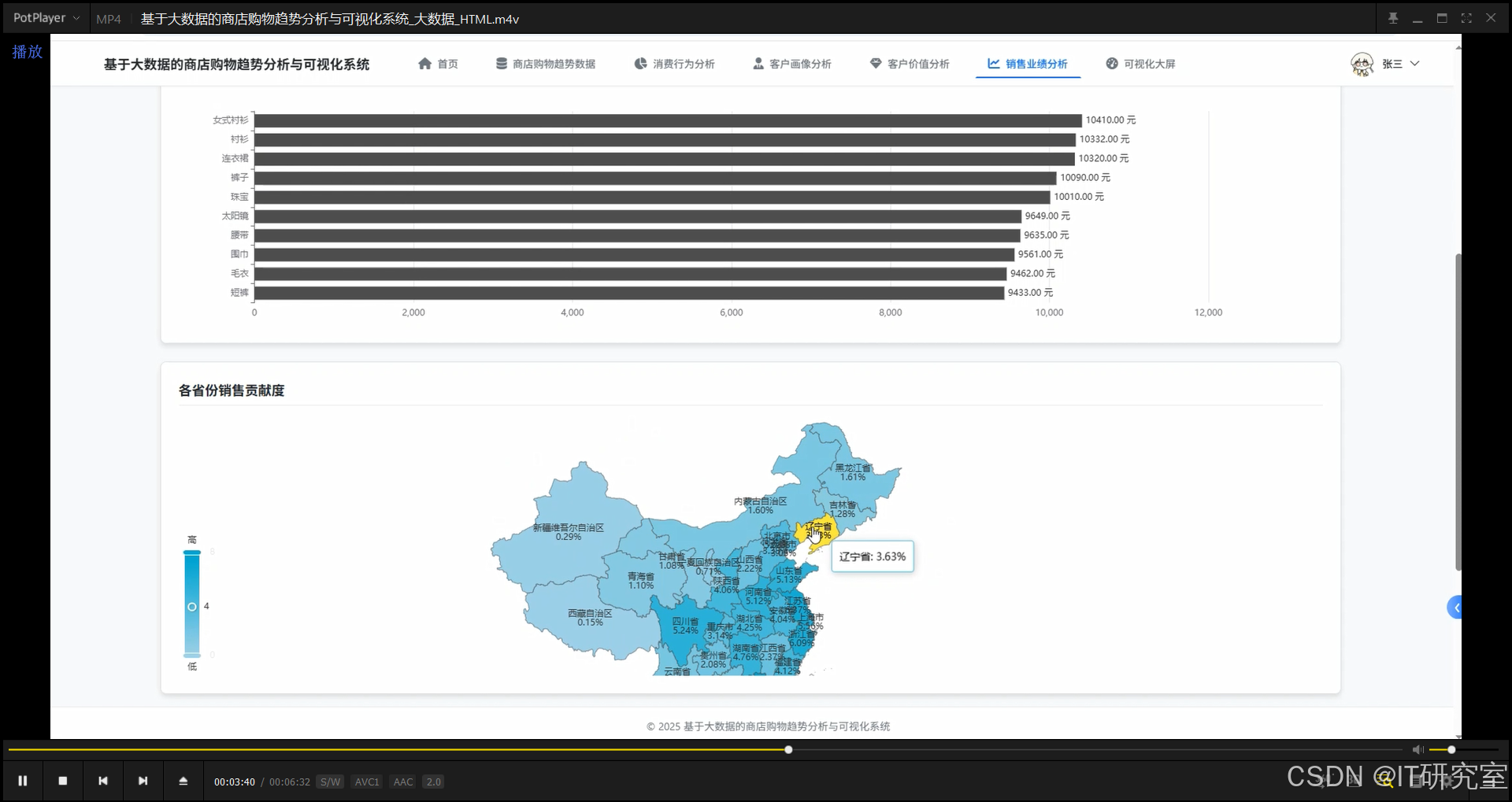

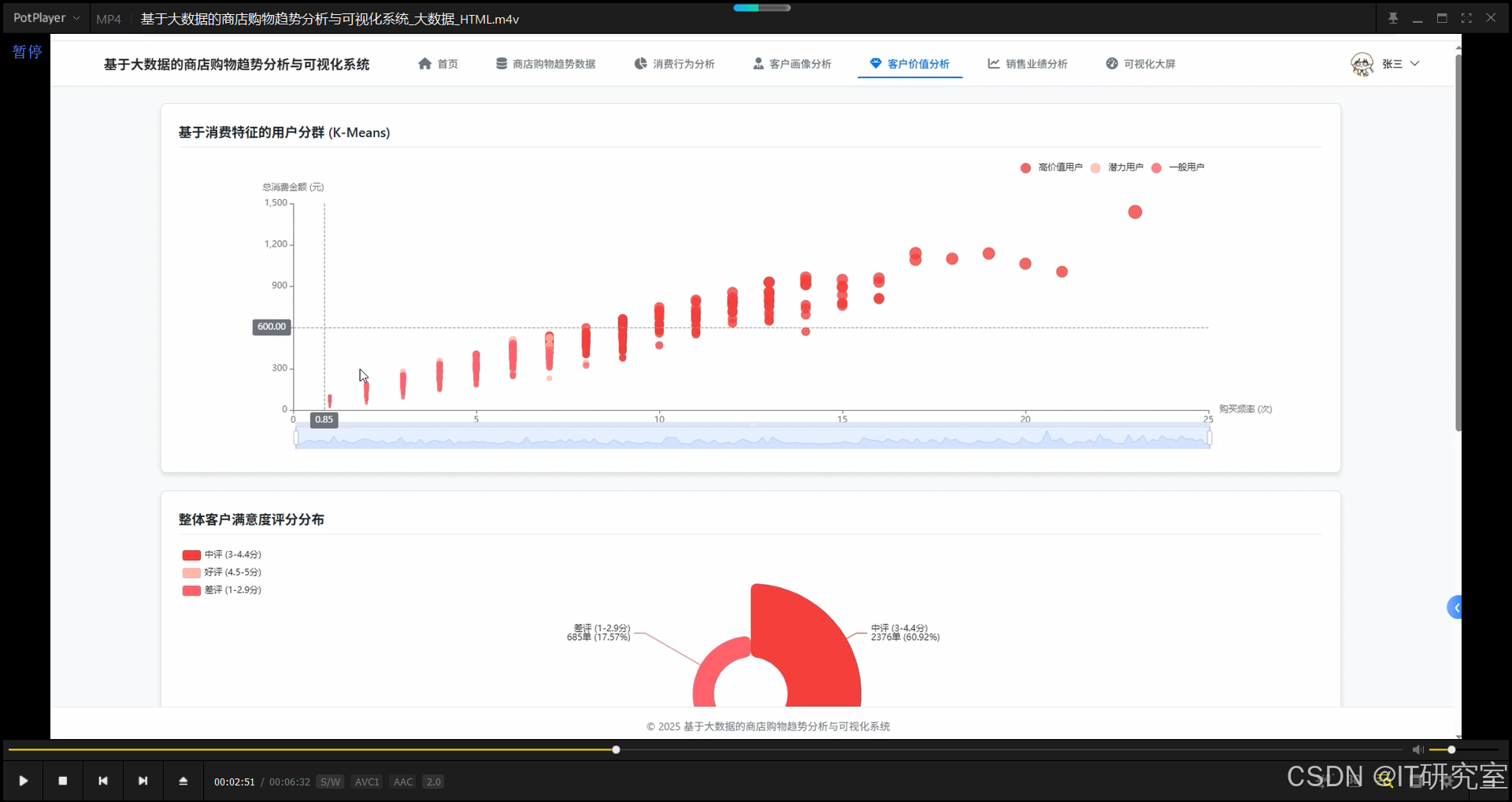

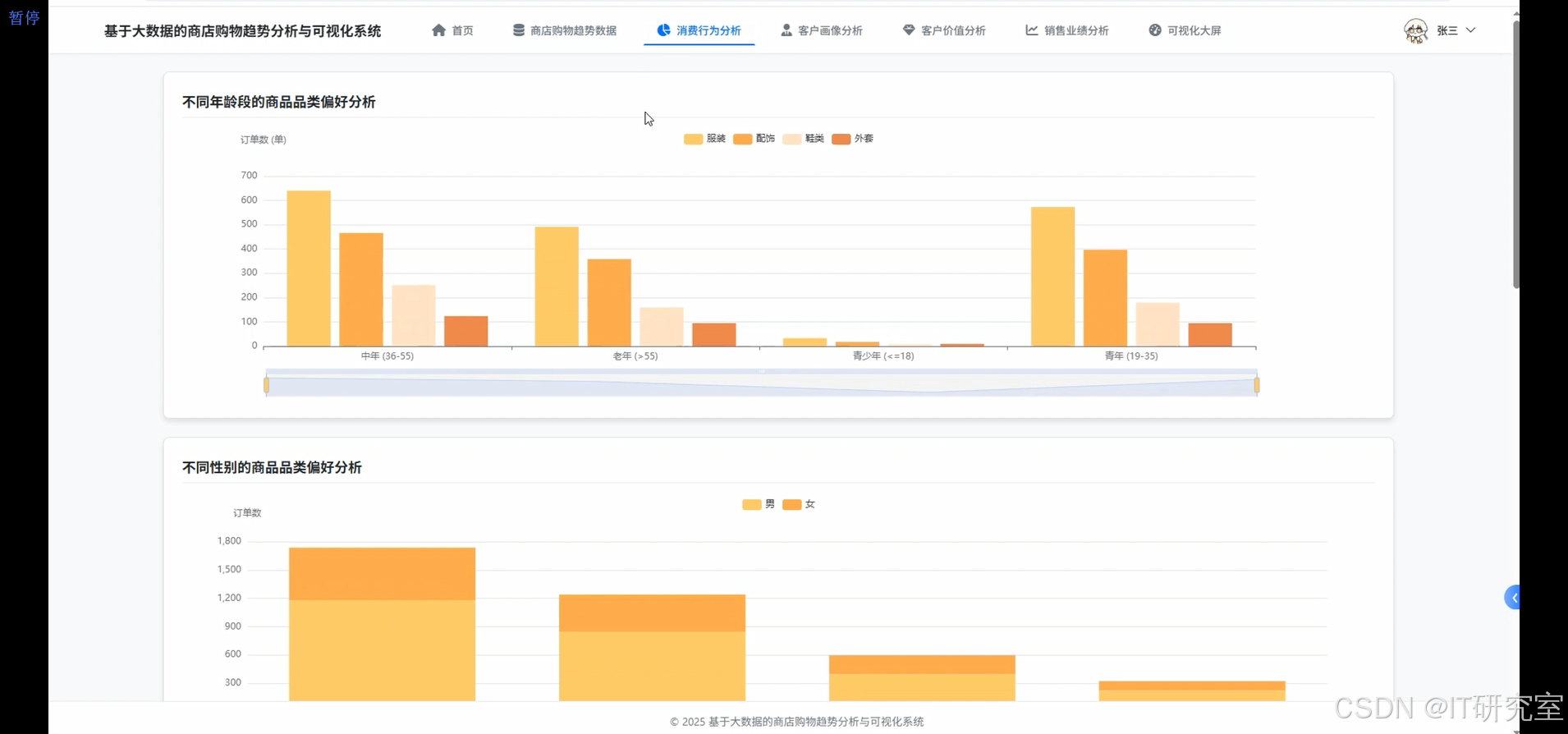

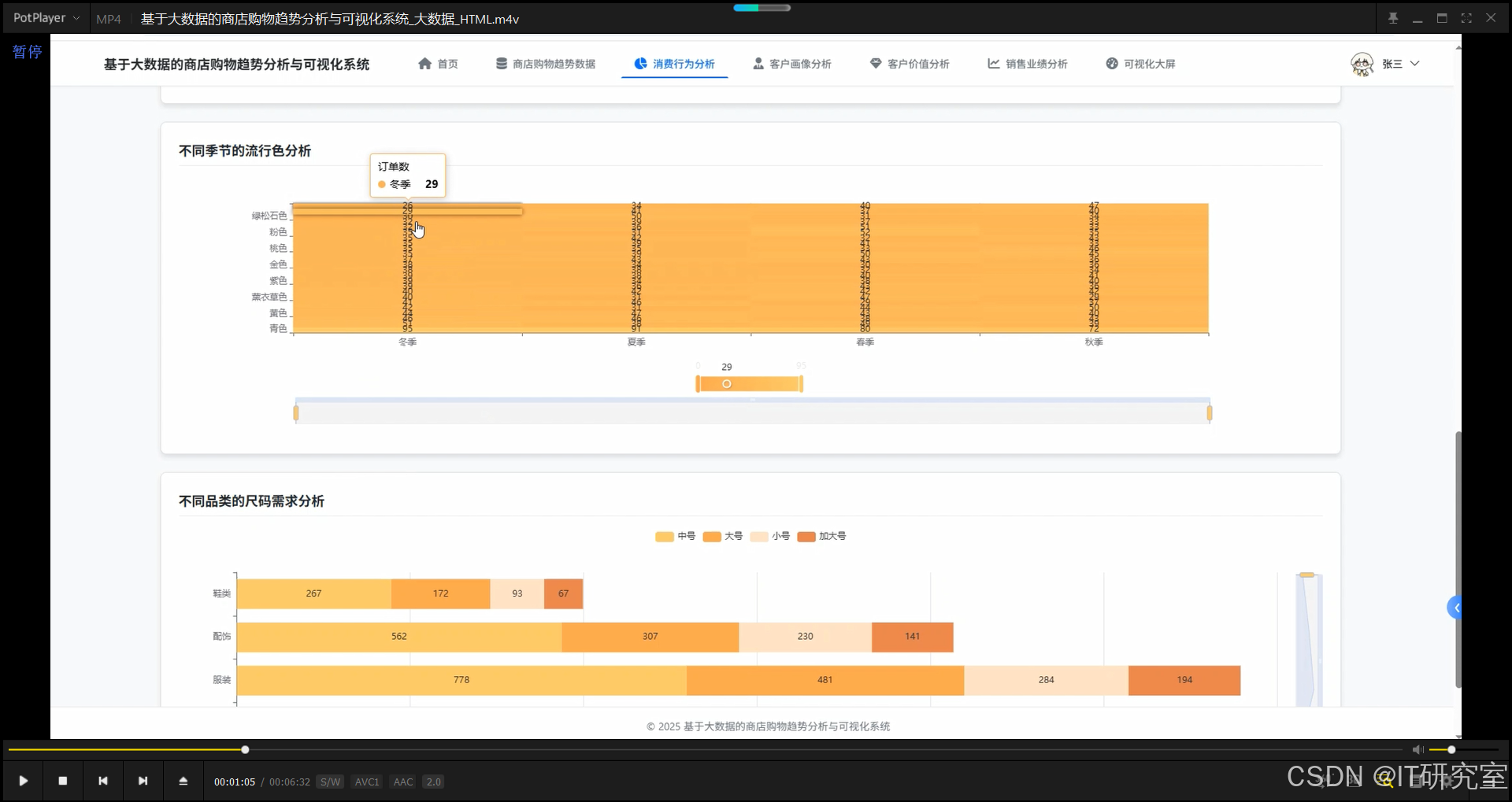

本系统是一个基于大数据技术栈的商店购物趋势分析与可视化平台,采用Hadoop+Spark分布式计算框架对海量购物数据进行高效处理和深度挖掘。系统后端采用Django框架构建RESTful API接口,利用Spark SQL和Pandas进行多维度数据分析,包括客户画像构建、消费行为模式识别、商品销售趋势预测等核心功能。前端基于Vue+ElementUI搭建交互界面,通过Echarts可视化引擎将分析结果以地图分布、趋势曲线、占比饼图、聚类散点等多种图表形式动态展示。系统实现了从数据采集存储(HDFS)、分布式计算(Spark)、业务逻辑处理(Django)到可视化呈现(Echarts大屏)的完整技术链路,提供顾客性别年龄分析、地域消费分布、商品类别销售对比、季节流行趋势、客户价值分群等17项分析功能,支持商家通过数据驱动决策优化库存管理、精准营销和客户运营策略,为零售行业的数字化转型提供了实用的技术解决方案。

选题背景

随着电子商务和新零售模式的快速发展,商店积累的交易数据呈现爆发式增长态势,这些数据中蕴含着顾客消费习惯、商品流行趋势、区域市场差异等重要商业信息。传统的人工统计和单机数据库分析方式已经难以应对TB级数据量的实时处理需求,商家迫切需要借助大数据技术来挖掘数据价值。目前零售企业普遍面临库存周转率低、营销投放不精准、客户流失率高等实际问题,这些问题的根源在于缺乏对消费数据的深度分析能力。Hadoop和Spark等分布式计算框架的成熟为处理海量购物数据提供了技术基础,而数据可视化技术的进步也让复杂的分析结果能够以直观的方式呈现给决策者。在这样的背景下,开发一套整合数据采集、分析、可视化的完整系统,帮助商家从海量交易记录中提取有价值的洞察,就成为一个值得探索的课题方向。

选题意义

本课题的实际意义主要体现在为中小型零售商提供了一套可落地的数据分析工具原型。通过对真实购物数据集的多维度分析,系统能够帮助商家识别出不同年龄段和性别群体的消费偏好,这对于调整商品结构和制定差异化营销策略具有参考价值。地域销售分布和季节趋势分析功能可以辅助商家优化区域配货计划,减少因盲目备货造成的资金占用。客户价值分群模块运用聚类算法将顾客划分为不同价值层级,让商家能够把有限的营销资源投向高价值客户,在一定程度上提升运营效率。从技术层面来看,本系统整合了当前主流的大数据技术栈,完成了从理论学习到工程实践的转化过程,加深了对分布式计算原理和数据可视化技术的理解。

二、开发环境

- 大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

- 开发语言:Python+Java(两个版本都支持)

- 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

- 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

- 详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

- 数据库:MySQL

三、系统界面展示

- 基于大数据的商店购物趋势分析与可视化系统统界面展示:

四、代码参考

- 项目实战代码参考:

java(贴上部分代码)

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, count, sum as spark_sum, avg, when, row_number, desc

from pyspark.sql.window import Window

from pyspark.ml.feature import VectorAssembler, StandardScaler

from pyspark.ml.clustering import KMeans

import pandas as pd

import numpy as np

from django.http import JsonResponse

from django.views import View

import json

spark = SparkSession.builder.appName("ShoppingTrendsAnalysis").config("spark.sql.shuffle.partitions", "4").config("spark.executor.memory", "2g").getOrCreate()

class CustomerProfileAnalysisView(View):

def post(self, request):

try:

df = spark.read.csv("/data/shopping_trends.csv", header=True, inferSchema=True)

df = df.filter(col("Purchase Amount (USD)").isNotNull() & col("Age").isNotNull())

age_bins = [0, 18, 35, 55, 100]

age_labels = ['青少年(<=18)', '青年(19-35)', '中年(36-55)', '老年(>55)']

age_conditions = [

(col("Age") <= 18, age_labels[0]),

((col("Age") > 18) & (col("Age") <= 35), age_labels[1]),

((col("Age") > 35) & (col("Age") <= 55), age_labels[2]),

(col("Age") > 55, age_labels[3])

]

age_case = when(age_conditions[0][0], age_conditions[0][1])

for condition, label in age_conditions[1:]:

age_case = age_case.when(condition, label)

df = df.withColumn("age_group", age_case)

gender_analysis = df.groupBy("Gender").agg(

count("Customer ID").alias("customer_count"),

spark_sum("Purchase Amount (USD)").alias("total_amount"),

avg("Purchase Amount (USD)").alias("avg_amount")

).toPandas()

age_analysis = df.groupBy("age_group").agg(

count("Customer ID").alias("customer_count"),

spark_sum("Purchase Amount (USD)").alias("total_amount"),

avg("Purchase Amount (USD)").alias("avg_amount")

).toPandas()

location_analysis = df.groupBy("Location").agg(

count("Customer ID").alias("customer_count")

).orderBy(desc("customer_count")).limit(10).toPandas()

subscription_analysis = df.groupBy("Subscription Status").agg(

count("Customer ID").alias("customer_count"),

spark_sum("Purchase Amount (USD)").alias("total_amount"),

avg("Purchase Amount (USD)").alias("avg_amount")

).toPandas()

location_age_analysis = df.groupBy("Location").agg(

avg("Age").alias("avg_age")

).orderBy(desc("avg_age")).limit(15).toPandas()

result_data = {

"gender_distribution": gender_analysis.to_dict(orient='records'),

"age_distribution": age_analysis.to_dict(orient='records'),

"location_top": location_analysis.to_dict(orient='records'),

"subscription_comparison": subscription_analysis.to_dict(orient='records'),

"location_age_avg": location_age_analysis.to_dict(orient='records')

}

return JsonResponse({"code": 200, "message": "客户画像分析完成", "data": result_data})

except Exception as e:

return JsonResponse({"code": 500, "message": f"分析失败: {str(e)}"})

class SalesPerformanceAnalysisView(View):

def post(self, request):

try:

df = spark.read.csv("/data/shopping_trends.csv", header=True, inferSchema=True)

df = df.filter(col("Purchase Amount (USD)").isNotNull())

category_sales = df.groupBy("Category").agg(

count("Customer ID").alias("order_count"),

spark_sum("Purchase Amount (USD)").alias("total_sales"),

avg("Purchase Amount (USD)").alias("avg_sales")

).orderBy(desc("total_sales")).toPandas()

item_sales = df.groupBy("Item Purchased").agg(

spark_sum("Purchase Amount (USD)").alias("total_sales"),

count("Customer ID").alias("purchase_count")

).orderBy(desc("total_sales")).limit(10).toPandas()

season_sales = df.groupBy("Season").agg(

spark_sum("Purchase Amount (USD)").alias("total_sales"),

count("Customer ID").alias("order_count")

).toPandas()

location_sales = df.groupBy("Location").agg(

spark_sum("Purchase Amount (USD)").alias("total_sales")

).toPandas()

total_sales = df.agg(spark_sum("Purchase Amount (USD)").alias("total")).collect()[0]["total"]

location_sales_pd = location_sales.toPandas()

location_sales_pd["contribution_rate"] = (location_sales_pd["total_sales"] / total_sales * 100).round(2)

location_sales_pd = location_sales_pd.sort_values("contribution_rate", ascending=False)

discount_impact = df.groupBy("Discount Applied").agg(

avg("Purchase Amount (USD)").alias("avg_amount"),

count("Customer ID").alias("order_count")

).toPandas()

result_data = {

"category_performance": category_sales.to_dict(orient='records'),

"top_items": item_sales.to_dict(orient='records'),

"season_trends": season_sales.to_dict(orient='records'),

"location_contribution": location_sales_pd.to_dict(orient='records'),

"discount_effectiveness": discount_impact.to_dict(orient='records')

}

return JsonResponse({"code": 200, "message": "销售业绩分析完成", "data": result_data})

except Exception as e:

return JsonResponse({"code": 500, "message": f"分析失败: {str(e)}"})

class CustomerValueClusteringView(View):

def post(self, request):

try:

df = spark.read.csv("/data/shopping_trends.csv", header=True, inferSchema=True)

df = df.filter(col("Purchase Amount (USD)").isNotNull() & col("Age").isNotNull())

customer_features = df.groupBy("Customer ID").agg(

avg("Age").alias("avg_age"),

spark_sum("Purchase Amount (USD)").alias("total_amount"),

count("Customer ID").alias("purchase_frequency")

)

customer_features = customer_features.filter(

col("avg_age").isNotNull() & col("total_amount").isNotNull() & col("purchase_frequency").isNotNull()

)

feature_columns = ["avg_age", "total_amount", "purchase_frequency"]

assembler = VectorAssembler(inputCols=feature_columns, outputCol="features_raw")

customer_features = assembler.transform(customer_features)

scaler = StandardScaler(inputCol="features_raw", outputCol="features", withStd=True, withMean=True)

scaler_model = scaler.fit(customer_features)

customer_features = scaler_model.transform(customer_features)

kmeans = KMeans(k=3, seed=42, featuresCol="features", predictionCol="cluster")

kmeans_model = kmeans.fit(customer_features)

clustered_customers = kmeans_model.transform(customer_features)

cluster_labels = {0: "高价值用户", 1: "潜力用户", 2: "一般用户"}

cluster_stats = clustered_customers.groupBy("cluster").agg(

count("Customer ID").alias("customer_count"),

avg("total_amount").alias("avg_total_amount"),

avg("purchase_frequency").alias("avg_frequency"),

avg("avg_age").alias("avg_age")

).toPandas()

cluster_stats = cluster_stats.sort_values("avg_total_amount", ascending=False).reset_index(drop=True)

cluster_mapping = {row["cluster"]: list(cluster_labels.values())[idx] for idx, row in cluster_stats.iterrows()}

cluster_stats["cluster_label"] = cluster_stats["cluster"].map(cluster_mapping)

cluster_distribution = cluster_stats[["cluster_label", "customer_count"]].to_dict(orient='records')

cluster_characteristics = cluster_stats[["cluster_label", "avg_total_amount", "avg_frequency", "avg_age"]].to_dict(orient='records')

sample_customers = clustered_customers.limit(500).toPandas()

sample_customers["cluster_label"] = sample_customers["cluster"].map(cluster_mapping)

scatter_data = sample_customers[["total_amount", "purchase_frequency", "cluster_label"]].to_dict(orient='records')

result_data = {

"cluster_distribution": cluster_distribution,

"cluster_characteristics": cluster_characteristics,

"scatter_plot_data": scatter_data

}

return JsonResponse({"code": 200, "message": "客户价值聚类分析完成", "data": result_data})

except Exception as e:

return JsonResponse({"code": 500, "message": f"聚类分析失败: {str(e)}"})五、系统视频

基于大数据的商店购物趋势分析与可视化系统项目视频:

大数据毕业设计选题推荐-基于大数据的商店购物趋势分析与可视化系统-大数据-Spark-Hadoop-Bigdata

结语

大数据毕业设计选题推荐-基于大数据的商店购物趋势分析与可视化系统-大数据-Spark-Hadoop-Bigdata

想看其他类型的计算机毕业设计作品也可以和我说~ 谢谢大家!

有技术这一块问题大家可以评论区交流或者私我~

大家可以帮忙点赞、收藏、关注、评论啦~

源码获取:⬇⬇⬇