学习PyTorch,您需要了解的知识

在您正式学习PyTorch之前,最好必须具备的基础知识包括 :Python 编程、基础数学(线性代数、概率论、微积分)、机器学习的基本概念、神经网络知识,以及一定的英语阅读能力来查阅文档和资料。当然你之前从没有接触过这些也没关系,可以在以后的学习过程中结合例子和疑问补齐巩固。

- 编程基础:熟悉至少一种编程语言,尤其是 Python,因为 PyTorch 主要是用 Python 编写的

- 数学基础:了解线性代数、概率论和统计学、微积分等基础数学知识,这些是理解和实现机器学习算法的基石

- 机器学习基础:了解机器学习的基本概念,如监督学习、无监督学习、强化学习、模型评估指标(准确率、召回率、F1分数等)

- 深度学习基础:熟悉神经网络的基本概念,包括前馈神经网络、卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)等

- 计算机视觉和自然语言处理基础:如果你打算在这些领域应用 PyTorch,了解相关的背景知识会很有帮助

- Linux/Unix 基础:虽然不是必需的,但了解 Linux/Unix 操作系统的基础知识可以帮助你更有效地使用命令行工具和脚本,特别是在数据预处理和模型训练中

- 英语阅读能力:由于许多文档、教程和社区讨论都是用英语进行的,具备一定的英语阅读能力将有助于你更好地学习和解决问题

什么是 PyTorch?

PyTorch 是一个开源的 Python 机器学习库,基于 Torch 库,底层由 C++ 实现,应用于人工智能领域,如计算机视觉和自然语言处理。它由 Meta(原 Facebook)的人工智能研究团队开发并维护,于 2016 年首次发布,凭借其灵活性、易用性和强大的功能,成为目前最受欢迎的深度学习框架之一。因为使用 Python 编写,因此对于大多数机器学习开发者而言,学习和使用起来也相对简单。许多深度学习软件都是基于 PyTorch 构建的,包括特斯拉自动驾驶、Uber 的 Pyro、Hugging Face 的 Transformers、 PyTorch Lightning 和 Catalyst。

PyTorch 主要有两大特征:

- 类似于 NumPy 的张量计算,能在 GPU 或 MPS 等硬件加速器上加速

- 基于带自动微分系统的深度神经网络

为何选择 PyTorch?

PyTorch 是 Facebook AI Research 和其他几个实验室的开发者的工作成果。该框架将 Torch 中高效而灵活的 GPU 加速后端库与直观的 Python 前端相结合,后者专注于快速原型设计、可读代码,并支持尽可能广泛的深度学习模型。Pytorch 支持开发者使用熟悉的命令式编程方法,但仍可以输出到图形。它于 2017 年以开源形式发布,一经发布就快速走红,深受机器学习开发者的喜爱。

为什么选用Pytorch?

- 动态图灵活性:在科研和快速迭代场景中碾压静态图框架(如 Caffe、TensorFlow 1.x)。

- 易用性:API 设计更符合 Python 开发者习惯,学习和调试成本更低。

- 科研生态:学术界首选,前沿算法(如 Transformer、扩散模型)的实现和工具库更丰富。

- 平衡科研与生产:既保留灵活性,又通过 TorchScript、ONNX 等工具逐步完善部署能力,填补了 Caffe 的僵化和 TensorFlow 早期的复杂性之间的空白。

和TensorFlow、Caffe等其他AI框架比较

| 对比维度 | PyTorch | TensorFlow | Caffe |

|---|---|---|---|

| 计算图类型 | 动态计算图(即时执行),运行时可灵活修改 | 静态计算图为主(2.x 支持动态图),需先定义后执行 | 静态计算图,完全基于配置文件定义 |

| API 设计 | 简洁直观,贴近 Python 原生风格,易用性高 | API 较复杂(历史迭代导致),高阶接口(Keras)与底层混合 | 接口较底层,依赖配置文件(.prototxt),灵活性低 |

| 调试难度 | 支持逐行调试、打印中间变量,调试便捷 | 动态图模式下调试改善,但静态图模式调试复杂 | 调试困难,依赖日志输出 |

| 科研适配性 | 极高,适合快速验证新算法、动态网络结构 | 中等,静态图对创新实验支持较弱 | 低,仅适合固定网络结构的复现 |

| 工业部署支持 | 支持(TorchScript、ONNX 转换),近年完善 | 极强(TensorRT、TFLite、JS 部署等),生态成熟 | 支持但工具链老旧,仅适合传统部署场景 |

| 生态系统 | 科研工具丰富(Hugging Face、扩散模型库等) | 工业工具完善(TPU 支持、云服务集成等) | 生态停滞,依赖第三方扩展 |

| 社区活跃度 | 学术界主导,顶会论文代码首选 | 工业界应用广泛,Google 持续维护 | 社区萎缩,更新缓慢(Caffe2 已合并到 PyTorch) |

| 学习门槛 | 低,适合初学者快速上手 | 中高,需适应多版本 API 差异 | 中,需学习配置文件语法 |

| 典型应用场景 | 学术研究、快速原型开发、大模型训练 | 工业级生产部署、移动端应用、大规模分布式训练 | 传统计算机视觉任务(如早期图像分类) |

| 硬件加速支持 | 原生支持 GPU(CUDA)、部分支持 TPU | 全面支持 GPU、TPU、边缘设备 | 仅支持 GPU(CUDA),无新型硬件适配 |

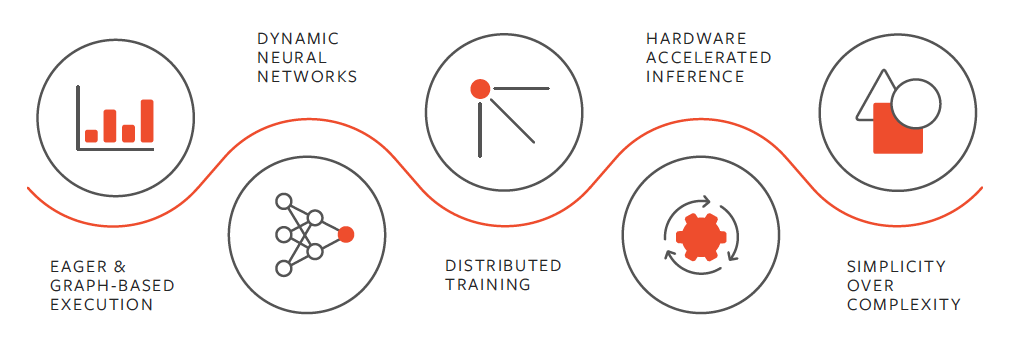

PyTorch 的一些重要特性

PyTorch 的一些重要特性包括:

-

PyTorch.org 社区有一个充满活力的大型社区,具有优秀的文档和教程。论坛十分活跃,并能给予帮助和支持。

-

采用 Python 编写,并集成了热门的 Python 库,例如用于科学计算的 NumPy、SciPy 和用于将 Python 编译为 C 以提高性能的 Cython。由于 PyTorch 的语法和用法类似于 Python,因此对于 Python 开发者来说,学习起来相对容易。

-

受主要云平台的有力支持。

-

脚本语言(称为 TorchScript)在即时模式下易于使用且灵活。这是一种快速启动执行模式,从 Python 调用运算时立即执行运算,但也可以在 C++ 运行时环境中转换为图形模型,以提高速度和实现优化。

-

它支持 CPU、GPU、并行处理以及分布式训练。这意味着计算工作可以在多个 CPU 和 GPU 核心之间分配,并且可以在多台机器上的多个 GPU 上进行训练。

-

PyTorch 支持动态计算图形,能够在运行时更改网络行为。与大多数机器学习框架相比,提供了更大的灵活性优势,因为大多数机器学习框架要求在运行时之前将神经网络定义为静态对象。

-

PyTorch Hub 是一个预训练模型库,在某些情况下只需使用一行代码就可以调用。

-

新自定义组件可创建为标准 Python 类的子类,可以通过 TensorBoard 等外部工具包轻松共享参数,并且可以轻松导入和内联使用库。

-

PyTorch 拥有一组备受好评的 API,可用于扩展核心功能。

-

既支持用于实验的"即时模式",也支持用于高性能执行的"图形模式"。

-

强大的自动求导(Autograd)

- 内置自动微分系统,支持对张量操作自动计算梯度,无需手动推导链式法则

- 支持动态计算图的梯度反向传播,即使计算流程在运行时变化,仍能正确求导,对递归网络、强化学习等依赖动态逻辑的场景友好

-

拥有从计算机视觉到增强学习等领域的大量工具和库。

-

支持 Python 程序员熟悉的纯 C++ 前端接口,可用于构建高性能 C++ 应用程序。

-

社区更新迭代快,快速支持新型硬件(如 GPU 新特性、AI 加速芯片)和技术(如量化、稀疏化)。

-

配套工具链丰富:

torchvision:计算机视觉工具(数据集、预处理、经典模型如 ResNet、YOLO 等);torchaudio:音频处理(特征提取、语音模型);torchtext(或替代库如Hugging Face Datasets):自然语言处理工具;

主要应用场景

- 深度学习模型的研究与开发(如神经网络、卷积神经网络 CNN、循环神经网络 RNN、Transformer 等);

- 计算机视觉(图像分类、目标检测、图像生成等);

- 自然语言处理(文本分类、机器翻译、大语言模型等);

- 强化学习、语音识别等其他 AI 领域。