《VR 360°全景视频开发》专栏

将带你深入探索从全景视频制作到Unity眼镜端应用开发的全流程技术。专栏内容涵盖安卓原生VR播放器开发、Unity VR视频渲染与手势交互、360°全景视频制作与优化,以及高分辨率视频性能优化等实战技巧。

📝 希望通过这个专栏,帮助更多朋友进入VR 360°全景视频的世界!

Part 4|未来趋势与技术展望

最后一Part,将分享一些关于XR技术未来发展的趋势,内容涵盖三维实时渲染与全景视频的共生、多模态交互体验的融合,以及AI如何深度赋能XR应用,推动智能化发展。同时畅想通向全感知XR智能沉浸时代的未来,探索如何通过更先进的技术不断提升用户体验。毕竟,360°全景视频仅是XR应用中的冰山一角。

往期回顾

第一节|技术上的抉择:三维实时渲染与VR全景视频的共生

链接:https://eqgis.blog.csdn.net/article/details/150354289

在实际的 VR 内容创作中,单一依赖三维实时渲染或全景视频往往难以同时满足沉浸感、交互性与性能优化的多重需求。因此,我们通常会将两种技术形态的优势进行有机融合,这种内容形态的融合,不仅为文旅、教育、展览等场景提供了更具表现力的解决方案,也为未来的 XR 应用奠定了可持续发展的技术路径。

第二节|多模态交互体验:手势、语音与眼动控制的集成应用

本节探讨VR/AR设备中多模态交互(Multi-Modal Interaction)的集成趋势与实现方式,重点分析手势识别、语音交互、眼动追踪三种主流交互方式在XR设备中的融合实践,以及Unity中如何实现跨模态的输入处理与用户意图理解。

文章目录

- [Part 4|未来趋势与技术展望](#Part 4|未来趋势与技术展望)

-

- 往期回顾

- 第二节|多模态交互体验:手势、语音与眼动控制的集成应用

-

- 一、从单一输入到多模态交互的时代转变

- 二、手势识别:自然交互的第一入口

-

- [2.1 技术流程](#2.1 技术流程)

- [2.2 在Unity中的API](#2.2 在Unity中的API)

- [2.3 手势识别原理](#2.3 手势识别原理)

- [2.4 挑战与优化方向](#2.4 挑战与优化方向)

- 三、语音交互:自然语言驱动的XR控制

-

- [3.1 技术架构](#3.1 技术架构)

- [3.2 实际实现方式](#3.2 实际实现方式)

- [3.3 优化与融合](#3.3 优化与融合)

- 四、眼动追踪:视线即焦点的沉浸式交互

-

- [4.1 原理](#4.1 原理)

- [4.2 应用场景](#4.2 应用场景)

- [4.3 Unity 实现示例](#4.3 Unity 实现示例)

- [4.4 优化与未来发展](#4.4 优化与未来发展)

- 五、多模态融合:意图识别与协同控制

-

- [5.1 概念说明](#5.1 概念说明)

- [5.2 实际应用场景](#5.2 实际应用场景)

- [5.3 挑战与未来方向](#5.3 挑战与未来方向)

- 六、小结

-

- [6.1 趋势](#6.1 趋势)

- [6.2 展望](#6.2 展望)

- 更多...

一、从单一输入到多模态交互的时代转变

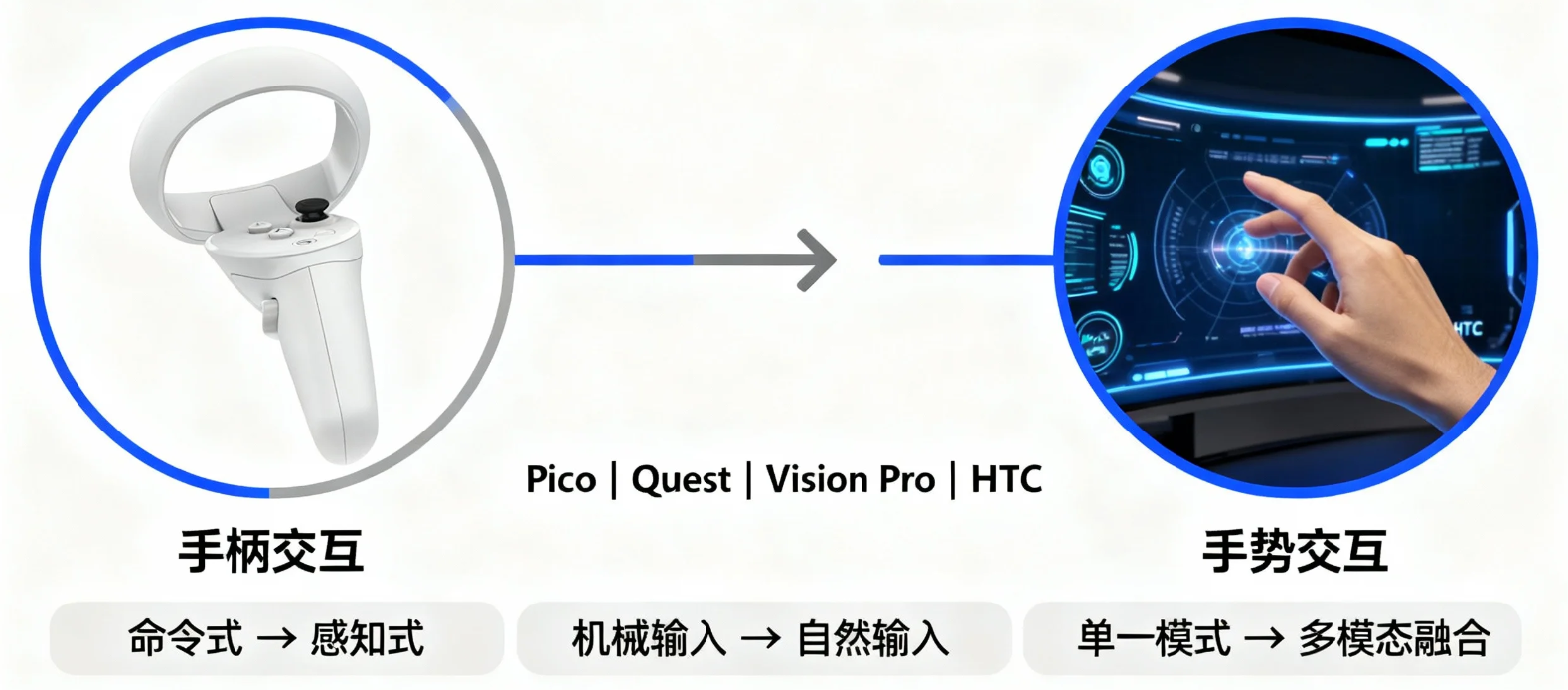

在传统VR系统中,主要交互方式依赖手柄(Controller)------通过按钮、摇杆和触发键进行输入。然而,随着Pico、Quest、Vision Pro等设备的传感系统升级,XR正在从 "手柄交互" 迈向 "无控制器交互" 时代。

这种转变不是简单的硬件更新,而是人机交互范式的演进:

- 从命令式操作 → 感知式操作

- 从机械输入 → 自然输入(Natural Interaction)

- 从单一模式 → 多模态融合

多模态交互结合视觉识别、语音理解、眼动追踪等技术,让XR系统逐渐具备"感知用户意图"的能力,实现更加自然的交互体验。

二、手势识别:自然交互的第一入口

本段为当下已用于项目中的技术分享。

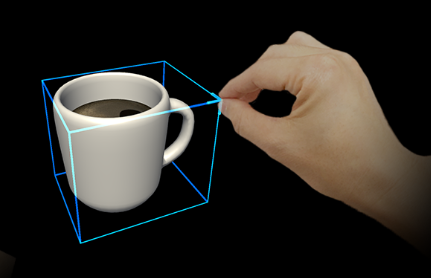

手势识别(Gesture Recognition)是多模态交互体系中最基础也是最直观的方式,它通过摄像头或红外传感器捕捉手部动作,实现虚拟空间中的抓取、点击、旋转等操作。

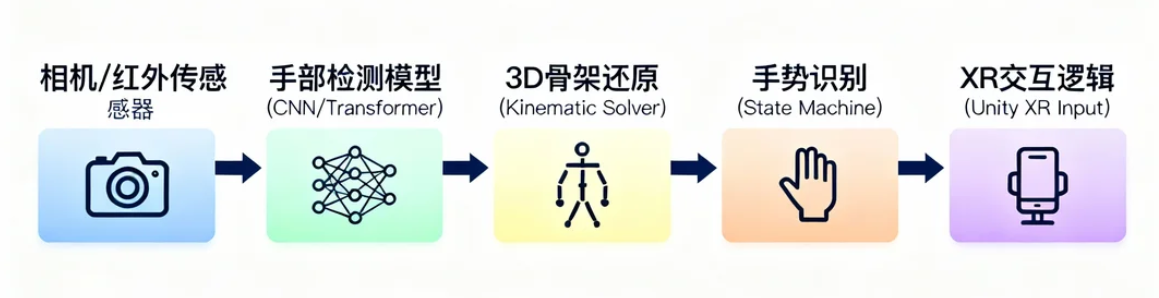

2.1 技术流程

主流VR手势识别系统通常基于骨架追踪(Skeleton Tracking)与关键点检测(Keypoint Detection):

流程说明:

- 摄像头采集:由设备前置摄像头或Leap Motion等外部模块捕捉手部影像。

- AI模型识别:卷积神经网络提取手部特征点。

- 3D骨骼:通过逆运动学(IK)计算三维骨骼。

- 状态识别:根据关键节点状态(握拳、张开、指向)判断手势。

- 事件触发:将结果映射到Unity中的交互逻辑。

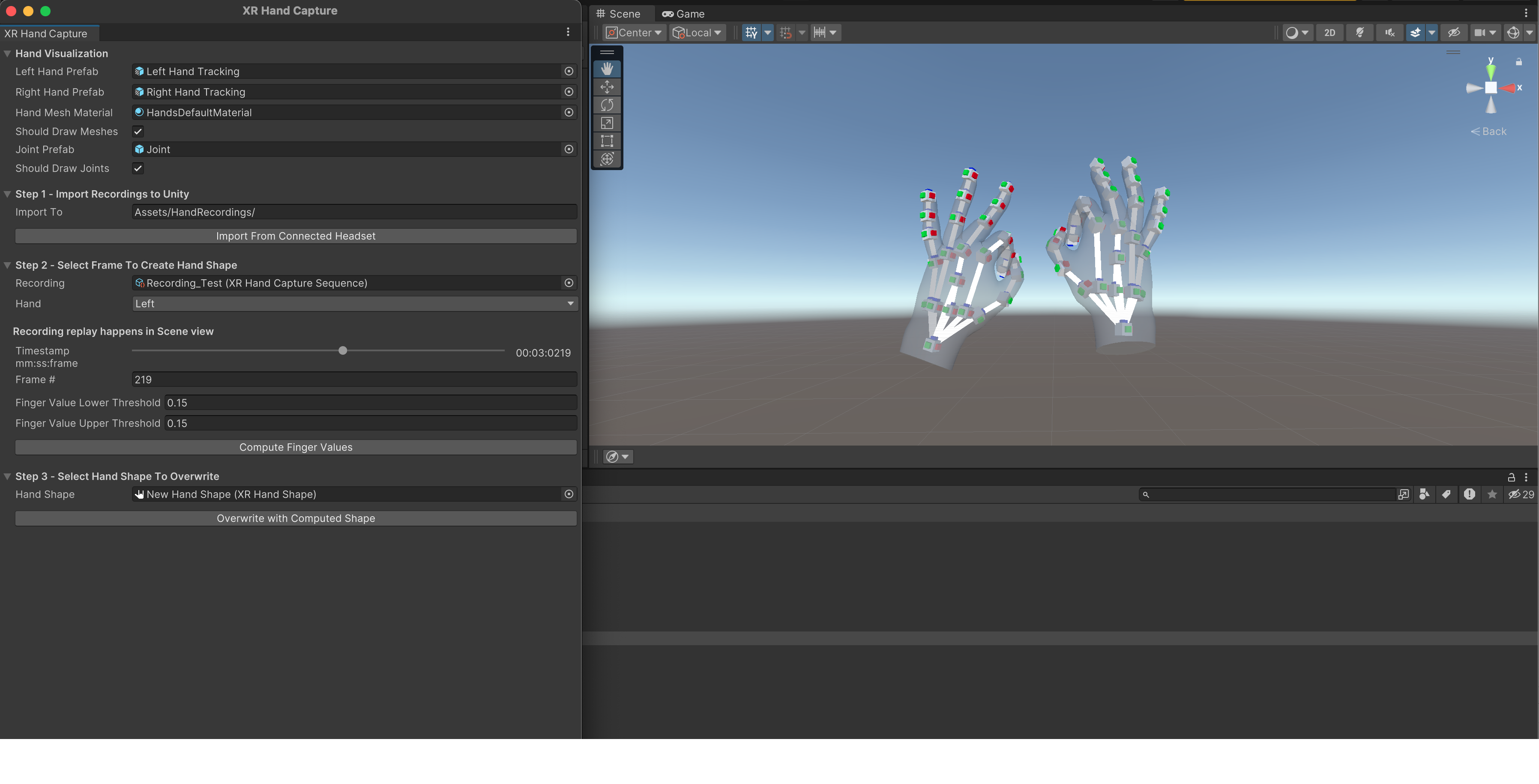

2.2 在Unity中的API

Unity提供了XR Hands,包定义了一个API,允许从支持手部跟踪的设备访问手部跟踪数据。

XR Hnads:

https://docs.unity3d.com/Packages/com.unity.xr.hands@1.7/manual/index.html

- XR Hands / OpenXR Hand Tracking :官方API,支持Pico、Quest等设备。

- Unity 的 XR Interaction Toolkit(XRIT) 在最新版本中(结合 com.unity.xr.hands 套件)已经原生支持 手势识别(Gesture Recognition)与基于手势的交互(Hand Gestures Interaction)。

在 XRIT 中,手势功能并不是单独的"识别系统",而是基于以下三层结构实现的:

| 层级 | 功能描述 | 对应模块 |

|---|---|---|

| 追踪层 | 提供手部骨架、姿态、指尖位置等数据 | XR Hands (com.unity.xr.hands) |

| 手势检测层 | 将手部数据分析为"Pinch""Grab""Open""Point"等状态 | XR Interaction Toolkit - Hands Subsystem |

| 交互层 | 使用识别到的手势触发 XRGrabInteractable、UI Press 等操作 | XR Interaction Toolkit - Hand Interaction Profiles |

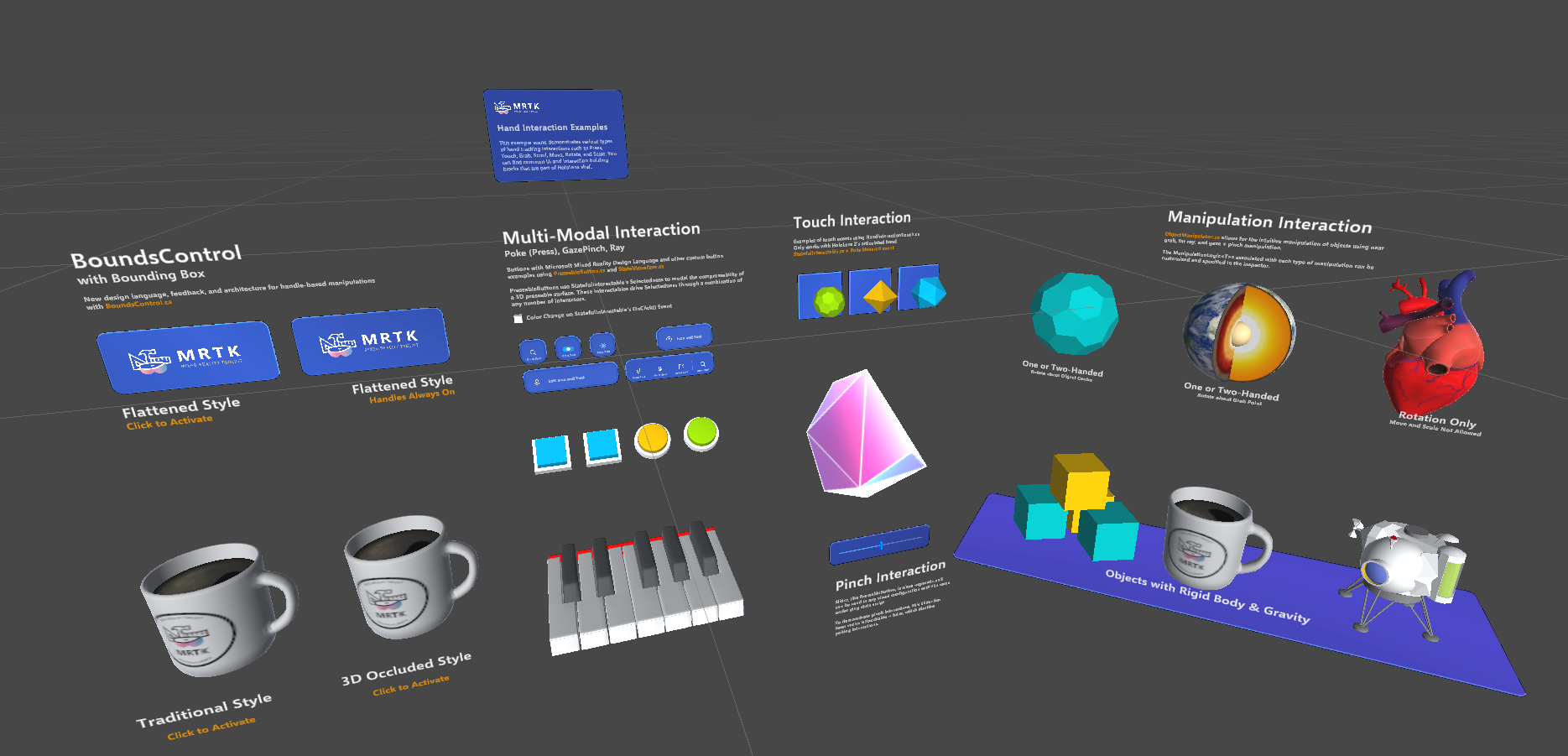

- MRTK3(Mixed Reality Toolkit v3)

早期 MRTK2(用于 HoloLens 2)依赖自家的输入系统(IMixedRealityInputSystem),而 Unity XR 生态逐渐标准化后,微软在 MRTK3 中做了架构转向:

| MRTK2 | MRTK3 |

|---|---|

| 自定义 Input System | 基于 Unity Input System |

| 自定义交互逻辑 | 复用 XR Interaction Toolkit |

| 特定平台(HoloLens) | 多平台(OpenXR, Meta Quest, PCVR) |

| 手势识别独立实现 | 基于 XRIT + XR Hands 统一封装 |

也就是说:

MRTK3 = XRIT + 自家扩展层 + 多平台适配层 + Mixed Reality UX Framework

补充:

关于在Unity中使用MRTK3,可参考我的《Pico MR实操分享》专栏,涵盖的Pico MR开发的串流PCVR,一体机VR、MR等多个使用场景以及踩坑记录。

2.3 手势识别原理

- 以手势捏合(Pinch)为例,若是基于XRHand实现的话,伪代码如下:

csharp

void Update()

{

XRHand leftHand = XRHandSubsystem.leftHand;

if (leftHand.isTracked)

{

Vector3 indexTip = leftHand.GetJoint(XRHandJointID.IndexTip).pose.position;

Vector3 thumbTip = leftHand.GetJoint(XRHandJointID.ThumbTip).pose.position;

float pinchDistance = Vector3.Distance(indexTip, thumbTip);

if (pinchDistance < 0.02f)

{

TriggerPinchAction();

}

}

}这里初步展示了 手势捏合(Pinch) 的基础判断逻辑,用于实现事件确认、物体抓取等操作。

通过上述代码,可发现我们通过判断食指指尖节点与拇指指尖节点的相对距离,即实现了手势捏合状态的判断。读者由此启发,即可以实现更复杂的手势。

2.4 挑战与优化方向

- 遮挡问题:手在身体或物体后以及手指交叉重叠等场景时识别困难。

- 延迟与抖动:需要时间滤波与卡尔曼滤波算法稳定手势轨迹。

- 环境光干扰:强光或反射环境会影响红外识别。

未来趋势:

- 结合深度相机 + AI骨架预测提升鲁棒性;

- 使用手部意图预测模型,提前判断动作意图;

- 实现无标记自由手势交互(如Vision Pro的手指捏合控制)。

三、语音交互:自然语言驱动的XR控制

本段为当下已用于项目中的技术分享。

语音交互为XR带来了无接触、无学习成本的自然控制方式。当手部被占用或视线交互受限时,语音识别成为最有效的补充交互形式。

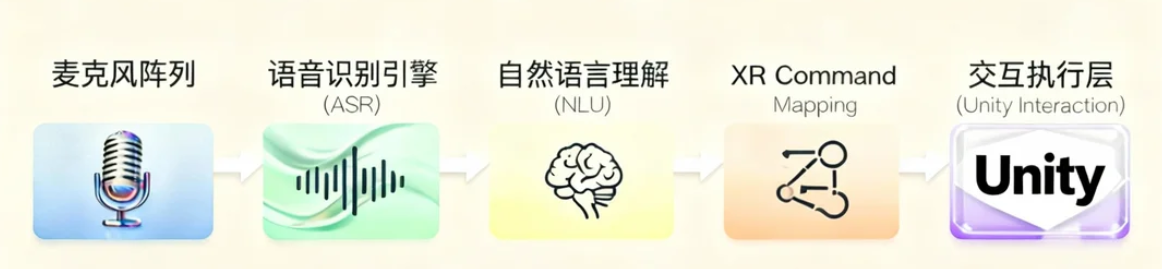

3.1 技术架构

语音交互的核心在于语音识别(ASR)与意图理解(NLU) 。

在XR环境中,语音交互系统通常由以下模块组成:

3.2 实际实现方式

在 Unity 中,可以使用以下方案:

- 平台SDK集成

- 一体机XR应用:针对诸如Pico这类基于安卓系统的XR设备,推荐直接使用讯飞、百度、阿里、思必驰等众多厂商的安卓SDK。

- PCVR应用:设备上采集到音频后,使用讯飞、百度、阿里、思必驰提供的网络API。

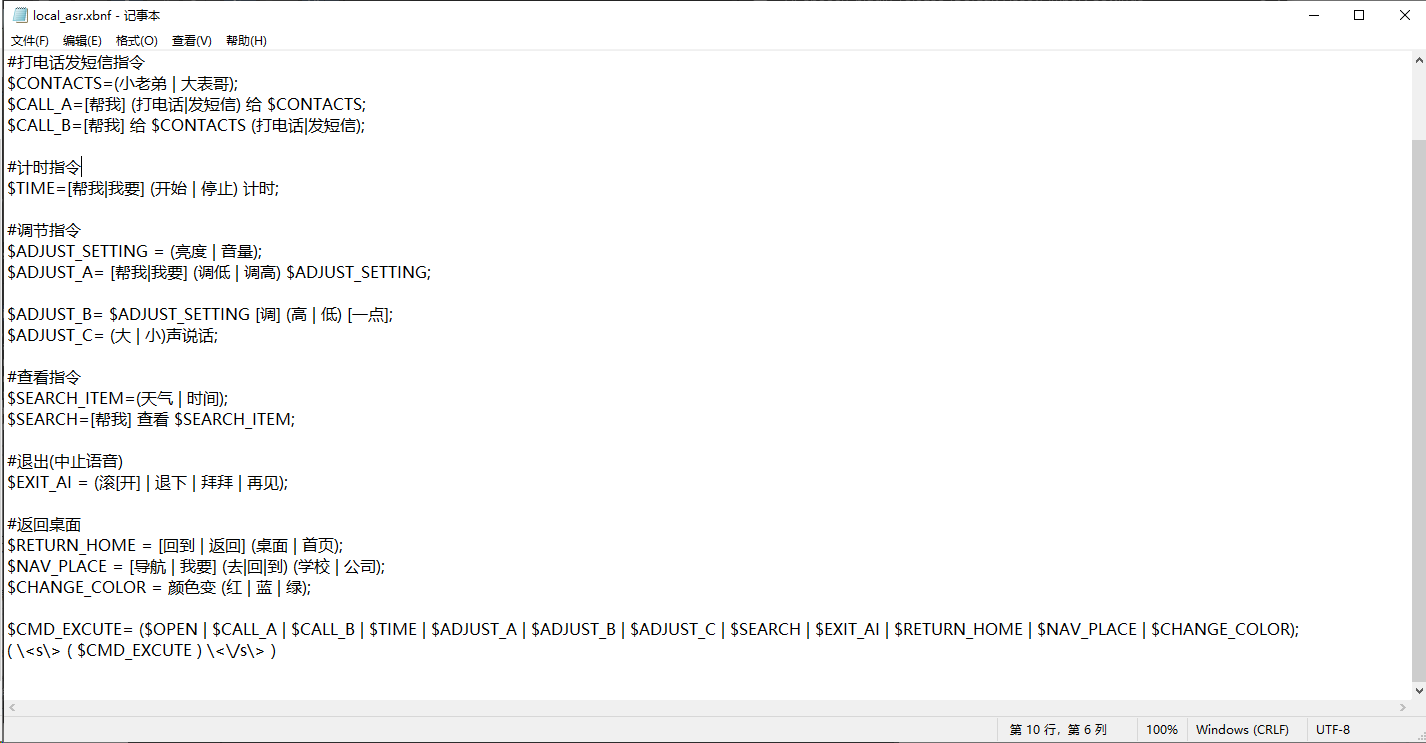

- 语音命令映射机制

- 通过ASR(语音识别)获取到内容后,我们需要将内容映射成对应的命令

以下是一份简单的映射,采用ebnf范式

- 指令响应(将对应指令转换为事件响应)

示例伪代码:

csharp

void OnRecognizedCommand(string command)

{

switch (command.ToLower())

{

case "pause video":

case "暂停播放":

videoPlayer.Pause();

break;

case "play":

case "播放视频":

videoPlayer.Play();

break;

case "reset view":

case "重置视角":

ResetView();

break;

}

}3.3 优化与融合

语音控制的挑战主要在于:

- 语音识别精度:嘈杂环境下准确率下降。

- 延迟与反馈:实时性要求高。

- 多语言支持:需集成本地化模型。

未来的XR语音系统将趋向以下方向:

- 离线语音识别模型(On-Device ASR),避免网络依赖;

- 上下文感知语音:根据用户当前视角或操作状态过滤无关指令;

- 情绪识别与语调理解:通过语音语调识别用户情绪状态,实现更自然反馈。

补充:

关于离线语音识别(ASR)+一体机安卓XR硬件的对接,可参考之前分享过的项目:

- 【工程配套】在Unity项目中接入思必驰语音SDK,实现类似"语音助手"的功能

https://eqgis.blog.csdn.net/article/details/148522910

四、眼动追踪:视线即焦点的沉浸式交互

本段为当下已用于项目中的技术分享。

4.1 原理

眼动追踪功能能够在应用中实时监测并定位用户的注视点。其核心是一项传感器技术,通过捕捉眼球运动,将用户的视线变化转化为数据流,输出瞳距、双目注视向量及注视点等信息,作为设备的输入信号。

4.2 应用场景

-

注视点选取(Gaze Selection) :

通过"凝视"特定UI几百毫秒触发点击事件。

常用场景:眼睛凝视UI一定时长后,触发事件(类似点击事件,或确认或弹窗或跳转至新内容页)。

-

注视渲染(Foveated Rendering) :

在用户注视区域使用高分辨率渲染,周边采用低分辨率,从而降低GPU负载。

参考Pico SDK的描述:

眼动追踪注视点渲染(Eye Tracked Foveated Rendering,ETFR)根据眼球的注视方向,以全分辨率渲染眼球注视区域的图像,以更低分辨率渲染边缘区域图像。

- 行为分析与广告热图 :

分析用户在VR环境中的视线轨迹,用于体验优化或广告分析。

记录眼睛注视点的轨迹,扩展应用体验。

4.3 Unity 实现示例

- XR Eye Tracking API

UnityXR输入系统提供了统一的 XR Eye Tracking API,使其可以快速适配支持眼动跟踪的设备。

伪代码示例:

csharp

XRInputSubsystem.TryGetEyeGaze(out Ray gazeRay);

if (Physics.Raycast(gazeRay, out RaycastHit hit))

{

HighlightObject(hit.transform);

if (UserGazeDuration(hit.transform) > 0.5f)

TriggerSelect(hit.transform);

}- PICO Unity Integration SDK

眼动追踪相关接口在 SDK 2.3.0 版本进行了升级改造,推荐你升级 SDK 至 2.3.0 或以上版本、升级 PICO 设备系统至 5.7.0 或以上版本使用最新的眼动追踪接口。

PICO Unity Integration SDK:

https://developer-cn.picoxr.com/document/unity/eye-tracking/

4.4 优化与未来发展

- 提高采样率与延迟稳定性(<10ms);

- 结合机器学习预测注视点;

- 与手势、语音形成"复合意图识别";

- 实现无UI交互------只通过视线与手势即可完成控制。

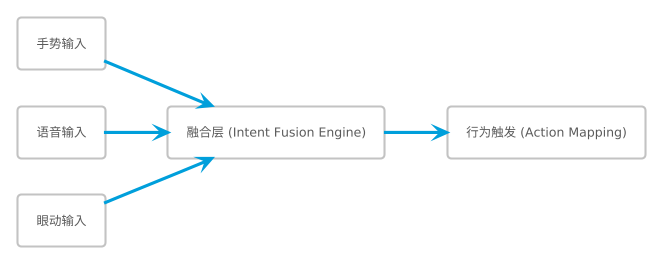

五、多模态融合:意图识别与协同控制

本段为后续项目中会逐渐运用的技术分享。

5.1 概念说明

多模态融合(Multimodal Fusion)是将手势、语音、视线、头部姿态等多种输入信号综合判断用户意图的技术。

这使XR设备从"命令驱动"迈向"语义理解"。

5.2 实际应用场景

示例:语音 + 手势的协同操作

用户说:"打开这个窗口",并用手指指向屏幕中的一个UI面板。

系统通过语音识别解析指令语义,同时通过手势识别锁定指向目标,最终执行"打开窗口"操作。

伪代码:

csharp

if (voiceIntent == "open" && gestureTarget != null)

{

OpenPanel(gestureTarget);

}5.3 挑战与未来方向

- 信号时序对齐问题:语音和手势输入不同步需时序融合。

- 模态冲突消解:当多模态信号冲突时,系统需自动推断最可信来源。

- 个体化学习:不同用户语速、手势习惯差异大,需自适应建模。

未来发展趋势包括:

- 多模态Transformer网络(如 Perceiver IO)统一处理语音+视觉+运动数据。

- 上下文感知交互系统,通过历史操作与环境理解预测用户意图。

- 情境AI助手(Contextual XR Agent),在VR中像人一样理解你。

六、小结

6.1 趋势

-

从检测到理解 :

手势、语音、眼动将不再孤立存在,而是融合为统一的意图识别系统。

-

从命令到语义 :

用户不再需要记指令,而是通过自然动作与语言表达需求。

-

从交互到感知 :

XR系统将主动"感知"用户状态(疲劳、情绪、注意力),实现全场景沉浸。

-

AI赋能的XR助手 :

AI将成为用户与虚拟世界之间的语义中枢,实现"无界交互"。

6.2 展望

多模态交互让XR系统从"响应输入"走向"理解意图",让虚拟世界的交互更加人性化与沉浸。

无论是捏合手势的即时反馈,语音命令的语义解析,还是注视控制的精准聚焦,它们共同构成了下一代XR体验的核心要素。

未来,当这些模态进一步融合,你不再需要思考"如何操作",而只是"自然地去做"------而XR系统,会自然而然地"明白你的意图"。

更多...

持续更新,欢迎指导与交流。

专栏地址:《VR 360°全景视频开发:从GoPro到Unity VR眼镜应用实战》

👉 专栏预告

👉 往期回顾

【Part 1 全景视频拍摄与制作基础】

- 第一节|全景视频概述与应用场景(2025年3月23日12:00更新)

- 第二节|全景视频拍摄设备选型与使用技巧(2025年3月30日12:00更新)

- 第三节|全景视频后期拼接与处理流程(2025年4月6日12:00更新)

- 第四节|基于UE/Unity的全景视频渲染与导出(2025年4月13日12:00更新)

【Part 2 安卓原生360°VR播放器开发实战】

- 第一节|通过传感器实现VR的3DOF效果(2025年4月20日12:00更新)

- 第二节|基于等距圆柱投影方式实现全景视频渲染(2025年4月27日12:00更新)

- 第三节|实现VR视频播放与时间轴同步控制(2025年5月6日00:00更新)

- 第四节|安卓VR播放器性能优化与设备适配(2025年5月12日00:00更新)

【 Part 3 Unity VR眼镜端播放器开发与优化】

-

第一节|基于Unity的360°全景视频播放实现方案(2025年5月20日08:00更新)

-

第二节|VR眼镜端的开发适配与交互设计 (2025年6月2日08:00更新)

-

第三节|Unity VR手势交互开发与深度优化 (2025年6月18日08:00更新)

-

第四节|高分辨率VR全景视频播放性能优化 (2025年7月2日23:00更新)

【Part 4 未来趋势与技术展望】

-

第一节|技术上的抉择:三维实时渲染与VR全景视频的共生(2025年8月13日21:00更新)

-

第二节|多模态交互体验:手势、语音与眼动控制的集成应用(2025年10月20日01:00更新)