今天是10.21日,开始学习

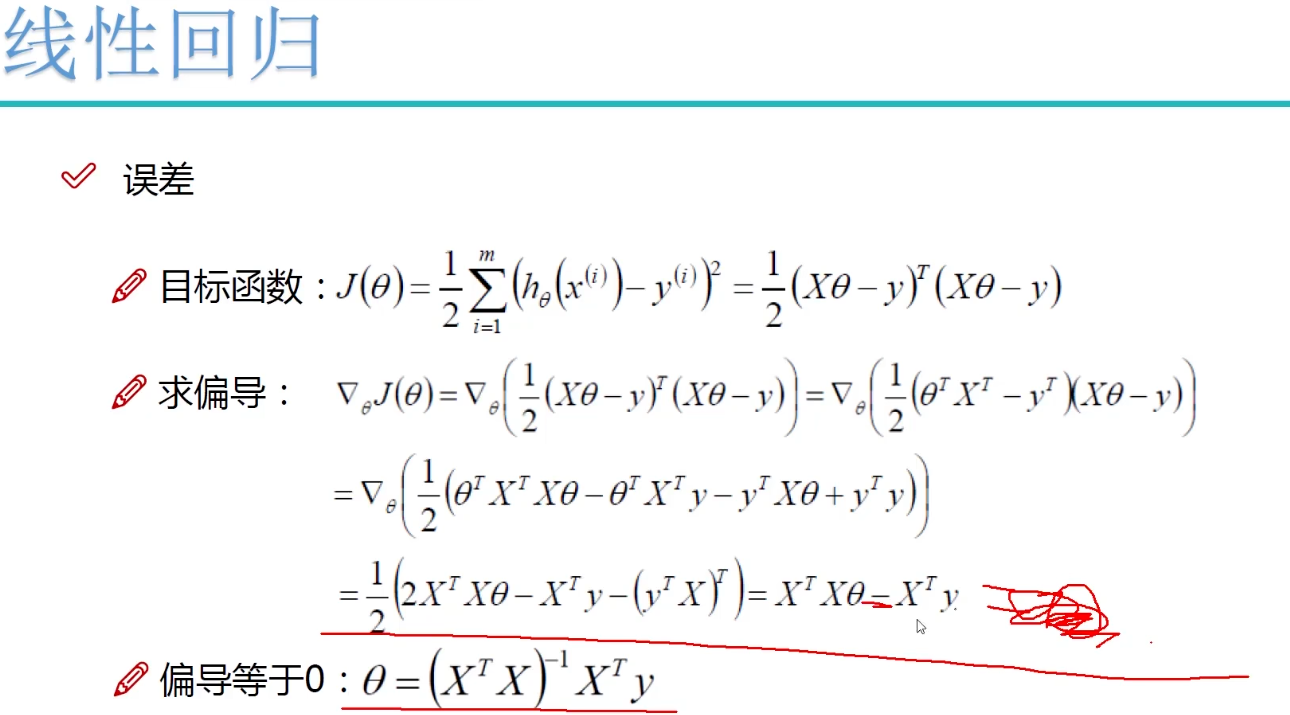

这里推导了求似然函数,推导到最后让似然函数置零,得到最小二乘解,相当于构建了问题和问题的求解方向

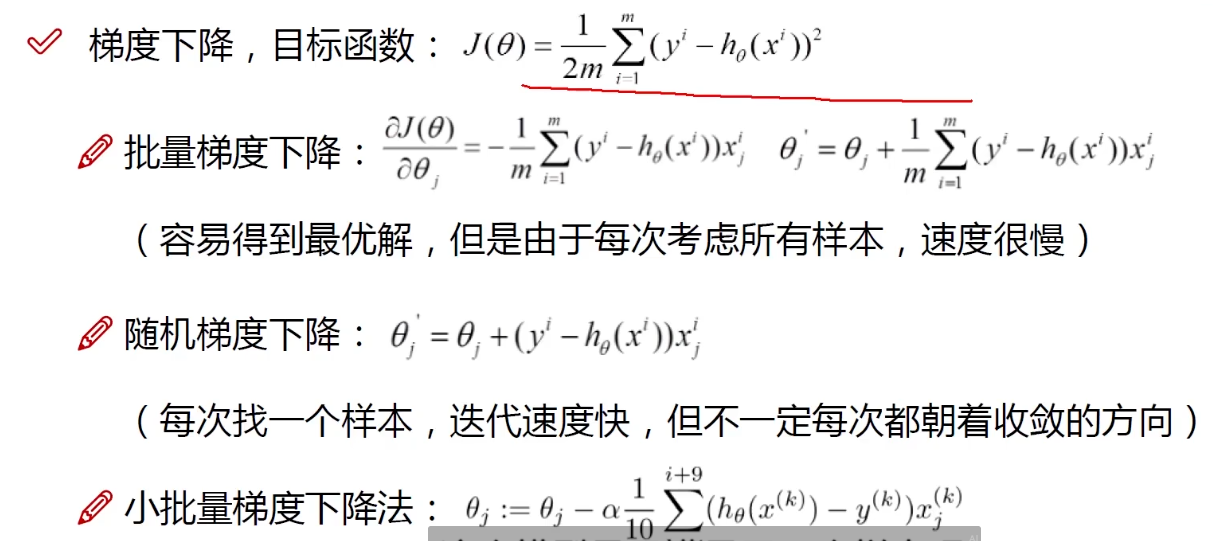

下一步,需要用某个解法去更新他,不能求出来一个值就完事了,还要找到让目标函数最优的那个theta,即下图的梯度下降

批量下降和随机下降的区别就是运算量的区别,避免了m个样本数量过大带来计算量过大的问题,这么说,小样本是否是可以用枚举来满足目标函数最小的?

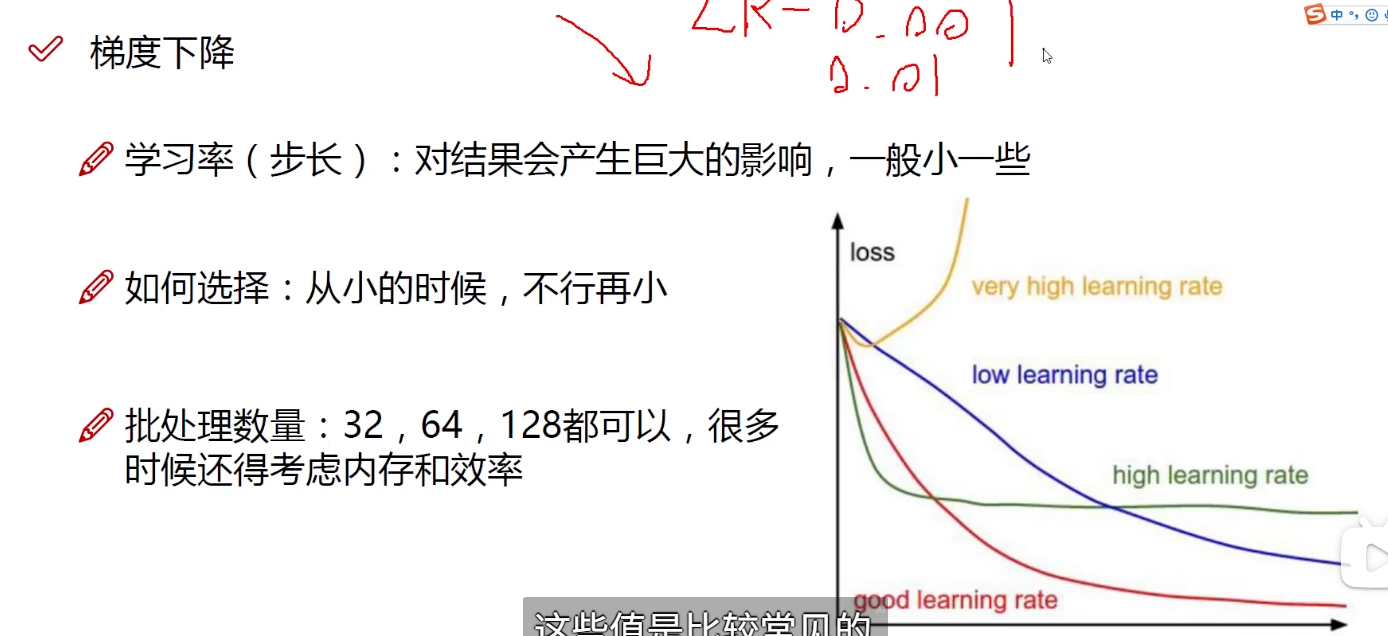

步长就是学习率

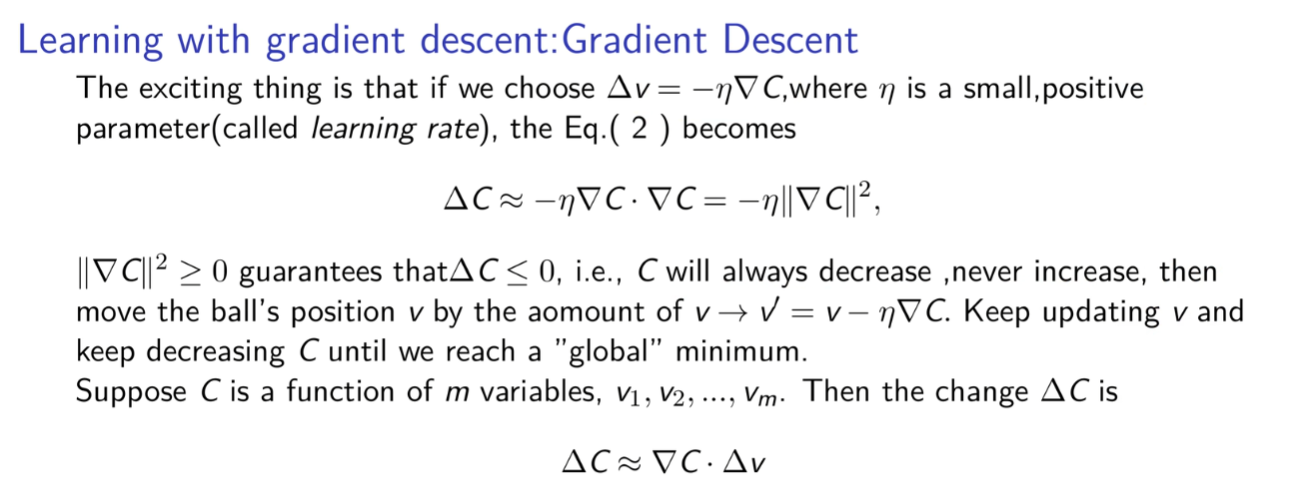

这里也侧面帮助理解梯度下降的本质其实就是一个搜索策略,每次将自变量往梯度的方向求解计算,然后直到目标函数不怎么变化

利用一个较小的值就可以约束目标函数的变化,就判断为收敛,比如设置一个阈值tolerance=1e-6

# 检查是否收敛

if abs(prev_loss - current_loss) < tolerance:

no_improvement_count += 1

else:

no_improvement_count = 0