多语言的视频转换翻译,最大的难点是声音、画面、字幕对齐,不同语言的语速和表达习惯差异巨大,一句3秒的中文,翻译成英文可能需要4秒,即便同种语言,不同发音人,所需时长也不同。这就导致了配音时长和原始字幕时长不匹配,音画开始"各说各话"。

一、自动化路上的"拦路虎"

最完美的解决方案是帧级精修,使用专业软件,像个后期剪辑师一样,但这违背了我们追求"自动化"和"批量化"的初衷。

我的目标很明确:为那些不需要影院级精度的普通视频,找到一种能够大规模、自动化处理的"凑合"方案。 我愿意牺牲一点点的播放流畅度,来换取整个工作流的效率。

然而,当我真正开始将这个想法付诸实践时,才发现真正的挑战并非来自核心算法,而是来自处理过程中无处不在的"意外"。

二、理解视频时间与帧的语言

在深入代码之前,我们必须先掌握视频处理的"底层语言"。否则,FFmpeg 的参数对我们来说就像是神秘的咒语。

2.1 基础:帧、帧率

- 帧 (Frame):视频的本质是连续播放的静态图像。每一张图像就是一"帧"。

- 帧率 (FPS):指每秒钟显示的帧数。30 FPS意味着每秒有30张图像闪过。帧率越高,画面感觉越流畅。

2.2 时间的心跳:PTS 与 DTS

这是整个视频同步问题的核心。在视频流中,每一帧都带有时间戳,告诉播放器何时处理它。主要有两种时间戳:

- DTS (Decoding Timestamp - 解码时间戳) :这是给解码器看的时间戳。它规定了帧被解码的顺序。可以把它想象成工厂里零件的"加工顺序号"。

- PTS (Presentation Timestamp - 播放时间戳) :这是给播放器看的时间戳。它规定了帧被显示在屏幕上的顺序。可以把它想象成成品的"上架时间表"。

在大多数简单视频中,DTS和PTS的顺序是一致的。但为了压缩效率,现代视频编码(如H.264/265)引入了P帧 (预测帧)和B帧(双向预测帧)。

B帧需要参考它前面和后面 的帧才能解码。这就导致了一个有趣的情况:一个B帧的解码 (DTS)必须晚于它所参考的未来P帧,但它的播放 (PTS)却必须早于那个P帧。因此,帧的解码顺序(DTS)和播放顺序(PTS)可能不一致。

这对我们意味着什么? 当我们对视频进行裁切和变速时,我们实际上是在粗暴地干预这个精心设计的时间体系。如果处理不当,就会产生花屏、绿屏、卡顿等各种"灵异事件"。

2.3 播放的节奏:CFR vs VFR

- CFR (Constant Frame Rate - 恒定帧率):像节拍器一样,每一帧的持续时间都完全相同。恒定30帧率的视频,每一帧精确地持续1/30秒。

- VFR (Variable Frame Rate - 可变帧率):像一个随性的鼓手,每一帧的持续时间可能不同。手机拍摄的视频常常是VFR。

这对我们意味着什么? VFR是视频编辑的噩梦。在CFR视频中,时间 = 帧号 / 帧率,计算简单。但在VFR视频中,你无法通过帧号推算时间,必须完全依赖每一帧的PTS。我们的变速操作,本质上就是将一个视频流,通过修改PTS,变成一个VFR的视频流。因此,我们必须让FFmpeg在后续处理中完全理解并尊重这个新的、不规则的VFR时间体系。

三、代码设计思想与整体架构

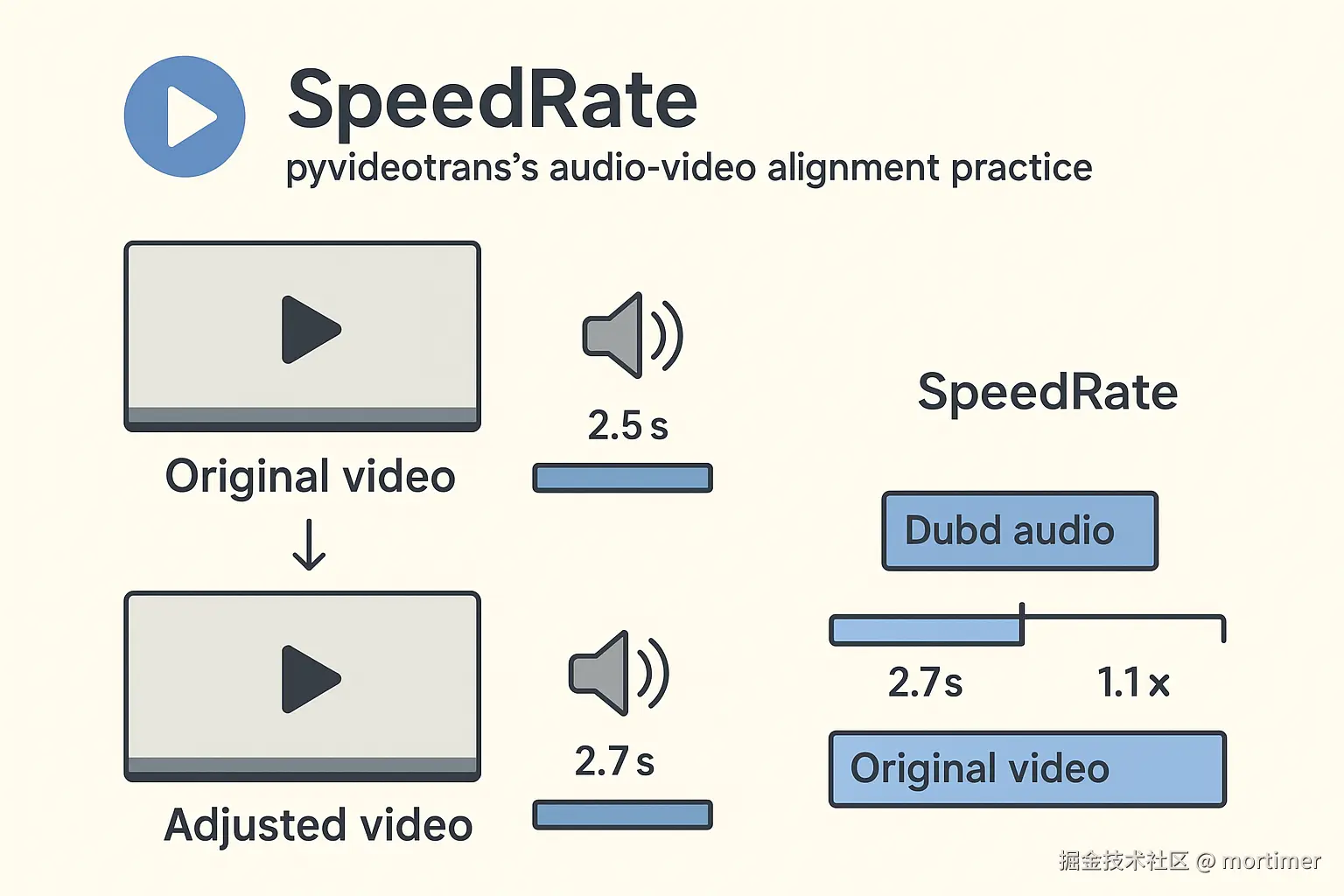

模块的核心思想很简单:当配音(B)比原声(A)长时,时间就不够用了。怎么办?要么让配音(B)"快点说",要么让画面(A)"慢点播" 。

为了避免单一调整过于极端,我设计了四种策略模式,用户可以根据需求灵活选择:

- 音频加速 + 视频慢速(混合模式)

- 仅音频加速

- 仅视频慢速

- 无变速(纯净拼接模式)

这个设计就像一个弹性的时间管理系统,通过在音频、视频和静默期之间"借贷"时间,来达到一个可接受的平衡。

整个模块被封装在 SpeedRate 类中,这是一个典型的面向对象设计,将复杂的状态和操作内聚在一起。其设计哲学可以总结为:分而治之,步步为营,层层校验。

- 分而治之 :将复杂的音视频同步问题拆解为五个独立的、顺序执行的阶段:

数据准备、调整计算、音频执行、视频执行、时间轴重建与合并。每个阶段都有明确的输入和输出。 - 步步为营 :前一个阶段的产出是后一个阶段的输入。例如,

_prepare_data准备好的基础时长是_calculate_adjustments决策的依据;而后者计算出的理论目标时长,则是_execute_...系列函数执行的蓝图。 - 层层校验:在关键节点,特别是与外部工具(FFmpeg、文件系统)交互时,充满了防御性编程。比如检查文件是否存在且大小正常、探测视频片段的真实物理时长、标准化音频参数等。

run() 方法:流程的指挥官

run() 方法是整个流程的总入口和指挥官。它的逻辑清晰地体现了上述设计哲学:

python

# 伪代码: SpeedRate.run()

def run(self):

# 如果无需任何变速,走一个简化的纯拼接流程

if not self.shoud_audiorate and not self.shoud_videorate:

self._run_no_rate_change_mode()

return ...

# [阶段1] 数据准备:清洗原始字幕数据,计算各种时长

self._prepare_data()

# [阶段2] 决策计算:根据策略,为每个片段计算理论目标时长

self._calculate_adjustments()

# [阶段3] 执行音频加速:根据理论目标,用FFmpeg处理音频

self._execute_audio_speedup()

# [阶段4] 执行视频处理:裁切、变速、再拼接视频,并获取真实物理时长

clip_meta_list = self._execute_video_processing()

# [阶段5] 时间轴重建与音频合并:根据视频处理的真实结果,重新生成音频片段列表

audio_concat_list = self._recalculate_timeline_and_merge_audio(clip_meta_list)

# [最终阶段] 总装与交付:拼接音频,并做最后的音视频对齐检查

if audio_concat_list:

self._finalize_files(audio_concat_list)

return self.queue_tts # 返回更新了时间轴的字幕数据这种结构使得代码易于理解和维护。如果视频处理出错了,我们只需要关注 _execute_video_processing 及其调用的相关函数。如果最终时间轴对不上,问题很可能出在 _recalculate_timeline_and_merge_audio。

四、从代码到命令

现在,深入到战术执行层面,看看代码是如何将理论转化为精确的命令行的。

预先 _prepare_data 数据清洗

主要是数据的清洗和计算。比如,代码会预先找出并合并那些时长小于40毫秒的"幽灵"片段,因为用FFmpeg对这么小的片段再进行裁切和setpts处理,极易出错。这是我们遇到的第一个工程问题:防患于未然比事后补救更重要。在决策阶段,模块会计算出每个片段的理论目标时长,形成一份"施工图纸"。

4.1 _execute_video_processing: 视频处理的核心战场

这个函数是整个模块最复杂、也最能体现工程深度的地方。它首先调用 _create_clip_meta 生成一个任务列表,然后使用多线程池并发执行 _cut_to_intermediate 函数来处理每个任务。

_create_clip_meta:绘制作战地图

这个函数的作用是遍历所有字幕,将整个视频分解为两种类型的片段:sub(对应有字幕的部分)和 gap(对应字幕间的静默期),并为每个片段生成一个包含所有必要信息的"任务描述"。

_cut_to_intermediate:单兵作战单元

这个函数负责生成最终的FFmpeg命令并执行它。以两个典型命令为例进行剖析:

命令示例1:一个不变速的gap片段

bash

ffmpeg -hide_banner -ignore_unknown -threads 0 -y \

-i F:/.../novoice.mp4 \

-ss 00:00:06.514 -t 0.559 \

-an -c:v libx264 -x264-params "keyint=1:min-keyint=1:scenecut=0" \

-preset ultrafast -crf 23 -pix_fmt yuv420p \

-vf "setpts=PTS" \

-vsync vfr \

F:/.../00001_gap.mp4命令示例2:一个需要慢放的sub片段

bash

ffmpeg -hide_banner -ignore_unknown -threads 0 -y \

-i F:/.../novoice.mp4 \

-ss 00:00:35.780 -t 1.772 \

-an -c:v libx264 -x264-params "keyint=1:min-keyint=1:scenecut=0" \

-preset ultrafast -crf 23 -pix_fmt yuv420p \

-vf "setpts=1.18397...*PTS" \

-vsync vfr \

F:/.../00008_sub.mp4参数逐一解密:

-hide_banner -ignore_unknown -y: FFmpeg的辅助参数。-y表示覆盖输出文件,-hide_banner隐藏版本信息,-threads 0让FFmpeg自动利用所有CPU核心。-i ... -ss ... -t ...:-i后跟输入文件。-ss和-t放在-i之后,确保精确到帧 的裁切。00:00:06.514是起始时间,0.559是持续时长(秒)。-an: 去除音频流,因为我们处理的是无声视频。-c:v libx264 -preset ultrafast -crf 23 -pix_fmt yuv420p: 视频编码设置。使用libx264编码器,ultrafast预设以追求最快速度(因为是中间文件),crf 23是可接受的质量/体积平衡点,yuv420p是兼容性最好的像素格式。-x264-params "keyint=1...": 这是我们对抗DTS/PTS错乱的"核武器"。它强制每一帧都是I帧,牺牲压缩率换取后续拼接的绝对稳定。-vf "setpts=...*PTS": 视频变速的核心。- 在命令1中,

setpts=PTS是一个至关重要的"空操作"。它确保了即使不变速,该片段的PTS也经过了"格式化",与变速片段的PTS体系保持一致。 - 在命令2中,

setpts=1.18397...*PTS则是实际的慢放操作。这个精确到小数点后多位的数字,正是由_calculate_adjustments函数计算出的final_video_duration_theoretical / source_duration的结果。

- 在命令1中,

-vsync vfr: 对我们变速操作的最终"确认"。它告诉编码器:"我们用setpts创造了一个VFR流,请你原样保留这些时间戳,不要自作主张地复制或丢弃帧。"

但真正的魔鬼在于一致性。如果一个视频片段使用了 setpts=1.5*PTS,而另一个(比如静默期片段)忘记使用或者直接复制,那么它们的PTS基准就完全不同。当用concat拼接这两段视频时,FFmpeg会彻底"精神错乱"。最终的视频可能会在拼接处卡住,或者时间轴跳跃,几分钟的视频可能只播放几十秒就结束了。

解决方案 :在_cut_to_intermediate函数中,为每一个裁切的片段,无论是否需要变速,都强制加上setpts滤镜。不需要变速的,就使用 setpts=PTS。这相当于对所有片段的时间戳进行了一次"格式化",确保它们在拼接时使用的是同一套"语言"。

通过这一套组合拳,我们确保了每个裁切出来的视频小片段都是高质量的"标准零件",为后续的"总装"打下了坚实的基础。

五、从理论到残酷的工程现实

理论讲完了,现在让我们进入真正的"战区"。一个看似完美的流程,在面对成百上千个来源不一、质量参差不齐的文件时,会瞬间崩溃。

5.1 音频采样率的"时间炸弹"

问题描述:我们的配音可能来自不同的TTS引擎,一个返回48000Hz采样率的mp3音频,另一个返回24000Hz的wav音频;而我们自己生成的静音片段是44100Hz,即便来源音频确定各项参数一致,但有的需加速,有的无需加速,也会导致各种差异。

当把这些不同采样率不同格式的音频片段直接交给FFmpeg的concat拼接时,一个"时间炸弹"就被引爆了。最终,你可能会得到一个时长从2分钟暴增到2小时、内容全是刺耳噪音的怪物文件。

解决方案 :强制标准化 。在 _ffmpeg_concat_audio 函数中,定义了全局的音频参数(AUDIO_SAMPLE_RATE = 44100, AUDIO_CHANNELS = 2)。在拼接前,它会多线程地遍历所有待拼接的音频片段,将它们全部重新编码为统一的采样率、声道和格式。这虽然增加了一点处理时间,但它彻底拆除了这个最隐蔽、破坏性最强的炸弹。

5.2 损坏片段的"瘟疫"

问题描述 :在大量的自动化处理中,总会有意外。网络波动或TTS端限流导致TTS配音失败或文件下载不完整、磁盘错误导致视频片段写入失败、X*PTS时倍数过大或过小、裁剪的时间范围只有几毫秒、或时间范围超过视频时长......最终结果就是产生了一堆体积为0字节或仅有几百字节的"损坏片段"。如果你不加处理,直接把这些"病人"和健康片段一起送入concat的拼接列表,整个拼接过程很可能会因为一个"坏掉"的文件而全盘崩溃。

解决方案 :严格的准入审查 。在代码的多个环节,都加入了严格的检查:Path(task['out']).exists() and Path(task['out']).stat().st_size > 1024。只有存在且大小超过1KB的文件,才有资格进入最终的拼接列表。这种主动过滤,远比被动地等待FFmpeg报错要高效和稳定。

1024B是个经验值,可播放的至少包含一帧画面的mp4,尺寸肯定大于1k,小于说明损坏了,直接丢弃

5.3 无处不在的try-except:最后的防线

你可能注意到代码里有很多try-except。是的,这看起来"丑陋",但对于一个要处理大量不可控输入的自动化流程来说,这是保证"健 '健壮性"的务实选择。

在实施了上述所有主动预防措施后,try-except就是我们最后的安全网。一个片段的处理失败(比如某个配音文件就是无法被任何解码器读取),不应该导致整个长达一小时的视频任务崩溃。通过捕获异常,我们可以记录错误,并用一个等长的静音片段来替代失败的部分,保证主流程能继续走下去。

总结与反思

这个模块是我在追求自动化效率过程中的一个产物。它远远达不到商业标准。它的变速处理可能会带来一定的音质或画质损失,它的对齐也只是"片段级"而非"帧级"。

但它最大的优点在于务实和高效。它将一个复杂的、需要大量人工干预的同步问题,变成了一个可配置、可自动执行的程序。对于那些内容价值远大于制作精度的视频(例如在线课程、信息分享、新闻资料等),这个模块提供了一个足够好的、可大规模应用的解决方案。

这整个过程也让我深刻体会到,在工程实践中,我们不应一味追求技术的"最优解",而应根据实际需求,在质量、成本和效率之间找到那个最合适的"平衡点"。更重要的是,一个稳健的自动化流程,其复杂性往往不在于核心算法的精妙,而在于对底层原理的深刻理解和对无数种潜在错误的周全防御。