一、 核心问题

大语言模型(LLMs)面临的一个根本性局限:固定上下文窗口无法支持长期、多轮对话的一致性。即使模型上下文长度不断增加,这只能延缓而非根治问题,尤其是在对话主题不连续的真实场景中,关键信息容易被海量无关内容淹没。

遗忘核心用户偏好与事实

案例1:遗忘核心用户偏好与事实 :

第一轮对话(周一):

用户:"我喜欢吃素食,而且对乳制品过敏。"

助理:"好的,已为您记录。我会为您推荐素食且无乳制品的食谱。"

问题分析:助理的推荐与用户明确声明的偏好完全矛盾。这不仅提供了无用信息,更严重的是损害了用户的信任。用户会感到困惑甚至失望:"它明明知道我的情况,为什么还这样建议?" 这种体验使得建立长期、可靠的对话关系变得不可能。

第二轮对话(周五): 经过几天的闲聊、工作讨论等大量对话后,上下文窗口已被填满,周一的对话记录已被挤出。

用户:"今晚有什么餐厅推荐吗?"

助理:"这家牛排馆很受欢迎,他们的奶油蘑菇汤是招牌。"

案例2:无法维护连贯的对话状态与任务进度:

对话初期:用户与助理详细讨论了目的地(日本)、出行时间(10月)、预算(中等),并初步决定避开黄金周。

对话中期:双方开始深入讨论关西地区(大阪、京都、奈良)的行程安排,涉及大量景点、交通和住宿信息。此时,初期关于"避开黄金周"的共识已被挤出上下文窗口。

对话后期:用户说:"那我们最终把行程定在10月初吧,这样能玩得尽兴些。"助理回应:"好的,已为您将行程安排在10月1日至7日。" (这恰好是日本的黄金周,人流量最大、费用最高的时候)。

问题分析:助理忘记了早期对话中最重要的约束条件之一("避开黄金周"),导致任务推进方向与用户的初始目标背道而驰。这使得AI无法成为可靠的任务协作者。

案例3:主题穿插导致关键信息被淹没:

用户提及:"我是素食主义者。"(关键事实A)

随后,用户就一个复杂的编程问题与助理进行了长时间的讨论。(大量无关信息B,填满了上下文窗口)

几小时后,用户回到最初话题:"我有点饿了,有什么推荐的吗?"此时,上下文窗口里充满了编程讨论B,而关键事实A早已被挤出。助理只能基于最近的上下文(编程)进行回应,要么无法理解"饿了"的请求,要么基于无效信息给出推荐。

问题分析:固定窗口是一种"先进先出"的堆栈模型,无法智能地识别和保留跨主题的、高优先级的信息。它将所有历史信息等同视之,导致最关键的信息在最需要的时候反而无法被获取。

二、 提出的解决方案

论文提出了两种创新的内存架构:

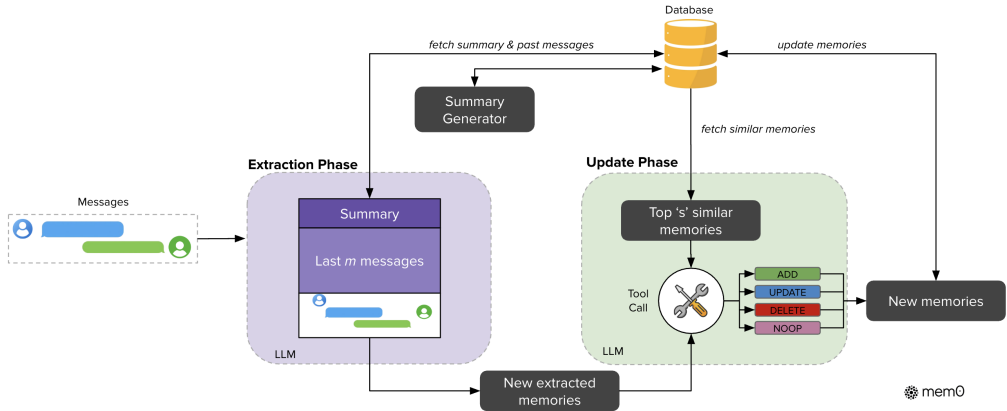

- Mem0(基础架构):一个可扩展的内存中心式架构。其核心在于对持续对话进行动态提取、整合与检索关键信息,而非被动地存储全部历史。

- Mem0g(增强变体):在 Mem0

基础上,引入了基于图形的内存表示,旨在更好地捕捉和推理对话元素(如实体、事件)之间复杂的关系结构。

三、 实验验证与关键发现

研究在 LOCOMO 基准上进行了全面评估,与六大类基线方法进行了系统对比。实验结果凸显了 Mem0 系列方法的双重优势:

• 性能优势:

- 在单跳、时序、多跳和开放域四种问题类型上,Mem0 和 Mem0g 一致优于所有现有内存系统。

- 具体数据:Mem0 在 LLM-as-a-Judge 指标上比 OpenAI 的内存功能相对提升 26%;Mem0g 的总体得分比基础 Mem0 再高出约 2%。

单跳问题:答案直接包含在单一轮对话中的简单事实查询。用于测试基础的事实检索能力。

示例:用户之前提到"我最喜欢的颜色是蓝色"。问题:"用户最喜欢的颜色是什么?"

多跳问题:答案需要综合跨越多个对话轮次甚至多个会话的分散信息才能得出。用于测试信息整合与推理能力。

示例:用户在第一场会话中说"我打算去巴黎旅行",在第二场会话中说"我预订了艾菲尔铁塔的门票"。问题:"用户要去哪里旅行并预订了艾菲尔铁塔的门票?"

时序问题:问题涉及事件的时间顺序、持续时间或相对发生时间。用于测试记忆系统对时间线的理解。

示例:用户先提到"我上周去了健身房",然后说"我昨天感觉很酸痛"。问题:"用户是在感觉身体酸痛之前还是之后去的健身房?"

开放域问题:问题可能涉及对对话内容的总结、推断或需要结合外部知识来回答。用于测试记忆系统在更广泛语境下的应用能力。

示例:基于用户描述的多个工作挫折,问题:"你认为用户最近的工作状态怎么样?"

• 效率优势:

- 与处理整个对话历史的"全文方法"相比,Mem0 实现了惊人的效率提升:p95 延迟降低 91%,同时节省超过 90% 的 token 成本。

- 这证明了 Mem0 在高端推理能力与实际部署的苛刻要求(低延迟、低成本)之间取得了绝佳的平衡。

四、 核心结论与意义

论文的最终结论强调,结构化、持久化的内存机制是实现长期对话连贯性的关键。Mem0 和 Mem0g 的成功验证,为构建更可靠、高效且能够真正"记住"对话历史的 LLM 驱动型 AI 智能体指明了方向,具有重要的学术价值和广阔的工业应用前景。