本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

1.背景

随着22年底chatgpt的重磅推出,大语言模型(LLM)发展迅猛,从最初的"大号文本预测器"(会听,会说)一步步成长为如今能处理复杂任务的"智能体"基石(会想、会做)。25年初deepseek点燃了国人对大模型的热情,不知您是否好奇Transformer、自注意力self-attention、LLM、Token、向量化Embedding、涌现、Pre-training、有监督微调SFT、RLHF、MOE、MLA、多模态、思维链CoT、FunctionCalling、RAG、MCP协议、AIAgent、A2A协议等概念层出不穷,到底在解决什么问题?

作为起始篇将与您一起从宏观上理解下大模型的基本脉络,并基于当下理解和认知,从工程师视角制定学习计划,欢迎关注交流讨论!

该系列将从工程师视角,一步步去学习并理解大模型相关概念,再到会用,深入理解,掌握原理,动手实践,解决实际问题。

1)概念:这些层出不穷的概念背后到底在解决什么问题?

2)会用:除了知识问答与会话,还能用大模型解决什么问题?有什么局限性?

3)理解:大语言模型vs工程开发在思维方式上有什么区别?

4)原理:大语言模型到底是如何工作的?

5)动手实践:如何从0开始构建大语言模型?

6)实际问题:如何用大语言模型创造性解决业务场景实际问题?

7)学习计划:工程师如何一步步掌握大模型背后的理论知识、算法模型?

2.概念:什么是LLM大语言模型?

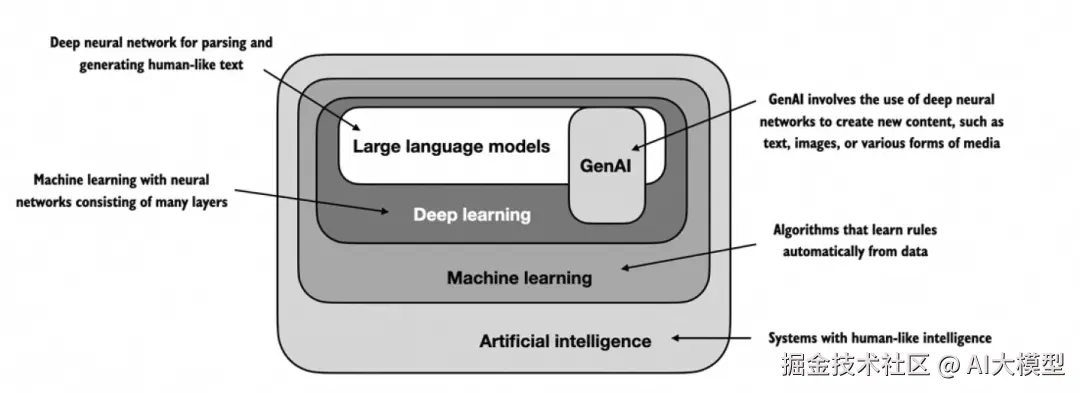

大语言模型(Large Language Model, LLM)是一种使用大量文本数据训练的深度学习模型,其核心能力是可以理解和生成人类语言。大模型 = 海量数据 + 深度学习算法 + 超强算力。人工智能AI、机器学习、深度学习、大语言模型LLM、生成式人工智能GenAI关系大致如下:

近几年大语言模型演变历程大致如下:

3.会用:大语言模型能做什么?

3.1应用场景

大模型(Large Language Models, LLMs)的应用非常广泛,并且正以前所未有的速度渗透到各个行业。它们不仅能处理自然语言任务,还能理解和生成代码、进行多模态交互,甚至作为智能体(Agent)自主决策和执行任务。

| 应用领域 | 具体场景 | 核心价值/案例 |

| 医疗与健康 | 智能问诊与分诊、医学影像分析、药物研发与挖掘、健康管理、医院运营优化 | 加速药物研发进程,提升诊疗效率,优化患者服务体验 |

| 软件开发 | 代码生成与补全、Bug调试与修复、代码解释、不同编程语言转换、自动化测试 | 提升开发效率,降低代码缺陷,加速学习进程 |

| 教育与科研 | 个性化辅导、作业批改、语言学习、科学计算、论文摘要与翻译 | 因材施教,提升学习效率,辅助科学研究 |

| 工业与制造 | 智能决策支持、生产流程优化、质量控制、 Predictive Maintenance(预测性维护)、供应链管理、研发设计 | 提升生产效率,降低故障率,缩短研发周期,优化能耗 |

| 能源与电力 | 虚拟电厂调度、电网负荷预测、能源交易、无功补偿优化、电能质量管理 | 提升电网稳定性,促进新能源消纳,实现精准的需求响应和调度 |

| 内容创作与 媒体 | 新闻撰稿、剧本创作、营销文案、翻译、摘要生成 | 提升内容生产效率和创意多样性 |

| 客户服务与营销 | 智能客服、个性化推荐、市场洞察分析、销售话术生成 | 提升客户满意度,降低人力成本,实现精准营销 |

| 法律司法 | 法律条文检索与解读、案例分析与裁判文书生成、合同审查与智能起草、案件焦点识别与证据分析 | 提升案件处理效率和准确性,降低人工工作负荷 |

| 航天高科技 | 在轨操作辅助、故障诊断与处置、航天员心理支持、天地协同智能问答 | 为在轨工作提供智能化、专业化支持 |

| 金融与风控 | 智能投顾、风险评估、反欺诈、信贷审批、市场行情分析 | 提升风险控制能力,优化投资决策,自动化业务流程 |

| 个人助理与娱乐 | 日程管理、信息检索、旅行规划、游戏NPC对话生成、写诗作画 | 提升生活和工作效率,提供个性化娱乐体验 |

3.2软件开发场景:AI Coding给想法插上翅膀?

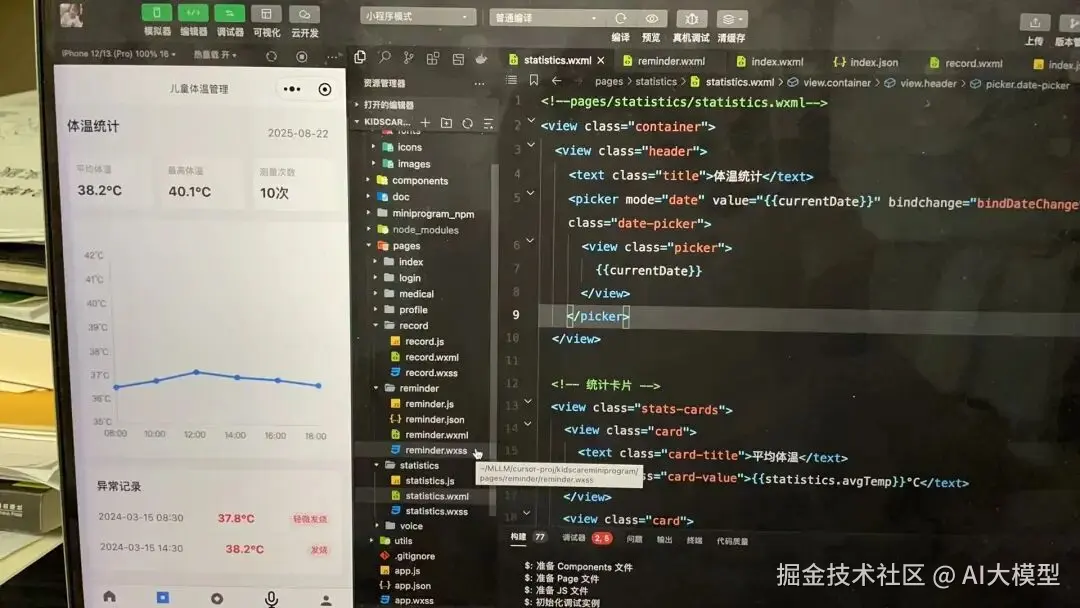

随着大模型辅助编码技术发展,即使您不会编程,也可以借助AICoding把想法快速转换成可运行的代码。这里用一个生活中的案例来看看AI如何给想法插上翅膀?从0实现一个微信小程序原型系统基本在小时级别就能完成。

3.2.1原始需求:儿童生病体温用药症状观测

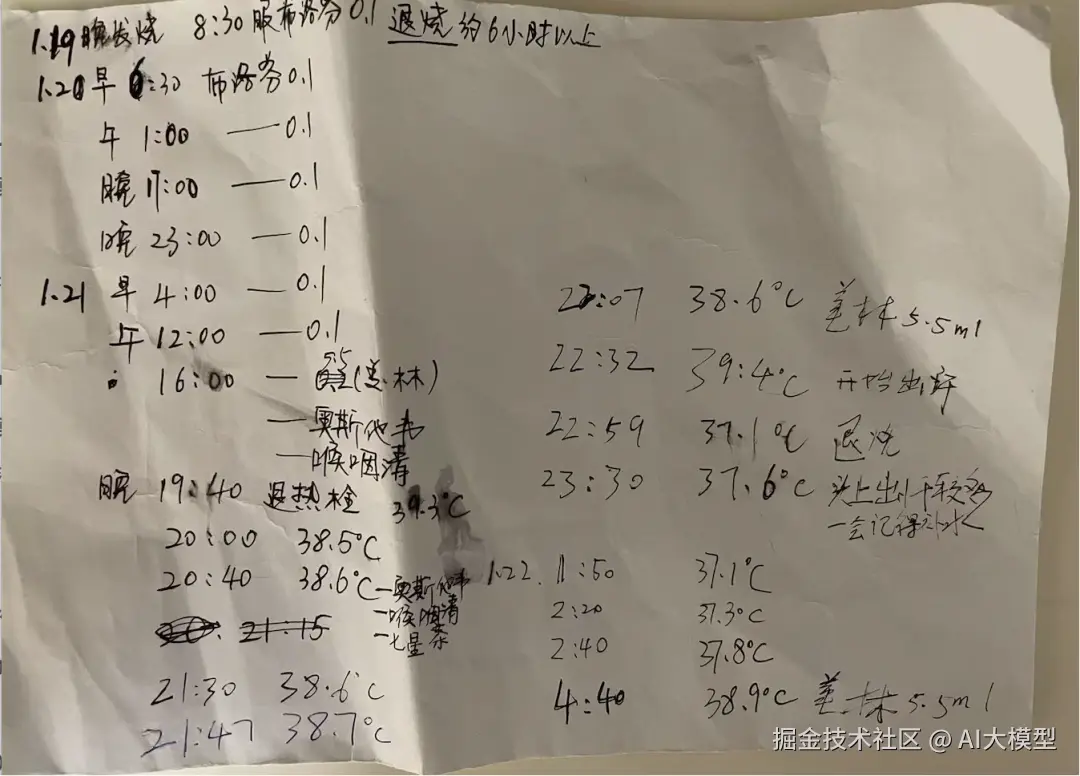

不知宝爸宝妈们在孩子生病发烧期间无比焦虑的场景,恨不得时刻能看看体温是不是降下来了?用退烧药之后能够持续多久?下面是我自己小孩3岁左右一段发烧记录:晚上到凌晨,我和爱人轮流测量体温,用药,观察症状变化情况。

3.2.2AICoding助您0编码实现微信小程序

首先,我没有写过多少前端代码和微信小程序,借助AI编程工具可以帮助我们从生活中实际场景出发--->到想法--->交互图生成--->AI辅助架构、数据库、API设计--->AI辅助生成前后端代码--->原型系统部署调试。

完整的小程序界面及实现过程这里不做赘述(目前开发体验版本),后续文章详细记录下完整的从想法到UED设计,及设计编码实现过程。有兴趣的朋友可以关注讨论。

4.理解:大语言模型工作原理?

4.1工程vs算法:演绎归纳思维差异

归纳与演绎是人类认识事物的两种思维方法,工程与算法是这两种思维方式的典型应用场景。归纳与演绎在工程和大模型算法中的分布是一种有趣的镜像关系:

1)传统工程立足于演绎的确定性,用归纳来应对现实世界的不完美。对于AI研究者而言,明白"演绎"框架(如算法、架构)的突破,才能为更强大的"归纳"能力搭建舞台。

2)大模型算法立足于归纳的概率性,用演绎来框架其学习和约束其行为。对于工程师而言,明白大模型的"归纳"本质,就不会期望它像传统软件一样绝对可靠,从而能更好地设计容错和验证流程。

4.1.1工程思维:演绎为主,归纳为辅

演绎法核心思想:从一般性前提推导出特殊性结论。如果前提为真,且推理过程正确,则结论必然为真。工程化思维解决问题的方式是演绎推导为主,归纳为辅。

推理方向:从一般到特殊(Top-Down)。

关键词:规则、公理、定理、逻辑推导、确定性。

应用场景:软件设计过程(PRD-交互-视觉-架构设计-编码实现)、传统工程(如土木、机械、电子工程)的核心是确定性和可靠性,其思维方式高度依赖演绎法。

严格的设计规范:工程师使用这些定律,结合具体需求(小前提),通过数学计算和逻辑推导,设计出桥梁、芯片或电路(结论)。这个过程是高度演绎的。

可预测性:因为基于确定性定律,工程系统的行为在理论上是可以精确预测的。一座桥能承重多少,在建造之前就可以通过计算得知。

小结:在传统工程中,演绎是"设计师",负责基于属性计算和工程设计完成确定性需求的构建;归纳是"测试/质检员"和"优化师",负责验证和调优。

4.1.2算法思维:归纳为主,演绎为辅

归纳法核心思想:从大量特殊性观察中总结出一般性规律或模式。结论是可能为真的,但不保证绝对正确。大模型算法解决问题的方式是归纳为主,演绎为辅。

推理方向:从特殊到一般(Bottom-Up)。

关键词:模式、趋势、概率、统计、不确定性。

应用场景:大模型(如GPT、BERT等)的本质是从数据中学习统计规律,其核心范式是归纳法。

1)学习过程就是归纳:大模型不预先输入"语法规则"或"世界知识"(大前提)。它通过在海量文本数据(数十亿个特殊样本)中寻找词与词、句与句之间的统计关联(如共现频率、注意力权重),归纳出一套内部的、隐含的"语言模型"和"世界模型"。这个过程完全是从特殊到一般。

2)概率性输出:模型的输出不是确定的真理,而是基于其归纳出的统计分布,计算出的最可能的词序列。它是"可能为真"的,这正是归纳法的特征。

3)涌现能力:模型表现出的推理、创作等复杂能力,并非由程序员显式编码(演绎),而是从数据中归纳涌现出来的,这超出了设计者的精确预期。

演绎的辅助角色:

1)算法框架设计:Transformer的架构、反向传播算法、损失函数等,是研究人员基于数学和计算机科学原理演绎设计出来的。这为归纳学习提供了舞台和规则。

2)提示工程与思维链:用户通过设计精妙的提示(Prompt),试图引导模型激活其内部归纳出的知识,并按照一种类似演绎的逻辑链(Chain-of-Thought)来生成答案。这是在用演绎的形式去驾驭归纳得到的能力。

3)规则约束:在模型输出端,会使用演绎性的规则进行过滤和约束,例如内容安全过滤、格式要求等,以确保输出符合某些确定性标准。

小结:在大模型算法中,归纳是"学生",负责从数据中学习知识;演绎是"教练"和"裁判",负责设计学习方法和设定输出规则。其分布是"归纳为主,演绎为辅"。

最终,最强大的系统将是那些能精巧融合两种范式的系统:用演绎法构建可靠框架,用归纳法汲取数据智慧,从而同时具备严谨性和灵活性。

4.2大语言模型工作原理

LLM的工作原理可以简单理解为一个"基于概率的超级文本生成器"。虽然它们本质上在于"预测下一个词",并需要大量文本进行训练,基于数十亿词汇训练的神经网络,不同于传统的人类编写的软件,没人完全理解其内部机制。大模型训练到推理的大致过程如下。

5.实践:如何从0构建大语言模型?

为什么我们应该构建自己的 LLM?从头开始编码一个 LLM 是理解其工作机制和局限性的绝佳练习。同时,这也使我们具备了对现有开源 LLM 架构进行预训练或微调的知识,以便将其应用于我们特定领域的数据集或任务。

简化的构建流程:篇幅原因这里不做赘述,欢迎关注,后面章节深入学习并拆解。

海量数据 → Transformer架构 + 预训练(自监督学习) → 基座模型 → 有监督微调(SFT) + 对齐优化(RLHF/DPO) → 对话/指令模型。

6.学习计划

为了进一步深入理解大模型工作原理并应用到工程实践中,整理如下学习计划:从数学理论--->编程工具python框架:NumPy/Pandas/PyTorch--->模型与算法理论知识--->工程实践。关键原则:

1)每阶段必须产出可运行代码(拒绝纯理论学习)

2)80%时间投入工程实践(数据处理/部署/监控)

3)成本意识贯穿全程(GPU使用/延迟/吞吐量)

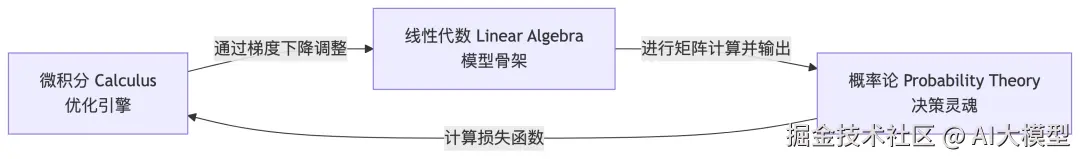

6.1阶段1(1-2周):数学理论vs大模型

数学知识是理解大模型原理的必备内功,回顾下大学和研究生期间数学知识?

1)线性代数:定义了模型的结构和表示方式,用矩阵和向量表示一切,向量、矩阵和张量运算是数据在模型中流动的语言。线性代数提供了如何用"数字块"来表示和操作"概念"的基本语法。

2)概率论:定义了模型的目标和行为方式,预测下一个词的概率分布,理解损失函数、模型评估和不确定性的关键。

3)微积分:定义了模型的学习算法,如何通过计算梯度来优化矩阵中的参数,以更好地完成概率预测的目标)。理解梯度、导数,这是模型优化的基础。

6.2阶段2(1-2周):编程工具与环境

搭建工程化环境 + 建立AI直觉 + 掌握PyTorch工程化开发,具备CV/NLP基础项目能力。

掌握python语言及NumPy (科学计算)、Pandas (数据处理),掌握PyTorch。

了解Hugging Face (模型中心)。

利用阿里云百炼搭建云端环境:基于 PAI DSW 准备在线学习环境

6.3阶段3(6-8周):模型与算法 (核心大脑)

6.3.1机器学习及深度学习基础知识(2-3周)

掌握机器学习、深度学习及NLP基础概念,理解回归、分类、过拟合与欠拟合等基本概念。掌握神经网络(NN)、卷积网络(CNN)、循环网络(RNN)等经典结构。监督学习 vs. 无监督学习,线性回归、逻辑回归、决策树、SVM等经典算法,模型评估方法。

1)书籍:《机器学习》《深度学习》

2)在线课程:李沐《动手学深度学习》(PyTorch版),学习神经网络基础(前向传播、反向传播)、CNN、RNN/LSTM、激活函数、优化算法。

3)实践:使用PyTorch练习所学内容,搭建简单模型。

6.3.2大模型核心技术(4-6周)

重中之重,深入理解Transformer架构及大模型的原理、训练和微调,所有现代AI大模型(如GPT、Llama)的基石,必须深入理解其自注意力Self-Attention机制、Encoder-Decoder结构、位置编码,深度理解Transformer架构论文:《Attention Is All You You Need》,视频学习解读。

1)开源项目:阅读deepseek、qwen等模型的代码或文档,学习GPT、BERT、LLaMA等主流模型的区别与原理,掌握预训练(Pretraining)与微调(Fine-tuning)概念,参数高效微调技术(LoRA、Adapter)。

2)资料推荐:阿里云大模型认证培训课程;李沐《动手学深度学习》。

3)代码实践:尝试实现一个简单的Transformer模块。熟悉预训练(Pre-training)、微调(Fine-tuning)、提示工程(Prompt Engineering)、RLHF(人类反馈强化学习)等核心技术范式。

6.4阶段4(4-6周):工程与实践 (落地能力)

掌握使用大模型构建应用的核心技能,包括RAG、智能体开发等。

1)RAG(检索增强生成):理解RAG架构,学习使用向量数据库(如FAISS、ChromaDB),构建知识库问答系统。

实践项目:搭建一个大模型问答系统(阿里云ACP培训实践项目)。

2)AI智能体(Agent)开发:用LangChain构建一个能联网搜索的智能体。在Coze或Dify上搭建一个多模态工作流应用。完成工具调用,记忆机制。

实践项目:结合业务场景构建一个AI智能体应用。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。