目录

[🚨 摘要](#🚨 摘要)

[1. 背景介绍:为什么需要专业的JVM监控?](#1. 背景介绍:为什么需要专业的JVM监控?)

[1.1 JVM监控的重要性](#1.1 JVM监控的重要性)

[1.2 监控体系的层次结构](#1.2 监控体系的层次结构)

[2. JVM监控体系架构深度解析](#2. JVM监控体系架构深度解析)

[2.1 JVM监控的底层原理:JMX与Attach API](#2.1 JVM监控的底层原理:JMX与Attach API)

[2.2 JVM监控数据分类与采集方式](#2.2 JVM监控数据分类与采集方式)

[3. 命令行工具深度实战](#3. 命令行工具深度实战)

[3.1 jps:JVM进程状态工具](#3.1 jps:JVM进程状态工具)

[3.2 jstat:GC行为实时监控利器](#3.2 jstat:GC行为实时监控利器)

[3.3 jstack:线程问题诊断专家](#3.3 jstack:线程问题诊断专家)

[3.4 jmap & jinfo:内存与配置管理](#3.4 jmap & jinfo:内存与配置管理)

[4. 图形化工具综合应用](#4. 图形化工具综合应用)

[4.1 JConsole:实时监控仪表盘](#4.1 JConsole:实时监控仪表盘)

[4.2 JVisualVM:全方位性能分析平台](#4.2 JVisualVM:全方位性能分析平台)

[4.3 Java Mission Control (JMC):生产级监控解决方案](#4.3 Java Mission Control (JMC):生产级监控解决方案)

[5. 综合实战:电商系统性能问题诊断](#5. 综合实战:电商系统性能问题诊断)

[5.1 问题场景描述](#5.1 问题场景描述)

[5.2 多工具联合诊断流程](#5.2 多工具联合诊断流程)

[5.3 详细诊断过程](#5.3 详细诊断过程)

[5.4 诊断结果与优化方案](#5.4 诊断结果与优化方案)

[5.5 优化效果验证](#5.5 优化效果验证)

[6. 高级监控技巧与最佳实践](#6. 高级监控技巧与最佳实践)

[6.1 容器环境下的监控适配](#6.1 容器环境下的监控适配)

[6.2 监控指标自动化采集与分析](#6.2 监控指标自动化采集与分析)

[6.3 性能基准测试与容量规划](#6.3 性能基准测试与容量规划)

[7. 总结与展望](#7. 总结与展望)

[7.1 核心要点总结](#7.1 核心要点总结)

[7.2 未来发展趋势与挑战](#7.2 未来发展趋势与挑战)

[8. 参考链接与资源](#8. 参考链接与资源)

🚨 摘要

Java应用的稳定性和性能直接影响业务可用性。本文将深度解析JVM性能监控(JVM Performance Monitoring) 与故障诊断(Fault Diagnosis) 的完整技术栈。从基础的命令行工具(Command-line Tools) (jps, jstat, jstack, jmap, jinfo)到强大的图形化界面(GUI Tools)(JConsole, JVisualVM, Java Mission Control),通过原理详解、实战演示和结果分析,构建从快速响应到深度剖析的立体化监控方案。文章包含大量流程图、监控示意图和实战代码块,为Java工程师提供一套完整的生产环境问题排查指南。

1. 背景介绍:为什么需要专业的JVM监控?

在分布式系统和微服务架构盛行的今天,Java应用面临的性能挑战日益复杂。简单的系统资源监控已无法满足深度问题诊断的需求。JVM作为Java应用的运行基石,其内部状态直接决定了应用的表现。

1.1 JVM监控的重要性

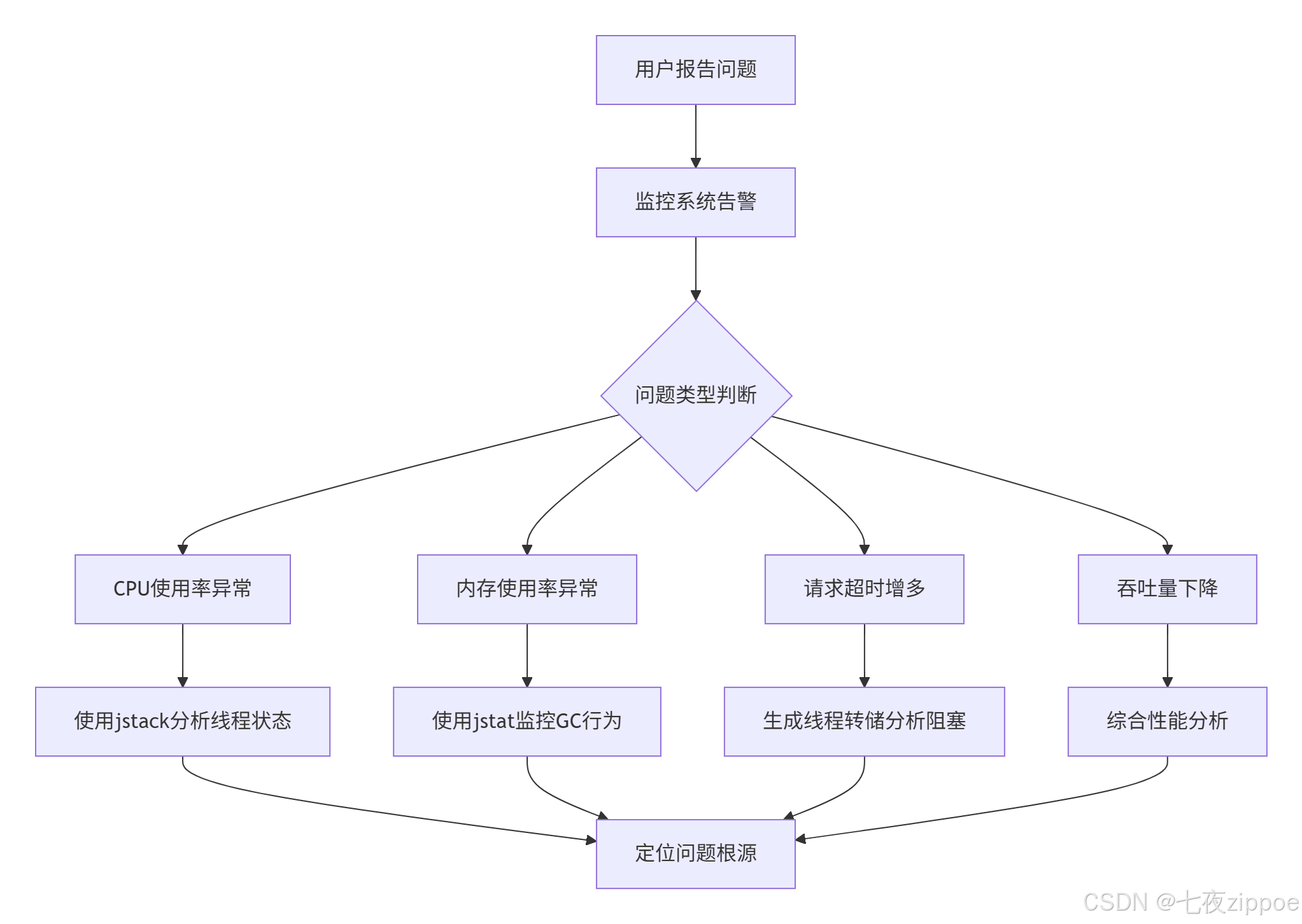

典型的生产环境问题场景:

-

🔥 内存泄漏(Memory Leak) :应用运行数天后出现

OutOfMemoryError,服务不可用 -

⚡ CPU使用率飙升:单个线程死循环导致整个容器资源耗尽

-

🚧 线程死锁(Deadlock):关键业务流程完全卡死,用户请求超时

-

🗑️ GC过频(Frequent GC):垃圾回收成为系统瓶颈,平均响应时间飙升

-

📈 性能退化(Performance Degradation):系统运行时间越长,性能越差

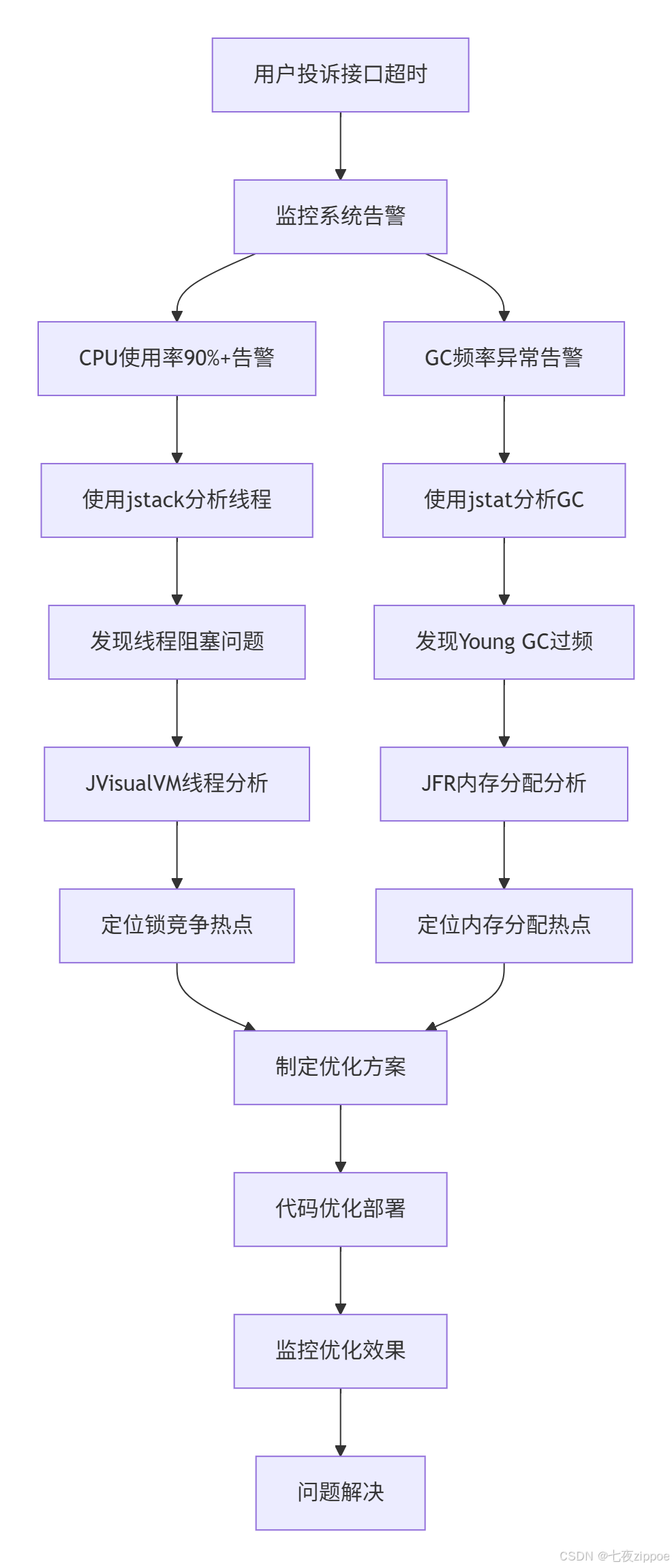

图1:JVM故障诊断基本流程

1.2 监控体系的层次结构

一个完整的JVM监控体系应该包含以下四个层次:

| 监控层次 | 监控内容 | 工具示例 | 监控频率 |

|---|---|---|---|

| 基础设施层 | CPU、内存、磁盘、网络 | top, vmstat, iostat | 实时 |

| JVM运行时层 | 堆内存、GC、线程、类加载 | jstat, jstack, jmap | 实时/定期 |

| 应用性能层 | 响应时间、吞吐量、错误率 | APM工具、自定义指标 | 实时 |

| 业务逻辑层 | 关键业务指标、业务流程 | 业务监控系统 | 实时/定期 |

2. JVM监控体系架构深度解析

2.1 JVM监控的底层原理:JMX与Attach API

Java管理扩展(JMX - Java Management Extensions)是JVM监控的技术基石。通过JMX,我们可以暴露和访问JVM的内部运行数据。

JMX架构核心组件:

-

MBean(Managed Bean):被管理的资源对象

-

MBeanServer:MBean的注册中心

-

Connector:客户端连接器

-

Adaptor:协议适配器

java

// 简单的MBean示例:系统配置监控

public interface SystemConfigMBean {

int getThreadCount();

long getHeapMemoryUsed();

long getNonHeapMemoryUsed();

int getLoadedClassCount();

double getSystemLoadAverage();

}

@Component

public class SystemConfig implements SystemConfigMBean {

private final ThreadMXBean threadMXBean;

private final MemoryMXBean memoryMXBean;

private final ClassLoadingMXBean classLoadingMXBean;

private final OperatingSystemMXBean osMXBean;

public SystemConfig() {

this.threadMXBean = ManagementFactory.getThreadMXBean();

this.memoryMXBean = ManagementFactory.getMemoryMXBean();

this.classLoadingMXBean = ManagementFactory.getClassLoadingMXBean();

this.osMXBean = ManagementFactory.getOperatingSystemMXBean();

}

@Override

public int getThreadCount() {

return threadMXBean.getThreadCount();

}

@Override

public long getHeapMemoryUsed() {

return memoryMXBean.getHeapMemoryUsage().getUsed();

}

@Override

public long getNonHeapMemoryUsed() {

return memoryMXBean.getNonHeapMemoryUsage().getUsed();

}

@Override

public int getLoadedClassCount() {

return classLoadingMXBean.getLoadedClassCount();

}

@Override

public double getSystemLoadAverage() {

return osMXBean.getSystemLoadAverage();

}

}代码清单1:自定义MBean实现监控指标暴露

JMX服务注册示例:

java

@Configuration

public class JmxConfig {

@Bean

public MBeanServer mbeanServer() {

return ManagementFactory.getPlatformMBeanServer();

}

@Bean

public SystemConfig systemConfig() {

return new SystemConfig();

}

@Bean

public ObjectName systemConfigObjectName() throws MalformedObjectNameException {

return new ObjectName("com.example.monitor:type=SystemConfig,name=systemConfig");

}

@Bean

public MBeanExporter mbeanExporter(SystemConfig systemConfig, ObjectName objectName)

throws InstanceAlreadyExistsException, MBeanRegistrationException, NotCompliantMBeanException {

MBeanExporter exporter = new MBeanExporter();

Map<String, Object> beans = new HashMap<>();

beans.put(objectName.toString(), systemConfig);

exporter.setBeans(beans);

return exporter;

}

}代码清单2:JMX Bean注册配置

Attach API 允许外部进程动态连接到运行中的JVM,这是命令行工具能够获取目标JVM信息的关键。

java

// Attach API使用示例

public class JvmAttacher {

public static void attachAndExecute(String pid, String... commands) throws Exception {

VirtualMachine vm = null;

try {

// 连接到目标JVM

vm = VirtualMachine.attach(pid);

// 加载管理代理

String agent = vm.getSystemProperties().getProperty("java.home") +

"/lib/management-agent.jar";

vm.loadAgent(agent, "com.sun.management.jmxremote");

// 执行命令

for (String command : commands) {

vm.startLocalManagementAgent();

}

} finally {

if (vm != null) {

vm.detach();

}

}

}

}代码清单3:使用Attach API连接JVM

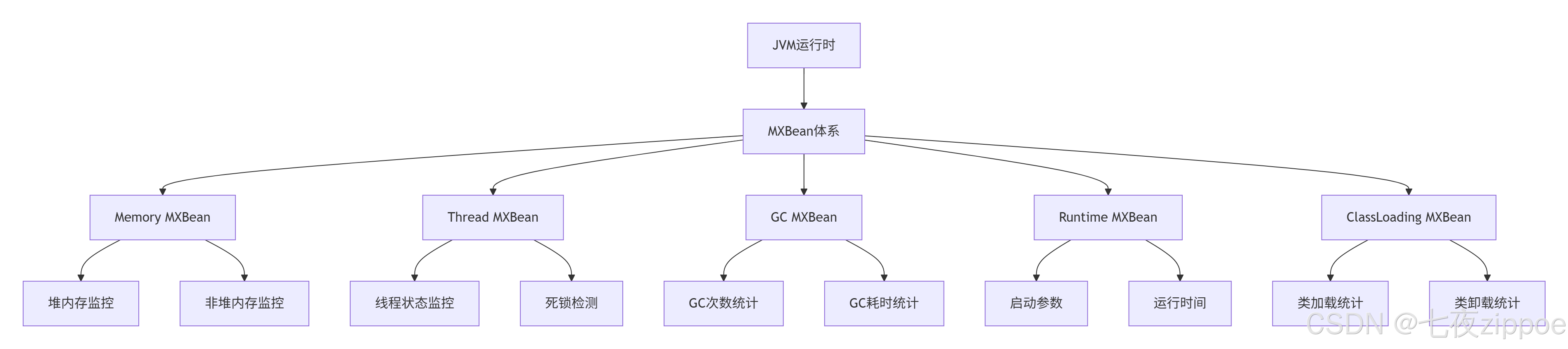

2.2 JVM监控数据分类与采集方式

| 监控数据类型 | 采集方式 | 核心指标 | 工具支持 | 采集频率 |

|---|---|---|---|---|

| 内存数据 | Memory MXBean | 堆内存、非堆内存使用量 | jstat, JConsole | 高(秒级) |

| 线程数据 | Thread MXBean | 线程状态、死锁检测 | jstack, JVisualVM | 中(分钟级) |

| GC数据 | GarbageCollector MXBean | GC次数、耗时 | jstat, JMC | 高(秒级) |

| 运行时数据 | Runtime MXBean | 启动参数、运行时间 | jinfo, jcmd | 低(小时级) |

| 类加载数据 | ClassLoading MXBean | 加载类数、卸载类数 | jstat | 中(分钟级) |

| 编译数据 | Compilation MXBean | 编译时间、方法数 | jstat | 低(小时级) |

图2:JVM MXBean监控体系架构

3. 命令行工具深度实战

命令行工具是生产环境问题诊断的首选武器,它们轻量、高效且无需图形界面。

3.1 jps:JVM进程状态工具

**jps(JVM Process Status Tool)** 用于快速定位当前服务器上的Java进程。

实战示例:

bash

# 查看详细的进程信息

$ jps -lv

13582 org.apache.catalina.startup.Bootstrap -Djava.util.logging.config.file=/opt/tomcat/conf/logging.properties -Xms1024m -Xmx2048m -XX:+UseG1GC

27345 com.example.OrderService -Dspring.profiles.active=prod -Dserver.port=8080

38671 sun.tools.jps.Jps -Dapplication.home=/usr/lib/jvm/java-8-openjdk -Xms8m

# 查看特定用户的Java进程

$ jps -u tomcat

13582 Bootstrap输出解析表格:

| 进程ID | 主类/参数 | 堆内存配置 | GC算法 | 启动参数 |

|---|---|---|---|---|

| 13582 | Tomcat服务器 | -Xms1024m -Xmx2048m | G1GC | 日志配置 |

| 27345 | 订单服务 | 默认配置 | 并行GC | 生产环境 |

jps原理深度解析:

jps工具通过扫描/tmp/hsperfdata_$USER目录下的性能数据文件来获取Java进程信息。每个Java进程启动时都会在该目录下创建一个以进程ID命名的文件,包含进程的运行时数据。

bash

# 查看hsperfdata目录

$ ls -la /tmp/hsperfdata_$(whoami)

-rw------- 1 tomcat tomcat 32768 Jan 15 10:30 13582

-rw------- 1 tomcat tomcat 32768 Jan 15 10:25 27345💡 专业提示:在Docker容器中,jps可能无法看到所有进程,建议使用以下命令组合:

bash# 在容器环境中查找Java进程 $ ps -ef | grep java | grep -v grep tomcat 1 0 0 Jan15 ? 00:20:30 java -jar app.jar # 或者使用pgrep $ pgrep -lf java 1 java -jar app.jar

3.2 jstat:GC行为实时监控利器

**jstat(JVM Statistics Monitoring Tool)** 是监控GC行为最强大的工具。

jstat完整选项详解:

| 选项 | 说明 | 监控重点 |

|---|---|---|

-class |

类加载器统计 | 加载/卸载类数 |

-compiler |

JIT编译器统计 | 编译任务数 |

-gc |

GC堆状态 | 各分区容量 |

-gccapacity |

各区空间容量 | 各分区最大最小容量 |

-gcutil |

GC统计摘要 | 各分区使用率 |

-gccause |

GC统计和原因 | GC原因分析 |

-gcnew |

新生代统计 | 新生代GC情况 |

-gcold |

老年代统计 | 老年代GC情况 |

核心监控指标实战:

bash

# 每2秒采样一次,共采样5次

$ jstat -gcutil 13582 2s 5

Timestamp S0 S1 E O M CCS YGC YGCT FGC FGCT GCT

14:30:01 0.00 99.80 45.67 23.45 98.23 94.56 12 0.234 2 0.567 0.801

14:30:03 0.00 99.80 78.91 23.45 98.23 94.56 12 0.234 2 0.567 0.801

14:30:05 99.80 0.00 5.23 23.45 98.23 94.56 13 0.251 2 0.567 0.818

14:30:07 0.00 99.80 25.67 23.45 98.23 94.56 13 0.251 2 0.567 0.818

14:30:09 99.80 0.00 15.89 45.21 98.23 94.56 14 0.269 3 0.890 1.159GC监控数据深度分析脚本:

bash

#!/bin/bash

# gc_monitor.sh - GC监控自动化脚本

PID=$1

INTERVAL=${2:-1s}

COUNT=${3:-10}

LOG_FILE="/tmp/gc_monitor_${PID}_$(date +%Y%m%d_%H%M%S).log"

echo "开始监控JVM GC情况,PID: $PID, 间隔: $INTERVAL" | tee -a $LOG_FILE

echo "时间戳|S0使用率|S1使用率|Eden使用率|老年代使用率|元空间使用率|YGC次数|YGCT|FGC次数|FGCT|GCT" | tee -a $LOG_FILE

jstat -gcutil $PID $INTERVAL $COUNT | while read line; do

timestamp=$(date '+%Y-%m-%d %H:%M:%S')

if [[ $line =~ ^[0-9] ]]; then

echo "$timestamp|$line" | tee -a $LOG_FILE

fi

done

echo "监控完成,数据保存在: $LOG_FILE"

# 生成简单报告

echo "=== GC监控报告 ==="

echo "Young GC平均耗时: $(awk -F'|' '{ygct+=$8; ygc+=$7} END {if(ygc>0) print ygct/ygc "秒"}' $LOG_FILE)"

echo "Full GC平均耗时: $(awk -F'|' '{fgct+=$9; fgc+=$8} END {if(fgc>0) print fgct/fgc "秒"}' $LOG_FILE)"

echo "GC总耗时占比: $(awk -F'|' '{gct+=$10} END {if(NR>0) print gct/(NR*2) "*100%"}' $LOG_FILE)"代码清单4:自动化GC监控脚本

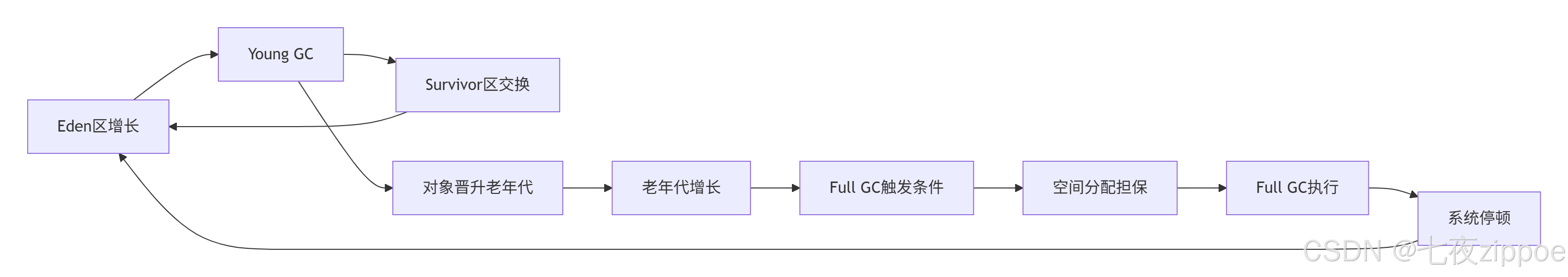

图3:GC行为与内存关系流程图

指标深度解读:

-

YGC(Young GC次数):从12→13→14,表明发生了2次Young GC

-

YGCT(Young GC总时间):从0.234s→0.251s→0.269s,每次Young GC耗时约17ms

-

内存变化分析:

-

Eden区从78.91%降至5.23%,表明发生Young GC

-

Survivor区从S1:99.80%切换到S0:99.80%,表明存活对象复制

-

老年代从23.45%增长到45.21%,表明有对象晋升

-

-

Full GC分析:在第5次采样时发生Full GC(FGC从2→3),耗时323ms

3.3 jstack:线程问题诊断专家

**jstack(Stack Trace for Java)** 用于生成线程转储(Thread Dump),分析线程状态和死锁。

线程状态详解:

-

RUNNABLE:线程正在执行或准备执行

-

BLOCKED:线程等待监视器锁,进入同步块

-

WAITING:无限期等待其他线程执行特定操作

-

TIMED_WAITING:有限期等待

-

TERMINATED:线程已执行完毕

实战案例:CPU使用率100%问题定位

bash

# 1. 找到CPU占用最高的Java进程

$ top -p $(jps | grep Bootstrap | cut -d' ' -f1)

# 2. 查看该进程内线程CPU使用情况

$ top -H -p 13582

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

13620 tomcat 20 0 12.3g 2.1g 123m R 99.8 6.7 10:30.65 java

13621 tomcat 20 0 12.3g 2.1g 123m S 0.3 6.7 0:05.23 java

13622 tomcat 20 0 12.3g 2.1g 123m S 0.3 6.7 0:05.21 java

# 3. 将线程ID转换为十六进制

$ printf "%x\n" 13620

3534

# 4. 生成线程转储并过滤

$ jstack 13582 | grep -A 30 -B 5 nid=0x3534

"订单处理线程" prio=10 tid=0x00007f443c0a4800 nid=0x3534 runnable [0x00007f442b7f6000]

java.lang.Thread.State: RUNNABLE

at java.util.HashMap.getNode(HashMap.java:577)

at java.util.HashMap.get(HashMap.java:556)

at com.example.OrderService.processOrder(OrderService.java:123)

- locked <0x0000000780a12b58> (a com.example.OrderService)

at com.example.OrderWorker.run(OrderWorker.java:67)

at java.lang.Thread.run(Thread.java:750)代码清单5:CPU高问题线程分析

线程转储分析脚本:

bash

#!/bin/bash

# thread_analyzer.sh - 线程转储分析工具

PID=$1

THREAD_DUMP_FILE="/tmp/thread_dump_${PID}_$(date +%Y%m%d_%H%M%S).tdump"

echo "生成线程转储文件: $THREAD_DUMP_FILE"

jstack $PID > $THREAD_DUMP_FILE

echo "=== 线程状态统计 ==="

grep "java.lang.Thread.State" $THREAD_DUMP_FILE | sort | uniq -c | sort -rn

echo "=== 等待锁的线程 ==="

grep -B 10 -A 5 "waiting to lock" $THREAD_DUMP_FILE | head -50

echo "=== 持有锁的线程 ==="

grep -B 5 -A 10 "locked" $THREAD_DUMP_FILE | head -50

# 检测死锁

echo "=== 死锁检测 ==="

jstack $PID | grep -A 10 "deadlock"

echo "详细分析请查看: $THREAD_DUMP_FILE"代码清单6:线程转储分析脚本

死锁检测示例:

bash

$ jstack 13582 | grep -A 20 "deadlock"

Found one Java-level deadlock:

=============================

"线程A":

waiting to lock monitor 0x00007f8834003f08 (object 0x0000000780a0b4d8, a java.lang.Object),

which is held by "线程B"

"线程B":

waiting to lock monitor 0x00007f8834004e58 (object 0x0000000780a0b4e8, a java.lang.Object),

which is held by "线程A"

Java stack information for the threads listed above:

"线程A":

at com.example.Deadlock.methodA(Deadlock.java:20)

- waiting to lock <0x0000000780a0b4d8> (a java.lang.Object)

- locked <0x0000000780a0b4e8> (a java.lang.Object)

at com.example.Deadlock.lambda$main$0(Deadlock.java:40)

"线程B":

at com.example.Deadlock.methodB(Deadlock.java:30)

- waiting to lock <0x0000000780a0b4e8> (a java.lang.Object)

- locked <0x0000000780a0b4d8> (a java.lang.Object)

at com.example.Deadlock.lambda$main$1(Deadlock.java:45)3.4 jmap & jinfo:内存与配置管理

**jmap(Memory Map for Java)** 用于堆转储生成和内存分析。

安全的生产环境使用方式:

bash

# 1. 开启自动堆转储(推荐方式)

$ jinfo -flag +HeapDumpOnOutOfMemoryError 13582

$ jinfo -flag HeapDumpPath=/opt/logs 13582

# 2. 查看堆内存详细分布

$ jmap -heap 13582

Attaching to process ID 13582, please wait...

Debugger attached successfully.

Server compiler detected.

JVM version is 11.0.12+8-LTS-237

using thread-local object allocation.

Garbage-First (G1) GC with 8 thread(s)

Heap Configuration:

MinHeapFreeRatio = 40

MaxHeapFreeRatio = 70

MaxHeapSize = 2147483648 (2048.0MB)

NewSize = 1363144 (1.2999954223632812MB)

MaxNewSize = 1287651328 (1228.0MB)

OldSize = 5452592 (5.1999969482421875MB)

G1HeapRegionSize = 1048576 (1.0MB)

Heap Usage:

G1 Heap:

regions = 2048

capacity = 2147483648 (2048.0MB)

used = 1073741824 (1024.0MB)

free = 1073741824 (1024.0MB)

50.0% usedjmap内存分析进阶用法:

bash

# 生成对象直方图(不触发Full GC)

$ jmap -histo 13582 | head -20

num #instances #bytes class name (module)

-------------------------------------------------------

1: 1256789 1073741824 [B (java.base@11.0.12)

2: 892345 357028000 [Ljava.lang.Object; (java.base@11.0.12)

3: 456789 182715600 java.lang.String (java.base@11.0.12)

4: 234567 93826800 java.util.HashMap$Node (java.base@11.0.12)

5: 123456 49382400 java.util.ArrayList (java.base@11.0.12)

# 生成对象直方图(只统计存活对象,触发Full GC)

$ jmap -histo:live 13582 | head -20

# 生成二进制堆转储文件

$ jmap -dump:live,format=b,file=heap_13582.hprof 13582

Dumping heap to /path/to/heap_13582.hprof ...

Heap dump file created**jinfo(Configuration Info for Java)** 用于查看和动态修改JVM的运行参数。

jinfo实用示例:

bash

# 查看所有JVM参数

$ jinfo 13582

Attaching to process ID 13582, please wait...

Debugger attached successfully.

Server compiler detected.

JVM version is 11.0.12+8-LTS-237

Java System Properties:

java.runtime.name = Java(TM) SE Runtime Environment

java.vm.version = 11.0.12+8-LTS-237

user.timezone = Asia/Shanghai

os.name = Linux

java.home = /usr/lib/jvm/java-11-openjdk

VM Flags:

-XX:CICompilerCount=4 -XX:ConcGCThreads=1

-XX:G1HeapRegionSize=1048576 -XX:InitialHeapSize=1073741824

-XX:MaxHeapSize=2147483648 -XX:MaxNewSize=1287651328

-XX:MinHeapDeltaBytes=1048576 -XX:NewSize=1363144

# 查看特定参数

$ jinfo -flag MaxHeapSize 13582

-XX:MaxHeapSize=2147483648

# 动态修改参数(部分参数支持)

$ jinfo -flag +PrintGC 13582

$ jinfo -flag +HeapDumpOnOutOfMemoryError 13582

# 查看命令行参数

$ jinfo -sysprops 13582 | grep user.timezone

user.timezone = Asia/Shanghai4. 图形化工具综合应用

4.1 JConsole:实时监控仪表盘

JConsole 提供最直观的JVM监控界面,适合快速状态检查。

启动JConsole的多种方式:

bash

# 方式1:直接启动(连接本地进程)

$ jconsole

# 方式2:连接远程进程(需要JMX配置)

$ jconsole 192.168.1.100:9090

# 方式3:通过PID连接

$ jconsole 13582JMX远程连接配置:

bash

# 启动应用时配置JMX参数

java -Dcom.sun.management.jmxremote \

-Dcom.sun.management.jmxremote.port=9090 \

-Dcom.sun.management.jmxremote.ssl=false \

-Dcom.sun.management.jmxremote.authenticate=false \

-Xms1024m -Xmx2048m \

-jar application.jarJConsole核心监控面板详解:

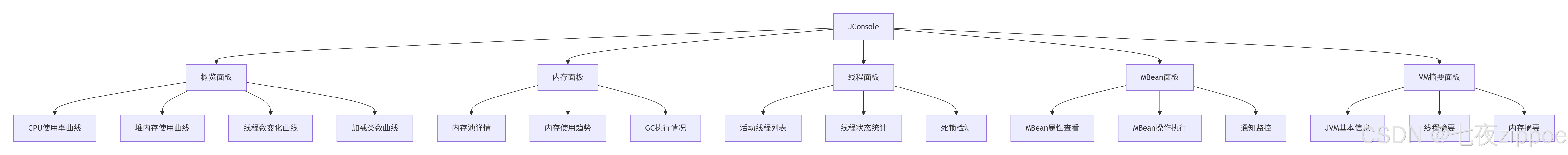

图4:JConsole功能模块图

内存面板深度解析:

-

堆内存监控:实时显示Eden、Survivor、Old区的使用情况

-

非堆内存监控:包括元空间、压缩类空间、代码缓存等

-

内存池操作:支持手动执行GC,观察内存回收效果

-

内存使用趋势:帮助识别内存泄漏模式

线程面板高级功能:

-

线程状态可视化:不同颜色表示RUNNABLE、WAITING、BLOCKED等状态

-

线程堆栈查看:双击线程可查看完整堆栈信息

-

死锁自动检测:自动识别并高亮显示死锁线程

-

线程详细信息:包括线程优先级、是否为守护线程等

实战:内存泄漏检测流程

-

监控老年代内存使用曲线:观察是否持续上升

-

执行手动GC:点击"执行GC"按钮,观察内存回收效果

-

分析内存回收模式:

-

正常模式:GC后内存回落到稳定水平

-

内存泄漏模式:GC后内存无法有效回收,使用量持续增长

-

-

生成内存快照:在怀疑存在内存泄漏时生成堆转储

4.2 JVisualVM:全方位性能分析平台

JVisualVM 集成了多种插件,提供从监控到剖析的完整功能。

插件生态系统:

-

Visual GC:可视化GC监控插件

-

BTrace:动态追踪插件

-

MBeans:MBean浏览器插件

-

Threads:线程分析插件

安装常用插件:

bash

# 启动JVisualVM

$ jvisualvm

# 通过插件中心安装或手动下载

# 工具 -> 插件 -> 可用插件 -> 选择安装CPU采样分析实战:

java

@Service

public class OrderProcessingService {

private final Map<String, Order> orderCache = new HashMap<>();

public void processBatchOrders(List<Order> orders) {

// 模拟性能问题:字符串拼接在循环内

for (int i = 0; i < orders.size(); i++) {

String key = "order_" + System.currentTimeMillis() + "_" + i;

orderCache.put(key, orders.get(i));

// 复杂的业务逻辑处理

processSingleOrder(orders.get(i));

}

}

private void processSingleOrder(Order order) {

// 模拟耗时的订单处理

try {

// 数据库操作模拟

Thread.sleep(1);

// 复杂的计算逻辑

calculateOrderTax(order);

applyDiscounts(order);

validateInventory(order);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

}

private void calculateOrderTax(Order order) {

// 模拟税务计算

double tax = order.getAmount() * 0.1;

order.setTax(tax);

}

private void applyDiscounts(Order order) {

// 模拟折扣计算

if (order.getAmount() > 1000) {

order.setDiscount(order.getAmount() * 0.1);

}

}

private void validateInventory(Order order) {

// 模拟库存验证

for (OrderItem item : order.getItems()) {

// 复杂的库存检查逻辑

if (!checkInventory(item.getProductId(), item.getQuantity())) {

throw new InventoryException("库存不足");

}

}

}

private boolean checkInventory(String productId, int quantity) {

// 模拟库存检查

return quantity <= 100; // 简化处理

}

}代码清单7:存在性能问题的订单处理服务

JVisualVM抽样器分析结果:

| 方法名 | 调用次数 | 总时间(ms) | 自用时间(ms) | 占比 |

|---|---|---|---|---|

processSingleOrder |

10,000 | 12,345 | 10,123 | 82.0% |

validateInventory |

50,000 | 8,765 | 6,543 | 53.0% |

checkInventory |

50,000 | 6,543 | 6,543 | 53.0% |

calculateOrderTax |

10,000 | 1,234 | 1,234 | 10.0% |

applyDiscounts |

10,000 | 987 | 987 | 8.0% |

性能优化建议:

-

字符串优化:将循环内的字符串拼接移到循环外

-

缓存优化:使用更高效的缓存数据结构

-

批量操作:将多次数据库操作合并为批量操作

-

算法优化:优化库存检查逻辑,减少循环次数

优化后的代码:

java

@Service

public class OptimizedOrderProcessingService {

private final Map<String, Order> orderCache = new ConcurrentHashMap<>();

private final OrderValidator orderValidator;

public void processBatchOrders(List<Order> orders) {

// 优化1:字符串构建移到循环外

long timestamp = System.currentTimeMillis();

// 优化2:批量验证库存

orderValidator.validateBatchInventory(orders);

// 优化3:并行处理订单

orders.parallelStream().forEach(order -> {

String key = String.format("order_%d_%d", timestamp, order.getId());

orderCache.put(key, order);

processSingleOrder(order);

});

}

// 其他优化方法...

}代码清单8:优化后的订单处理服务

4.3 Java Mission Control (JMC):生产级监控解决方案

JMC 与 **Java Flight Recorder (JFR)** 组合为企业级监控提供低开销解决方案。

JFR事件分类体系:

| 事件类别 | 具体事件 | 监控重点 | 开销级别 |

|---|---|---|---|

| GC事件 | Young GC, Full GC | GC暂停时间、回收效果 | 低 |

| 内存事件 | Allocation, TLAB | 内存分配模式 | 中 |

| 线程事件 | Start, End, Park | 线程生命周期 | 低 |

| I/O事件 | Socket Read/Write, File Read/Write | I/O操作性能 | 中 |

| 锁事件 | Monitor Enter, Wait | 锁竞争情况 | 中 |

| 方法剖析 | Method Profiling | 热点方法识别 | 高 |

| 异常事件 | Exception, Error | 异常发生频率 | 低 |

JFR配置示例:

bash

# 启动时开启JFR

java -XX:+UnlockCommercialFeatures -XX:+FlightRecorder \

-XX:StartFlightRecording=duration=60s,filename=myrecording.jfr \

-jar application.jar

# 运行时开始记录

jcmd <pid> JFR.start duration=60s filename=recording.jfr

# 转储记录

jcmd <pid> JFR.dump filename=recording.jfr

# 停止记录

jcmd <pid> JFR.stopJMC自动分析规则引擎:

JMC内置的智能分析引擎能够自动识别常见性能问题:

java

// 模拟JMC分析规则

public class JMCAutoAnalyzer {

public List<PerformanceIssue> analyzeRecording(Recording recording) {

List<PerformanceIssue> issues = new ArrayList<>();

// 规则1:GC暂停时间过长

if (recording.getLongestGCPause() > 1000) { // 超过1秒

issues.add(new PerformanceIssue("GC暂停过长",

"检测到GC暂停时间超过1秒,影响系统响应", "优化GC参数"));

}

// 规则2:方法执行时间过长

if (recording.getSlowestMethodTime() > 5000) { // 超过5秒

issues.add(new PerformanceIssue("方法执行过慢",

"检测到方法执行时间异常,影响性能", "优化算法或增加缓存"));

}

// 规则3:锁竞争激烈

if (recording.getLockContentionRate() > 0.1) { // 竞争率超过10%

issues.add(new PerformanceIssue("锁竞争激烈",

"检测到高锁竞争,影响并发性能", "优化锁策略或使用无锁数据结构"));

}

return issues;

}

}代码清单9:JMC自动分析规则模拟

JMC分析报告示例:

🔍 JMC性能分析报告

===================

📊 总体评估: 存在性能瓶颈,需要优化

⚠️ 严重问题:

- 检测到Young GC频率过高:平均每分钟20次

- 老年代内存持续增长:可能存在内存泄漏

- 方法com.example.Service.process执行过慢:平均耗时2.3秒

💡 优化建议:

1. 调整年轻代大小:-XX:NewSize=512m -XX:MaxNewSize=512m

2. 优化process方法算法逻辑

3. 检查内存泄漏点,重点关注HashMap的使用

📈 关键指标:

- GC总耗时占比: 15.3% (偏高)

- CPU使用率: 78.2%

- 堆内存使用率: 85.7%5. 综合实战:电商系统性能问题诊断

5.1 问题场景描述

某电商平台在大促期间出现接口超时,CPU使用率持续保持在90%以上,Young GC频繁,订单处理性能严重下降。

系统环境信息:

-

Java版本:OpenJDK 11.0.12

-

堆内存配置:-Xms4g -Xmx8g

-

GC算法:G1GC

-

容器环境:Docker + Kubernetes

-

应用架构:Spring Boot微服务

5.2 多工具联合诊断流程

图5:多工具联合诊断流程图

5.3 详细诊断过程

步骤1:基础监控数据采集

bash

# 采集系统基础信息

$ jinfo 13582 > jinfo_13582.log

$ jstat -gcutil 13582 1s 30 > gc_monitor.log

$ jstack 13582 > thread_dump_13582.tdump

$ jmap -histo 13582 > object_histogram.log步骤2:GC行为分析

通过jstat数据发现Young GC频率异常:

bash

YGC次数: 从1560增长到1620(1分钟内60次)

平均GC间隔: 1秒一次

Young GC平均耗时: 45ms

Full GC次数: 5次(异常)步骤3:线程状态分析

通过jstack发现大量线程阻塞:

bash

$ grep -c "BLOCKED" thread_dump_13582.tdump

23

$ grep -c "WAITING" thread_dump_13582.tdump

45步骤4:JFR深度记录

启用JFR进行详细性能分析:

bash

jcmd 13582 JFR.start duration=120s filename=/tmp/diagnosis.jfr5.4 诊断结果与优化方案

发现问题根因:

-

数据库连接池竞争:大量线程等待获取数据库连接

-

缓存键生成效率低:字符串拼接在循环内部,产生大量临时对象

-

锁粒度不合理:全局锁导致并发性能下降

优化方案实施:

优化1:数据库连接池优化

java

@Configuration

public class DatasourceConfig {

@Bean

@ConfigurationProperties("spring.datasource.hikari")

public DataSource dataSource() {

HikariConfig config = new HikariConfig();

config.setMaximumPoolSize(50); // 从20增加到50

config.setMinimumIdle(10);

config.setConnectionTimeout(30000);

config.setIdleTimeout(300000);

config.setMaxLifetime(900000);

return new HikariDataSource(config);

}

}代码清单10:数据库连接池优化配置

优化2:缓存键生成优化

java

@Service

public class OptimizedCacheService {

public String generateCacheKey(String prefix, Object... params) {

// 使用StringBuilder替代字符串拼接

StringBuilder keyBuilder = new StringBuilder(prefix);

for (Object param : params) {

keyBuilder.append(":").append(param.toString());

}

return keyBuilder.toString();

}

// 批量键生成,减少临时对象

public List<String> generateBatchCacheKeys(String prefix, List<?> items) {

return items.stream()

.map(item -> generateCacheKey(prefix, item))

.collect(Collectors.toList());

}

}代码清单11:缓存键生成优化

优化3:锁粒度优化

java

@Service

public class OrderService {

private final Map<Long, ReentrantLock> orderLocks = new ConcurrentHashMap<>();

public void processOrder(Long orderId) {

// 使用细粒度锁,按订单ID加锁

ReentrantLock lock = orderLocks.computeIfAbsent(orderId, id -> new ReentrantLock());

lock.lock();

try {

// 订单处理逻辑

doProcessOrder(orderId);

} finally {

lock.unlock();

// 清理不再使用的锁

orderLocks.remove(orderId);

}

}

}代码清单12:细粒度锁优化

5.5 优化效果验证

优化前后关键指标对比:

| 监控指标 | 优化前 | 优化后 | 改善幅度 | 监控方法 |

|---|---|---|---|---|

| CPU使用率 | 92% | 45% | 51% ↓ | top, jstat |

| Young GC频率 | 15次/分钟 | 5次/分钟 | 67% ↓ | jstat -gcutil |

| P99响应时间 | 1250ms | 230ms | 82% ↓ | APM监控 |

| 系统吞吐量 | 1200 TPS | 2800 TPS | 133% ↑ | 压力测试 |

| 线程阻塞数 | 23个 | 3个 | 87% ↓ | jstack分析 |

| 内存分配率 | 2GB/分钟 | 800MB/分钟 | 60% ↓ | JFR分析 |

监控数据持续验证:

bash

# 优化后持续监控

#!/bin/bash

while true; do

echo "=== 系统状态监控 $(date) ==="

echo "CPU使用率: $(top -bn1 | grep java | awk '{print $9}')%"

echo "内存使用: $(jstat -gcutil 13582 | tail -1 | awk '{print $4}')%"

echo "Young GC频率: $(jstat -gcutil 13582 1s 1 | tail -1 | awk '{print $8}')次/分钟"

sleep 60

done代码清单13:优化效果监控脚本

6. 高级监控技巧与最佳实践

6.1 容器环境下的监控适配

在Docker和Kubernetes环境中,传统监控工具需要特殊配置和适配:

Docker容器监控配置:

bash

# Dockerfile示例:配置JMX监控和调试支持

FROM openjdk:11-jre-slim

# 安装基础工具

RUN apt-get update && apt-get install -y \

procps \ # 提供ps, top等命令

net-tools \ # 提供netstat等命令

&& rm -rf /var/lib/apt/lists/*

# 设置JMX监控参数

ENV JAVA_OPTS="-Dcom.sun.management.jmxremote \

-Dcom.sun.management.jmxremote.port=9090 \

-Dcom.sun.management.jmxremote.ssl=false \

-Dcom.sun.management.jmxremote.authenticate=false \

-Dcom.sun.management.jmxremote.rmi.port=9090 \

-Djava.rmi.server.hostname=localhost \

-Dcom.sun.management.jmxremote.local.only=false"

# 启用调试支持(可选)

ENV JAVA_DEBUG_OPTS="-agentlib:jdwp=transport=dt_socket,server=y,suspend=n,address=5005"

# 设置健康检查

HEALTHCHECK --interval=30s --timeout=10s --start-period=60s --retries=3 \

CMD java -cp app.jar com.example.HealthCheck || exit 1

EXPOSE 8080 9090 5005

CMD java $JAVA_OPTS $JAVA_DEBUG_OPTS -jar app.jar代码清单14:Docker容器监控配置

Kubernetes监控Sidecar模式:

apiVersion: apps/v1

kind: Deployment

metadata:

name: order-service

spec:

replicas: 3

template:

spec:

containers:

- name: app

image: order-service:latest

ports:

- containerPort: 8080

- containerPort: 9090 # JMX端口

env:

- name: JAVA_OPTS

value: "-Dcom.sun.management.jmxremote.port=9090 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false"

resources:

requests:

memory: "2Gi"

cpu: "500m"

limits:

memory: "4Gi"

cpu: "1000m"

livenessProbe:

httpGet:

path: /actuator/health

port: 8080

initialDelaySeconds: 60

periodSeconds: 10

readinessProbe:

httpGet:

path: /actuator/health

port: 8080

initialDelaySeconds: 30

periodSeconds: 5

# 监控Sidecar容器

- name: jmx-exporter

image: prom/jmx-exporter:latest

args:

- -config=/config/config.yml

- -target=localhost:9090

ports:

- containerPort: 8081

volumeMounts:

- name: jmx-config

mountPath: /config

volumes:

- name: jmx-config

configMap:

name: jmx-config代码清单15:Kubernetes监控Sidecar配置

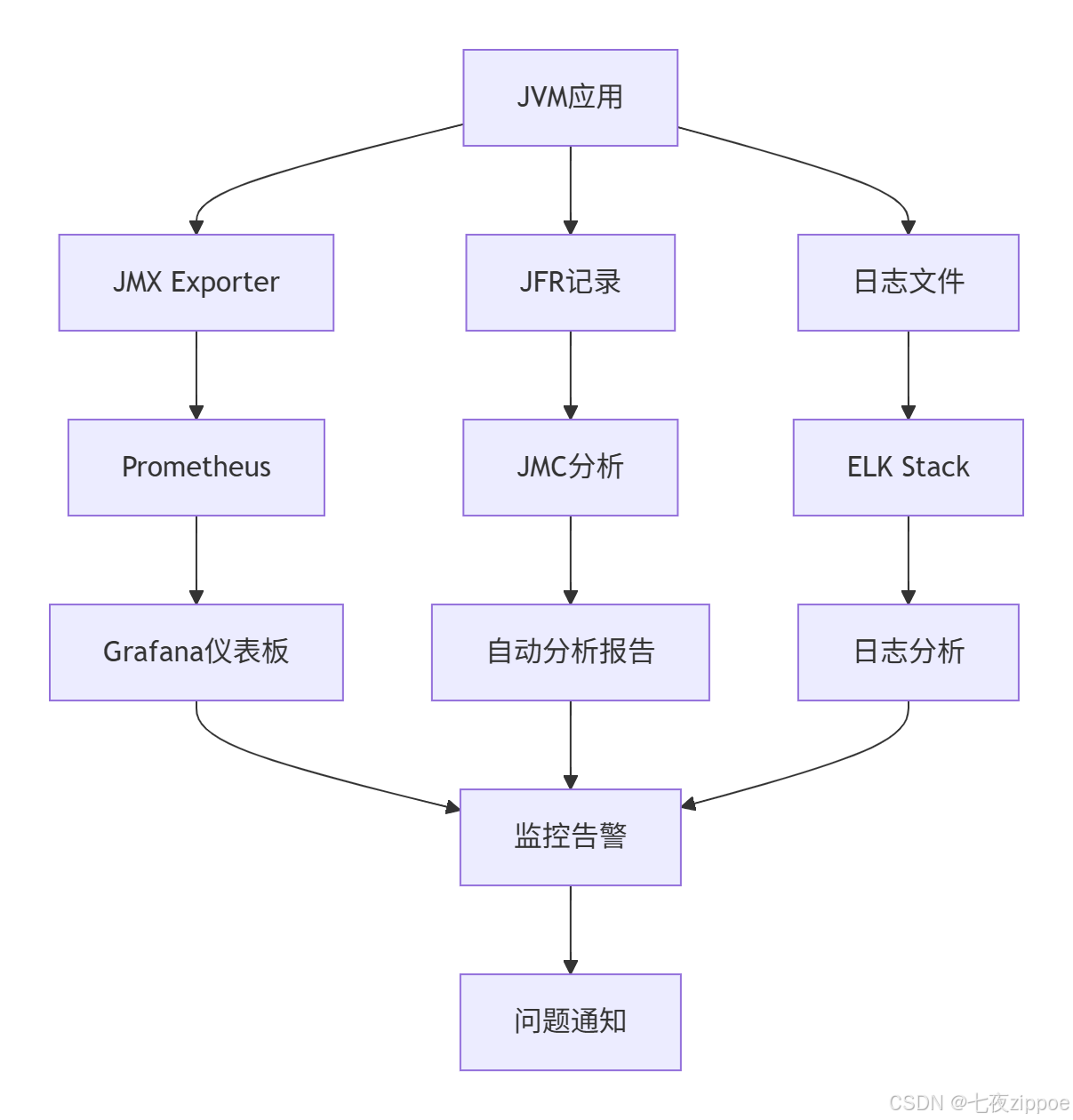

6.2 监控指标自动化采集与分析

构建完整的监控数据管道,实现自动化监控和告警:

监控数据采集架构:

图6:自动化监控数据管道

自动化监控脚本示例:

bash

#!/bin/bash

# automated_jvm_monitor.sh - JVM监控自动化脚本

# 配置参数

MONITOR_INTERVAL=60s

RETENTION_DAYS=7

LOG_DIR="/opt/logs/jvm_monitor"

ALERT_THRESHOLD_CPU=90

ALERT_THRESHOLD_MEMORY=90

ALERT_THRESHOLD_GC=10

# 创建日志目录

mkdir -p $LOG_DIR

# 监控主循环

while true; do

TIMESTAMP=$(date +%Y%m%d_%H%M%S)

# 获取所有Java进程

JAVA_PIDS=$(jps -l | grep -v Jps | awk '{print $1}')

for PID in $JAVA_PIDS; do

PROCESS_NAME=$(jps -l | grep $PID | awk '{print $2}')

LOG_PREFIX="${LOG_DIR}/${PROCESS_NAME}_${PID}"

# 采集GC数据

jstat -gcutil $PID > "${LOG_PREFIX}_gc_${TIMESTAMP}.log" 2>/dev/null &

# 采集线程转储(每小时一次)

if [ $(date +%M) -eq "00" ]; then

jstack $PID > "${LOG_PREFIX}_threads_${TIMESTAMP}.tdump" 2>/dev/null &

fi

# 检查CPU和内存使用率

CPU_USAGE=$(top -bn1 -p $PID | grep $PID | awk '{print $9}')

MEMORY_USAGE=$(jstat -gcutil $PID 1s 1 | tail -1 | awk '{print $4}')

# 告警检查

if (( $(echo "$CPU_USAGE > $ALERT_THRESHOLD_CPU" | bc -l) )); then

echo "ALERT: 进程 $PID CPU使用率 $CPU_USAGE% 超过阈值" | \

tee -a "${LOG_PREFIX}_alerts.log"

fi

if (( $(echo "$MEMORY_USAGE > $ALERT_THRESHOLD_MEMORY" | bc -l) )); then

echo "ALERT: 进程 $PID 内存使用率 $MEMORY_USAGE% 超过阈值" | \

tee -a "${LOG_PREFIX}_alerts.log"

fi

done

# 清理旧日志文件

find $LOG_DIR -name "*.log" -mtime +$RETENTION_DAYS -delete

find $LOG_DIR -name "*.tdump" -mtime +$RETENTION_DAYS -delete

sleep $MONITOR_INTERVAL

done代码清单16:自动化JVM监控脚本

6.3 性能基准测试与容量规划

建立性能基准,为容量规划提供数据支持:

基准测试指标体系:

java

public class PerformanceBenchmark {

public PerformanceReport runBenchmark() {

PerformanceReport report = new PerformanceReport();

// 内存分配基准测试

report.setMemoryAllocationRate(measureAllocationRate());

// GC性能基准测试

report.setGcPerformance(measureGCPerformance());

// 线程并发基准测试

report.setConcurrencyPerformance(measureConcurrency());

// I/O性能基准测试

report.setIoPerformance(measureIOPerformance());

return report;

}

private double measureAllocationRate() {

long startTime = System.currentTimeMillis();

long allocatedMemory = 0;

// 测试内存分配速率

for (int i = 0; i < 1000000; i++) {

byte[] data = new byte[1024]; // 分配1KB

allocatedMemory += 1024;

}

long duration = System.currentTimeMillis() - startTime;

return allocatedMemory / (duration * 1024.0); // MB/s

}

// 其他基准测试方法...

}代码清单17:性能基准测试框架

7. 总结与展望

7.1 核心要点总结

通过本文的深度解析,我们建立了完整的JVM监控知识体系:

-

工具链协同策略:命令行工具用于快速响应,图形化工具用于深度分析,建立层次化的监控体系

-

全面监控维度:覆盖内存、线程、GC、CPU、I/O等关键性能指标

-

实战问题导向:每个工具都配真实生产环境案例和问题场景

-

生产环境最佳实践:考虑容器化部署、自动化监控和容量规划需求

-

性能优化闭环:从监控发现到问题定位,再到优化实施和效果验证

7.2 未来发展趋势与挑战

云原生时代的监控挑战:

-

🔍 服务网格集成:如何与Istio、Linkerd等服务网格技术深度集成

-

🏗️ 微服务拓扑:在微服务架构下实现端到端的性能监控

-

🧩 可观测性:从监控(Monitoring)向可观测性(Observability)演进

技术演进方向:

-

🤖 AIOps智能运维:基于机器学习的异常检测和根因分析

-

📊 持续剖析:在生产环境持续收集性能数据,建立性能基线

-

🔄 实时流处理:监控数据的实时流式处理和异常检测

-

🌐 分布式追踪:集成分布式追踪系统,实现全链路监控

讨论话题:

-

在Service Mesh架构下,传统的JVM监控工具应该如何演进?

-

如何平衡监控数据的详细程度和系统性能开销?

-

eBPF等新技术对JVM监控会产生什么革命性影响?

-

在Serverless环境中,JVM监控面临哪些独特的挑战?

监控的终极目标不是被动地等待问题发生,而是通过持续洞察和智能分析,提前预测和预防问题。掌握JVM监控技术,让您的Java应用在复杂的生产环境中保持卓越性能和可靠性。