大模型部署

1.自己部署

云服务器部署

优点:前期成本低,维护简单。

缺点:数据不安全,长期使用成本高。

本地部署

优点:数据安全,长期成本低。

缺点:初期成本高,维护困难。

2.他人部署(API接口调用并使用)

无需部署,直接使用,数据不安全,长期成本高。第三方平台已经部署好了,直接调用接口使用即可,按流量收费。

自己本地部署

Ollama、LM Studio 一键下载、运行大模型。

在本电脑安装工具,在执行一些命令,这样大模型就能成功的跑在自己的电脑上。

Ollama官网:https://ollama.com

选择系统下载

如windows系统,下载后的exe文件,直接安装。安装完右下角会多一个ollama的图标。

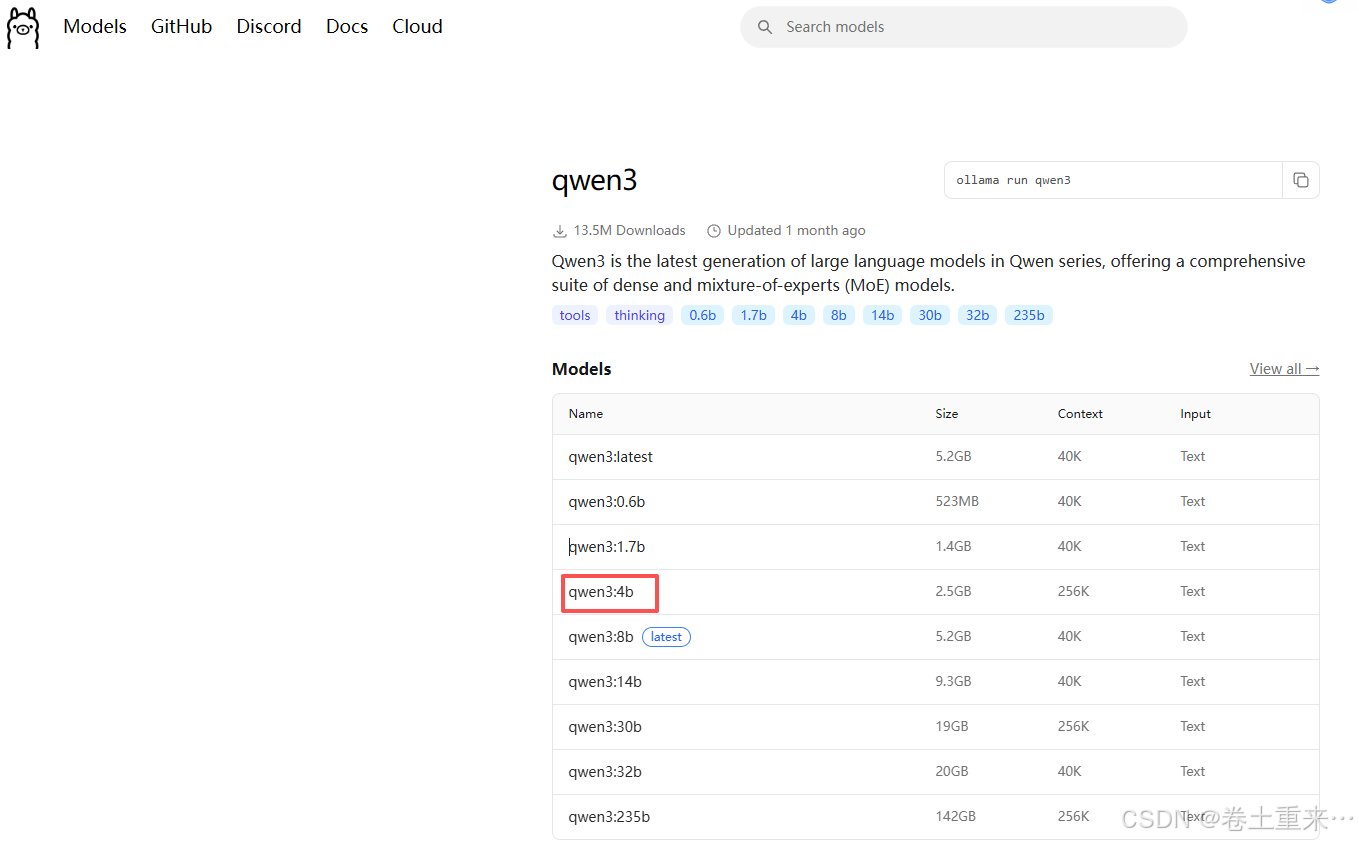

ollama支持很多模型,例如阿里提供的qwen3。

选择一个模型:

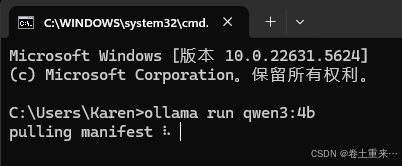

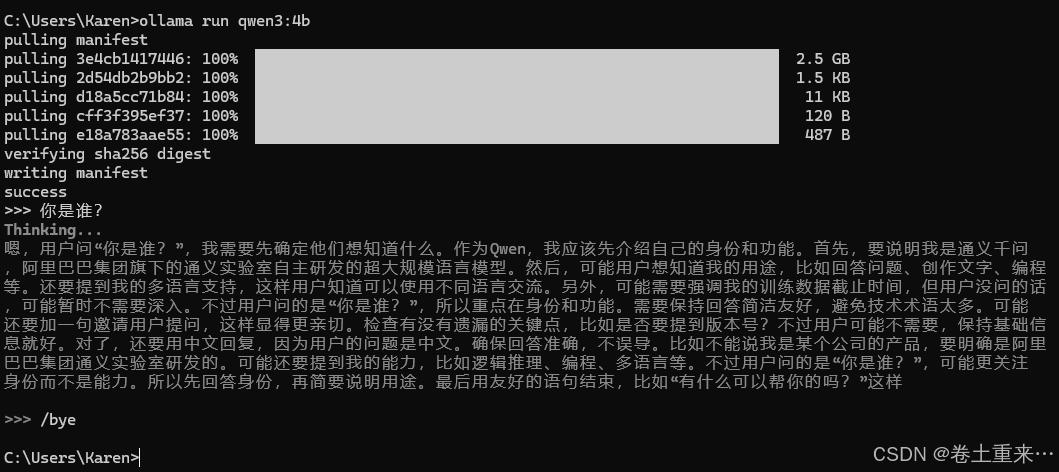

第一次使用模型,ollama run命令回去下载模型。

后面再运行ollama run 命令,就直接进入对话状态。

/bye 命令退出对话模式。

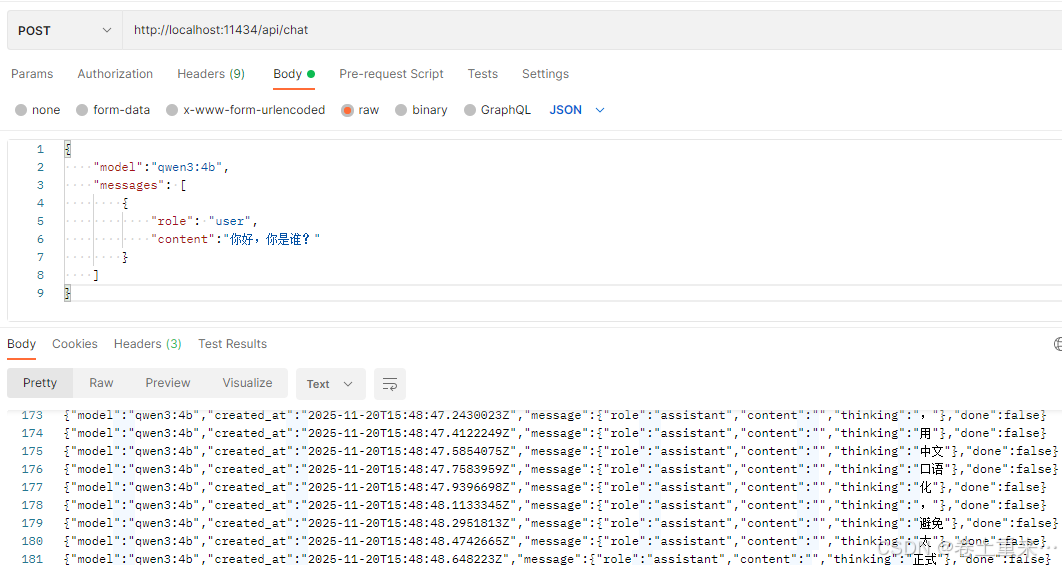

ollama运行的默认端口11434,Post请求方式

默认调用ollama部署的大模型是流式调用。

大模型调用apifox

http://localhost:11434/api/chat

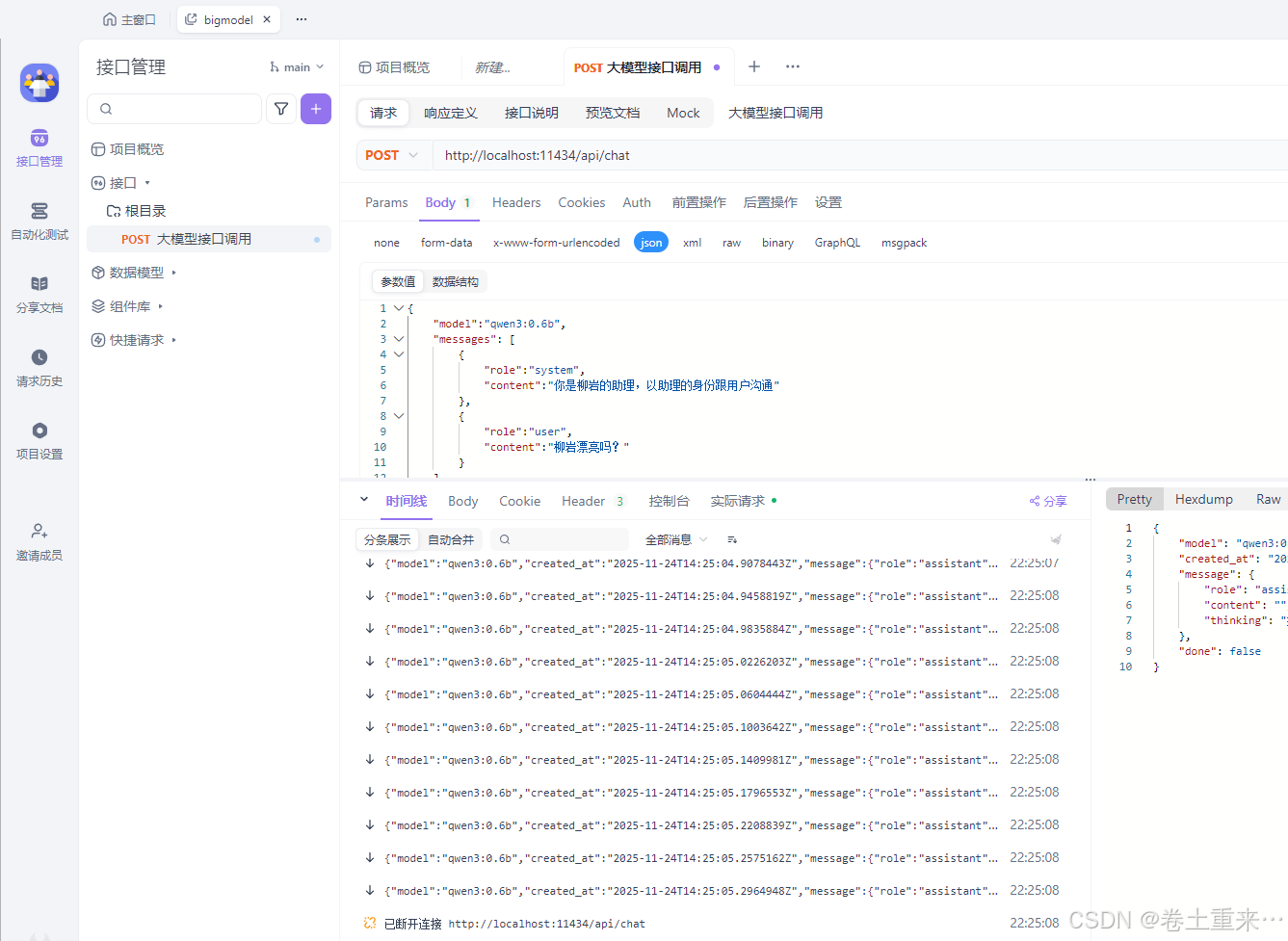

{

"model":"qwen3:0.6b",

"messages": [

{

"role":"user",

"content":"柳岩漂亮吗?"

}

]

}

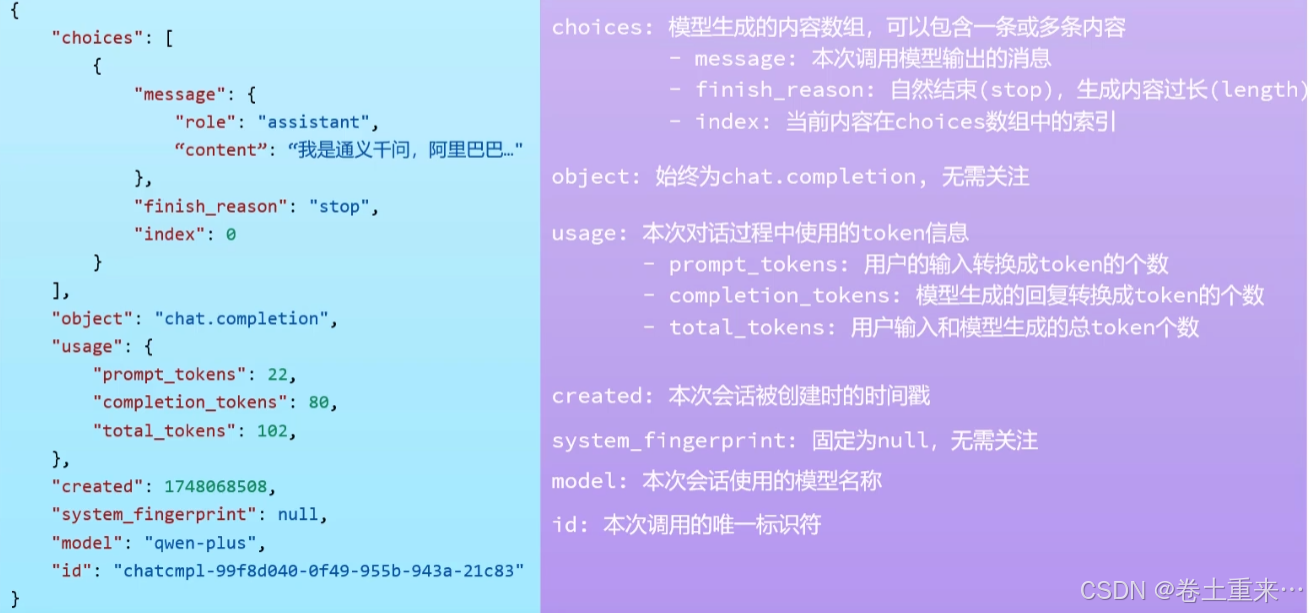

大模型参数说明

1.model 调用的那个模型。

2.messages 发送给模型的数据,模型根据这些数据给出合适的响应。

3.content 消息的内容。

4.role 消息角色

-user 用户消息,在文本框中输入的内容。

-system 系统消息,给大模型设定一个角色,大模型会以该角色与用户进行沟通

-assistant 模型响应消息,将第一次大模型响应的消息跟第二次用户提出的问题一起发送给大模型,大模型就能实现多轮问答的作用。

{

"model":"qwen3:0.6b",

"messages": [

{

"role":"system",

"content":"你是柳岩的助理,以助理的身份跟用户沟通"

},

{

"role":"user",

"content":"柳岩漂亮吗?"

}

],

"stream": true,

"enable_search": true

}

stream 调用方式, true非阻塞流式调用,false阻塞调用,一次性响应,默认值为false。

enable_search 联网搜索,启用后,模型会将搜索结果作为参考信息。true开启,false关闭(默认)