你在项目中使用过 Redis 吗?主要用于哪些场景?

在实际 Golang 项目开发中,Redis 是核心中间件之一,基于其高性能、原子性、丰富数据结构的特性,主要用于缓存、分布式锁、限流、消息队列、数据共享等场景,覆盖电商、支付、社交、后台管理系统等多个业务领域。以下结合具体项目实践,详细说明核心使用场景、实现方案、Golang 代码示例及注意事项,体现工程落地能力。

一、核心使用场景(结合项目实践)

-

数据缓存(最常用场景,提升查询性能)

-

业务背景:项目中高频查询的热点数据(如商品详情、用户信息、配置参数),若每次从 MySQL 查询,会导致数据库压力大、响应延迟高(尤其高并发场景)。

-

实现逻辑:采用"缓存优先"策略,查询时先从 Redis 获取数据,命中则直接返回;未命中则查询 MySQL,将结果写入 Redis 后返回,同时设置合理的过期时间,避免缓存与数据库数据不一致。

-

数据结构选择:根据数据类型选择对应的 Redis 结构:

- 简单键值数据(如配置参数

site_title):使用 String 类型; - 复杂对象(如商品详情

product_id:1001):使用 Hash 类型(存储对象字段键值对)或 String 类型(存储 JSON 序列化字符串); - 列表数据(如热门商品列表):使用 List 类型或 Sorted Set 类型(支持排序)。

- 简单键值数据(如配置参数

-

Golang 代码示例(商品详情缓存,使用 String 存储 JSON):

import ( "encoding/json" "fmt" "time" "github.com/go-redis/redis/v8" ) type Product struct { ID int64 `json:"id"` Name string `json:"name"` Price float64 `json:"price"` Stock int `json:"stock"` } // 获取商品详情:先查缓存,再查数据库 func GetProductDetail(rdb *redis.Client, ctx context.Context, productID int64) (*Product, error) { cacheKey := fmt.Sprintf("product:detail:%d", productID) // 1. 从 Redis 查询缓存 cacheVal, err := rdb.Get(ctx, cacheKey).Result() if err == nil { // 缓存命中,反序列化返回 var product Product if err := json.Unmarshal([]byte(cacheVal), &product); err != nil { return nil, err } return &product, nil } else if err != redis.Nil { // 缓存查询异常(非未命中),返回错误 return nil, err } // 2. 缓存未命中,查询 MySQL(此处省略 MySQL 查询逻辑,模拟返回数据) product := &Product{ ID: productID, Name: "Golang 编程实战", Price: 99.0, Stock: 1000, } // 3. 结果写入 Redis,设置过期时间 10 分钟(避免缓存雪崩,可加随机值) jsonData, err := json.Marshal(product) if err != nil { return nil, err } expireTime := time.Minute * 10 + time.Second*time.Duration(rand.Intn(60)) // 随机 0-60 秒 if err := rdb.Set(ctx, cacheKey, jsonData, expireTime).Err(); err != nil { return nil, err } return product, nil } -

注意事项:

- 过期时间设置:避免所有缓存同时过期导致"缓存雪崩",需在基础过期时间上添加随机值;

- 缓存更新策略:数据库数据更新时,采用"更新数据库+删除缓存"(而非更新缓存),避免并发场景下的数据不一致;

- 缓存穿透防护:对不存在的 key(如查询不存在的商品 ID),缓存空值并设置短过期时间(如 1 分钟),避免恶意请求穿透到数据库。

-

-

分布式锁(解决跨服务并发竞争问题)

-

业务背景:分布式系统中,跨服务、跨进程的并发操作(如秒杀下单、库存扣减、分布式任务调度),需保证操作的原子性,避免超卖、重复执行等问题。

-

实现逻辑:利用 Redis 的

SETNX(不存在时设置)命令和过期时间,实现分布式锁的获取、释放和超时自动释放,核心满足"互斥性、安全性、可用性"三大特性。 -

关键设计:

- 锁的标识:使用唯一值(如 UUID+服务IP)作为锁的 value,避免误释放其他服务的锁;

- 过期时间:防止服务宕机导致锁无法释放,设置合理的过期时间(需大于业务执行时间);

- 释放逻辑:通过 Lua 脚本原子执行"判断 value 是否匹配+删除 key",避免并发释放时的误操作。

-

Golang 代码示例(基于 Redis 实现分布式锁):

import ( "context" "fmt" "github.com/go-redis/redis/v8" "github.com/google/uuid" "time" ) type RedisLock struct { rdb *redis.Client ctx context.Context lockKey string lockVal string // 唯一标识,避免误释放 expire time.Duration } // 创建分布式锁实例 func NewRedisLock(rdb *redis.Client, ctx context.Context, lockKey string, expire time.Duration) *RedisLock { return &RedisLock{ rdb: rdb, ctx: ctx, lockKey: lockKey, lockVal: uuid.NewString() + ":" + "service-1", // 唯一值:UUID+服务标识 expire: expire, } } // 获取锁:成功返回 true,失败返回 false func (l *RedisLock) Lock() bool { // SETNX + 过期时间,原子操作 ok, err := l.rdb.SetNX(l.ctx, l.lockKey, l.lockVal, l.expire).Result() if err != nil { fmt.Printf("获取锁失败:%v\n", err) return false } return ok } // 释放锁:通过 Lua 脚本原子执行 func (l *RedisLock) Unlock() bool { // Lua 脚本:判断 value 匹配则删除,否则不操作 luaScript := ` if redis.call('GET', KEYS[1]) == ARGV[1] then return redis.call('DEL', KEYS[1]) else return 0 end ` res, err := l.rdb.Eval(l.ctx, luaScript, []string{l.lockKey}, l.lockVal).Result() if err != nil { fmt.Printf("释放锁失败:%v\n", err) return false } // 执行结果为 1 表示释放成功,0 表示锁已过期或不属于当前实例 return res == int64(1) } // 秒杀下单场景使用分布式锁 func SecKill(rdb *redis.Client, ctx context.Context, productID int64, userID int64) bool { lockKey := fmt.Sprintf("lock:seckill:%d", productID) // 创建锁,过期时间 5 秒(确保业务能在 5 秒内执行完) lock := NewRedisLock(rdb, ctx, lockKey, time.Second*5) defer lock.Unlock() // 延迟释放锁 // 获取锁失败,返回秒杀失败 if !lock.Lock() { fmt.Printf("用户 %d 秒杀失败:当前商品已被锁定\n", userID) return false } // 锁获取成功,执行秒杀逻辑(查询库存、扣减库存、创建订单) // 此处省略 MySQL 操作,模拟库存扣减 stockKey := fmt.Sprintf("product:stock:%d", productID) currentStock, err := rdb.Decr(ctx, stockKey).Result() if err != nil { fmt.Printf("库存扣减失败:%v\n", err) return false } if currentStock < 0 { // 库存不足,回滚库存 rdb.Incr(ctx, stockKey) fmt.Printf("用户 %d 秒杀失败:库存不足\n", userID) return false } fmt.Printf("用户 %d 秒杀成功:商品 %d 剩余库存 %d\n", userID, productID, currentStock) return true } -

注意事项:

- 锁超时处理:若业务执行时间超过锁的过期时间,可能导致锁自动释放,需结合"锁续期"(如定时任务延长锁的过期时间)或控制业务执行时间;

- 高并发优化:获取锁失败时,可通过"自旋重试"(循环尝试获取锁,设置重试次数和间隔)提升成功率,避免直接返回失败;

- 红锁方案:若 Redis 是集群部署,为避免单点故障导致锁失效,可采用 Redlock 算法(在多个 Redis 节点上获取锁,超过半数节点成功则视为锁获取成功)。

-

-

接口限流(防止系统被高并发请求击垮)

-

业务背景:公开接口(如登录接口、短信发送接口)可能面临恶意请求或突发流量,需限制单位时间内的请求次数,保护后端服务稳定性。

-

实现逻辑:基于 Redis 的

INCR命令和过期时间,实现"固定窗口限流"或"滑动窗口限流",核心是统计单位时间内的请求次数,超过阈值则拒绝请求。 -

数据结构选择:String 类型(存储请求次数),键名包含限流维度(如

rate_limit:login:user_123表示用户 123 的登录接口限流)。 -

Golang 代码示例(固定窗口限流,限制每分钟最多 10 次请求):

import ( "context" "fmt" "github.com/go-redis/redis/v8" "time" ) // 接口限流:返回 true 表示允许请求,false 表示限流 func RateLimit(rdb *redis.Client, ctx context.Context, key string, limit int64, duration time.Duration) bool { // 限流键:包含接口标识+限流维度(如用户ID、IP) rateKey := fmt.Sprintf("rate_limit:%s", key) // 1. 原子自增请求次数 count, err := rdb.Incr(ctx, rateKey).Result() if err != nil { fmt.Printf("限流统计失败:%v\n", err) return false // 失败时默认拒绝请求,可根据业务调整 } // 2. 第一次请求时,设置过期时间 if count == 1 { if err := rdb.Expire(ctx, rateKey, duration).Err(); err != nil { fmt.Printf("设置限流过期时间失败:%v\n", err) rdb.Decr(ctx, rateKey) // 回滚计数 return false } } // 3. 判断请求次数是否超过阈值 return count <= limit } // 登录接口限流:每个用户每分钟最多 10 次请求 func LoginHandler(rdb *redis.Client, ctx context.Context, userID int64, password string) string { // 限流键:login:user_123(接口标识+用户ID) limitKey := fmt.Sprintf("login:user_%d", userID) // 限制:每分钟最多 10 次请求 if !RateLimit(rdb, ctx, limitKey, 10, time.Minute) { return "请求过于频繁,请1分钟后再试" } // 限流通过,执行登录逻辑(验证密码等) // 此处省略业务逻辑,模拟登录成功 return "登录成功" } -

注意事项:

- 限流维度:根据业务需求选择限流维度(如 IP、用户 ID、接口名称),避免单一维度被绕过;

- 滑动窗口优化:固定窗口限流存在"临界问题"(如窗口边界前后各发送 limit 次请求,实际单位时间内请求次数为 2*limit),可采用"滑动窗口限流"(基于 ZSet 存储请求时间戳,统计窗口内的请求次数)解决;

- 限流友好性:限流触发时,返回明确的错误信息和重试时间,提升用户体验。

-

-

消息队列(解耦异步任务,提升系统吞吐量)

-

业务背景:非实时性任务(如订单支付成功后发送短信通知、物流状态更新、数据异步同步),需解耦生产者和消费者,避免同步执行导致响应延迟。

-

实现逻辑:利用 Redis List 类型的

LPUSH(生产者入队)和BRPOP(消费者阻塞出队)命令,实现简单的消息队列,支持异步处理任务。 -

核心优势:部署简单、轻量级,无需额外引入 RabbitMQ、Kafka 等中间件,适合中小规模的异步任务场景。

-

Golang 代码示例(订单通知消息队列):

import ( "context" "fmt" "github.com/go-redis/redis/v8" "time" ) const ( OrderNotifyQueue = "queue:order:notify" // 订单通知队列键名 ) // 生产者:订单支付成功后,发送通知消息到队列 func PushOrderNotify(rdb *redis.Client, ctx context.Context, orderID int64, userID int64) error { // 消息内容:JSON 格式存储订单ID和用户ID message := fmt.Sprintf(`{"order_id":%d,"user_id":%d,"notify_type":"payment_success"}`, orderID, userID) // LPUSH 入队(从列表左侧插入) err := rdb.LPush(ctx, OrderNotifyQueue, message).Err() if err != nil { fmt.Printf("消息入队失败:orderID=%d, err=%v\n", orderID, err) return err } fmt.Printf("消息入队成功:orderID=%d\n", orderID) return nil } // 消费者:监听队列,阻塞获取消息并处理 func ConsumeOrderNotify(rdb *redis.Client, ctx context.Context) { for { // BRPOP 阻塞出队(从列表右侧弹出,无消息时阻塞,超时时间 0 表示永久阻塞) result, err := rdb.BRPop(ctx, 0, OrderNotifyQueue).Result() if err != nil { fmt.Printf("消息出队失败:%v\n", err) time.Sleep(time.Second * 2) // 失败后重试 continue } // result[0] 是队列名,result[1] 是消息内容 queueName := result[0] message := result[1] fmt.Printf("消费消息:队列=%s, 内容=%s\n", queueName, message) // 处理消息(发送短信、更新物流状态等) // 此处省略业务逻辑,模拟处理成功 time.Sleep(time.Millisecond * 100) // 模拟处理耗时 fmt.Printf("消息处理成功:%s\n", message) } } -

注意事项:

- 消息可靠性:Redis 消息队列不支持消息持久化(默认内存存储,Redis 宕机后消息丢失),需开启 Redis 持久化(RDB+AOF),并处理消费者宕机导致的消息未处理问题;

- 消息重复消费:消费者处理消息后未及时确认(Redis 无内置确认机制),可能导致消息重复消费,需在业务层实现幂等性(如基于订单 ID 去重);

- 高级特性缺失:Redis 消息队列不支持死信队列、延迟队列(需基于 ZSet 实现)、消息路由等高级特性,复杂场景建议使用专业消息队列。

-

-

数据共享与分布式会话(跨服务数据同步)

-

业务背景:分布式系统中,跨服务的数据共享(如用户登录状态、临时配置),需一个中心化的存储介质,避免数据分散在各个服务节点。

-

典型场景:分布式会话(用户登录后,将会话信息存储在 Redis 中,所有服务节点通过 Redis 获取会话信息,实现跨服务登录状态共享)。

-

数据结构选择:Hash 类型(存储会话详情,如

session:user_123的user_id、username、expire_time字段)。 -

Golang 代码示例(分布式会话存储与验证):

import ( "context" "fmt" "github.com/go-redis/redis/v8" "time" ) // 存储用户会话 func StoreSession(rdb *redis.Client, ctx context.Context, sessionID string, userID int64, username string, expire time.Duration) error { sessionKey := fmt.Sprintf("session:%s", sessionID) // Hash 类型存储会话字段 err := rdb.HMSet(ctx, sessionKey, map[string]interface{}{ "user_id": userID, "username": username, "create_at": time.Now().Unix(), }).Err() if err != nil { return err } // 设置会话过期时间(如 2 小时) return rdb.Expire(ctx, sessionKey, expire).Err() } // 验证会话有效性 func ValidateSession(rdb *redis.Client, ctx context.Context, sessionID string) (int64, string, error) { sessionKey := fmt.Sprintf("session:%s", sessionID) // 获取会话所有字段 sessionData, err := rdb.HGetAll(ctx, sessionKey).Result() if err != nil { return 0, "", err } if len(sessionData) == 0 { return 0, "", fmt.Errorf("会话不存在或已过期") } // 解析会话字段 userID := parseInt64(sessionData["user_id"]) username := sessionData["username"] // 延长会话过期时间(活跃用户自动续期) if err := rdb.Expire(ctx, sessionKey, time.Hour*2).Err(); err != nil { return 0, "", err } return userID, username, nil } func parseInt64(s string) int64 { // 省略字符串转 int64 逻辑 return 0 } -

注意事项:

- 会话安全:sessionID 需足够随机(如 UUID),避免被猜测;敏感信息(如密码)不存储在会话中;

- 过期时间:设置合理的会话过期时间,避免无效会话占用存储空间;活跃用户自动续期,提升用户体验;

- 持久化:开启 Redis 持久化,避免 Redis 重启导致所有会话丢失。

-

二、面试加分点

- 能结合具体项目场景说明 Redis 的使用,而非仅罗列场景,体现工程落地能力;

- 能提供完整的 Golang 代码示例(基于主流 Redis 客户端

go-redis/redis),展示代码编写规范和细节处理(如错误处理、过期时间设置); - 能指出每个场景的注意事项和优化方案(如缓存雪崩防护、分布式锁续期、限流临界问题解决),体现问题思考深度;

- 能对比 Redis 与其他方案的优劣(如 Redis 消息队列 vs Kafka、分布式锁 vs Zookeeper 锁),体现技术选型能力;

- 能提及 Redis 部署相关的优化(如持久化策略、集群模式、内存淘汰策略),体现运维意识。

记忆法

- 场景-特性-结构绑定记忆法:将使用场景与 Redis 核心特性、数据结构强绑定------缓存→高性能+String/Hash、分布式锁→原子性+String、限流→INCR+String、消息队列→List、分布式会话→Hash,通过"场景→特性→结构"的链条强化记忆;

- 核心场景口诀记忆法:总结口诀"缓存锁限流,消息加会话",每个关键词对应一个核心场景,结合具体业务案例(如缓存→商品详情、锁→秒杀),快速回忆场景细节和实现方案。

HTTP 与 HTTPS 的核心区别是什么?

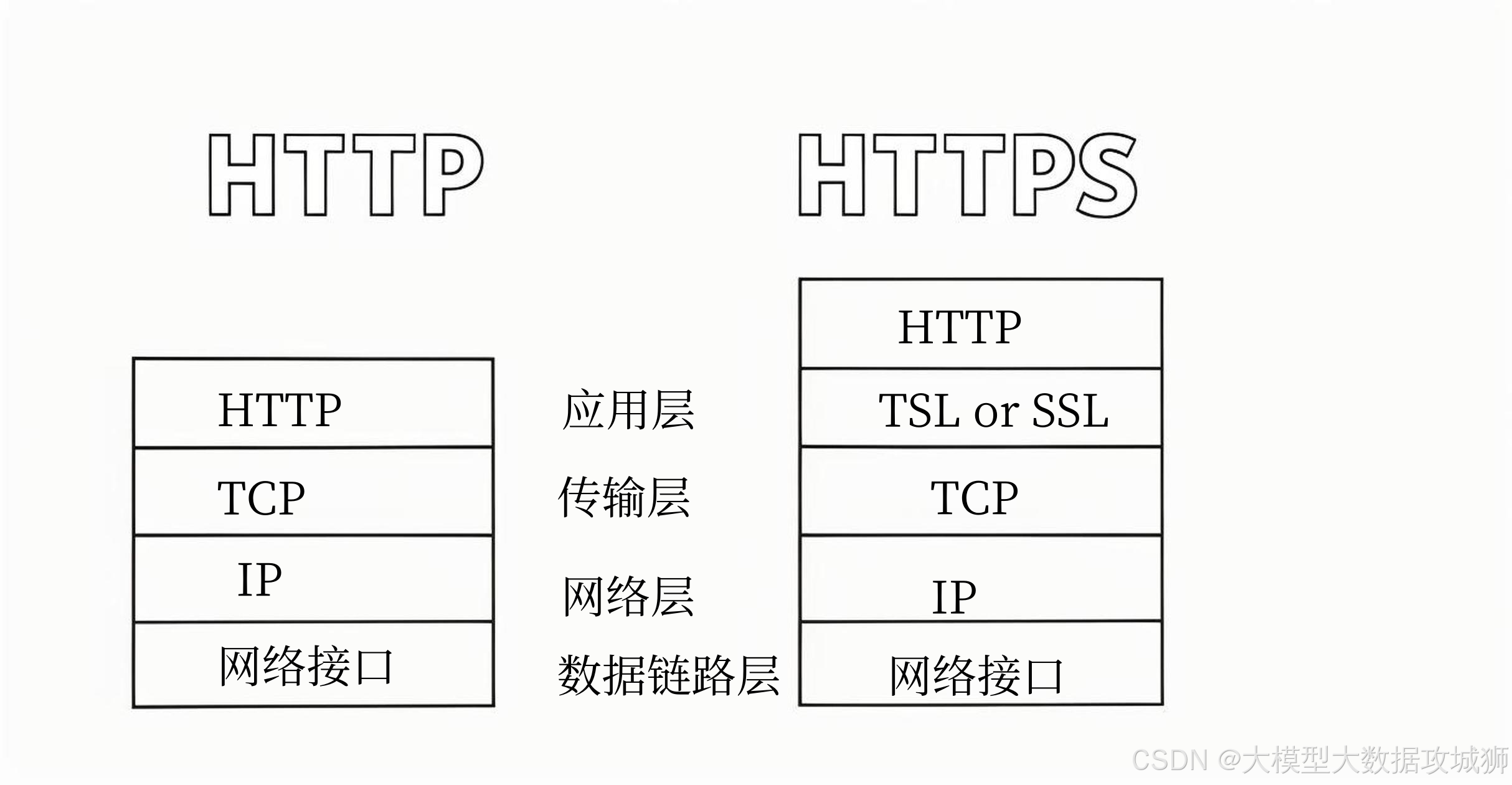

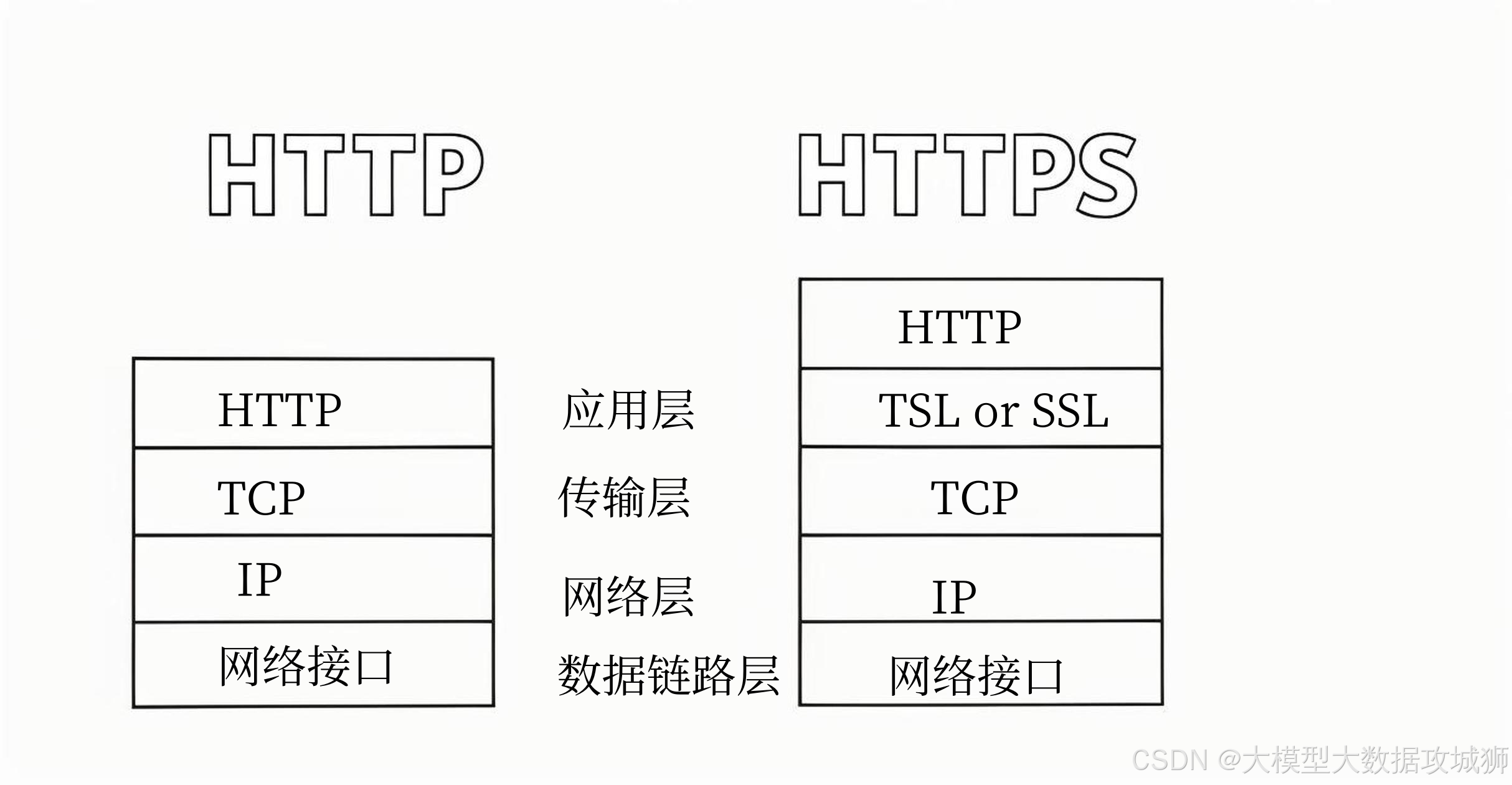

HTTP(超文本传输协议)和 HTTPS(超文本传输安全协议)的核心区别在于"安全性"------HTTPS 是在 HTTP 基础上引入 TLS/SSL 协议层实现加密传输,解决了 HTTP 明文传输带来的安全隐患,同时在端口、连接过程、性能等方面存在差异。以下从安全机制、传输过程、核心特性、适用场景等维度,全面解析两者的核心区别,结合底层原理和实际应用说明,体现对协议本质的理解。

一、核心区别总览表

| 对比维度 | HTTP | HTTPS |

|---|---|---|

| 核心定义 | 无加密的超文本传输协议,基于 TCP 直接传输明文数据 | HTTP + TLS/SSL 协议,通过加密实现安全传输 |

| 传输安全性 | 明文传输,数据易被窃听、篡改、伪造 | 加密传输,保障数据机密性、完整性、身份认证 |

| 底层协议栈 | 应用层直接基于 TCP 传输(HTTP → TCP) | 应用层→TLS/SSL 层→TCP(HTTP → TLS/SSL → TCP) |

| 端口 | 默认 80 端口 | 默认 443 端口 |

| 连接建立过程 | 三次握手后直接传输 HTTP 数据(无额外握手) | TCP 三次握手后,需额外进行 TLS/SSL 握手(协商加密算法、交换密钥) |

| 性能开销 | 无加密/解密开销,性能更高 | 存在 TLS/SSL 握手耗时和数据加解密开销,性能略低(可通过优化缓解) |

| 证书要求 | 无需证书 | 需配置 CA 签发的数字证书(用于身份认证,避免中间人攻击) |

| 数据完整性 | 无校验机制,数据可能被篡改 | 通过 MAC(消息认证码)或哈希算法校验,确保数据未被篡改 |

| 身份认证 | 无身份认证,无法确认服务器/客户端身份 | 基于数字证书验证服务器身份(可选验证客户端身份),避免访问伪造服务器 |

| 适用场景 | 非敏感数据传输(如静态网站、公开资讯) | 敏感数据传输(如电商支付、登录认证、金融交易) |

二、关键区别深度解析(核心重点)

-

传输安全性:明文 vs 加密(最核心区别)

-

HTTP 传输特性:HTTP 协议传输的所有数据(请求头、请求体、响应头、响应体)都是明文形式,数据在网络中传输时,任何中间节点(如路由器、网关、黑客监听设备)都能直接捕获并读取数据内容。

- 安全风险:

- 窃听:黑客可捕获用户登录的账号密码、支付信息等敏感数据;

- 篡改:黑客可修改传输的数据(如修改商品价格、订单金额);

- 伪造:黑客可伪造服务器响应(如伪造登录成功页面),实施钓鱼攻击。

- 示例:用户通过 HTTP 协议登录网站,请求数据

POST /login HTTP/1.1\r\nContent-Type: application/x-www-form-urlencoded\r\n\r\nusername=test&password=123456是明文传输,黑客监听网络即可获取账号密码。

- 安全风险:

-

HTTPS 传输特性:HTTPS 在 HTTP 与 TCP 之间增加了 TLS/SSL 协议层,所有数据传输前都会通过 TLS/SSL 进行加密,传输过程中是密文形式,中间节点无法解析数据内容。

- 加密机制:

- 握手阶段:采用非对称加密(如 RSA、ECC)交换会话密钥(对称加密密钥),非对称加密安全性高但效率低,仅用于密钥交换;

- 数据传输阶段:采用对称加密(如 AES、ChaCha20)加密实际数据,对称加密效率高,适合大量数据传输;

- 完整性校验:通过 HMAC(哈希消息认证码)或 SHA 哈希算法,对数据进行校验,确保数据传输过程中未被篡改;

- 身份认证:通过 CA 签发的数字证书,验证服务器身份,确保客户端连接的是真实服务器,而非中间人伪造的服务器。

- 示例:用户通过 HTTPS 登录网站,账号密码会被 AES 对称加密后传输,黑客即使捕获数据,也无法解密(无会话密钥),且无法篡改数据(篡改后 HMAC 校验失败)。

- 加密机制:

-

-

协议栈与连接建立过程:简单 vs 复杂

-

HTTP 连接建立:流程简单,仅需 TCP 三次握手后,直接发送 HTTP 请求数据,无额外开销。

- 流程:客户端→TCP 三次握手→发送 HTTP 请求→服务器返回 HTTP 响应→连接关闭(或 Keep-Alive 复用)。

-

HTTPS 连接建立:流程复杂,TCP 三次握手后,需额外进行 TLS/SSL 握手(通常 4-6 次交互),协商加密参数和交换密钥,之后才能传输 HTTP 数据。

- TLS 1.3 握手流程(优化后,较 TLS 1.2 更高效):

- 客户端发送 Client Hello:包含支持的加密套件、TLS 版本、随机数;

- 服务器发送 Server Hello + 证书 + 密钥交换信息:确认加密套件和 TLS 版本,返回服务器证书(用于身份认证),发送公钥或密钥交换参数;

- 客户端验证证书:验证证书是否由可信 CA 签发、证书是否过期、证书域名是否匹配;

- 客户端发送密钥交换响应 + 已加密的 Finished 消息:使用服务器公钥加密会话密钥,发送给服务器,同时发送加密的 Finished 消息(用于验证握手完整性);

- 服务器解密会话密钥 + 发送已加密的 Finished 消息:服务器用私钥解密会话密钥,发送加密的 Finished 消息;

- 握手完成:双方使用会话密钥进行对称加密,传输 HTTP 数据。

- 关键:TLS 握手是 HTTPS 性能开销的主要来源,TLS 1.3 相比 TLS 1.2 减少了交互次数(从 6 次交互减为 4 次),握手耗时显著降低。

- TLS 1.3 握手流程(优化后,较 TLS 1.2 更高效):

-

-

证书要求:无 vs 必须(身份认证的核心)

- HTTP 无证书要求:HTTP 协议不强制身份认证,服务器无需配置证书,任何人都可以搭建 HTTP 服务器,导致客户端无法确认服务器的真实性。

- HTTPS 必须配置 CA 证书:HTTPS 要实现身份认证,服务器必须配置由可信 CA(证书颁发机构,如 Let's Encrypt、Verisign)签发的数字证书。

- 证书的作用:

- 验证服务器身份:证书包含服务器域名、公钥、CA 签名等信息,客户端通过验证 CA 签名,确认证书的合法性,进而确认服务器身份;

- 分发公钥:证书中包含服务器公钥,客户端通过公钥加密会话密钥,实现密钥安全交换。

- 证书类型:

- 域名验证证书(DV 证书):仅验证域名所有权,免费(如 Let's Encrypt),适用于个人网站、小型应用;

- 组织验证证书(OV 证书):验证域名所有权和组织身份,收费,适用于企业网站;

- 扩展验证证书(EV 证书):最高级别验证,浏览器地址栏会显示绿色锁标和企业名称,适用于金融、电商等敏感场景。

- 风险提示:若服务器使用自签名证书(未经过 CA 签发),客户端会提示"证书不受信任",此时存在中间人攻击风险,不建议在生产环境使用。

- 证书的作用:

-

性能开销:低 vs 略高(可优化)

- HTTP 性能:无加密/解密、无额外握手流程,CPU 和网络开销低,响应速度快。

- HTTPS 性能:存在两方面开销:

- 握手开销:TLS 握手过程增加了网络交互次数和计算开销(如非对称加密运算),首次连接时握手耗时约 100-300ms;

- 数据传输开销:数据传输时的对称加密/解密需要 CPU 计算,相比 HTTP 增加了约 5-10% 的 CPU 开销。

- 优化方案:

- 复用连接:开启 HTTP Keep-Alive,复用 TCP 连接,减少 TLS 握手次数(后续请求无需重新握手);

- 启用 TLS 1.3:相比 TLS 1.2 减少握手交互,降低握手耗时;

- 会话复用:通过 Session ID 或 Session Ticket 复用之前的 TLS 会话,无需重新协商密钥;

- 硬件加速:使用支持 AES-NI 指令集的 CPU,加速对称加密/解密运算;

- CDN 加速:通过 CDN 分发 HTTPS 流量,减少网络延迟,同时 CDN 可优化 TLS 握手(如边缘节点缓存证书)。

三、其他补充区别

- 浏览器标识:HTTP 网站浏览器地址栏显示"不安全"标识,HTTPS 网站显示绿色锁标(部分浏览器对 EV 证书显示企业名称);

- 搜索引擎权重:搜索引擎(如 Google、百度)更倾向于收录 HTTPS 网站,且 HTTPS 网站在搜索结果中的排名更有优势;

- 兼容性:HTTP 兼容所有网络设备和浏览器,HTTPS 部分老旧设备或浏览器可能不支持最新的 TLS 版本(如 TLS 1.3),需兼容配置(如同时支持 TLS 1.2 和 TLS 1.3)。

四、面试加分点

- 能从"协议栈、加密机制、身份认证、性能开销"等底层维度解析区别,而非仅罗列表面差异(如端口、证书);

- 能详细说明 TLS/SSL 握手流程和加密机制(非对称加密交换密钥、对称加密传输数据),体现对 HTTPS 安全原理的理解;

- 能提及 HTTPS 性能优化方案,体现工程实践能力;

- 能结合适用场景说明选型逻辑(如敏感数据用 HTTPS,静态资源可酌情用 HTTP,但现在主流推荐全站 HTTPS);

- 能指出 HTTPS 并非绝对安全(如证书被劫持、弱加密套件被破解),体现辩证思维。

记忆法

- 核心区别口诀记忆法:总结口诀"HTTP 明文无证书,80 端口性能优;HTTPS 加密需 CA,443 端口安全高",每个关键词对应核心区别(明文/加密、无证书/需 CA、端口、性能/安全),快速回忆核心要点;

- 分层记忆法:按"安全核心→协议流程→特性扩展"分层记忆------安全核心(明文 vs 加密+认证)是根本区别,协议流程(简单 TCP 握手 vs TCP+TLS 握手)是实现差异,特性扩展(端口、性能、证书)是衍生区别,通过分层逻辑强化记忆。

HTTP 的 GET 请求与 HEAD 请求有什么区别?

HTTP 的 GET 和 HEAD 请求均属于"安全、幂等"的请求方法,核心用途都是获取服务器资源,但两者的核心区别在于响应体的返回策略:GET 请求会返回完整的响应体(包含资源数据),而 HEAD 请求仅返回响应头(不返回响应体)。除此之外,两者在请求格式、适用场景、服务器处理逻辑等方面存在关联与差异,以下结合 HTTP 协议规范和实际应用场景,全面解析两者的区别与联系。

一、核心区别总览表

| 对比维度 | GET 请求 | HEAD 请求 |

|---|---|---|

| 核心用途 | 获取服务器资源的完整数据(响应头+响应体) | 获取服务器资源的元信息(仅响应头),验证资源是否存在、更新时间等 |

| 响应返回 | 响应头(Headers)+ 响应体(Body) | 仅响应头(Headers),响应体为空(即使服务器返回响应体,客户端也会忽略) |

| 响应状态码 | 成功时返回 200 OK,同时携带响应体 | 成功时返回 200 OK(与 GET 一致),但无响应体;其他状态码与 GET 一致(如 404 Not Found、301 重定向) |

| 服务器处理逻辑 | 解析请求→查询资源→生成响应头→生成响应体→返回完整响应 | 解析请求→查询资源→生成响应头→不生成响应体→返回仅含响应头的响应(处理逻辑与 GET 一致,仅省略响应体生成步骤) |

| 适用场景 | 浏览网页、查询数据、获取静态资源(图片、JS、CSS)等需要资源内容的场景 | 验证资源是否存在、获取资源元信息(文件大小、更新时间)、检查资源是否过期、测试接口可用性等无需资源内容的场景 |

| 性能开销 | 需传输响应体,若资源较大(如大文件),网络和服务器开销较高 | 无需传输响应体,网络传输量小,服务器无需生成和传输响应体,开销更低 |

| 缓存行为 | 可被浏览器、代理服务器缓存(符合缓存规则时) | 与 GET 一致,可被缓存(响应头中的 Cache-Control、ETag 等缓存字段有效),后续请求可复用缓存的响应头 |

| 请求参数 | 通常通过 URL 传递(参数拼接在 URL 后),长度受浏览器 |

TCP 与 UDP 的区别是什么?UDP 的优点及适用场景有哪些?

TCP(传输控制协议)和 UDP(用户数据报协议)是 TCP/IP 协议栈中传输层的核心协议,两者的核心差异源于"可靠性"与"效率"的权衡:TCP 是面向连接、可靠的字节流协议,牺牲部分效率保障数据传输的完整性和顺序性;UDP 是无连接、不可靠的数据报协议,放弃可靠性换取低延迟和高吞吐量。以下从协议特性、传输机制、适用场景等维度全面解析区别,并聚焦 UDP 的优点与落地场景。

一、TCP 与 UDP 的核心区别总览表

| 对比维度 | TCP | UDP |

|---|---|---|

| 连接特性 | 面向连接(需三次握手建立连接,四次挥手关闭连接) | 无连接(发送数据前无需建立连接,直接发送) |

| 可靠性 | 可靠传输(保证数据无丢失、无重复、按序到达) | 不可靠传输(不保证数据到达、不保证顺序、可能丢失或重复) |

| 传输方式 | 字节流传输(数据无边界,按字节流连续传输) | 数据报传输(数据以独立数据包为单位传输,每个数据包含完整地址信息) |

| 拥塞控制 | 有(滑动窗口、慢启动、拥塞避免等算法,动态调整发送速率) | 无(发送速率由应用层控制,不感知网络拥塞) |

| 流量控制 | 有(基于滑动窗口机制,避免接收方缓冲区溢出) | 无(不控制发送速率,可能导致接收方处理不及时) |

| 头部开销 | 较大(固定头部 20 字节,含序列号、确认号、窗口大小等字段) | 极小(固定头部 8 字节,仅含源端口、目的端口、长度、校验和) |

| 延迟性能 | 较高(连接建立、重传、拥塞控制等机制增加延迟) | 极低(无连接开销、无重传机制,数据发送延迟小) |

| 适用场景 | 需可靠传输的场景(文件传输、HTTP/HTTPS、数据库交互) | 对延迟敏感、可容忍少量数据丢失的场景(实时音视频、游戏、物联网) |

二、核心区别深度解析

-

连接与可靠性:面向连接的可靠传输 vs 无连接的不可靠传输

- TCP 的可靠性保障机制:

- 三次握手建立连接:确保客户端和服务器双方的收发能力正常,同步初始序列号(ISN),为后续数据传输的顺序性和完整性奠定基础;

- 序列号与确认号:每个 TCP 段都带有序列号(标记数据字节位置),接收方收到数据后返回确认号(表示期望接收的下一字节位置),发送方未收到确认则重传数据;

- 重传机制:超时重传(发送后未按时收到确认则重传)、快速重传(收到 3 个重复确认则立即重传),避免数据丢失;

- 流量控制:接收方通过窗口大小字段告知发送方自身缓冲区剩余空间,发送方据此调整发送速率,避免接收方缓冲区溢出;

- 拥塞控制:通过慢启动、拥塞避免、快速恢复等算法,感知网络拥塞状态(如丢包),动态降低发送速率,避免网络崩溃。

- UDP 的不可靠性体现:

- 无连接建立过程:发送方直接将数据封装成 UDP 数据报,通过 IP 协议发送,无需确认接收方是否就绪;

- 无重传机制:发送方发送数据后不保留副本,接收方收到数据后也不返回确认,数据丢失后需应用层自行处理;

- 无顺序保障:UDP 数据报在网络中传输可能因路由延迟不同导致乱序,接收方按收到的顺序交付应用层,不做排序处理;

- 无流量/拥塞控制:发送方持续按应用层速率发送数据,不管接收方处理能力和网络拥塞状态,可能导致数据丢失或接收方过载。

- TCP 的可靠性保障机制:

-

传输方式与头部开销:字节流 vs 数据报,高开销 vs 低开销

- TCP 字节流传输:TCP 将应用层数据视为连续的字节流,拆分成长度合适的 TCP 段(MSS 限制)传输,接收方接收后重组字节流,交付应用层时无数据边界(需应用层自行定义边界,如 HTTP 协议的 Content-Length 字段)。TCP 头部含序列号、确认号、窗口大小、紧急指针等多个控制字段,固定开销 20 字节,加上选项字段后开销更大,传输效率较低。

- UDP 数据报传输:UDP 保留应用层数据的边界,应用层发送的每一块数据都会被封装成一个独立的 UDP 数据报(最大长度 65507 字节),接收方接收后按数据报原样交付应用层,无需重组。UDP 头部仅含源端口、目的端口、数据报长度、校验和 4 个字段,固定开销 8 字节,是 TCP 头部开销的 1/3 左右,传输效率极高,尤其适合小数据包传输。

-

延迟与吞吐量:高延迟低吞吐量 vs 低延迟高吞吐量

- TCP 延迟来源:连接建立(三次握手约 1-3 个 RTT)、连接关闭(四次挥手)、重传等待(超时重传需等待 RTO)、拥塞控制(慢启动阶段发送速率低),这些机制导致 TCP 延迟较高,不适合实时场景。但 TCP 的可靠性保障使其吞吐量稳定,不会因数据丢失导致无效传输。

- UDP 延迟优势:无连接开销(无需握手/挥手)、无重传等待、无拥塞控制限制,数据从应用层到网络层的转发路径极短,端到端延迟可低至毫秒级。UDP 不控制发送速率,在网络带宽充足时能实现高吞吐量(如大文件多线程 UDP 传输),但网络拥塞时会出现大量丢包,吞吐量下降。

三、UDP 的优点及适用场景

-

UDP 的核心优点

- 低延迟:无连接建立/关闭开销,无重传和拥塞控制的等待时间,数据发送延迟远低于 TCP,是实时应用的核心优势;

- 高吞吐量:头部开销小,无传输层控制机制的速率限制,在带宽充足时能充分利用网络资源,适合大数据量快速传输;

- 简单灵活:协议逻辑简单,无需维护连接状态(如序列号、窗口大小),服务器可同时处理大量 UDP 连接(如物联网设备接入),客户端实现成本低;

- 支持广播/多播:UDP 原生支持广播(向同一网络内所有设备发送数据)和多播(向特定组内设备发送数据),TCP 仅支持点对点单播;

- 无粘包问题:UDP 数据报保留应用层数据边界,接收方按数据报独立处理,无需应用层额外处理粘包(TCP 字节流需应用层定义边界)。

-

UDP 的适用场景(结合实际应用)

- 实时音视频传输(核心场景):如视频通话(Zoom、微信视频)、直播(抖音、快手)、VoIP(网络电话)。这类场景对延迟敏感(延迟超过 100ms 会影响体验),且可容忍少量数据丢失(单个数据包丢失仅导致瞬间画面模糊或声音卡顿,不影响整体体验)。应用层通过 RTP/RTCP 协议补充 UDP 的不足:RTP 负责数据封装和序列号排序,RTCP 负责丢包统计和带宽协商,实现"准可靠"传输。

- 在线游戏(高频场景):如王者荣耀、英雄联盟等多人在线游戏。游戏需实时同步玩家位置、操作指令(如按键、释放技能),延迟直接影响游戏公平性和体验(延迟超过 50ms 会出现"卡顿")。UDP 能快速传输指令数据,应用层通过"预测补偿"(如根据玩家历史位置预测当前位置)和"重传关键数据"(如技能释放指令)解决少量丢包问题。

- 物联网(IoT)设备通信:如智能家居设备(摄像头、传感器)、工业传感器数据采集。这类设备通常带宽有限、计算能力弱(无法承担 TCP 复杂的协议处理),且数据多为短数据包(如传感器的温度、湿度数据,仅几十字节)。UDP 低开销、简单灵活的特性适合设备批量接入,应用层通过轻量级协议(如 MQTT-SN)实现数据可靠传输。

- 广播/多播场景:如局域网内的设备发现(如打印机、智能电视的局域网搜索)、实时数据推送(如股票行情、体育赛事比分直播)。UDP 广播可让设备快速发现同一网络内的服务,多播可高效向多个订阅者推送数据(避免 TCP 单播的带宽浪费)。

- 大文件传输(优化场景):如网盘文件下载、视频文件分发。传统 TCP 传输大文件时,拥塞控制和重传机制导致传输速率不稳定,尤其在跨网传输时效率低。UDP 可通过应用层优化(如 BitTorrent 协议、QUIC 协议)实现高速传输:分块传输数据、多线程并发发送、应用层重传丢失的块、动态调整发送速率,在带宽充足时吞吐量远高于 TCP。

- DNS 解析:DNS 协议基于 UDP 传输,原因是 DNS 查询请求和响应均为短数据包(通常小于 512 字节),UDP 低延迟的特性可快速返回解析结果,提升网页加载速度。若查询结果超过 512 字节,DNS 会自动切换到 TCP 传输。

四、面试加分点

- 能从协议底层机制(如三次握手、序列号、滑动窗口)解释 TCP 可靠性的实现,而非仅罗列"可靠""不可靠"等表面特性;

- 能结合 UDP 的优点,分析具体应用场景的选型逻辑(如实时音视频选 UDP 是因为延迟敏感,而非单纯"适合");

- 能提及 UDP 应用层的补充方案(如 RTP/RTCP、MQTT-SN、QUIC),体现对协议落地的理解;

- 能对比 QUIC 协议(基于 UDP 的可靠传输协议),说明 UDP 的扩展性优势(可在应用层实现自定义的可靠性机制);

- 能举例说明 TCP 和 UDP 的实际应用(如 HTTP/HTTPS 用 TCP,DNS/游戏用 UDP),体现工程实践认知。

记忆法

- 核心区别口诀记忆法:总结口诀"TCP 连接可靠流,拥塞流量都可控;UDP 无连不可靠,低延高吞开销小",每个关键词对应核心特性(连接/无连、可靠/不可靠、字节流/数据报、拥塞控制/无、低延迟/高延迟、低开销/高开销),快速回忆区别;

- 场景-优点绑定记忆法:将 UDP 场景与优点强绑定------实时音视频/游戏→低延迟,物联网→简单低开销,广播/多播→原生支持,大文件传输→高吞吐量,通过"场景→优点"的链条强化记忆,避免混淆适用场景。

TCP 三次握手的过程是什么?为什么需要三次握手?

TCP 三次握手是 TCP 协议建立面向连接、可靠传输的核心流程,本质是"双方确认彼此收发能力正常,并同步初始序列号(ISN)"的过程。三次握手的设计既保证了连接建立的可靠性,又避免了资源浪费,是 TCP 协议兼顾"可靠"与"高效"的关键。以下详细拆解三次握手的具体过程,结合协议底层逻辑解释"为什么需要三次握手",而非两次或四次。

一、TCP 三次握手的完整过程(基于 TCP 头部核心字段)

在理解三次握手前,需明确 TCP 头部的两个关键字段:

- 序列号(Sequence Number,SEQ):标记当前发送的数据段中,第一个字节的序号(用于保证数据按序到达);

- 确认号(Acknowledgment Number,ACK):标记期望接收的下一个数据段的序列号(ACK=对方上一个 SEQ + 1,用于确认已收到对方数据);

- 标志位(Flags):核心是 SYN(同步序列号,用于发起连接)和 ACK(确认标志,用于确认收到数据)。

假设通信双方为客户端(主动发起连接方)和服务器(被动监听连接方),三次握手的具体过程如下:

-

第一次握手:客户端 → 服务器(SYN 报文,发起连接)

- 客户端状态变化:从 CLOSED 状态进入 SYN-SENT 状态;

- 报文特征:TCP 头部 SYN 标志位为 1,ACK 标志位为 0;

- 核心字段:客户端生成一个随机的初始序列号(ISN_c,如 100),填入 SEQ 字段(SEQ=100);

- 目的:客户端向服务器表明"我想和你建立连接,请你确认你的接收能力,并同步你的初始序列号"。

-

第二次握手:服务器 → 客户端(SYN+ACK 报文,确认并同步)

- 服务器状态变化:从 LISTEN 状态进入 SYN-RCVD 状态;

- 报文特征:TCP 头部 SYN 标志位为 1,ACK 标志位为 1(同时携带同步和确认信息);

- 核心字段:

- ACK 字段:填入客户端 ISN_c + 1(如 100 + 1 = 101),表示"我已收到你 SEQ=100 的报文,下次请发送 SEQ=101 及以后的数据";

- SEQ 字段:服务器生成自己的随机初始序列号(ISN_s,如 200),填入 SEQ 字段(SEQ=200);

- 目的:服务器向客户端确认"我收到了你的连接请求,我的接收能力正常;同时我也发起同步,请你确认你的接收能力,并记录我的初始序列号"。

-

第三次握手:客户端 → 服务器(ACK 报文,最终确认)

- 客户端状态变化:从 SYN-SENT 状态进入 ESTABLISHED 状态(连接建立完成);

- 服务器状态变化:收到 ACK 报文后,从 SYN-RCVD 状态进入 ESTABLISHED 状态;

- 报文特征:TCP 头部 ACK 标志位为 1,SYN 标志位为 0;

- 核心字段:

- ACK 字段:填入服务器 ISN_s + 1(如 200 + 1 = 201),表示"我已收到你 SEQ=200 的报文,下次请发送 SEQ=201 及以后的数据";

- SEQ 字段:填入客户端上一次 SEQ + 1(如 100 + 1 = 101);

- 目的:客户端向服务器最终确认"我收到了你的同步信息,我的接收能力正常,现在双方的序列号已同步,连接可以正式传输数据了"。

关键结论:三次握手完成后,客户端和服务器均确认了对方的收发能力,且同步了彼此的初始序列号(ISN_c 和 ISN_s),后续数据传输时,双方通过序列号和确认号保证数据的顺序性和完整性。

二、为什么需要三次握手?(核心原因:确认双向收发能力+避免无效连接)

三次握手的设计是 TCP 协议"可靠性"的基础,核心解决两个关键问题:确认双方双向收发能力正常 和避免历史无效连接请求耗尽服务器资源,少一次(两次)会导致可靠性缺失,多一次(四次)则造成资源浪费。

- 核心原因 1:确认双方"双向"收发能力正常(两次握手无法实现)TCP 是面向连接的可靠传输协议,必须确保客户端和服务器的"发送能力"和"接收能力"均正常(即双向通信通路畅通),三次握手是实现这一目标的最低成本方案。

-

若仅用两次握手:流程变为"客户端发送 SYN → 服务器发送 SYN+ACK → 连接建立"。此时:

- 服务器仅确认了"客户端的发送能力正常"(能收到客户端的 SYN)和"自己的接收能力正常",但无法确认"客户端的接收能力正常"(服务器发送的 SYN+ACK 可能丢失,客户端未收到);

- 服务器认为连接已建立,会为连接分配资源(如缓冲区、端口),但客户端未收到 SYN+ACK,不会认为连接建立,也不会发送数据,导致服务器资源被无效占用(直到超时释放);

- 举例:客户端发送 SYN 后,报文在网络中丢失,客户端超时后重发 SYN;若第一次丢失的 SYN 后续到达服务器,服务器发送 SYN+ACK 但客户端未收到(因客户端已重发并建立新连接),服务器会一直维护这个无效连接,浪费资源。

-

三次握手如何解决:第三次握手的 ACK 报文,是客户端向服务器证明"我能收到你的数据(SYN+ACK),我的接收能力正常"。只有服务器收到第三次握手的 ACK,才能确认"客户端收发能力正常,自己收发能力正常",双向通路畅通,此时分配资源才合理。

- 核心原因 2:同步双方初始序列号(ISN),为可靠传输奠定基础TCP 需通过序列号和确认号保证数据的无重复、按序到达,而序列号的起点(ISN)必须由双方协商并同步,三次握手是同步 ISN 的必经过程。

-

ISN 的特性:ISN 不是固定值(如 0),而是随机生成的(避免历史数据段与当前连接的数据段混淆)。例如,客户端 ISN_c=100,服务器 ISN_s=200,后续客户端发送数据时 SEQ 从 101 开始,服务器发送数据时 SEQ 从 201 开始,双方通过 ACK 字段确认已收到的序列号范围。

-

两次握手无法同步 ISN:若仅两次握手,服务器发送 SYN+ACK 时同步了自己的 ISN_s,但无法确认客户端是否收到 ISN_s(客户端可能未收到 SYN+ACK,导致 ISN 同步失败)。第三次握手的 ACK 字段(ACK=ISN_s+1),是客户端告知服务器"我已收到你的 ISN_s,后续你发送数据请从 ISN_s+1 开始",完成 ISN 双向同步。

- 核心原因 3:避免历史无效连接请求("延迟的 SYN 报文")耗尽服务器资源网络中可能存在"延迟的 SYN 报文":客户端之前发起的连接请求(SYN)因网络拥堵等原因延迟到达服务器,此时客户端可能已超时重发并建立新连接,或已放弃连接。若仅两次握手,服务器收到延迟的 SYN 后,会直接发送 SYN+ACK 并建立连接,分配资源,但客户端不会回应(因不认可该连接),导致服务器资源被无效占用。

- 三次握手如何避免:服务器收到延迟的 SYN 后,发送 SYN+ACK,但客户端会发现该 SYN 对应的连接已不存在(或未发起),不会发送第三次握手的 ACK。服务器等待 ACK 超时后(通常 30-60 秒),会释放该连接的资源,避免资源浪费。而两次握手时,服务器发送 SYN+ACK 后就认为连接建立,资源会被长期占用,直到超时。

- 为什么不需要四次握手?(效率优化)四次握手的逻辑是"客户端 SYN → 服务器 ACK → 服务器 SYN → 客户端 ACK",但 TCP 协议将"服务器 ACK"和"服务器 SYN"合并为一个"SYN+ACK"报文,减少一次网络交互,提升连接建立效率。由于 ACK 和 SYN 是不同的标志位,可在同一个 TCP 报文中携带,不影响功能,因此三次握手是"可靠"与"高效"的最优平衡。

三、面试加分点

- 能结合 TCP 头部的 SEQ、ACK、SYN 字段拆解握手过程,体现对协议底层的理解;

- 能从"双向收发能力确认""ISN 同步""避免历史无效连接"三个核心维度解释三次握手的必要性,而非仅说"保证可靠";

- 能对比两次握手的缺陷(如资源浪费、无法确认客户端接收能力),强化三次握手的合理性;

- 能提及 ISN 的随机性设计(避免历史数据混淆),体现对协议细节的关注;

- 能结合实际场景(如高并发服务器的 SYN 洪水攻击,与三次握手的 SYN-RCVD 状态相关),体现工程实践认知。

记忆法

- 过程口诀记忆法:总结口诀"客发 SYN 求连接,服回 SYN+ACK 应,客发 ACK 终确认,双向通路全打通",每个分句对应一次握手,明确发送方、报文特征和目的,快速回忆流程;

- 原因分层记忆法:将"为什么需要三次握手"分为"能力确认""ISN 同步""避免无效连接"三层,每层绑定核心逻辑(双向收发、可靠传输基础、资源保护),通过分层逻辑强化记忆,避免遗漏关键原因。

TCP 中 TIME-WAIT 状态的作用是什么?

TIME-WAIT 是 TCP 连接关闭过程中,主动关闭连接一方(可能是客户端或服务器)在发送 FIN+ACK 报文后,进入的一个关键状态,默认持续时间为 2 倍的最大报文段寿命(2MSL,RFC 标准推荐 MSL 为 2 分钟,实际系统中通常配置为 30 秒或 1 分钟)。TIME-WAIT 状态的核心作用是"保障 TCP 连接关闭的可靠性"和"避免历史数据干扰新连接",是 TCP 协议设计中兼顾可靠性与兼容性的关键机制,以下从四个核心作用展开解析,结合协议底层逻辑和实际问题说明。

一、核心作用 1:确保被动关闭方能收到最终的 ACK 报文(避免 FIN 报文丢失导致的连接残留)

TCP 连接关闭过程(四次挥手)的核心流程:

- 主动关闭方(A)发送 FIN 报文,表明"我已无数据要发送",进入 FIN-WAIT-1 状态;

- 被动关闭方(B)收到 FIN 后,返回 ACK 报文,表明"我已收到你的关闭请求",进入 CLOSE-WAIT 状态(此时 B 可能仍有数据要发送);

- B 发送完所有数据后,发送 FIN 报文,表明"我也无数据要发送",进入 LAST-ACK 状态;

- A 收到 B 的 FIN 后,返回 ACK 报文,表明"我已收到你的关闭请求",进入 TIME-WAIT 状态(而非直接进入 CLOSED 状态);

- B 收到 A 的 ACK 后,进入 CLOSED 状态;

- A 等待 2MSL 后,确认 B 已收到 ACK,进入 CLOSED 状态。

TIME-WAIT 状态的第一个关键作用,是解决"第四步 A 发送的 ACK 报文丢失"的问题:

- 若 A 发送 ACK 后直接进入 CLOSED 状态,而该 ACK 报文在网络中丢失,B 会因未收到 ACK 而超时重传 FIN 报文;

- 此时 A 已关闭连接,无法识别 B 重传的 FIN 报文(认为是无效报文),会返回 RST 报文,导致 B 无法正常关闭连接(B 会一直停留在 LAST-ACK 状态,直到超时释放资源);

- A 进入 TIME-WAIT 状态后,会等待 2MSL:MSL 是 TCP 报文在网络中的最大生存时间(超过 MSL 未被接收则丢弃),2MSL 确保网络中与该连接相关的所有报文(包括 B 重传的 FIN 报文)都已消失。若 A 在 TIME-WAIT 期间收到 B 重传的 FIN 报文,会重新发送 ACK 报文,并重置 TIME-WAIT 计时器,确保 B 最终能收到 ACK,正常关闭连接。

二、核心作用 2:避免历史数据段干扰新连接(防止"幽灵报文"导致的数据错乱)

TCP 连接的唯一标识是"四元组":源 IP、源端口、目的 IP、目的端口。当一个 TCP 连接关闭后,若短期内使用相同的四元组建立新连接,网络中可能残留着上一个连接的"延迟数据段"(又称"幽灵报文"),这些报文若被新连接接收,会导致数据错乱(如覆盖新连接的有效数据、破坏序列号同步)。

TIME-WAIT 状态的 2MSL 等待时间,正是为了让网络中所有与上一个连接相关的报文自然过期:

- MSL 是报文的最大生存时间,2MSL 确保上一个连接的所有报文(包括发送方未收到确认的重传报文、网络延迟的报文)都已被丢弃,不会进入新连接;

- 举例:假设上一个连接的四元组为(客户端 IP:192.168.1.1,端口:5000;服务器 IP:10.0.0.1,端口:80),连接关闭后,客户端立即使用端口 5000 与服务器端口 80 建立新连接。若网络中残留着上一个连接的报文(SEQ=1000,数据为"旧数据"),该报文可能被新连接的服务器接收,而新连接的序列号可能从 2000 开始,服务器会误认为该报文是新连接的有效数据,导致数据错乱。TIME-WAIT 状态的 2MSL 等待,可避免这种情况。

三、核心作用 3:保证连接关闭的完整性(协调双方资源释放)

TCP 连接关闭是一个双向过程,主动关闭方和被动关闭方需各自释放连接相关的资源(如缓冲区、端口、序列号计数器)。TIME-WAIT 状态的等待时间,为双方资源释放提供了缓冲:

- 主动关闭方在 TIME-WAIT 期间,会保留连接的相关状态(如序列号范围、端口占用),避免因资源过早释放导致无法处理被动关闭方的重传 FIN 报文;

- 被动关闭方收到 ACK 后,会立即释放资源,而主动关闭方的 2MSL 等待,确保被动关闭方有足够的时间完成资源释放,避免新连接建立时与旧连接的资源冲突。

四、TIME-WAIT 状态的常见问题与优化(面试延伸)

TIME-WAIT 状态是必要的,但在高并发场景(如服务器频繁处理短连接,如 HTTP 短连接)中,会出现大量 TIME-WAIT 状态的连接,导致服务器端口耗尽(每个 TIME-WAIT 连接会占用一个端口),影响新连接建立。常见优化方案如下:

- 调整 2MSL 时间:通过系统参数(如 Linux 的

net.ipv4.tcp_fin_timeout)减小 TIME-WAIT 超时时间(如从 60 秒改为 30 秒),但需注意不能过小(否则无法保证历史报文过期); - 启用端口复用(SO_REUSEADDR):允许应用程序绑定已处于 TIME-WAIT 状态的端口,避免端口耗尽。但需注意,端口复用仅适用于"四元组不完全相同"的新连接,且需确保应用层能处理可能的历史报文(如通过序列号过滤);

- 启用快速回收(TCP_FASTOPEN):在支持 TCP Fast Open 的场景下,减少连接建立的延迟,间接降低 TIME-WAIT 连接的积累;

- 采用长连接:如 HTTP Keep-Alive,减少短连接的创建和关闭频率,从根源上减少 TIME-WAIT 连接数量;

- 调整连接队列参数:如 Linux 的

net.ipv4.tcp_max_tw_buckets,限制 TIME-WAIT 连接的最大数量,超出后会强制关闭旧的 TIME-WAIT 连接(需谨慎使用,避免影响正常连接)。

五、面试加分点

- 能结合 TCP 四次挥手流程,说明 TIME-WAIT 状态的触发时机(主动关闭方发送最终 ACK 后),体现对连接关闭过程的理解;

- 能从"确保 ACK 送达""避免历史报文干扰""协调资源释放"三个核心维度解析作用,而非仅说"等待报文过期";

- 能解释 2MSL 的含义(2 倍最大报文段寿命)及设计逻辑(确保历史报文丢弃+处理重传 FIN);

- 能结合高并发场景的实际问题(端口耗尽),给出合理的优化方案,体现工程实践能力;

- 能区分 TIME-WAIT 与 CLOSE-WAIT 状态(CLOSE-WAIT 是被动关闭方未发送 FIN 时的状态,通常因应用层未处理关闭请求导致),体现对 TCP 状态机的熟悉。

记忆法

- 核心作用口诀记忆法:总结口诀"TIME-WAIT 等两事,ACK 送达防丢失,历史报文全过期,新连接无干扰",每个分句对应一个核心作用(确保 ACK 送达、避免历史报文干扰),快速回忆核心要点;

- 逻辑关联记忆法:将 TIME-WAIT 与"连接关闭可靠性""新连接安全性"强关联------TIME-WAIT 是为了让旧连接"干净地退出",既保证旧连接的关闭流程完整,又不影响新连接的正常运行,通过"旧连接收尾→新连接保障"的逻辑链强化记忆。

常见的 HTTP 状态码有哪些?请解释 201、301、302、401、403、404 的含义?

HTTP 状态码是服务器对客户端请求的响应状态标识,由三位数字组成,分为 5 大类(1xx-5xx),核心作用是"快速告知客户端请求处理结果",便于客户端(如浏览器、APP)做出对应处理(如重定向、重试、提示错误)。以下先梳理常见的 HTTP 状态码分类及核心场景,再重点解析 6 个高频状态码的含义、使用场景及注意事项,结合实际应用说明,体现对协议落地的理解。

一、HTTP 状态码分类及常见状态码总览

HTTP 状态码按首位数字分为 5 大类,每类对应不同的响应场景:

| 状态码分类 | 首位数字 | 核心含义 | 常见状态码 |

|---|---|---|---|

| 信息性状态码 | 1xx | 服务器已接收请求,需客户端继续处理(临时响应) | 100 Continue(预检后继续发送请求体)、101 Switching Protocols(切换协议,如 HTTP 升级为 WebSocket) |

| 成功状态码 | 2xx | 请求已被服务器成功接收、理解并处理 | 200 OK(请求成功)、201 Created(资源创建成功)、204 No Content(请求成功但无响应体)、206 Partial Content(部分内容请求成功,如断点续传) |

| 重定向状态码 | 3xx | 请求需客户端进一步操作(如跳转至其他 URL)才能完成 | 301 Moved Permanently(永久重定向)、302 Found(临时重定向)、304 Not Modified(缓存命中,无需重新获取资源)、307 Temporary Redirect(临时重定向,不允许修改请求方法) |

| 客户端错误状态码 | 4xx | 客户端请求存在错误(如参数非法、权限不足),服务器无法处理 | 400 Bad Request(请求参数错误)、401 Unauthorized(未授权,需登录)、403 Forbidden(权限不足,禁止访问)、404 Not Found(资源不存在)、405 Method Not Allowed(请求方法不支持)、408 Request Timeout(请求超时)、429 Too Many Requests(请求过于频繁,限流) |

| 服务器错误状态码 | 5xx | 服务器处理请求时发生内部错误(与客户端无关) | 500 Internal Server Error(服务器内部错误)、502 Bad Gateway(网关错误,如反向代理后端服务不可用)、503 Service Unavailable(服务不可用,如服务器过载、维护)、504 Gateway Timeout(网关超时,如后端服务响应超时) |

二、高频状态码(201、301、302、401、403、404)详细解析

-

201 Created(资源创建成功,成功状态码)

-

核心含义:客户端的 POST/PUT 请求已成功处理,且在服务器端创建了新的资源(如创建用户、创建订单、上传文件)。

-

关键特性:

- 响应头需包含

Location字段,指定新创建资源的 URI(客户端可通过该 URI 访问新资源); - 响应体通常包含新资源的详细信息(如创建的订单 ID、用户信息),也可返回空(需结合业务场景)。

- 响应头需包含

-

适用场景:

- 客户端提交表单创建资源(如用户注册:POST /api/users,服务器创建用户后返回 201,Location 为 /api/users/1001);

- 上传文件(如 POST /api/files,服务器接收文件后存储,返回 201,Location 为 /api/files/xxx.pdf);

- 提交订单(POST /api/orders,服务器创建订单后返回 201,Location 为 /api/orders/20240101001)。

-

与 200 OK 的区别:200 表示"请求成功"(如查询数据、更新资源),不强调"创建新资源";201 明确表示"资源创建成功",且必须返回新资源的 URI。

-

示例响应: http

HTTP/1.1 201 Created Location: /api/users/1001 Content-Type: application/json { "id": 1001, "username": "test", "email": "test@example.com", "created_at": "2024-01-01T12:00:00Z" }

-

-

301 Moved Permanently(永久重定向,重定向状态码)

- 核心含义:请求的资源已被永久移动到新的 URI,后续所有请求都应使用新 URI,而非原 URI。

- 关键特性:

- 响应头包含

Location字段,指定新的资源 URI; - 浏览器会缓存该重定向关系(下次访问原 URI 时,直接跳转新 URI,无需向服务器发送请求);

- 搜索引擎会更新索引,将原 URI 指向新 URI(有利于 SEO,避免原 URI 权重丢失);

- 请求方法转换:若原请求为 GET,重定向后仍为 GET;若原请求为 POST,部分浏览器会转换为 GET(建议仅对 GET 请求使用 301)。

- 响应头包含

- 适用场景:

- 网站域名变更(如原域名 example.com 迁移至 new-example.com,访问 example.com/xxx 时返回 301,Location 为 new-example.com/xxx);

- 资源路径重构(如原路径 /api/v1/users 升级为 /api/v2/users,返回 301 永久重定向);

- 废弃旧接口,引导用户使用新接口(确保用户请求不失效)。

- 注意事项:避免滥用 301,因浏览器缓存后,修改或取消重定向需用户清除缓存(或等待缓存过期),灵活性低。

-

302 Found(临时重定向,重定向状态码)

- 核心含义:请求的资源临时移动到新的 URI,原 URI 仍有效,后续请求可继续使用原 URI(仅当前请求需跳转新 URI)。

- 关键特性:

- 响应头包含

Location字段,指定临时 URI; - 浏览器不缓存该重定向关系(每次访问原 URI 时,都会向服务器发送请求,获取重定向指令);

- 搜索引擎不会更新索引(原 URI 权重保留,新 URI 仅作为临时跳转目标);

- 请求方法转换:同 301,部分浏览器会将 POST 转换为 GET(RFC 标准不推荐,但实际场景中需注意)。

- 响应头包含

- 适用场景:

- 网站临时维护(访问原网站时,302 跳转至维护页面,维护结束后恢复原 URI);

- 临时资源迁移(如服务器扩容,部分资源临时部署在新节点,后续会迁回);

- 登录跳转(未登录用户访问需登录的页面时,302 跳转至登录页,登录成功后跳转回原页面);

- A/B 测试(临时将部分用户跳转至测试版本,不影响原版本的正常访问)。

- 与 301 的核心区别:301 是"永久迁移",302 是"临时迁移";301 会被缓存,302 不缓存;301 影响 SEO 索引,302 不影响。

-

401 Unauthorized(未授权,客户端错误状态码)

-

核心含义:客户端请求的资源需要身份认证(如登录),但客户端未提供认证信息,或提供的认证信息无效(如 token 过期、密码错误)。

-

关键特性:

- 响应头通常包含

WWW-Authenticate字段,指定认证方式(如 Basic 认证、Bearer Token 认证); - 客户端处理逻辑:浏览器会弹出登录窗口(Basic 认证),或 APP 引导用户跳转至登录页;

- 与 403 的核心区别:401 是"未认证"(需要登录),403 是"已认证但权限不足"(禁止访问)。

- 响应头通常包含

-

适用场景:

- 未登录用户访问需要登录的资源(如访问 /api/user/info,未携带登录 token,返回 401);

- 认证信息无效(如 token 过期、签名错误,返回 401,提示用户重新登录);

- 权限校验前的身份认证(先确认用户是否登录,再判断是否有权限)。

-

示例响应: http

HTTP/1.1 401 Unauthorized WWW-Authenticate: Bearer realm="user" Content-Type: application/json { "error": "unauthorized", "message": "token 已过期,请重新登录" }

-

-

403 Forbidden(禁止访问,客户端错误状态码)

- 核心含义:客户端已通过身份认证(如已登录),但服务器拒绝提供请求的资源(因客户端权限不足,或资源被限制访问)。

- 关键特性:

- 客户端已提供有效认证信息,但权限未达到访问资源的要求;

- 服务器明确拒绝访问,即使客户端重新提交请求(如补充认证信息),也会返回 403(区别于 401,401 可通过补充认证信息解决)。

- 适用场景:

- 普通用户访问管理员接口(如用户已登录,但尝试访问 /api/admin/delete,返回 403);

- 资源被限制访问(如某文件仅允许内部员工访问,外部用户即使登录也返回 403);

- IP 黑名单限制(客户端 IP

哪些排序算法是稳定的?为什么?

排序算法的"稳定性"指的是:排序后,值相等的元素保持原有相对顺序不变 。例如,数组 [(2, A), (1, B), (2, C)] 按第一个元素排序后,若稳定排序结果为 [(1, B), (2, A), (2, C)](A 在 C 前,与原顺序一致),不稳定排序可能得到 [(1, B), (2, C), (2, A)](A 和 C 顺序颠倒)。稳定性的核心价值是"保留相等元素的原始关联信息"(如排序带附属数据的记录),以下结合常见排序算法,解析稳定排序的种类、底层原因及不稳定排序的问题。

一、稳定的排序算法及核心原因

常见的稳定排序算法包括:冒泡排序、插入排序、归并排序、基数排序(桶排序的变种),它们的稳定性源于"比较和移动元素时,不破坏相等元素的相对位置"。

-

冒泡排序(稳定)

-

核心逻辑:重复遍历数组,相邻元素两两比较,若顺序错误则交换位置("轻的冒泡到前面"),直到数组有序。

-

稳定性原因:仅当

arr[i] > arr[i+1]时才交换元素,相等元素不交换 。例如,数组[2(A), 2(C), 1(B)]排序时,2(A) 和 2(C) 相等,不会交换位置,排序后仍为[1(B), 2(A), 2(C)],保留原始顺序。 -

代码验证(Golang 实现):

func bubbleSort(arr [][2]interface{}) { n := len(arr) for i := 0; i < n-1; i++ { swapped := false for j := 0; j < n-1-i; j++ { // 仅当 arr[j] 大于 arr[j+1] 时交换,相等不交换 if arr[j][0].(int) > arr[j+1][0].(int) { arr[j], arr[j+1] = arr[j+1], arr[j] swapped = true } } if !swapped { break } } } // 测试:输入 [(2, "A"), (1, "B"), (2, "C")],输出 [(1, "B"), (2, "A"), (2, "C")]

-

-

插入排序(稳定)

- 核心逻辑:将数组分为"有序区"和"无序区",依次从无序区取元素,插入到有序区的合适位置(比它大的元素后移)。

- 稳定性原因:插入时,相等元素插入到已存在的相等元素之后 ,不破坏相对顺序。例如,有序区为

[2(A)],插入2(C)时,因2(C) == 2(A),会插入到2(A)后面,而非前面,确保顺序不变。 - 关键细节:若插入逻辑改为"小于等于时插入前面",则会变成不稳定排序,因此"相等元素不提前"是插入排序稳定的核心。

-

归并排序(稳定)

- 核心逻辑:采用"分治思想",将数组递归拆分为子数组,子数组排序后合并为有序数组(合并时通过临时数组保留顺序)。

- 稳定性原因:合并两个有序子数组时,当元素相等时,优先取左子数组的元素 ,确保左子数组中相等元素的相对顺序在合并后保持不变。例如,左子数组

[2(A), 3]、右子数组[2(C), 4]合并时,先取左子数组的2(A),再取右子数组的2(C),结果为[2(A), 2(C), 3, 4]。 - 注意:归并排序的稳定性依赖"合并时的顺序选择",若优先取右子数组的相等元素,则会不稳定,因此标准归并排序严格遵循"左优先"。

-

基数排序(稳定)

- 核心逻辑:非比较排序,按"位"排序(如个位、十位、百位),每次按当前位的值将元素分配到对应桶中,再按桶的顺序合并元素。

- 稳定性原因:每次按位分配和合并时,保持元素的相对顺序 。例如,数组

[12(A), 21, 12(C)]按个位排序时,12(A) 和 12(C) 都进入"个位=2"的桶,合并时按原顺序排列;再按十位排序时,同样保留桶内顺序,最终结果为[12(A), 12(C), 21]。 - 关键:基数排序的稳定性依赖"桶排序的稳定性",若桶内元素无序存储,则会破坏稳定性,因此桶排序需配合稳定的内部排序(如插入排序)。

二、不稳定的排序算法及不稳定原因

常见的不稳定排序算法包括:选择排序、快速排序、堆排序、希尔排序,它们的不稳定性源于"通过交换或跳跃式移动元素,破坏了相等元素的相对位置"。

-

选择排序(不稳定)

- 核心逻辑:每次从无序区选择最小元素,与无序区第一个元素交换位置。

- 不稳定原因:交换操作可能导致相等元素的相对位置颠倒。例如,数组

[2(A), 3, 2(C), 1]:- 第一次选择最小元素

1,与2(A)交换,数组变为[1, 3, 2(C), 2(A)]; - 排序完成后,

2(C)在2(A)前,与原顺序(A 在 C 前)不一致,稳定性被破坏。

- 第一次选择最小元素

- 关键:选择排序的"交换"是跳跃式的(最小元素可能与无序区第一个元素相隔多个位置),而非相邻交换,因此无法保证相等元素顺序。

-

快速排序(不稳定)

- 核心逻辑:选择基准元素,将数组分为"小于基准"和"大于基准"的两部分,递归排序两部分。

- 不稳定原因:基准元素与其他元素交换时,可能破坏相等元素的顺序。例如,数组

[2(A), 1, 2(C)],选择2(A)作为基准:- 遍历后找到小于基准的元素

1,与基准交换,数组变为[1, 2(A), 2(C)](此时稳定); - 若数组为

[2(A), 3, 2(C), 1],选择2(A)作为基准,交换后可能导致2(C)与2(A)顺序颠倒(取决于分区逻辑)。

- 遍历后找到小于基准的元素

- 注意:快速排序的不稳定性是"概率性"的,部分优化实现可能在特定场景下表现稳定,但标准快速排序因交换逻辑本质上不稳定。

-

堆排序(不稳定)

- 核心逻辑:将数组构建为大顶堆(或小顶堆),每次提取堆顶元素(最大/最小),与堆尾元素交换,再调整堆结构。

- 不稳定原因:堆顶元素与堆尾元素的交换是跳跃式的,可能破坏相等元素顺序。例如,堆

[3, 2(A), 2(C)](大顶堆):- 提取堆顶

3,与堆尾2(C)交换,数组变为[2(C), 2(A), 3]; - 此时

2(C)在2(A)前,原顺序被破坏,排序结果不稳定。

- 提取堆顶

三、稳定性的实际意义(为什么需要稳定排序?)

稳定性并非所有场景都需要,但在以下场景中至关重要:

- 多字段排序场景:先按字段 A 排序,再按字段 B 排序,需保留字段 A 的排序结果。例如,先按"班级"排序(稳定排序),再按"成绩"排序,确保同一班级内的学生成绩排序后,仍保留原班级内的相对顺序。

- 带附属数据的排序:元素包含多个属性,排序仅基于部分属性,需保留其他属性的关联关系。例如,排序"订单记录"(包含订单号、金额、下单时间),按金额排序时,需保留同一金额订单的下单时间顺序(避免后续按时间筛选时出错)。

- 分布式排序/外部排序:多阶段排序(如先分片排序,再合并排序),需各阶段排序算法稳定,否则合并后会破坏整体顺序。

四、面试加分点

- 能明确"稳定性的定义"(相等元素相对顺序不变),而非模糊描述"排序结果正确";

- 能结合算法底层逻辑(交换方式、插入位置、合并顺序)解释稳定性原因,而非仅罗列算法名称;

- 能举例说明不稳定排序的"反例"(如选择排序的交换导致顺序颠倒),体现对算法细节的理解;

- 能说明稳定性的实际应用场景,体现工程实践思维;

- 能提及"稳定排序的时间/空间复杂度"(如归并排序稳定但空间复杂度 O(n),冒泡排序稳定但时间复杂度 O(n²)),体现对算法权衡的认知。

记忆法

- 稳定排序口诀记忆法:总结口诀"冒插归基稳如山"(冒泡、插入、归并、基数),每个字对应一种稳定排序,结合"稳定"的核心逻辑(不交换相等元素、左优先合并、按位保序)强化记忆;

- 原因归类记忆法:将稳定排序的原因归类为"不交换相等元素"(冒泡、插入)、"合并时左优先"(归并)、"按位保序"(基数),不稳定排序的原因归类为"跳跃式交换"(选择、堆排序)、"基准交换"(快速排序),通过归类逻辑快速区分。

什么是 TopK 问题?海量数据场景下如何高效解决 TopK 问题?

TopK 问题是算法领域的经典问题,核心定义是:从海量数据(可能是数组、文件、流数据等)中,快速找出前 K 个最大(或最小)的元素(如找出 1000 万条数据中前 100 个最大的数、找出热门商品排行榜前 10 名)。TopK 问题的关键挑战是"数据量大(无法全部加载到内存)"和"效率要求高(避免全量排序)",因此核心思路是"不做全量排序,通过局部筛选保留候选集",以下先明确问题定义,再详解不同场景下的高效解决方案,结合工程实践说明。

一、TopK 问题的核心分类

根据数据存储形态和场景,TopK 问题可分为两类:

- 静态 TopK:数据固定(如本地文件、数据库表),一次性找出前 K 个元素;

- 动态 TopK:数据持续流入(如实时日志流、用户行为流),需实时维护前 K 个元素(新数据到来时快速更新结果)。

两类问题的核心目标一致:在时间复杂度和空间复杂度最优的前提下,准确找出 TopK 元素,避免全量排序(全量排序时间复杂度 O(n log n),海量数据下不可行)。

二、静态 TopK 问题的高效解决方案(数据可离线处理)

静态场景下,数据总量固定,核心优化方向是"减少内存占用"和"降低时间复杂度",主流方案有以下 3 种:

-

小顶堆(最小堆)法(推荐,内存受限场景)

-

核心思路:用大小为 K 的小顶堆存储候选 TopK 元素,遍历所有数据,仅保留比堆顶大的元素,最终堆内元素即为 TopK 最大元素(找最小元素则用大顶堆)。

-

具体步骤:

- 初始化:从原始数据中取前 K 个元素,构建小顶堆(堆顶为当前候选集中的最小值);

- 遍历数据:对剩余每个元素,若元素大于堆顶,则替换堆顶元素,并调整堆结构(下沉操作,维持小顶堆特性);若元素小于等于堆顶,则直接跳过;

- 结果:遍历完成后,堆内的 K 个元素即为前 K 个最大元素。

-

时间复杂度:构建堆 O(K) + 遍历剩余数据 O((n-K) log K),整体 O(n log K)(n 为数据总量,K 远小于 n 时,log K 可视为常数,效率接近 O(n));

-

空间复杂度:O(K)(仅需存储 K 个候选元素,适合海量数据无法加载到内存的场景);

-

Golang 代码实现(找前 K 个最大元素):

import ( "container/heap" "fmt" ) // 定义小顶堆结构(实现 heap.Interface 接口) type IntMinHeap []int func (h IntMinHeap) Len() int { return len(h) } func (h IntMinHeap) Less(i, j int) bool { return h[i] < h[j] } // 小顶堆:h[i] < h[j] func (h IntMinHeap) Swap(i, j int) { h[i], h[j] = h[j], h[i] } func (h *IntMinHeap) Push(x interface{}) { *h = append(*h, x.(int)) } func (h *IntMinHeap) Pop() interface{} { old := *h n := len(old) x := old[n-1] *h = old[:n-1] return x } // TopK 最大元素:小顶堆法 func TopKMax(nums []int, k int) []int { if k <= 0 || len(nums) < k { return nums } // 1. 构建前 K 个元素的小顶堆 h := IntMinHeap(nums[:k]) heap.Init(&h) // 2. 遍历剩余元素,大于堆顶则替换并调整堆 for _, num := range nums[k:] { if num > h[0] { // 堆顶是当前候选集最小值,大于堆顶则入选 heap.Pop(&h) heap.Push(&h, num) } } // 3. 堆内元素即为 TopK 最大元素(无序,需排序可额外处理) result := make([]int, k) for i := 0; i < k; i++ { result[i] = heap.Pop(&h).(int) } return result } // 测试:nums = [3,1,4,1,5,9,2,6], k=3 → 输出 [5,6,9](堆弹出顺序为从小到大,需反转得从大到小) -

适用场景:数据量较大(如 1000 万条),但 K 较小(如 100、1000),内存可容纳 K 个元素;

-

优点:时间复杂度低(O(n log K)),空间复杂度低(O(K)),实现简单;

-

缺点:K 接近 n 时(如 K=1000 万,n=1000 万+1),效率接近全量排序(O(n log n)),不推荐。

-

-

快速选择算法(QuickSelect,内存充足场景)

- 核心思路:基于快速排序的"分区"思想,不做全量排序,仅递归分区直到找到第 K 大元素的位置,该位置左侧即为 TopK 元素。

- 具体步骤:

- 选择基准元素,将数组分为"小于基准""等于基准""大于基准"三部分;

- 若"大于基准"的元素个数 > K:TopK 元素在"大于基准"的分区中,递归处理该分区;

- 若"大于基准"的元素个数 + "等于基准"的元素个数 >= K:TopK 元素即为"大于基准"的所有元素 + 部分"等于基准"的元素;

- 否则:剩余所需元素从"小于基准"的分区中寻找,递归处理该分区。

- 时间复杂度:平均 O(n),最坏 O(n²)(可通过随机选择基准元素优化为近似 O(n));

- 空间复杂度:O(log n)(递归栈空间,可优化为迭代实现 O(1) 空间);

- 适用场景:数据可全部加载到内存(如 n=1000 万,内存足够),K 可大可小;

- 优点:平均效率极高(O(n)),适合内存充足的静态场景;

- 缺点:数据无法加载到内存时不可用,最坏情况效率低(需随机基准优化)。

-

外部排序法(海量数据无法加载到内存场景)

- 核心思路:当数据量极大(如 100G 日志文件),无法全部加载到内存时,采用"分治+归并"的外部排序思想,分阶段筛选 TopK 元素。

- 具体步骤:

- 分片处理:将大文件按内存大小分割为多个小文件(如每个小文件 1G),对每个小文件进行排序(如快速排序),并提取每个小文件的 TopK 元素(形成多个小的 TopK 候选集文件);

- 归并筛选:将所有候选集文件加载到内存,构建小顶堆(堆大小为候选集文件个数),每个候选集文件维护一个指针指向当前待处理元素;

- 迭代归并:每次从堆顶取出最小元素(当前所有候选集的最小值),若该元素来自某个候选集文件,将该文件的下一个元素加入堆,直到收集到 K 个最大元素;

- 时间复杂度:O(m * s log s + K log m)(m 为小文件个数,s 为每个小文件的大小);

- 适用场景:TB 级海量数据,无法加载到内存;

- 优点:可处理超大规模数据,不依赖内存大小;

- 缺点:实现复杂,需处理文件 I/O、分片、归并等细节,效率受 I/O 影响较大(可通过 SSD 或缓存优化)。

二、动态 TopK 问题的高效解决方案(数据持续流入场景)

动态场景下,数据实时生成(如用户点击流、系统日志),需实时维护 TopK 结果(新数据到来时快速更新),主流方案如下:

-

基于小顶堆的实时维护(推荐,K 较小场景)

- 核心思路:与静态场景的小顶堆法一致,维护一个大小为 K 的小顶堆,新数据到来时:

- 若数据大于堆顶元素:弹出堆顶,将新数据加入堆并调整;

- 若数据小于等于堆顶元素:直接跳过;

- 堆内元素始终为当前的 TopK 最大元素。

- 时间复杂度:单次更新 O(log K)(适合高并发场景,如每秒 10 万条数据);

- 适用场景:K 较小(如 Top10、Top100),数据流入速率高;

- 优点:实时性强,更新效率高,内存占用低;

- 缺点:K 较大时(如 K=10000),log K 增大,更新效率下降。

- 核心思路:与静态场景的小顶堆法一致,维护一个大小为 K 的小顶堆,新数据到来时:

-

基于红黑树/平衡二叉搜索树的维护(K 较大场景)

- 核心思路:用红黑树(或 Golang 中的

map+排序,但效率较低)维护 TopK 元素,红黑树按元素大小排序,支持 O(log K) 时间的插入、删除、查询操作。 - 具体逻辑:

- 新数据到来时,若红黑树大小 < K:直接插入;

- 若红黑树大小 == K:比较新数据与树中最小元素(红黑树左子树最左节点),若新数据更大,则删除最小元素,插入新数据;

- 时间复杂度:单次更新 O(log K)(与小顶堆相当,但查询 TopK 元素时无需额外排序,红黑树可直接遍历输出有序结果);

- 适用场景:K 较大(如 Top1000),且需要频繁查询 TopK 有序结果;

- 优点:支持有序查询,更新效率稳定;

- 缺点:实现复杂(需自定义红黑树),内存占用略高于小顶堆。

- 核心思路:用红黑树(或 Golang 中的

-

基于计数排序/桶排序的优化(元素值范围有限场景)

- 核心思路:若数据值范围较小(如用户分数 0-100、商品销量 0-10000),用数组(桶)记录每个值的出现次数,实时维护计数,查询 TopK 时从大到小累加计数,直到收集到 K 个元素。

- 具体逻辑:

- 初始化桶数组

bucket,bucket[v]表示值为 v 的元素个数; - 新数据到来时,

bucket[v]++; - 查询 TopK 时,从最大值到最小值遍历桶,累加

bucket[v],直到总和 >= K,收集对应的值;

- 初始化桶数组

- 时间复杂度:单次更新 O(1),查询 TopK O(M)(M 为值范围大小);

- 适用场景:元素值范围有限(如 M=1000),查询频率不高;

- 优点:更新效率极高,实现简单;

- 缺点:值范围过大时(如 M=1e6),桶数组占用内存过大,不适用。

三、面试加分点

- 能明确 TopK 问题的核心挑战(海量数据、高效筛选),而非仅描述"找前 K 个元素";

- 能区分静态/动态场景,给出针对性解决方案,体现场景化思维;

- 能提供完整的 Golang 代码实现(如小顶堆法),展示工程落地能力;

- 能分析各方案的时间/空间复杂度,说明选型逻辑(如 K 小时用小顶堆,海量数据用外部排序);

- 能提及优化细节(如快速选择的随机基准、外部排序的 I/O 优化、动态场景的并发安全),体现深度思考;

- 能结合实际业务场景举例(如热门商品 Top10 用小顶堆实时维护,100G 日志 Top100 用外部排序),体现业务结合能力。

记忆法

- 解决方案分类记忆法:按"场景+核心结构"分类------静态海量用"小顶堆/外部排序",静态内存充足用"快速选择",动态 K 小用"小顶堆",动态 K 大用"红黑树",值范围有限用"桶排序",通过场景绑定结构强化记忆;

- 核心思路口诀记忆法:总结口诀"TopK 不做全排序,局部筛选保候选",所有方案的核心都是"避免全量排序,通过堆、分区、分治等方式保留候选集",快速回忆核心优化方向。

如何解决最长连续子数组的最大和问题?(提示:可使用动态规划)

最长连续子数组的最大和(LeetCode 53 题)是动态规划的经典应用,核心问题定义是:给定一个整数数组(可能包含负数),找出一个连续子数组(至少包含一个元素),使其和最大,返回该最大和 (如数组 [-2,1,-3,4,-1,2,1,-5,4] 的最大连续子数组是 [4,-1,2,1],最大和为 6)。该问题的关键挑战是"子数组连续"和"存在负数(可能导致累加和下降)",动态规划是最优解法(时间复杂度 O(n),空间复杂度 O(1)),以下详细解析动态规划思路、优化方案、代码实现及其他补充解法。

一、动态规划(DP)核心思路

动态规划的核心是"状态定义"和"状态转移方程",通过分解问题、保存中间结果,避免重复计算。

- 状态定义定义

dp[i]表示:以数组第 i 个元素结尾的最长连续子数组的最大和。

- 关键:子数组必须以

nums[i]结尾,确保子数组的连续性(若不限制结尾,无法保证连续); - 例如,数组

[-2,1,-3,4]:dp[0] = -2(以-2结尾的子数组只有[-2]);dp[1] = max(1, dp[0]+1) = max(1, -2+1)=1(以1结尾的子数组为[1]或[-2,1],最大和为 1);dp[2] = max(-3, dp[1]+(-3)) = max(-3, 1-3)=-2(以-3结尾的子数组为[-3]或[1,-3]或[-2,1,-3],最大和为 -2);dp[3] = max(4, dp[2]+4) = max(4, -2+4)=4(以4结尾的子数组为[4]或[-3,4]等,最大和为 4)。

- 状态转移方程基于状态定义,

dp[i]只有两种选择:

- 选择 1:将

nums[i]加入到以nums[i-1]结尾的子数组中(即dp[i-1] + nums[i]); - 选择 2:不加入前序子数组,单独以

nums[i]作为新的子数组(即nums[i]);因此,状态转移方程为:dp[i] = max(nums[i], dp[i-1] + nums[i])

- 最终结果整个数组的最大连续子数组和,是

dp数组中的最大值(因dp[i]覆盖了所有以nums[i]结尾的子数组,最大值即为全局最优解)。

二、空间优化(从 O(n) 到 O(1))

原始动态规划思路需要额外维护一个 dp 数组(空间复杂度 O(n)),但观察状态转移方程可知:dp[i] 仅依赖于 dp[i-1](前一个状态),因此无需存储整个 dp 数组,仅需用一个变量保存前一个状态的值(pre),空间复杂度可优化至 O(1)。

优化后的核心逻辑:

- 初始化

pre = nums[0](第一个元素的dp[0]),maxSum = nums[0](全局最大和); - 遍历数组从索引 1 开始:

pre = max(nums[i], pre + nums[i])(更新当前状态为前一个状态与当前元素的最大值);maxSum = max(maxSum, pre)(更新全局最大和);

- 遍历结束后,

maxSum即为答案。

三、Golang 代码实现(优化后 O(n) 时间 + O(1) 空间)

func maxSubArray(nums []int) int {

if len(nums) == 0 {

return 0

}

pre := nums[0] // 保存前一个状态 dp[i-1]

maxSum := nums[0] // 全局最大和

for i := 1; i < len(nums); i++ {

// 状态转移:当前元素单独成组,或加入前一个子数组

pre = max(nums[i], pre + nums[i])

// 更新全局最大和

if pre > maxSum {

maxSum = pre

}

}

return maxSum

}

// 辅助函数:返回两个整数的最大值

func max(a, b int) int {

if a > b {

return a

}

return b

}

// 测试用例

func main() {

nums1 := []int{-2,1,-3,4,-1,2,1,-5,4}

fmt.Println(maxSubArray(nums1)) // 输出 6(子数组 [4,-1,2,1])

nums2 := []int{1}

fmt.Println(maxSubArray(nums2)) // 输出 1(仅一个元素)

nums3 := []int{-1,-2,-3}

fmt.Println(maxSubArray(nums3)) // 输出 -1(所有元素为负,取最大的单个元素)

nums4 := []int{5,4,-1,7,8}

fmt.Println(maxSubArray(nums4)) // 输出 23(子数组 [5,4,-1,7,8])

}四、其他补充解法(拓展思路)

除了动态规划,该问题还有其他解法,可作为面试中的拓展回答,体现思维广度:

-

分治算法(时间复杂度 O(n log n),空间复杂度 O(log n))

- 核心思路:将数组递归拆分为左、右两个子数组,最大子数组和可能来自三个场景:

- 完全在左子数组中;

- 完全在右子数组中;

- 跨越左、右子数组的中间区域(需计算左子数组从中间向左的最大和,右子数组从中间向右的最大和,两者相加);

- 递归终止条件:数组长度为 1 时,返回该元素;

- 优点:适合并行计算(左、右子数组可独立计算);

- 缺点:时间复杂度高于动态规划,实现更复杂,实际场景中较少使用。

- 核心思路:将数组递归拆分为左、右两个子数组,最大子数组和可能来自三个场景:

-

暴力枚举(时间复杂度 O(n²),空间复杂度 O(1))

- 核心思路:枚举所有可能的连续子数组,计算其和,记录最大值;

- 具体逻辑:外层循环遍历子数组起始索引

i,内层循环遍历子数组结束索引j(j >= i),累加nums[i..j]的和,更新最大值; - 优点:实现简单,易于理解;

- 缺点:时间复杂度高(n 较大时如 n=1e4 会超时),仅适用于小规模数组,面试中不推荐作为最优解。

五、边界情况与易错点

- 数组长度为 1:直接返回该元素(即使是负数);

- 数组所有元素为负数:最大和为最大的单个元素(而非空数组,因题目要求子数组至少包含一个元素);

- 子数组包含多个正数和负数:需灵活选择"是否加入前序子数组"(如前序和为负数时,单独以当前正数作为新子数组);

- 溢出问题:若数组元素较大(如 int32 范围外),需使用 64 位整数(如 Golang 中的

int64)存储pre和maxSum,避免溢出。

六、面试加分点

- 能先给出动态规划的原始思路,再优化空间复杂度(从 O(n) 到 O(1)),体现优化思维;

- 能提供完整的 Golang 代码实现,覆盖所有边界情况(如长度为 1、全负数数组),体现代码严谨性;

- 能解释状态定义的核心逻辑("以 nums[i] 结尾"确保连续性),而非仅背诵状态转移方程;

- 能拓展分治算法、暴力算法的思路,并对比各算法的时间/空间复杂度,体现思维广度;

- 能结合实际业务场景举例(如计算股票价格波动的最大收益、用户行为数据的最大连续活跃天数),体现业务落地能力;

- 能指出溢出问题并给出解决方案,体现细节关注能力。

记忆法

- 动态规划核心口诀记忆法:总结口诀"DP 定义结尾和,转移选择加或舍,全局最大遍历得"------"结尾和"指

dp[i]以 nums[i] 结尾,"加或舍"指状态转移时选择"加前序和"或"舍前序单独成组","全局最大"指遍历 dp 数组取最大值,快速回忆核心逻辑; - 优化思路记忆法:绑定"状态依赖"与"空间优化"------因

dp[i]仅依赖dp[i-1],可用单个变量替代数组,形成"变量替代数组"的优化逻辑,强化记忆。

如何实现大文件排序?

大文件排序(又称"外部排序")是指当文件大小远超内存容量(如 100G 文件,内存仅 8G)时,无法将整个文件加载到内存中进行排序的解决方案。其核心思路是"分治思想":将大文件拆分为多个可加载到内存的小文件(分片),对每个小文件进行内部排序(内存排序),再将所有有序小文件合并为一个有序大文件。以下详细解析外部排序的完整流程、关键步骤、优化方案及 Golang 实现思路,体现工程实践中的细节处理。

一、大文件排序的核心流程(分治+归并)

外部排序的完整流程可分为三个核心阶段:分片(Split)→ 内部排序(Sort)→ 归并(Merge),每个阶段需解决"如何高效拆分""如何优化内存排序""如何减少归并 I/O"等问题。

阶段 1:分片(Split)------ 将大文件拆分为小文件

核心目标:将无法加载到内存的大文件,按内存容量拆分为多个"可加载到内存"的小文件(又称"运行段",Run),确保每个小文件可在内存中完成排序。

-

关键步骤:

- 确定分片大小:分片大小需略小于可用内存(预留部分内存用于排序算法的临时空间)。例如,内存 8G,预留 2G 用于系统和排序临时空间,分片大小设为 6G;

- 逐块读取大文件:用文件流(如 Golang 的

os.File)按分片大小读取数据块,避免一次性加载整个文件; - 写入小文件:将读取到的内存数据块写入独立的小文件(如

split_001.txt、split_002.txt),直到大文件全部拆分完成; - 注意事项:

- 数据格式:若文件是文本格式(如每行一个数据),需按行拆分(避免拆分到中间行);若为二进制格式,需按固定字节数拆分(确保数据完整性);

- 编码处理:文本文件需处理编码(如 UTF-8、GBK),避免拆分导致字符乱码;

- 临时文件管理:拆分后的小文件为临时文件,排序完成后需清理,避免磁盘空间占用。

-

分片阶段的优化:

- 预分配磁盘空间:创建小文件时预分配磁盘空间(如

os.Truncate),避免频繁扩容导致的 I/O 开销; - 批量读写:采用缓冲区(如 Golang 的

bufio.Reader/bufio.Writer)批量读取和写入数据,减少系统调用次数(磁盘 I/O 是外部排序的瓶颈,批量操作可提升效率);

- 预分配磁盘空间:创建小文件时预分配磁盘空间(如

你项目中涉及微信支付模块时,若收到微信支付的重复通知,如何防止接口重复消费(即保证接口幂等性)?你提到的 Redis 或数据库事务方案具体如何实现?

微信支付的重复通知是支付场景中常见问题,核心原因包括网络延迟(微信服务器未收到我方响应)、微信重试机制(默认重试 8 次,间隔从 15s 到 24h 递增)、我方接口响应超时等。若未处理重复通知,可能导致"一笔支付订单重复入账、重复发货"等业务问题,因此必须通过幂等性设计保证接口多次调用结果一致。幂等性的核心是"通过唯一标识识别重复请求,拒绝重复处理",以下结合项目实践,详解 Redis 和数据库事务两种核心方案的实现逻辑、代码示例及优缺点。

一、幂等性设计的核心前提:获取唯一请求标识

微信支付通知的核心是支付结果通知(notify 接口),微信服务器会在支付成功后向我方回调地址推送 XML/JSON 格式的通知,其中包含唯一标识字段,这是实现幂等性的基础:

- 核心唯一标识:

out_trade_no(我方订单号,由我方生成,全局唯一)或transaction_id(微信支付订单号,微信生成,全局唯一); - 选择原则:优先使用

out_trade_no(我方自主控制,无需依赖微信查询),若订单号生成规则确保唯一,可直接作为幂等标识;若存在特殊场景(如订单号重复),可组合transaction_id作为联合标识。 - 关键验证:接收通知后,首先验证微信签名(通过微信 SDK 验证

sign字段),确保通知来自微信官方,再进行幂等性判断(避免恶意重复请求)。

二、方案一:Redis 分布式锁 + 标识记录(高性能方案)

Redis 方案的核心逻辑是"用 Redis 记录已处理的订单标识,同时通过分布式锁防止并发重复处理",适合高并发场景(如秒杀支付、高频交易),优点是响应速度快、支持分布式部署,缺点是依赖 Redis 可用性。

1. 实现步骤(完整流程)

- 接收微信支付通知,验证签名合法性(微信 SDK 自带验证逻辑);

- 从通知中提取

out_trade_no(我方订单号)作为幂等标识; - 尝试获取 Redis 分布式锁(锁 key 为

pay:idempotent:out_trade_no:{订单号}),防止并发重复请求; - 若获取锁失败:说明当前订单正在处理中,直接返回微信"成功响应"(避免微信重试);

- 若获取锁成功:查询 Redis 中是否存在该订单的"已处理标识"(key 为

pay:processed:out_trade_no:{订单号}); - 若已存在已处理标识:说明是重复通知,释放锁,返回成功响应;

- 若不存在已处理标识:执行核心业务逻辑(查询订单状态、更新订单为"支付成功"、入账、发货等);

- 业务逻辑执行成功后,在 Redis 中设置已处理标识(过期时间建议 24h+,覆盖微信最大重试周期);

- 释放分布式锁,返回微信成功响应(必须返回

{"code":"SUCCESS","message":"success"},否则微信会继续重试)。

2. 关键细节:Redis 分布式锁的设计(避免死锁)

- 锁的过期时间:设置为 30s-60s(根据业务逻辑执行时间调整,确保业务能完成),避免因服务宕机导致锁无法释放;

- 锁的value:使用 UUID 或随机字符串,释放锁时通过 Lua 脚本验证 value 一致(避免误释放其他线程的锁);

- 重试机制:获取锁失败时,可短暂重试(如 3 次,间隔 50ms),避免因瞬时并发导致的误判。

3. Golang 代码实现(结合 Redis 客户端 go-redis/redis)

import (

"context"

"fmt"

"github.com/go-redis/redis/v8"

"github.com/wechatpay-apiv3/wechatpay-go/core"

"github.com/wechatpay-apiv3/wechatpay-go/services/payments/jsapi"

"time"

)

// Redis 客户端初始化(实际项目中需配置连接池、哨兵/集群模式)

var redisClient = redis.NewClient(&redis.Options{

Addr: "redis-host:6379",

Password: "redis-password",

DB: 0,

})

var ctx = context.Background()

// 微信支付通知处理接口(HTTP Handler)

func WxPayNotifyHandler(c *gin.Context) {

// 1. 接收并解析微信通知(此处简化,实际需用微信 SDK 解析 XML/JSON)

var notifyReq jsapi.TransactionNotifyResponse

if err := c.ShouldBindXML(¬ifyReq); err != nil {

c.XML(200, gin.H{"code": "FAIL", "message": "参数解析失败"})

return

}

// 2. 验证微信签名(必须步骤,防止伪造通知)

// 微信 SDK 验证逻辑:需传入 API 密钥、证书等配置,此处省略具体实现

if err := verifyWxSign(¬ifyReq); err != nil {

c.XML(200, gin.H{"code": "FAIL", "message": "签名验证失败"})

return

}

outTradeNo := notifyReq.OutTradeNo // 我方订单号(幂等标识)

lockKey := fmt.Sprintf("pay:idempotent:lock:%s", outTradeNo)

processedKey := fmt.Sprintf("pay:processed:%s", outTradeNo)

lockValue := uuid.NewString() // 随机 value,用于释放锁验证

lockExpire := 30 * time.Second // 锁过期时间

// 3. 获取 Redis 分布式锁(Lua 脚本确保原子性)

lockScript := `if redis.call('setnx', KEYS[1], ARGV[1]) == 1 then

return redis.call('expire', KEYS[1], ARGV[2])

else

return 0

end`

lockResult, err := redisClient.Eval(ctx, lockScript, []string{lockKey}, lockValue, lockExpire.Seconds()).Int()

if err != nil || lockResult == 0 {

// 获取锁失败:返回成功响应,避免微信重试

c.XML(200, gin.H{"code": "SUCCESS", "message": "success"})

return

}

defer func() {

// 4. 释放锁(Lua 脚本确保原子性,仅释放自己的锁)

unlockScript := `if redis.call('get', KEYS[1]) == ARGV[1] then

return redis.call('del', KEYS[1])

else

return 0

end`

redisClient.Eval(ctx, unlockScript, []string{lockKey}, lockValue)

}()

// 5. 检查订单是否已处理

processed, err := redisClient.Exists(ctx, processedKey).Result()

if err != nil {

c.XML(200, gin.H{"code": "FAIL", "message": "Redis 查询失败"})

return

}

if processed == 1 {

// 已处理:返回成功响应

c.XML(200, gin.H{"code": "SUCCESS", "message": "success"})

return

}

// 6. 执行核心业务逻辑(事务性操作,需确保原子性)

if err := processPaySuccess(outTradeNo, notifyReq.TransactionId, notifyReq.TotalFee); err != nil {

// 业务处理失败:返回失败响应,微信会重试(需做好日志记录,便于排查)

log.Printf("订单 %s 处理失败:%v", outTradeNo, err)

c.XML(200, gin.H{"code": "FAIL", "message": "业务处理失败"})

return

}

// 7. 标记订单已处理(过期时间 24h,覆盖微信最大重试周期)

if err := redisClient.SetEx(ctx, processedKey, "1", 24*time.Hour).Err(); err != nil {

log.Printf("订单 %s 标记已处理失败:%v", outTradeNo, err)

// 此处可考虑降级:将标识写入数据库,避免重复处理

saveProcessedFlagToDB(outTradeNo)

}

// 8. 返回成功响应

c.XML(200, gin.H{"code": "SUCCESS", "message": "success"})

}

// 核心业务逻辑:更新订单状态、入账、发货等(需保证事务性)

func processPaySuccess(outTradeNo, transactionId string, totalFee int64) error {

// 实际项目中需使用数据库事务,确保所有操作原子执行

tx := db.Begin() // gorm 事务示例

defer func() {

if r := recover(); r != nil {

tx.Rollback()

}

}()

// 步骤1:查询订单状态(防止重复处理,双重校验)

var order Order

if err := tx.Where("out_trade_no = ?", outTradeNo).First(&order).Error; err != nil {

tx.Rollback()

return fmt.Errorf("查询订单失败:%v", err)

}

if order.Status == "PAID" {

tx.Rollback()

return nil // 订单已支付,直接返回

}

// 步骤2:更新订单状态为"支付成功"

if err := tx.Model(&order).Updates(map[string]interface{}{

"status": "PAID",

"transaction_id": transactionId,

"pay_time": time.Now(),

"total_fee": totalFee,

}).Error; err != nil {

tx.Rollback()

return fmt.Errorf("更新订单失败:%v", err)

}

// 步骤3:入账(如用户余额增加、商户账户增加)

if err := tx.Create(&AccountRecord{

OutTradeNo: outTradeNo,

Amount: totalFee,

Type: "PAY_IN",

CreateTime: time.Now(),

}).Error; err != nil {

tx.Rollback()

return fmt.Errorf("入账失败:%v", err)

}

// 步骤4:发货(如生成物流单、发送商品兑换码,可异步处理)

if err := createDeliveryOrder(tx, outTradeNo, order.UserID); err != nil {

tx.Rollback()

return fmt.Errorf("发货失败:%v", err)

}

return tx.Commit().Error

}4. 方案优缺点

- 优点:Redis 读写性能高(单机 QPS 万级以上),支持分布式部署(适配微服务架构),锁机制能有效防止并发重复处理;

- 缺点:依赖 Redis 可用性(需部署哨兵/集群模式保证高可用),若 Redis 宕机,可能导致短暂的幂等性失效(可降级到数据库方案);

- 降级策略:Redis 不可用时,将幂等标识写入数据库临时表,确保核心业务不中断。

三、方案二:数据库事务 + 唯一索引(强一致性方案)

数据库方案的核心逻辑是"通过数据库唯一索引保证幂等标识不重复,结合事务确保业务操作原子性",适合对一致性要求极高的场景(如金融支付),优点是不依赖第三方组件、一致性强,缺点是数据库压力较大,高并发场景需优化。

1. 实现步骤(完整流程)

- 创建幂等性表(专门记录已处理的支付通知标识),添加唯一索引(防止重复插入);

- 接收微信通知,验证签名后提取

out_trade_no作为幂等标识; - 开启数据库事务,尝试将

out_trade_no插入幂等性表; - 若插入成功:说明是首次通知,执行核心业务逻辑(更新订单、入账、发货);

- 若插入失败(唯一索引冲突):说明是重复通知,回滚事务,返回微信成功响应;

- 业务逻辑执行成功后,提交事务,返回微信成功响应;

- 业务逻辑执行失败:回滚事务,返回微信失败响应(微信会重试)。

2. 关键设计:幂等性表结构(MySQL 示例)

CREATE TABLE `pay_idempotent` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT '主键ID',

`out_trade_no` varchar(64) NOT NULL COMMENT '我方订单号(幂等标识)',

`transaction_id` varchar(64) DEFAULT NULL COMMENT '微信支付订单号',

`create_time` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间',

`update_time` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间',

PRIMARY KEY (`id`),

UNIQUE KEY `uk_out_trade_no` (`out_trade_no`) COMMENT '唯一索引:防止重复插入'

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COMMENT='支付幂等性记录表';- 唯一索引

uk_out_trade_no是核心:确保同一out_trade_no只能插入一次,插入冲突即判定为重复通知; - 字段扩展:可添加

status字段(如PROCESSING/SUCCESS),处理业务逻辑执行中服务宕机的情况(重启后通过status字段恢复处理)。

3. Golang 代码实现(结合 GORM 框架)

import (

"github.com/gin-gonic/gin"

"github.com/wechatpay-apiv3/wechatpay-go/services/payments/jsapi"

"gorm.io/gorm"

"time"

)

// 幂等性表模型

type PayIdempotent struct {

ID int64 `gorm:"primarykey" json:"id"`

OutTradeNo string `gorm:"size:64;not null;uniqueIndex:uk_out_trade_no" json:"out_trade_no"`

TransactionId string `gorm:"size:64" json:"transaction_id"`

CreateTime time.Time `gorm:"autoCreateTime" json:"create_time"`

UpdateTime time.Time `gorm:"autoUpdateTime" json:"update_time"`

}

// 微信支付通知处理接口

func WxPayNotifyHandler(c *gin.Context) {

// 1. 解析通知并验证签名(同方案一)

var notifyReq jsapi.TransactionNotifyResponse

if err := c.ShouldBindXML(¬ifyReq); err != nil {

c.XML(200, gin.H{"code": "FAIL", "message": "参数解析失败"})

return

}

if err := verifyWxSign(¬ifyReq); err != nil {

c.XML(200, gin.H{"code": "FAIL", "message": "签名验证失败"})

return

}

outTradeNo := notifyReq.OutTradeNo

transactionId := notifyReq.TransactionId

// 2. 开启数据库事务

tx := db.Begin()

defer func() {

if r := recover(); r != nil {

tx.Rollback()

}

}()

// 3. 尝试插入幂等性表(唯一索引冲突即重复通知)

idempotent := PayIdempotent{

OutTradeNo: outTradeNo,

TransactionId: transactionId,

}

if err := tx.Create(&idempotent).Error; err != nil {

// 唯一索引冲突:重复通知,回滚事务并返回成功

tx.Rollback()

c.XML(200, gin.H{"code": "SUCCESS", "message": "success"})

return

}

// 4. 执行核心业务逻辑(同方案一,更新订单、入账、发货)

if err := processPaySuccess(tx, outTradeNo, transactionId, notifyReq.TotalFee); err != nil {

tx.Rollback()

log.Printf("订单 %s 处理失败:%v", outTradeNo, err)

c.XML(200, gin.H{"code": "FAIL", "message": "业务处理失败"})

return

}

// 5. 提交事务

if err := tx.Commit().Error; err != nil {

tx.Rollback()

log.Printf("事务提交失败:%v", err)

c.XML(200, gin.H{"code": "FAIL", "message": "事务提交失败"})

return

}

// 6. 返回成功响应

c.XML(200, gin.H{"code": "SUCCESS", "message": "success"})

}

// 核心业务逻辑(接收事务对象,确保原子性)

func processPaySuccess(tx *gorm.DB, outTradeNo, transactionId string, totalFee int64) error {

// 步骤1:查询订单(双重校验,防止订单不存在或已支付)

var order Order

if err := tx.Where("out_trade_no = ?", outTradeNo).First(&order).Error; err != nil {

return fmt.Errorf("查询订单失败:%v", err)

}

if order.Status == "PAID" {

return nil

}

// 步骤2:更新订单状态

if err := tx.Model(&order).Updates(map[string]interface{}{

"status": "PAID",

"transaction_id": transactionId,

"pay_time": time.Now(),

"total_fee": totalFee,

}).Error; err != nil {

return fmt.Errorf("更新订单失败:%v", err)

}

// 步骤3:入账、发货等操作(同方案一)

// ...

return nil

}4. 方案优缺点

- 优点:不依赖第三方组件(Redis),数据库事务+唯一索引保证强一致性,适合金融级场景;

- 缺点:数据库写入压力大(高并发场景下,插入幂等性表会成为瓶颈),需优化数据库(如分库分表、索引优化);

- 优化策略:幂等性表按

out_trade_no哈希分表,减少单表压力;定期清理过期数据(如超过 7 天的记录),提升查询和插入效率。

四、面试加分点

- 能明确幂等性的核心是"唯一标识+重复拦截",而非单纯"拒绝重复请求",体现对概念的深刻理解;

- 能结合微信支付的重试机制(8 次重试、间隔递增),设计标识的过期时间(24h+),体现对业务场景的熟悉;

- 能提供完整的代码实现(包括签名验证、事务处理、异常降级),展示工程落地能力;

- 能对比两种方案的优缺点和适用场景(Redis 适合高并发、数据库适合强一致性),体现选型思维;

- 能考虑异常场景(如服务宕机、Redis 宕机、数据库事务失败),设计降级和恢复策略,体现健壮性思维;

- 能提及"双重校验"(Redis 标记+订单状态查询、数据库插入+订单状态查询),避免单一环节失效导致的问题。

记忆法

- 核心逻辑口诀记忆法:总结口诀"唯一标识是基础,Redis 锁防并发,数据库表保一致,事务原子不重复",每个关键词对应方案的核心组件(唯一标识、Redis 锁、数据库表、事务),快速回忆整体逻辑;

- 方案选型绑定记忆法:将方案与场景强绑定------"高并发选 Redis(快),金融级选数据库(稳)",通过"场景-需求-方案"的链条强化记忆,避免选型混淆。

你项目中的消息推送功能是如何实现的?

消息推送是项目中常见的功能,核心目标是"将特定信息(如订单通知、活动提醒、系统公告)精准、实时地推送给目标用户",常见推送渠道包括 APP 内推送、短信、微信公众号模板消息、邮件等。项目中需根据业务场景(实时性要求、用户触达率、成本)选择合适的推送方式,同时解决"高并发推送、消息可靠性、用户偏好设置"等问题。以下结合实际项目,详解消息推送的整体架构、核心组件、多渠道实现及关键优化。

一、消息推送的整体架构设计(分层架构)

为保证推送功能的可扩展性、可维护性和可靠性,采用"分层架构"设计,分为接入层、业务层、推送层、渠道层,各层职责清晰,解耦业务与推送逻辑:

| 架构分层 | 核心职责 | 关键组件 |

|---|---|---|

| 接入层 | 接收推送请求(业务系统调用、定时任务触发),参数校验,限流熔断 | 推送 API 接口、定时任务(如活动通知)、参数校验器、限流组件 |

| 业务层 | 处理推送业务逻辑(用户筛选、消息模板渲染、权限校验、用户偏好过滤) | 消息模板引擎、用户筛选服务、偏好设置服务、权限校验服务 |

| 推送层 | 消息队列解耦、异步推送、重试机制、推送状态记录 | 消息中间件(RabbitMQ/Kafka)、推送任务调度器、重试组件、推送日志表 |

| 渠道层 | 对接第三方推送渠道(短信平台、微信公众号、APP 推送 SDK),统一推送接口 | 多渠道适配器、渠道配置中心、渠道降级组件 |

二、核心组件详细实现(结合 Golang 代码)

1. 接入层:统一推送 API 与参数校验

接入层提供 RESTful API 供业务系统调用,同时通过定时任务触发批量推送(如每日签到提醒),核心是"标准化请求参数、校验合法性、防止恶意推送"。

// 推送请求结构体(标准化参数)

type PushRequest struct {

PushType string `json:"push_type" binding:"required,oneof=SINGLE BATCH"` // 单推/批量推

UserIDs []string `json:"user_ids" binding:"required"` // 目标用户ID列表

TemplateID string `json:"template_id" binding:"required"` // 消息模板ID

TemplateVars map[string]string `json:"template_vars"` // 模板变量(如{order_no})

ChannelTypes []string `json:"channel_types" binding:"required,oneof=APP SMS WECHAT EMAIL"` // 推送渠道

Priority int `json:"priority" default:"3"` // 优先级(1-5,1最高)

}

// 统一推送 API 接口

func PushAPIHandler(c *gin.Context) {

var req PushRequest

if err := c.ShouldBindJSON(&req); err != nil {

c.JSON(400, gin.H{"code": 400, "message": fmt.Sprintf("参数校验失败:%v", err)})

return

}

// 限流校验(防止高并发推送压垮系统,如每秒最多1000次请求)

if err := limiter.Allow(); err != nil {

c.JSON(429, gin.H{"code": 429, "message": "推送请求过于频繁,请稍后再试"})

return

}

// 权限校验(仅允许指定业务系统调用,通过请求头 Token 验证)

if err := verifyPushPermission(c.Request.Header.Get("X-Push-Token")); err != nil {

c.JSON(403, gin.H{"code": 403, "message": "无推送权限"})

return

}

// 将推送请求投递到消息队列,异步处理(解耦接入层与业务层)

pushTask := &PushTask{

TaskID: uuid.NewString(),

PushRequest: req,

CreateTime: time.Now(),

Status: "PENDING",

}

if err := producePushTask(pushTask); err != nil {

c.JSON(500, gin.H{"code": 500, "message": "推送任务创建失败"})

return

}

c.JSON(200, gin.H{"code": 200, "message": "推送任务已受理", "data": map[string]string{"task_id": pushTask.TaskID}})

}

// 定时任务:每日签到提醒(批量推送)

func DailyCheckinRemindTask() {

// 1. 筛选目标用户(如未签到的活跃用户)

userIDs, err := selectUnCheckinUserIDs()

if err != nil {

log.Printf("筛选未签到用户失败:%v", err)

return

}

if len(userIDs) == 0 {

return

}

// 2. 构建推送请求

req := PushRequest{

PushType: "BATCH",

UserIDs: userIDs,

TemplateID: "CHECKIN_REMIND", // 签到提醒模板ID

TemplateVars: map[string]string{"time": time.Now().Format("15:04")},

ChannelTypes: []string{"APP", "WECHAT"}, // 优先 APP 和微信推送

Priority: 2,

}

// 3. 投递到消息队列

pushTask := &PushTask{

TaskID: uuid.NewString(),

PushRequest: req,

CreateTime: time.Now(),

Status: "PENDING",

}

if err := producePushTask(pushTask); err != nil {

log.Printf("批量推送任务创建失败:%v", err)

}

}2. 业务层:模板渲染与用户偏好过滤

业务层从消息队列消费推送任务,核心是"渲染消息内容、过滤不符合用户偏好的渠道、确保推送精准性"。

-

消息模板引擎:采用模板渲染库(如

text/template),支持动态替换变量(如订单号、时间),模板存储在数据库中,支持动态配置; -

用户偏好过滤:用户可在 APP 内设置推送渠道偏好(如关闭短信推送),推送前需查询用户偏好,过滤不允许的渠道。

// 消息模板模型

type MessageTemplate struct {

TemplateID stringgorm:"primarykey" json:"template_id"

Title stringjson:"title"// 消息标题(邮件/APP推送用)

Content stringjson:"content"// 模板内容(如"您的订单{order_no}已支付成功")

ChannelTypes []stringgorm:"type:json" json:"channel_types"// 支持的渠道

CreateTime time.Timegorm:"autoCreateTime" json:"create_time"

}// 消费推送任务(消息队列消费者)

func ConsumePushTask(task *PushTask) error {

req := task.PushRequest// 1. 查询消息模板 var template MessageTemplate if err := db.Where("template_id = ?", req.TemplateID).First(&template).Error; err != nil { log.Printf("查询模板失败:%v,task_id:%s", err, task.TaskID) return err } // 2. 渲染消息内容(替换模板变量) renderedContent, err := renderTemplate(template.Content, req.TemplateVars) if err != nil { log.Printf("模板渲染失败:%v,task_id:%s", err, task.TaskID) return err } renderedTitle := renderTemplate(template.Title, req.TemplateVars) // 3. 遍历目标用户,过滤偏好渠道 for _, userID := range req.UserIDs { // 查询用户推送偏好(如用户关闭了短信推送) userPreference, err := getUserPushPreference(userID) if err != nil { log.Printf("查询用户偏好失败:%v,user_id:%s", err, userID) continue } // 过滤用户不允许的渠道 allowedChannels := filterAllowedChannels(req.ChannelTypes, userPreference.DisabledChannels) if len(allowedChannels) == 0 { log.Printf("用户 %s 无允许的推送渠道,跳过", userID) continue } // 4. 构建用户级推送任务,投递到渠道推送队列 userPushTask := &UserPushTask{ TaskID: task.TaskID, UserID: userID, Title: renderedTitle, Content: renderedContent, Channels: allowedChannels, Priority: req.Priority, CreateTime: time.Now(), } if err := produceUserPushTask(userPushTask); err != nil { log.Printf("投递用户推送任务失败:%v,user_id:%s", err, userID) continue } } // 更新任务状态为"处理中" return db.Model(&PushTask{}).Where("task_id = ?", task.TaskID).Update("status", "PROCESSING").Error}

// 模板渲染函数

func renderTemplate(templateStr string, vars map[string]string) (string, error) {

tpl, err := template.New("message").Parse(templateStr)

if err != nil {

return "", err

}

var buf bytes.Buffer

if err := tpl.Execute(&buf, vars); err != nil {

return "", err

}

return buf.String(), nil

}// 过滤允许的推送渠道

func filterAllowedChannels(requestedChannels, disabledChannels []string) []string {

disabledMap := make(map[string]bool)

for _, ch := range disabledChannels {

disabledMap[ch] = true

}

var allowed []string

for _, ch := range requestedChannels {

if !disabledMap[ch] {

allowed = append(allowed, ch)

}

}

return allowed

}

3. 推送层:异步推送与重试机制

推送层消费用户级推送任务,调用渠道层接口推送消息,核心是"保证消息可靠性(失败重试)、记录推送状态、支持优先级调度"。

-

重试机制:采用"指数退避"策略(如首次失败后 10s 重试,第二次 30s,第三次 60s,最多重试 3 次),避免频繁重试压垮渠道;

-

状态记录:推送结果(成功/失败)记录到

push_log表,支持后续查询和统计; -

优先级调度:高优先级任务(如订单支付通知)优先消费,确保实时性。

// 用户推送任务消费逻辑

func ConsumeUserPushTask(userTask *UserPushTask) error {

// 按优先级处理(高优先级任务优先推送)

if userTask.Priority <= 2 {

// 高优先级:使用单独的协程池,确保快速处理

highPriorityPool.Submit(func() {

handleUserPush(userTask)

})

} else {

// 普通优先级:加入普通协程池

normalPriorityPool.Submit(func() {

handleUserPush(userTask)

})

}

return nil

}// 处理单个用户的推送

func handleUserPush(userTask *UserPushTask) {

for _, channel := range userTask.Channels {

// 调用渠道层推送接口

pushResult, err := pushToChannel(channel, userTask)

// 记录推送日志

pushLog := &PushLog{

TaskID: userTask.TaskID,

UserID: userTask.UserID,

Channel: channel,

Title: userTask.Title,

Content: userTask.Content,

Success: err == nil,

ErrorMsg: ifErr(err, err.Error()),

PushTime: time.Now(),

RetryCount: 0,

}

if err := db.Create(&pushLog).Error; err != nil {

log.Printf("记录推送日志失败:%v", err)

}// 推送失败,触发重试 if err != nil { if pushLog.RetryCount < 3 { // 最多重试3次 retryAfter := getRetryDelay(pushLog.RetryCount) // 指数退避延迟 time.AfterFunc(retryAfter, func() { retryUserPush(userTask, channel, pushLog.RetryCount+1) }) } else { // 重试次数耗尽,触发告警(如短信通知运维) sendAlert(fmt.Sprintf("用户 %s 渠道 %s 推送失败,task_id:%s,错误:%v", userTask.UserID, channel, userTask.TaskID, err)) } } }}

// 重试推送

func retryUserPush(userTask *UserPushTask, channel string, retryCount int) {

pushResult, err := pushToChannel(channel, userTask)

// 更新推送日志

errMsg := ifErr(err, err.Error())

if err := db.Model(&PushLog{}).

Where("task_id = ? AND user_id = ? AND channel = ?", userTask.TaskID, userTask.UserID, channel).

Updates(map[string]interface{}{

"success": err == nil,

"error_msg": errMsg,

"push_time": time.Now(),

"retry_count": retryCount,

}).Error; err != nil {

log.Printf("更新重试日志失败:%v", err)

}// 仍失败且未达最大重试次数,继续重试 if err != nil && retryCount < 3 { retryAfter := getRetryDelay(retryCount) time.AfterFunc(retryAfter, func() { retryUserPush(userTask, channel, retryCount+1) }) } else if err != nil { sendAlert(fmt.Sprintf("用户 %s 渠道 %s 重试 %d 次失败,task_id:%s", userTask.UserID, channel, retryCount, userTask.TaskID)) }}

// 指数退避延迟计算

func getRetryDelay(retryCount int) time.Duration {

delays := []time.Duration{10 * time.Second, 30 * time.Second, 60 * time.Second}

return delays[retryCount]

}

4. 渠道层:多渠道适配器与统一接口

渠道层对接第三方推送服务,通过"适配器模式"封装不同渠道的推送逻辑,提供统一的推送接口,便于扩展新渠道(如新增钉钉推送)。

// 推送渠道接口(统一接口)

type PushChannel interface {

Push(userID, title, content string) (bool, error)

}

// APP 推送适配器(对接极光推送 SDK)

type JPushAdapter struct {

appKey string

masterSecret string

}

func NewJPushAdapter(appKey, masterSecret string) *JPushAdapter {

return &JPushAdapter{appKey: appKey, masterSecret: masterSecret}

}

func (j *JPushAdapter) Push(userID, title, content string) (bool, error) {

// 初始化极光推送客户端

jclient := jpush.NewClient(j.appKey, j.masterSecret)

// 构建推送请求(按 userID 推送,对应 APP 内的注册ID)

pushReq := jpush.NewPushRequest().

SetPlatform(jpush.ALL).

SetAudience(jpush.NewAudience().SetRegistrationID([]string{userID})).

SetNotification(jpush.NewNotification().SetAlert(content).

AddAndroidNotification(jpush.NewAndroidNotification().SetTitle(title)).

AddIOSNotification(jpush.NewIOSNotification().SetAlert(title)))

// 发送推送

resp, err := jclient.Push(context.Background(), pushReq)

if err != nil {

return false, err

}

return resp.StatusCode == 200, nil

}

// 短信推送适配器(对接阿里云短信服务)

type AliSmsAdapter struct {

accessKey string

secretKey string

signName string

templateCode string

}

func NewAliSmsAdapter(accessKey, secretKey, signName, templateCode string) *AliSmsAdapter {

return &AliSmsAdapter{accessKey: accessKey, secretKey: secretKey, signName: signName, templateCode: templateCode}

}

func (a *AliSmsAdapter) Push(userID, title, content string) (bool, error) {

// 初始化阿里云短信客户端(userID 此处为手机号)

client, err := dysmsapi.NewClientWithAccessKey("cn-hangzhou", a.accessKey, a.secretKey)

if err != nil {

return false, err

}

// 构建短信请求

req := &dysmsapi.SendSmsRequest{

PhoneNumbers: &userID,

SignName: &a.signName,

TemplateCode: &a.templateCode,

TemplateParam: &fmt.Sprintf(`{"content":"%s"}`, content),

}

// 发送短信

resp, err := client.SendSms(req)

if err != nil {

return false, err

}

return *resp.Code == "OK", nil

}

// 微信公众号推送适配器(对接微信公众号 API)

type WechatMPAdapter struct {

appID string

appSecret string

templateID string

}

// 其他渠道适配器(邮件、钉钉等)类似...

// 渠道工厂:根据渠道类型创建适配器

func NewPushChannel(channelType string) (PushChannel, error) {

switch channelType {

case "APP":

return NewJPushAdapter(config.JPush.AppKey, config.JPush.MasterSecret), nil

case "SMS":

return NewAliSmsAdapter(config.AliSms.AccessKey, config.AliSms.SecretKey, config.AliSms.SignName, config.AliSms.TemplateCode), nil

case "WECHAT":

return NewWechatMPAdapter(config.WechatMP.AppID, config.WechatMP.AppSecret, config.WechatMP.TemplateID), nil

case "EMAIL":

return NewEmailAdapter(config.Email.Host, config.Email.Port, config.Email.Username, config.Email.Password), nil

default:

return nil, fmt.Errorf("不支持的推送渠道:%s", channelType)

}

}

// 调用渠道推送

func pushToChannel(channelType string, userTask *UserPushTask) (bool, error) {

channel, err := NewPushChannel(channelType)

if err != nil {

return false, err

}

return channel.Push(userTask.UserID, userTask.Title, userTask.Content)

}Linux 系统中,查看端口占用、CPU 负载、内存占用的命令分别是什么?如何向一个进程发送信号?

Linux 系统中,进程管理、资源监控是开发和运维的核心操作,熟练掌握相关命令能快速定位问题(如端口冲突、资源耗尽)。以下按 "端口占用、CPU 负载、内存占用" 分类详解常用命令,同时说明进程信号发送的方法,结合实际场景举例,确保实用性和可操作性。

一、查看端口占用的命令(核心需求:定位端口被哪个进程占用)

端口占用是开发中常见问题(如启动服务时提示 "端口已被使用"),核心命令包括 netstat、ss、lsof,其中 ss 效率最高(推荐优先使用),lsof 功能最灵活。

-

ss命令(推荐,高效快速,Linux 2.6+ 内置)- 核心功能:查看系统套接字(socket)状态,包括 TCP/UDP 端口占用,支持过滤和格式化输出。

- 常用参数:

-t:仅显示 TCP 端口;-u:仅显示 UDP 端口;-l:仅显示监听状态(LISTEN)的端口;-n:不解析域名(IP 直接显示,加速查询);-p:显示占用端口的进程 PID 和名称(需 root 权限);-a:显示所有状态的端口(监听、连接、关闭等)。

- 实用示例:

- 查看所有监听的 TCP 端口及进程:

ss -tlnp(输出包含端口号、PID、进程名,如127.0.0.1:8080对应 PID 1234 的java进程); - 查看指定端口(如 80)的占用情况:

ss -tlnp | grep :80(快速定位 80 端口是否被占用及占用进程); - 查看 UDP 端口占用:

ss -ulnp(适用于 UDP 服务如 DNS、日志收集)。

- 查看所有监听的 TCP 端口及进程:

-

lsof命令(功能强大,支持多维度过滤)- 核心功能:List Open Files,列出系统中所有打开的文件(Linux 中 "一切皆文件",端口也属于文件),可通过端口号反向查询进程。

- 常用参数:

-i:过滤网络文件(端口相关);-i :端口号:指定端口号查询;-P:不解析端口号为服务名(如 80 不显示为 http);-n:不解析 IP 为域名;-p PID:通过 PID 查看进程打开的文件(反向查询)。

- 实用示例:

- 查看 8080 端口的占用进程:

lsof -i :8080(输出包含 PID、进程名、用户、协议类型,如PID 1234 (go)占用 8080 端口); - 查看 TCP 协议 3306 端口(MySQL)占用:

lsof -i tcp:3306; - 查看进程 1234 打开的所有端口:

lsof -i -p 1234(适用于排查进程异常占用端口)。

- 查看 8080 端口的占用进程:

-

netstat命令(传统命令,兼容性好,效率略低)- 核心功能:与

ss类似,查看网络连接和端口状态,适用于老版本 Linux 系统。 - 常用参数:

-t:TCP 端口;-u:UDP 端口;-l:监听状态;-n:不解析域名和端口名;-p:显示进程 PID 和名称(需 root);-a:所有状态。

- 实用示例:

netstat -tlnp | grep :3306(查看 MySQL 端口占用)。

- 核心功能:与

二、查看 CPU 负载的命令(核心需求:监控 CPU 使用率、进程占用情况)

CPU 负载过高会导致服务响应缓慢、卡顿,常用命令包括 top、htop、mpstat、pidstat,其中 top 是最基础且必备的命令。

-

top命令(实时监控,全局视图)- 核心功能:实时显示系统整体 CPU 负载、内存使用、进程列表(默认每 3 秒刷新一次),支持交互式操作。

- 界面关键指标解读:

- 第一行:系统时间、运行时间、登录用户数、负载平均值(

load average: 0.50, 0.30, 0.20分别表示 1 分钟、5 分钟、15 分钟的负载,值越小负载越低,单核 CPU 负载 >1 表示过载); - 第二行:进程总数(total)、运行中(running)、睡眠中(sleeping)、僵尸进程(zombie)数量;

- 第三行:CPU 使用率(

%us:用户空间进程占用率,%sy:内核空间占用率,%id:空闲率,%wa:I/O 等待占用率,%wa过高可能是磁盘 I/O 瓶颈);

- 第一行:系统时间、运行时间、登录用户数、负载平均值(

- 交互式操作(实时调整):

P:按 CPU 使用率降序排序(默认);M:按内存使用率降序排序;N:按 PID 降序排序;q:退出top视图;k:向指定进程发送信号(后续详细说明)。

-

htop命令(top增强版,界面更友好)- 核心功能:兼容

top的所有功能,新增彩色显示、鼠标操作、进程树视图,需手动安装(yum install htop或apt install htop)。 - 优势:支持横向滚动查看长命令行、进程分组显示、快速搜索进程(按

/输入关键词),比top更易用。

- 核心功能:兼容

-

mpstat命令(CPU 核心级监控)- 核心功能:查看每个 CPU 核心的负载情况,适用于多核心服务器(如 8 核 CPU 某一核心过载的场景)。

- 常用参数:

-P ALL:显示所有核心的 CPU 使用率;-u:显示 CPU 使用率统计(默认);- 间隔时间 刷新次数:如

mpstat -P ALL 2 3(每 2 秒刷新一次,共刷新 3 次)。

- 实用场景:排查 "整体 CPU 负载不高,但服务卡顿" 问题(可能是单个核心被某进程占满)。

-

pidstat命令(进程级 CPU 监控)- 核心功能:针对单个或多个进程,查看其 CPU 使用率、线程数、上下文切换次数,精准定位高 CPU 进程。

- 常用参数:

-u:显示 CPU 使用率;-p PID:指定进程 PID;- 间隔时间 刷新次数:如

pidstat -u -p 1234 1 5(监控 PID 1234 的进程,每 1 秒刷新一次,共 5 次)。

三、查看内存占用的命令(核心需求:监控内存使用、排查内存泄漏)

内存占用过高会导致系统 OOM(Out Of Memory)杀死进程,常用命令包括 free、top、htop、vmstat。

-

free命令(快速查看内存整体使用)-

核心功能:显示系统物理内存、交换内存(swap)的总容量、已用、空闲、缓存占用情况。

-

常用参数:

-h:人性化显示单位(如 GB、MB,避免换算);-m:以 MB 为单位显示;-g:以 GB 为单位显示;-s 间隔时间:持续刷新(如free -h -s 2每 2 秒刷新一次)。

-

输出解读(

free -h示例):total used free shared buff/cache available Mem: 15Gi 3.2Gi 8.5Gi 128Mi 3.8Gi 12Gi Swap: 19Gi 0B 19Gitotal:物理内存总容量;used:已使用内存(包括进程占用、内核占用);free:完全空闲的内存;buff/cache:缓冲区(buffer)和页缓存(cache)占用的内存(可被系统回收);available:可用内存(free + buff/cache中可回收部分,最能反映系统实际可用内存)。

-

-

top/htop命令(进程级内存监控)- 核心功能:在全局监控视图中,查看单个进程的内存占用情况。

- 关键指标(

top界面):%MEM:进程占用的物理内存百分比;VSZ:进程虚拟内存大小(包括代码、数据、共享库、交换空间);RSS:进程实际占用的物理内存大小(不包括虚拟内存和交换空间,最能反映进程内存消耗);

- 操作:按

M键按%MEM降序排序,快速定位内存占用最高的进程。

-

vmstat命令(内存和 I/O 综合监控)- 核心功能:显示内存、进程状态、CPU、磁盘 I/O 等系统整体状态,适用于排查内存泄漏导致的系统性能下降。

- 常用参数:

vmstat 2 5(每 2 秒刷新一次,共 5 次); - 关键指标:

si:从交换空间(swap)读入物理内存的数据量(单位:块 / 秒),si持续不为 0 可能是物理内存不足;so:从物理内存写入交换空间的数据量(单位:块 / 秒),so持续不为 0 表示内存严重不足;buff/cache:缓冲区和页缓存大小。

四、向进程发送信号(核心需求:控制进程行为,如终止、重启、刷新配置)

Linux 中,信号(Signal)是进程间通信的一种方式,用于通知进程执行特定操作(如终止、暂停)。常用命令是 kill 和 pkill,核心是 "指定信号类型 + 进程标识(PID 或进程名)"。

-

常用信号类型(核心信号编号及含义)

信号编号 信号名称 含义 常用场景 1 SIGHUP 挂起信号,进程收到后重新加载配置(不终止进程) 重启服务(如 Nginx、Redis),避免停机 9 SIGKILL 强制终止信号,进程无法忽略,直接杀死进程 强制关闭无响应的进程(如死循环进程) 15 SIGTERM 正常终止信号,进程收到后可清理资源再退出(默认信号) 优雅关闭进程(推荐优先使用,避免数据丢失) 2 SIGINT 中断信号,等同于键盘 Ctrl+C 手动终止前台运行的进程 18 SIGCONT 继续信号,恢复被暂停的进程 恢复 SIGSTOP暂停的进程19 SIGSTOP 暂停信号,进程暂停运行(无法忽略) 临时暂停进程(如调试时) -

kill命令(通过 PID 发送信号)- 基本语法:

kill -信号编号 PID或kill -信号名称 PID; - 实用示例:

- 优雅终止 PID 1234 的进程:

kill -15 1234或kill -SIGTERM 1234(推荐,进程有时间清理资源); - 强制终止 PID 1234 的进程:

kill -9 1234或kill -SIGKILL 1234(仅在进程无响应时使用); - 重启 Nginx 进程(PID 5678):

kill -1 5678(Nginx 收到 SIGHUP 信号后重新加载配置); - 暂停 PID 1234 的进程:

kill -19 1234; - 恢复暂停的进程:

kill -18 1234。

- 优雅终止 PID 1234 的进程:

- 基本语法:

-

pkill命令(通过进程名发送信号,更便捷)- 核心功能:无需查询 PID,直接通过进程名匹配进程并发送信号(支持模糊匹配);

- 基本语法:

pkill -信号编号 进程名; - 实用示例:

- 优雅终止所有

go进程:pkill -15 go; - 强制关闭所有

java进程:pkill -9 java; - 重启 Nginx 服务(进程名

nginx):pkill -1 nginx。

- 优雅终止所有

五、面试加分点

- 能区分不同命令的适用场景(如

ss比netstat高效,lsof支持多维度过滤),体现对命令细节的掌握; - 能解读

top/free命令的关键指标(如available内存、RSS进程内存),而非仅罗列命令; - 能说明信号的区别(如

SIGTERM与SIGKILL的使用场景,避免数据丢失),体现对进程管理的深刻理解; - 能结合实际问题举例(如端口冲突用

ss -tlnp | grep :端口定位,高 CPU 用top按P排序排查),展示实操能力; - 能提及

htop、pidstat等增强命令,体现技术广度。

记忆法

- 核心命令口诀记忆法:总结口诀 "端口 ss/lsof,CPU top/htop,内存 free/vmstat,信号 kill/pkill",每个关键词对应一类操作,快速关联命令;

- 信号编号绑定记忆法:将常用信号与场景绑定 ------"1 重启(SIGHUP)、9 强制杀(SIGKILL)、15 正常杀(SIGTERM)、2 Ctrl+C(SIGINT)",通过场景强化信号编号记忆。

Go 与 C++ 的对比有哪些?(从语法、并发、内存管理、适用场景等方面)

Go(又称 Golang)和 C++ 是两款高性能编程语言,均适用于系统级开发,但设计理念、语法特性、生态场景差异显著。C++ 强调 "零成本抽象" 和极致性能,兼容 C 语言,灵活度极高;Go 强调 "简单高效" 和原生并发,语法简洁,开箱即用。以下从语法、并发、内存管理、性能、适用场景等核心维度对比,结合实际开发场景说明选型逻辑。

一、语法特性对比(核心差异:简洁 vs 灵活)

语法是开发效率的核心影响因素,Go 以 "简洁、无冗余" 为设计哲学,C++ 以 "多范式、高灵活" 为特点,两者语法复杂度差异明显。

| 对比维度 | Go | C++ |

|---|---|---|

| 语法风格 | 极简主义,无多余特性,关键字仅 25 个,代码可读性强 | 多范式(面向对象、泛型、函数式、过程式),关键字多(63 个),语法复杂灵活 |

| 类型系统 | 静态类型,强类型,支持类型推断(var x = 10 或 x := 10),无隐式类型转换 |

静态类型,强类型,支持类型推断(C++11 后 auto),允许有限隐式类型转换(如 int 转 double),支持指针、引用、const 常量 |

| 面向对象 | 无类(class)和继承,通过 "结构体(struct)+ 方法(method)" 实现面向对象特性,支持组合(composition)而非继承,无多态关键字(通过接口实现多态) | 完整面向对象支持(类、继承、多态、封装),支持单继承、多重继承(易引发菱形继承问题),通过虚函数(virtual)实现多态 |

| 泛型 | Go 1.18 后支持泛型(type T interface{}),语法简洁,仅支持函数和结构体泛型,无模板特化 |

支持模板(template)泛型,功能强大,支持函数模板、类模板、模板特化、模板偏特化,可实现复杂泛型逻辑 |

| 错误处理 | 无异常机制(try/catch),通过返回值 error 类型显式处理错误,支持 errors.New() 自定义错误,Go 1.13+ 支持错误包装(fmt.Errorf("xxx: %w", err)) |

支持异常机制(try/catch/throw),同时支持返回值错误处理,异常可跨函数传播,但异常开销较高,易导致资源泄漏(需手动管理 RAII) |

| 其他特性 | 原生支持切片(slice)、映射(map)、通道(channel),内置 go 关键字启动协程,无指针算术(安全) |

支持指针算术(如 p++)、运算符重载、宏定义(#define)、预编译指令,无内置容器(依赖 STL 容器如 vector、map) |

二、并发模型对比(核心差异:原生协程 vs 手动线程)

并发是现代编程的核心需求,Go 原生支持高效并发,C++ 需依赖第三方库或手动管理线程,两者并发开发效率和性能差异显著。

-

Go:原生协程(Goroutine)+ 通道(Channel)模型

-

核心组件:

- Goroutine:轻量级线程(用户态线程),由 Go 运行时(runtime)调度,而非操作系统内核,创建成本极低(栈初始大小 2KB,可动态扩缩容,支持百万级并发);

- Channel:用于 Goroutine 间通信的管道,支持同步 / 异步通信,遵循 "不要通过共享内存通信,而通过通信共享内存" 的设计哲学,避免数据竞争;

- 调度器:M:N 调度(M 个 Goroutine 映射到 N 个操作系统线程),Go 运行时负责 Goroutine 的切换,无内核态切换开销,并发效率极高;

- 辅助工具:

sync包(互斥锁Mutex、读写锁RWMutex、等待组WaitGroup)、context包(协程生命周期管理)。

-

代码示例(简单并发):

func main() { ch := make(chan int) // 启动 2 个 Goroutine go func() { ch <- 1 }() go func() { ch <- 2 }() // 接收结果 fmt.Println(<-ch, <-ch) // 输出 1 2 或 2 1(顺序不确定,可通过同步控制) }

-

-

C++:线程(Thread)+ 锁(Mutex)模型

-

核心组件:

- 线程:依赖操作系统线程(内核态线程),C++11 后支持

std::thread标准库,创建成本高(栈初始大小 MB 级,支持并发数有限,通常数千级); - 同步机制:依赖

std::mutex(互斥锁)、std::condition_variable(条件变量)、std::future/std::promise(异步结果传递),需手动处理数据竞争,易出现死锁; - 无原生协程:C++20 后支持协程(Coroutine),但需手动实现调度器,语法复杂,生态不完善,实际开发中仍以线程为主;

- 第三方库:如 Boost.Thread 可增强并发功能,但需额外依赖。

- 线程:依赖操作系统线程(内核态线程),C++11 后支持

-

代码示例(简单并发):

#include <iostream> #include <thread> #include <mutex> using namespace std; mutex mtx; void printNum(int num) { lock_guard<mutex> lock(mtx); // 手动加锁 cout << num << endl; } int main() { thread t1(printNum, 1); thread t2(printNum, 2); t1.join(); t2.join(); return 0; }

-

-

核心差异总结:

- 开发效率:Go 并发开发更简单(

go关键字 + 通道),无需关注线程创建、调度、栈管理;C++ 需手动管理线程、锁,开发复杂度高; - 并发性能:Go 支持百万级 Goroutine,切换开销低;C++ 线程并发数有限,内核态切换开销高;

- 数据安全:Go 通道天然支持安全通信,数据竞争少;C++ 需手动加锁,易出现死锁和数据竞争。

- 开发效率:Go 并发开发更简单(

三、内存管理对比(核心差异:自动 GC vs 手动管理)

内存管理直接影响程序稳定性和开发效率,Go 内置垃圾回收(GC),C++ 以手动内存管理为主,两者各有优劣。

-

Go:自动垃圾回收(GC)+ 逃逸分析

- 核心机制:

- 垃圾回收:Go 1.5+ 采用 "三色标记 + 混合写屏障" 算法,GC 停顿时间极短(毫秒级,Go 1.19+ 支持并发标记和并发清理),无需手动释放内存;

- 逃逸分析:编译时分析变量生命周期,决定变量分配在栈上(栈内存自动释放,无 GC 开销)或堆上(堆内存由 GC 管理),减少 GC 压力;

- 内存分配:采用 "TCMalloc" 风格的内存分配器,支持多线程缓存,分配效率高;

- 限制:无手动内存释放接口(

free),无法精确控制内存回收时机,对内存敏感场景(如嵌入式)不够灵活。

- 核心机制:

-

C++:手动内存管理 + RAII 机制

- 核心机制:

- 手动管理:通过

new分配内存,delete/delete[]释放内存,需开发者手动跟踪内存生命周期,易出现内存泄漏、野指针、重复释放等问题; - RAII(资源获取即初始化):通过类的构造函数获取资源,析构函数释放资源(如

std::string、std::vector容器自动管理内存),减少手动释放错误; - 智能指针:C++11 后支持

std::unique_ptr(独占所有权)、std::shared_ptr(共享所有权)、std::weak_ptr(弱引用),模拟自动内存管理,但仍需关注循环引用问题; - 优势:内存管理完全可控,无 GC 开销,内存使用效率极高,适合对内存延迟敏感的场景。

- 手动管理:通过

- 核心机制:

-

核心差异总结:

- 开发效率:Go 无需关注内存释放,开发效率高,降低入门门槛;C++ 需手动管理内存,开发成本高,对开发者要求高;