入门AI大模型的速成秘诀

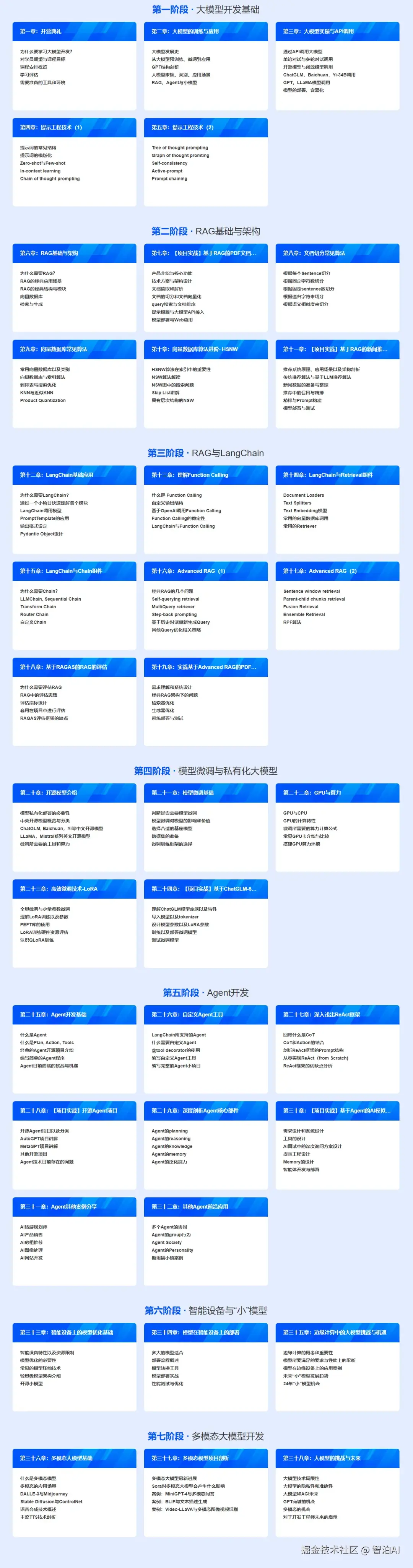

第一阶段:打牢基础

深入NLP核心知识体系,系统掌握Transformer架构原理,熟练运用词向量与分词技术,基于Python与PyTorch构建开发环境以强化底层逻辑支撑。

第二阶段:模型训练和推理

系统学习预训练阶段的核心方法,深入理解SFT有监督微调的技术逻辑,熟练运用RLHF强化学习框架与Reward模型构建机制,全面掌握DPO等推理优化策略的应用,从而透彻解析模型从初始训练到最终高效输出的完整技术路径。

第三阶段:模型微调与蒸馏

针对垂直领域优化需求,实践LORA/QLORA低资源微调方案:采用Prompt Tuning技术路径,借助数据蒸馏实现大模型向小模型的知识迁移,有效控制部署开销。

第四阶段:了解评估体系

掌握文本生成评估指标BLEU 与ROUGE 的核心方法;

深入解析Perplexity(困惑度)的数学意义与实用场景;

通过Benchmark 多任务测试与长尾任务评估的实践应用;

构建模型性能衡量的科学评价体系。

第五阶段:优化技术

聚焦于ROPE编码与Flash Attention等核心加速算法的研究,深入探索混合精度训练技术及KVCache优化策略,通过分析各厂商模型创新方案实现运算速度与显存利用率的双重提升。

第六阶段:模型梳理

系统梳理GPT、LLaMA、Qwen等主流开源模型的版本演进路径:分析闭源与开源模型的技术差异,明确各模型的最佳应用场景,为技术选型提供决策支持。

第七阶段:分布式训练

针对大模型参数规模持续扩张的挑战,需掌握分布式训练框架及其实现方法,深入解析多卡并行计算机制,突破单卡显存容量限制,从而保障超大规模模型的训练需求。

第八阶段:项目实战落地

依托RAG与Agent技术构建行业解决方案:涵盖智能问答系统、文生图应用等场景,实现从需求分析至部署落地的全链路技术闭环与业务价值融合。

【完整版可share】·更多AI大模型学习视频及资源,都在智泊AI。