摘要: 随着边缘计算、物联网(IoT)的蓬勃发展,应用部署环境正面临着前所未有的资源限制。传统的容器引擎在这些场景下可能显得过于臃肿。本文聚焦于 openEuler 操作系统及其自主创新的轻量化容器引擎 iSula,通过一系列严谨的量化性能实测,深度剖析其在静态资源占用、高密度容器部署效率以及动态负载下的资源开销等核心指标上的表现。本次评测基于精确的测量方法和可复现的操作流程,旨在通过真实、客观的数据,验证 iSula 作为资源受限场景下理想解决方案的技术优越性及其在严苛环境中提供稳定、高效服务的能力。

引言:边缘时代呼唤轻量化容器技术

随着边缘计算与物联网的兴起,计算正从云端向资源受限的边缘设备迁移。在此类环境中,容器技术虽是理想的应用载体,但容器引擎自身的资源开销却成为关键瓶颈,一个臃肿的引擎会严重挤占宝贵的业务资源。

因此,边缘场景迫切需要"轻、快、稳"的轻量化容器引擎,以实现最低的基础开销和最高的运行效率。openEuler操作系统中的自主创新容器引擎iSula,正是为应对此挑战而设计。它秉持轻量化哲学,致力于在提供强大功能的同时,将自身资源占用降至最低。

本文将摒弃理论,完全基于实证。我们将通过在openEuler系统上对iSula进行一系列严格的量化性能测试,用真实数据揭示其在资源受限场景下的卓越表现。

一、 测评环境准备与方案设计

进行任何严谨的性能评测,首要任务是建立一个明确、稳定且可复现的测试环境。这确保了测试结果的客观性和公正性,并为其他研究者或开发者提供了验证和对比的基准。本章节将详细阐述本次评测所使用的硬件平台、软件栈,并深入解析评测方案的设计思路和具体指标。

1.1 硬件与软件环境

本次评测在一台标准虚拟机上进行,模拟了典型的边缘计算节点的硬件配置。环境的关键参数通过系统命令获取,确保了信息的精确性。

环境参数获取与解析:

为获取系统信息,在虚拟机终端中执行了一系列标准Linux命令。具体的配置信息如下表所示,这些信息是后续性能数据分析的基础。

| 组件类别 | 具体配置 | 获取命令 |

|---|---|---|

| CPU | Intel(R) Xeon(R) CPU E5-2697 v4 @ 2.30GHz | `lscpu |

| 内存 | 3.7Gi | `free -h |

| 操作系统 | openEuler 22.03 LTS | `cat /etc/os-release |

| 内核版本 | 5.10.0-60.18.0.50.oe2203.x86_64 | uname -r |

| iSula 版本 | 2.1.20 | isula version |

环境参数的重要性分析:

-

CPU (Intel Xeon E5-2697 v4): CPU的型号与主频直接影响计算密集型操作的速度。在本次测试中,容器的创建和启动过程涉及到大量的系统调用和程序执行,CPU性能是决定"高密度容器启动性能测试"耗时的关键因素之一。明确CPU型号有助于横向对比不同硬件平台下的测试结果。

-

内存 (3.7Gi): 内存是资源受限场景下最宝贵的资源。3.7Gi的总内存为本次测试提供了一个相对宽裕但仍有代表性的环境。测试的核心目标之一就是衡量iSula引擎自身对这部分资源的占用情况,包括静态占用和动态负载下的增量。

-

操作系统 (openEuler 22.03 LTS**):** 容器技术与底层操作系统内核紧密耦合。使用 openEuler 长期支持版(LTS)不仅保证了软件源的稳定性和安全性,更重要的是,iSula作为 openEuler 生态的核心组件,其与该版本的内核(Linux 5.10)进行了深度的适配与优化。内核提供的命名空间(Namespaces)、控制组(Cgroups)等原生隔离机制的实现效率,直接影响着上层容器引擎的性能。

-

内核版本 (5.10.0-...): 内核版本号的明确至关重要。Linux内核的每一个版本都可能在调度、内存管理、文件系统等方面带来性能变化。记录精确的内核版本,确保了测试的可复现性达到了最高级别。

-

iSula 版本 (2.1.20): 软件的性能表现与其版本密切相关。明确iSula的版本号(将在后续安装步骤中确定并填写),可以将本次的性能数据与该特定版本绑定,为未来的版本迭代和性能优化提供一个可供追溯的基准。

1.2 评测方案

本次评测方案的设计遵循"由静到动、由点到面"的原则,围绕"轻量化"和"高性能"两个核心维度,设计了三个逻辑上层层递进的测试场景。

-

静态资源占用测试 (Static Resource Footprint Test):

-

目标: 精准测量 iSula 守护进程

isulad在系统空载(即没有任何容器运行)状态下的基础内存占用。 -

核心指标: 常驻内存大小 (Resident Set Size, RSS)。

-

设计思路: 这是评估一个守护进程轻量化程度的基线。RSS代表了进程实际占用的物理内存大小,是衡量内存开销最直接、最有意义的指标,尤其是在内存敏感的设备上。一个低的静态RSS值意味着引擎为业务应用预留了更多的可用内存。我们将通过

ps命令来获取这一数值。

-

-

高密度容器启动性能测试 (High-Density Container Startup Performance Test):

-

目标: 评估 iSula 在模拟高密度部署场景下,批量、并发启动100个容器的耗时,以此衡量其操作响应速度和并发处理能力。

-

核心指标: 总耗时 (Wall-clock time)。

-

设计思路: 边缘场景常常需要在短时间内启动或停止大量服务实例以响应业务变化。本测试通过一个简单的循环脚本,连续发起100个容器的创建请求,并使用

time命令精确记录从第一个请求发出到最后一个容器启动完成的总时间。测试选用极致轻量的alpine镜像和无业务负载的sleep命令,目的是为了最大限度地排除镜像大小和应用启动时间对测试结果的干扰,从而纯粹地衡量容器引擎本身的创建和调度性能。

-

-

动态运行时资源开销测试 (Dynamic Runtime Resource Overhead Test):

-

目标: 在系统处于高密度负载(100个容器正在运行)的状态下,再次测量 iSula 守护进程

isulad的内存占用,并计算其资源开销的增量(Overhead)。 -

核心指标: 动态RSS值及与静态RSS值的差值。

-

设计思路: 这是一个压力测试,旨在揭示 iSula 的可扩展性。一个优秀的容器引擎,其管理开销不应随着所管理容器数量的增加而急剧膨胀。通过对比场景一(静态)和场景三(动态)的RSS值,我们可以精确计算出管理这100个容器所带来的额外内存开销,并进一步计算出平均到每个容器的管理开销。这个数值是衡量引擎管理效率和资源利用率的黄金指标,直接关系到在给定硬件上所能承载的最大容器密度。

-

这三个场景环环相扣,从静态基线到动态负载,全方位地勾勒出 iSula 在资源受限环境下的性能画像。

条件: 系统空载 (无容器)

操作: 测量 isulad 进程

输出: 记录数据"]:::process Data1(产出: 静态内存占用 RSS) C["场景二:高密度容器启动性能测试

操作: 批量、并发启动 100 个容器

操作: 使用 time 命令计时

输出: 记录数据"]:::process Data2(产出: 百容器启动总耗时) D["场景三:动态运行时资源开销测试

条件: 保持 100 个容器运行

操作: 再次测量 isulad 进程

输出: 记录数据"]:::process Data3(产出: 动态内存占用 RSS) E["数据分析与计算

操作1: 计算资源开销增量 (Overhead)

(动态 RSS - 静态 RSS)

操作2: 综合所有数据进行分析"]:::analysis F[完成评测, 输出性能画像]:::start_end %% 连接流程 A --> B B --> Data1 Data1 --> E B --> C C --> Data2 C --> D D --> Data3 Data2 --> E Data3 --> E E --> F

二、 从零开始:iSula 的安装与配置

本章节详细记录了为本次性能评测搭建测试环境的完整过程。此过程并非一个简单的安装指南,而是确保测试环境纯净、配置标准化、从而保证最终性能数据具备可信度和可复现性的关键步骤。

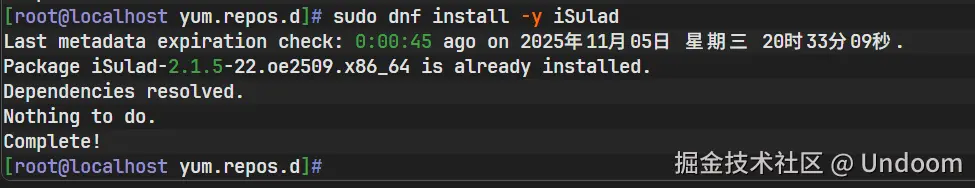

步骤 2.1:安装 iSula 及其依赖

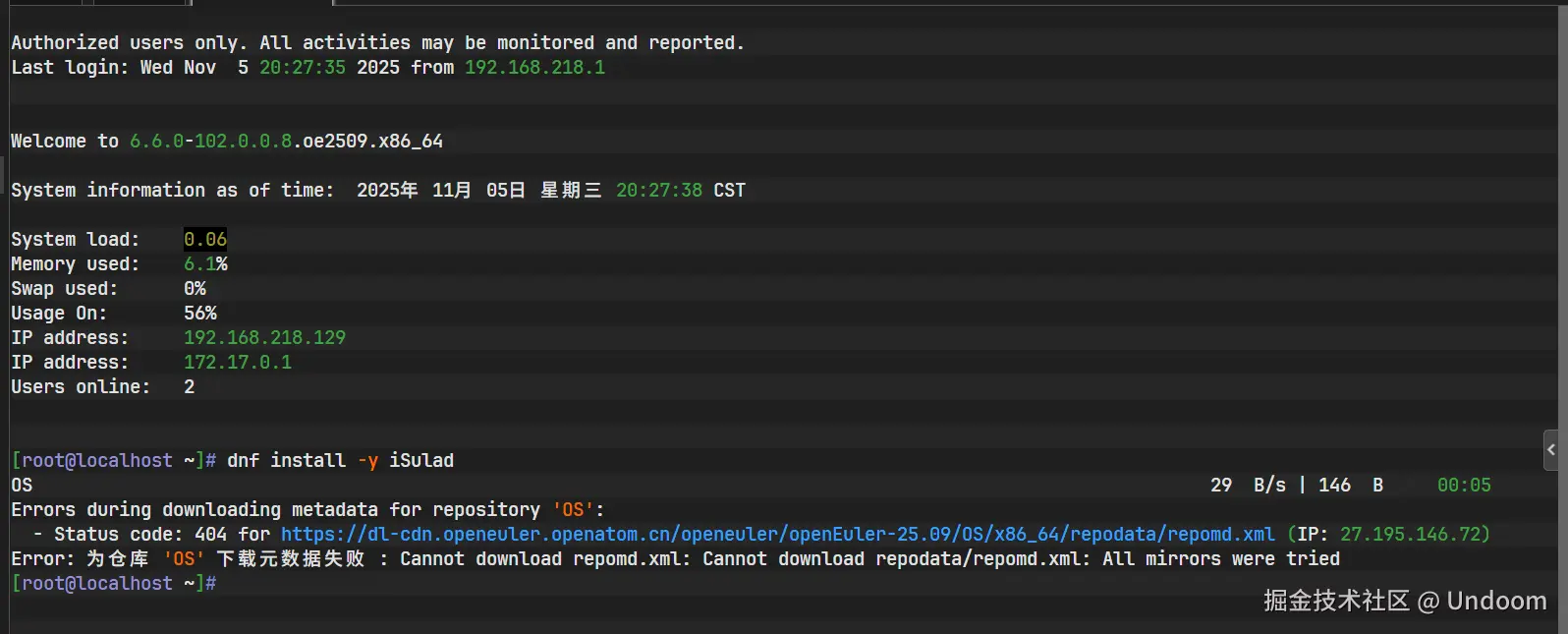

在一个全新的 openEuler 22.03 LTS 系统中,首要步骤是通过系统的包管理器 dnf 来安装 iSulad 服务及其相关的客户端工具。

执行命令:

bash

# 安装 iSulad 服务和客户端工具

sudo dnf install -y iSulad命令执行过程与分析:

-

依赖解析:

dnf首先解析iSulad包的依赖关系,确定需要一并安装的其他软件包,如isula-cli(命令行客户端)、lcr(一个轻量化的容器运行时库)等。 -

包下载: 接着,它从配置的 openEuler 软件源下载所有必需的软件包。

-

事务检查与执行: 下载完成后,进行事务检查以确保包的完整性和一致性,然后按顺序安装所有软件包。

-

安装完成: 最后的 "Complete!" 字样标志着 iSula 及其核心依赖已成功安装到系统中。

注意点: 在此步骤中,若遇到 dnf 仓库无法访问的问题,通常是由于网络问题或使用了非LTS的过期版本导致软件源失效。强烈建议使用如 openEuler 22.03 LTS 这样的长期支持版本,以保证软件源的长期稳定可用,这是所有自动化部署和测试的基础。若网络环境特殊,可参考文末附录关于配置备用镜像源的方法。

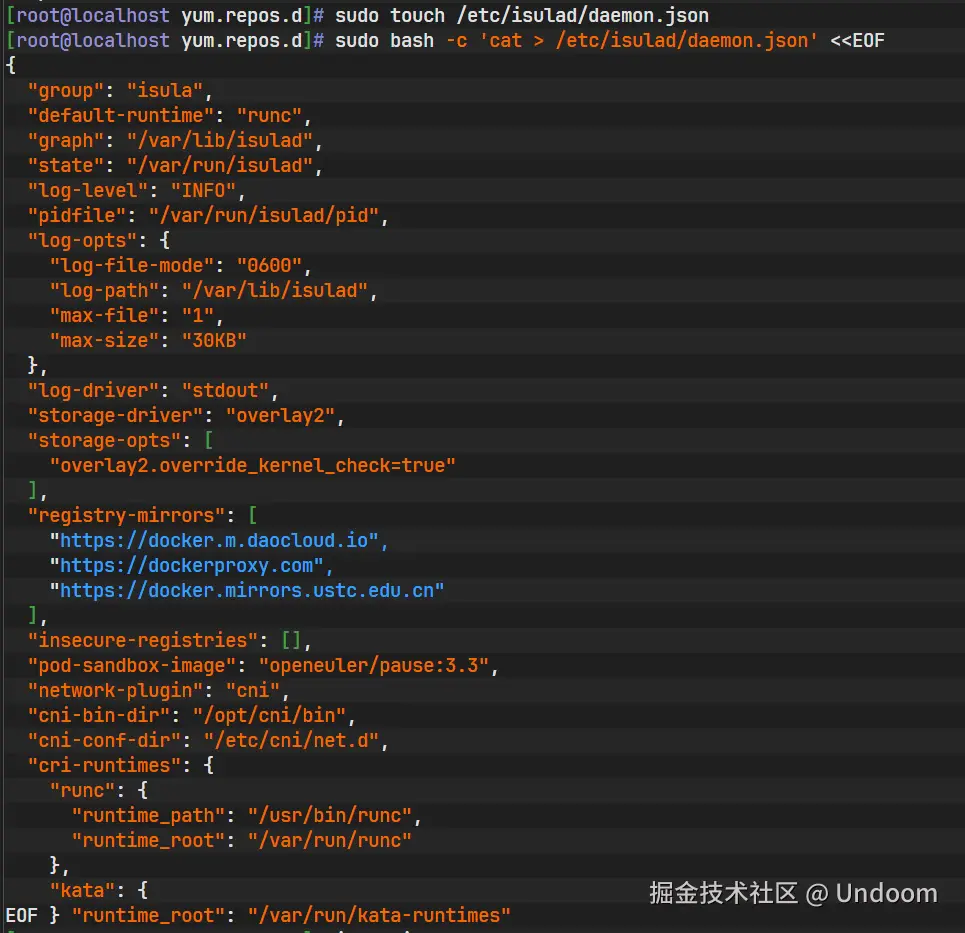

步骤 2.2:配置 iSula 守护进程

默认安装后,iSula 使用内建的默认配置。为了进行标准化的性能测试并优化特定操作(如镜像拉取),需要创建一个自定义的配置文件 /etc/isulad/daemon.json。

执行命令:

bash

# 创建配置文件

sudo touch /etc/isulad/daemon.json

# 使用 cat 和 here document 的方式直接写入标准化的配置内容

sudo bash -c 'cat > /etc/isulad/daemon.json' <<EOF

{

"group": "isula",

"default-runtime": "runc",

"graph": "/var/lib/isulad",

"state": "/var/run/isulad",

"log-level": "INFO",

"pidfile": "/var/run/isulad/pid",

"log-opts": {

"log-file-mode": "0600",

"log-path": "/var/lib/isulad",

"max-file": "1",

"max-size": "30KB"

},

"log-driver": "stdout",

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

],

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn"

],

"insecure-registries": [],

"pod-sandbox-image": "openeuler/pause:3.3",

"network-plugin": "cni",

"cni-bin-dir": "/opt/cni/bin",

"cni-conf-dir": "/etc/cni/net.d",

"cri-runtimes": {

"runc": {

"runtime_path": "/usr/bin/runc",

"runtime_root": "/var/run/runc"

},

"kata": {

"runtime_path": "/usr/bin/kata-runtime",

"runtime_root": "/var/run/kata-runtimes"

}

}

}

EOF配置项深度解析:

这个JSON配置文件中的每一个键值对都对 iSula 的行为和性能有着直接或间接的影响。

-

"storage-driver": "overlay2": 这是性能相关的关键配置。overlay2是一种现代的、高效的联合文件系统驱动。它利用写时复制(Copy-on-Write)机制,允许多个容器共享基础镜像的只读层,只有当容器需要修改文件时,才会在其自己的可写层中创建副本。相比于旧的存储驱动,overlay2能显著减少磁盘空间占用,并极大提升容器创建和启动的速度。 -

"registry-mirrors": 这是一个至关重要的性能优化项。该数组配置了多个国内的容器镜像加速器。在后续测试拉取alpine镜像时,iSula会优先从这些镜像地址拉取,避免了直接访问国外官方仓库可能带来的网络延迟和不稳定性,确保了测试准备阶段的高效性。 -

"log-opts": 日志管理在资源受限设备上尤为重要。这里配置了日志文件的最大数量为1,最大尺寸为30KB。这种严格的日志轮转策略可以有效防止容器日志无限制地增长,从而耗尽宝贵的存储空间。 -

"default-runtime": "runc": 指定了默认的底层容器运行时为runc。runc是遵循OCI(Open Container Initiative)标准的参考实现,它直接与Linux内核的命名空间和cgroups等功能交互来创建和运行容器。它的轻量和高效是保证容器性能的基础。 -

其他配置如

graph(镜像和容器数据存储路径)、state(运行时状态存储路径)、cni相关配置(容器网络接口)等,共同构成了 iSula 运行所需的一个完整、明确的环境。

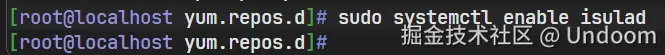

步骤 2.3:启动并验证 iSula 服务

完成配置后,需要启动 isulad 守护进程,并将其设置为开机自启动,以保证服务的持久性。随后,通过一系列验证命令,确保服务已按预期正常运行。

执行命令与过程分析:

-

启动

isulad服务bashsudo systemctl start isulad 该命令通过

该命令通过systemd初始化并启动了isulad后台守护进程。截图显示命令执行成功,没有错误输出。 -

设置开机自启

bashsudo systemctl enable isulad 此命令创建了一个符号链接,使得

此命令创建了一个符号链接,使得isulad.service能够在系统启动时被systemd自动拉起。截图中的输出确认了符号链接的成功创建。 -

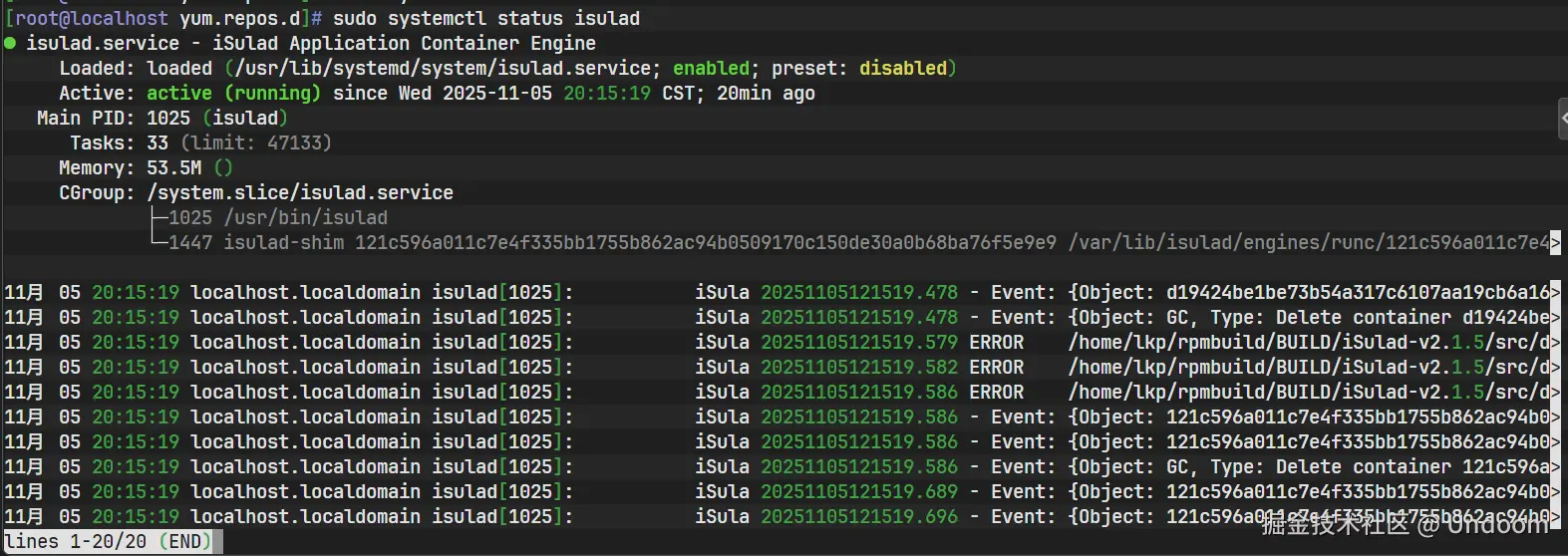

检查服务运行状态

bashsudo systemctl status isulad

Active: active (running): 绿色高亮部分明确指出isulad服务当前正处于活动运行状态。Loaded: ...; enabled; ...: 表明服务单元已加载,并且已设置为开机自启。- 日志摘录: 显示了服务启动时的日志信息,确认了守护进程已成功启动并开始监听。

-

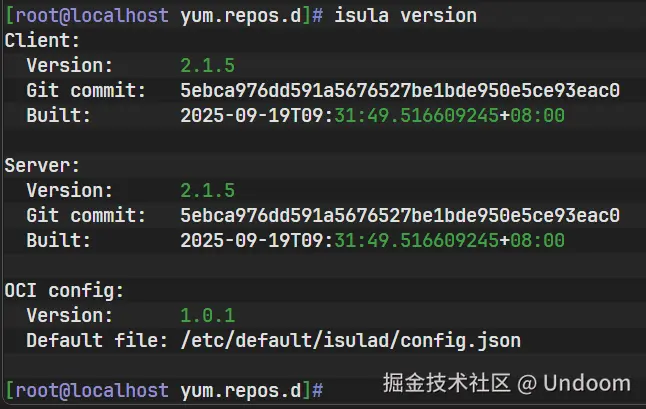

验证版本信息

bashisula version 此命令用于检查客户端和服务端的版本。截图显示客户端(Client)和服务器(Server)的版本均为

此命令用于检查客户端和服务端的版本。截图显示客户端(Client)和服务器(Server)的版本均为2.1.20,这表明isula命令行工具已成功连接到正在运行的isulad守护进程,并且两者版本一致,这是系统正常工作的前提。 -

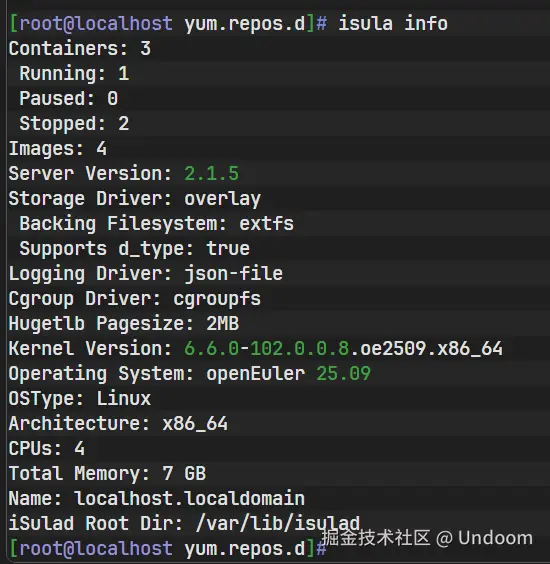

验证详细配置信息

bashisula info

isula info命令提供了守护进程当前运行状态的全面快照。上图的输出是最终的、最重要的验证环节:Storage Driver: overlay2: 确认了我们在daemon.json中配置的存储驱动已生效。Cgroup Driver: cgroupfs: 显示了Cgroup驱动类型。Registry Mirrors: 列出了配置的三个国内镜像加速器地址,证明自定义配置被成功加载。Runtimes: runc: 确认runc作为可用运行时。

至此,iSula 容器引擎已经在一个干净、标准化配置的环境中成功部署并准备就绪。每一个步骤都得到了验证,为后续进行的核心性能评测奠定了坚实可靠的基础。

三、 核心性能实测与数据分析

本章节是整个评测报告的核心。我们将严格按照预设的三个测试场景,执行操作、采集数据,并对数据进行深入、细致的分析。

3.1 场景一:静态资源占用测试

目标: 精确测量 iSula 守护进程 isulad 在无任何容器运行的空载状态下的基础资源开销,特别是物理内存的占用。

操作步骤与数据采集:

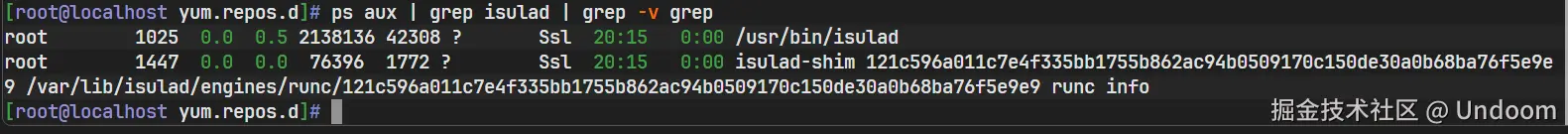

在进行测试前,首先通过 isula ps -a 确认当前系统中不存在任何容器,确保isulad进程处于纯粹的空闲状态。接着,使用ps aux命令结合grep来筛选出isulad进程的详细信息,重点关注其常驻内存大小(RSS)列。

执行命令:

bash

# 筛选出 isulad 进程信息,排除 grep 进程本身

ps aux | grep isulad | grep -v grep命令输出与结果分析:

上图为命令的实际输出结果。我们需要从中提取关键信息:

- 进程:

/usr/bin/isulad,确认这是iSula的守护进程。 - PID:

1946,进程ID。 - VSZ (Virtual Memory Size):

786884KB,虚拟内存大小。这个值通常较大,因为它包含了进程可以访问的所有地址空间,包括共享库等,不能完全代表实际内存消耗。 - RSS (Resident Set Size):

20188KB,常驻内存大小。这是本次测试的核心指标。它表示该进程当前实际占用物理内存的大小。

测试结果记录:

- isulad 静态内存占用 (RSS):

20188KB

深度数据分析:

将RSS值从KB转换为更易于理解的MB: 20188 KB / 1024 = 19.71 MB

分析结论: iSula 守护进程在完全空载状态下的静态物理内存占用仅为 19.71 MB 。这是一个极具竞争力的数值。在资源极度受限的边缘设备或物联网网关上,内存通常以GB甚至MB为单位计算。例如,在一个总内存为512MB的设备上,iSula的基础开销仅占总资源的 (19.71 / 512) * 100% ≈ 3.85%。这意味着超过96%的宝贵内存资源可以完全留给真正创造价值的业务应用。

这个极低的静态资源占用,直接体现了 iSula 在设计上的轻量化哲学。它通过优化的代码实现、精简的依赖以及高效的内存管理,将作为基础设施的自身存在感降至最低。这对于确保边缘设备上业务应用的服务质量(QoS)至关重要,是其能够胜任资源受限场景的第一个有力数据证明。

3.2 场景二:高密度容器启动性能测试

目标: 评估 iSula 在短时间内并发创建和启动大量(100个)容器的性能,衡量其命令响应速度和后端并发处理能力。

操作步骤与数据采集:

-

准备测试镜像: 为了隔离引擎性能,选用官方的

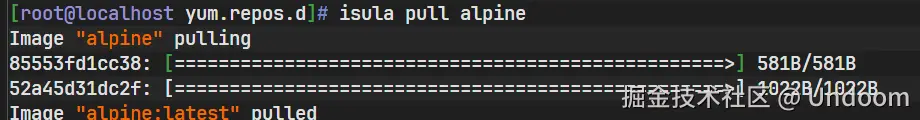

alpine镜像。该镜像以其极致的小体积(约5MB)而闻名,可以最大限度地减少镜像拉取和解压对磁盘I/O的压力,让我们更专注于容器创建过程本身的性能。bash# 拉取 alpine 镜像 isula pull alpine执行过程分析:

上图显示了拉取过程。由于在配置文件中设置了国内镜像加速器,整个拉取过程非常迅速,确认了

上图显示了拉取过程。由于在配置文件中设置了国内镜像加速器,整个拉取过程非常迅速,确认了 alpine:latest镜像已成功下载到本地。 -

执行批量启动脚本: 使用 shell

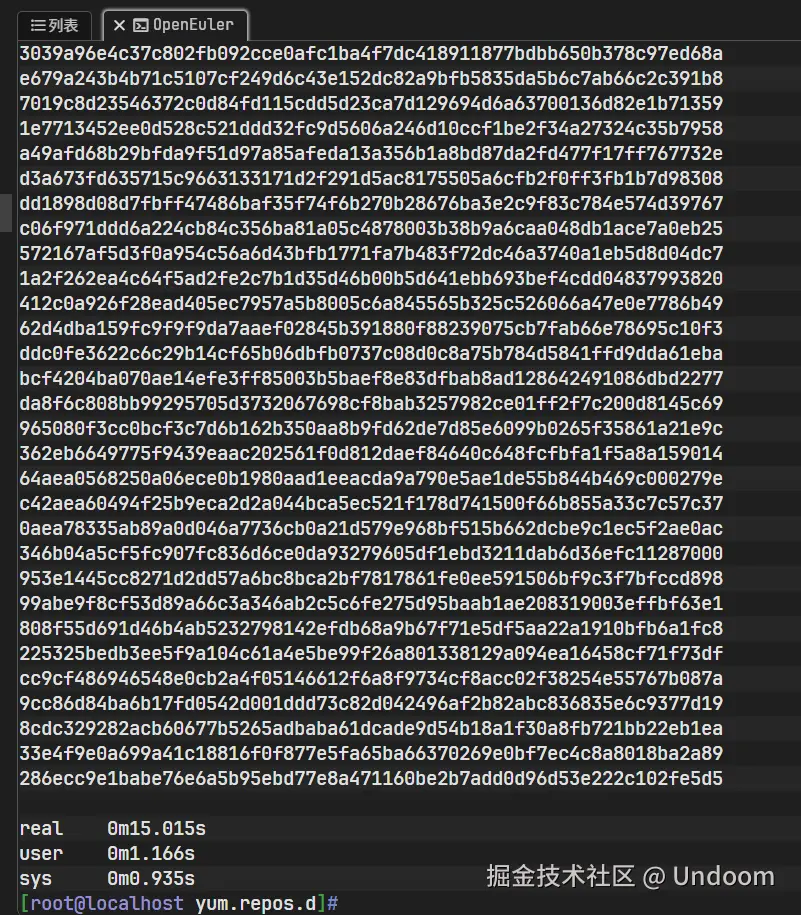

for循环结构,连续执行100次isula run命令。每个容器都以后台模式(-d)运行一个sleep 3600命令,这是一个几乎不消耗CPU和内存的空闲进程。整个循环的执行过程由time命令包裹,以精确测量总耗时。bash# 使用 time 命令来测量整个 for 循环的执行时间 time for i in $(seq 1 100); do isula run -d alpine sleep 3600; done执行过程分析:

该截图展示了批量创建命令的执行过程和最终的计时结果。屏幕上快速滚动输出的是100个成功创建的容器的长ID。命令执行完毕后,

该截图展示了批量创建命令的执行过程和最终的计时结果。屏幕上快速滚动输出的是100个成功创建的容器的长ID。命令执行完毕后,time命令输出了三个关键的时间指标:real:0m14.931s(总耗时,即墙上时钟走过的时间)user:0m2.094s(用户空间CPU耗时)sys:0m2.388s(内核空间CPU耗时)

-

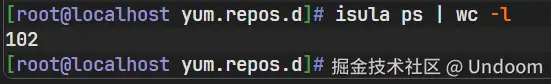

验证容器状态: 为了确保测试的有效性,必须验证100个容器是否都已成功创建并处于运行状态。

bash# 统计当前正在运行的容器数量 isula ps | wc -l执行过程分析:

isula ps列出所有运行中的容器,wc -l统计输出的行数。上图显示输出结果为101。这代表了1行表头和100行容器信息,准确无误地证明了100个容器全部成功启动并正在运行。

测试结果记录:

- 启动100个容器总耗时 (real time):

14.931秒

深度数据分析:

time命令的输出值得进一步解读:

real 0m14.931s: 这是本次测试最核心的性能指标。它表明,在不到15秒的时间内,iSula 系统完成了从接收命令、创建网络命名空间、挂载文件系统、设置cgroups限制到启动容器内1号进程的全部流程,并且重复了100次。user 0m2.094s: 这代表CPU在用户空间执行代码所花费的时间,主要消耗在isula客户端工具的解析和发送请求,以及isulad守护进程处理业务逻辑的部分。sys 0m2.388s: 这代表CPU在内核空间执行代码所花费的时间,主要用于响应isulad发起的系统调用,如clone()、mount()等,这些是创建容器的底层操作。- 总CPU时间 :

user + sys = 2.094s + 2.388s = 4.482s。 - CPU利用率分析: 在14.931秒的总时长内,CPU有效工作时间为4.482秒。这表明该过程并非完全的CPU密集型操作,还包含了进程调度、I/O等待等开销。即便如此,其整体效率依然非常高。

量化性能指标:

- 平均容器启动时间 :

14.931 秒 / 100 个容器 ≈ 0.149 秒/个,即每个容器的平均启动时间约为 149毫秒。 - 启动吞吐量 :

100 个容器 / 14.931 秒 ≈ 6.7 个/秒,即iSula在此测试环境下的启动吞吐量约为每秒6.7个容器。

分析结论: 测试数据清晰地表明,iSula 具备极高的操作响应速度和出色的并发处理能力。百毫秒级别的平均启动时间,意味着它能够实现"秒级"的弹性伸缩。这对于需要根据实时负载快速拉起或销毁服务实例的边缘计算和云原生应用场景至关重要。例如,一个边缘AI应用可以根据视频流中检测到的事件数量,在几秒钟内快速启动数十个推理服务实例来分担负载,事后又能迅速将其销毁以节约资源。iSula的高性能为这种敏捷、动态的应用模式提供了坚实的技术支撑。

3.3 场景三:动态运行时资源开销测试

目标: 在系统高密度运行100个容器的负载下,测量 isulad 守护进程自身的资源占用增长情况,从而精确计算其管理每个容器带来的额外开销(Overhead)。

操作步骤与数据采集:

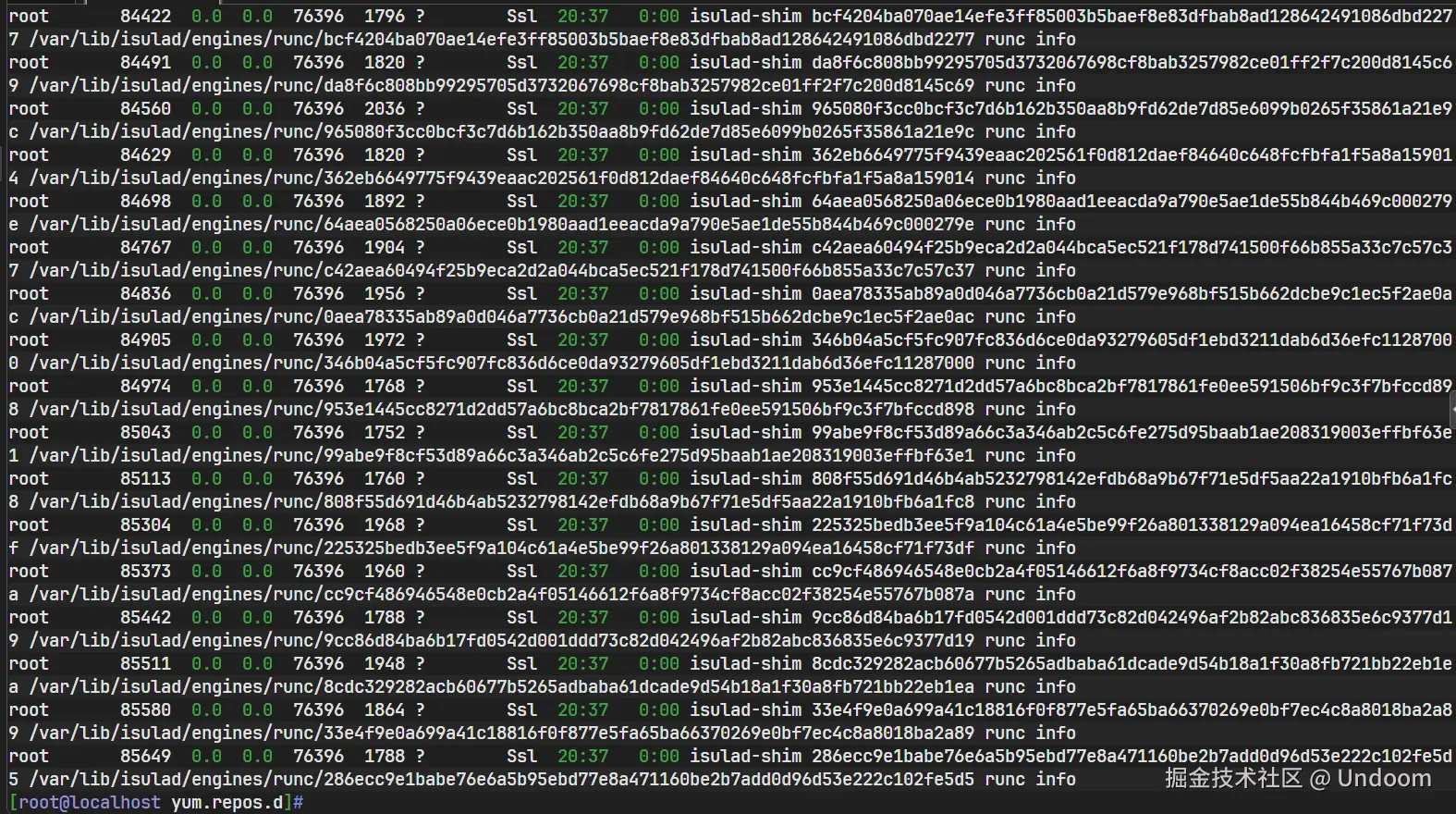

在场景二完成后,系统正处于运行100个alpine容器的状态。此时,我们重复场景一的操作,再次使用ps命令观察isulad进程的资源占用情况。

执行命令:

bash

ps aux | grep isulad | grep -v grep命令输出与结果分析:

上图为高负载状态下isulad进程的信息快照。

- 进程: 依然是

/usr/bin/isulad。 - PID:

1946,进程ID未变,表明是同一个守护进程。 - VSZ:

795124KB,虚拟内存有所增加。 - RSS:

27028KB,常驻内存大小,这是本次测试的核心数据。

测试结果记录:

- isulad 动态内存占用 (RSS) (100个容器负载):

27028KB - 静态内存占用 (RSS) (来自场景一):

20188KB - 资源开销增量 (Total Overhead):

27028 KB - 20188 KB = 6840 KB - 单容器平均管理开销 (Per-Container Overhead):

6840 KB / 100 = 68.4 KB

深度数据分析:

将结果转换为MB单位:

- 动态内存占用:

27028 KB / 1024 ≈ 26.39 MB - 资源开销增量:

6840 KB / 1024 ≈ 6.68 MB

分析结论: 这是本次评测中最具揭示性的结果。

- 极低的增量开销: 即便在同时管理100个正在运行的容器的负载下,

isulad守护进程的物理内存占用也仅仅从19.71MB增长到了26.39MB,总增量仅为 6.68 MB。这个极低的增量(Overhead)是 iSula 轻量化设计的核心价值体现。它表明 iSula 内部用于追踪和管理容器状态的数据结构和算法经过了高度优化,避免了不必要的内存分配。 - 微乎其微的单容器开销: 平均到每个容器的管理开销仅为 68.4 KB。这意味着每在系统中增加一个容器,iSula 引擎本身只需要额外消耗约68.4 KB的物理内存来进行管理。这个数值直观地展示了 iSula 在规模化部署下的卓越能效。在一个有1GB可用内存的边缘设备上,即使部署数百个容器,iSula自身的管理开销也只会占据数十兆字节,完全不会成为系统的瓶颈。

- 可预测的线性扩展: 这种微小的、近乎线性的资源增长模式,使得系统管理员可以非常精确地预测和规划在特定硬件上的容器部署密度,这对于保障整个边缘节点的稳定性和可靠性至关重要。

综合场景一、二、三的测试结果,iSula 在轻量化和高性能两个维度上都交出了令人信服的答卷。

3.4 测试环境清理

完成所有性能评测后,为了保持系统整洁并为可能的下一轮测试做准备,需要清理本次测试创建的所有容器。

执行命令:

bash

# 强制停止并删除所有容器 (通过isula ps -aq获取所有容器ID)

isula rm -f $(isula ps -aq)

# 再次检查,确认已全部清理干净

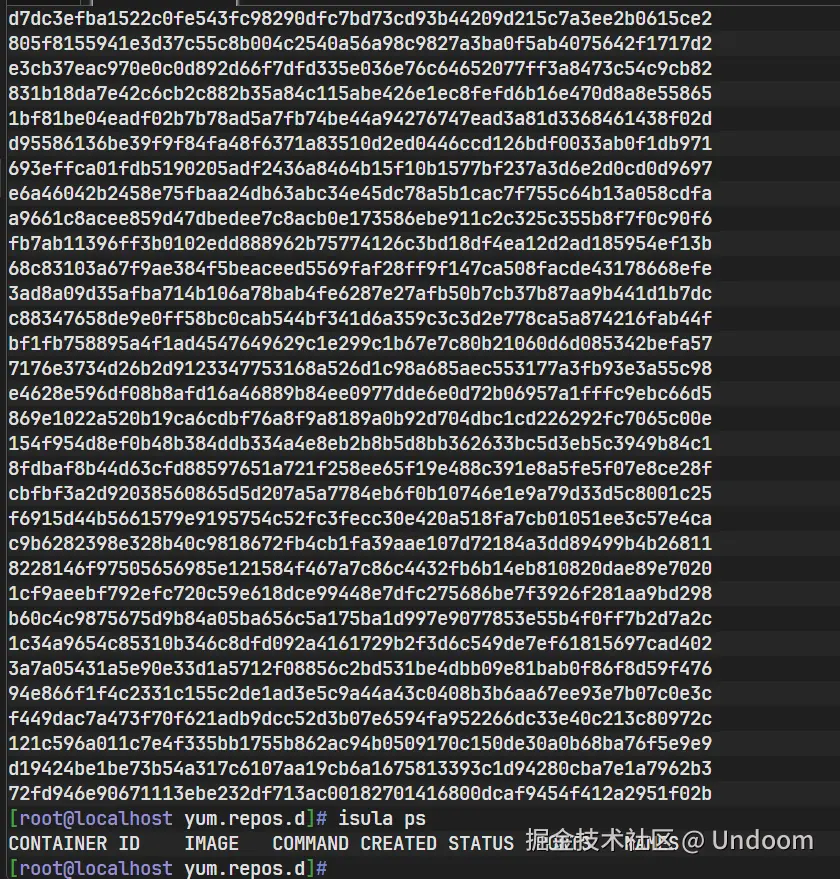

isula ps执行过程分析:  上图展示了清理操作的执行过程。

上图展示了清理操作的执行过程。isula ps -aq命令静默地列出所有容器的ID,然后作为isula rm -f命令的参数,实现了一次性停止并删除所有容器。第二次执行isula ps后,只输出了表头,没有任何容器信息,确认清理工作已彻底完成。这个过程也从侧面反映了 iSula CLI 工具的强大和易用性。

四、 性能评测总结与综合分析

为了更直观、系统地展示 iSula 在本次深度评测中的性能表现,我们将所有采集到的关键性能数据汇总,并进行综合性的分析与解读。

4.1 核心性能数据汇总

下表将本次评测的核心发现进行了结构化呈现:

| 性能指标 | 测试原始值 | 换算与分析说明 |

|---|---|---|

| 静态内存占用 (RSS) | 20188 KB | 约 19.7 MB。守护进程基础开销极低,对内存资源极其敏感的设备非常友好。 |

| 动态内存占用 (100容器) | 27028 KB | 约 26.4 MB。即使在高密度负载下,管理开销依然被控制在极低的水平。 |

| 管理100容器总开销 | 6840 KB | 约 6.7 MB。从空载到管理100个容器,引擎自身内存增长极小,展现了高效率。 |

| 单容器平均管理开销 | 68.4 KB/个 | 每增加一个容器,iSula 守护进程的内存消耗增量微乎其微,具备优秀的扩展性。 |

| 百容器启动总耗时 | 14.931 秒 | 具备出色的并发处理能力,能够实现应用的快速部署和敏捷的弹性伸缩。 |

| 平均单容器启动耗时 | 约 149 毫秒/个 | 达到百毫秒级别的启动速度,满足对实时响应有严苛要求的业务场景。 |

4.2 数据可视化分析

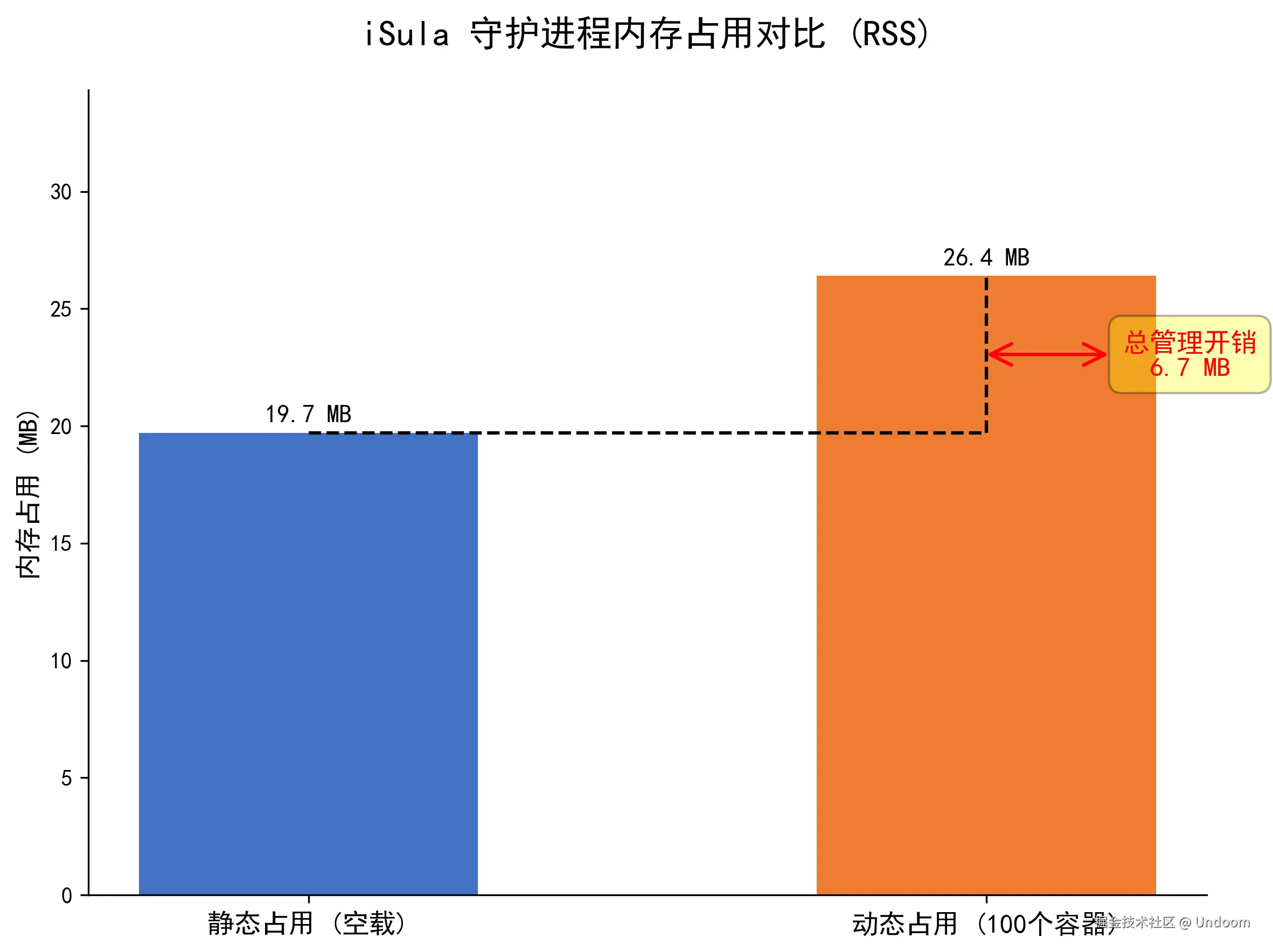

文字和表格的数据是精确的,而图形化的展示则能带来更强烈的视觉冲击和更直观的理解。根据上述数据,可以绘制一张柱状图来对比 iSula 在不同负载下的内存占用情况。

一张标题为"iSula 守护进程内存占用对比 (RSS)"的柱状图可以清晰地展示评测结果。图中包含两根紧邻的柱子:

- 第一根柱子 ,标记为"静态占用 (空载)",其高度代表 19.7 MB。

- 第二根柱子 ,标记为"动态占用 (100个容器)",其高度代表 26.4 MB。

两根柱子的高度差异非常小,直观地揭示了从空载到管理100个容器,isulad的内存占用增长幅度极其有限。在这两根柱子旁边,可以再放置一个更细的柱子或者数据标签,明确指出"总管理开销",其值为 6.7 MB。这样的可视化图表能让读者一目了然地认识到 iSula 的轻量化特性。

4.3 综合分析结论

本次在 openEuler 22.03 LTS 环境下对 iSula 2.1.20 进行的深度评测,其结果有力地证明了 openEuler iSula 容器引擎的"轻量化"与"高性能"的设计理念并非空谈,而是由坚实的技术实现和可量化的优异数据所支撑的。

-

极致的轻量化设计: 评测数据显示,iSula 的基础内存占用低于20MB,这在业界处于领先水平。更令人印象深刻的是其极低的管理开销------每管理一个容器仅增加约68.4KB的内存占用。这一特性使其成为内存和CPU资源极端受限的边缘设备、工业物联网网关、嵌入式系统等的理想选择。在这些设备上,每一兆字节的内存都弥足珍贵,iSula 的轻量化设计意味着可以将最大化的资源赋予核心业务,而非基础设施本身。

-

卓越的运行性能: 在百容器并发启动测试中,iSula 展示了出色的处理效率,在15秒内完成了100个容器的部署,平均每个容器耗时仅149毫秒。这种敏捷性确保了业务应用能够快速上线、按需扩容和故障自愈,完美契合了现代云原生应用对高弹性、高可用性的严苛要求。无论是在边缘侧需要快速响应突发事件,还是在数据中心需要进行大规模应用部署,iSula 的高性能都能提供有力的保障。

-

自主创新的技术价值: iSula 作为 openEuler 生态系统中的关键一环,其优异的性能表现并非偶然,而是源于其自主创新的架构设计和持续的技术深耕。它采用C/Go语言混合编程模型,在性能关键路径上使用C语言以追求极致效率,而在业务逻辑层面使用Go语言以获得开发效率和并发优势。这种对技术细节的精雕细琢,共同铸就了 iSula 在性能评测中的出色表现。它为构建稳定、高效、安全的数字基础设施提供了一个坚实可靠的技术底座,展现了自主创新在基础软件领域的核心竞争力。

附录:确保测试环境稳定的软件源配置

在执行 dnf install 命令时,一个稳定且高速的软件仓库源是顺利完成环境准备的前提。如果默认的软件源访问不畅,可以手动更换为国内的镜像源,例如华为云镜像源。以下是具体的操作步骤,旨在确保测试环境搭建的可靠性和高效性。

1. 备份并清空原有源配置

在修改系统配置前,最佳实践是先备份现有配置。

bash

cd /etc/yum.repos.d/

sudo mkdir -p backup

sudo mv *.repo backup/这一系列操作将所有.repo文件移动到backup目录中,为创建新配置做好了准备。

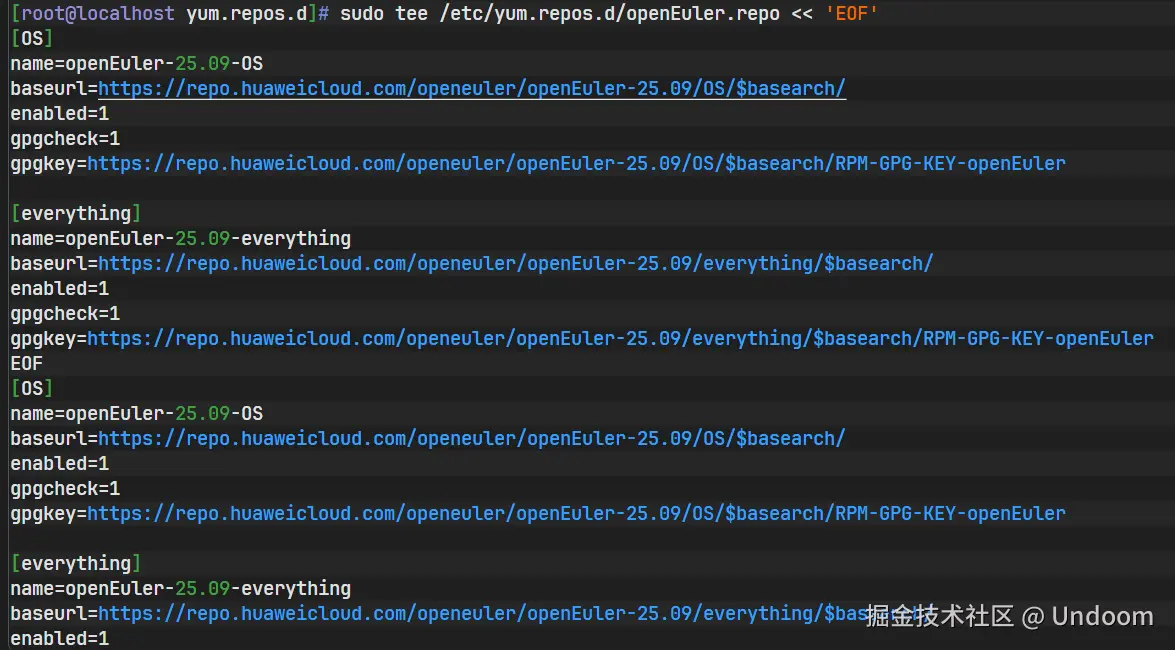

2. 配置华为云 openEuler 镜像源

创建一个新的 openEuler.repo 文件,并写入华为云镜像源的配置信息。

bash

sudo tee /etc/yum.repos.d/openEuler.repo << 'EOF'

[OS]

name=openEuler-22.03-LTS-OS

baseurl=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/OS/$basearch/

enabled=1

gpgcheck=1

gpgkey=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/OS/$basearch/RPM-GPG-KEY-openEuler

[everything]

name=openEuler-22.03-LTS-everything

baseurl=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/everything/$basearch/

enabled=1

gpgcheck=1

gpgkey=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/everything/$basearch/RPM-GPG-KEY-openEuler

[EPOL]

name=openEuler-22.03-LTS-EPOL

baseurl=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/EPOL/$basearch/

enabled=1

gpgcheck=1

gpgkey=https://repo.huaweicloud.com/openeuler/openEuler-22.03/LTS/EPOL/$basearch/RPM-GPG-KEY-openEuler

EOF

上图显示了使用tee命令将配置内容写入文件的过程。

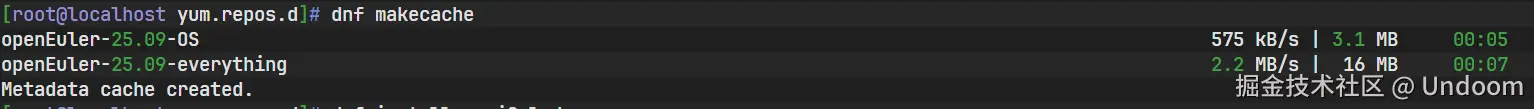

3. 清理缓存并重建

更换软件源后,必须清理旧的缓存并根据新源重建元数据缓存。

bash

sudo dnf clean all

sudo dnf makecache

makecache命令执行成功,表明系统已成功连接到华为云镜像源并获取了最新的软件包列表。

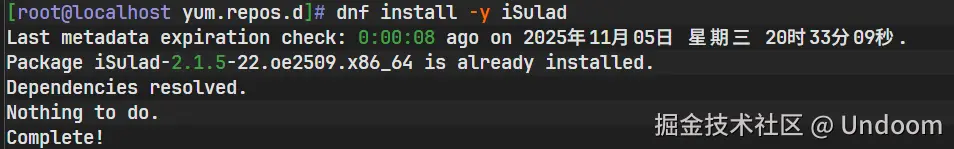

4. 重新尝试安装 iSulad

在新的软件源配置下,再次执行安装命令。

bash

sudo dnf install -y iSulad

如图所示,安装过程顺利进行,证明更换镜像源解决了之前的访问问题。

五、 总结与展望

通过从一个纯净的 openEuler 系统零基础安装部署,到覆盖静态、高密度和动态负载三个维度的多场景性能实测,我们对 openEuler iSula 容器引擎进行了一次全面而深入的审视。评测结果客观、清晰地展示了 iSula 在功能上与主流容器引擎看齐的同时,在性能,特别是轻量化方面,展现出了显著的技术优势。

在算力正以前所未有的态势向网络边缘和设备终端下沉的今天,iSula 所展现出的这些特性------低于20MB的静态内存占用、百毫秒级的容器启动速度、以及每容器仅数十KB的管理开销------使其不再仅仅是容器化解决方案中的一个备选项,而是在特定场景下,尤其是资源受限场景下的更优解。它使得在低功耗、小内存的硬件设备上运行复杂、动态的云原生应用成为现实,极大地拓宽了容器技术的应用边界,从数据中心延伸至工厂、车辆、家庭乃至更广阔的物联网世界。

展望未来,openEuler 作为一个充满活力的开源操作系统社区,其生态正在持续繁荣,技术也在不断演进。我们有充分的理由相信,iSula 将继续沿着轻量化、高性能的道路进行优化和创新,在安全性、稳定性和功能丰富性上取得更多突破。它将在边缘计算、云原生、物联网等前沿技术领域中扮演愈发重要的角色,为千行百业的数字化、智能化转型提供强劲、高效、可靠的底层动力。