仅供学习示意,侵权联系删除

数字孪生可视化+AI,地理场景?多模态数据处理

人智融合数据洞察:大模型驱动的可视分析与叙事新范式

引言:打破传统可视分析的"效率瓶颈"与"技能门槛"

数据可视化是连接数据与用户的"最后一公里",但传统可视分析面临两大核心痛点:一是制作成本高,一个专业可视分析系统至少需要200人时搭建;二是灵活性差,仅支持固定数据与预设场景,无法响应实时分析需求;三是技能门槛高,普通用户缺乏可视分析知识与实现能力,难以自主挖掘数据洞察。

复旦大学陈思明团队(FDU-VIS实验室)聚焦"人智融合",提出大模型驱动的智能可视分析方案------通过AI Agent自动完成任务规划、可视化生成、交互辅助,同时实现数据叙事的智能化升级,让"零代码数据分析""数据故事自动生成"成为现实,彻底重构可视分析与数据叙事的生产范式。

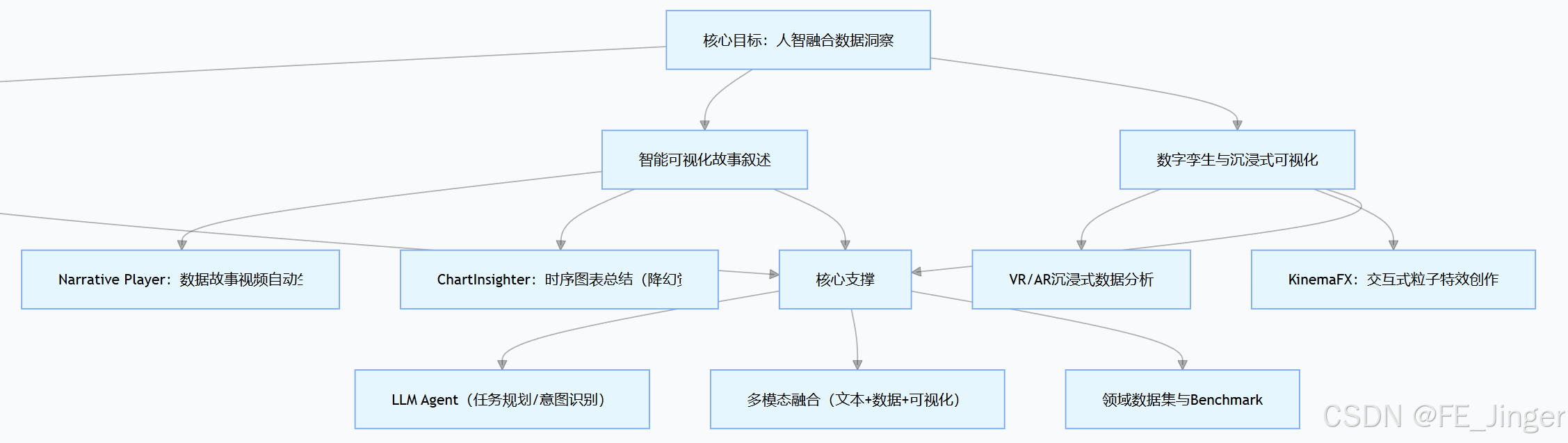

一、核心架构:三大研究方向构建人智融合数据洞察体系

团队的研究围绕"高效分析+生动叙事+沉浸体验"展开,形成三大核心方向,各方向相互支撑,覆盖从数据处理到洞察传递的全链路:

核心逻辑:以LLM Agent为大脑 ,负责任务分解、意图识别、流程规划;以可视化生成与交互为核心 ,实现数据到洞察的高效转化;以多模态叙事为载体,让数据洞察更生动易懂;最终达成"AI负责执行与规划,人类负责监督与完善"的人智协同模式。

二、深度解析:三大核心方向的技术突破

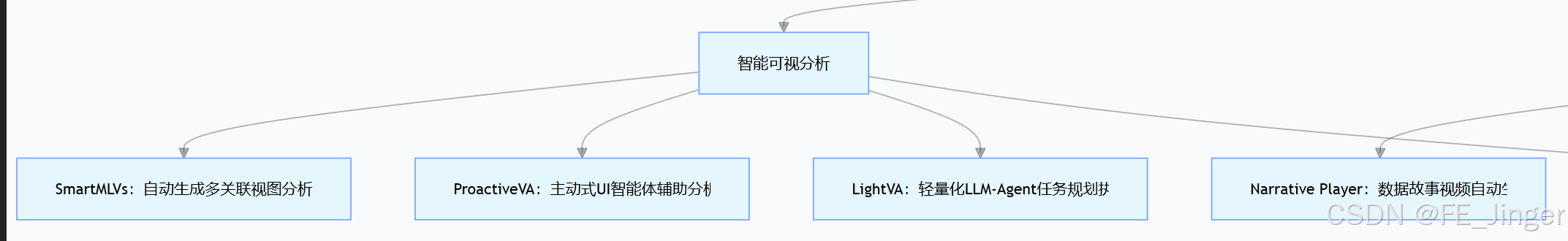

1. 智能可视分析:让AI成为"数据分析助手",自动生成+主动辅助

核心目标是"降低分析门槛,提升分析效率",通过AI Agent替代繁琐的手工操作,同时主动感知用户需求提供辅助,覆盖从"被动响应"到"主动服务"的升级。

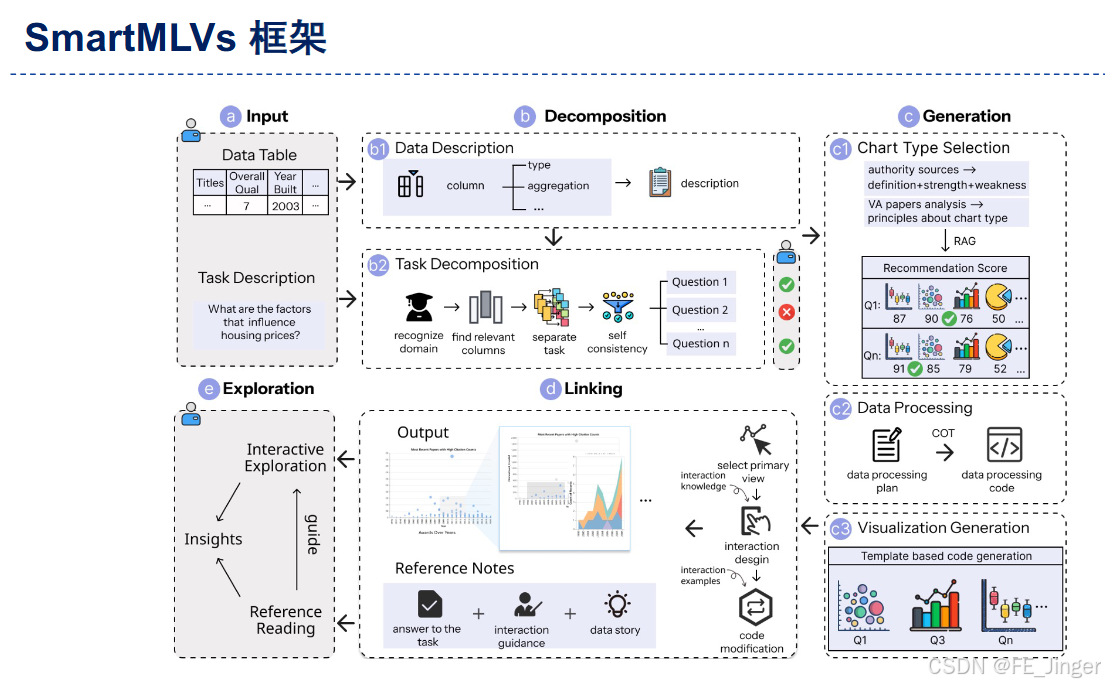

(1)SmartMLVs:自动生成多关联视图分析系统

针对"用户需零代码构建可视分析系统"的需求,SmartMLVs通过"任务分解-可视化选择-代码生成-交互设计"的全流程自动化,实现多关联视图的智能生成:

- 输入:数据表格+分析目标(如"分析房价影响因素""评估城市风险事件");

- 核心流程:

- 任务分解:LLM将总目标拆分为可执行的子任务(如"筛选关键特征""生成趋势图");

- 可视化推荐:基于领域知识(如"趋势用折线图""对比用柱状图")选择适配图表类型;

- 代码生成:模板化生成可视化代码,组合成多关联视图的分析系统;

- 交互优化:自动设计视图联动逻辑(如点击地图筛选图表数据)。

- 实践成效:曾获IEEE PacificVis 2025最佳论文提名,可覆盖社交媒体事件分析、学术数据挖掘等多场景。

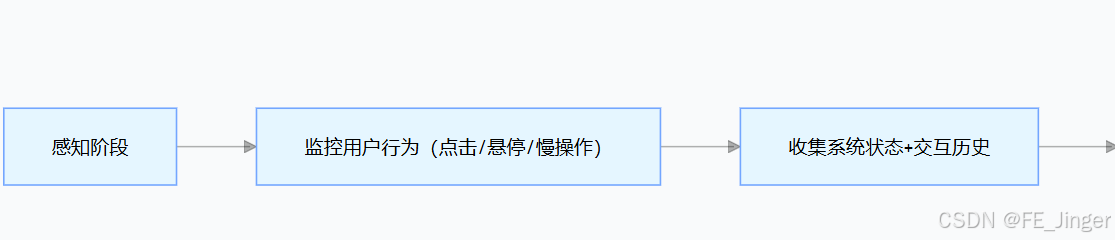

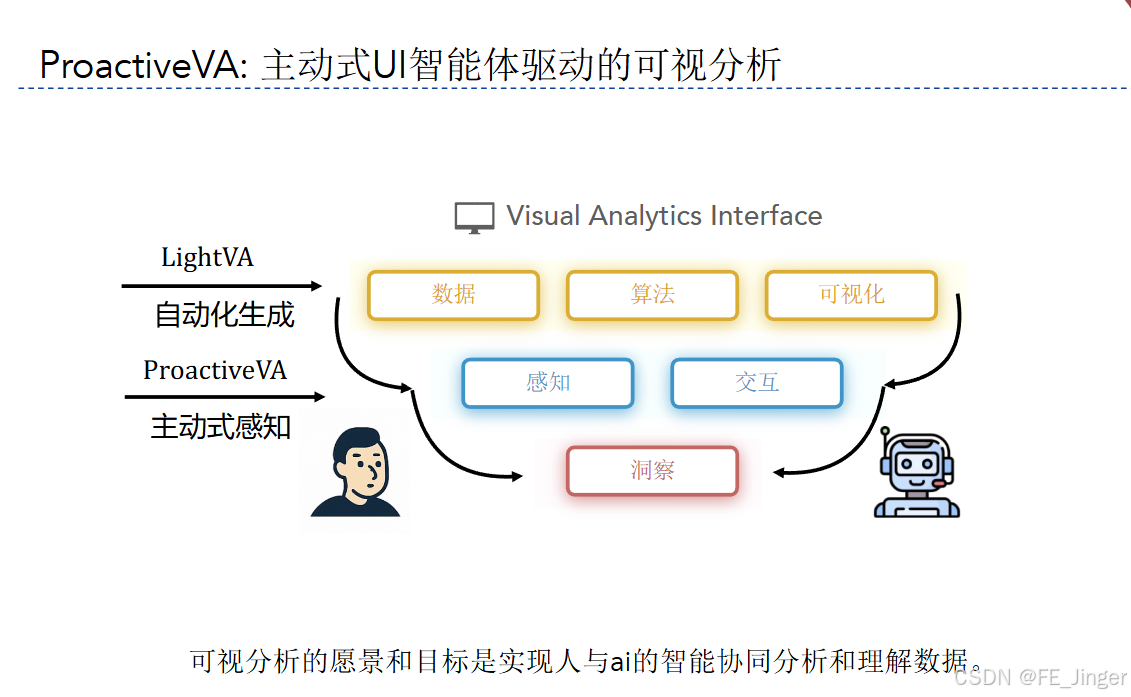

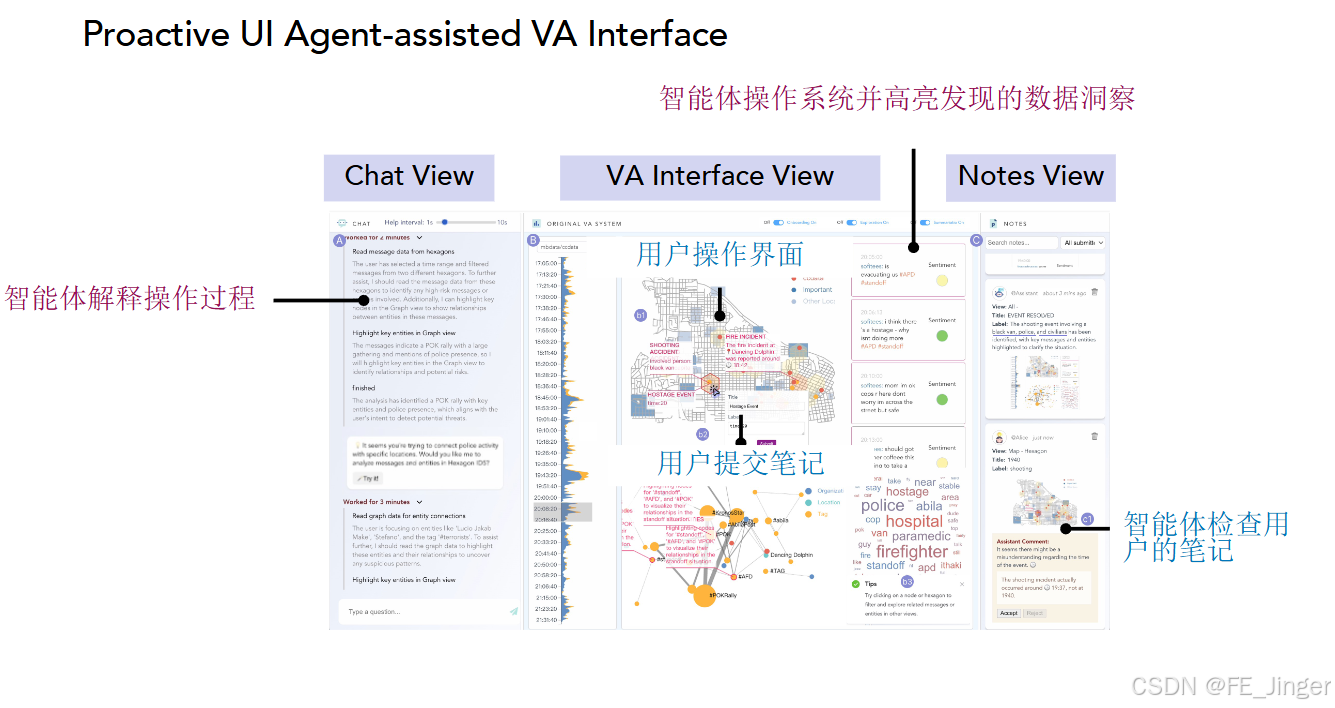

(2)ProactiveVA:主动式UI智能体,读懂用户"困惑"

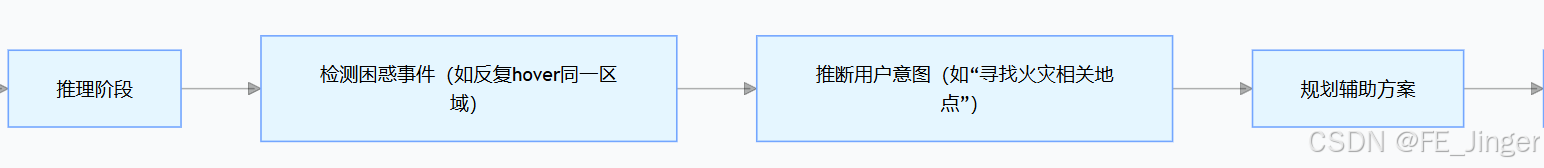

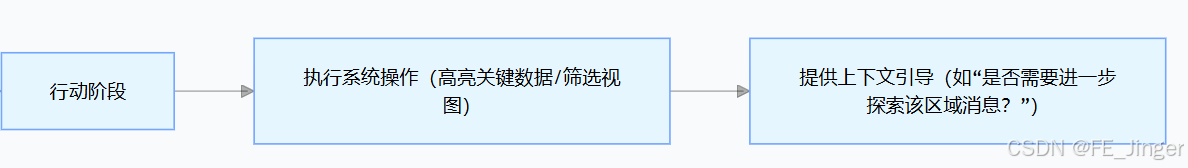

突破传统分析系统"被动响应"的局限,ProactiveVA通过"感知-推理-行动"闭环,主动为用户提供分析辅助:

- 核心亮点:非侵入式辅助,不打扰用户操作;基于LLM自主判断"何时帮、怎么帮",而非依赖预设规则;

- 典型场景:在社交媒体风险事件分析中,用户反复查看某区域数据时,Agent自动高亮该区域的高风险事件与关联消息,辅助快速定位洞察。

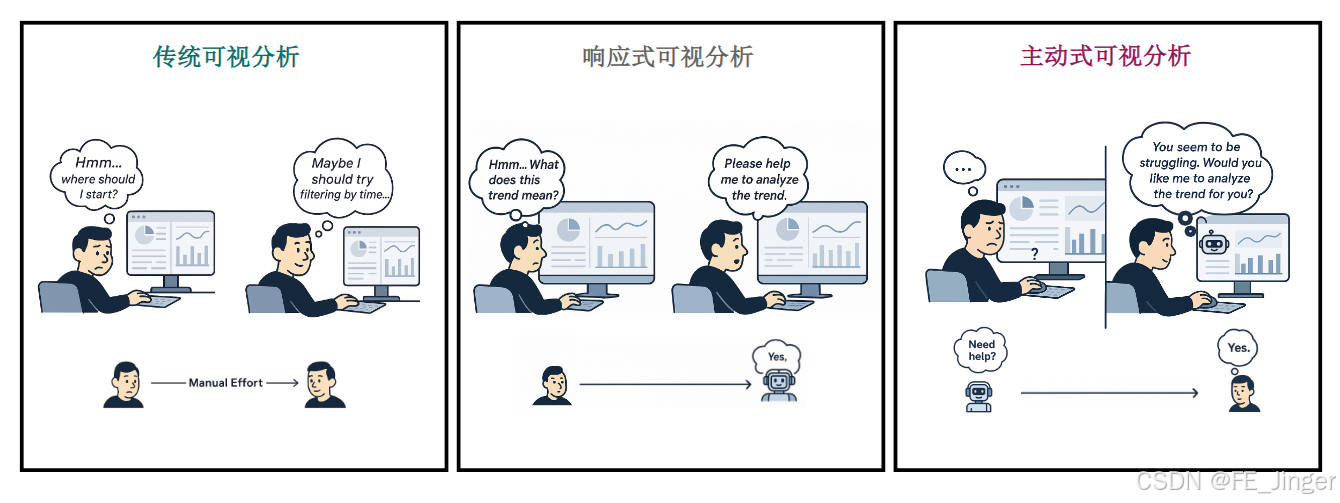

(3)三大可视分析范式对比

| 范式 | 核心特点 | 用户体验 | 适用场景 |

|---|---|---|---|

| 传统可视分析 | 手工搭建视图,手动探索 | "不知道从哪开始" | 专业分析师场景 |

| 响应式可视分析 | 用户主动提问,AI响应 | "需要主动求助" | 有明确分析目标场景 |

| 主动式可视分析(ProactiveVA) | AI主动感知需求,辅助探索 | "AI懂我,主动帮忙" | 无明确目标的探索性分析 |

2. 智能可视化故事叙述:让数据"会讲故事",文本+数据→动态叙事

核心目标是"让数据洞察高效传递",通过大模型将"文本+数据"转化为动态可视化故事(视频/交互式叙事),解决传统数据文档"枯燥难懂""洞察隐藏"的问题。

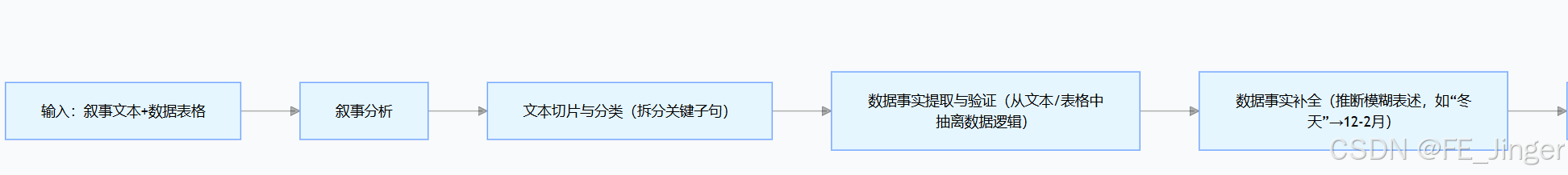

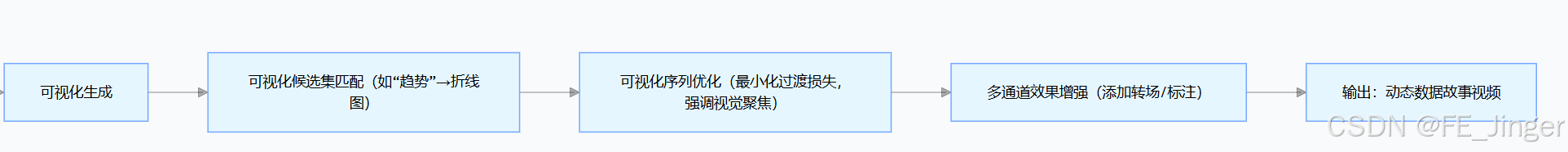

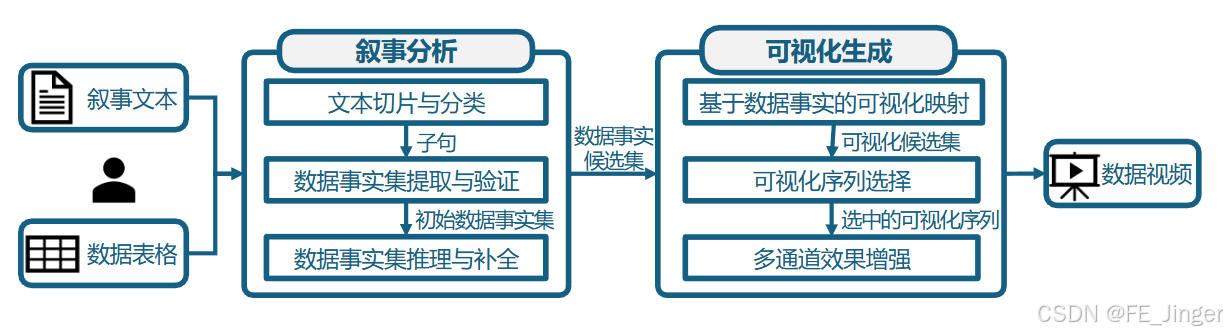

(1)Narrative Player:数据故事视频自动生成

只需输入"叙事文本+数据表格",即可自动生成带可视化的动态数据视频,让抽象数据变得生动:

- 典型案例:输入肇庆气候的叙事文本("5-8月最热,5-6月降雨超250mm")+ 月度气候数据表格,系统自动生成动态视频------用折线图展示气温变化,柱状图呈现降雨量,配合文本旁白,生动呈现"气候交响曲"。

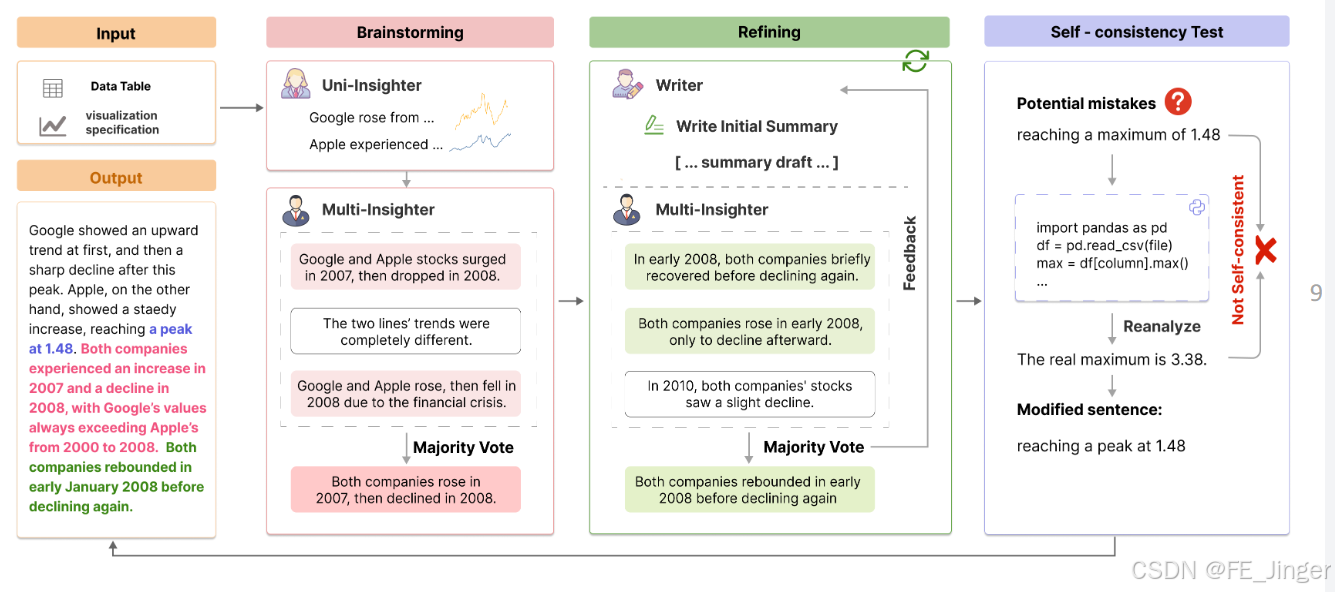

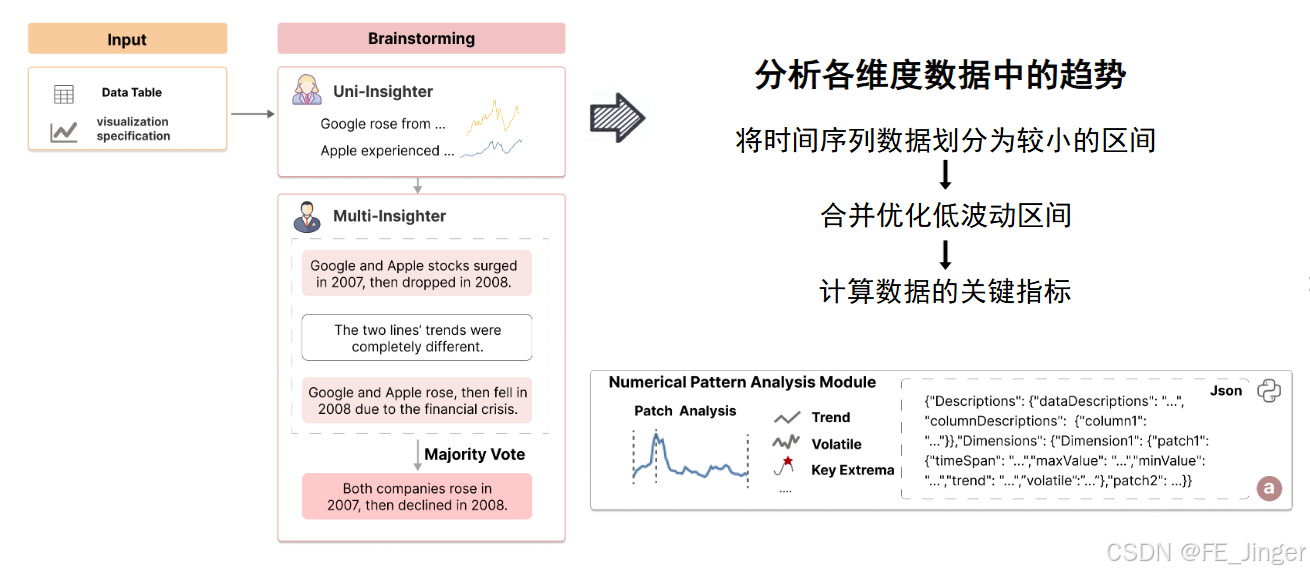

(2)ChartInsighter:时序图表总结(精准降幻觉)

针对大模型生成图表总结时"幻觉率高"的痛点,ChartInsighter通过"多轮校验"实现高精度时序图表总结:

- 核心流程:

- 头脑风暴:多LLM生成初始总结草稿;

- 精炼优化:基于数据表格验证数值、趋势的准确性(如修正"峰值1.48"为真实值"3.38");

- 自一致性测试:通过代码查询原始数据,排除幻觉表述;

- 输出总结:包含图表类型、关键极值、趋势关系、多维关联等多层语义。

- 实践成效:在Benchmark测试中,语义丰富度(3.79)远超GPT-4(2.86),幻觉率仅0.14(GPT-4为0.48),精准度大幅提升。

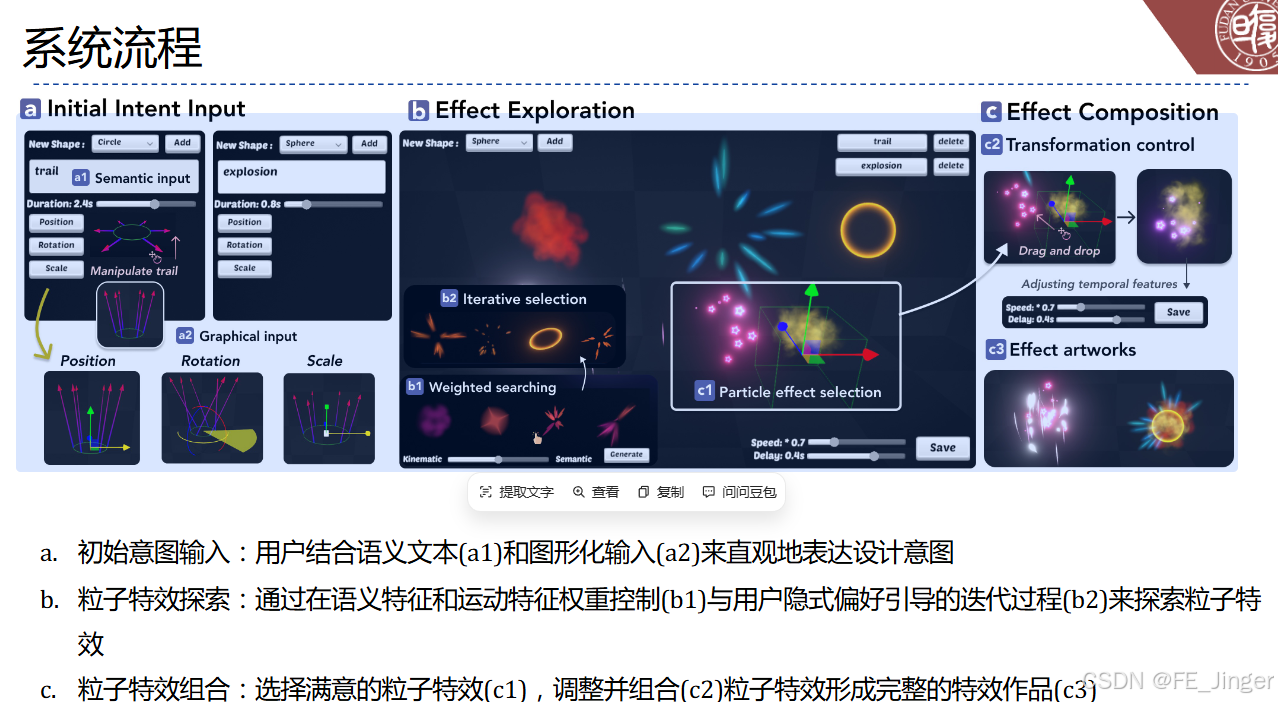

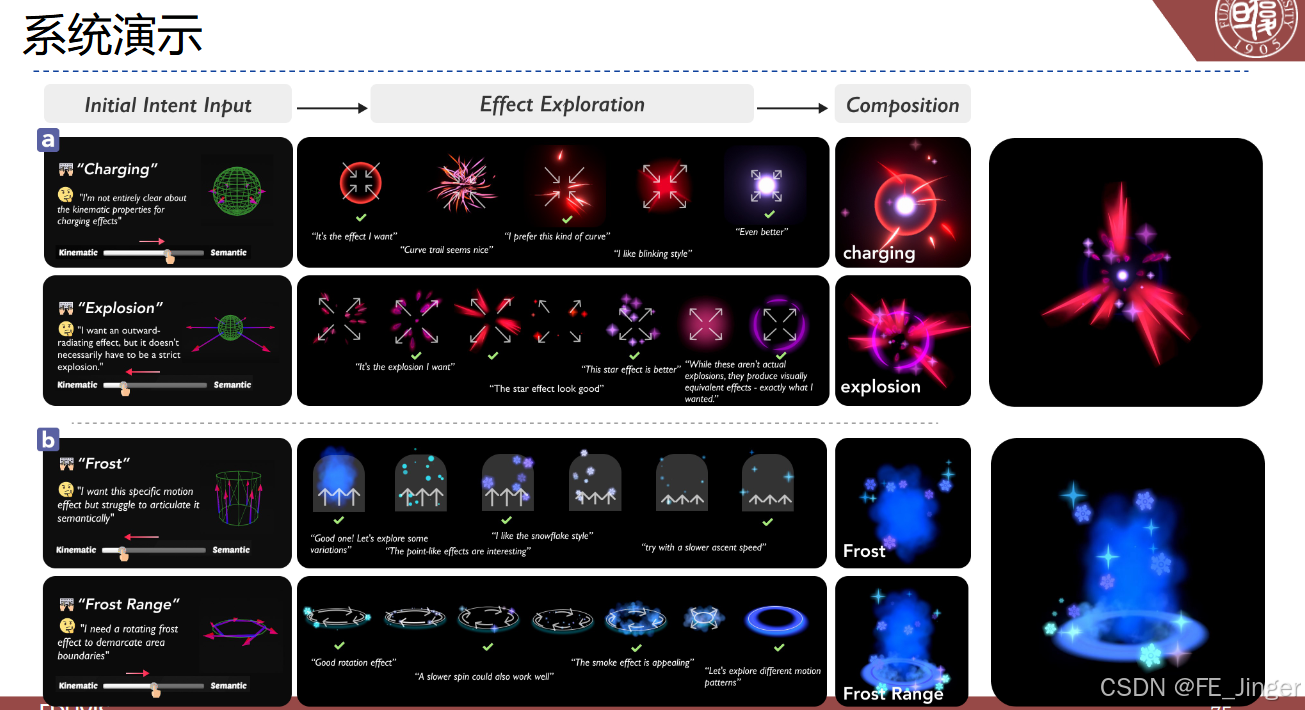

3. 数字孪生与沉浸式可视化:让分析"身临其境"

核心目标是"增强数据感知体验",结合VR/AR、粒子特效等技术,打造沉浸式分析环境,适用于复杂场景(如城市大数据、自动驾驶):

- KinemaFX:交互式粒子特效创作系统,用户通过"语义文本+图形化输入"(如"爆炸效果""旋转 frost 特效"),即可生成定制化粒子特效,用于增强可视化场景的氛围感;

- VR网球直播可视化:将球员运动轨迹、击球速度等数据嵌入VR直播画面,让观众直观感受比赛节奏;

- 数字孪生城市:将时空城市大数据与3D场景结合,支持沉浸式探索城市交通、环境等数据规律。

三、实践成效:数据见证技术价值

团队的方案已通过多个国际顶级会议(IEEE VIS、PacificVis、UIST)验证,核心成效如下:

- 效率提升:可视分析系统搭建时间从"200人时"缩短至"小时级",图表总结生成时间从"人工1小时"缩短至"分钟级";

- 效果优化:ChartInsighter的语义丰富度、幻觉控制精度均超越GPT-4等主流大模型,ProactiveVA在用户实验中获得85%的满意度;

- 场景覆盖:已落地社交媒体风险分析、销售数据洞察、气候数据叙事、VR体育直播等多个场景,获IEEE VAST Challenge一等奖等多项国际奖项。

四、总结与展望:人智融合是可视分析的未来

复旦大学陈思明团队的研究,本质上是通过"大模型+可视分析"的融合,重新定义了"人与数据的交互方式"------从"人适应系统"到"系统适应人",从"被动看数据"到"主动获洞察",从"枯燥读数据"到"沉浸听故事"。

未来,这套体系将向三个方向深化:

- 更深度的人智协同:AI不仅能生成分析系统与叙事,还能参与决策过程,提供可解释的建议;

- 多场景适配:拓展至金融科技、自动驾驶、人文历史等更多领域,形成领域专属的分析与叙事模板;

- 更自然的交互体验:结合语音、手势等多模态输入,让用户"用自然语言指挥,用直觉探索",彻底打破技术门槛。

在大模型的加持下,可视分析不再是专业分析师的"专属技能",而是人人都能掌握的"数据洞察工具";数据叙事也不再是设计师的"手工创作",而是AI辅助下的"高效创新"。人智融合,正在让数据洞察变得更高效、更生动、更普惠。

要不要我帮你生成一份Narrative Player数据故事视频的快速上手教程,包含输入示例、参数配置和效果演示,方便你直接体验数据叙事的智能化生成?