01 背景介绍

网络自动化平台下的监控中心模块,依赖MySQL数据库进行数据存储,随着业务规模扩展及数据量激增,原有的几个子模块,如服务监控、监控规则和扫描记录的增删改查操作,暴露出以下关键问题:

-

概率性异常:高并发场景下偶现数据不一致

-

事务边界模糊:跨操作事务管理复杂易错

-

容错机制缺失:错误场景缺乏自动恢复能力

-

配置文件同步风险:动态更新时存在竞态条件

使用语言:Go语言,主要用在代码补全功能、配合使用的模型为7B

本文档聚焦网络自动化平台下的监控中心,通过AI辅助生成的典型代码案例,针对其核心子模块------服务监控模块、监控规则模块和扫描记录模块,在高并发场景下的增删改查操作进行了专项优化,系统化展示如何利用现代框架特性(GORM/Viper)结合事务管理、原子操作等机制,构建高可靠的数据库操作体系。

02 核心解决方案与AI生成案例

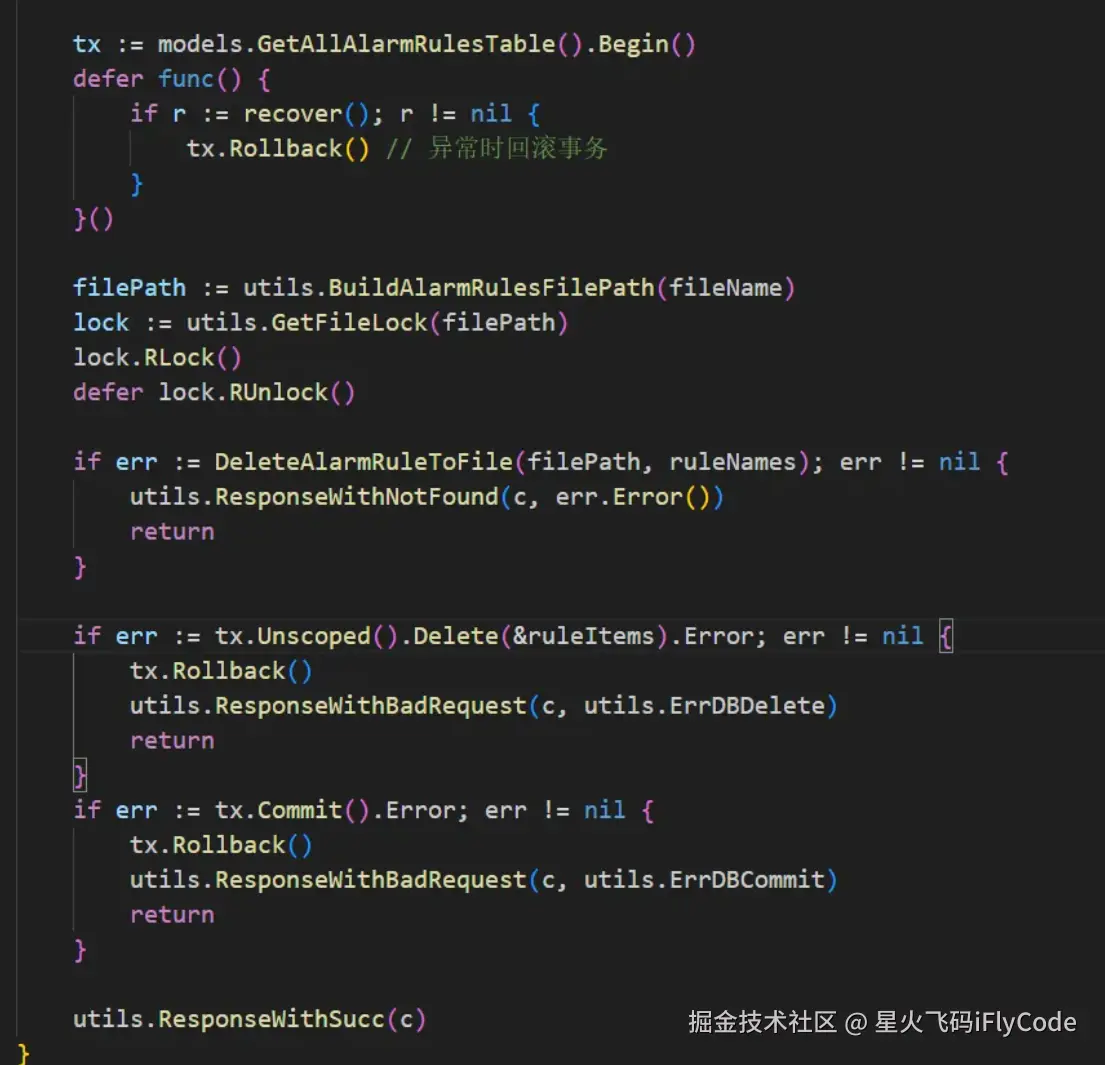

案例1:监控规则删除

------ 事务化物理删除(解决脏写问题)

操作步骤:利用智能对话功能,输入提示词后,让大模型输出高质量代码

- 输入提示词至AI工具:

- "使用GORM编写一个事务函数,删除ID=5的MonitorRulesItem记录,要求包含错误处理、物理删除,并适配现有项目结构"

- AI生成基础代码后,改写适配实际项目。

AI生成****代码:

lua

func DeleteItemByID(db *gorm.DB, id uint) error { // 开启事务 tx := db.Begin() defer func() { if r := recover(); r != nil { tx.Rollback() // 异常时回滚 panic(r) // 重新抛出panic供上层捕获 } }() // 执行物理删除(绕过软删除) if err := tx.Unscoped().Delete(&models.MonitorRulesItem{}, id).Error; err != nil { tx.Rollback() // 删除失败时回滚 return fmt.Errorf("delete failed: %w", err) } // 提交事务 if err := tx.Commit().Error; err != nil { return fmt.Errorf("commit failed: %w", err) } return nil}基础代码实现了用事务包裹删除操作,且通过Unscoped()直接永久删除数据库记录,事务处理逻辑与GORM官方文档一致,因此可直接复用,通过智能对话方式实现代码补全的内容,采纳率达80%以上。

以下为是适配实际代码的结果:

案例2:服务监控同步

------ 事务化批量操作

操作步骤:利用智能对话功能,输入提示词后,让大模型输出高质量代码

- 输入提示词至AI工具:

- "创建事务函数,用于同步服务实例到数据库,要求包含完整的错误处理、自动回滚机制,并支持批量更新/插入操作。"

- AI生成基础代码后,改写适配实际项目。

AI生成****代码:

lua

package mainimport ( "fmt" "gorm.io/gorm" // 确保已安装 gorm.io/gorm v2+)type ServersItem struct { // 根据实际表结构定义字段(示例) ID uint `gorm:"primaryKey"` Name string IP string}func transactionalUpsert(db *gorm.DB, updates []ServersItem, creates []ServersItem) error { // 开启事务 tx := db.Begin() defer func() { if r := recover(); r != nil { tx.Rollback() panic(r) // 重新抛出异常供上层捕获 } else if tx.Error != nil { // 检测事务自身错误 tx.Rollback() } }() // 执行批量更新(仅当有更新项时) if len(updates) > 0 { if err := tx.Save(&updates).Error; err != nil { return fmt.Errorf("update failed: %w", err) } } // 执行批量插入(仅当有新建项时) if len(creates) > 0 { if err := tx.Create(&creates).Error; err != nil { return fmt.Errorf("insert failed: %w", err) } } // 提交事务 if err := tx.Commit().Error; err != nil { return fmt.Errorf("transaction commit failed: %w", err) } return nil}基础代码实现了用事务包裹操作,保证批量操作要么成功要么回退,逻辑清晰,因此直接采用上述代码对实际代码进行调整:通过智能对话方式实现代码补全的内容,采纳率达70%以上。

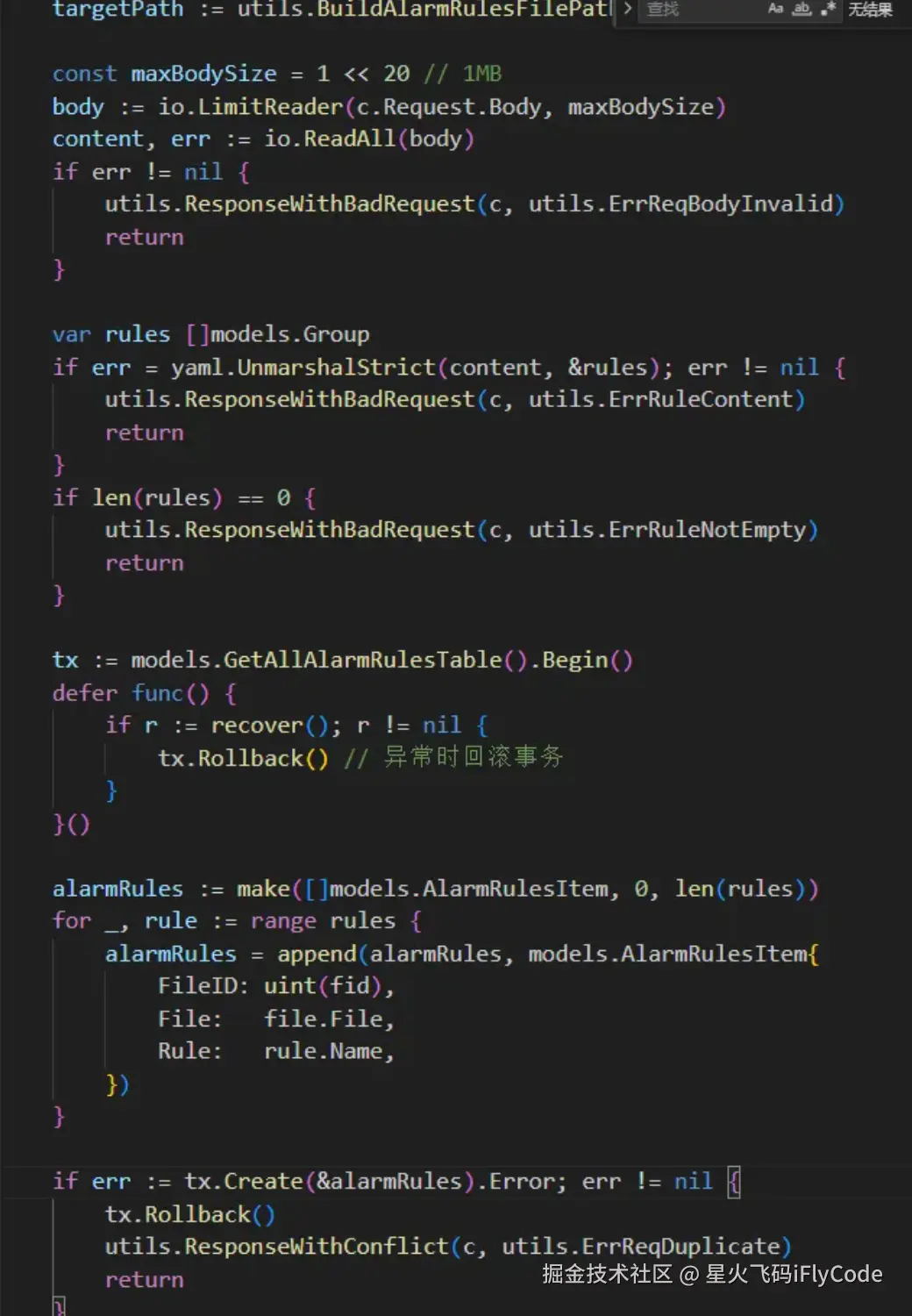

案例3:YAML文件解析与数据库写入

------ 事务化数据写入

操作步骤:选中部分代码后,利用智能对话功能,输入提示词后,让大模型输出高质量代码

-

选中代码

// 解析YAML文件并存入数据库content, err := os.ReadFile(yamlPath)if err != nil { ... }var data MyStructif err := yaml.Unmarshal(content, &data); err != nil { ... }db.Create(&Table1{ FileName: filepath.Base(yamlPath), Content: string(content),})

-

输入提示词至AI工具:

- "优化yaml文件解析过程,并将解析后的结果保存至数据库。要求用事务实现,具备回滚机制。"

- AI生成基础代码后,改写适配实际项目。

AI生成代码:

lua

func ImportYamlToDB(db *gorm.DB, yamlPath string) error { // AI 自动补充文件校验 info, err := os.Stat(yamlPath) if os.IsNotExist(err) { return fmt.Errorf("文件不存在: %s", yamlPath) } // 带缓冲的文件读取 content, err := ioutil.ReadAll(io.LimitReader(file, maxFileSize)) if err != nil { return fmt.Errorf("文件读取失败: %w", err) } // 严格模式解析 var data MyStruct if err := yaml.UnmarshalStrict(content, &data); err != nil { return fmt.Errorf("YAML解析失败: %w\n内容: %s", err, string(content)) } // 事务性数据库操作 tx := db.Begin() defer func() { if r := recover(); r != nil { tx.Rollback() } }() record := Table1{ FileName: filepath.Base(yamlPath), ContentHash: sha256.Sum256(content), // AI 建议添加内容哈希校验 Content: string(content), ParsedData: data, // 存储解析后的结构体 } if err := tx.Create(&record).Error; err != nil { tx.Rollback() return fmt.Errorf("数据库插入失败: %w", err) } return tx.Commit().Error}添加的yaml文件解析前置步骤清晰,首先确认文件是否存在,然后限制文件大小进行读取以防崩溃,用严格模式解析yaml文件杜绝了格式问题。将所有数据库操作放在事务内实现,满足提示词要求,因此采用该结果,适配实际代码:通过智能对话方式实现代码补全的内容,采纳率达70%以上。

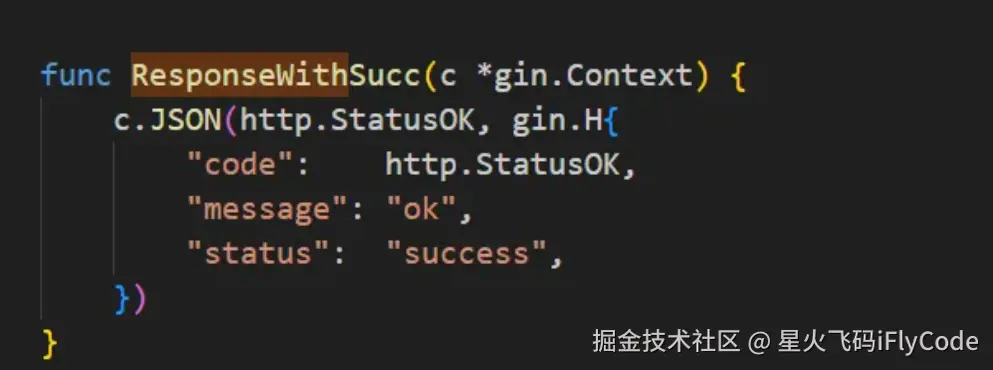

案例4:通过组件接口完成API响应------RESTful API响应封装

实现方式:基于代码补全功能自动补全代码

原代码:

go

func ResponseWithSuccess(c *gin.Context) {}AI补全代码:

go

func ResponseWithSuccess(c *gin.Context) { c.JSON(http.StatusOK, gin.H{ "code": http.StatusOK, "message": "ok", "status": "success", })}AI生成的代码完全满足标准化RESTful API响应需求,所以直接使用,通过代码自动续写的功能,直接进行代码采纳操作,无需做任何修改。

03 总结

本次iFlyCode代码补全实践明显提升了开发效率。遵循常规工作节奏,光靠人工一点点优化整个项目的代码,估计得花上两周时间才能弄完。但用了 iFlyCode这个帮手,仅仅用了3天就顺利完成了任务,而且在优化过程中,还顺便把代码的规范性也仔细调整好了。很明显,合理利用手里的智能工具,不仅能大大缩短项目完成的时间,还能少花很多人力,降低可能出现的风险。这样一来,团队就能把更多精力放在琢磨核心业务逻辑的创新和改进上,让项目又快又好地往前推进。