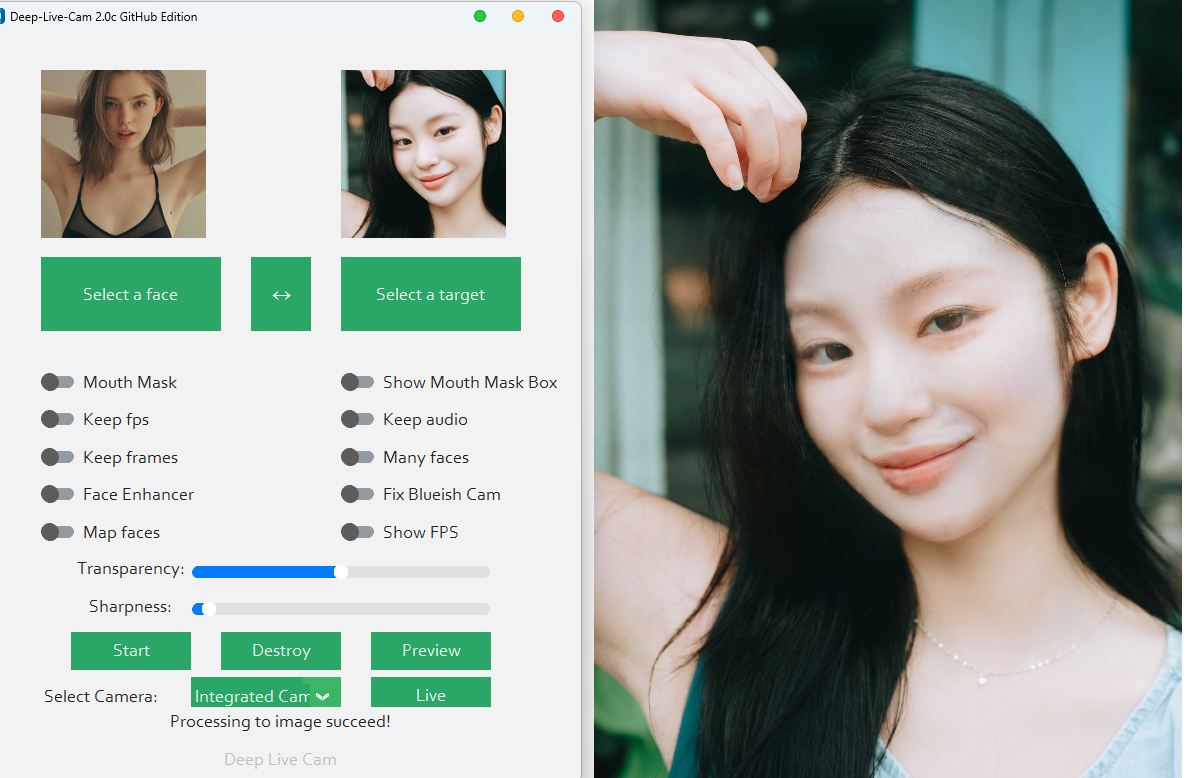

hacksider/Deep-Live-Cam: real time face swap and one-click video deepfake with only a single image![]() https://github.com/hacksider/Deep-Live-Cam今天调试了一下这个项目,主要的问题就是需要下载的一些资源太慢了,然后就是教程不是很详细,最后的结果感觉没什么效果,不知道是不是要自己额外训练,希望有会的大佬可以指点一下。

https://github.com/hacksider/Deep-Live-Cam今天调试了一下这个项目,主要的问题就是需要下载的一些资源太慢了,然后就是教程不是很详细,最后的结果感觉没什么效果,不知道是不是要自己额外训练,希望有会的大佬可以指点一下。

按照项目的流程,我使用的anaconda环境,cuda版本是12.8,windows11操作系统。

Set up Your Platform

Python (3.11 recommended)

推荐使用3.11版本,但是我使用的是3.10的。

pip

我环境用的是anaconda配置(也可以不需要,后续用venv,但这个**python -m venv venv 中的版本是不确定的,取决于你的系统配置**)。

conda create --name deep_live_cam python=3.10

git

Git下载安装(保姆教程)-CSDN博客![]() https://blog.csdn.net/2503_91462991/article/details/147215703Git-2.52.0-64-bit.exe下载后安装流程一步步安装。

https://blog.csdn.net/2503_91462991/article/details/147215703Git-2.52.0-64-bit.exe下载后安装流程一步步安装。

FFmpeg - iex (irm ffmpeg.tc.ht)

FFmpeg 安装与使用_ffmpeg的安装和使用教程-CSDN博客![]() https://blog.csdn.net/cliffordl/article/details/149689102下载ffmpeg-8.0.1-full_build.7z 解压后配置环境变量,通过命令行输入ffmpeg -version来验证是否安装成功。

https://blog.csdn.net/cliffordl/article/details/149689102下载ffmpeg-8.0.1-full_build.7z 解压后配置环境变量,通过命令行输入ffmpeg -version来验证是否安装成功。

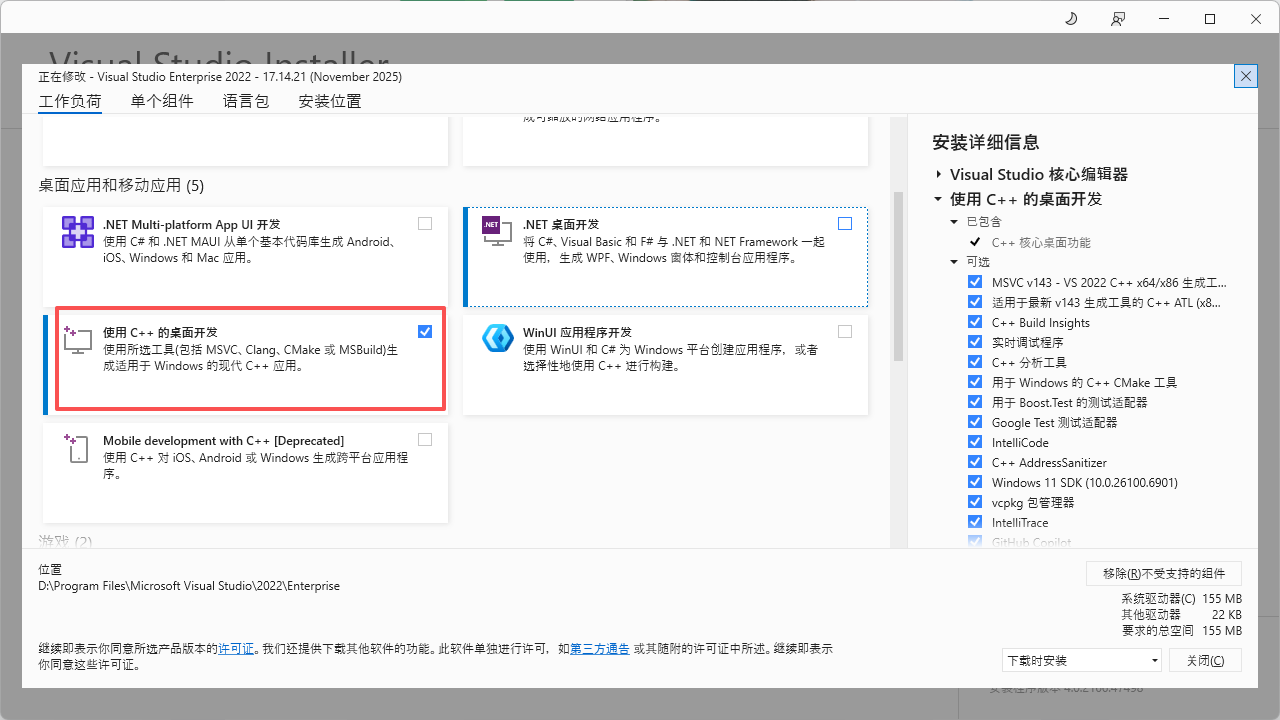

Visual Studio 2022 Runtimes (Windows)

Deep-Live-Cam项目在Windows系统下的Insightface编译问题解决方案-CSDN博客![]() https://blog.csdn.net/gitblog_00939/article/details/151451423这里我是下载visual studio 2022后安装了"使用C++的桌面开发"。

https://blog.csdn.net/gitblog_00939/article/details/151451423这里我是下载visual studio 2022后安装了"使用C++的桌面开发"。

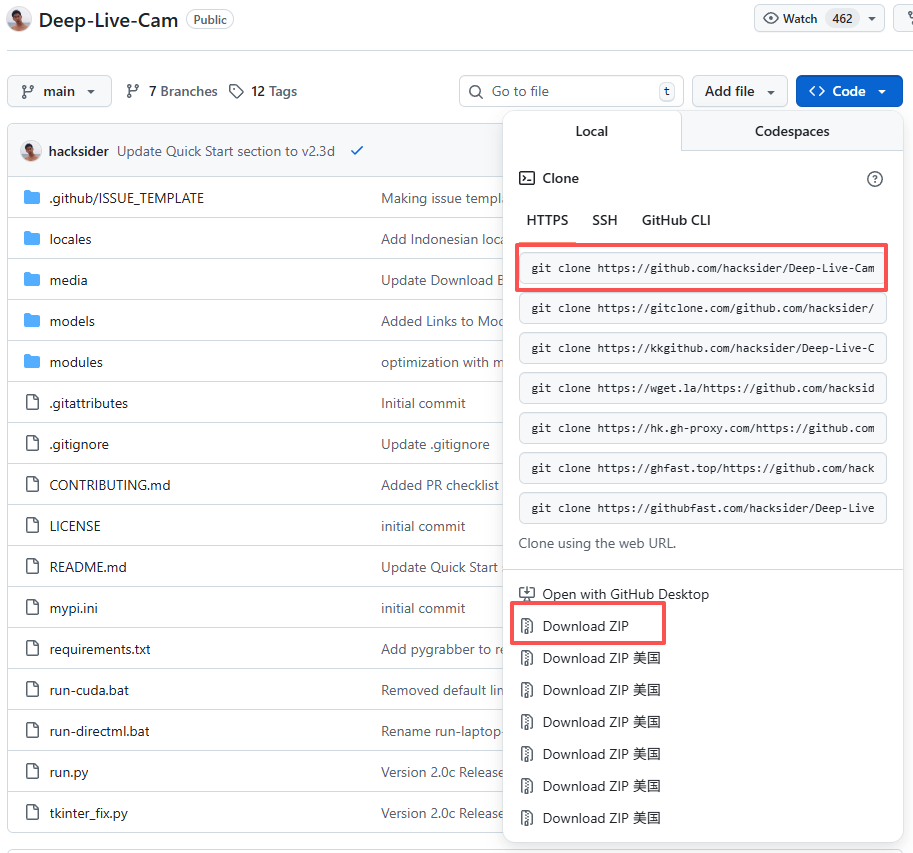

Clone the Repository

bash

git clone https://github.com/hacksider/Deep-Live-Cam.git

cd Deep-Live-Cam这个用git下载太慢了,我是直接在GitHub上下载,下载后的文件名是"Deep-Live-Cam-main",自己修改成"Deep-Live-Cam",之后用cd进入项目的目录。

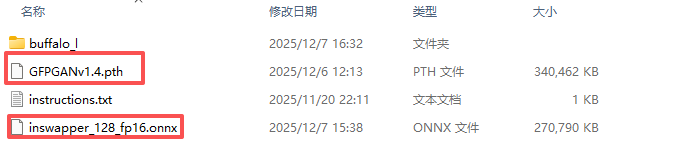

Download the Models

Place these files in the "models" folder.(下载的模型放到\Deep-Live-Cam\models目录下)

Install Dependencies

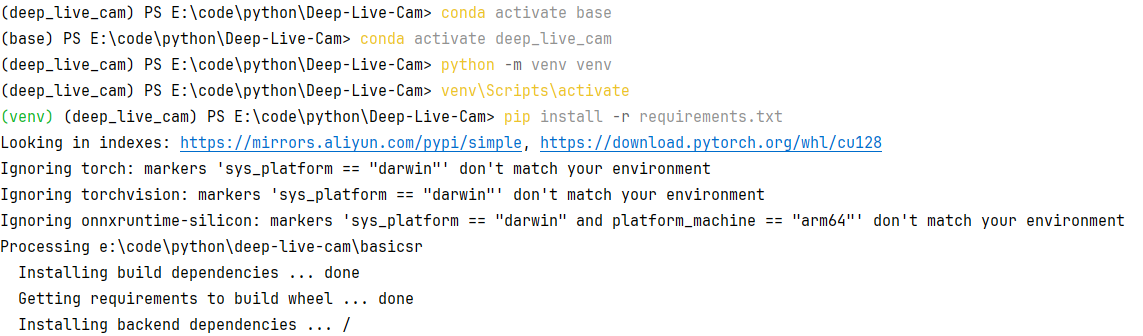

这里我是先通过conda进入deep_live_cam环境,这里使用的conda和venv两者的区别我还不清楚,因为原本是没有提到conda的,而且这个地方当时一直报错,可能是因为之前没有安装FFmpeg和Visual Studio的原因。

bash

conda activate deep_live_cam

python -m venv venv

venv\Scripts\activate

pip install -r requirements.txt这个下面总结是这样,而且是不建议向我这样操作,大家可以尝试conda和venv二选一(我就是这么在PyCharm里面显示那些库还是没有安装的,原来是安装到venv中去了)。

| 命令 | 作用 | 详细解释 |

|---|---|---|

python -m venv venv |

创建 一个名为 venv 的虚拟环境。 |

-m venv 调用Python内置的 venv 模块。 最后一个 venv 是你为环境自定义的文件夹名 (通常就叫 venv),里面会包含独立的Python解释器和pip。 |

venv\Scripts\activate |

激活刚刚创建的虚拟环境。 | 执行后,你的命令行提示符前通常会显示 (venv),表示后续所有Python/pip操作都被隔离在这个小环境里,不会影响系统全局的Python环境。 |

pip install -r requirements.txt |

根据清单文件安装所有依赖。 | -r 表示"读取文件"。pip会读取项目根目录下的 requirements.txt 文件,并自动安装里面列出的所有包及其指定版本。 |

bash

conda activate deep_live_cam

pip install -r requirements.txt

bash

python -m venv venv

venv\Scripts\activate

pip install -r requirements.txt| 你的目标 | 正确做法 | 后续操作 |

|---|---|---|

使用现有的 conda 环境 (推荐) |

只需激活conda环境即可。不要 在里面创建venv。 |

conda activate deep_live_cam 然后直接运行你的项目:python run.py ... |

想使用纯粹的 venv 环境 |

1. 先彻底退出conda环境 :conda deactivate 2. 使用系统Python创建纯净的venv环境。 |

python -m venv venv venv\Scripts\activate pip install -r requirements.txt |

对于使用pip进行包的安装可以尝试换源来提升下载的速度。

python pip安装库下载源更换(清华源、阿里源、中科大源、豆瓣源)_python_脚本之家

bash

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

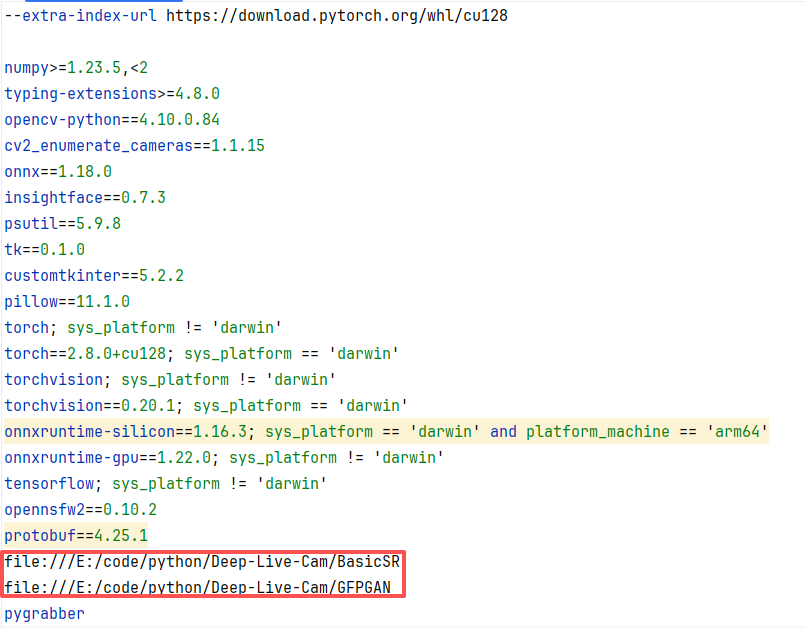

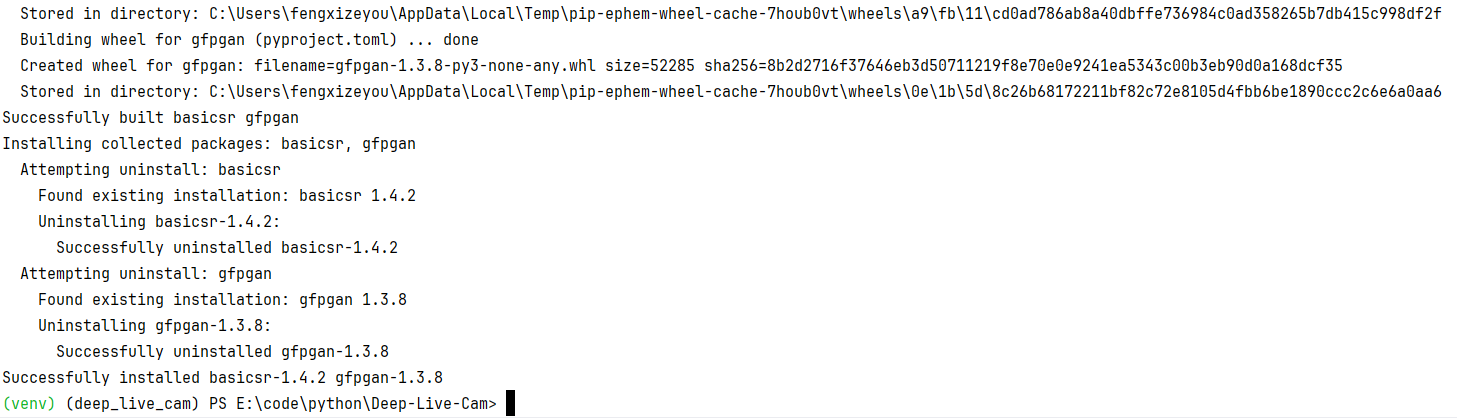

pip config set install.trusted-host mirrors.aliyun.com因为网络问题这里会出现下载失败,我是通过下载后进行本地的配置。

XPixelGroup/BasicSR: Open Source Image and Video Restoration Toolbox for Super-resolution, Denoise, Deblurring, etc. Currently, it includes EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR, etc. Also support StyleGAN2, DFDNet.![]() https://github.com/XPixelGroup/BasicSRTencentARC/GFPGAN: GFPGAN aims at developing Practical Algorithms for Real-world Face Restoration.

https://github.com/XPixelGroup/BasicSRTencentARC/GFPGAN: GFPGAN aims at developing Practical Algorithms for Real-world Face Restoration.![]() https://github.com/TencentARC/GFPGAN

https://github.com/TencentARC/GFPGAN

这个安装成功不会显示报错信息。

CUDA Execution Provider (Nvidia)

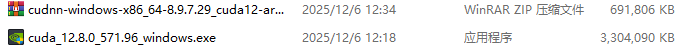

CUDA和cuDNN的安装_cuda12.8对应的cudnn-CSDN博客![]() https://blog.csdn.net/m0_62907835/article/details/145441697在输入下面这条指令之前我安装了CUDA和cuDNN。

https://blog.csdn.net/m0_62907835/article/details/145441697在输入下面这条指令之前我安装了CUDA和cuDNN。

Install CUDA Toolkit 12.8.0

Install cuDNN v8.9.7 for CUDA 12.x (required for onnxruntime-gpu):

Download cuDNN v8.9.7 for CUDA 12.x

Make sure the cuDNN bin directory is in your system PATH

Install dependencies:

bash

pip install -U torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128

pip uninstall onnxruntime onnxruntime-gpu

pip install onnxruntime-gpu==1.21.0在运行的过程中因为网络问题出现中断,还是通过自己下载好后本地进行的配置。

Usage:

bash

python run.py --execution-provider cuda在配置过程中遇到的问题还有权限不够,需要以管理员的身份运行(写入到C盘)。