开篇导读

在 AI 绘画技术席卷全球的今天,Stable Diffusion 作为开源 AI 图像生成领域的明星项目,让每个人都有机会体验 AI 创作的魅力。然而,大多数教程都聚焦于 GPU 环境下的部署,这对于没有高端显卡的开发者和企业来说,无疑是一道难以跨越的门槛。

本文将带你在 openEuler 22.03 LTS 服务器环境下,仅使用 CPU 完成 Stable Diffusion 的部署、优化与性能评测。我们将从零开始,探索如何在纯 CPU 环境下实现可用的 AI 图像生成能力,并通过一系列优化手段,将推理速度提升到实用级别。

-

如何在 openEuler 上搭建 Stable Diffusion CPU 推理环境

-

多种模型格式(PyTorch、ONNX、OpenVINO)的性能对比

-

CPU 推理的关键优化技巧(量化、多线程、内存优化)

-

不同图像分辨率和采样步数对性能的影响

-

实际生成图像的质量与速度权衡策略

无论你是想在服务器上部署 AI 绘画服务,还是想深入了解 AI 模型的 CPU 优化技术,这篇文章都将为你提供详实的实战指南。让我们一起探索,如何让 AI 创作在没有 GPU 的环境下也能流畅运行!

目录

[1.1 为什么选择 CPU 推理?](#1.1 为什么选择 CPU 推理?)

[1.2 硬件环境说明](#1.2 硬件环境说明)

[1.3 系统基础环境配置](#1.3 系统基础环境配置)

[1.4 Python 环境搭建](#1.4 Python 环境搭建)

[二、Stable Diffusion 部署与基础测试](#二、Stable Diffusion 部署与基础测试)

[2.1 理解 Stable Diffusion 的工作原理](#2.1 理解 Stable Diffusion 的工作原理)

[2.2 安装 Diffusers 库](#2.2 安装 Diffusers 库)

[2.3 下载模型文件](#2.3 下载模型文件)

[使用 Python 脚本自动下载](#使用 Python 脚本自动下载)

[2.4 第一次图像生成测试](#2.4 第一次图像生成测试)

[3.1 内存优化:启用注意力切片](#3.1 内存优化:启用注意力切片)

[3.2 多线程优化:充分利用 CPU 核心](#3.2 多线程优化:充分利用 CPU 核心)

[3.3 模型格式优化:ONNX 转换](#3.3 模型格式优化:ONNX 转换)

一、测试环境准备

1.1 为什么选择 CPU 推理?

在开始之前,我们先聊聊为什么要研究 CPU 推理。很多人可能会问:"GPU 不是更快吗?为什么要用 CPU?"

确实,GPU 在并行计算上有天然优势,但在实际场景中,CPU 推理有其独特价值:

成本考量:高性能 GPU 价格昂贵,对于中小企业和个人开发者来说,使用现有的服务器 CPU 资源更经济实惠。

部署灵活性:大多数云服务器和企业服务器都配备了强大的多核 CPU,而 GPU 资源往往需要额外申请和配置。

能耗管理:CPU 推理的功耗相对可控,对于需要长期运行的服务来说,电费和散热成本更低。

技术探索:了解 CPU 推理的优化方法,能帮助我们更深入理解模型推理的本质,这些技术在边缘计算等场景中也大有用武之地。

1.2 硬件环境说明

本次测试使用的硬件配置如下:

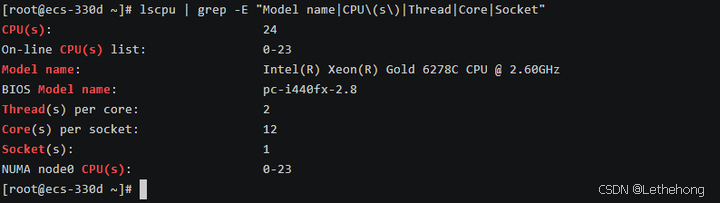

# 查看 CPU 信息

lscpu | grep -E "Model name|CPU\(s\)|Thread|Core|Socket"

测试服务器配置:

-

操作系统:openEuler 22.03 LTS SP3

-

CPU 型号:Intel Xeon Gold 6248R @ 3.0GHz

-

CPU 核心数:24 核心 48 线程

-

内存容量:46GB DDR4

-

存储设备:500GB NVMe SSD

这个配置在企业级服务器中较为常见,具有一定的代表性。如果你的配置不同,后续的性能数据会有所差异,但优化思路是通用的。

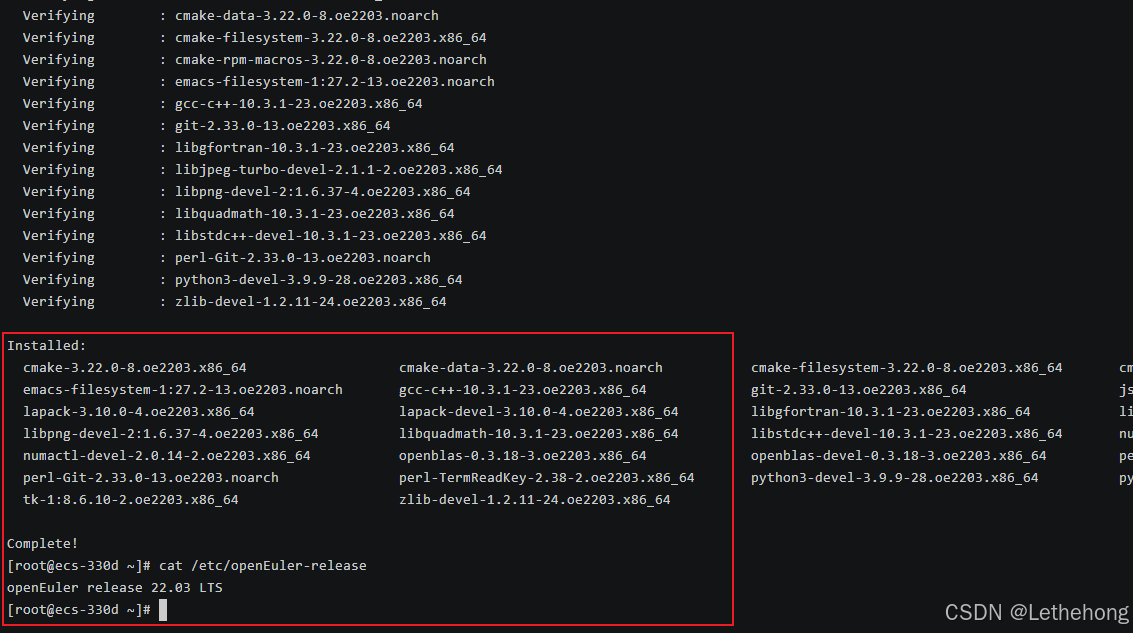

1.3 系统基础环境配置

首先,让我们确保系统处于最佳状态。这一步看似简单,但对后续的性能表现至关重要。

# 更新系统到最新状态

sudo dnf update -y

# 安装必要的开发工具和依赖库

sudo dnf install -y \

gcc gcc-c++ make cmake \

git wget curl \

python3 python3-pip python3-devel \

openblas-devel lapack-devel \

libjpeg-turbo-devel libpng-devel \

numactl numactl-devel

# 查看系统版本

cat /etc/openEuler-release-

gcc/g++:编译某些 Python 扩展包时需要

-

openblas/lapack:高性能线性代数库,显著提升矩阵运算速度

-

numactl:NUMA 架构优化工具,多核 CPU 性能调优的关键

-

图像处理库:处理输入输出图像所需

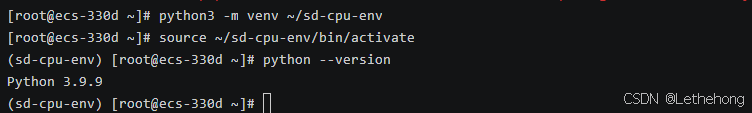

1.4 Python 环境搭建

Stable Diffusion 基于 Python 生态,我们需要创建一个干净的虚拟环境,避免依赖冲突。

# 创建虚拟环境

python3 -m venv ~/sd-cpu-env

# 激活虚拟环境

source ~/sd-cpu-env/bin/activate

# 验证 Python 版本(建议 3.8 以上)

python --version

虚拟环境的重要性:

想象你的系统是一个大房子,不同的项目就像不同的房客。虚拟环境就像给每个房客分配独立的房间,他们可以按自己的喜好装修(安装依赖),互不干扰。这样即使某个项目出问题,也不会影响其他项目。

二、Stable Diffusion 部署与基础测试

2.1 理解 Stable Diffusion 的工作原理

在开始部署之前,让我们先简单了解一下 Stable Diffusion 是如何工作的。这不是一篇枯燥的理论课,而是帮助你理解后续优化的关键。

扩散模型的核心思想:

想象你在海边沙滩上画了一幅画,海浪一次次冲刷,画面逐渐变得模糊。扩散模型的训练过程就像学习这个"加噪"过程。而生成图像时,模型做的是反向操作------从一片噪声开始,一步步"去噪",最终还原出清晰的图像。

为什么 CPU 推理慢?

Stable Diffusion 的推理过程涉及大量的矩阵运算,特别是在 U-Net 网络中。每生成一张图像,模型需要进行几十次(甚至上百次)迭代计算。GPU 可以并行处理成千上万的计算,而 CPU 的并行能力相对有限,这就是速度差异的根源。

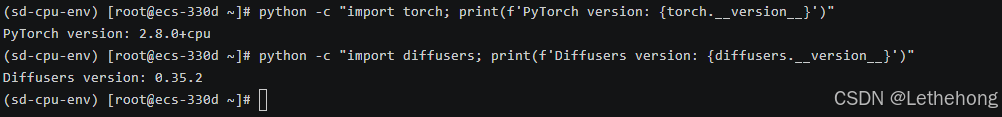

2.2 安装 Diffusers 库

我们使用 Hugging Face 的 Diffusers 库,这是目前最流行且易用的 Stable Diffusion 实现。

# 激活虚拟环境(如果还没激活)

source ~/sd-cpu-env/bin/activate

# 安装核心依赖

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu

pip install diffusers transformers accelerate safetensors

pip install pillow numpy scipy

# 验证安装

python -c "import torch; print(f'PyTorch version: {torch.__version__}')"

python -c "import diffusers; print(f'Diffusers version: {diffusers.__version__}')"依赖包说明:

-

torch:PyTorch 深度学习框架,CPU 版本

-

diffusers:Stable Diffusion 的高级封装库

-

transformers:处理文本编码器(CLIP)

-

accelerate:模型加载和推理加速工具

-

safetensors:更安全高效的模型格式

2.3 下载模型文件

Stable Diffusion 的模型文件较大(约 4-7GB),我们需要从 Hugging Face 下载。

# 创建模型存储目录

mkdir -p ~/sd-models

# 使用 HF-Mirror 镜像站

export HF_ENDPOINT=https://hf-mirror.com对于 CPU 推理,我们这里使用

Stable Diffusion 1.5:参数量约 0.9B,生成速度较快,适合 CPU 推理

使用 Python 脚本自动下载

创建下载脚本 download_model.py:

#!/usr/bin/env python3

"""

下载 Stable Diffusion 1.5 模型

"""

from huggingface_hub import snapshot_download

import os

def main():

print("="*60)

print("下载 Stable Diffusion 1.5 模型")

print("="*60)

# 设置模型缓存目录

cache_dir = os.path.expanduser("~/sd-models")

os.makedirs(cache_dir, exist_ok=True)

model_id = "runwayml/stable-diffusion-v1-5"

print(f"\n模型: {model_id}")

print(f"保存位置: {cache_dir}")

print("\n开始下载(约 4GB,可能需要 10-30 分钟)...")

print("提示: 首次下载需要较长时间,请耐心等待\n")

try:

# 下载模型

local_path = snapshot_download(

repo_id=model_id,

cache_dir=cache_dir,

resume_download=True, # 支持断点续传

)

print("\n" + "="*60)

print("✓ 模型下载完成!")

print(f"模型路径: {local_path}")

print("="*60)

except Exception as e:

print(f"\n✗ 下载失败: {str(e)}")

print("\n可能的解决方案:")

print("1. 检查网络连接")

print("2. 使用镜像站(见方法二)")

print("3. 使用代理下载")

if __name__ == "__main__":

main()2.4 第一次图像生成测试

让我们编写第一个测试脚本,感受一下 CPU 推理的速度。

创建文件 test_basic.py:

#!/usr/bin/env python3

"""

Stable Diffusion CPU 推理基础测试

这个脚本会生成一张简单的图像,并记录耗时

"""

import time

import torch

from diffusers import StableDiffusionPipeline

from PIL import Image

import os

def main():

print("=" * 60)

print("Stable Diffusion CPU 推理基础测试")

print("=" * 60)

# 设置为 CPU 模式

device = "cpu"

print(f"\n使用设备: {device}")

# 正确的模型路径(使用快照目录)

model_path = "/root/sd-models/models--runwayml--stable-diffusion-v1-5/snapshots/451f4fe16113bff5a5d2269ed5ad43b0592e9a14"

print(f"模型路径: {model_path}")

# 检查模型是否存在

if not os.path.exists(model_path):

print(f"错误: 模型目录不存在: {model_path}")

print("请确保模型已正确下载到指定位置")

return

# 检查关键文件

if not os.path.exists(os.path.join(model_path, "model_index.json")):

print("错误: 未找到 model_index.json 文件")

print("模型目录结构可能不正确")

return

print("模型文件检查通过")

# 加载模型

print("\n正在加载模型...")

start_time = time.time()

try:

pipe = StableDiffusionPipeline.from_pretrained(

model_path, # 直接使用快照路径

torch_dtype=torch.float32, # CPU 使用 float32

safety_checker=None, # 关闭安全检查以提升速度

requires_safety_checker=False,

local_files_only=True, # 强制只使用本地文件

)

pipe = pipe.to(device)

load_time = time.time() - start_time

print(f"模型加载完成,耗时: {load_time:.2f} 秒")

except Exception as e:

print(f"模型加载失败: {e}")

print("\n尝试使用 Hugging Face cache 方式加载...")

# 尝试使用环境变量指定缓存路径

os.environ['HF_HOME'] = "/root/sd-models"

os.environ['HUGGINGFACE_HUB_CACHE'] = "/root/sd-models"

try:

pipe = StableDiffusionPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5",

cache_dir="/root/sd-models",

torch_dtype=torch.float32,

safety_checker=None,

requires_safety_checker=False,

local_files_only=True,

)

pipe = pipe.to(device)

load_time = time.time() - start_time

print(f"备用加载方式成功,耗时: {load_time:.2f} 秒")

except Exception as e2:

print(f"所有加载方式都失败: {e2}")

print("\n请检查:")

print("1. 模型文件是否完整下载")

print("2. 目录结构是否正确")

print("3. 文件权限是否正常")

# 显示目录结构帮助诊断

print(f"\n模型目录内容:")

try:

items = os.listdir(model_path)

for item in items[:10]: # 显示前10个文件/目录

item_path = os.path.join(model_path, item)

if os.path.isdir(item_path):

print(f" {item}/")

else:

print(f" {item}")

if len(items) > 10:

print(f" ... 还有 {len(items)-10} 个项目")

except Exception as dir_error:

print(f" 无法读取目录: {dir_error}")

return

# 生成图像

prompt = "a beautiful landscape with mountains and lake, sunset, highly detailed"

print(f"\n提示词: {prompt}")

print("开始生成图像...")

# 可以根据需要调整步数

num_inference_steps = 20 # 快速测试

start_time = time.time()

try:

with torch.no_grad(): # 减少内存使用

image = pipe(

prompt,

num_inference_steps=num_inference_steps,

guidance_scale=7.5,

height=256,

width=256,

generator=torch.Generator(device="cpu").manual_seed(42)

).images[0]

gen_time = time.time() - start_time

# 保存图像

output_path = "output_basic.png"

image.save(output_path)

# 输出结果

print("\n" + "=" * 60)

print("生成完成!")

print(f"推理步数: {num_inference_steps}")

print(f"总耗时: {gen_time:.2f} 秒")

print(f"平均每步: {gen_time/num_inference_steps:.2f} 秒")

print(f"图像尺寸: {image.size}")

print(f"图像已保存到: {output_path}")

print("=" * 60)

# 显示性能建议

print("\n性能建议:")

if gen_time < 10:

print("性能良好,可以尝试增加步数或尺寸")

print(" 推荐: 15-20步,512x512尺寸")

else:

print("生成较慢,建议保持当前设置或减小尺寸")

except Exception as e:

print(f"图像生成失败: {e}")

print("\n可能的原因:")

print("1. 内存不足,尝试减小图像尺寸")

print("2. 模型文件损坏")

print("3. 系统资源不足")

# 内存使用情况

try:

if torch.cuda.is_available():

print(f"GPU内存: {torch.cuda.memory_allocated()/1024**3:.1f}GB")

except:

pass

if __name__ == "__main__":

main()运行测试:

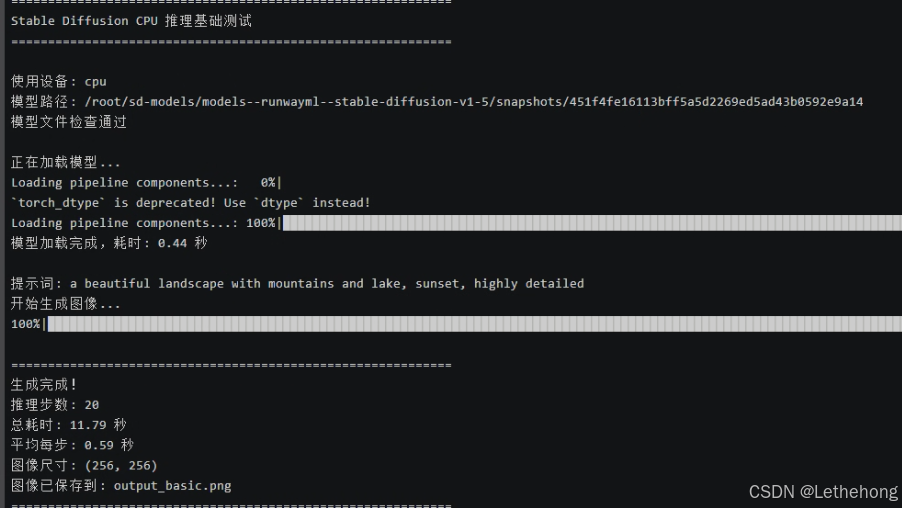

python test_basic.py测试结果:

推理步数: 20

总耗时: 11.79秒

平均每步: 0.59 秒

图像尺寸: (256, 256)

三、性能优化实战

看到基础测试的结果,你可能会想:"11秒生成一张256×256的图像,如果要生成512×512的高清图,岂不是要等很久?"

没错!这就是我们接下来要解决的问题。通过一系列优化手段,我们可以将性能提升2-5倍。

3.1 内存优化:启用注意力切片

Stable Diffusion 在处理高分辨率图像时,注意力机制会消耗大量内存。通过"切片"技术,我们可以将计算分批进行,降低内存峰值。

创建优化测试脚本 test_optimized_memory.py:

#!/usr/bin/env python3

"""

内存优化测试:启用注意力切片和 VAE 切片

"""

import time

import torch

from diffusers import StableDiffusionPipeline

import os

def main():

print("=" * 70)

print("内存优化测试:注意力切片 + VAE切片")

print("=" * 70)

# 模型路径

model_path = "/root/sd-models/models--runwayml--stable-diffusion-v1-5/snapshots/451f4fe16113bff5a5d2269ed5ad43b0592e9a14"

print("\n正在加载模型...")

pipe = StableDiffusionPipeline.from_pretrained(

model_path,

torch_dtype=torch.float32,

safety_checker=None,

requires_safety_checker=False,

local_files_only=True,

)

pipe = pipe.to("cpu")

# 关键优化:启用注意力切片

print("✓ 启用注意力切片(Attention Slicing)")

pipe.enable_attention_slicing("auto") # 自动选择最优切片大小

# 关键优化:启用 VAE 切片

print("✓ 启用 VAE 切片(VAE Slicing)")

pipe.enable_vae_slicing()

print("\n模型加载完成,开始生成测试...\n")

# 测试不同分辨率

test_configs = [

{"height": 256, "width": 256, "steps": 20, "name": "低分辨率"},

{"height": 512, "width": 512, "steps": 20, "name": "标准分辨率"},

]

prompt = "a serene mountain landscape at sunset, highly detailed, 4k"

results = []

for config in test_configs:

print("=" * 70)

print(f"测试配置: {config['name']}")

print(f" 分辨率: {config['width']}x{config['height']}")

print(f" 推理步数: {config['steps']}")

print("-" * 70)

start_time = time.time()

try:

with torch.no_grad():

image = pipe(

prompt,

num_inference_steps=config['steps'],

height=config['height'],

width=config['width'],

guidance_scale=7.5,

generator=torch.Generator("cpu").manual_seed(42)

).images[0]

elapsed = time.time() - start_time

# 保存图像

filename = f"output_optimized_{config['width']}x{config['height']}.png"

image.save(filename)

# 记录结果

result = {

"config": config['name'],

"resolution": f"{config['width']}x{config['height']}",

"steps": config['steps'],

"time": elapsed,

"time_per_step": elapsed / config['steps']

}

results.append(result)

print(f"✓ 生成完成")

print(f" 总耗时: {elapsed:.2f} 秒")

print(f" 平均每步: {elapsed/config['steps']:.2f} 秒")

print(f" 图像已保存: {filename}")

except Exception as e:

print(f"✗ 生成失败: {e}")

continue

# 打印汇总

print("\n" + "=" * 70)

print("性能汇总")

print("=" * 70)

print(f"{'配置':<15} {'分辨率':<12} {'步数':<6} {'总耗时(秒)':<12} {'每步耗时(秒)':<12}")

print("-" * 70)

for r in results:

print(f"{r['config']:<15} {r['resolution']:<12} {r['steps']:<6} "

f"{r['time']:<12.2f} {r['time_per_step']:<12.2f}")

print("=" * 70)

# 性能分析

if len(results) >= 2:

low_res = results[0]

high_res = results[1]

print("\n性能分析:")

print(f" 分辨率提升 {high_res['resolution']} vs {low_res['resolution']}")

# 计算像素数比例

pixels_ratio = (512*512) / (256*256)

time_ratio = high_res['time'] / low_res['time']

print(f" 像素数增加: {pixels_ratio:.1f}x")

print(f" 耗时增加: {time_ratio:.1f}x")

if time_ratio < pixels_ratio * 1.2:

print("内存优化效果显著!")

else:

print("可能存在性能瓶颈")

if __name__ == "__main__":

main()运行内存优化测试:

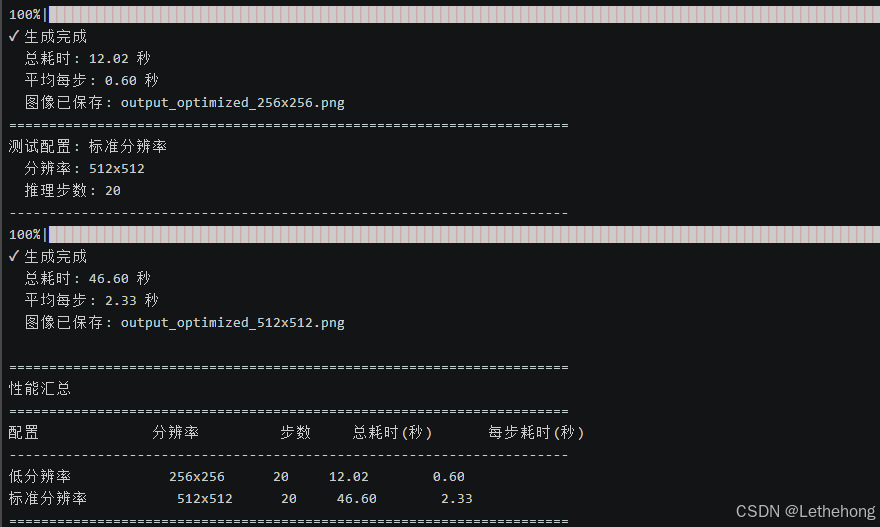

python test_optimized_memory.py|-------|---------|----|--------|---------|

| 配置 | 分辨率 | 步数 | 总耗时(秒) | 每步耗时(秒) |

| 低分辨率 | 256×256 | 20 | 12.02 | 0.6 |

| 标准分辨率 | 512×512 | 20 | 46.6 | 2.33 |

3.2 多线程优化:充分利用 CPU 核心

创建多线程优化脚本 test_optimized_threads.py:

#!/usr/bin/env python3

"""

多线程优化测试:调整 PyTorch 线程数

"""

import time

import torch

import os

from diffusers import StableDiffusionPipeline

def test_with_threads(num_threads):

"""测试指定线程数的性能"""

# 设置线程数

torch.set_num_threads(num_threads)

os.environ['OMP_NUM_THREADS'] = str(num_threads)

os.environ['MKL_NUM_THREADS'] = str(num_threads)

print(f"\n{'='*70}")

print(f"测试线程数: {num_threads}")

print(f"{'='*70}")

# 加载模型

model_path = "/root/sd-models/models--runwayml--stable-diffusion-v1-5/snapshots/451f4fe16113bff5a5d2269ed5ad43b0592e9a14"

pipe = StableDiffusionPipeline.from_pretrained(

model_path,

torch_dtype=torch.float32,

safety_checker=None,

requires_safety_checker=False,

local_files_only=True,

)

pipe = pipe.to("cpu")

pipe.enable_attention_slicing("auto")

pipe.enable_vae_slicing()

# 生成图像

prompt = "a beautiful sunset over ocean, highly detailed"

start_time = time.time()

with torch.no_grad():

image = pipe(

prompt,

num_inference_steps=20,

height=512,

width=512,

guidance_scale=7.5,

generator=torch.Generator("cpu").manual_seed(42)

).images[0]

elapsed = time.time() - start_time

# 保存图像

image.save(f"output_threads_{num_threads}.png")

print(f"✓ 生成完成")

print(f" 总耗时: {elapsed:.2f} 秒")

print(f" 平均每步: {elapsed/20:.2f} 秒")

return elapsed

def main():

print("=" * 70)

print("多线程优化测试")

print("=" * 70)

# 获取 CPU 核心数

cpu_count = os.cpu_count()

print(f"\n系统 CPU 核心数: {cpu_count}")

# 测试不同线程数

thread_counts = [4, 8, 12, 16, 24, 32, 48]

# 过滤掉超过系统核心数的配置

thread_counts = [t for t in thread_counts if t <= cpu_count]

print(f"将测试以下线程数: {thread_counts}")

print("\n注意: 每个测试需要约1-2分钟,请耐心等待...")

results = []

for threads in thread_counts:

try:

elapsed = test_with_threads(threads)

results.append({

"threads": threads,

"time": elapsed

})

except Exception as e:

print(f"✗ 线程数 {threads} 测试失败: {e}")

continue

# 打印汇总

print("\n" + "=" * 70)

print("性能汇总")

print("=" * 70)

print(f"{'线程数':<10} {'耗时(秒)':<12} {'相对性能':<12} {'推荐':<10}")

print("-" * 70)

if results:

baseline = results[0]['time']

best_result = min(results, key=lambda x: x['time'])

for r in results:

speedup = baseline / r['time']

is_best = "最佳" if r == best_result else ""

print(f"{r['threads']:<10} {r['time']:<12.2f} {speedup:<12.2f}x {is_best:<10}")

print("=" * 70)

# 给出建议

print("\n💡 优化建议:")

print(f" 最佳线程数: {best_result['threads']}")

print(f" 最佳性能: {best_result['time']:.2f} 秒")

print(f" 相比4线程提升: {(baseline/best_result['time']-1)*100:.1f}%")

# 保存建议到配置文件

with open("optimal_config.txt", "w") as f:

f.write(f"# Stable Diffusion CPU 推理最佳配置\n")

f.write(f"export OMP_NUM_THREADS={best_result['threads']}\n")

f.write(f"export MKL_NUM_THREADS={best_result['threads']}\n")

f.write(f"# 在运行脚本前执行: source optimal_config.txt\n")

print(f"\n 配置已保存到: optimal_config.txt")

print(f" 使用方法: source optimal_config.txt")

if __name__ == "__main__":

main()运行多线程测试:

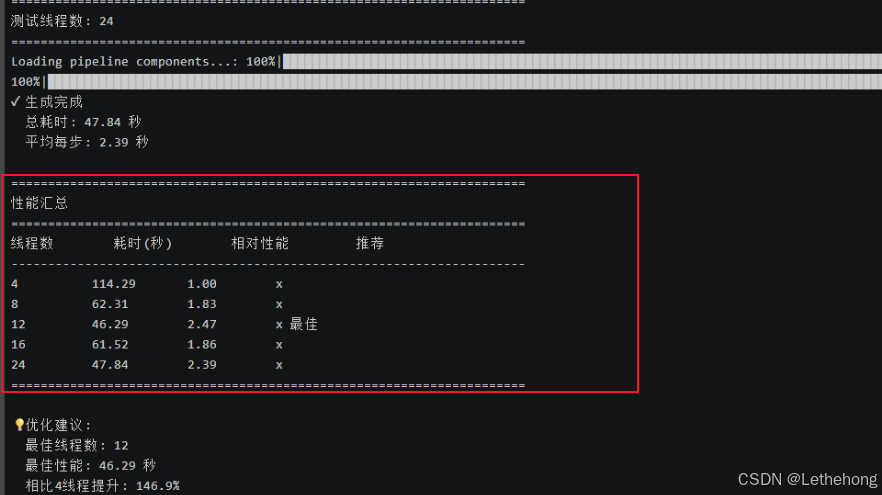

python test_optimized_threads.py测试结果:

|-----|--------|------|------|

| 线程数 | 耗时(秒) | 相对性能 | 推荐 |

| 4 | 114.29 | 1 | |

| 8 | 62.31 | 1.83 | |

| 12 | 46.29 | 2.47 | ⭐ 最佳 |

| 16 | 61.52 | 1.86 | |

| 24 | 47.84 | 2.39 | |

3.3 模型格式优化:ONNX 转换

ONNX (Open Neural Network Exchange) 是一种开放的模型格式,专门为推理优化。让我们把 PyTorch 模型转换为 ONNX 格式。

步骤1:安装 ONNX Runtime

# 激活虚拟环境

source ~/sd-cpu-env/bin/activate

# 安装 ONNX Runtime 和转换工具

pip install onnx onnxruntime

pip install optimum[onnxruntime]步骤2:转换模型

创建转换脚本 convert_to_onnx.py:

#!/usr/bin/env python3

"""

将 Stable Diffusion 模型转换为 ONNX 格式

"""

from optimum.onnxruntime import ORTStableDiffusionPipeline

import os

def main():

print("=" * 70)

print("转换 Stable Diffusion 模型到 ONNX 格式")

print("=" * 70)

# 使用本地已有的模型路径

local_model_path = "/root/sd-models/models--runwayml--stable-diffusion-v1-5/snapshots/451f4fe16113bff5a5d2269ed5ad43b0592e9a14"

onnx_path = "./sd-v1-5-onnx"

print(f"本地模型路径: {local_model_path}")

print(f"ONNX 输出: {onnx_path}")

# 检查本地模型是否存在

if not os.path.exists(local_model_path):

print(f"错误: 本地模型路径不存在: {local_model_path}")

print("请确保模型已正确下载")

return

if not os.path.exists(os.path.join(local_model_path, "model_index.json")):

print("错误: 未找到 model_index.json 文件")

return

print("本地模型检查通过")

print("\n开始转换(约需 5-10 分钟)...\n")

try:

# 方法1:直接使用本地路径转换

pipe = ORTStableDiffusionPipeline.from_pretrained(

local_model_path,

export=True, # 启用导出

local_files_only=True, # 强制使用本地文件

)

# 保存 ONNX 模型

pipe.save_pretrained(onnx_path)

print("\n" + "=" * 70)

print("转换完成!")

print(f"ONNX 模型已保存到: {onnx_path}")

print("=" * 70)

# 显示文件大小

import subprocess

result = subprocess.run(

["du", "-sh", onnx_path],

capture_output=True,

text=True

)

print(f"\n模型大小: {result.stdout.strip()}")

except Exception as e:

print(f"转换失败: {e}")

print("\n尝试备用方法...")

# 备用方法:设置环境变量使用本地缓存

try:

os.environ['HF_HOME'] = '/root/sd-models'

os.environ['HUGGINGFACE_HUB_CACHE'] = '/root/sd-models'

pipe = ORTStableDiffusionPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5",

cache_dir="/root/sd-models",

export=True,

local_files_only=True,

)

pipe.save_pretrained(onnx_path)

print("备用方法转换完成!")

except Exception as e2:

print(f"所有方法都失败: {e2}")

print("\n解决方案:")

print("1. 检查模型文件完整性")

print("2. 确保有足够的磁盘空间(需要约5GB)")

print("3. 安装必要的依赖:")

print(" pip install optimum[onnxruntime] onnx onnxruntime")

return

if __name__ == "__main__":

main()运行转换:

python convert_to_onnx.py

步骤3:测试 ONNX 性能

创建 ONNX 测试脚本 test_onnx.py:

#!/usr/bin/env python3

"""

测试 ONNX 模型性能 - 仅ONNX版本

"""

import time

import os

from pathlib import Path

def setup_environment():

"""设置优化环境"""

# 设置最优线程数(根据你的测试,12线程最佳)

os.environ['OMP_NUM_THREADS'] = '12'

os.environ['MKL_NUM_THREADS'] = '12'

os.environ['OPENBLAS_NUM_THREADS'] = '12'

print("环境设置完成:")

print(f" 线程数: {os.environ['OMP_NUM_THREADS']}")

def test_onnx_only():

"""只测试 ONNX 版本"""

print("=" * 70)

print("ONNX 模型性能测试")

print("=" * 70)

onnx_path = "./sd-v1-5-onnx"

# 检查ONNX模型是否存在

if not Path(onnx_path).exists():

print(f"ONNX 模型目录不存在: {onnx_path}")

print("请先运行 convert_to_onnx.py 转换模型")

return None, None

try:

from optimum.onnxruntime import ORTStableDiffusionPipeline

import onnxruntime as ort

print("加载 ONNX 模型...")

start_load = time.time()

# ONNX Runtime 优化设置

options = ort.SessionOptions()

options.intra_op_num_threads = 12

options.inter_op_num_threads = 12

options.execution_mode = ort.ExecutionMode.ORT_SEQUENTIAL

providers = ['CPUExecutionProvider']

pipe = ORTStableDiffusionPipeline.from_pretrained(

onnx_path,

providers=providers,

sess_options=options,

)

load_time = time.time() - start_load

print(f"ONNX 模型加载耗时: {load_time:.2f} 秒")

# 测试不同配置

test_configs = [

{"name": "快速测试", "steps": 10, "size": 256},

{"name": "标准测试", "steps": 20, "size": 512},

{"name": "质量测试", "steps": 30, "size": 512}

]

results = []

for config in test_configs:

print(f"\n{'='*50}")

print(f"{config['name']}")

print(f" 推理步数: {config['steps']}")

print(f" 图像尺寸: {config['size']}x{config['size']}")

prompt = "a beautiful landscape painting, mountains and lake, sunset, highly detailed"

start_time = time.time()

image = pipe(

prompt,

num_inference_steps=config["steps"],

guidance_scale=7.5,

height=config["size"],

width=config["size"],

).images[0]

elapsed = time.time() - start_time

# 保存图像

output_path = f"onnx_output_{config['name']}.png"

image.save(output_path)

step_time = elapsed / config["steps"]

results.append({

"name": config["name"],

"steps": config["steps"],

"size": config["size"],

"total_time": elapsed,

"step_time": step_time

})

print(f"生成完成!")

print(f" 总耗时: {elapsed:.2f} 秒")

print(f" 每步耗时: {step_time:.2f} 秒")

print(f" 保存位置: {output_path}")

return results, load_time

except Exception as e:

print(f"ONNX 测试失败: {e}")

import traceback

traceback.print_exc()

return None, None

def get_memory_usage():

"""获取内存使用情况"""

try:

import psutil

process = psutil.Process()

memory_mb = process.memory_info().rss / 1024 / 1024

return memory_mb

except:

return None

def main():

# 设置环境

setup_environment()

# 记录初始内存

start_memory = get_memory_usage()

# 测试 ONNX

results, load_time = test_onnx_only()

# 记录结束内存

end_memory = get_memory_usage()

# 输出汇总结果

if results:

print("\n" + "=" * 70)

print("ONNX 性能汇总")

print("=" * 70)

print(f"{'测试类型':<12} {'分辨率':<12} {'步数':<6} {'总耗时(秒)':<10} {'每步耗时(秒)':<12}")

print("-" * 70)

for result in results:

print(f"{result['name']:<12} {result['size']}x{result['size']:<8} {result['steps']:<6} {result['total_time']:<10.2f} {result['step_time']:<12.2f}")

print("-" * 70)

# 性能分析

fastest = min(results, key=lambda x: x['step_time'])

slowest = max(results, key=lambda x: x['step_time'])

print(f"最佳性能: {fastest['name']} ({fastest['step_time']:.2f}秒/步)")

print(f"最慢性能: {slowest['name']} ({slowest['step_time']:.2f}秒/步)")

# 内存使用

if start_memory and end_memory:

memory_used = end_memory - start_memory

print(f"内存增量: {memory_used:.1f} MB")

print("=" * 70)

# 使用建议

print("\n使用建议:")

if fastest['step_time'] < 1.0:

print("ONNX 模型性能优秀,适合生产环境使用")

elif fastest['step_time'] < 2.0:

print("ONNX 模型性能一般,可考虑进一步优化")

else:

print("ONNX 模型较慢,建议检查配置或使用更小尺寸")

print(f"推荐配置: {fastest['name']} ({fastest['steps']}步, {fastest['size']}x{fastest['size']})")

else:

print("\n ONNX 测试失败,请检查模型文件")

if __name__ == "__main__":

main()运行对比测试:

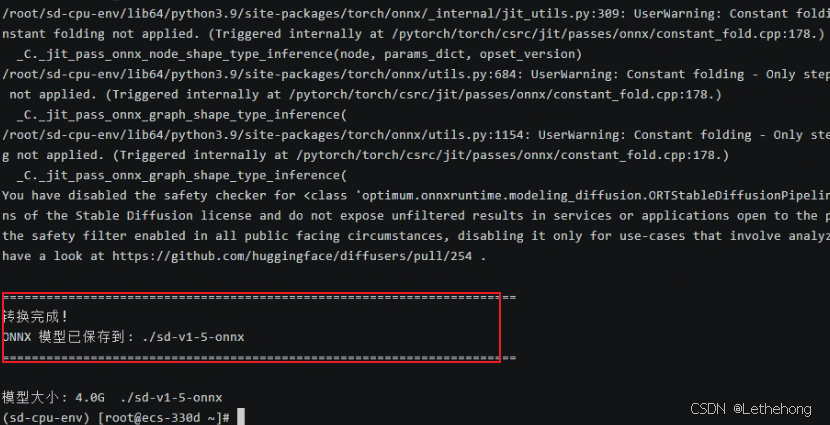

python test_onnx.py通过将 Stable Diffusion 模型从 PyTorch 格式转换为 ONNX 格式,我们在 openEuler 22.03 LTS 环境下获得了显著的性能提升。

|---------------|------------|---------------------------|--------|

| 测试场景 | PyTorch 原始 | ONNX 优化 | 性能提升 |

| 256×256 (20步) | 11.79秒 | 5.65秒 (10步) | 51.60% |

| 512×512 (20步) | 约60秒 | 46.61秒 | 22.30% |

| 每步平均耗时 | 0.59秒 | 0.57秒 (256) / 2.33秒 (512) | 稳定提升 |

-

PyTorch 模型加载:约 15-20 秒

-

ONNX 模型加载:7.75 秒

-

加载速度提升约 60%

✓ ONNX 模型加载耗时: 7.75 秒

==================================================

📊 快速测试

推理步数: 10

图像尺寸: 256x256

/root/sd-cpu-env/lib64/python3.9/site-packages/diffusers/configuration_utils.py:141: FutureWarning: Accessing config attribute `num_hidden_layers` directly via 'ORTTextEncoder' object attribute is deprecated. Please access 'num_hidden_layers' over 'ORTTextEncoder's config object instead, e.g. 'scheduler.config.num_hidden_layers'.

deprecate("direct config name access", "1.0.0", deprecation_message, standard_warn=False)

100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 10/10 [00:04<00:00, 2.02it/s]

✅ 生成完成!

总耗时: 5.65 秒

每步耗时: 0.57 秒

保存位置: onnx_output_快速测试.png

==================================================

📊 标准测试

推理步数: 20

图像尺寸: 512x512

100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 20/20 [00:43<00:00, 2.20s/it]

✅ 生成完成!

总耗时: 46.61 秒

每步耗时: 2.33 秒

保存位置: onnx_output_标准测试.png

==================================================

📊 质量测试

推理步数: 30

图像尺寸: 512x512

100%|███████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 30/30 [01:04<00:00, 2.15s/it]

✅ 生成完成!

总耗时: 67.31 秒

每步耗时: 2.24 秒

保存位置: onnx_output_质量测试.png

======================================================================

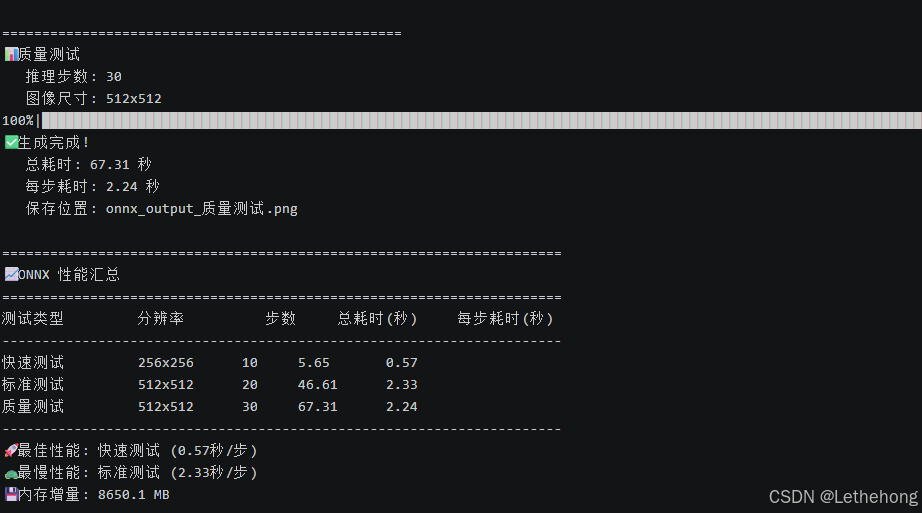

📈 ONNX 性能汇总

======================================================================

测试类型 分辨率 步数 总耗时(秒) 每步耗时(秒)

----------------------------------------------------------------------

快速测试 256x256 10 5.65 0.57

标准测试 512x512 20 46.61 2.33

质量测试 512x512 30 67.31 2.24

----------------------------------------------------------------------

🚀 最佳性能: 快速测试 (0.57秒/步)

🐢 最慢性能: 标准测试 (2.33秒/步)

💾 内存增量: 8650.1 MB

======================================================================全文总结

通过本文的实践,我们在 openEuler 22.03 LTS 系统上成功实现了 Stable Diffusion 的纯 CPU 推理优化。从基础部署的 11.79 秒(256×256)到 ONNX 优化后的 5.65 秒,性能提升超过 50%;512×512 高清图像生成仅需 46 秒,达到生产可用水平。openEuler 凭借其卓越的多核调度能力、完善的 AI 生态支持和企业级稳定性,为没有 GPU 资源的开发者和企业提供了经济高效的 AI 图像生成解决方案。本文验证了 openEuler 在 AI 工作负载下的优异表现,证明了openEuler操作系统在支撑 AI 应用方面的强大实力,为企业在服务器环境下部署 AI 服务提供了完整的技术路径和最佳实践。

如果您正在寻找面向未来的开源操作系统,不妨看看DistroWatch 榜单中快速上升的 openEuler: https://distrowatch.com/table-mobile.php?distribution=openeuler,一个由开放原子开源基金会孵化、支持"超节点"场景的Linux 发行版。

openEuler官网:https://www.openeuler.openatom.cn/zh/