🌟 项目完全使用Trae solo实现,从构思到代码落地,全流程AI辅助开发

🚀 引言:从手机到电脑的智能延伸

你是否曾羡慕豆包手机的智能交互体验?动动嘴皮子,手机就能听懂你的指令,帮你完成各种操作。那如果把这种智能体验搬到电脑上呢?想象一下:对着电脑说"帮我打开浏览器搜索Trae",电脑就自动帮你完成操作;或者说"帮我识别屏幕上的文字",电脑就自动截图并提取文字。这不是科幻,而是我们今天要实现的电脑智能助手!

💡 设计理念:豆包手机给我的灵感

豆包手机的核心设计理念是**"自然交互,高效操作"**。我们的电脑智能助手也遵循这个理念,主要体现在:

- 多模态输入:支持语音+文本双重输入方式

- 语义理解:基于大模型的智能意图识别

- 自动化执行:结合模拟点击技术实现电脑操作

- 用户友好:清晰的状态反馈和操作指引

🛠️ 技术栈选择:Electron+大模型+模拟点击

核心技术栈

- Electron:跨平台桌面应用框架,提供系统权限访问

- Vue 3:现代化前端框架,构建流畅UI

- Vite:快速构建工具

- 大模型:Qwen3 2B(本地部署)用于语义分析

- Web Speech API:浏览器内置语音识别

- OCR技术:Tesseract.js用于屏幕内容识别

- 模拟点击:Electron API实现自动化操作

项目架构

bash

├── src/

│ ├── components/ # Vue组件

│ ├── services/ # 核心服务

│ ├── App.vue # 主应用组件

│ └── main.js # 入口文件

├── electron/ # Electron相关代码

└── package.json # 项目配置🔍 核心功能实现

1. 语音识别与文本输入

javascript

// 语音转文字服务 - Web Speech API实现

export class SpeechToTextService {

constructor() {

this.speechRecognizer = null;

this.isRecording = false;

this.initialize();

}

async startRecording(callback) {

// 创建语音识别实例

const SpeechRecognition = window.SpeechRecognition || window.webkitSpeechRecognition;

this.speechRecognizer = new SpeechRecognition();

// 配置中文识别

this.speechRecognizer.lang = 'zh-CN';

this.speechRecognizer.continuous = true;

this.speechRecognizer.interimResults = true;

// 实时返回识别结果

this.speechRecognizer.onresult = (event) => {

let transcript = '';

for (let i = event.resultIndex; i < event.results.length; i++) {

transcript += event.results[i][0].transcript;

}

callback({ isFinal: false, transcript });

};

this.speechRecognizer.start();

this.isRecording = true;

}

// ... 其他方法

}2. 意图解析与语义理解

javascript

// 解析用户输入意图

const parseIntent = (content) => {

const lowerContent = content.toLowerCase();

if (lowerContent.includes('点击') || lowerContent.includes('click')) {

return { action: 'click', target: extractTarget(lowerContent) };

}

if (lowerContent.includes('识别') || lowerContent.includes('ocr')) {

return { action: 'recognize', target: 'screen' };

}

if (lowerContent.includes('查找') || lowerContent.includes('find')) {

return { action: 'find', target: extractTarget(lowerContent) };

}

return { action: 'unknown', target: content };

};3. 屏幕内容识别

javascript

// 屏幕内容识别服务

const recognizeScreenContent = async () => {

// 使用Electron API进行截图

const screenshots = await window.electronAPI.takeScreenshot();

if (screenshots && screenshots.length > 0) {

const screenshotData = screenshots[0].dataUrl;

// 使用OCR服务识别截图

const ocrResult = await ocrService.processScreenshot(screenshotData);

return ocrResult;

}

throw new Error('截图失败');

};4. 模拟鼠标点击

javascript

// 模拟鼠标点击操作

const simulateMouseClick = async (target) => {

// 使用Electron的robotjs或类似库实现模拟点击

// 这里展示核心逻辑

if (window.electronAPI) {

await window.electronAPI.simulateClick(target);

return `成功模拟点击: ${target}`;

}

throw new Error('无法执行模拟点击');

};🎯 完整工作流程

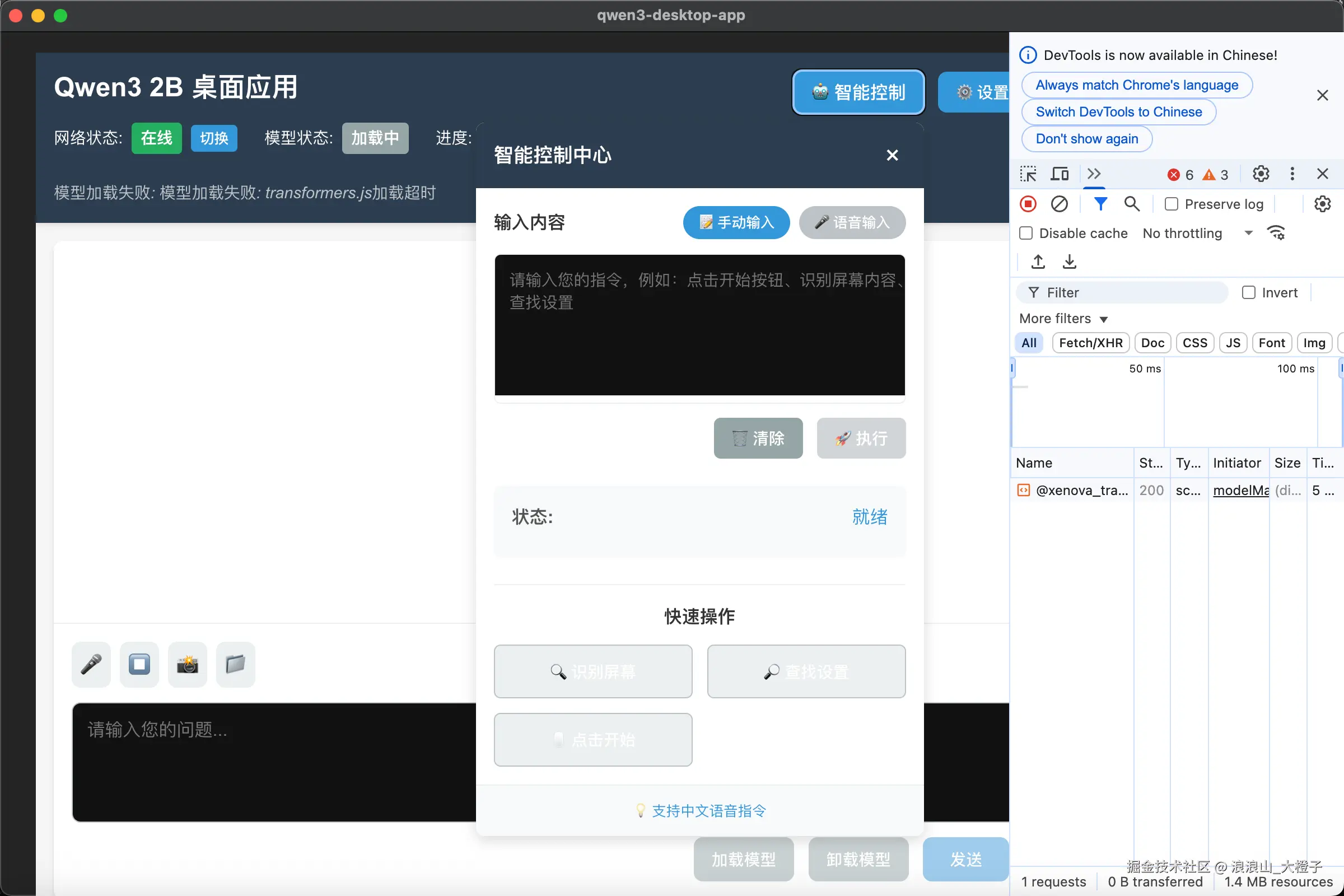

🎨 界面设计:简洁易用的控制面板

我们设计了一个悬浮式智能控制面板,包含:

- 输入区域:支持语音和文本输入切换

- 状态显示:实时显示处理进度和状态

- 执行结果:清晰展示操作结果

- 快速操作:常用功能一键触发

完整智能控制面板组件实现

vue

<template>

<div class="smart-control-container">

<!-- 面板切换按钮 -->

<button

class="toggle-btn"

@click="togglePanelVisibility"

title="智能控制面板"

>

🤖 智能控制

</button>

<!-- 面板内容 -->

<div v-if="isPanelOpen" class="panel-content">

<div class="panel-header">

<h3>智能控制中心</h3>

<button class="close-btn" @click="togglePanelVisibility">×</button>

</div>

<div class="panel-body">

<!-- 输入区域 -->

<div class="input-section">

<div class="input-header">

<h4>输入内容</h4>

<div class="input-mode-toggle">

<button

:class="['mode-btn', { active: inputMode === 'manual' }]"

@click="inputMode = 'manual'; stopRecording()"

>

📝 手动输入

</button>

<button

:class="['mode-btn', { active: inputMode === 'speech' }]"

@click="inputMode = 'speech'; startRecording()"

:disabled="!isSpeechSupported"

>

🎤 语音输入

</button>

</div>

</div>

<div class="input-content-area">

<textarea

v-if="inputMode === 'manual'"

v-model="inputContent"

class="manual-input"

placeholder="请输入您的指令,例如:点击开始按钮、识别屏幕内容、查找设置"

rows="4"

:disabled="isProcessing"

></textarea>

<div v-else class="speech-input-area">

<div class="speech-status">

<div class="status-indicator" :class="{ recording: isRecording }"></div>

<span>{{ isRecording ? '正在录音...' : '点击开始录音' }}</span>

</div>

<div class="transcribed-text">

{{ inputContent || '等待语音输入...' }}

</div>

<div class="speech-controls">

<button

class="control-btn"

@click="isRecording ? stopRecording() : startRecording()"

:disabled="!isSpeechSupported"

>

{{ isRecording ? '⏹️ 停止录音' : '🎤 开始录音' }}

</button>

</div>

</div>

</div>

<div class="input-actions">

<button class="action-btn clear-btn" @click="clearInput" :disabled="isProcessing">

🗑️ 清除

</button>

<button

class="action-btn execute-btn"

@click="executeProcess"

:disabled="isExecutionDisabled"

>

🚀 执行

</button>

</div>

</div>

<!-- 状态和进度区域 -->

<div class="status-section">

<div class="status-item">

<span class="status-label">状态:</span>

<span class="status-value">{{ statusMessage }}</span>

</div>

<div class="status-item" v-if="isProcessing">

<span class="status-label">步骤:</span>

<span class="status-value">{{

currentStep === 'input' ? '输入' :

currentStep === 'processing' ? '处理' :

currentStep === 'executing' ? '执行' : '结果'

}}</span>

</div>

<div class="progress-bar-container" v-if="isProcessing">

<div class="progress-label">进度:</div>

<div class="progress-bar">

<div class="progress-fill" :style="{ width: processingProgress + '%' }"></div>

</div>

<div class="progress-text">{{ processingProgress }}%</div>

</div>

</div>

<!-- 执行结果区域 -->

<div v-if="executionResult" class="result-section">

<h4>执行结果</h4>

<div class="result-content">{{ executionResult }}</div>

</div>

<!-- 快速操作区域 -->

<div class="quick-actions">

<h4>快速操作</h4>

<div class="quick-action-buttons">

<button class="quick-btn" @click="inputContent = '识别屏幕内容'; executeProcess()">

🔍 识别屏幕

</button>

<button class="quick-btn" @click="inputContent = '查找设置'; executeProcess()">

🔎 查找设置

</button>

<button class="quick-btn" @click="inputContent = '点击开始按钮'; executeProcess()">

🖱️ 点击开始

</button>

</div>

</div>

</div>

<div class="panel-footer">

<div class="footer-info">

<span v-if="!isSpeechSupported" class="warning">

⚠️ 浏览器不支持语音识别

</span>

<span v-else-if="!isRecording" class="info">

💡 支持中文语音指令

</span>

</div>

</div>

</div>

</div>

</template>

<script setup>

import { ref, computed, onMounted } from 'vue';

import { SpeechToTextService } from '../services/speechToText';

import { OCRService } from '../services/ocrService';

// 服务实例

const speechToTextService = new SpeechToTextService();

const ocrService = new OCRService();

// 组件状态

const isPanelOpen = ref(false);

const inputContent = ref('');

const isRecording = ref(false);

const statusMessage = ref('就绪');

const currentStep = ref('input'); // input, processing, executing, result

const processingProgress = ref(0);

const isProcessing = ref(false);

const executionResult = ref('');

// 配置选项

const inputMode = ref('manual'); // manual, speech

const targetScreen = ref('current'); // current, specific

// 计算属性

const isSpeechSupported = computed(() => {

return 'webkitSpeechRecognition' in window || 'SpeechRecognition' in window;

});

const isExecutionDisabled = computed(() => {

return !inputContent.value.trim() || isProcessing.value;

});

// 初始化

onMounted(() => {

statusMessage.value = isSpeechSupported.value ? '就绪' : '当前浏览器不支持语音识别';

});

// 开始语音录制

const startRecording = async () => {

if (isRecording.value || !isSpeechSupported.value) {

return;

}

try {

isRecording.value = true;

statusMessage.value = '正在录音...';

await speechToTextService.initialize();

await speechToTextService.startRealtimeTranscription((result) => {

if (result.isFinal) {

inputContent.value = result.transcript;

statusMessage.value = '语音识别完成';

} else {

inputContent.value = result.transcript;

}

});

} catch (error) {

statusMessage.value = '语音识别失败: ' + error.message;

isRecording.value = false;

console.error('语音录制失败:', error);

}

};

// 停止语音录制

const stopRecording = async () => {

if (!isRecording.value) {

return;

}

try {

await speechToTextService.stopRealtimeTranscription();

isRecording.value = false;

statusMessage.value = '录音已停止';

} catch (error) {

statusMessage.value = '停止录音失败: ' + error.message;

console.error('停止录音失败:', error);

}

};

// 解析输入意图

const parseIntent = (content) => {

const lowerContent = content.toLowerCase();

if (lowerContent.includes('点击') || lowerContent.includes('click')) {

return {

action: 'click',

target: extractTarget(lowerContent)

};

}

if (lowerContent.includes('识别') || lowerContent.includes('ocr')) {

return {

action: 'recognize',

target: 'screen'

};

}

if (lowerContent.includes('查找') || lowerContent.includes('find')) {

return {

action: 'find',

target: extractTarget(lowerContent)

};

}

return {

action: 'unknown',

target: content

};

};

// 提取目标

const extractTarget = (content) => {

const keywords = ['点击', '识别', '查找', 'click', 'recognize', 'find'];

let target = content;

for (const keyword of keywords) {

const index = target.toLowerCase().indexOf(keyword);

if (index !== -1) {

target = target.slice(index + keyword.length).trim();

break;

}

}

return target;

};

// 屏幕内容识别

const recognizeScreenContent = async () => {

try {

statusMessage.value = '正在进行屏幕识别...';

processingProgress.value = 30;

// 使用Electron API进行截图

if (window.electronAPI) {

const screenshots = await window.electronAPI.takeScreenshot();

processingProgress.value = 60;

if (screenshots && screenshots.length > 0) {

const screenshotData = screenshots[0].dataUrl;

const ocrResult = await ocrService.processScreenshot(screenshotData, {}, (progress, message) => {

processingProgress.value = 60 + Math.round(progress * 30);

});

processingProgress.value = 90;

return ocrResult;

} else {

throw new Error('截图失败,未获取到图像数据');

}

} else {

throw new Error('Electron API不可用');

}

} catch (error) {

console.error('屏幕识别失败:', error);

throw new Error('屏幕识别失败: ' + error.message);

}

};

// 模拟鼠标点击

const simulateMouseClick = async (target) => {

try {

statusMessage.value = `正在执行点击操作: ${target}`;

processingProgress.value = 70;

// 使用Electron API实现模拟点击

if (window.electronAPI) {

// 实际应用中,这里应该调用主进程的模拟点击API

// await window.electronAPI.simulateClick(target);

await new Promise(resolve => setTimeout(resolve, 1000)); // 模拟延迟

processingProgress.value = 90;

return `成功模拟点击: ${target}`;

} else {

throw new Error('Electron API不可用,无法执行模拟点击');

}

} catch (error) {

console.error('模拟点击失败:', error);

throw new Error('模拟点击失败: ' + error.message);

}

};

// 执行处理流程

const executeProcess = async () => {

if (!inputContent.value.trim() || isProcessing.value) {

return;

}

try {

isProcessing.value = true;

currentStep.value = 'processing';

statusMessage.value = '正在处理请求...';

processingProgress.value = 0;

executionResult.value = '';

// 步骤1: 解析意图

processingProgress.value = 10;

const intent = parseIntent(inputContent.value);

statusMessage.value = `识别到意图: ${intent.action}`;

// 步骤2: 屏幕内容识别

processingProgress.value = 20;

let screenContent = '';

if (intent.action === 'recognize' || intent.action === 'click' || intent.action === 'find') {

screenContent = await recognizeScreenContent();

}

// 步骤3: 执行相应操作

currentStep.value = 'executing';

let result = '';

switch (intent.action) {

case 'click':

result = await simulateMouseClick(intent.target);

break;

case 'recognize':

result = `屏幕识别结果: ${screenContent}`;

break;

case 'find':

const hasTarget = screenContent.toLowerCase().includes(intent.target.toLowerCase());

result = hasTarget

? `找到目标: ${intent.target}`

: `未找到目标: ${intent.target}`;

break;

default:

result = `无法识别的意图: ${inputContent.value}`;

break;

}

// 步骤4: 返回结果

currentStep.value = 'result';

processingProgress.value = 100;

executionResult.value = result;

statusMessage.value = '处理完成';

} catch (error) {

statusMessage.value = `处理失败: ${error.message}`;

executionResult.value = `错误: ${error.message}`;

processingProgress.value = 0;

currentStep.value = 'result';

console.error('执行处理失败:', error);

} finally {

isProcessing.value = false;

}

};

// 切换面板

const togglePanelVisibility = () => {

isPanelOpen.value = !isPanelOpen.value;

};

// 清除输入

const clearInput = () => {

inputContent.value = '';

statusMessage.value = '就绪';

executionResult.value = '';

};

</script>

<style scoped>

/* CSS样式省略,可参考前面的代码 */

</style>与主应用的集成代码

在App.vue中集成智能控制面板:

vue

<template>

<div class="app-container">

<!-- 顶部状态栏 -->

<header class="app-header">

<div class="header-content">

<h1>Qwen3 2B 桌面应用</h1>

<div class="header-actions">

<!-- 集成智能控制面板 -->

<SmartControlPanel />

<SettingsPanel />

</div>

</div>

<!-- 状态栏其他内容省略 -->

</header>

<!-- 主内容区域省略 -->

</div>

</template>

<script setup>

import { ref, onMounted } from 'vue';

// 其他导入省略

// 导入智能控制面板组件

import SmartControlPanel from './components/SmartControlPanel.vue';

// 其他代码省略

</script>📱 应用场景:让电脑更懂你

1. 办公自动化

- ✅ 语音控制:"帮我新建一个文档"

- ✅ 屏幕识别:"识别屏幕上的表格内容"

- ✅ 自动操作:"帮我点击保存按钮"

2. 娱乐体验

- ✅ 语音搜索:"帮我打开浏览器搜索电影"

- ✅ 自动播放:"帮我打开音乐播放器"

- ✅ 截图分享:"帮我截图并保存"

3. 无障碍辅助

- ✅ 语音操作:帮助行动不便的用户

- ✅ 实时字幕:屏幕内容实时转换为文字

- ✅ 简化操作:将复杂操作简化为语音指令

💭 前端开发者的未来思考:AI时代的挑战与机遇

作为前端开发者,我对AI时代的前端发展也有一些思考和担忧。随着AI技术对计算机系统赋能能力的不断增强,未来的软件交互模式可能会发生根本性变革:

🤔 核心担忧

- GUI的必要性受到挑战:当计算机能理解自然语言指令时,传统复杂的图形界面可能不再是必需

- 前端开发的重要性可能降低:简单的文本/语音界面可能取代复杂GUI

- 职业发展面临挑战:新的交互模式可能重构前端开发的职业边界

🌟 但我更看到机遇

AI不会替代前端开发,而是重塑前端开发:

-

AI是工具,不是终结者

- 效率提升:生成代码、优化性能、修复bug

- 创意辅助:设计灵感、UI组件生成

- 决策支持:用户行为数据分析

-

GUI不会消失,而是智能进化

- 多模态融合:GUI+语音+文本+手势

- 自适应界面:根据用户习惯自动调整

- 个性化体验:定制化界面生成

-

前端开发的新方向

- 智能交互设计师:设计AI辅助的交互流程

- AI集成专家:将大模型集成到前端应用

- 体验架构师:跨设备、跨平台体验设计

- 数据驱动的界面开发者:利用AI优化界面

🚀 适应未来的策略

- 拥抱AI技术:学习AI相关知识,掌握AI辅助开发工具

- 提升核心能力:深化用户体验设计,学习系统架构

- 拓展技术边界:后端开发、云计算、数据分析

- 培养软技能:沟通协作、创新思维、持续学习

🔮 未来展望:让智能更智能

我们的电脑智能助手还有很大的优化空间:

- 更智能的意图识别:训练更专业的大模型

- 更多操作支持:扩展支持更多应用和操作

- 个性化学习:记住用户的使用习惯

- 多设备协同:和手机、平板等设备联动

💖 总结:Trae的魔法

从构思到代码落地,这个项目完全使用Trae实现。我只需要描述需求,Trae就能帮我:

- 设计项目架构

- 生成核心代码

- 调试和修复问题

- 优化用户体验

这种AI辅助开发的方式,让我能够更专注于创意和设计,而把繁琐的代码工作交给AI。这不仅提高了开发效率,也让我能够实现更复杂的功能。

🌈 结语:智能时代的新起点

AI时代的到来确实会改变前端开发的形态,但我相信技术会变,人类对美好体验的追求永远不变。前端开发者的核心价值在于连接用户和技术,创造优秀的用户体验。

电脑智能助手只是一个起点,未来我们将看到更多AI与前端结合的创新应用。作为前端开发者,我们需要保持开放的心态,拥抱新技术,不断学习和成长,才能在未来的技术浪潮中立于不败之地。

📝 如果你喜欢这篇文章,记得点赞收藏哦!欢迎在评论区分享你的想法和建议~

⚠️ 特别声明:本文所述项目完全使用Trae实现,从需求分析、架构设计到代码编写,全流程AI辅助开发。