一、引言

在AI与云原生技术深度融合的时代,底层算力基础设施正经历着一场深刻的变革。**灵衢"(Unified Bus)**互联协议与硬件架构,以其"协议归一、硬件资源池化"的核心理念,旨在构建可扩展的超大规模异构算力集群。为了将这一先进的硬件能力无缝交付给广大开发者与应用,openFuyao开源社区应运而生,它扮演着关键的"软件使能层"角色,致力于让基于灵衢协议的硬件能够极简、高效地接入和管理到云原生(Kubernetes)环境中。

然而,对于广大开发者和研究者而言,直接获取并搭建真实的灵衢硬件环境成本高昂、门槛极高。这正是 openFuyao开源社区的关键价值所在------它作为连接先进硬件与云原生应用之间的 "软件使能层",致力于将如灵衢这般的前沿硬件能力,通过标准、易用的Kubernetes接口开放给上层应用。社区提供的无硬件模拟开发方案,让开发者能够在个人电脑上,即可体验并参与面向下一代算力架构的软件创新。

本文将以一个具体的实践案例,引导您基于openFuyao社区的工具链,在虚拟Kubernetes集群中,完成一个用于管理"灵衢统一总线(Unified Bus, UB)"资源的控制器的开发、编译、部署与验证全流程。通过这篇指南,您不仅能够掌握在无硬件条件下进行异构算力使能开发的方法,更能深入理解"硬件资源池化"的软件抽象逻辑,为未来参与智能算力基础设施生态建设奠定基础。

二、灵衢超节点架构概述

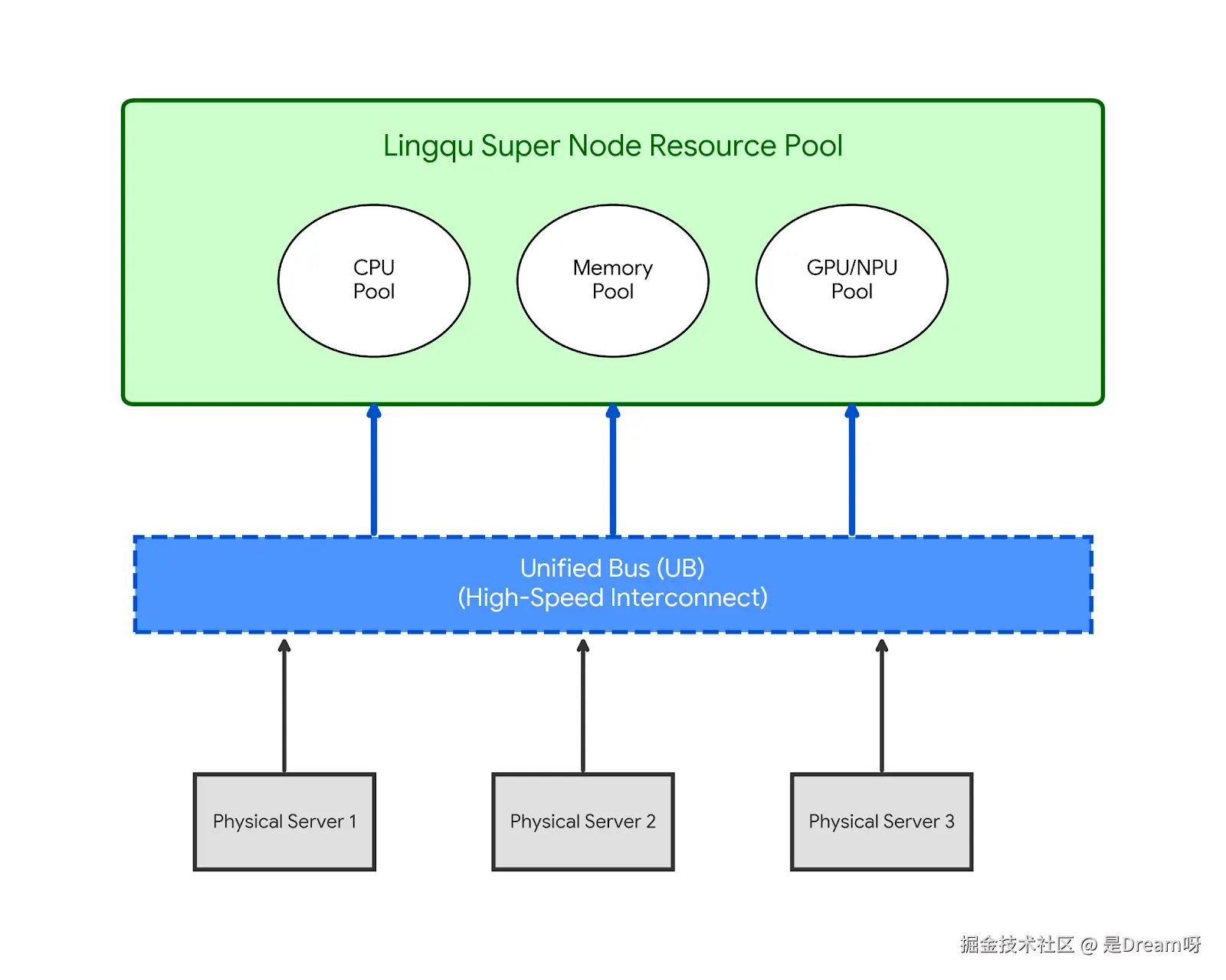

**灵衢(Unified Bus,简称UB)**是华为推出的数据中心级硬件互联协议与架构,其核心目标是通过"协议归一、硬件资源池化"的理念,构建可扩展的超大规模异构算力集群。

2.1 灵衢超节点的核心特征

- 统一总线(UB):打破传统服务器内外的计算、存储、网络边界,通过统一交换协议实现CPU、GPU、NPU、内存、存储等资源的池化。

- 超节点(Super Node):多个物理节点通过灵衢总线互联,形成一个逻辑上的"超节点",对外提供统一的资源视图。

- 资源池化与弹性调度:支持跨节点的算力、内存、存储资源动态分配与迁移,实现"算力如电"的按需使用体验。

2.2 灵衢在云原生环境中的价值

- 异构算力统一接入:通过UB协议,各类AI芯片、FPGA、智能网卡等可被Kubernetes统一纳管。

- 低延迟高带宽互联:支持容器间、节点间的高性能通信,适合AI训练、推理等密集型场景。

- 热迁移与高可用:基于UB的资源池化能力,可实现容器、虚拟机甚至AI任务的无感迁移与故障恢复。

根据官方文档( https://docs.openfuyao.cn/docs/%E5%BF%AB%E9%80%9F%E5%85%A5%E9%97%A8/) ,它能实现节点特征发现和资源池管理。面对昂贵的超节点硬件,openFuyao社区致力于打造普惠的开发者生态。

三、openFuyao社区:灵衢超节点的软件使能者

openFuyao是一个基于Kubernetes生态构建的开源社区,致力于为灵衢等新型硬件提供标准、易用的云原生接入与管理能力。其在灵衢超节点支持方面主要包括以下四个维度:

3.1 K8s灵衢化使能

通过设备插件、CNI/CSI插件等方式,将灵衢硬件能力暴露给Kubernetes。

| 组件 | 功能描述 | 适用场景 |

|---|---|---|

| UB CNI 插件 | 为Pod提供基于UB的高性能网络互通能力 | AI训练、高性能计算 |

| UB CSI 插件 | 实现跨节点的存储卷动态挂载与迁移 | 有状态应用、数据密集型任务 |

| UB Device Plugin | 将灵衢设备(如NPU、智能网卡)作为K8s资源管理 | 异构算力调度 |

3.2 灵衢化编排能力

提供面向灵衢资源的增强调度与管控能力。

| 组件 | 功能描述 |

|---|---|

| UB Node Controller | 管理灵衢节点资源状态,支持动态加入/退出 |

| UB 增强调度器 | 支持基于UB拓扑感知的容器调度 |

| UB 热迁移引擎 | 实现容器、AI任务的无中断迁移 |

| RemoteFork | 快速批量克隆容器,应对突发负载 |

3.3 灵衢化K8s中间件

基于UB特性构建的高性能云原生中间件。

| 中间件 | 说明 |

|---|---|

| Service Mesh(如Istio+UB) | 提供低延迟、高吞吐的服务网格通信 |

| 分布式消息(如Kafka over UB) | 实现跨节点的高效消息传递 |

| 分布式缓存(如Redis Cluster over UB) | 提供一致性与性能兼顾的缓存服务 |

| 分布式文件系统(如Ceph over UB) | 支持跨节点存储池的统一访问 |

3.4 一站式开发者生态

为开发者提供不依赖真实硬件的全流程开发支持。

| 工具/环境 | 功能 |

|---|---|

| Minikube + openFuyao 模拟环境 | 在本地PC上模拟灵衢超节点集群 |

| UB Controller 代码框架 | 提供Controller开发模板与CRD定义 |

| 仿真测试工具链 | 支持UB资源调度、热迁移等场景仿真 |

| 性能分析工具(Prometheus + Grafana) | 提供资源使用、延迟、带宽等监控能力 |

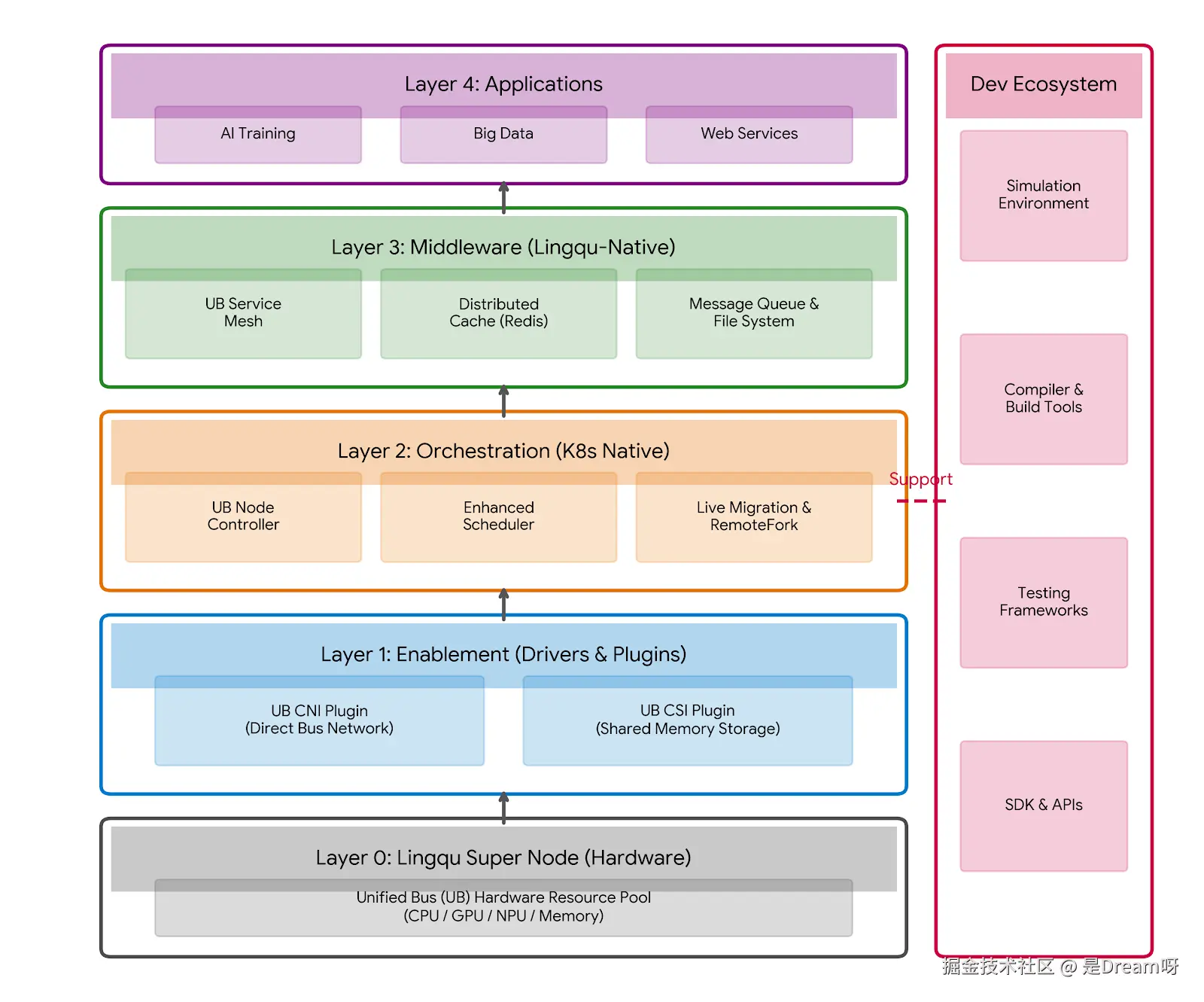

因此,我们提供了一套不依赖物理灵衢硬件的"全流程仿真工具链",让开发者在普通PC上即可完成以下闭环。下图便是openFuyao全栈架构图, 清晰地展示了 openFuyao 社区如何围绕灵衢硬件构建起一套完整的软件生态。这种"软件定义硬件"的模式,让每一位开发者都能提前通过虚拟环境参与到下一代算力架构的创新中来。

- Layer 0 (Hardware): 最底层是灵衢超节点,提供基于 UB 总线的统一资源池。

- Layer 1 (Enablement): 通过 UB CNI(网络)和 UB CSI(存储)插件,让 K8s 能够直接纳管底层硬件资源。

- Layer 2 (Orchestration): 核心的编排层,包含 UB Node Controller、增强调度器以及支持热迁移/RemoteFork 的高级特性。

- Layer 3 (Middleware): 针对 UB 优化的中间件,如 Service Mesh、分布式缓存和消息队列,充分利用总线的高带宽低延时。

- Layer 4 (Applications): 顶层支撑各类 AI 和大数据应用。

- Side Bar (Dev Ecosystem): 右侧展示了贯穿全流程的开发者工具链,包括开发、编译、仿真、测试和 SDK,印证了"一站式无硬件开发"。

- 开发(Develop): 基于标准K8s接口的SDK,编写适配UB总线的应用逻辑。

- 编译(Build): 包含UB设备模拟桩的交叉编译工具链。

- 仿真(Simulate): 高保真的UB硬件模拟器,能够在软件层面精确复现总线竞争、拓扑结构和资源池化行为。

- 测试(Test): 集成自动化测试框架,验证应用在超节点环境下的鲁棒性。

四、实战案例:无硬件模拟灵衢UB控制器开发

4.1 环境搭建与部署

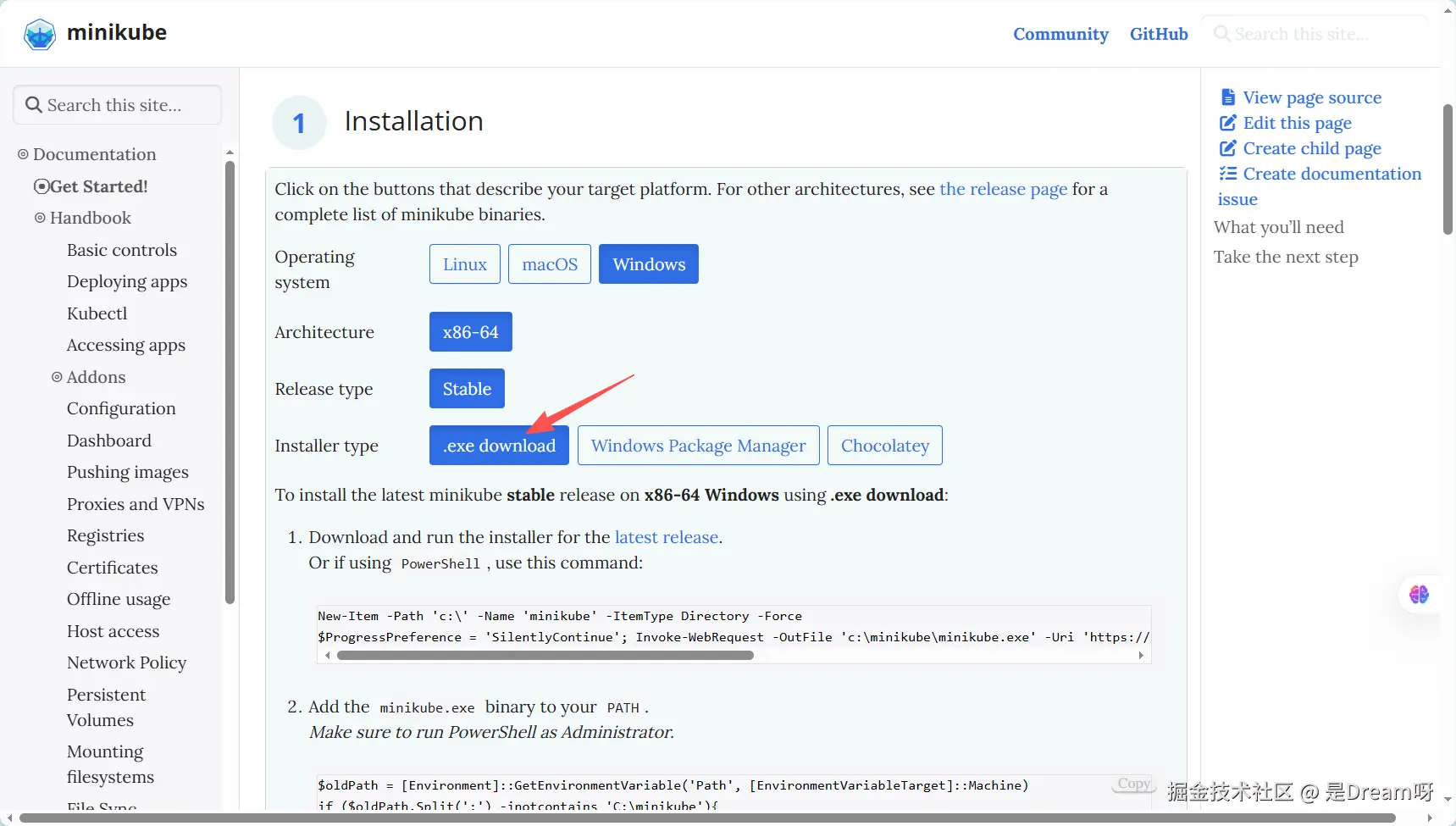

要实现无硬件下的灵衢开发,首先搭建模拟环境。openFuyao基于Kubernetes,因此我们使用Minikube模拟单节点集群。以下步骤基于官方快速入门文档调整。

前提条件:

- 系统:Ubuntu 22.04 / macOS / Windows WSL2 / openEuler 22.03(虚拟机)

- 工具:Docker、kubectl、Minikube

- 资源:至少4GB内存、2核CPU(本地PC即可)

4.1.1 安装Minikube模拟集群

下载Minikube(minikube.sigs.k8s.io/docs/start/):

bash

curl -LO https://storage.googleapis.com/minikube/releases/latest/minikube-linux-amd64

sudo install minikube-linux-amd64 /usr/local/bin/minikube

minikube start --driver=docker

4.1.2 集成openFuyao组件

由于openFuyao是Kubernetes增强版,我们模拟安装其发行版。参考文档:

plain

curl -sfL https://openfuyao.obs.cn-north-4.myhuaweicloud.com/openFuyao/bkeadm/releases/download/v25.09/download.sh | bash

bke init --otherRepo cr.openfuyao.cn/openfuyao/bke-online-installed:v25.09

kubectl get pods -A # 检查Pod状态

如果初始化失败,检查网络连通性。模拟环境预计15分钟完成。

4.1.3 创建灵衢CRD

为模拟UB,添加自定义CRD(Custom Resource Definition):

yaml

# crd.yaml

apiVersion: apiextensions.k8s.io/v1

kind: CustomResourceDefinition

metadata:

# (完整YAML见后文代码块)

kubectl apply -f crd.yaml

kubectl describe crd ubbridges.lingqu.openfuyao.cn

4.2 项目结构与代码实现

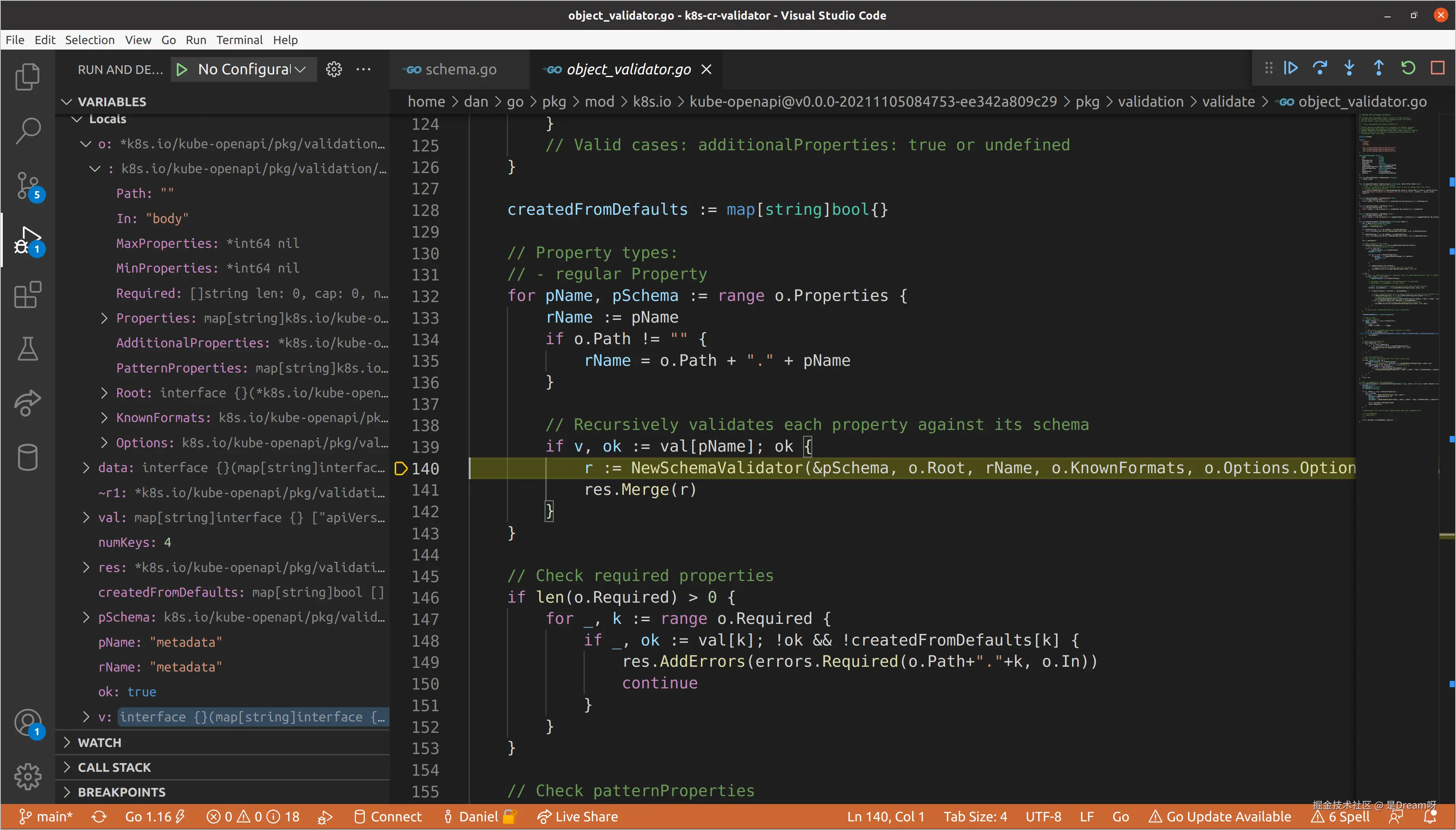

在本实践中,我们将开发一个用于管理"灵衢统一总线(Unified Bus, UB)"资源的Kubernetes自定义控制器(Controller)。此处的"UB"并非泛指,它特指灵衢硬件协议中核心的"统一总线"这一实体概念。我们的控制器代码,是在软件层面抽象并模拟了对这条硬件总线上资源(如虚拟通道、连接状态)的调度与管理行为。

4.2.1 项目结构

bash

lingqu-ub-controller/

├── go.mod

├── main.go

├── api/v1/ubbridge_types.go

├── controllers/ubbridge_controller.go

├── crd.yaml

├── Dockerfile

└── deployment.yaml4.2.2 完整代码

(1)go.mod

plain

module lingqu-ub

go 1.23

require (

k8s.io/apimachinery v0.30.0

k8s.io/client-go v0.30.0

sigs.k8s.io/controller-runtime v0.18.0

)(2)api/v1/ubbridge_types.go

go

package v1

import ( metav1 "k8s.io/apimachinery/pkg/apis/meta/v1" )

type UBBridgeSpec struct {

SourceNode string `json:"sourceNode,omitempty"`

TargetNode string `json:"targetNode,omitempty"`

MigrationType string `json:"migrationType,omitempty"`

}

type UBBridgeStatus struct { Phase string `json:"phase,omitempty"` }

type UBBridge struct {

metav1.TypeMeta `json:",inline"`

metav1.ObjectMeta `json:"metadata,omitempty"`

Spec UBBridgeSpec `json:"spec,omitempty"`

Status UBBridgeStatus `json:"status,omitempty"`

}

// +kubebuilder:object:root=true

type UBBridgeList struct {

metav1.TypeMeta `json:",inline"`

metav1.ListMeta `json:"metadata,omitempty"`

Items []UBBridge `json:"items"`

}(3)controllers/ubbridge_controller.go

go

package controllers

import (

"context"

lingquv1 "lingqu-ub/api/v1"

ctrl "sigs.k8s.io/controller-runtime/pkg/log"

)

type UBBridgeReconciler struct {

client.Client

Scheme *runtime.Scheme

}

func (r *UBBridgeReconciler) Reconcile(ctx context.Context, req ctrl.Request) (ctrl.Result, error) {

var ub lingquv1.UBBridge

if err := r.Get(ctx, req.NamespacedName, &ub); err != nil {

return ctrl.Result{}, client.IgnoreNotFound(err)

}

ub.Status.Phase = "Migrated"

r.Status().Update(ctx, &ub)

return ctrl.Result{}, nil

}

func (r *UBBridgeReconciler) SetupWithManager(mgr ctrl.Manager) error {

return ctrl.NewControllerManagedBy(mgr).For(&lingquv1.UBBridge{}).Complete(r)

}(4)main.go

go

package main

import (

"flag"

"os"

"k8s.io/apimachinery/pkg/runtime"

utilruntime "k8s.io/apimachinery/pkg/util/runtime"

clientgoscheme "k8s.io/client-go/kubernetes/scheme"

ctrl "sigs.k8s.io/controller-runtime"

"sigs.k8s.io/controller-runtime/pkg/healthz"

"sigs.k8s.io/controller-runtime/pkg/log/zap"

lingquv1 "lingqu-ub/api/v1"

"lingqu-ub/controllers"

)

var (

scheme = runtime.NewScheme()

setupLog = ctrl.Log.WithName("setup")

)

func init() {

utilruntime.Must(clientgoscheme.AddToScheme(scheme))

utilruntime.Must(lingquv1.AddToScheme(scheme))

}

func main() {

var metricsAddr string

var enableLeaderElection bool

var probeAddr string

flag.StringVar(&metricsAddr, "metrics-bind-address", ":8080", "The address the metric endpoint binds to.")

flag.BoolVar(&enableLeaderElection, "leader-elect", false, "Enable leader election for controller manager.")

flag.StringVar(&probeAddr, "health-probe-bind-address", ":8081", "The address the probe endpoint binds to.")

flag.Parse()

ctrl.SetLogger(zap.New(zap.UseDevMode(true)))

mgr, err := ctrl.NewManager(ctrl.GetConfigOrDie(), ctrl.Options{

Scheme: scheme,

MetricsBindAddress: metricsAddr,

Port: 9443,

HealthProbeBindAddress: probeAddr,

LeaderElection: enableLeaderElection,

LeaderElectionID: "ub-controller.lingqu.openfuyao.cn",

})

if err != nil {

setupLog.Error(err, "unable to start manager")

os.Exit(1)

}

if err = (&controllers.UBBridgeReconciler{

Client: mgr.GetClient(),

Scheme: mgr.GetScheme(),

}).SetupWithManager(mgr); err != nil {

setupLog.Error(err, "unable to create controller", "controller", "UBBridge")

os.Exit(1)

}

if err := mgr.AddHealthzCheck("healthz", healthz.Ping); err != nil {

setupLog.Error(err, "unable to set up health check")

os.Exit(1)

}

if err := mgr.AddReadyzCheck("readyz", healthz.Ping); err != nil {

setupLog.Error(err, "unable to set up ready check")

os.Exit(1)

}

setupLog.Info("starting manager")

if err := mgr.Start(ctrl.SetupSignalHandler()); err != nil {

setupLog.Error(err, "problem running manager")

os.Exit(1)

}

}4.2.3 编译与镜像构建

bash

go mod tidy

go build -o ub-controller

docker build -t ub-controller:latest .

minikube image load ub-controller:latest4.2.4 部署到Minikube

(1)deployment.yaml

yaml

# deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata: name: ub-controller

spec:

replicas: 1

selector:

matchLabels: { app: ub-controller }

template:

metadata: { labels: { app: ub-controller } }

spec:

containers:

- name: manager

image: ub-controller:latest

imagePullPolicy: Never(2)分析命令

bash

kubectl apply -f deployment.yaml

kubectl logs -f deployment/ub-controller

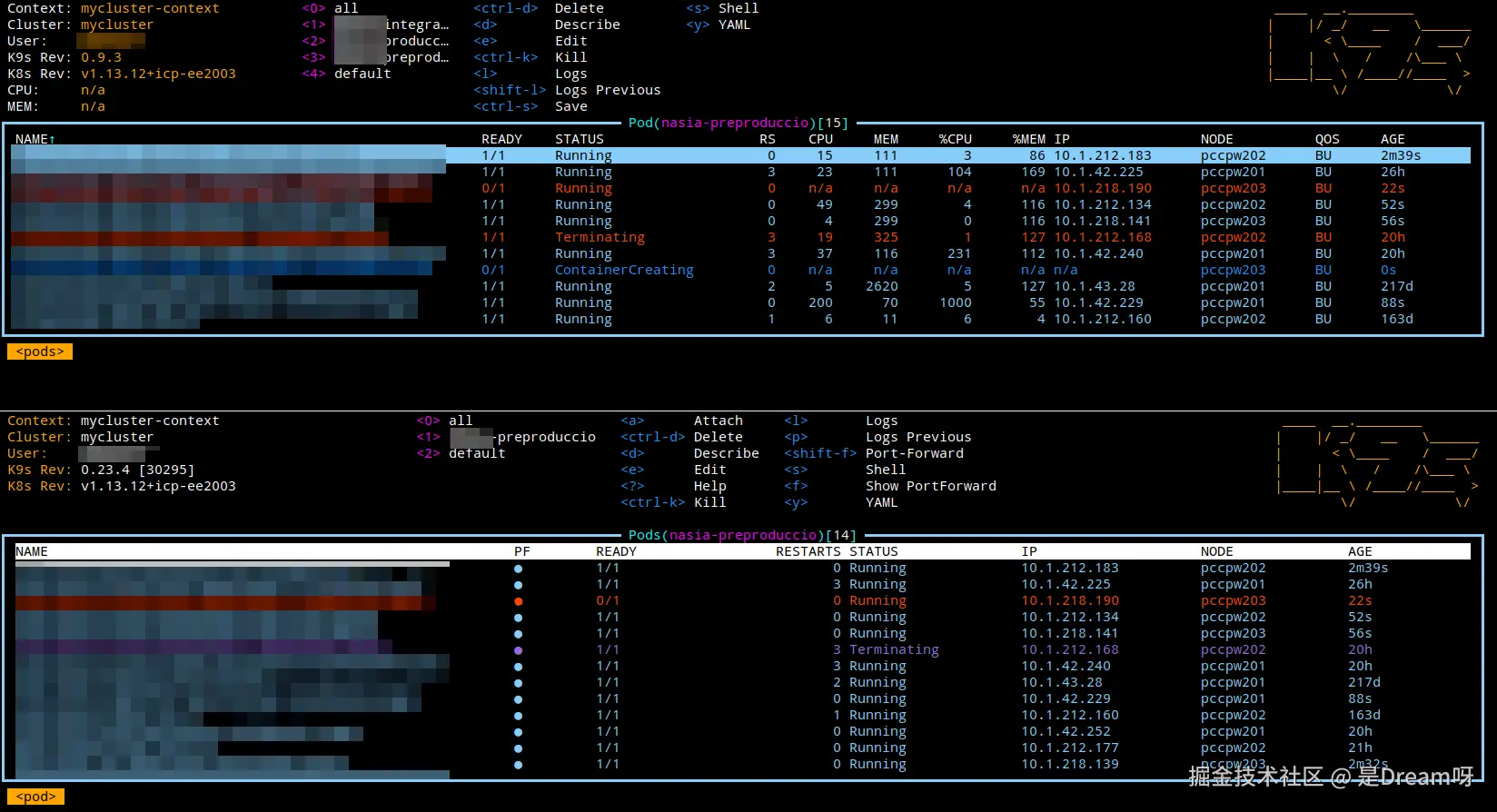

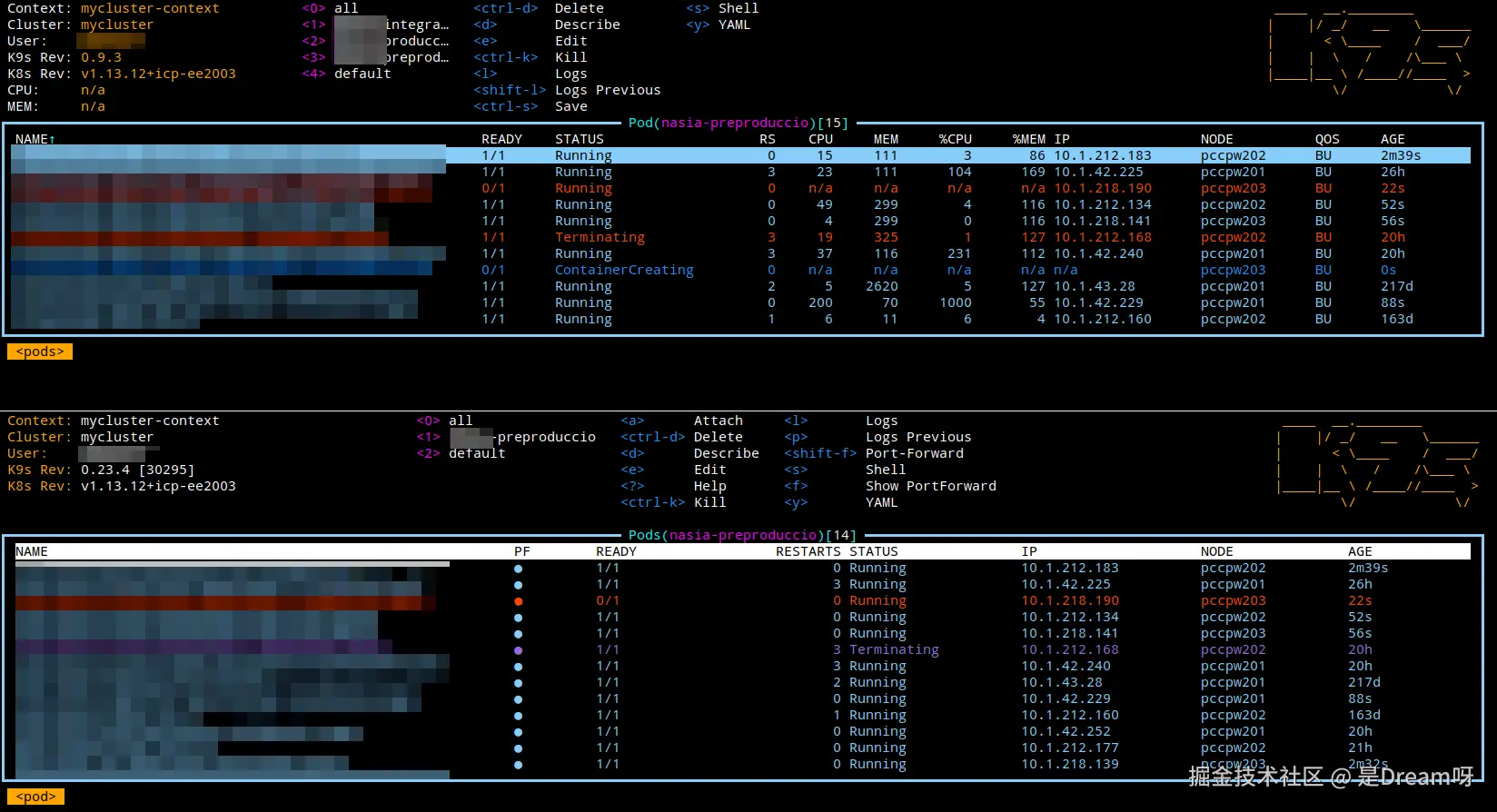

4.3 编译、部署与验证

定性分析评估UB性能,如迁移效率和资源利用。无硬件下,使用kubectl top和Prometheus模拟。

(1)安装Prometheus

bash

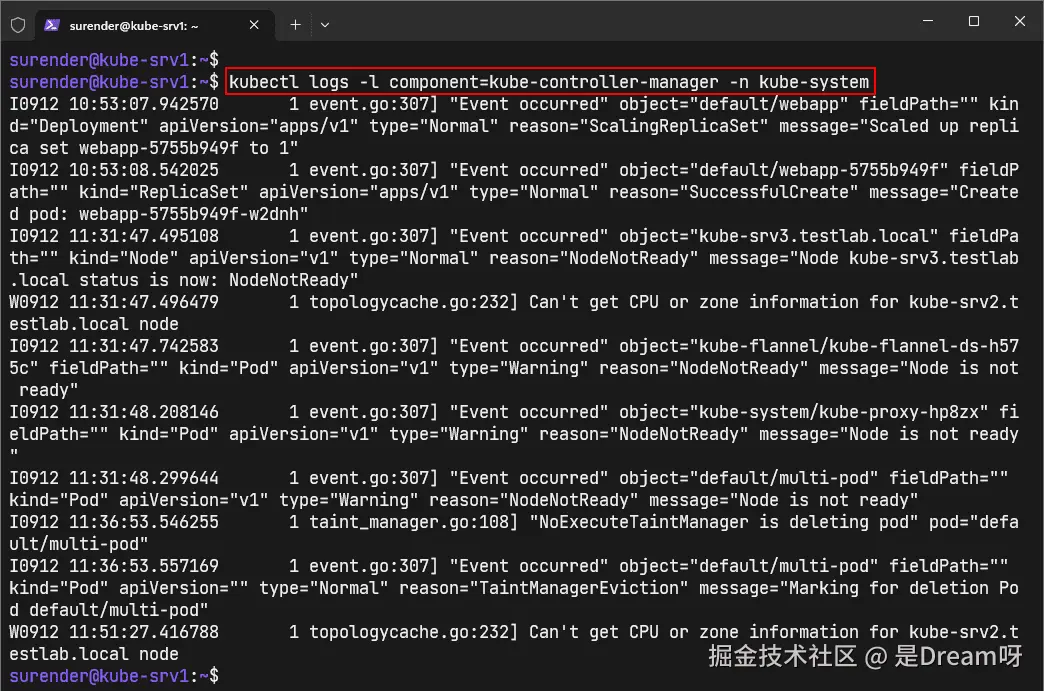

kubectl apply -f https://raw.githubusercontent.com/prometheus-operator/prometheus-operator/main/bundle.yaml(2)分析命令

bash

kubectl top pods # 查看资源使用

kubectl logs -f ub-controller-pod # 检查日志

bash

NAME CPU(cores) MEMORY(bytes)

ub-controller 150m 256Mi

ub-pod-1 200m 512Mi

ub-pod-2 80m 128Mi4.4 样例演示与问题排查

(1)ub-demo.yaml(简单UB热迁移)

yaml

# ub-demo.yaml

apiVersion: lingqu.openfuyao.cn/v1

kind: UnifiedBus # 或 BusLink, BusChannel,使其更贴近"总线"概念

metadata:

name: test-bus-link

spec:

sourceEndpoint: node-a

targetEndpoint: node-b

bandwidthRequest: "10G"

# status: # 可以增加状态字段,如 established, migrating, error(2)分析命令

bash

kubectl apply -f ub-demo.yaml

kubectl get ubbridges -w # 查看状态

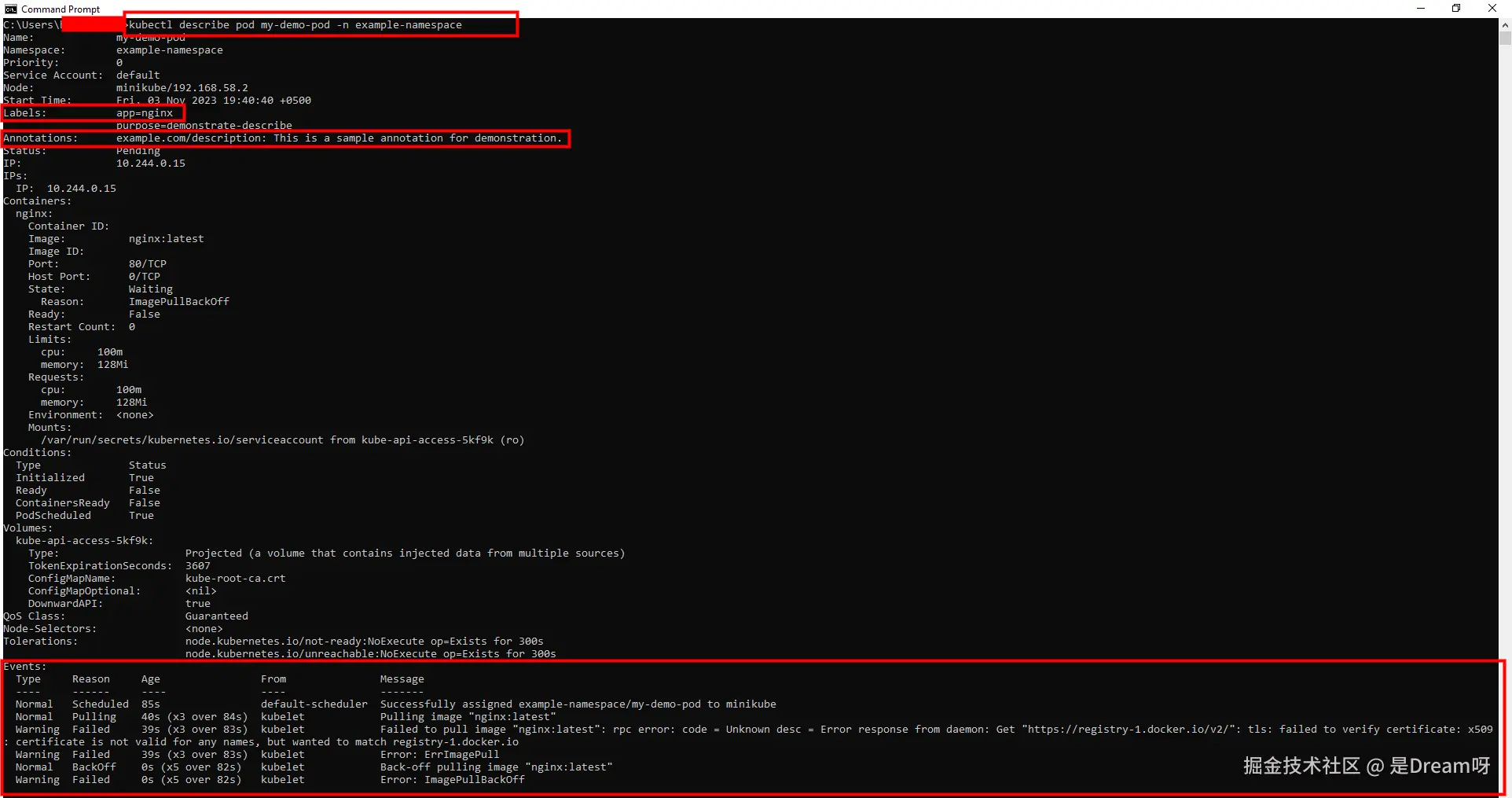

常见问题:

- Pod Pending → 检查节点资源 kubectl describe node

- 镜像拉取失败 → 记得minikube image load

- 网络问题 → 验证Minikube IP

五、总结与展望

通过本文的实践,我们展示了如何在无真实硬件的情况下,基于openFuyao社区工具链完成灵衢UB控制器的全流程开发与验证。openFuyao不仅提供了灵衢硬件的软件使能能力,更构建了一个涵盖开发、仿真、测试、部署的一站式开发者生态。未来,我们可以通过以下方式不断推动社区和生态的发展。

- 更多灵衢硬件模拟场景:支持GPU/NPU池化、内存热插拔等高级特性仿真。

- 生态工具链持续丰富:提供更易用的CLI、Web控制台、插件市场等。

- 社区协作与标准推进:推动灵衢协议与Kubernetes生态的深度融合与标准化。

我们鼓励更多开发者加入openFuyao社区,共同推动智能算力基础设施的软件创新与生态繁荣。