引言

在电力、石化与制造等行业,巡检工作长期依赖人工目视与纸质记录,效率与准确性极易受光照条件、反光干扰、视线遮挡及人员疲劳等因素影响。

借助 Rokid AR 眼镜 进行第一视角的图像采集与叠加显示,并深度融合 OCR(光学字符识别)、条码识别与仪表读数推理 技术,可以将"识别 → 理解 → 指导"的数字化链路直接落地于巡检现场。这一方案不仅形成了完整的数据闭环,更显著降低了漏检率与误判率。

业务痛点与目标

痛点包括铭牌小字难读、仪表角度不易、条码污损与偏转、巡检记录不统一。目标是稳定识别多类型对象,提供阈值判定与 SOP 指引,并以低时延、低功耗的方式融入巡检流程。系统需适配低光、反光与灰尘等复杂条件,并提供拍摄引导与回退机制。

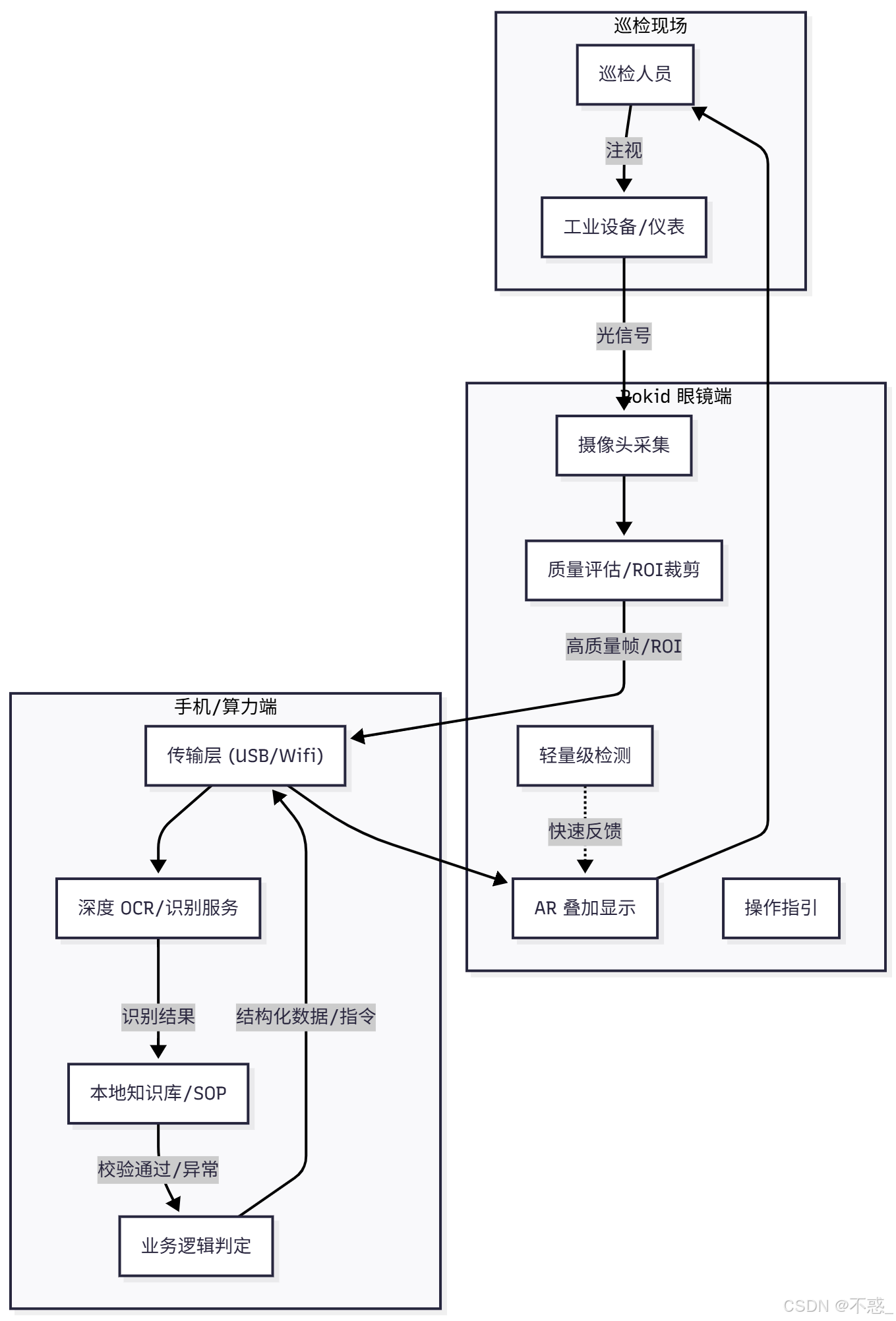

架构设计

架构采用**"端云协同"或"端边协同"**模式,分为纯眼镜端与手机算力端(或边缘盒子):

- 纯眼镜端(前端):负责图像采集、图像质量评估(模糊/过暗检测)、ROI(感兴趣区域)裁剪以及轻量级的特征提取。

- 手机协同端(算力端):接收眼镜上行的关键帧,运行高精度的 OCR 版面分析、深度学习推理与知识库比对,最终返回结构化数据与操作指令。

两者间需建立ROI 优先传输与断线回退机制,以确保在工业弱网环境下的可用性。

识别模块

OCR覆盖场景文本与印刷体,结合版面分析与行业词典进行校验;条码识别需支持多制式与纠错,并对旋转与缺损具备容错;仪表读数分数字仪表与指针仪表两类,数字仪表通过字符分割识别,指针仪表通过表盘检测、指针角度估计与刻度映射推断读数,并解析单位与阈值。

数据与知识库

现场数据集应覆盖多角度与多光照条件,并进行透视校正与锐化等预处理。知识库存放设备参数、阈值区间与 SOP;结果需进行校验与一致性判断,例如将铭牌、条码与工单目标进行匹配,减少误识。

交互与指引

眼镜端以叠加显示标注框、读数与判定结果,并给予下一步操作建议;通过语音或手势在工单间切换、提交异常或拍照留档。当清晰度不足或反光明显时,显示拍摄引导与重试入口。

稳定性与安全

ROI 优先策略减少带宽与延迟;质量门限对清晰度与曝光进行判断,提示拍摄原因;缓存最近识别与位置,提高多次扫描一致性。隐私策略以结构化结果优先存储、传输加密与最小日志记录为原则,并支持一键清理与审计。

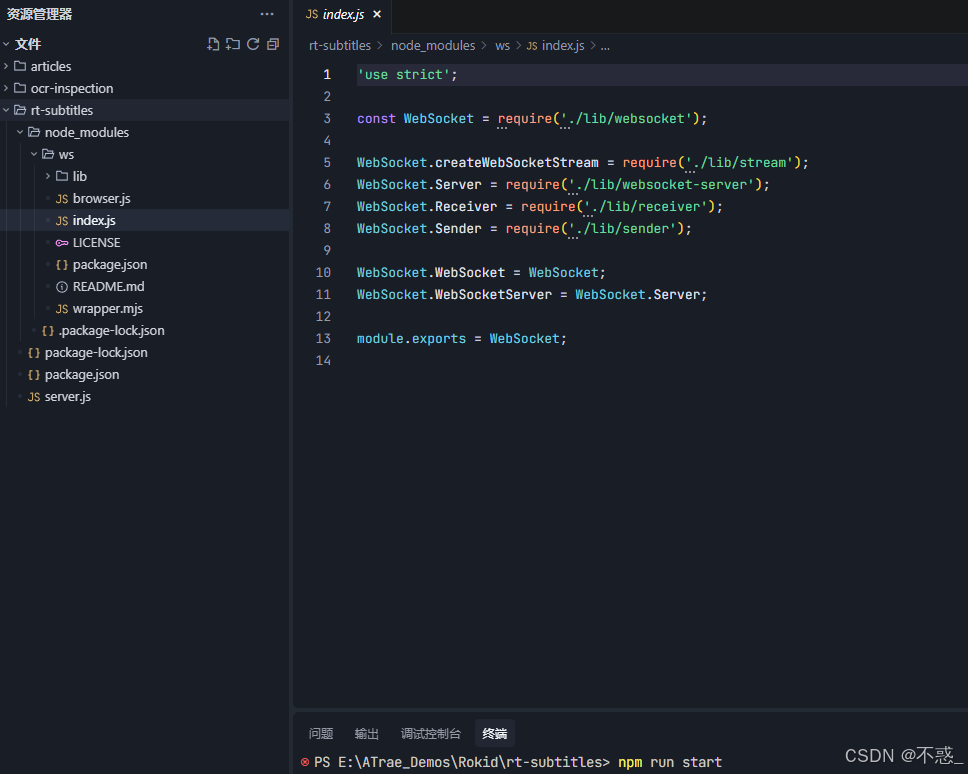

以下给出最小可运行的眼镜端与手机协同端骨架,体现采集、上行与叠加结果的基本路径。可替换识别模块为实际 OCR/条码与仪表推理服务。

眼镜端(Android/Kotlin)

kotlin

import android.graphics.*

import android.os.Bundle

import android.view.View

import android.view.ViewGroup

import android.widget.FrameLayout

import android.widget.TextView

import androidx.appcompat.app.AppCompatActivity

import androidx.camera.core.*

import androidx.camera.lifecycle.ProcessCameraProvider

import androidx.core.content.ContextCompat

import java.net.HttpURLConnection

import java.net.URL

import java.util.concurrent.Executors

import org.json.JSONObject

import java.io.ByteArrayOutputStream

class OcrInspectionActivity : AppCompatActivity() {

private lateinit var overlayView: TextView

private val cameraExecutor = Executors.newSingleThreadExecutor()

override fun onCreate(savedInstanceState: Bundle?) {

super.onCreate(savedInstanceState)

val root = FrameLayout(this)

overlayView = TextView(this)

root.addView(overlayView, ViewGroup.LayoutParams.MATCH_PARENT, ViewGroup.LayoutParams.WRAP_CONTENT)

setContentView(root)

startCamera()

}

private fun startCamera() {

val cameraProviderFuture = ProcessCameraProvider.getInstance(this)

cameraProviderFuture.addListener({

val cameraProvider = cameraProviderFuture.get()

val analysis = ImageAnalysis.Builder().build()

analysis.setAnalyzer(cameraExecutor) { imageProxy ->

val bmp = imageToBitmap(imageProxy)

val res = sendFrame(bmp, "http://192.168.1.2:8080/infer")

runOnUiThread { overlayView.text = res }

imageProxy.close()

}

val selector = CameraSelector.DEFAULT_BACK_CAMERA

cameraProvider.bindToLifecycle(this, selector, analysis)

}, ContextCompat.getMainExecutor(this))

}

private fun imageToBitmap(image: ImageProxy): Bitmap {

val yBuffer = image.planes[0].buffer

val uBuffer = image.planes[1].buffer

val vBuffer = image.planes[2].buffer

val ySize = yBuffer.remaining()

val uSize = uBuffer.remaining()

val vSize = vBuffer.remaining()

val nv21 = ByteArray(ySize + uSize + vSize)

yBuffer.get(nv21, 0, ySize)

vBuffer.get(nv21, ySize, vSize)

uBuffer.get(nv21, ySize + vSize, uSize)

val yuv = YuvImage(nv21, ImageFormat.NV21, image.width, image.height, null)

val out = ByteArrayOutputStream()

yuv.compressToJpeg(Rect(0, 0, image.width, image.height), 70, out)

val bytes = out.toByteArray()

return BitmapFactory.decodeByteArray(bytes, 0, bytes.size)

}

private fun sendFrame(bmp: Bitmap, urlStr: String): String {

val url = URL(urlStr)

val conn = url.openConnection() as HttpURLConnection

conn.requestMethod = "POST"

conn.doOutput = true

conn.setRequestProperty("Content-Type", "image/jpeg")

val bos = ByteArrayOutputStream()

bmp.compress(Bitmap.CompressFormat.JPEG, 70, bos)

conn.outputStream.write(bos.toByteArray())

val res = conn.inputStream.bufferedReader().readText()

conn.disconnect()

return res

}

}手机端识别服务(Python/FastAPI)

python

from fastapi import FastAPI, UploadFile, File

import uvicorn

import json

app = FastAPI()

@app.post("/infer")

async def infer(image: UploadFile = File(...)):

payload = {

"items":[

{"type":"ocr","text":"VALVE A", "bbox":[100,80,160,40], "status":"normal"},

{"type":"gauge","value":0.72,"unit":"MPa","bbox":[220,120,120,120],"status":"normal"}

],

"next_step":"记录并前往阀门A"

}

return payload

if __name__ == "__main__":

uvicorn.run(app, host="0.0.0.0", port=8080)

指标与方法论

OCR 指标以准确率与召回率为主;条码识别关注成功率与耗时;仪表读数以 MAE/RMSE 评估;现场指标包含完成时间、误报与漏报率、纠错比例;系统指标关注延迟分位、丢帧率与功耗。方法论强调在 ROI 优先与质量门限基础上,结合知识库一致性校验与现场交互引导,实现稳定的高可用。

风险与回退

极端条件包括强反光、低照、雾气与遮挡。可采用多帧融合、透视校正与去眩光,必要时切换为手动输入。对涂改与欺骗样本采取跨源一致性校验,并触发二次确认或远程协作复核。

结语

工业巡检与 OCR 的核心是"精准识别、语义理解与现场指导"的闭环。Rokid 眼镜使第一视角成为主通道,让识别结果与指引在视野中即时浮现,显著降低漏检与误判。通过 ROI 策略、质量门限与知识库比对,可在复杂环境中保持稳定与高效,逐步走向生产落地。