一、基本介绍

官方网址 :https://wan.video/

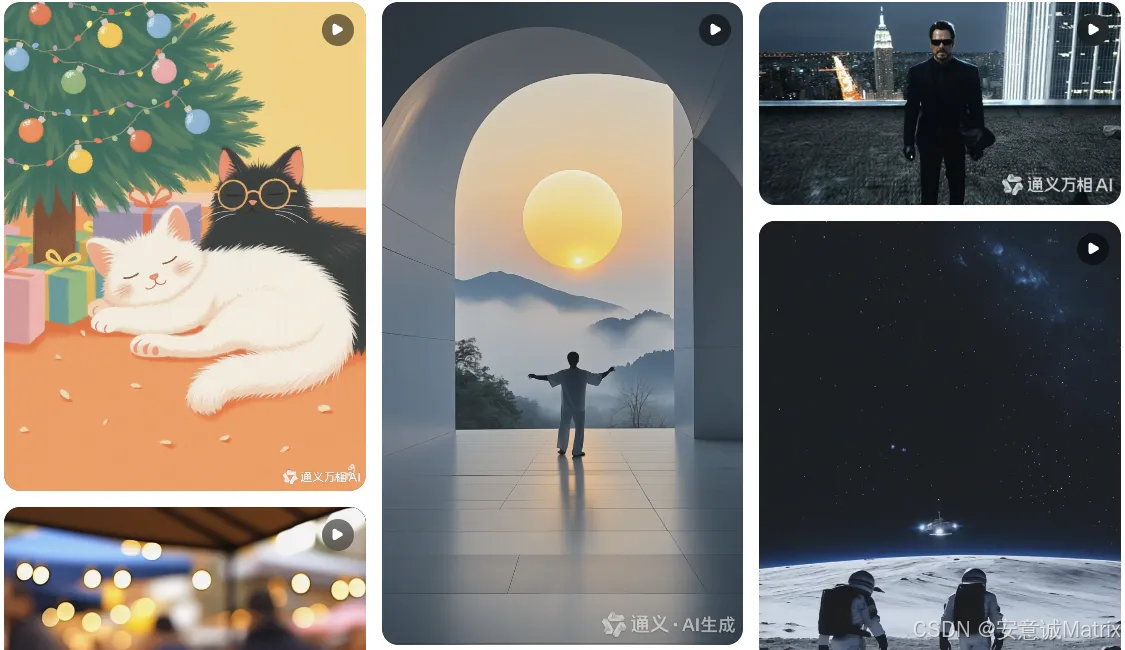

WAN(通义万相)是阿里巴巴开发的开源视频生成大模型系列,由通义实验室研发,旨在推动AI视频生成技术的边界,支持从文本或图像生成高质量视频。

核心版本演进:

- Wan2.1:2025年2-3月开源,包含14B和1.3B参数规模模型,支持文生视频(T2V)和图生视频(I2V)

- Wan2.2:2025年7月28日发布,首次将MoE(混合专家)架构引入视频生成,支持消费级显卡运行

- Wan2.5 :2025年9月24日发布,实现原生音画同步,支持文本/图像直接生成带同步音频的视频

二、技术特点与核心能力

1️⃣ Wan2.1技术亮点

- 3D因果VAE架构:专为视频设计的时空压缩,减少60%显存占用

- Diffusion Transformer(DiT)基础:结合扩散模型的生成能力与Transformer的长程依赖建模

- 多模态支持:首个支持中英双语视觉文本生成的视频模型

- 完整功能矩阵:覆盖T2V、I2V、视频编辑、文生图和视频转音频等八大任务

2️⃣ Wan2.2突破性创新

- MoE架构:将视频生成分为高噪和低噪阶段,由不同专家模型处理,在保持计算成本下提升容量

- 轻量化部署:5B参数版本可在RTX 4090等消费级显卡流畅运行,生成720P@24fps视频

- 电影级画质:270亿参数版本实现专业级视觉效果和复杂运动控制

3️⃣ Wan2.5核心突破

- 原生音画同步:单一生成管道同时处理视觉、语言和声音,一步生成音画匹配的完整视频

- 全模态输入:支持文本、图像、音频任意组合输入,理解"镜头语言"

- 高分辨率:支持480p/720p/1080p分辨率,最长10秒视频生成

三、开源与技术细节公开情况

已公开发布的核心技术文档:

-

论文:《Wan: Open and Advanced Large-Scale Video Generative Models》(arXiv:2503.20314)

- 作者:阿里巴巴通义实验室团队

- 发布时间:2025年3月

- 内容:详细介绍WAN模型架构、创新点、训练方法和实验结果

-

开源代码与权重:

- 全系列模型(包括Wan2.1、Wan2.2)的完整代码和权重已开源,采用Apache 2.0协议

- 开源平台:GitHub、Hugging Face、魔搭(ModelScope)社区

- 包含推理代码、训练策略和使用示例

-

技术报告:

- Wan2.1技术报告:详细介绍模型架构、时空注意力机制和因果VAE设计

- Wan2.2技术文档:深入解析MoE架构在视频生成中的应用

- Wan2.5技术白皮书:说明音画同步实现原理和多模态融合技术

四、使用场景

- 内容创作:电影分镜、广告制作、短视频创意

- 产品演示:一键生成产品功能展示视频

- 游戏开发:快速创建游戏过场动画、角色动画

- 教育内容:自动生成教学视频,降低制作门槛

- 个人创作:用户上传图片+文本描述,生成个性化纪念视频

五、总结

阿里WAN大模型(通义万相)是目前最先进的开源视频生成系统之一 ,从Wan2.1到Wan2.5实现了从基础视频生成到音画同步的跨越式发展。所有技术细节已通过论文、开源代码和技术报告完全公开,为AI视频生成领域提供了重要参考和创新方向。

注:如需更深入的技术实现细节,可直接查阅官方论文(arXiv:2503.20314)或访问GitHub上的开源仓库。