1. AIGC - 内容生成基本功

概念: 利用 AI 技术自动创作文本、图像、音频等各类内容的技术统称。全称 Artificial Intelligence Generated Content (人工智能生成内容)

核心能力: 用 AI 来自动生成 "人类常干的活"

本质: AI 模型通过学习海量数据,自主生成符合需求的全新内容,而非简单复制或拼接现有信息

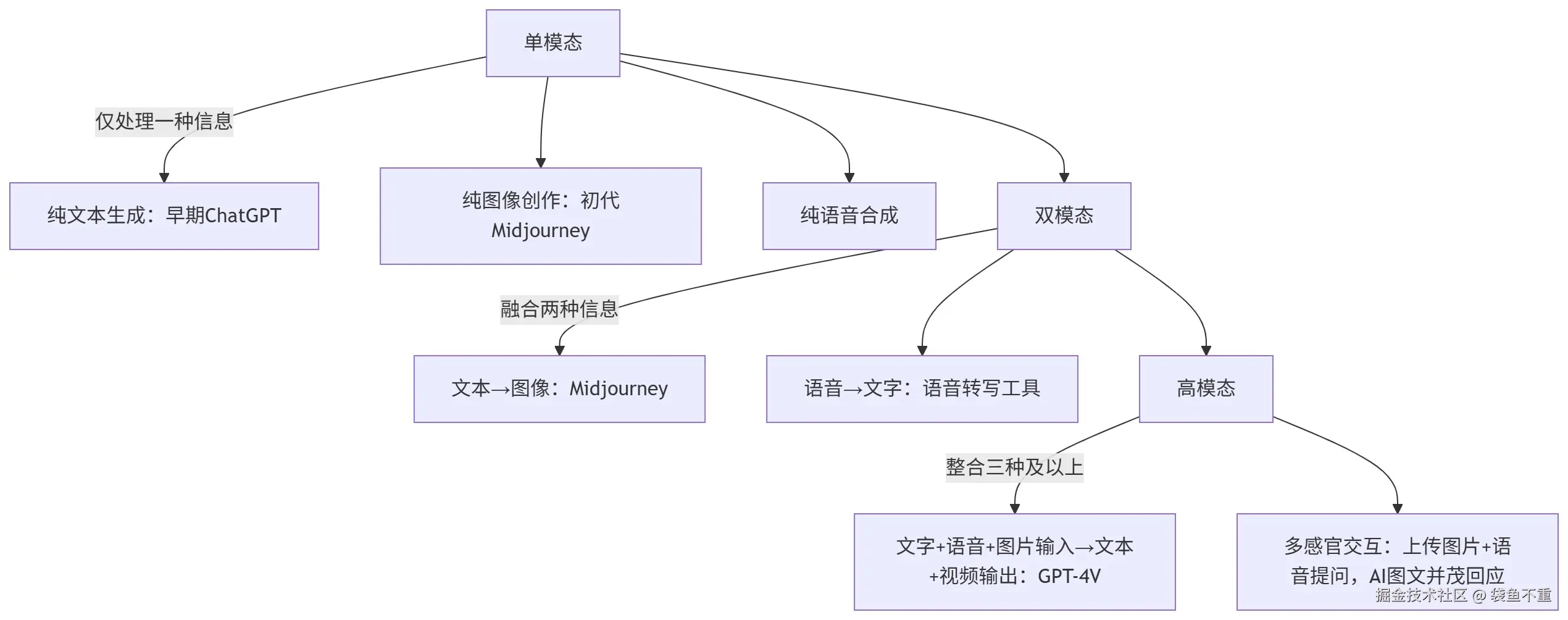

初期的AIGC有个明显局限:只能专注于一种信息类型,就像一个偏科的学生------要么只懂文字(早期ChatGPT),要么只懂图像(初代Midjourney),这就是"单模态"阶段。

2. 多模态 - 感官升级

- 单模态:AI 仅聚焦一种信息类型,比如纯文本生成(早期 ChatGPT)、纯图像创作(初代 Midjourney)。

- 双模态:融合两种信息类型,比如文本生成图像、语音转文字。

- 高模态:整合三种及以上信息类型,比如 "文字 + 语音 + 图片" 混合输入提问,AI 输出 "文本 + 视频 + 音频" 组合结果(如 GPT-4V、Runway Gen-2)。

概念: 多模态 = AI 打破单一信息类型限制,同时处理或融合文本、图像、音频、视频等两种及以上内容,像人类一样多感官感知世界。

核心能力: AI 同时处理 / 融合多种信息类型,打破单一文本、图像等模态的局限,更贴近人类感知世界的方式。

限制:

- 数据真实性不足:易生成 "幻觉内容",比如编造虚假数据、引用不存在的文献,尤其专业领域误差率高。

- 缺乏原创性:本质是对训练数据的重组优化,难产生真正的 "突破性创意",易出现同质化内容。

- 合规与伦理风险:可能侵犯版权(复刻训练数据中的原创内容)、生成偏见 / 不良信息,且责任界定模糊。

- 可控性有限:复杂需求下难精准匹配预期,比如多轮创作中易偏离主题,细节调整成本高。

- 依赖高质量数据:训练数据的覆盖面、准确性直接影响输出效果,小众领域或专业场景表现不佳。

- 不具备实时性:依赖训练数据,如果知识库没有更新,要让他知道最新的数据,需要自己给他"喂数据"

- 不会用工具:从现有知识库获取数据,因此不会查询最新的信息,不会自主调用 API。

3. RAG、Function Call - 工具加持

如果说RAG是"知识库",那Function Call就是AI的"手脚"。它让AI从"只说不做"升级为"能说会做"------比如根据指令自动调用计算器算复杂数据、调用地图API查路线、调用表格工具生成报表,彻底解决了纯文本回答无法落地的问题。

3.1 RAG

概念: 全称 Retrieval-Augmented Generation(检索增强生成)。 本质是 AI 生成内容前,先从外部知识库(而非仅依赖训练数据)检索相关信息,再结合检索结果生成答案。

核心能力: 解决 AIGC 实时性的问题

- 弥补知识滞后:训练数据有时间 cutoff,RAG 可实时调取最新数据(如 2025 年的行业报告),让回答更具时效性。

- 减少幻觉:基于真实可追溯的检索结果生成内容,降低编造虚假信息的概率。

- 提升专业性:可接入垂直领域知识库(如医疗、法律文献),让非专业训练的 AI 也能输出专业答案。

3.2 Function Call

概念: 让模型根据指令,自动调用外部函数和接口

核心能力: AI 调用外部工具 / API 的能力,让 AI 从 "只生成内容" 升级为 "能执行操作",解决纯文本回答无法落地的问题。

4. Agent - 自主决策能力

概念: 让模型具备一定程度的自主决策和任务规划能力,不用一步一步告诉它怎么做,而是会给出最终的规划和结果

核心能力: 具备自主能力的 AI 智能体,能理解目标、规划步骤、调用工具,无需人类反复指令就能独立完成复杂任务。

限制: 缺乏"标准化"

- 复杂任务规划能力弱:面对多步骤、多变量的任务(如跨部门复杂项目推进),易拆解逻辑混乱,或忽略关键约束条件。

- 意图理解不精准:对模糊需求、隐含意图的捕捉能力不足,可能偏离用户真实目标,尤其涉及主观偏好的场景(如个性化方案定制)。

- 风险控制与责任界定模糊:自主调用工具时可能触发合规风险(如误操作数据、泄露隐私),且出现问题后难以明确责任归属。

- 资源依赖与稳定性不足:高度依赖外部工具 API、知识库的可用性,一旦接口故障或数据更新不及时,会直接导致任务中断。

- 缺乏灵活应变能力:遇到突发情况(如计划中的工具不可用、需求临时变更),调整方案的效率低,易陷入 "执行死循环"。

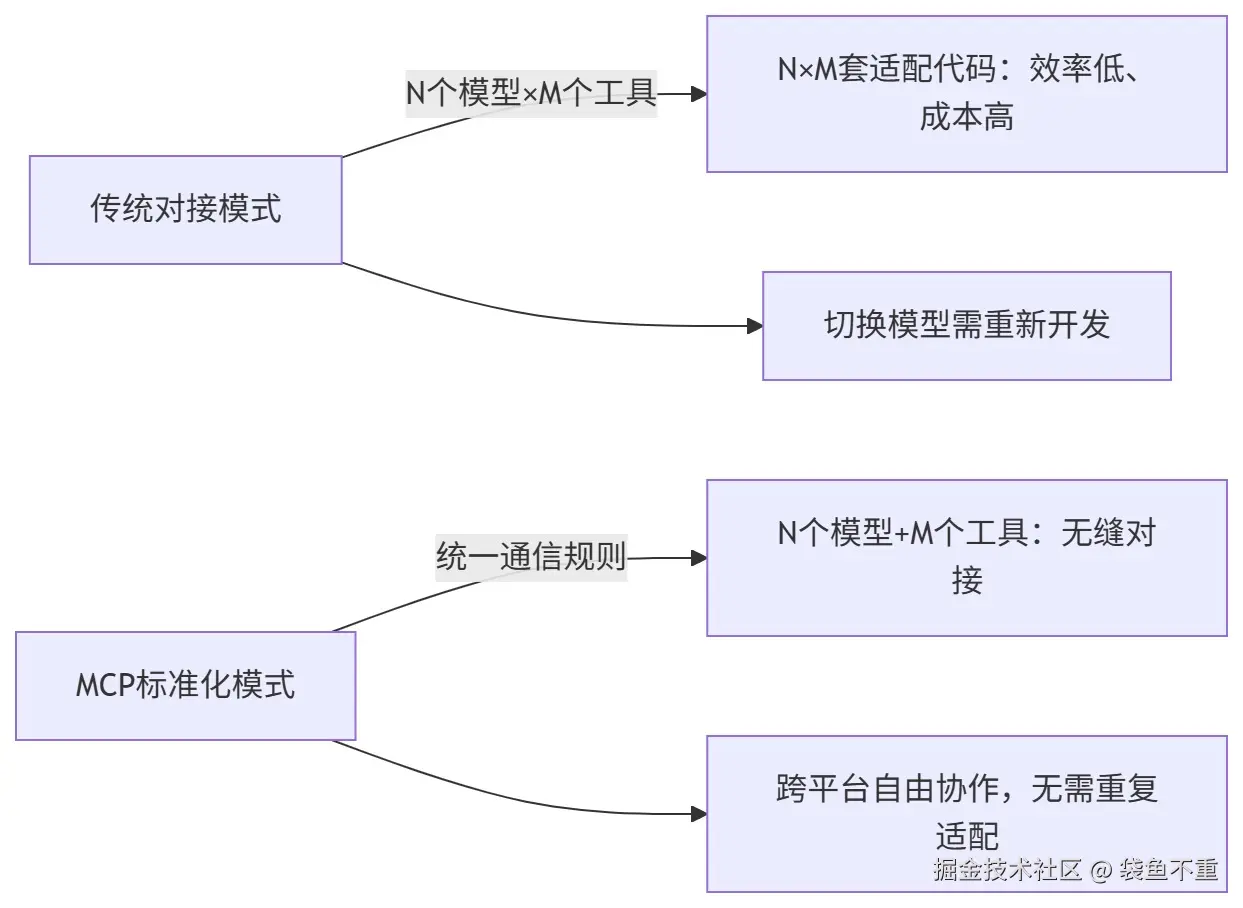

比如你让它"策划一场周末旅行",Agent会自动拆解成"查目的地天气→找景点攻略→订酒店→规划路线"等步骤,分别调用天气API、旅游知识库、订票工具完成,最后给你一份完整攻略。但此时的Agent仍有不足:不同AI模型和工具对接时很混乱,容易出现"沟通不畅"的问题。

5. MCP - 通用沟通协议,构建跨平台的 AI 工具生态

概念: 全称 Model Context Protocol(模型上下文协议),标准化模型和外部工具之间的连接方式。是 Anthropic 于 2024 年 11 月提出的开放标准,堪称 AI 与外部世界交互的 "万能接口",专门解决不同 AI 模型与工具、数据源对接混乱的问题。

核心能力: 可以把它理解为 AI 领域的 USB-C 接口或 "万能遥控器"。过去不同 AI 模型调用工具时,需针对性开发适配代码,比如 OpenAI 和百度文心一言调用同一数据库可能要写两套逻辑;而 MCP 定义了统一的通信规则,只要 AI 模型和工具都支持该协议,就能无缝对接,不用重复适配,解决了 AI 与工具交互的 "N×M" 适配难题(以前是 M × N 的混乱对接,现在是 M + N 的标准接口。)。

与 Function Call 的区别: 两者都能让 AI 调用外部工具,但逻辑差异明显。Function Call 是单体集成式方案,比如某 AI 模型的 Function Call 功能,只能适配该平台指定的工具或接口,切换模型后可能要重新开发;而 MCP 是分布式的标准化协议,相当于独立的 "翻译官",不管 AI 模型和工具来自哪个平台,只要遵循该协议,就能互相通信,更适合构建跨平台的 AI 工具生态。