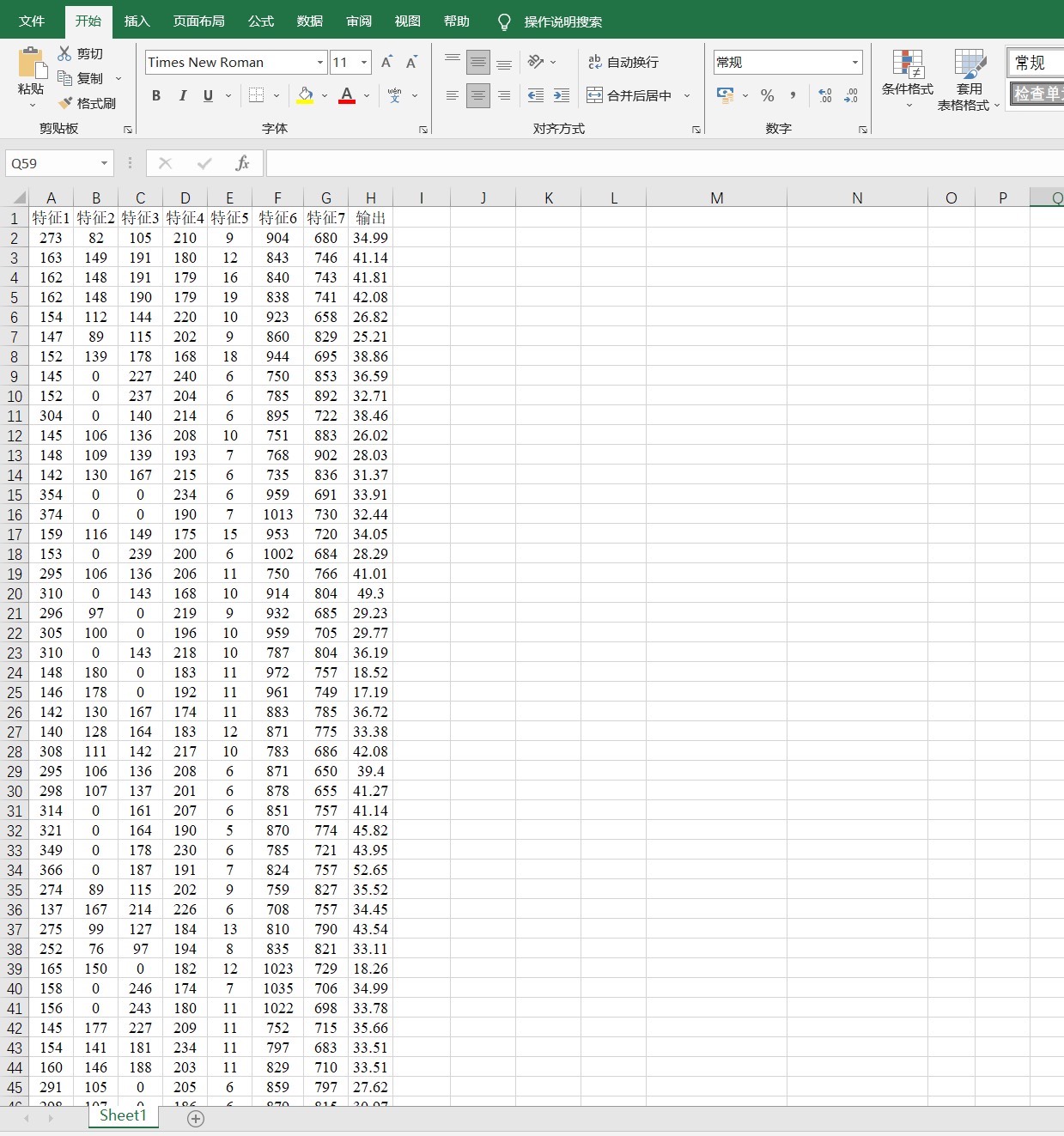

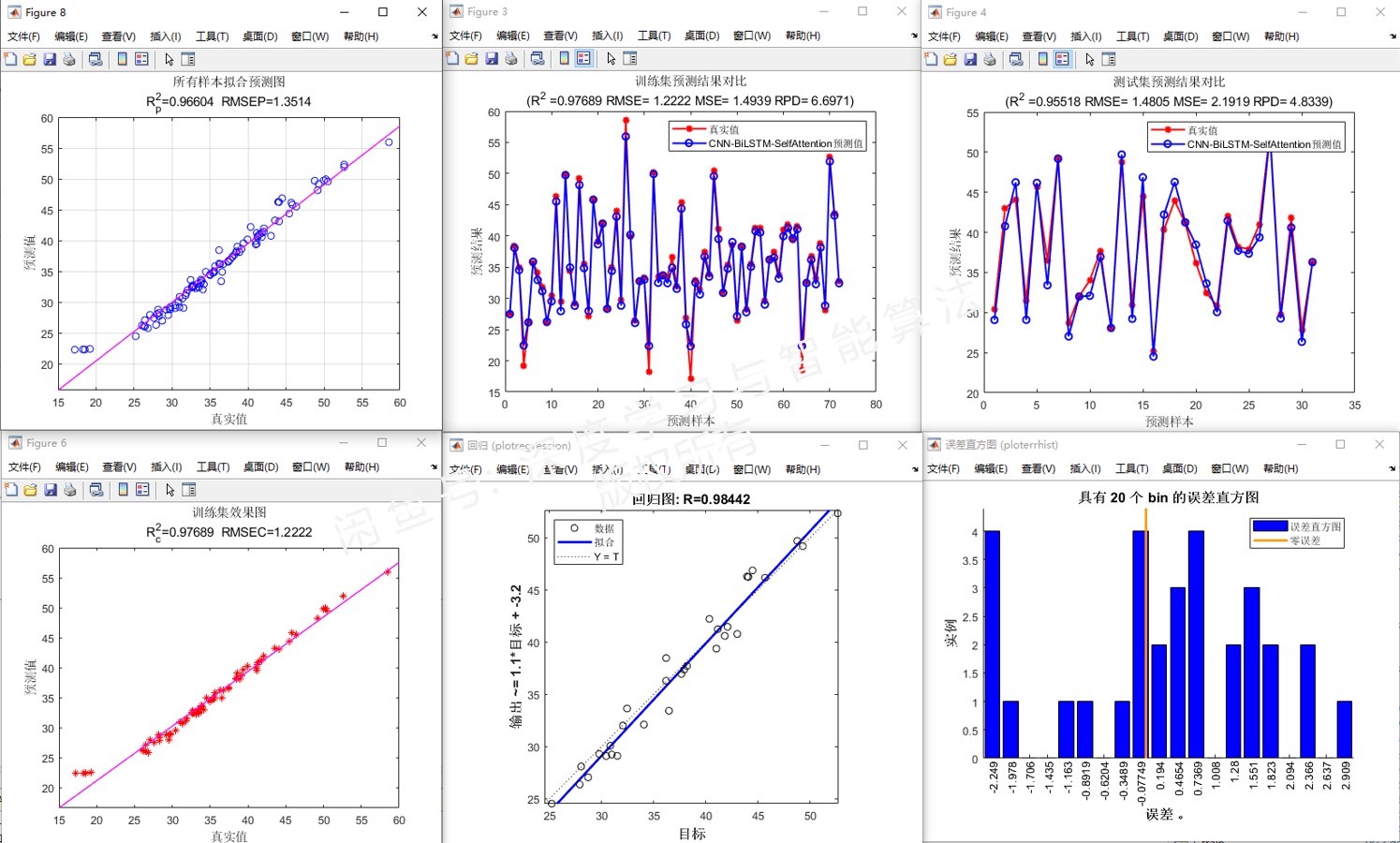

CNN-BiLSTM-SelfAttention基于卷积神经网络-双向长短期记忆网络结合自注意力机制的多变量回归预测Matlab语言 1.多特征输入,回归也可以换成时间序列单列预测(售前选一种),Matlab版本要在2021a及以上。 2.特点: 1卷积神经网络(CNN):捕捉数据中的局部模式和特征。 2长短期记忆网络(LSTM):处理数据捕捉长期依赖关系。 3自注意力机制:为模型提供了对关键信息的聚焦能力,从而提高预测的准确度。 3.直接替换Excel数据即可用,注释清晰,适合新手小白 附赠测试数据,输入格式如图2所示,可直接运行 5.商品仅包含Matlab代码,价格不包含讲解,后可保证原始程序运行,但不支持退换 6.模型只是提供一个衡量数据集精度的方法,因此无法保证替换数据就一定得到您满意的结果~

最近在研究多变量回归预测相关的课题,发现CNN - BiLSTM - SelfAttention这种组合模型挺有意思,今天就来和大家唠唠在Matlab环境下(2021a及以上版本)怎么实现它,而且还能灵活地用于多特征输入,或者时间序列单列预测(这里咱们就以多特征输入的回归预测为例哈)。

一、模型特点

卷积神经网络(CNN)

CNN主要用来捕捉数据中的局部模式和特征。比如说在图像识别里,它能快速找到图像里的边边角角这些局部特征。在咱们这个预测任务里,它可以敏锐地发现输入特征数据里一些局部存在的规律。就像下面这个简单的Matlab代码片段(假设数据已经整理好放在 data 矩阵里):

matlab

layers = [

imageInputLayer([size(data, 2), 1, 1])

convolution2dLayer(3, 16, 'Padding', 'same')

reluLayer()

maxPooling2dLayer(2, 'Stride', 2)];这里 imageInputLayer 设置了输入数据的维度,因为咱们是多特征输入,把特征数当成图像的宽度,通道数设为1。convolution2dLayer 就是定义卷积层,3代表卷积核大小,16是输出的特征图数量,'Padding' 设置为 'same' 是为了让输出和输入尺寸一样。reluLayer 是激活函数层,maxPooling2dLayer 进行最大池化操作,降低数据维度同时保留主要特征。

长短期记忆网络(LSTM)

LSTM擅长处理数据中的长期依赖关系。在时间序列或者像咱们多特征数据里,有些信息之间的联系不是短距离能体现的,LSTM就能很好地捕捉到这些。下面继续看代码:

matlab

layers = [layers

bilstmLayer(32)

bilstmLayer(32)];这里用 bilstmLayer 搭建双向LSTM层,32表示隐藏单元的数量。双向LSTM可以同时从正向和反向处理数据,更好地捕捉序列中的依赖信息。

自注意力机制

自注意力机制就像是给模型开了个"聚焦镜",让模型对关键信息有更强的聚焦能力,从而大大提高预测的准确度。虽然Matlab没有直接像某些深度学习框架那样有特别简单直接的自注意力函数,但咱们可以自己构建一个简单的自注意力模块。

matlab

function [attended] = selfAttention(input)

% 假设输入是一个三维张量 [batch_size, sequence_length, feature_dim]

[batch_size, sequence_length, feature_dim] = size(input);

query = reshape(permute(input, [1, 3, 2]), [batch_size, feature_dim * sequence_length]);

key = reshape(permute(input, [1, 3, 2]), [batch_size, feature_dim * sequence_length]);

value = reshape(permute(input, [1, 3, 2]), [batch_size, feature_dim * sequence_length]);

attention_scores = query * key';

attention_scores = attention_scores / sqrt(feature_dim);

attention_weights = softmax(attention_scores, 2);

attended = attention_weights * value;

attended = reshape(attended, [batch_size, sequence_length, feature_dim]);

end这个自定义函数 selfAttention 接受输入数据,通过一系列矩阵运算得到注意力分数,经过归一化得到注意力权重,最后和 value 矩阵相乘得到经过注意力机制处理的数据。

二、数据处理与模型训练

咱们这个模型很友好,直接替换Excel数据就能用。假设数据已经整理好放在 data.xlsx 里,下面是读取数据和简单预处理的代码:

matlab

data = readtable('data.xlsx');

data = table2array(data);

inputFeatures = data(:, 1:end - 1);

target = data(:, end);

% 数据归一化

inputFeatures = normalize(inputFeatures, 'range');

target = normalize(target, 'range');这里读取Excel数据,把特征和目标值分开,然后进行归一化处理,让数据都在0到1之间,有助于模型训练。

接着就是模型搭建和训练:

matlab

layers = [

imageInputLayer([size(inputFeatures, 2), 1, 1])

convolution2dLayer(3, 16, 'Padding', 'same')

reluLayer()

maxPooling2dLayer(2, 'Stride', 2)

bilstmLayer(32)

bilstmLayer(32)

fullyConnectedLayer(1)

regressionLayer()];

options = trainingOptions('adam',...

'MaxEpochs', 100,...

'InitialLearnRate', 0.001,...

'ValidationData', {inputFeatures, target},...

'ValidationFrequency', 10,...

'Verbose', false,...

'Plots', 'training-progress');

net = trainNetwork(inputFeatures, target, layers, options);这里搭建了完整的模型结构,从输入层、卷积层、LSTM层到全连接层和回归层。trainingOptions 设置了训练参数,用 adam 优化器,最大训练100个epoch,初始学习率0.001 ,并设置了验证数据和频率。最后用 trainNetwork 训练模型。

三、关于这个商品

咱们这个商品里就只有Matlab代码哈,注释写得很清晰,新手小白也能轻松上手。还附赠了测试数据,输入格式也有图2展示,拿到手就能直接运行。不过得说明一下,价格可不包含讲解哦。虽然能保证原始程序运行,但不支持退换。而且这个模型说到底只是提供一个衡量数据集精度的方法,要是你替换了数据,可没办法保证一定能得到满意的结果,毕竟不同数据集差异还是挺大的嘛。希望大家在探索多变量回归预测的路上,能从这个模型里找到一些有用的思路!