摘要:AI Agent 工程化的关键在于"该省则省":高频确定性任务用硬编码或规则引擎处理,复杂开放问题才调用大模型,通过混合架构实现低成本、高可靠、低延迟的生产级智能系统。

从硬编码到规则引擎:AI Agent 工程化的降本增效之路

核心观点:智能不等于全用大模型。真正的生产级 AI 系统,是"能省则省、该智则智"的混合架构。

引言:别让 LLM 干所有活

当我们兴奋地构建 AI Agent 时,很容易陷入一个误区:把所有逻辑都交给大语言模型(LLM)处理 。

但现实很骨感:LLM 调用贵、延迟高、行为不可控。如果用户每天问一万次"我的订单到哪了?",每次都让 GPT-4o 思考一遍,成本和体验都会崩盘。

于是,聪明的工程师开始思考:能不能把高频、确定性强的路径固化下来?

答案是肯定的------这条路,从硬编码 起步,走向规则引擎 ,最终形成AI + 规则的混合智能架构。

第一阶段:硬编码 ------ 最朴素的优化

对于模式固定、逻辑明确的请求,直接写死处理流程是最高效的方式。

erlang

if "订单" in query and ("在哪" in query or "物流" in query):

order_id = extract_order_id(query)

status = logistics_api.get_status(order_id)

return f"您的订单当前状态:{status}"✅ 优势:

- 零 LLM 调用,成本趋近于 0

- 响应毫秒级,用户体验好

- 行为完全可控,无幻觉风险

❌ 局限:

- 规则散落在代码中,难以维护

- 每次新增场景都要改代码、测、上线

硬编码是起点,但不是终点。

第二阶段:规则引擎 ------ 把"if-else"解放出来

规则引擎的核心思想是:将业务逻辑从代码中剥离,变成可配置、可热更新的策略。

什么是规则引擎?

它是一个专门执行"如果......那么......"规则的运行时系统。例如:

json

{

"condition": "intent == 'order_status'",

"action": "call_logistics_api_and_format_response"

}运营人员只需修改规则配置,无需程序员介入。

在 AI Agent 中的价值

| 场景 | 处理方式 |

|---|---|

| "退货流程是什么?" | 规则引擎 → 返回预设 FAQ |

| "我买的 A 能和 B 一起用吗?" | LLM + RAG → 分析产品文档 |

| "帮我订明天去上海的机票" | Agent 规划 → 调用航班 API |

规则引擎处理"已知问题",LLM 处理"未知问题"。

自动驾驶中的启示

自动驾驶系统早已采用类似思路:

- 深度学习负责"感知世界"(识别车辆、行人)

- 规则引擎负责"遵守交规"(红灯停、斑马线让行)

即使 AI 认为"可以安全通过",规则仍强制制动------这是安全底线。

AI Agent 同理:规则是成本与安全的守门人。

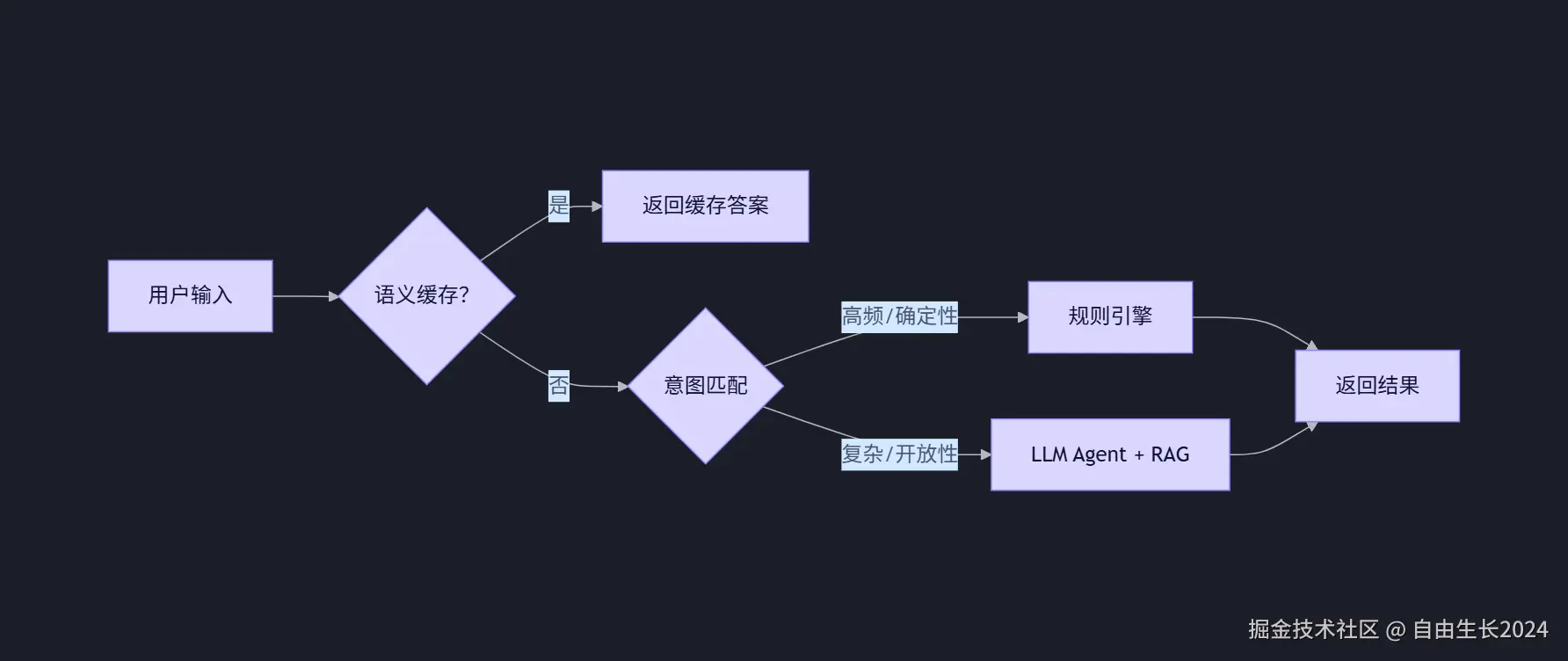

第三阶段:混合架构 ------ 智能系统的成熟形态

现代生产级 AI 系统普遍采用三层路由架构:

关键组件

- 语义缓存:用向量数据库缓存相似问题的答案,避免重复计算

- 意图分类器:轻量模型或关键词匹配,决定走哪条路径

- 规则引擎:处理标准化业务流程

- 通用 Agent:仅用于真正需要泛化能力的场景

效果数据(行业实践)

- 70%+ 请求 由规则或缓存处理,不调用 LLM

- 整体成本下降 50%~90%

- P99 延迟从 2s 降至 200ms 以内

结语:智能的本质是"恰到好处"

不要为了用 AI 而用 AI。

真正的工程智慧,在于知道什么时候不用大模型。

从硬编码到规则引擎,再到混合智能架构,我们走的是一条从实验到生产、从炫技到务实 的进化之路。

未来的 AI Agent,不是"全知全能"的神,而是懂得分工协作、精打细算的高效工作者。

作者建议 :

如果你正在开发 AI Agent,不妨先问自己:

"这个问题,有没有可能用 10 行 if-else 解决?"

如果有,那就别急着调 LLM------先省下那一分钱,再谈智能。