从"人工催办"到"AI 规则驱动":我们如何解放测试团队的生产力

很多测试同学除了本职工作,还承担着中小型项目的管理工作,却因此成了项目中的"人工待办清单"。

"人工待办"依赖记忆的流程节点去推动事情,我们发现:测试团队真正该做的测试工作(深度测试、质量分析、风险挖掘),正被流程管理悄悄偷走。

于是,我们打造了这个超轻量的项目管理工具 ,让规则在项目群"主动说话",将"何时、谁、做什么"标准化,由程序收集信息、提醒推进。

Part 1. 从"混乱的记忆经验"到"动态的客观规则"

认识到"依赖人工待办"的痛点只是第一步。核心挑战是:项目管理本身既有定式又有变化。

- 3 人 3 天的紧急需求,与跨端日常迭代的管理差异?

- 内部协作项目,与外部频繁对接项目的节点区别?

过去,全凭测试负责人的"个人经验"处理,可能出现的结果:

- 小型项目被过度管理,徒增负担;

- 大型项目又管理不足,漏洞百出。

我们意识到,项目管理规则不是统一模板,而是能应对不同"项目参数"的动态规则系统。

搭建这套系统,需围绕项目管理时的具体问题展开:

据此,我们得出三个解题方向。

1、按项目规模 控制管理粒度

| 项目类型 | 管理策略 | 关键动作 |

|---|---|---|

| 小型需求 | 功能独立,迭代要"快" | 只保留确保质量底线的关键检查点 |

| 中型迭代 | 保证速度 + 强调"稳" | 加入技术评审、联调日会等节点,确保信息同步和风险前置 |

| 大型项目 | 在中型基础上强调"可控"与"对齐" | 增加每日站会、细化联调计划等 |

2、 按项目类型 区分差异节点

- 含客户端项目:增加集测、上线前物料检查、发版等节点

- 涉外部门项目:增加需求串讲、技术方案串讲、测试边界拉齐等节点

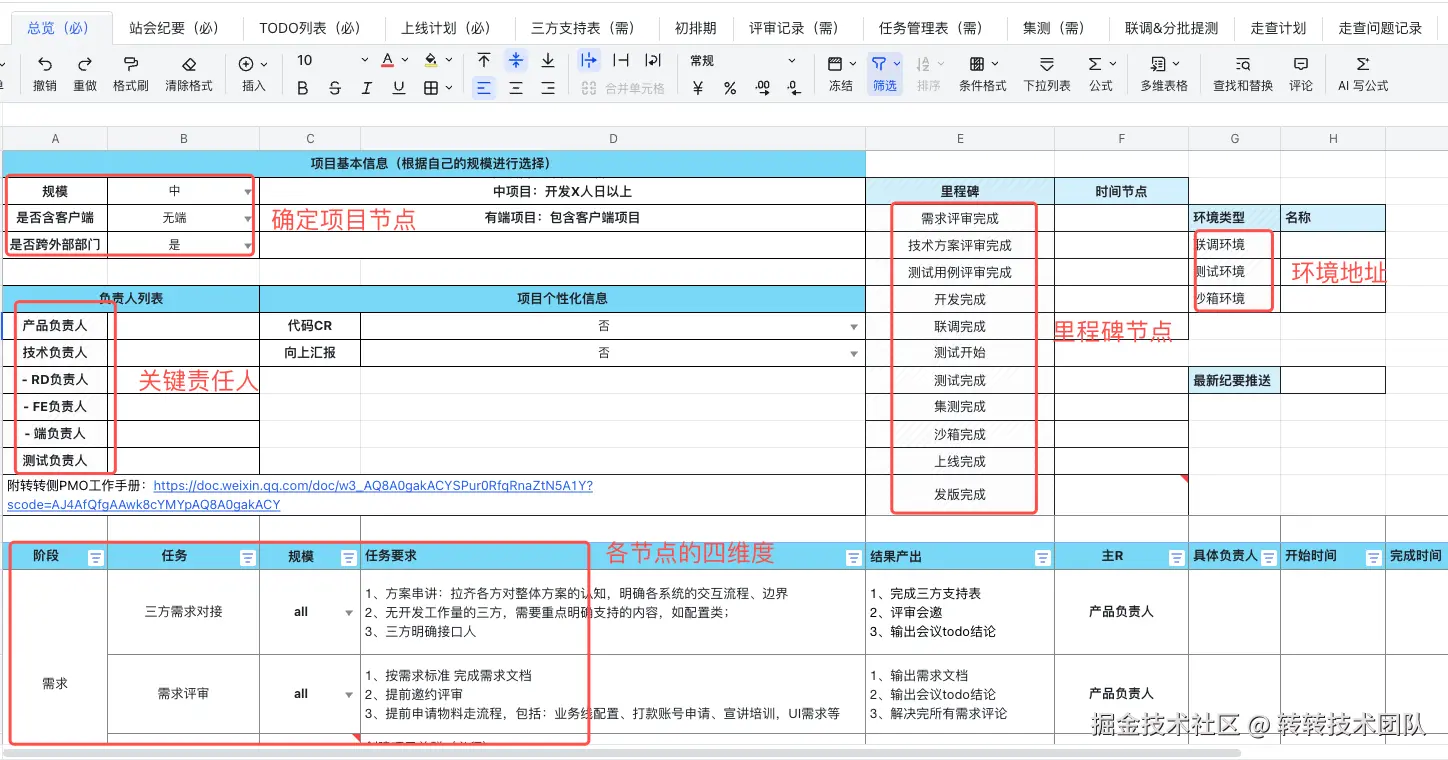

3、 四个维度定规则 清晰可落地

| 维度 | 定义 | 示例(测试期每日站会) |

|---|---|---|

| 谁 | 负责人 | 测试负责人 |

| 什么时间 | 触发条件 | 测试期间 |

| 干什么事(以什么标准) | 具体动作 | 固定时间组织站会 会上发言模板:昨日、今日、风险依赖 站会控制时间 |

| 交付什么结果 | 产出内容 | 群内发送站会记录 |

产出结果举例:站会记录要求

- 清晰阐明整体进度是否正常,风险情况(高、中、低、无)

- 若不正常,阐明原因和应对解决方案

- Todo 事项需包含:事项内容、跟进人、解决时间

我们推出一份详尽的项目管理规范,但落地不尽人意 。

比如这份"差点意思"的站会记录:

会议内容

- 测试 A:昨天测首页,好多 bug,图片加载慢、按钮点不动,环境也卡。

- 测试 B:支付模块测一半,开发改了代码没说,之前的测试白做了,今天再重新测。

- 开发 C(临时参会):A 说的按钮问题不是我写的,没法修,环境卡是运维的事。

- 待办 1:首页图片加载慢、按钮异常、环境卡顿

- 待办 2:支付模块需重新测试

深刻体会到:最难的从来不是"制定规则",而是"让规则执行"

Part 2. 如何让规则拥有"执行力"?

1、思考:为何落地难?

我们意识到执行问题可能出在三个"人性弱点"与规则的冲突:

- 记忆负担:流程节点多,易遗漏

- 执行成本:写纪要等需额外思考格式,较麻烦

- 缺失监督:无实时客观检查,全靠自觉

我们意识到:

静态文档难以落地,规则必须进化为一个动态的、能够主动驱动行为的工具。

核心问题随之而来:什么样的工具,才能真正具备驱动团队遵守规则的"力"?

2、 改变:融入而非对抗,赋能而非监控

核心思路:必须深度融入大家已经形成习惯的、最自然、最高频的协作场景里。

在我们团队,这个场景就是 "项目群"。几乎所有的项目协作都发生在这里:

- 信息中枢:需求文档、技术方案、测试用例、项目排期等核心资产,都以群公告的形式沉淀

- 协作广场:评审邀约、进度同步、问题讨论、决策拍板,所有沟通都在群聊中实时发生

破局路径由此明确: 以"项目群"为基础,将规则引擎悄无声息地编织进去 。

我们不再要求大家"看文档",而是让规则在群里"主动说话 "、"主动办事"。

1. 低成本:简单智能交互

关键信息发送至群内周知时,仅需增加 @项目管理助手

- 系统自动识别意图,存储至项目管理表格

- 将接入和信息同步成本降到最低

2. 节点推送:变"人找事"为"事找人"

规则引擎按项目排期自动推送信息:

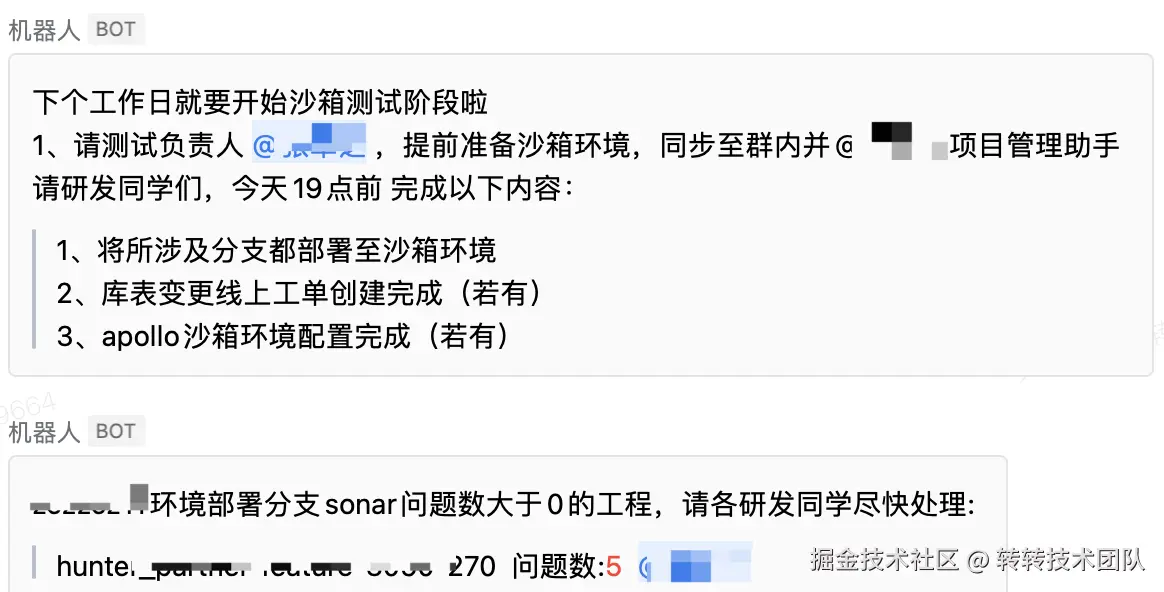

- 事前提醒 :

"下个工作日就要进入测试啦,辛苦测试负责人 @xx 申请测试环境,同步至群内并 @项目管理机器人" - 过程赋能 :

"xxx 环境所部署分支覆盖率不足,请测试负责人 @xx 关注" - 结果校验 :

"会议纪要内容风险为高,但无原因和对应解决措施"

"项目已上线,但存在未关闭缺陷,请及时关注"

Part 3. 我们是如何实现落地的?

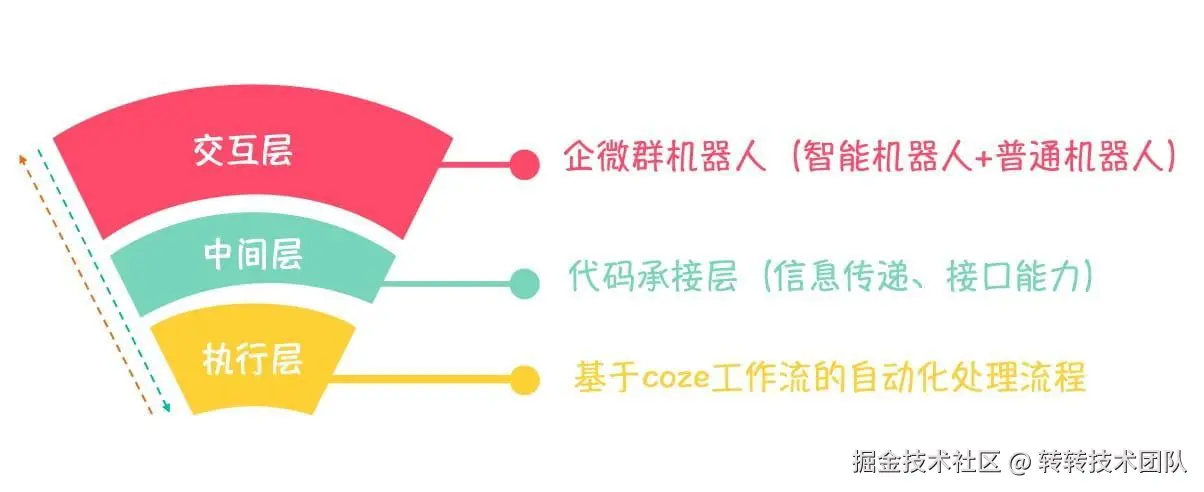

三层框架

1. 交互层:企微群机器人

- 智能机器人:接收群内消息,理解用户意图

- 普通机器人:负责定时消息推送

2. 中间层:转换层

- 将智能机器人接收到的消息传递给 Coze

- 封装代码逻辑供 Coze 调用,实现群推送等功能

3. 执行层:基于 Coze 搭建的自动化流程

-

接收用户消息

- 使用大模型识别意图、提取关键信息

- 评估输入是否符合要求

- 更新至项目管理表格

-

定时推送

- 设置触发器定时执行

- 根据项目管理表 + 当前日期 → 判断节点 → 推送信息

-

通用能力

- 覆盖率获取、静态扫描结果获取等

-

自定义 Coze 插件

- 飞书官方插件不能实现期望功能 → 开发飞书插件并上架商店(复制工作表、Sheet 页、追加数据)

- 飞书官方插件不能实现期望功能 → 开发飞书插件并上架商店(复制工作表、Sheet 页、追加数据)

简单架构图

核心数据表格

| 表名 | 作用 |

|---|---|

| 项目总览表 | 接入表,记录项目关键信息: 群聊 ID、项目名称、项目管理表格(自动创建)、TAPD 地址、群消息机器人 |

| 项目管理表 | 基于 PART1 沉淀的规则,记录项目关键节点与状态 |

具体功能说明

- 自动接入:基于群内标准化输入,自动写入总览表

- 自动更新:用户主动推送信息 → 自动更新项目管理表,无需额外维护

- 定时提醒:需执行动作/关注内容 → 自动 @ 具体人员

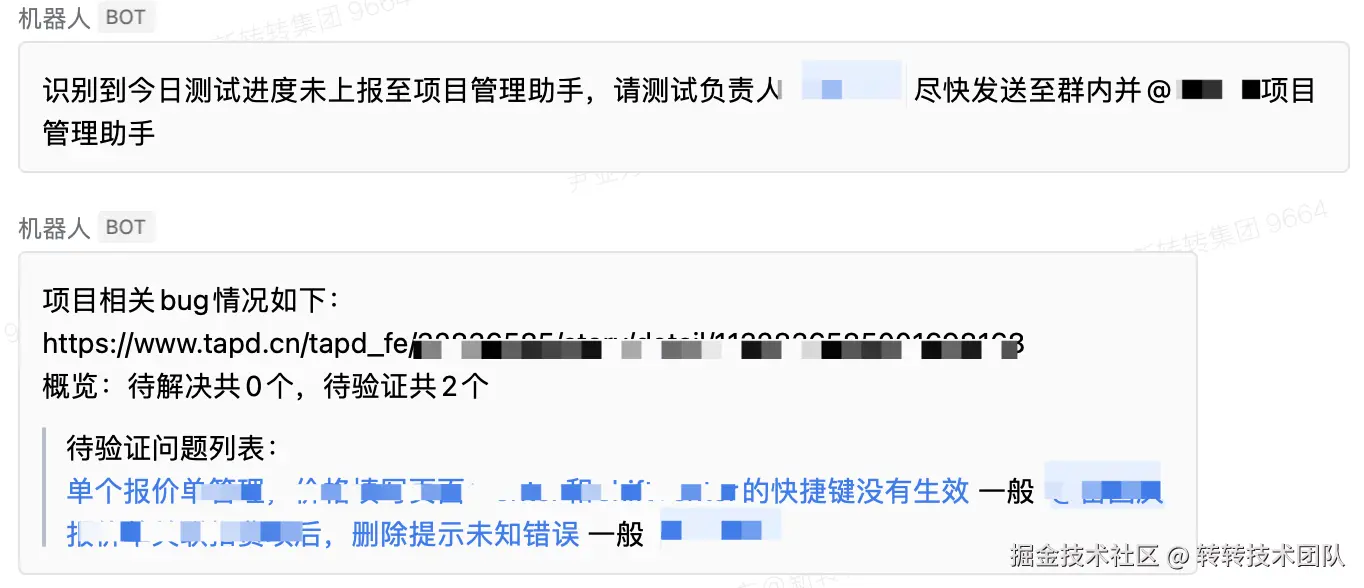

- 工具赋能:联动 TAPD、公司平台,通过接口获取节点信息 → Coze 处理 → 推送

- 自动闭环:上线后持续跟进 TAPD 状态和 Bug 情况 → 全部处理后 → 自动标记为"已上线"

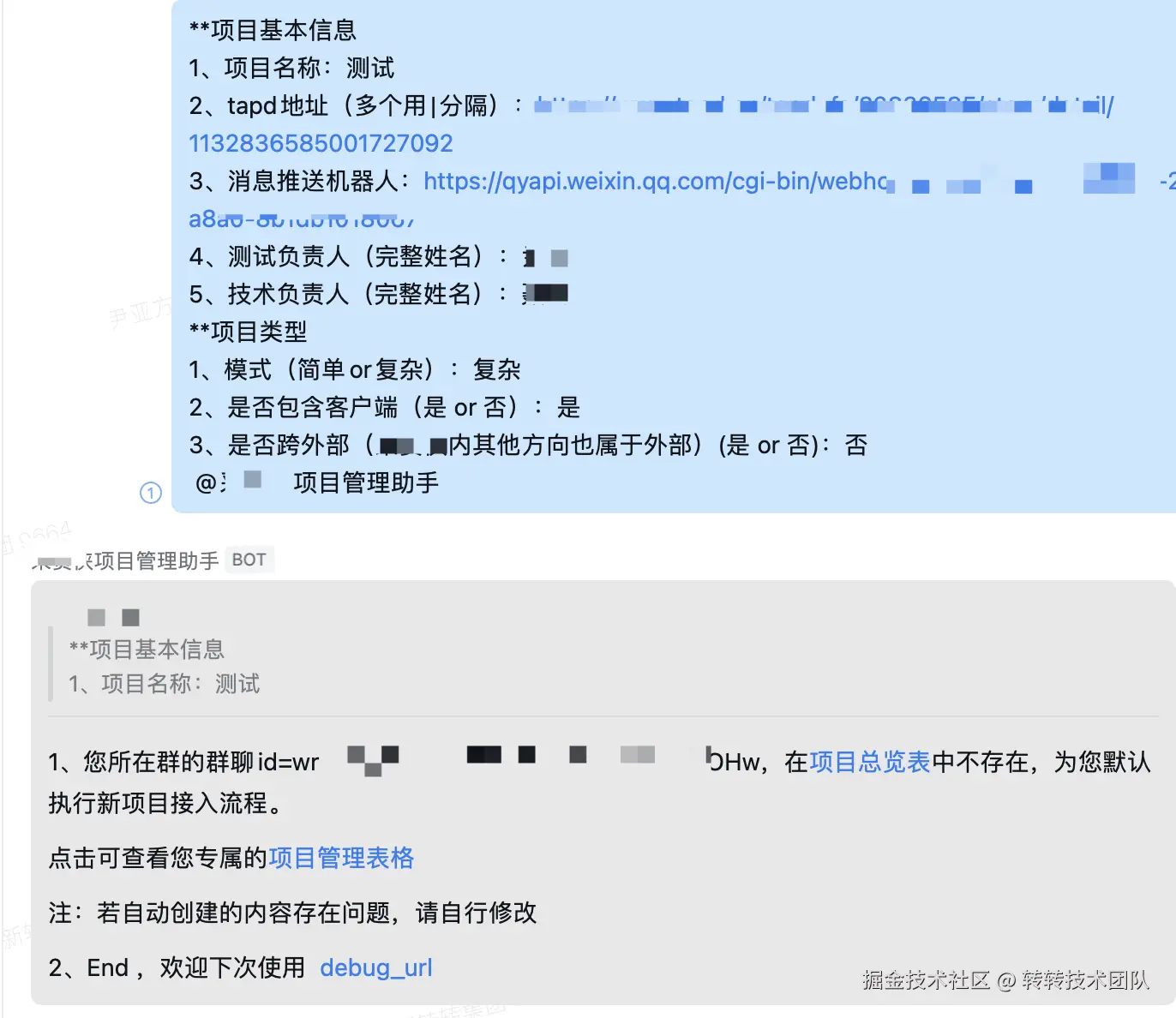

落地效果示例

- ✅ 输入信息自动接入

- ✅ 测试进度上报校验 + Bug 情况总结

- ✅ 分支覆盖率结果推送

- ✅ 提前一天事项提醒|静态扫描结果提醒

大家可能有的小疑问

Q:为什么要用 2 个机器人?

A:受企业微信限制,智能机器人只能被动响应用户主动 @ 的消息,无法主动推送。普通机器人用于定时任务。

Q:为什么不用企业微信文档?

A:企微文档能力受限,且与 Coze 集成弱;而飞书 + Coze 集成成熟,可自行开发插件,灵活度高。

相关资料合集

飞书电子表格 API:open.feishu.cn/document/se...

Coze 基于 API 创建插件:www.coze.cn/open/docs/g...

应用效果

实际反馈:

- "事项并行时,会忘记一些节点。接入后,到关键节点自动提醒,不会忘啦!"

- "Bug 情况的推送很给力,之前总有人不及时解决,需要一直催。现在每天推送后,解决进度都变快了。"

- "各分支的覆盖率是否达标一目了然,再也不用一个个检查了。"

团队建议:

- 对未完成的 Todo 列表进行提醒

- 根据上线计划,Check 是否执行到位(如定时任务是否配置并开启)

- 通过冒烟任务执行情况校验联调进度是否正常

写在最后

这个工具把我们过去靠人脑记忆、靠人工催促的规则,交给了程序。带来切实改变::

- 不再费心记忆每个时间节点该做什么

- 不用自己一个个查覆盖率、人工汇总 Bug

- 产出内容是否合理,不用组长盯,工具会自动告诉你问题在哪

最重要的是:测试团队终于能把主要精力,逐步放回测试本身。

我们仍在起步阶段,后续将赋能更多流程节点。让项目过程管理越来越轻松。

如果你也受困于"人工待办",或也想用 Coze 做一些工具赋能,欢迎一起交流!

> 转转研发中心及业界小伙伴们的技术学习交流平台,定期分享一线的实战经验及业界前沿的技术话题。

> 关注公众号「转转技术」(综合性)、「大转转FE」(专注于FE)、「转转QA」(专注于QA),更多干货实践,欢迎交流分享~