目录

[1 引言](#1 引言)

[2 理论知识与技术基础](#2 理论知识与技术基础)

[2.1 可持续性的系统定义:从"能持续存在"到"三支柱约束"](#2.1 可持续性的系统定义:从“能持续存在”到“三支柱约束”)

[2.2 生命周期视角:把"三支柱"翻译成"安全---成本---环境"三类KPI](#2.2 生命周期视角:把“三支柱”翻译成“安全—成本—环境”三类KPI)

[2.3 AI 的技术定义与能力边界:弱AI、AGI 与"理解"的争论](#2.3 AI 的技术定义与能力边界:弱AI、AGI 与“理解”的争论)

[2.4 AI 的环境负担核算:从能耗到碳排的基本方程](#2.4 AI 的环境负担核算:从能耗到碳排的基本方程)

[3 可持续性与技术:从三支柱到"系统权衡"的工程直觉](#3 可持续性与技术:从三支柱到“系统权衡”的工程直觉)

[3.1 SDGs 如何嵌在三支柱结构里](#3.1 SDGs 如何嵌在三支柱结构里)

[3.2 "Vasa 例子"背后的方法论:局部最优的组合不等于系统最优](#3.2 “Vasa 例子”背后的方法论:局部最优的组合不等于系统最优)

[3.3 交通与减排案例:同一目标下的多路径与伦理张力](#3.3 交通与减排案例:同一目标下的多路径与伦理张力)

[4 AI作为技术系统:定义、价值生成与"生成式拐点"的可持续含义](#4 AI作为技术系统:定义、价值生成与“生成式拐点”的可持续含义)

[4.1 AI 的定义之争为何影响可持续评估](#4.1 AI 的定义之争为何影响可持续评估)

[4.2 行为阈值与理解阈值:图灵测试与中文房间对风险想象的校正](#4.2 行为阈值与理解阈值:图灵测试与中文房间对风险想象的校正)

[4.3 生成式AI的"新颖性约束":数据来源、贡献者激励与模型退化](#4.3 生成式AI的“新颖性约束”:数据来源、贡献者激励与模型退化)

[5 可持续AI:目标体系、贡献路径与"无负外部性"判据](#5 可持续AI:目标体系、贡献路径与“无负外部性”判据)

[5.1 可持续AI不是单一指标,而是一组"发展目标"的约束集](#5.1 可持续AI不是单一指标,而是一组“发展目标”的约束集)

[5.2 从图2到领域贡献:医疗、环境治理、安全与反欺诈](#5.2 从图2到领域贡献:医疗、环境治理、安全与反欺诈)

[5.3 "贡献不等于可持续":从目标体系推导出"负外部性禁止"的工程检查口径](#5.3 “贡献不等于可持续”:从目标体系推导出“负外部性禁止”的工程检查口径)

[6 不可持续AI:环境---社会---经济三重失衡的生成机制](#6 不可持续AI:环境—社会—经济三重失衡的生成机制)

[6.1 环境维度:从数据中心扩张到"核算边界"导致的系统性低估](#6.1 环境维度:从数据中心扩张到“核算边界”导致的系统性低估)

[6.2 社会维度:版权、文化生态与信息失真](#6.2 社会维度:版权、文化生态与信息失真)

[6.3 经济与权力结构:自动化偏好、就业安全与"图灵陷阱"](#6.3 经济与权力结构:自动化偏好、就业安全与“图灵陷阱”)

[7 走向可持续的技术治理:用"目标---约束---核算"框架避免误判](#7 走向可持续的技术治理:用“目标—约束—核算”框架避免误判)

[7.1 "目标体系"是第一层:用图2把可持续从口号变成可验证命题](#7.1 “目标体系”是第一层:用图2把可持续从口号变成可验证命题)

[7.2 "底线约束"是第二层:三支柱的可行域思维如何落到AI系统](#7.2 “底线约束”是第二层:三支柱的可行域思维如何落到AI系统)

[7.3 "生命周期核算"是第三层:把AI环境影响从"估计"变为"可追溯账本"](#7.3 “生命周期核算”是第三层:把AI环境影响从“估计”变为“可追溯账本”)

[7.4 版权与激励机制:把"公平承认贡献"视作AI长期可用性的前提条件](#7.4 版权与激励机制:把“公平承认贡献”视作AI长期可用性的前提条件)

[7.5 就业、安全与反垄断:把分配问题纳入"可持续"的定义](#7.5 就业、安全与反垄断:把分配问题纳入“可持续”的定义)

[8 总结](#8 总结)

参考文献:Kondratenko, A., Kondratenko, A. & Kamberov, K. May AI be sustainable? An outlook on sustainability and technology. AI & Soc (2025). https://doi.org/10.1007/s00146-025-02804-x

1 引言

讨论"AI 是否可持续",最容易走偏的地方,是把"可持续"简化成单一维度的"低碳"或"节能"。在可持续科学与政策语境里,可持续并不是某项指标的最大化,而是一种系统在时间尺度上维持自身、并在多维约束下保持功能与秩序的能力;当某个方案在环境指标上看似完美,却在安全或经济上崩塌时,它依旧是不具备可持续性的。可持续发展的经典表述强调三大支柱:环境、经济与社会,并且强调三者同等重要、不可偏废。把这套结构性理解迁移到技术体系上,就会得到一个更接近工程评估的表达:技术的三类生命周期关键绩效指标分别对应安全、成本效率与环境效率,任何一项长期显著失衡,都可能使系统无法"持续存在"。这一点在"1627 年瑞典战舰 Vasa"的例子里表达得非常尖锐:它在"零排放木船"意义上几乎可以被描述为环保典范,但因为稳定性不足导致首航即沉没并造成伤亡,安全与成本效率被毁,从定义上就不可能是可持续技术。

当 AI 进入"可持续"讨论时,问题会更复杂:AI 本身是一类通用技术,既可能被嵌入到节能减排与污染治理系统中成为"加速器",也可能因为算力与数据中心基础设施扩张带来更高能耗、用水与碳排,甚至在社会层面引发版权、就业与权力结构的系统性副作用。更关键的是,AI 的收益与代价并不总是在同一个时间尺度或同一个群体上显现:企业可能在短期获得成本与效率收益,但环境与社会成本可能被外部化、延后化,或者由弱势群体承担。把这些张力组织成一个可分析的框架,才可能回答"AI 是否可持续"这一问题,而不是停留在立场对立与口号争吵。

2 理论知识与技术基础

2.1 可持续性的系统定义:从"能持续存在"到"三支柱约束"

在严格意义上,可持续首先是一个系统概念:如果一个系统在时间上无法维持自身,或其维持方式必然破坏支撑它的外部条件,那么它就不可持续。将可持续拆成环境、经济、社会三支柱的意义,不是为了把讨论变成三份清单,而是为了把"单指标最优"转化为"多约束可行"。三支柱思想强调,如果只把资源投向其中一根支柱,哪怕这一根支柱被打造得极致强壮,另外两根支柱的脆弱也会在关键时刻让系统整体倒塌;因此"优先级排序"往往不是解决方案,真正的难点是以系统方法在三者之间做权衡并保持底线。对技术而言,这种底线通常体现为:安全不能被牺牲到超出社会可接受范围,成本效率不能让技术失去可负担性与可扩散性,环境效率不能靠转移污染或隐藏排放来"看起来很绿"。这类"底线逻辑"在 Vasa 的例子里被用作隐喻:一个部件级别看似最先进的组合,若缺乏系统权衡,整体依旧可能是灾难。

为了把上述思想写成可计算的形式,可以把可持续性看成一个多维约束的可行性问题。令一个技术系统的三支柱绩效分别用三个标量表示:社会维度绩效、经济维度绩效

、环境维度绩效

。当讨论"是否可持续"时,最自然的表达不是把三者加权求和,而是先定义最低可接受阈值

,并把可持续视为满足底线的逻辑合取:

\\text{Sustainable} \\iff (S_{soc}\\ge \\tau_{soc})\\land(S_{eco}\\ge \\tau_{eco})\\land(S_{env}\\ge \\tau_{env})

这条公式背后的直觉是:可持续不是"综合分数高",而是"没有致命短板"。加权和在优化中当然常见,但它更适合用于在可行域内部做细微权衡,而不适合替代底线判断,因为加权和允许用某一维度的巨大收益去掩盖另一维度的严重损害。工程评估里常见的做法,恰恰是先做底线约束,再讨论权衡空间,这与三支柱在概念上的地位是一致的。

2.2 生命周期视角:把"三支柱"翻译成"安全---成本---环境"三类KPI

把三支柱落到技术评估的抓手上,一个非常实用的翻译是:社会维度在技术层面常通过安全(Safety)体现,经济维度常通过成本效率(Cost-efficiency)体现,环境维度常通过环境效率(Environmental efficiency)体现,并且这些指标都应当在生命周期尺度上评估,而不是只看运行阶段或某个局部环节。这个"生命周期三KPI"视角非常关键,因为它直接纠正了两类常见误判:第一类误判是只看运行阶段的零排放,而忽略制造、供应链与报废阶段的环境负担;第二类误判是把"环境效率"误当作"可持续"的全部,从而忽略安全与成本效率的系统性作用。

为了让"KPI 在生命周期上评估"更具体,可以用"功能单位"与"生命周期累积"写出一个常用的形式。设系统在生命周期内提供的总服务量(功能单位)为 (F)(例如吨公里、次诊断、次推理请求等),则成本效率可写成单位服务成本 (C/F),环境效率可写成单位服务环境负担 (E/F)(E 可以是 CO₂e、SOx、用水等多指标组合),安全可写成单位服务风险 (R/F)(R 可以是期望伤亡、事故概率或风险暴露)。于是三支柱在工程上就转化为"三个单位化指标"在生命周期上的同时满足。这种写法并不要求立刻拥有精确数据,它首先要求把边界与口径讲清楚,从而避免只在某个环节做"局部最优"的叙事。

表1 三支柱与技术生命周期KPI的对应关系

| 可持续三支柱 | 技术侧典型KPI(生命周期评估) | 为什么必须在生命周期上看 |

|---|---|---|

| 环境(Environmental) | 环境效率:单位服务的排放/污染/资源消耗 | 运行阶段"看起来干净"不代表供应链与制造阶段干净 |

| 经济(Economic) | 成本效率:单位服务成本、可负担性、可扩散性 | 成本不可控会阻断规模化,从而破坏"可持续存在" |

| 社会(Social) | 安全、健康、权益、分配公平等(技术侧常落到安全与权利) | 社会不可接受的风险与伤害会引发反弹与制度性限制 |

2.3 AI 的技术定义与能力边界:弱AI、AGI 与"理解"的争论

AI 的可持续讨论必须先回答"AI 是什么"。一个务实的定义是:AI 是一种能以接近、等同或超过人类能力的效率,完成某些智力任务的技术;在这种定义下,电子计算器或智能手机也可以被视作 AI 的实例。与此同时,AI 常被区分为"狭义/弱 AI"(面向特定任务的智能)与"强 AI/通用人工智能 AGI"(具备类似人类的一般推理能力),而现实中的主流进展主要属于弱 AI。

围绕 AI 是否可能达到"理解"与"推理"的水平,经典讨论会引用图灵测试作为"行为主义阈值",也会引用中文房间思想实验指出"符号操作不等于理解"的质疑;这些讨论在可持续议题里并非哲学旁枝,因为它们决定了社会对 AI 能力与风险的预期管理方式。当社会把 AI 误当作"会理解的主体"时,责任归属、信任边界与治理机制都会偏离现实;而当社会把 AI 完全当作"无风险工具"时,又会忽略其在信息传播、就业结构、权力集中等方面的系统性外溢效应。尤其是生成式 AI 在 2020 年代的突破,显著扩大了 AI 在语言、图像、视频与音乐等创造性任务上的可用性,但也引入了"新颖性、相似性与数据依赖"相关的争议:如果模型高度依赖人类既有内容的持续输入,那么训练数据的合法性、贡献者的激励机制、以及"AI 生成内容反哺训练导致模型退化"的风险,都会变成可持续问题的一部分。

2.4 AI 的环境负担核算:从能耗到碳排的基本方程

在环境维度上,AI 的资源消耗最终需要落到能量与物质通量。最常用的一条链路是"电能---碳强度---碳排":如果系统消耗电能 (E)(kWh),所在电力结构的碳强度为 (CI)(kgCO₂e/kWh),则碳排可写为:

\\mathrm{CO_2e} = E\\cdot CI

而电能来自功率随时间的积分,粗略可写为:

E=\\int_{0}\^{T}P(t),dt\\approx \\overline{P},T

这些公式本身并不新,但它们强调了两个经常被忽视的事实:第一,降低碳排既可以通过降低能耗(更高效的算法、硬件、系统设计)实现,也可以通过降低电力碳强度(更清洁的电力结构)实现;第二,只在"最终训练一次"的能耗上做核算,往往会系统性低估真实环境代价,因为研发迭代、调参试验、数据处理与反复训练都在累计能耗与资源消耗。对于生成式模型尤其如此,一项"只算最后一次大训练"的核算方式,会把大量开发阶段的资源消耗排除在系统边界之外,从而产生过度乐观的结论。

3 可持续性与技术:从三支柱到"系统权衡"的工程直觉

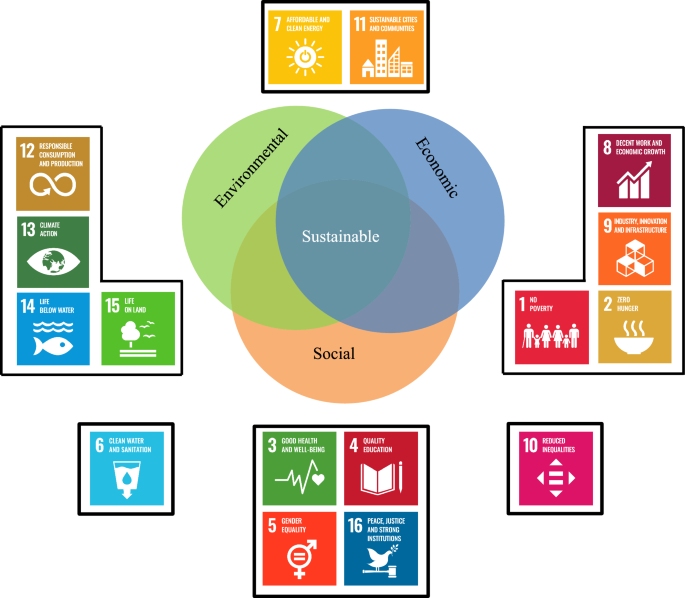

3.1 SDGs 如何嵌在三支柱结构里

联合国可持续发展目标(SDGs)之所以常被用作三支柱的"可视化锚点",是因为它把抽象的三支柱拆解为更具体的治理目标。图1把环境、经济、社会三个圆相交的结构放在中央,并在周边用具体 SDG 图标做了映射:环境侧聚集了负责任消费与生产、气候行动、水下生物、陆地生物等目标;经济侧聚集了体面工作与经济增长、产业创新与基础设施等目标;社会侧聚集了健康福祉、优质教育、性别平等、清洁饮水与卫生设施、减少不平等、和平正义与强大机构等目标,同时也包含消除贫困、零饥饿等基本民生目标;此外,清洁能源与可持续城市社区等目标被放在上方,体现其跨支柱的性质。

为了让这张图在工程语境里可用,一个有帮助的做法是把 SDGs 看成"约束集合",而不是"愿望清单"。当某项技术被宣传为"绿色"时,应当追问它在哪些 SDGs 维度上提升了系统能力,又在哪些维度上制造了新的外部性。比如"零排放"如果以牺牲安全为代价,那么它会在 SDG 的"健康与安全""社会福祉""强大机构与治理"等维度引发反作用;同理,如果"减排"靠大幅提高成本实现,从而让服务变得不可负担,那么它会冲击"消除贫困""减少不平等"等目标。也正因如此,三支柱与 SDGs 的结合提供了一种更稳健的判断方式:不是问"这技术是不是绿色",而是问"它能否在多目标体系内维持长期均衡"。

表2 图1中SDGs与三支柱的映射

| 支柱/区域(按图1布局) | 图中出现的SDG编号与名称(中文对照) |

|---|---|

| 环境相关(Environmental 侧) | 12 负责任消费和生产;13 气候行动;14 水下生物;15 陆地生物 |

| 经济相关(Economic 侧) | 8 体面工作和经济增长;9 产业、创新和基础设施 |

| 社会相关(Social 侧及社会治理相关) | 1 消除贫困;2 消除饥饿;3 良好健康与福祉;4 优质教育;5 性别平等;6 清洁饮水与卫生设施;10 减少不平等;16 和平、正义与强大机构 |

| 跨支柱(图顶端) | 7 经济适用的清洁能源;11 可持续城市和社区 |

3.2 "Vasa 例子"背后的方法论:局部最优的组合不等于系统最优

Vasa 的故事之所以在可持续技术讨论中有效,是因为它把"单指标叙事"击穿得很彻底:如果只读"零排放、风助推进、能效船体、先进装备、极致装饰",几乎没有人会拒绝把它称为"可持续船舶";但一旦把安全与成本效率纳入评价,结果立刻反转。这个例子指出两层方法论:其一,可持续必须要求三支柱都达到"令人满意"的水平,而不是允许某一支柱的失败;其二,系统效率来自权衡而非堆砌,哪怕每个组件都被各自优化到极致,缺乏系统权衡仍可能导致整体性能灾难。进一步地,当评价维度多元时,单一学科视角往往会失效,因为不同维度需要不同知识体系来刻画,因而可持续技术开发需要跨学科或超学科的方法,让不同领域的洞见在同一个决策框架里被平等对待。

将这种方法论抽象成一个"系统权衡"的数学直觉,可以把技术设计看作带约束的多目标优化:在满足安全底线、成本底线、环境底线的前提下,再去最大化综合效用。形式上可以写为:

\\max_{\\theta};U(\\theta)\\quad \\text{s.t.}\\quad S_{soc}(\\theta)\\ge \\tau_{soc},; S_{eco}(\\theta)\\ge \\tau_{eco},; S_{env}(\\theta)\\ge \\tau_{env}

这里 是技术方案与运行策略的集合,U 是综合效用或社会福利函数。这个写法故意把"底线约束"与"效用最大化"分开,强调可持续判断首先是可行性问题,然后才是最优性问题。Vasa 的失败可以被解释为它根本不在可行域内:安全约束被违反,再多的环境优势也无法把它拉回"可持续"。

3.3 交通与减排案例:同一目标下的多路径与伦理张力

在更现实的技术对比中,水上货运被视作一种在三维指标上表现突出的可持续技术:其在单位吨公里 CO₂ 排放上具有很强的环境效率,在单位吨公里成本上具有成本优势,并在安全性(以人员致死风险衡量)上也处于领先行列。这种"三维同时占优"的情形并不多见,因此它经常被用作说明"可持续不是幻想,确实存在结构性优势路径"。与此同时,监管与技术也会相互塑形,例如国际海事组织在防治船舶空气污染方面的法规实施,被认为显著降低了 SOx 排放;而闭式循环洗涤器等技术也在低成本条件下减少空气污染并限制污水排放。

与此形成对照的是电动汽车与航空:电动汽车在某些情形下确实有显著的减排潜力,但这种潜力依赖于电力来源的清洁程度;如果电能来自可再生能源,减排效果才可能接近显著幅度,而生命周期成本仍可能高于传统燃油车,并且动力系统与电池生产环节还可能带来对人类与动物有毒物质的生命周期排放上升。航空则在安全性与速度、成本效率上表现突出,却是温室气体排放强度较高的运输方式;提升能效可以带来一定比例的减排,但用零排放燃料完全替代航空燃料可能使航空运输失去可负担性,从而在经济维度与社会可达性上产生反作用。

如果把"政策工具"纳入讨论,碳定价与绿色补贴常被视作普遍的去碳化手段。碳定价通过让排放付费来提供减排激励,绿色补贴则通过降低绿色技术成本来提升其市场竞争力;但即便在"理论减排效率"层面碳定价可能表现更好,它仍可能在伦理与实践层面引发可持续性争议,例如富裕主体"付费逃避承诺"、以及碳税负担向中低收入群体转嫁导致分配不公;同时,排放交易还可能让环境解决方案呈现"人为的成本效率",从而抑制真正具备经济竞争力的生态创新,并推高商品与服务价格、降低生活水平、加剧社会分层。补贴在表面上更"可持续",是因为它倾向于降低终端价格,但其财政负担与长期激励结构同样需要系统评估。

表3 典型技术/政策路径在三支柱上的张力

| 路径/案例 | 环境维度(环境效率) | 经济维度(成本效率/可负担) | 社会维度(安全/公平/可接受) | 关键张力点 |

|---|---|---|---|---|

| 水上货运 | 单位吨公里CO₂排放优势明显 | 单位吨公里成本优势明显 | 致死风险等安全指标表现较好 | "三维同时占优"较罕见,提示结构性优势路径存在 |

| 船舶防污法规 + 洗涤器技术 | SOx 排放显著降低,污染控制更有效 | 技术成本较低、可扩散性强 | 对健康与生态系统有益 | 需要在排放转移(空气→水)等边界上做生命周期核算 |

| 电动汽车(一般论) | 具备减排潜力,但依赖电力清洁度 | 生命周期成本可能更高 | 某些有毒物质排放可能上升 | 运行端"干净"不等于全生命周期"干净" |

| 航空 | 能效提升可减排一定比例 | 成本效率与速度优势强 | 安全性强但排放压力大 | "完全零排放燃料替代"可能冲击可负担性 |

| 碳定价 | 可能具有较高减排效率 | 通过价格机制驱动替代 | 存在分配不公等伦理争议 | 价格负担转嫁与"付费逃避"削弱可持续正当性 |

| 绿色补贴 | 通过降低绿色技术成本促进减排 | 可能降低终端价格 | 更易获得社会接受 | 财政与激励结构需系统评估,避免新的不公平 |

4 AI作为技术系统:定义、价值生成与"生成式拐点"的可持续含义

4.1 AI 的定义之争为何影响可持续评估

AI 没有统一标准定义,但在可持续讨论里,一个工作性定义往往更有用:AI 是能以接近或超过人类效率完成某些智力任务的技术。在此定义下,AI 的边界被显著拉宽,计算器和智能手机都可纳入;这在治理上带来一个重要启示:如果把 AI 仅等同于大模型或生成式系统,就会忽略大量已经深度嵌入社会基础设施的"弱 AI",而这些系统的可持续外部性可能更隐蔽、更难退出。与此同时,弱 AI 与 AGI 的区分也提示:可持续讨论不应被"强 AI 想象"绑架,现实中的风险与收益主要来自狭义系统在规模化部署中的系统效应,包括基础设施扩张、制度适配滞后、与社会结构的再分配冲击。

4.2 行为阈值与理解阈值:图灵测试与中文房间对风险想象的校正

图灵测试把"是否像人类"转化为一种行为判别:当对话中人类无法区分对方是人还是机器,就可认为机器达到了某种关键阈值。与此相对,中文房间思想实验强调:即便系统能给出完美回答,它也可能只是按照形式规则处理符号,并不具备真正理解。两者在哲学上争论不休,但在可持续议题中,它们共同提醒一个实践问题:社会对 AI 的信任与委托往往基于"它看起来懂",而不是基于"它真的懂"。当生成式系统能够提供高度连贯、甚至具有说服力的错误信息时,信息生态、教育与公共决策会被系统性扰动;这类扰动不是单点故障,而可能成为社会维度可持续性的压力源。

4.3 生成式AI的"新颖性约束":数据来源、贡献者激励与模型退化

生成式 AI 的扩张在某种意义上把"可持续"问题从能源与碳排,延伸到知识产权、文化生态与激励结构。一个核心矛盾是:如果生成式系统要持续提高质量并保持新颖性,就需要持续获得新的高质量人类内容或真实世界数据;而如果训练数据大量来自未经授权的内容抓取,或内容贡献者无法获得公平认可与补偿,那么贡献者会减少公开发布,网络上的高质量人类内容比例下降,AI 生成内容比例上升,反而会让训练数据变得更"自我循环",触发模型质量退化甚至"崩塌"。这种链路把版权与激励机制转化为技术可持续性的条件变量:不是"道德问题",而是"输入分布能否长期维持"的系统问题。相关讨论不仅涉及内容抓取引发的诉讼,也涉及研究指出当训练数据中 AI 生成内容比例升高时模型会快速退化的风险。

将这一矛盾写成一个简单的动态直觉,可以设在线内容池中"人类原创内容比例"为,AI 生成内容比例为

。如果创作者激励不足导致

下降,而模型训练对高质量人类内容的依赖使性能 Q对

单调上升,则长期稳定需要满足"激励---供给---质量"的正反馈不崩坏。形式上可用一个象征性关系表达:

\\frac{dQ}{dt} = f(p_h(t)) - g(\\text{噪声},,p_{ai}(t))

其中 f表示人类高质量内容对模型性能增长的贡献,g 表示噪声与自生成数据比例导致的退化。这个表达不追求定量预测,而是强调:版权、补偿与数据治理之所以属于可持续议题,是因为它们会改变的演化,从而改变模型长期可用性。

5 可持续AI:目标体系、贡献路径与"无负外部性"判据

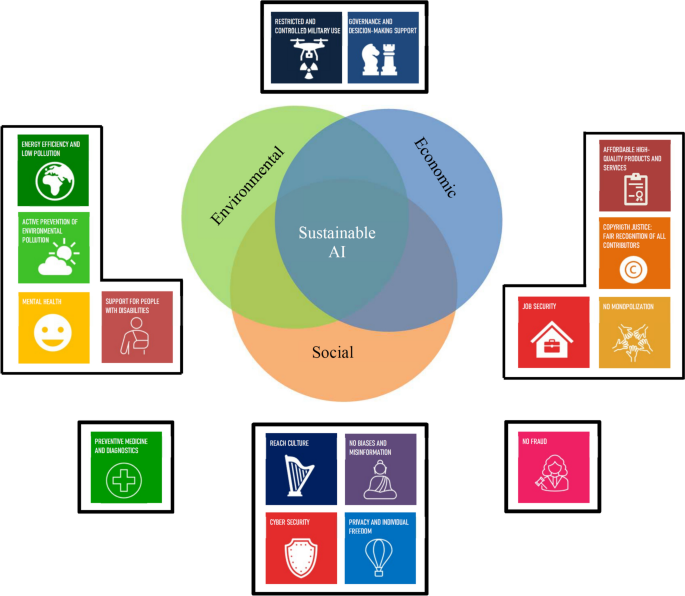

5.1 可持续AI不是单一指标,而是一组"发展目标"的约束集

当把可持续技术的三支柱要求迁移到 AI 上,一个更合适的表达不是"让 AI 更绿色",而是为 AI 构造一组发展目标,使其在推进某些目标时不以损害其他目标为代价。图2用与 SDGs 类似的方式提出了"可持续 AI 发展目标":中央仍是环境、经济、社会三圈交叠,但周边目标更贴近 AI 系统的具体外部性与社会期待,例如能效与低污染、积极预防环境污染、预防医学与诊断、心理健康、支持残障群体、可负担的高质量产品与服务、版权正义(公平承认贡献者)、就业安全、反垄断(不垄断化)、反欺诈、文化可达性、无偏见与反错误信息、网络安全、隐私与个体自由,以及"受限且受控的军事使用""治理与决策支持"等。

把图2转成可操作判据,可以将"可持续 AI"视为一个多目标约束满足问题。设目标集合为 ,AI 系统在生命周期内对每个目标的净影响为

,则图2隐含的判据可写成:系统至少在某些目标上产生正贡献,同时不应对其他目标造成负影响。一个最贴近原意的逻辑表达是:

\\exists i,;\\Delta G_i\>0 \\quad \\text{and}\\quad \\forall j,;\\Delta G_j\\ge 0

这条公式表达了两个关键点:第一,可持续不是"对所有目标都有巨大贡献",而是"有明确的正贡献方向";第二,可持续也不是"只要有贡献就行",而是"不能用其他目标的负外部性来交换"。当把这条判据放回现实,就会得到一个更严格的要求:AI 的成本与效率收益如果以更高碳排、更强监控、更大不平等为代价,就不能被称为可持续,这与"只看经济或只看环境"的单维叙事形成明显区别。

5.2 从图2到领域贡献:医疗、环境治理、安全与反欺诈

在图2的目标体系下,AI 的正向贡献可以被组织为若干"与三KPI一致"的路径。经济维度上,AI 被强调的一个普遍收益是降低成本与提升决策表现,从而提升产品与服务的可负担性与质量;这一点不仅体现在企业运营效率,也体现在医疗、物流、教育等服务体系的资源配置中。社会维度上,预防医学与诊断被视作非常典型的可持续贡献路径:早期诊断能够减少严重并发症,提高治疗及时性与有效性;同时,AI 在假肢与外骨骼等辅助技术中被用于实现高精度控制,以改善残障与老年群体生活质量,并在康复与能力增强方面发挥作用。相关报道中甚至给出了上肢外骨骼在一定响应时间条件下达到较高运动准确率的结果,用以说明"支持残障群体""改善健康福祉"不是抽象口号,而可以对应具体技术指标。

环境维度上,AI 的贡献被拆成两类:一类是主动用 AI 优化系统以提升能效、降低排放;另一类是提升能耗预测等能力,以更好地调度能源与资源。在安全维度上,AI 被用于碰撞损伤预测与规避(例如自动驾驶车辆与船舶),并可用于网络安全威胁检测与欺诈预防。值得注意的是,这些贡献路径本身并不保证"AI 就可持续",它们只是说明在目标体系内存在明确的正贡献方向;是否可持续仍取决于其生命周期内是否在其他目标上产生负外部性,例如为了提升诊断准确率而扩大隐私侵害,为了提升能效而引入监控与压迫工具,或为了降低企业成本而引发就业安全与权力集中风险。

表4 图2"可持续AI目标"的中文对照与主要指向

| 目标标签 | 中文对照 | 主要关联的三支柱维度(理解性归类) |

|---|---|---|

| Energy efficiency and low pollution | 能源效率与低污染 | 环境(也影响经济成本) |

| Active prevention of environmental pollution | 主动预防环境污染 | 环境 |

| Preventive medicine and diagnostics | 预防医学与诊断 | 社会(健康),也影响经济成本 |

| Mental health | 心理健康 | 社会 |

| Support for people with disabilities | 支持残障人群 | 社会 |

| Affordable high-quality products and services | 可负担的高质量产品与服务 | 经济(也影响社会公平) |

| Copyright justice: fair recognition of all contributors | 版权正义:公平承认所有贡献者 | 社会与经济(激励结构) |

| Job security | 就业安全 | 社会与经济 |

| No monopolization | 不垄断化 | 经济与社会(权力结构) |

| No fraud | 无欺诈 | 经济与社会 |

| Reach culture | 文化可达性 | 社会 |

| No biases and misinformation | 无偏见与无错误信息 | 社会(信息生态) |

| Cyber security | 网络安全 | 社会与经济 |

| Privacy and individual freedom | 隐私与个体自由 | 社会 |

| Restricted and controlled military use | 限制且受控的军事使用 | 社会治理(跨支柱) |

| Governance and decision-making support | 治理与决策支持 | 社会治理(跨支柱) |

5.3 "贡献不等于可持续":从目标体系推导出"负外部性禁止"的工程检查口径

当用图2的目标体系来评估 AI 系统时,一个重要结论是:只要把 AI 放进某个"绿色应用"里并不能自动获得"可持续"标签。原因在于系统评估关心的是净影响与外溢影响,而不是局部任务的效率提升。举例来说,一个用 AI 优化能源调度的系统,如果依赖高强度数据采集并侵害隐私,或者其算力成本导致能耗与碳排上升,净环境收益可能被抵消,社会维度还会恶化;再如,一个用 AI 自动化客服的系统,如果显著削弱就业安全并加剧收入不平等,那么它在经济效率上可能得分很高,却在社会维度上破坏了可持续底线。图2之所以把"就业安全""不垄断化""隐私与个体自由""无欺诈""版权正义"等目标与"能效减排"并列,恰恰是为了避免把可持续误读成"环保单项"。

6 不可持续AI:环境---社会---经济三重失衡的生成机制

6.1 环境维度:从数据中心扩张到"核算边界"导致的系统性低估

AI 在环境维度上的主要风险,并不只是"它耗电",而是耗电与碳排在规模化部署中呈现的结构性增长,以及对核算边界的系统性低估。实践数据显示,企业环境报告中已经出现与 AI 基础设施扩张相关的排放上升:例如某些企业报告其 2023 年碳排较基线年份增长超过一定比例,并将增长主要归因于生成式 AI 所需的基础设施与电力;同样也有企业报告 2023 年碳排相对基线增长,并将额外排放与数据中心能耗与供应链相关增长联系起来。这里的关键不是具体公司,而是机制:当 AI 被大规模集成到产品与服务中时,推理需求与训练需求共同推动算力基础设施增长,而基础设施扩张会通过电力消耗与供应链排放反映到环境指标上。

比"排放上升"更隐蔽的问题是"核算口径偏小"。有研究指出,乐观的 AI 环境影响估计往往只考虑最新模型的最终训练与运行需求,却忽略了开发阶段的大量迭代试验;当把开发过程纳入"整体核算"后,得到的资源消耗量级会明显不同,甚至可以用"足以支撑一个平均家庭多年用电""相当于一个人多年用水"等类比来呈现其规模感。对于可持续评估而言,这意味着一个非常具体的技术要求:必须把 AI 系统的生命周期边界划清楚,至少应当将"开发迭代 + 最终训练 + 推理部署 + 基础设施与供应链"纳入同一框架,否则"可持续"判断会建立在系统性低估之上。

将"边界偏小"写成一个可检查的核算分解,可以把 AI 的环境负担拆成若干项的和:

I_{env}=I_{dev}+I_{train}+I_{infer}+I_{infra}+I_{supply}

这里表示研发与试验阶段的累计消耗,

表示最终训练,

表示部署推理,

表示数据中心与硬件基础设施运行,

表示供应链与制造相关负担。所谓"只算最终训练",相当于把

与部分

,

从系统边界里剔除,这在方法论上就会导向低估。

另外,环境负担还体现在"单位服务能耗差异"。有观点引用研究机构报告指出,某些生成式系统的单次查询能耗可能显著高于传统搜索查询,这意味着如果以生成式系统替代搜索入口,哪怕用户行为不变,总体能耗也可能上升,从而对气候行动目标形成阻力。这个机制与传统 ICT 系统的"效率提升但需求扩张"并不矛盾:当单位服务能耗更高且服务规模更大时,总量压力会更突出。

表5 AI环境影响核算的"边界分解"与常见低估点

| 核算模块 | 应纳入的活动范围(概念性) | 常见低估点 |

|---|---|---|

| 开发迭代 (I_{dev}) | 反复试验、调参、数据处理、模型选择等 | 只统计"最后一次训练",忽略大量试验消耗 |

| 最终训练 (I_{train}) | 最终版本模型训练的电能/水资源消耗 | 单独统计易被当作"全部影响" |

| 推理部署 (I_{infer}) | 线上调用、批处理推理、模型更新等 | 忽略规模化调用带来的长期累积 |

| 基础设施 (I_{infra}) | 数据中心运维、冷却、冗余、网络等 | 把基础设施当作"既有"而不归因于AI需求增长 |

| 供应链 (I_{supply}) | 硬件制造、运输、上游材料等 | 仅关注用电,忽略供应链排放与资源消耗 |

6.2 社会维度:版权、文化生态与信息失真

社会维度的不可持续风险在生成式 AI 时代表现得尤为集中,其中版权与贡献者权益是一条非常典型的链路:当训练数据大量来自对网络公开内容的抓取,而缺乏同意、署名与补偿时,风险不仅在于法律诉讼与道德争议,更在于它会破坏内容生产的激励结构,长期削弱高质量人类内容供给,从而反噬模型训练与社会文化生态。现实中已经出现围绕训练数据与内容使用的诉讼案例,也出现内容行业的集体行动与罢工,推动对 AI 使用提出更透明的规则,例如要求对演员形象数字化复制获得同意并给予同等报酬等;这些行动把"版权正义""公平承认贡献者"从价值宣言变成制度议题。

更深一层的社会风险来自信息失真与说服性错误:生成式系统可能在"幻觉"状态下生成错误信息并表现出较强说服力,用户不一定具备及时识别与纠错能力;在更大尺度上,错误信息、偏见扩散、以及由推荐算法形成的"过滤气泡"会影响公共讨论的多样性与理性基础。与此同时,AI 也被指出可能被用于金融欺诈与欺骗,或者在聊天机器人等应用中传播性别与种族偏见。信息生态一旦被持续污染,社会维度的可持续性会受到长期侵蚀,因为社会的协作能力与治理质量都依赖相对可信的信息基础。

在更极端的社会治理风险上,AI 的人脸识别、情绪识别、大数据收集与健康信息的非授权获取等能力,被描述为可能被专制政府用于监控与压制异议,从而损害个体自由与人权。这类风险之所以必须进入"可持续 AI"框架,是因为可持续本就包含社会与制度维度:如果技术扩散的代价是更系统的压迫与权利退化,那么无论其经济效率多高,都不能被视作可持续。图2把"隐私与个体自由""治理与决策支持""限制且受控的军事使用"放入目标体系,正是对这种风险的结构化回应。

6.3 经济与权力结构:自动化偏好、就业安全与"图灵陷阱"

经济维度的不可持续风险常被误读为"技术进步导致岗位变化",但更关键的是自动化的制度激励可能把 AI 引向替代人类劳动而非增强人类能力,从而削弱就业安全、繁荣与福祉。相关讨论提出"图灵陷阱"的概念:当机器成为更好的劳动替代品时,劳动者的经济与政治议价能力下降,并越来越依赖控制技术的主体;在既有税制与激励结构下,企业更倾向于投资自动化而不是人类增强,这会放大分配不平等。现实案例中也出现企业公开表示减少招聘、缩减员工规模并归因于 AI 替代带来的效率提升,同时以此解释内部薪酬变化;另一些与 AI 相关的"数据标注/审核"工作则被描述为高要求但低报酬,说明即使是"人机协作"的增强路径,也可能在缺乏制度约束时变成不公平补偿。

在更宏观的结构风险上,当 AI 技术由少数主体开发与控制时,存在显著的权力集中风险,可能改变国家与阶层之间的权力平衡;即便 AI 能提升生产率并增加全球财富,如果缺乏分配机制,这种增量也不一定转化为多数人的福祉,反而可能加剧不平等。同时,竞争逻辑也可能迫使多数人在"拥抱 AI 否则淘汰"的范式下生存,工作与生活边界被进一步挤压。与直觉相反,AI 的替代可能先冲击创造性劳动而把重复性劳动留给人类,这对文化与自我认同也会形成压力。

表6 不可持续AI的主要风险链路(按三支柱归并整理)

| 支柱维度 | 风险链路(概念化) | 典型表现(来自讨论要点) |

|---|---|---|

| 环境 | 基础设施扩张 + 核算边界偏小 → 排放/用水被低估或上升 | 企业环境报告出现排放基线增长并关联AI基础设施;只算最终训练会低估开发阶段;单位查询能耗差异可能带来总量压力 |

| 社会 | 训练数据抓取 → 版权冲突与激励结构破坏 → 文化生态受损;说服性错误与偏见扩散 → 信息生态污染;监控工具化 → 权利退化 | 诉讼与罢工推动更透明AI使用规则;AI生成内容占比上升可能导致模型退化;幻觉与欺诈、偏见、过滤气泡、隐私侵犯与压迫工具化 |

| 经济 | 自动化偏好 + 制度激励 → 就业安全下降;财富与权力集中 → 不平等扩大 | "图灵陷阱"描述劳动议价权下降与依赖控制技术者;企业减少招聘、裁员并归因AI替代;技术控制者权力集中风险 |

7 走向可持续的技术治理:用"目标---约束---核算"框架避免误判

7.1 "目标体系"是第一层:用图2把可持续从口号变成可验证命题

要避免把可持续 AI 讨论变成道德争吵,第一步是把可持续具体化为"目标体系"。图2提供了一种结构化模板:它把环境、经济、社会三圈作为底层结构,把"能效与低污染、预防医学、就业安全、版权正义、隐私自由、反欺诈、网络安全、反垄断、无偏见与无错误信息"等作为可观察目标,把"受控军事使用、治理与决策支持"作为跨支柱治理目标。这样一来,"AI 是否可持续"就被转化为可检验命题:系统是否在若干目标上形成净正贡献?是否在任何目标上产生显著负外部性?如果负外部性存在,是否可以通过设计与制度修正消除?这种问法比"AI 会不会拯救地球"更接近工程与政策的现实。

7.2 "底线约束"是第二层:三支柱的可行域思维如何落到AI系统

在可行域思维下,AI 的经济效率收益不能自动抵消环境与社会损害。把这一点落到 AI 系统的工程评估上,最直接的方式是把三支柱底线转成可量化约束。例如环境底线可以通过碳排预算与用水预算表达,经济底线可以通过可负担性与市场结构(例如避免垄断)表达,社会底线可以通过隐私侵害阈值、偏见指标、工作质量与就业安全指标表达。这样做的意义不在于立即得到完美指标体系,而在于明确"不可交换的底线"。当某个系统的商业价值建立在侵害隐私、未经授权使用内容、或将风险转嫁给弱势群体之上时,它在底线层面就已经越界,后续再讨论"总体更好"往往只是叙事策略而非科学评估。

7.3 "生命周期核算"是第三层:把AI环境影响从"估计"变为"可追溯账本"

环境维度上最可操作的改进,是把核算边界从"最终训练"扩展到"开发---训练---推理---基础设施---供应链"的全链路,并把能耗、碳排与用水纳入同一账本。讨论中已经明确指出,只算最终训练与运行会低估开发阶段的大部分影响,并给出了开发过程的整体影响类比;这意味着可持续 AI 的环境评估至少应当满足两个条件:第一,核算边界必须包含开发迭代;第二,核算必须能追溯到能源结构与基础设施来源,否则 CO₂e 只是一个漂浮的数字。进一步地,如果单位查询能耗显著高于传统替代方案,那么规模化替代就需要特别审慎,否则可能在宏观上阻碍气候行动。

7.4 版权与激励机制:把"公平承认贡献"视作AI长期可用性的前提条件

在社会维度上,版权正义并不只是"是否尊重创作者",而是 AI 产业链能否长期获得高质量训练数据与社会许可的前提。围绕数据抓取与训练材料使用的诉讼与行业行动,实际上在推动一种"可持续数据契约":明确同意、明确补偿、明确透明度,并将 AI 定位为增强而不是替代。更深层的逻辑是,如果贡献者无法被公平认可并获得补偿,他们会减少公开分享,AI 训练数据结构会发生变化,AI 生成内容比例上升并带来模型退化风险,这会把版权问题转化为"模型长期性能维持"的技术问题。可持续 AI 目标体系把"版权正义"与"文化可达性"并列,恰恰是在强调:文化生态是一个需要激励与规则维护的系统,而不是无限可免费开采的矿。

7.5 就业、安全与反垄断:把分配问题纳入"可持续"的定义

在经济与社会交界处,最大的挑战往往是分配与权力结构。自动化偏好、税制激励与市场集中可能共同推动"图灵陷阱"式路径:企业通过替代劳动获得收益,而劳动者议价权下降并依赖控制技术的少数主体;与此同时,若缺乏有效分配机制,生产率提升与财富增长并不必然带来普遍福祉。可持续 AI 的目标体系明确提出"就业安全""不垄断化",并在讨论中指出技术控制者的权力集中风险,这意味着评估 AI 是否可持续不能只看 GDP、利润或效率,而必须把就业质量、收入不平等、权力集中这些系统变量纳入同一个框架。否则,所谓"可持续"就会变成少数人的可持续,而不是社会整体的可持续。

8 总结

"AI 能否可持续"并不是一个关于态度的提问,而是一个关于系统设计与制度边界的提问。可持续首先要求三支柱底线同时成立,并在技术语境里体现为安全、成本效率与环境效率的生命周期均衡;Vasa 的隐喻提醒,局部最优的堆叠可能导致系统性失败,必须用系统方法进行权衡并尊重跨学科约束。AI 作为通用技术,其可持续性需要用目标体系来表达:图2给出了一个结构化的"可持续 AI 发展目标"集合,把能效减排、健康福祉、版权正义、隐私自由、就业安全、反垄断、反欺诈、信息可信与受控军事使用等并列为可持续约束。只要 AI 的经济收益以环境排放上升、核算边界低估、版权与激励结构破坏、信息生态污染、监控压迫工具化、就业安全削弱与权力集中为代价,就不满足"无负外部性"的可持续判据;反过来,只有在生命周期核算、权利与激励机制、以及分配与治理结构同时对齐目标体系时,"可持续 AI"才不至于成为单维度的修辞。