今年 8 月,美团开源的 InfiniteTalk 项目凭借无限长度生成能力与精准的唇形、头部、表情及姿态同步表现,迅速成为语音驱动虚拟人领域的主流工具,吸引全球数万名开发者的使用。10月底,LongCat 团队开源了 LongCat-Video 视频生成模型,尤其在长视频生成领域具备显著优势。

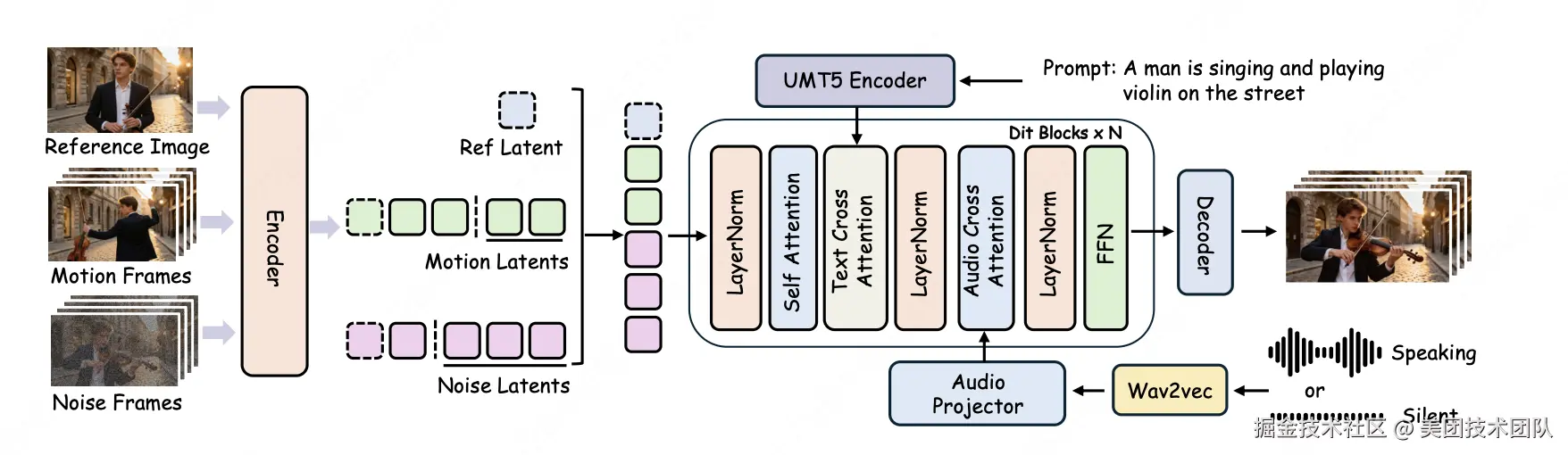

在 InfiniteTalk 和 LongCat-Video 基座的良好基础上,LongCat 团队针对实际场景中的核心痛点持续优化,正式发布并开源 SOTA 级虚拟人视频生成模型 ------LongCat-Video-Avatar。该模型基于 LongCat-Video 基座打造,延续 "一个模型支持多任务" 的核心设计,原生支持 Audio-Text-to-Video(AT2V)、Audio-Text-Image-to-Video(ATI2V)及视频续写等核心功能,同时在底层架构上全面升级,实现动作拟真度、长视频稳定性与身份一致性三大维度的显著突破,为开发者提供更稳定、高效、实用的创作解决方案。

开源地址:

- GitHub :github.com/meituan-lon...

- Hugging Face :huggingface.co/meituan-lon...

- Project :meigen-ai.github.io/LongCat-Vid...

一、技术亮点

1.1 开源 SOTA 拟真度:让虚拟人"活"起来

告别"僵硬",迎接"鲜活"。还记得以前那些虚拟人吗?只有嘴巴在动,头和身体却像没通电,看起来既尴尬又不自然。全新的 LongCat-Video-Avatar 彻底改变了这一点。它像一位全能导演,不仅指挥嘴型,还同步指挥眼神、表情和肢体动作,实现丰富饱满的情感表达,让虚拟人真正"演"了起来。

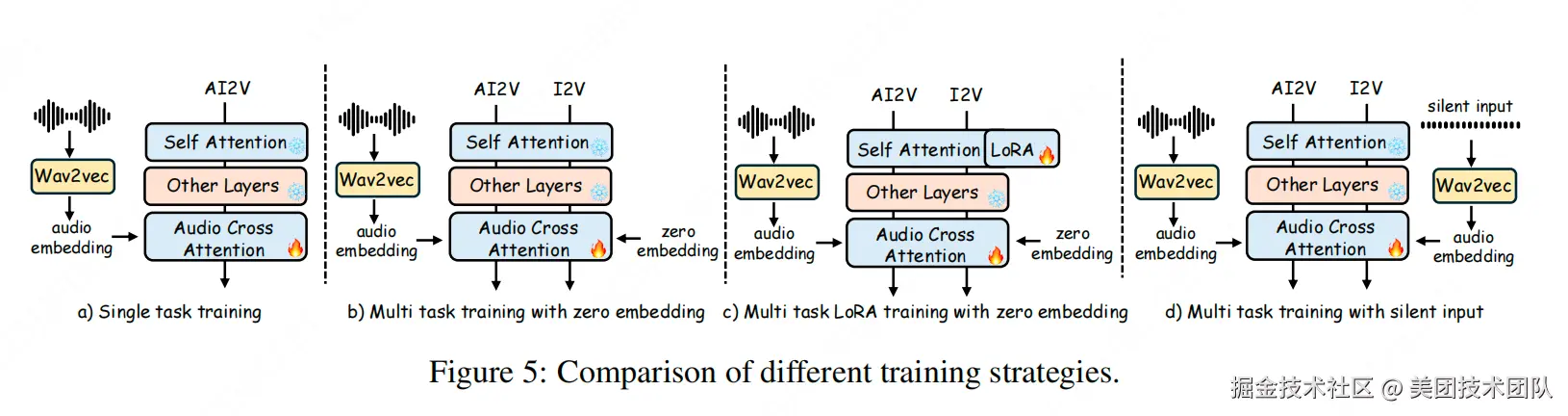

连"不说话"的时候,都很像人: 真人说话是有停顿和呼吸的。我们通过一种独特的训练方法 Disentangled Unconditional Guidance(解耦无条件引导),让模型明白了"静音"不等于"死机"。现在,哪怕是在说话的间歇,虚拟人也会像你我一样,自然地眨眼、调整坐姿、放松肩膀。

这种技术让 LongCat-Video-Avatar 成为首个同时支持文字、图片、视频三种生成模式的全能选手。从口型精准到全身生动,虚拟人从此有了真正的生命力。

1.2 长时序高质量生成:让视频"稳"下来

上一代 InfiniteTalk 在长视频生成中会出现视觉质量退化的现象,而VAE 的反复编解码是正是视觉质量退化的主要原因。现有方法通常将上一段生成结果解码为像素,再将末尾帧重新编码为潜变量,作为下一段的条件------这一"解码→再编码"循环会持续引入累积误差,导致色彩偏移与细节模糊。

LongCat-Video-Avatar提出了Cross-Chunk Latent Stitching (跨片段隐空间拼接) 训练策略以根本性解决此问题。在训练阶段,我们从同一视频中采样两个连续且部分重叠的片段,在隐空间内直接进行特征替换,让模型学会在潜空间中无缝衔接上下文。在推理时,系统直接将前一段生成的 latent 序列末尾部分作为下一段的 context latent,全程无需解码到像素域。该设计不仅消除 VAE 循环带来的画质损失,还显著提升推理效率,并有效弥合训练与推理之间的流程差异(train-test gap)。实验显示,LongCat-Video-Avatar 在生成5分钟约 5000 帧视频时仍保持稳定色彩与清晰细节。

1.3 商用级一致性:精准锚定角色,让演绎生动自如

为维持长视频中的身份(ID)一致性, InfiniteTalk 采用注入参考帧的方式,但有时会导致色彩偏移(color shift)或动作僵化("复制-粘贴"效应)。LongCat-Video-Avatar 从以下两方面进行系统升级:

- 基座升级:视频基础模型迁移到 LongCat-Video,后者在大规模长视频预训练中具备了更强的身份保持与色彩一致性先验。

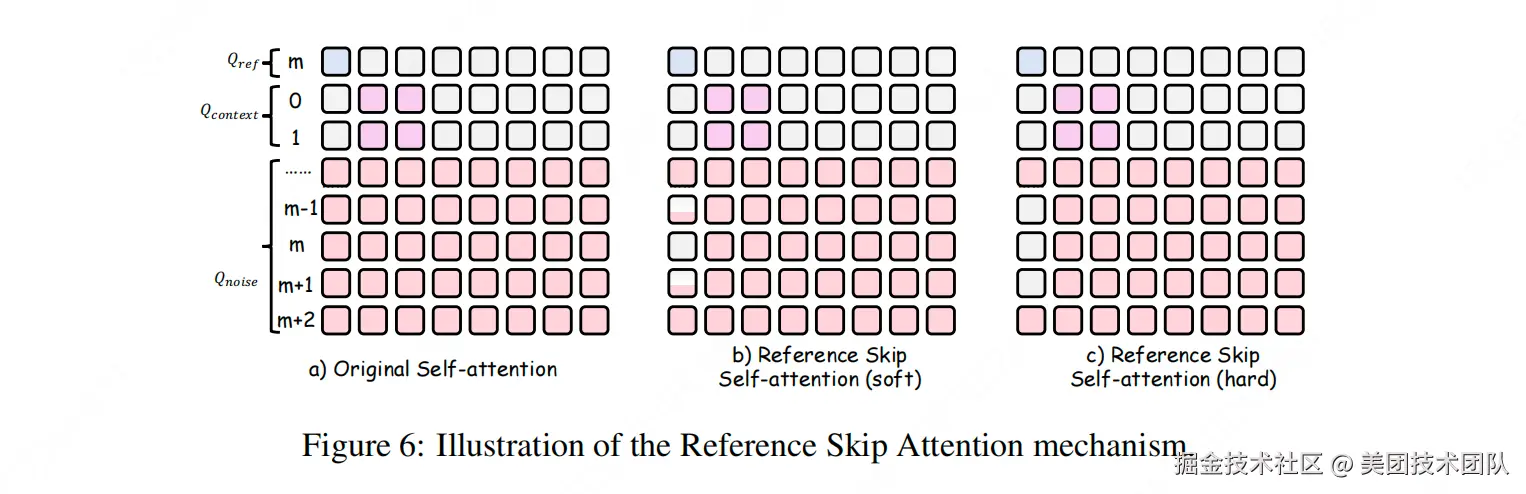

- 参考机制创新:我们引入了带位置编码的参考帧注入模式。推理时,用户可通过指定RoPE中的索引位置,灵活控制参考帧在生成块中的插入位置。更重要的是,我们设计了Reference Skip Attention机制,在参考帧相邻的时间步,屏蔽参考帧对注意力计算的直接影响,仅允许其提供身份语义先验,而不主导具体动作生成。这套机制在确保ID一致性的同时,有效抑制了动作的重复与僵化,使长视频既稳定又富有变化。

二、模型性能

2.1 客观基准评测

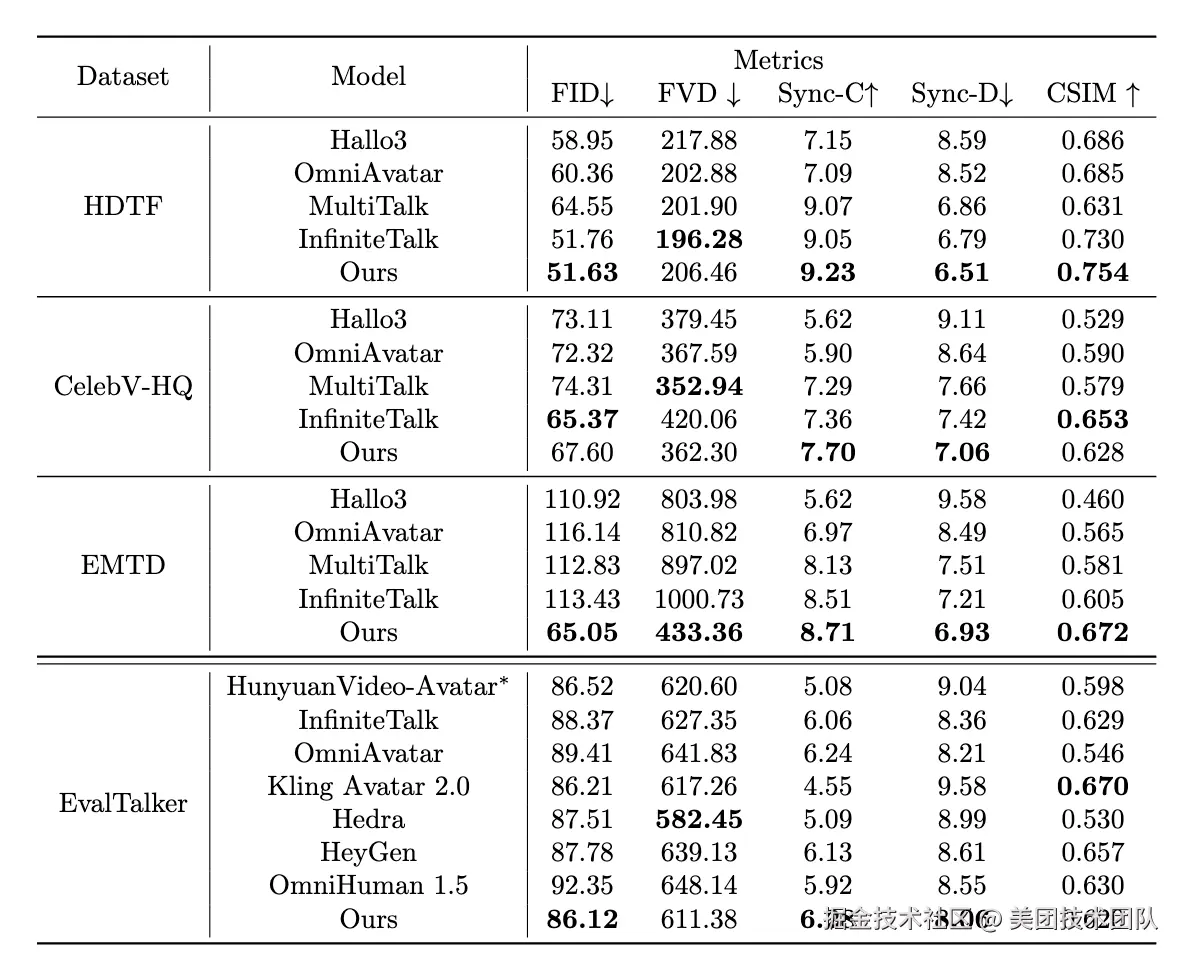

在 HDTF、CelebV-HQ 、EMTD 和 EvalTalker 等权威公开数据集上的定量评测表明,LongCat-Video-Avatar 在多项核心指标上达到SOTA领先水平。

在衡量唇音同步精度的 Sync-c/Sync-D指标上,LongCat-Video-Avatar 在各个数据集上均取得 SOTA 成绩;在一致性指标方面(FID、FVD、CSIM)也表现优异。

2.2 综合主观评测

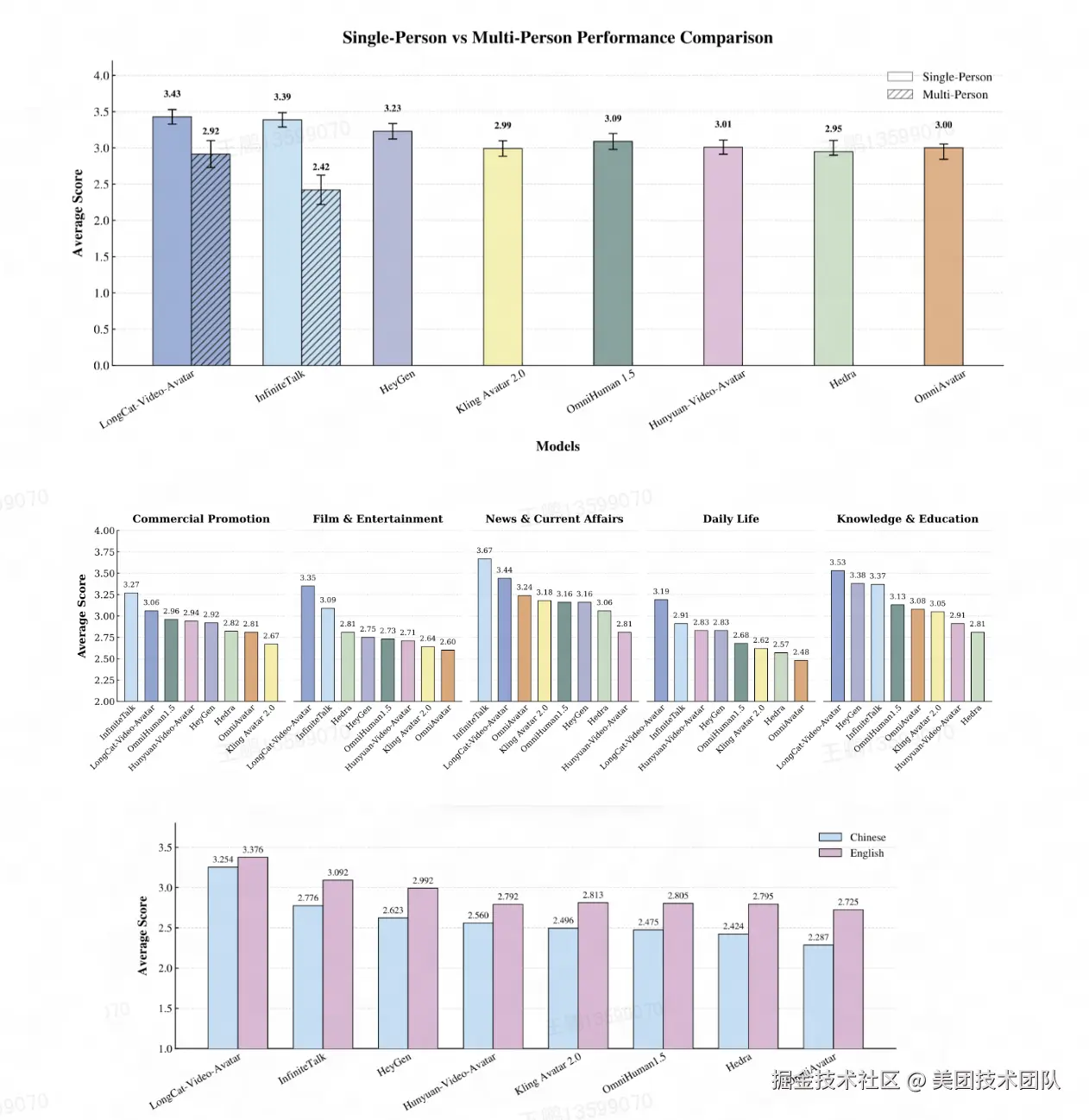

为贴近真实用户体验,我们基于 EvalTalker 基准组织了大规模人工评测,从"自然度与真实感"维度对生成视频进行盲测打分(5分制)。

在涵盖商业推广、影视娱乐、新闻时事、日常生活和知识教育五大场景的单人对话测试中,LongCat-Video-Avatar 的综合评分领先于包括 InfiniteTalk、HeyGen、Kling Avatar 2.0 在内的众多主流开源与商业模型。

通过基于EvalTalker基准的严谨人工评测(共492名参与者),LongCat-Video-Avatar在多个细分维度获得显著正向反馈:

- 静音段表现:绝大多数评审者指出,LongCat-Video-Avatar 在静音段能保持如呼吸、眨眼等自然微动作;

- 长视频稳定性:在长序列生成中,相较 InfiniteTalk,该模型展现出更优的身份一致性与视觉连续性,有效缓解了长期存在的漂移问题;

- 动作多样性:得益于创新的参考帧机制,其生成的动作被普遍认为更为丰富、自然,避免了明显的重复或"复制-粘贴"效应;

- 语言表现:LongCat-Video-Avatar 在中文和英文语言中均优于所有对比方法,体现出稳健的跨语言性能和精准的音画同步效果;

- 应用场景表现:LongCat-Video-Avatar 在影视娱乐、日常生活和知识教育场景中表现最优,展现出在多样应用场景下的强泛化能力。

三、One More Thing,开源是为了更好的共创

LongCat-Video-Avatar 是我们继 InfiniteTalk 之后,在数字人生成方向上的持续迭代。我们关注开发者在长视频生成中遇到的实际问题------身份漂移、画面卡顿、静音段僵硬,并尝试从模型层面给出改进。

这次开源的不是一个"终极方案",而是一个进化的、可用的技术基座。它们都基于真实反馈与长期实验,代码和模型均已开放。我们坚持开源,是因为相信工具的价值在迭代中产生,而迭代需要更多人的使用、验证与共建。如果你正在探索数字人相关应用,或对生成技术有想法,欢迎关注我们的项目,更欢迎留下你的反馈。

开源地址:

- GitHub :github.com/meituan-lon...

- Hugging Face :huggingface.co/meituan-lon...

- Project :meigen-ai.github.io/LongCat-Vid...

现在,轮到你来创造"千人千面"的数字世界了。

关注「美团技术团队」微信公众号,在公众号菜单栏对话框回复【2024年货】、【2023年货】、【2022年货】、【2021年货】、【2020年货】、【2019年货】、【2018年货】、【2017年货】等关键词,可查看美团技术团队历年技术文章合集。

| 本文系美团技术团队出品,著作权归属美团。欢迎出于分享和交流等非商业目的转载或使用本文内容,敬请注明"内容转载自美团技术团队"。本文未经许可,不得进行商业性转载或者使用。任何商用行为,请发送邮件至 tech@meituan.com 申请授权。