一、水位管理的核心挑战

在电商大促(如双11)和秒杀活动中,系统面临瞬时流量洪峰 (如千万级QPS)、资源竞争激增 (数据库锁冲突)、业务链路脆弱性(库存超卖)等核心挑战。水位管理需解决三大矛盾:

- 资源弹性:应对流量突增与资源闲置的平衡

- 业务连续性:保障核心链路可用性与非核心功能降级

- 成本控制:避免过度扩容导致的资源浪费

二、电商大促水位管理策略

1. 容量预估:从历史数据到AI预测

- 多维度数据建模:结合历史GMV、流量峰值(如2024年天猫双11峰值达11.2万笔/秒)、用户行为(加购转化率、支付成功率)构建预测模型

- 动态水位调整 :使用阿里Rhino系统实现自动化容量评估,通过拓扑流量估算和排队论算法预测资源缺口(如数据库连接池扩容需提前30%)

- 案例:京东2024年618通过混合云弹性伸缩,大促期间自动扩容3000+容器实例,资源利用率提升至78%

2. 资源隔离:多级防护体系

| 隔离层级 | 技术实现 | 典型场景 |

|---|---|---|

| 网络层 | SLB流量调度、全局限流 | 抵御10Tbps级DDoS攻击 |

| 应用层 | 线程池隔离、信号量控制 | 核心交易链路与营销活动隔离 |

| 数据层 | 读写分离、分库分表 | 库存数据库与订单数据库分离 |

| 业务层 | 热点数据隔离、异步队列 | 秒杀库存与普通库存分桶 |

3. 动态扩缩容:从静态阈值到智能决策

- K8s HPA进阶 :基于业务指标(如支付成功率<99.9%)而非单纯CPU/内存触发扩缩容

- 弹性资源池:预留20%突发资源应对"秒杀级"流量(如阿里云ESS弹性伸缩延迟<15秒)

- 案例 :拼多多2024年春节活动采用混合弹性策略,核心服务保持50%基础容量,弹性资源池动态补充峰值需求

三、秒杀场景专项水位管理

1. 库存水位控制:从静态扣减到动态博弈

- 预扣减机制 :Redis原子操作(如

DECR)实现库存预扣,结合Lua脚本保证数据一致性 - 熔断降级 :当库存扣减QPS超过阈值时,自动触发虚拟排队(如显示"排队中"而非直接拒绝)

- 热点隔离:将秒杀商品放入独立Redis集群,避免缓存雪崩

2. 流量削峰:三阶缓冲体系

- 客户端限流:按钮置灰+IP限流(如每秒限5次请求)

- 网关削峰:Nginx令牌桶限流(rate=1000r/s)+ 请求合并

- 业务层缓冲:消息队列削峰(如Kafka堆积10万消息自动扩容Consumer)

3. 熔断机制:三级防护策略

| 熔断级别 | 触发条件 | 处置动作 |

|---|---|---|

| L1(业务级) | 接口错误率>5% | 自动降级非核心功能(如取消优惠券核验) |

| L2(链路级) | 链路超时率>10% | 拒绝50%请求并触发告警 |

| L3(系统级) | CPU>90%持续30秒 | 全局限流+自动扩容 |

四、水位管理技术架构演进

1. 传统架构痛点

- 被动响应:依赖人工扩容,故障恢复时间>30分钟

- 资源浪费:静态资源分配导致70%服务器低负载运行

- 数据孤岛:各业务线独立监控,缺乏全局视角

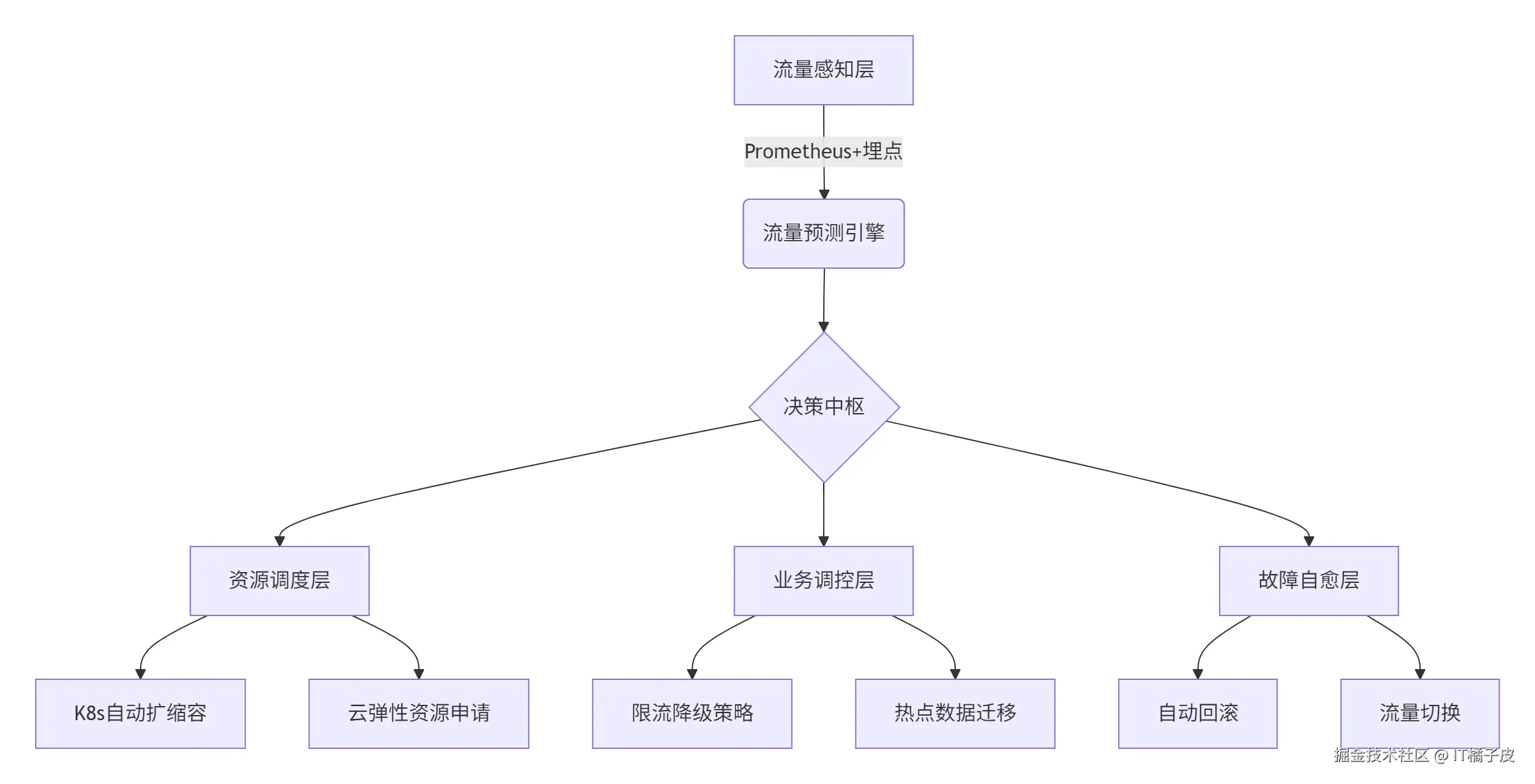

2. 智能水位管理平台架构

3. 关键技术创新

- 混沌工程:Netflix Chaos Monkey模拟网络分区,验证水位管理容错能力

- 数字孪生:阿里云SRE通过全链路仿真系统预演大促场景

- AI预测 :字节跳动Rhino系统实现85%+的容量预测准确率

五、最佳实践与避坑指南

1. 容量规划黄金法则

- 20/80原则:80%资源应对常态流量,20%应对突发峰值

- 三倍安全余量:数据库连接池、线程池等关键资源按预估量3倍配置

- 灰度验证 :大促前72小时进行全链路压测(如阿里PTS平台)

2. 典型事故复盘

-

案例1:某电商库存超卖事件

原因:未考虑Redis持久化阻塞导致库存回补延迟

解决方案 :采用双删策略(更新后1s、5s二次删除脏数据)

-

案例2:支付链路雪崩

原因:未隔离第三方支付回调与核心交易链路

解决方案 :引入服务泳道,支付回调走独立网络平面

3. 监控体系设计

-

核心指标矩阵:

erlang监控维度,指标项,告警阈值 流量层,QPS,>10万 资源层,Redis CPU,>80% 业务层,支付成功率,<99.9% 链路层,接口P99时延,>500ms

六、未来演进方向

- Serverless水位管理:AWS Lambda自动扩缩容粒度细化至10ms

- 边缘计算缓冲:CDN节点缓存热点商品数据,降低中心机房压力

- 预测式扩缩容:基于时序预测提前1小时完成资源调配

水位管理已从被动防御转向主动预测,通过智能算法+架构革新的融合,未来将实现"资源随需流动,系统自适应波动"的终极目标。