本文作者来自小米大模型 Plus 团队,共同一作为张少杰、张若嶒、付培,通讯作者为多模态感知方向负责人罗振波。

在打造智能数字助手的过程中,让智能体像人类一样自然地理解并操作图形界面是一项核心难题。尽管多模态大模型与强化学习微调推动了智能体的进步,但其交互逻辑与真实的人机交互仍存在明显差距。

为缩小这一差距,本研究提出"眨眼-思考-链接"(Blink-Think-Link,BTL)框架,受人脑工作模式启发,将交互拆解为三个与生物认知过程对齐的阶段,兼顾感知效率与决策精度。

(1)Blink(眨眼) :快速检测并关注相关屏幕区域,类似眼跳;

(2)Think(思考) :进行高级推理与决策,体现认知规划;

(3)Link(链接):生成可执行命令,模拟人类的动作选择。

论文标题:BTL-UI: Blink-Think-Link Reasoning Model for GUI Agent

论文链接:https://arxiv.org/abs/2509.15566

代码链接:https://github.com/xiaomi-research/btl-ui方法介绍

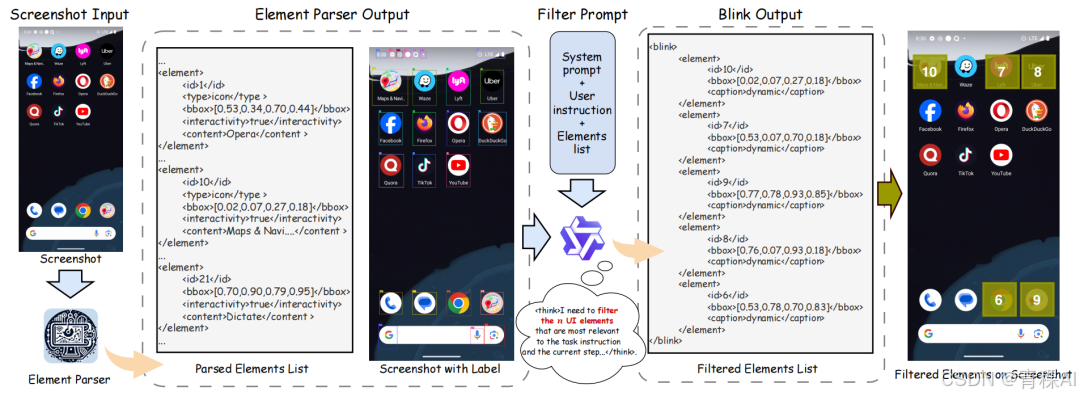

第一阶段:眨眼(Blink)-快速视觉定位

模型需要如同人类扫视眼动般,快速定位屏幕上的视觉焦点。为此,本文构建了眨眼数据(Blink Data)的自动化标注管线:首先提取按钮、图标、文本字段等单独 UI 元素,并为其标注边界框、类型与语义标题;随后调用 Qwen2.5-VL 32B,根据视觉显著性和任务相关性过滤、排序元素,以模拟自上而下的注意力。

第二阶段:思考 (Think) - 高级认知规划

在"眨眼"定位了视觉焦点区域后,智能体进行高级推理与决策,其过程仿照认知任务规划的运作模式。相关推理轨迹被记录于 <think></think>标签内。

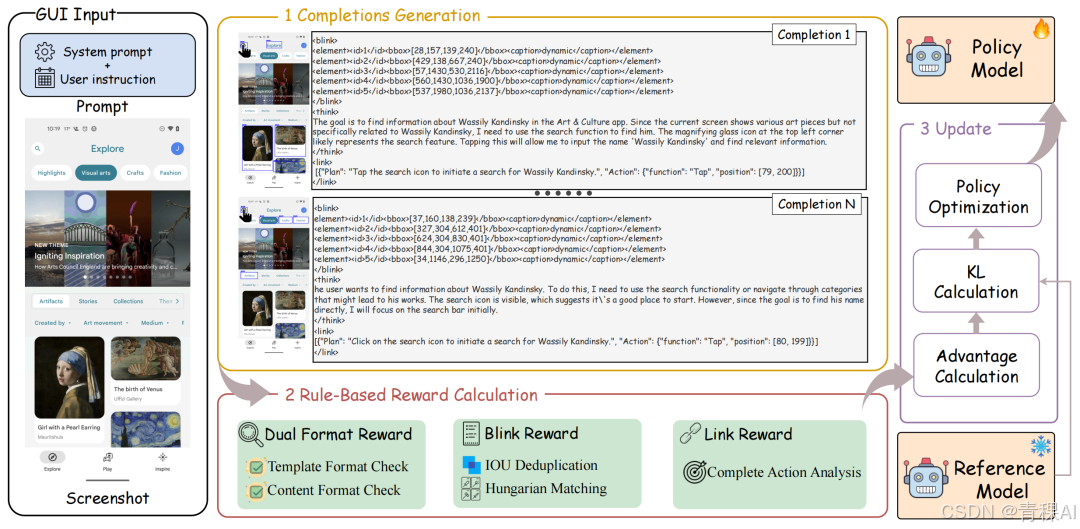

第三阶段:链接 (Link) - 精确动作生成

最后,模型生成可执行命令,模拟人类的动作选择机制。为了解决传统RFT奖励模型的局限性,即过度依赖基于结果的奖励,而忽略了对中间交互过程的指导。本文提出了BTL奖励------基于规则的"过程-结果集成"奖励机制。该奖励包含三个核心部分:

(1)用于模板和内容匹配的双重格式奖励 ;

(2)用于指导细粒度交互过程的眨眼奖励 ;

(3)用于动作结果评估的链接奖励。

通过结合细粒度监督过程的眨眼奖励和反馈精确结果的链接奖励,该机制融合了面向过程和以结果为驱动的方法。

双重格式奖励包括模板检查函数和内容检查函数。具体而言,模板检查函数用于检验生成内容是否满足"眨眼-思考-链接"三阶段语法结构;内容检查函数则评估眨眼内容是否符合XML格式及链接内容是否符合JSON格式,以支持轨迹规划与参数化操作的解析。

眨眼奖励鼓励智能体快速准确定位与指令相关的界面元素。从智能体预测中提取感兴趣区域集合,将其与真实标注进行对比。采用匈牙利匹配器及IoU阈值,定义匹配索引集。在规划任务中与指令相关的元素在当前屏幕截图内可能不存在,此时的操作应通过滚动或返回跳转至其他页面。因此预测结果中允许出现感兴趣区域集合为空的情况。

链接奖励是为了评估智能体生成完整可执行命令的能力。当前基于RFT的GUI智能体通常将预测动作的奖励拆分为动作类型奖励与动作参数奖励,如点击坐标或输入文本。

此类奖励机制将动作割裂为两个独立部分,不符合人类认知规律,同时分段式奖励会引发奖励破解现象,阻碍智能体理解预设动作空间。

因此,本文采用严格的二元标准:仅当动作类型及其关联参数完全正确时,智能体才能获得奖励。这种全有或全无的机制确保最终生成的指令具有内部一致性,并能准确反映预期GUI操作。

基于BTL框架,本文开发了一个名为BTL-UI的智能体,在多个GUI任务中展现了该框架的有效性。

实验结果

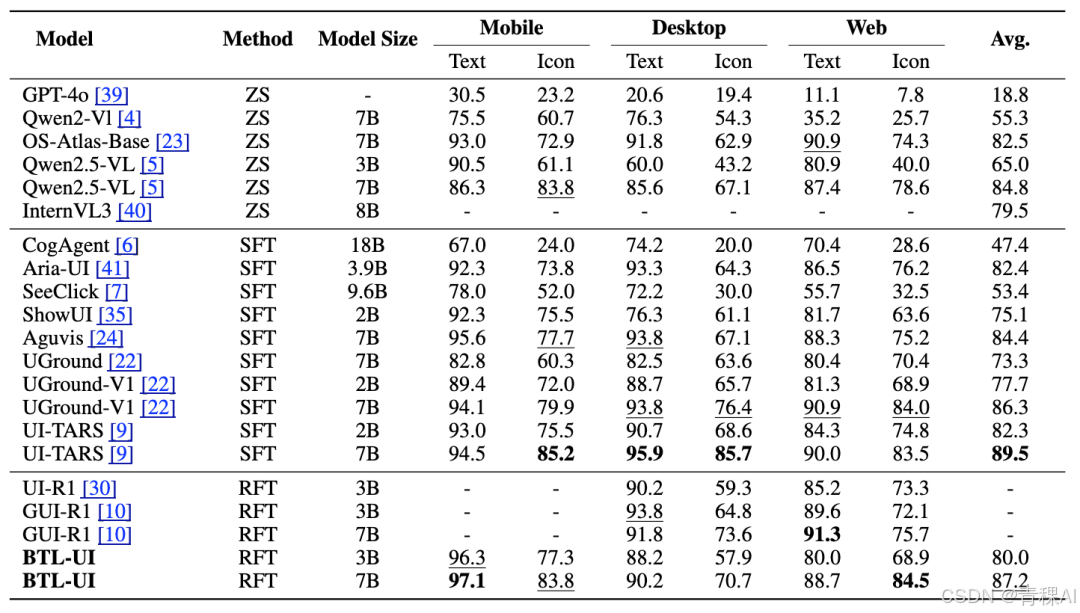

为全面评估 BTL-UI,本文在 GUI 智能体定位与规划基准上进行测试。

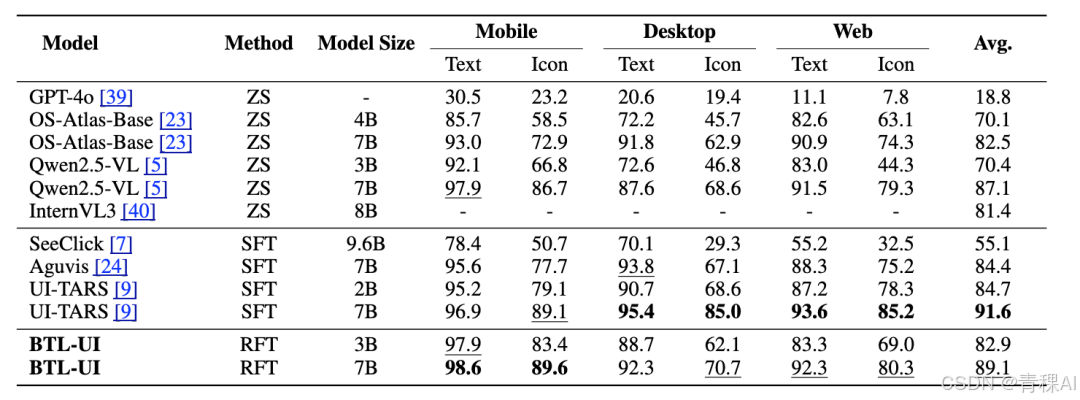

定位能力:在 ScreenSpot 数据集上,BTL-UI-7B 以 87.2% 的平均准确率超越基线,在 ScreenSpot-V2 上进一步提升至 89.1%;3B 版本亦取得强竞争力,验证训练范式有效性。

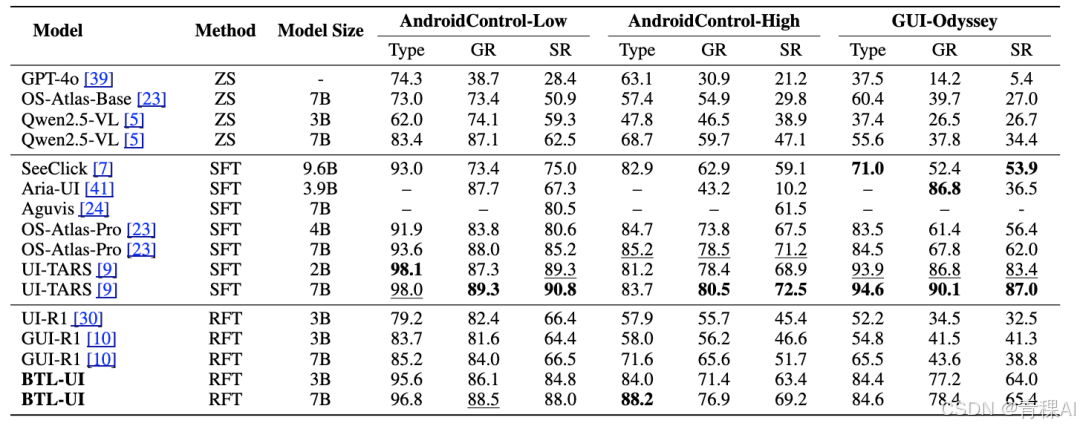

低级规划能力:在需精确执行逐步 GUI 交互的 AndroidControl-Low 任务中,BTL-UI-3B 达到 84.8% 的步骤成功率,显著优于其他模型。

高级规划能力:在 AndroidControl-High 与 GUI-Odyssey 的长步骤任务中,BTL-UI-7B 分别取得 69.2% 与 65.4% 的步骤成功率,领先其他基于强化微调的模型。

消融实验

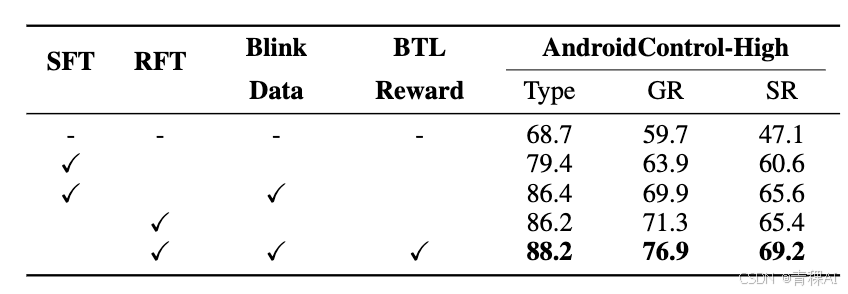

为明确BTL框架中各组件的贡献,本文在AndroidControl-High基准上进行了消融实验。

当仅使用监督微调训练时,BTL-UI的成功率为60.6%。进一步使用生成的眨眼数据后,监督微调的性能提升了5%,这证明眨眼数据不仅适用于强化微调,也适用于监督微调。

此外,未使用眨眼数据的强化微调获得65.6%的成功率。采用眨眼数据和BTL奖励后,成功率提升3.8%。

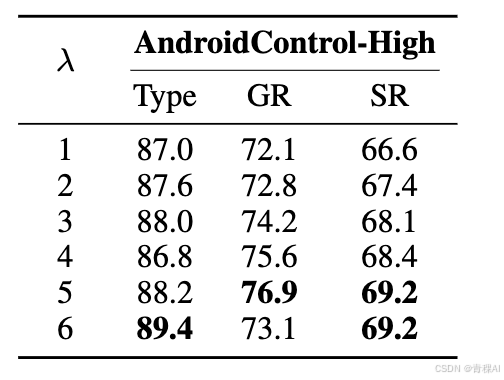

本文同时检验了眨眼阶段不同感兴趣区域数量(λ)的影响。

总结与展望

BTL 框架以"眨眼-思考-链接"的三阶段认知范式,模拟了人类在 GUI 操作中的感知、决策与执行过程,弥补了传统结果驱动 RFT 的缺陷,并在多项任务上带来显著提升。

这一范式为构建更自然、高效、符合人类认知的数字化助手提供了新路径,未来可进一步拓展至更广泛的人机交互场景。