前言

小伙伴们好!在短视频内容创作日益火爆的今天,如何快速产出高质量的视频内容成为了每个创作者面临的难题。传统的视频制作流程繁琐复杂,从脚本撰写到拍摄剪辑,往往需要花费大量的时间和精力,而且对于没有专业设备和技能的普通创作者来说,想要产出具有Sora2级别效果的AI视频更是难上加难。好家伙,这个问题终于有了完美的解决方案!

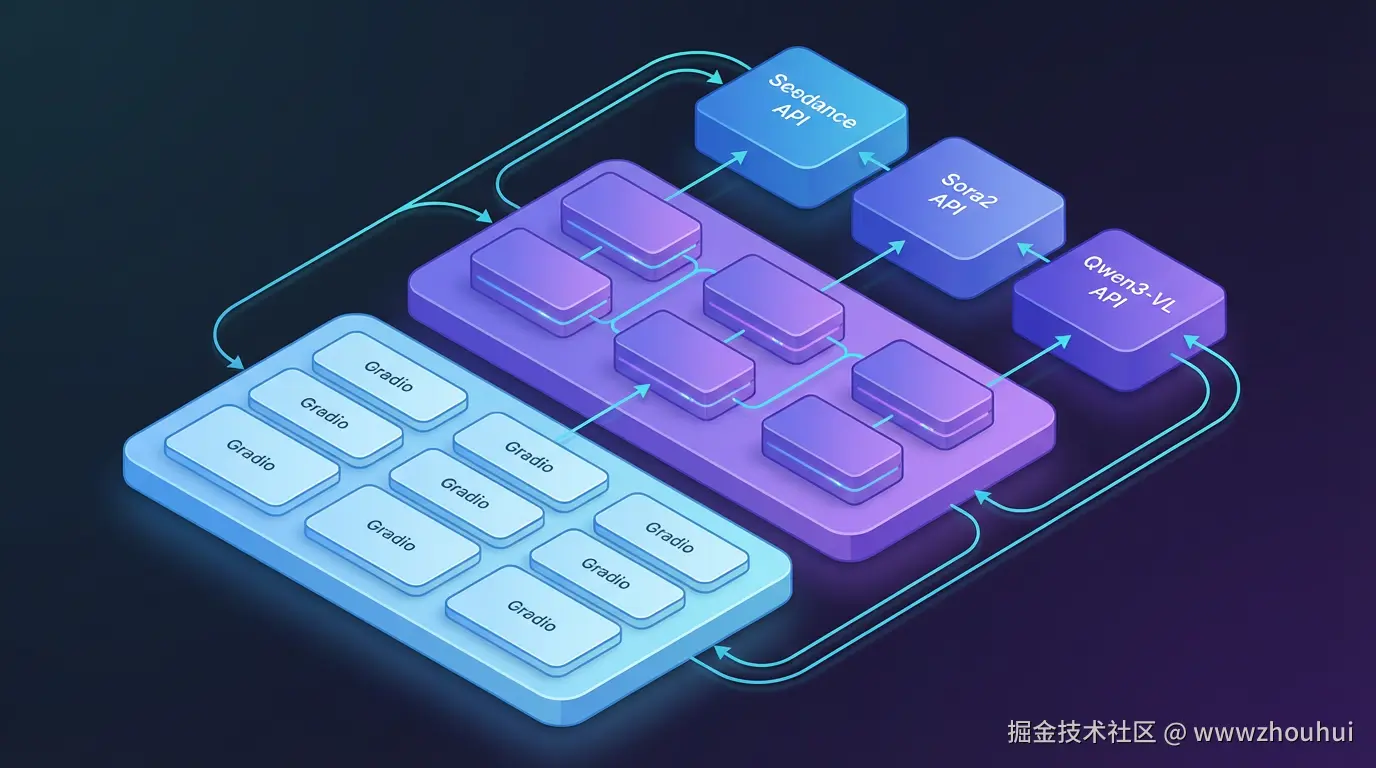

AI-video-Replicate 是一款开源的AI视频生成与复刻工具,支持 Seedance 、Sora2 和 Sora2免费 三种主流模型提供者,提供文生视频、图生视频和视频复刻三大核心功能。通过这个工具,我们可以轻松实现从文本描述生成视频、上传图片生成动态视频,以及最强大的------上传现有视频自动提取提示词一键复刻!

这2天开发了一个基于端视频复刻的一个项目叫做 AI-video-Replicate ,今天我们就在本地和Docker环境手把手教大家部署这个AI视频复刻神器,体验和感受一下这个工具的强大能力。

项目介绍

✨ 核心特性

-

🎬 三模型支持: 同时支持 Seedance、Sora2、Sora2免费三种顶级视频生成模型

-

📝 文生视频: 输入文本描述,AI自动生成高质量视频

-

🖼️ 图生视频: 上传参考图片,一键生成动态视频(Seedance/Sora2)

-

🔄 视频复刻: 上传视频自动提取提示词,一键复刻同款视频

-

⏱️ 实时进度: 任务提交后自动轮询,实时显示生成进度

-

🎯 样例视频: 内置样例视频,快速体验无需准备素材

🛠️ 技术栈

后端

-

语言: Python 3.11+

-

框架: Gradio(Web界面)

-

视觉理解: Qwen3-VL(视频分析提取提示词)

-

HTTP客户端: httpx(支持HTTP/2)

模型支持

| 特性 | Seedance | Sora2 | Sora2免费 |

|---|---|---|---|

| 模型 | seedance-1-5-pro-251215 | sora-2 | sora2-landscape-10s/15s |

| 时长 | 4s, 5s, 8s, 12s | 10s, 15s | 10s, 15s |

| 比例 | 21:9, 16:9, 4:3, 1:1, 3:4, 9:16 | portrait, landscape | 横屏/竖屏 |

| 图生视频 | ✅ 支持 | ✅ 支持 | ❌ 仅文生视频 |

| 免费额度 | 按需付费 | 按需付费 | 每天10次 |

🎯 应用场景

-

短视频创作: 快速生成抖音、快手、视频号等平台的短视频内容

-

内容复刻: 分析爆款视频结构,一键生成同风格内容

-

创意验证: 快速将创意文案转化为视频预览

-

素材生成: 批量生成营销、教学、产品展示等视频素材

部署实战

环境准备

我们首先需要准备一台能够运行Python的环境,可以是本地电脑,也可以是云服务器。这里我们提供两种部署方式:本地运行和Docker部署,小伙伴们可以根据自己的需求选择。

环境要求:

- Python 3.8+ (推荐3.11)

- 网络环境能够访问各模型API

- Docker(可选,用于容器化部署)

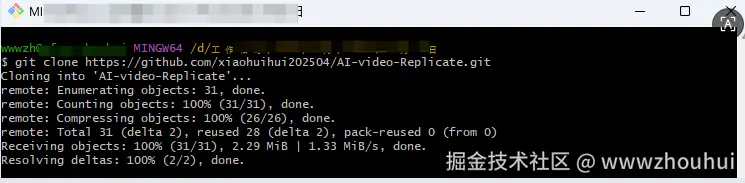

项目下载

在终端输入以下命令下载项目:

shell

# 克隆项目到本地

git clone https://github.com/xiaohuihui202504/AI-video-Replicate.git

# 进入项目目录

cd AI-video-Replicate

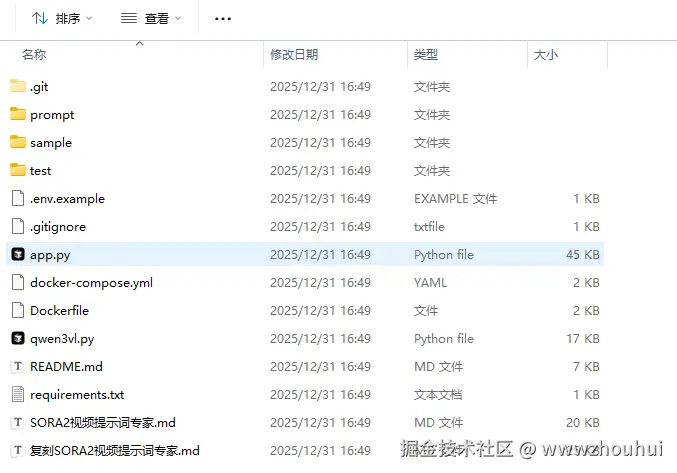

等待几分钟后下载完成,我们就可以看到完整的项目结构了。

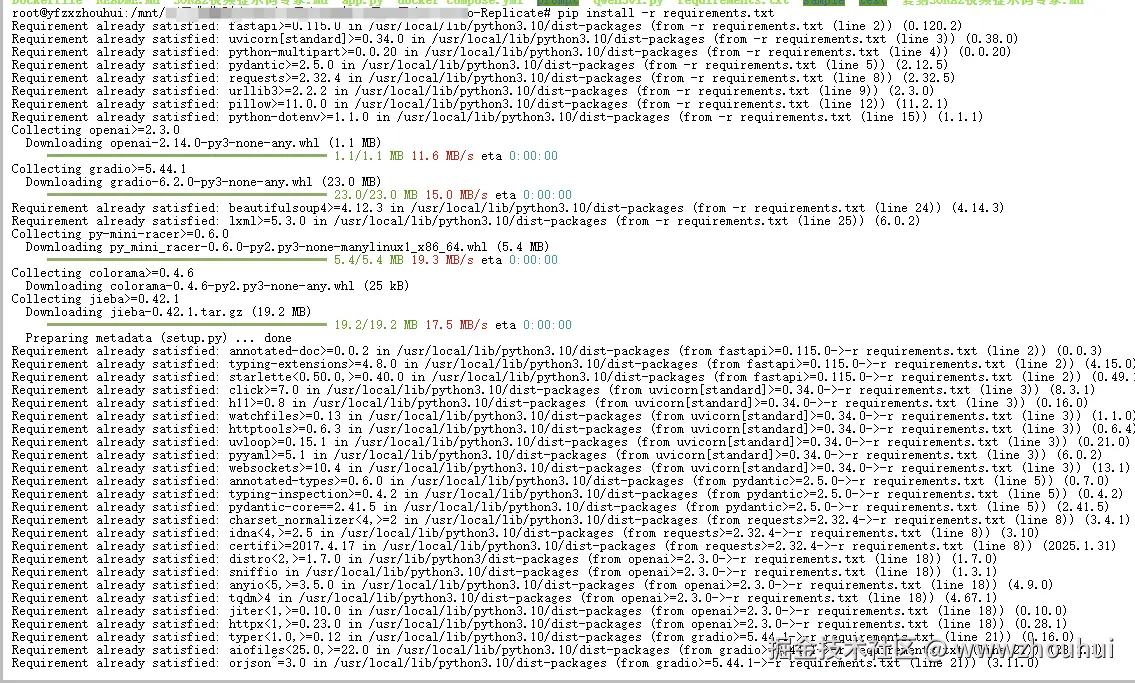

依赖安装

接下来安装项目所需的依赖包:

shell

# 安装基础依赖

pip install -r requirements.txt

# 安装HTTP/2支持(视频下载需要)

pip install httpx[http2]

注意: 如果安装过程中遇到网络问题,可以使用国内镜像源:

shell

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple配置环境变量

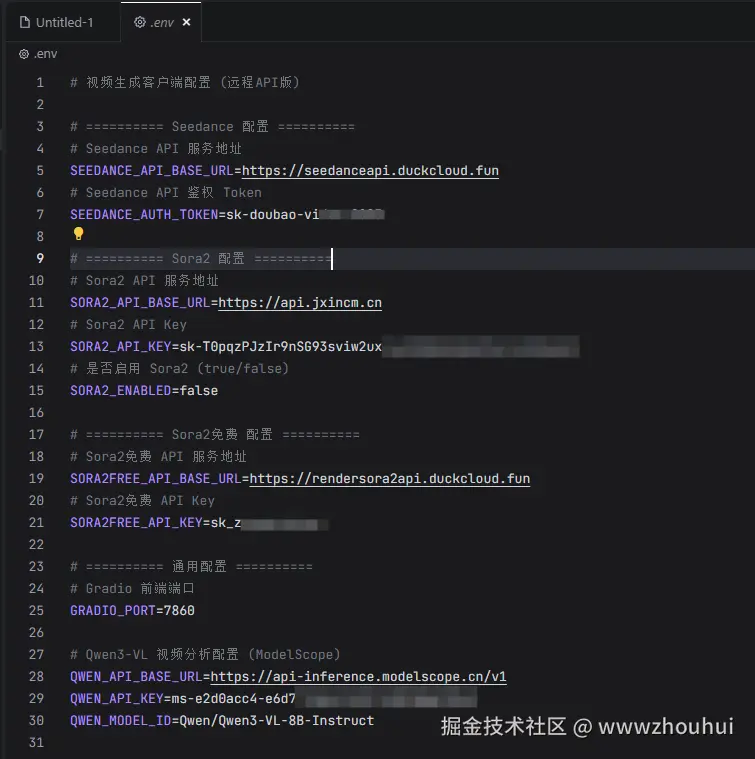

这一步非常关键!我们需要配置各个模型的API Key:

shell

# 复制环境变量模板

cp .env.example .env然后编辑 .env 文件,填入你的API Key:

yaml

# Seedance 配置

SEEDANCE_API_BASE_URL=https://seedanceapi.duckcloud.fun

SEEDANCE_AUTH_TOKEN=your-seedance-token

# Sora2 配置

SORA2_API_BASE_URL=https://api.jxincm.cn

SORA2_API_KEY=your-sora2-key

SORA2_ENABLED=true

# Sora2免费 配置

SORA2FREE_API_BASE_URL=https://rendersora2api.duckcloud.fun

SORA2FREE_API_KEY=your-free-key

# Qwen3-VL 配置(视频分析用)

QWEN_API_BASE_URL=https://api-inference.modelscope.cn/v1

QWEN_API_KEY=your-qwen-key

QWEN_MODEL_ID=Qwen/Qwen3-VL-8B-Instruct

# Gradio 端口

GRADIO_PORT=7860

API Key获取方式:

- Seedance: 联系服务提供商获取

- Sora2 : 访问 api.jxincm.cn/register?af... 注册获取

- Sora2免费: 默认已配置,每天10次免费额度

- Qwen3-VL : 访问 modelscope.cn 注册获取

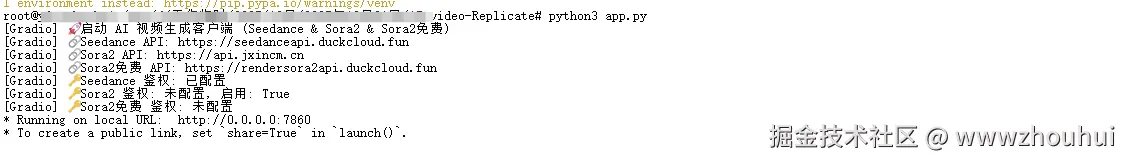

方式一:本地启动

配置完成后,直接运行启动命令:

shell

python app.py

启动成功后,打开浏览器访问 http://localhost:7860 即可看到Web界面。

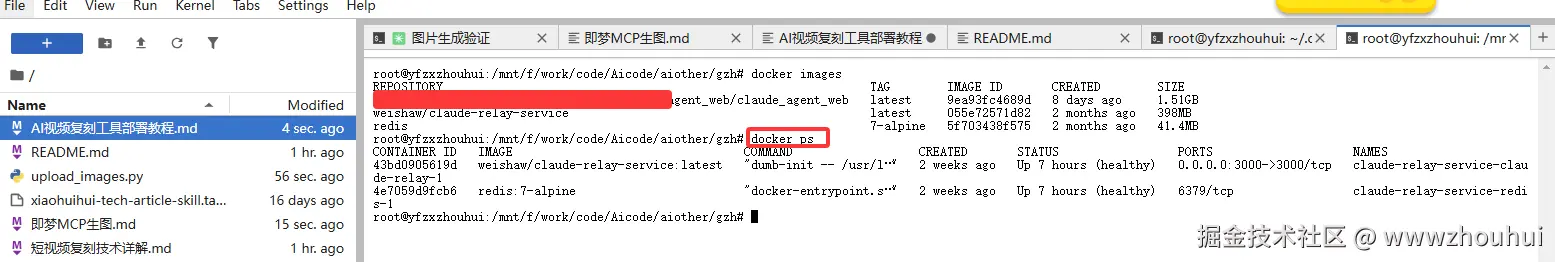

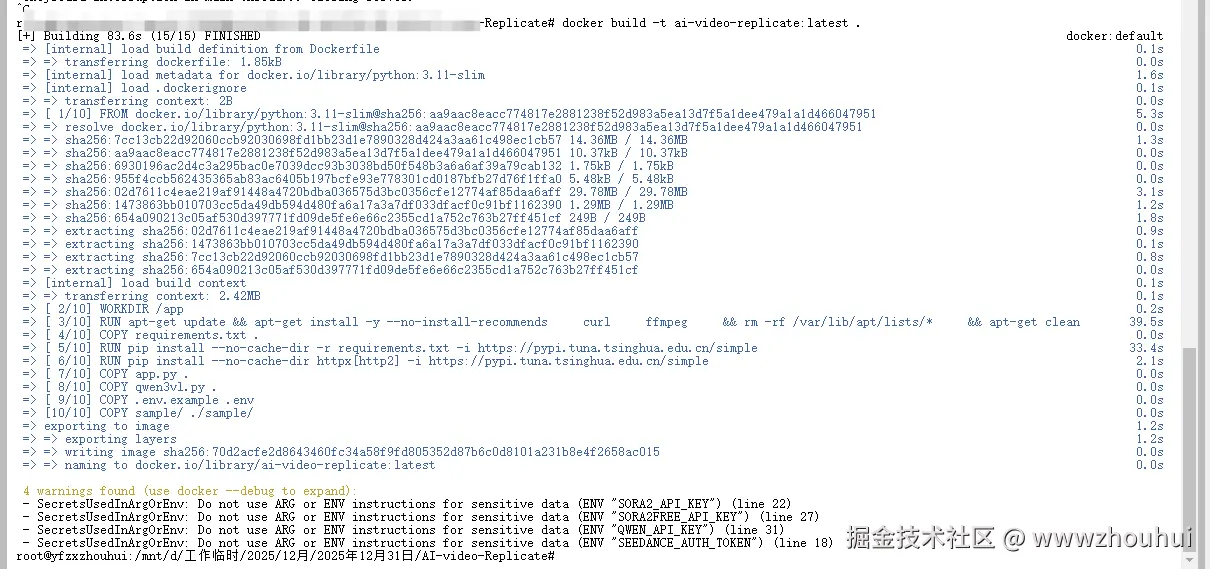

方式二:Docker部署(推荐)

如果你更喜欢容器化部署,可以使用Docker:

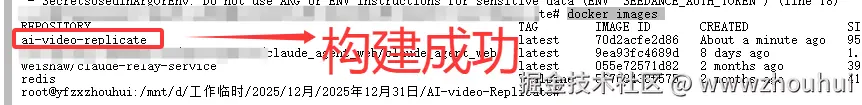

1. 构建镜像

shell

docker build -t ai-video-replicate:latest .

容器镜像构建后我们通过下面的命令查看容器镜像是否构建成功

docker images

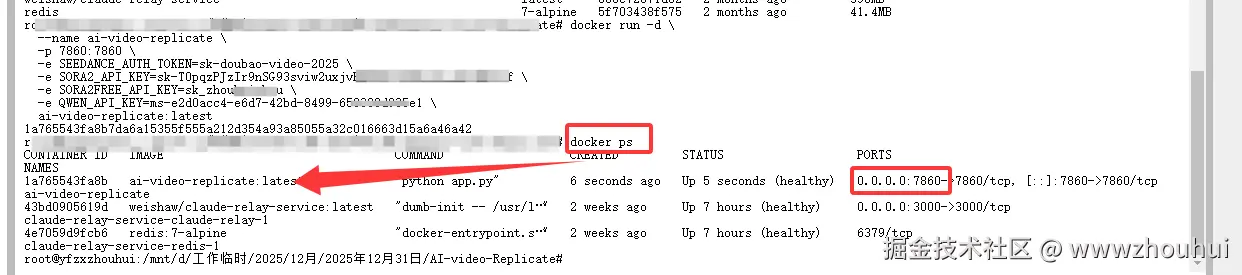

2. 运行容器

shell

docker run -d \

--name ai-video-replicate \

-p 7860:7860 \

-e SEEDANCE_AUTH_TOKEN=your-seedance-token \

-e SORA2_API_KEY=your-sora2-key \

-e SORA2FREE_API_KEY=your-free-key \

-e QWEN_API_KEY=your-qwen-key \

ai-video-replicate:latest

3. 使用 docker-compose(更推荐)

创建好 .env 文件后,直接运行:

shell

docker-compose up -d功能测试

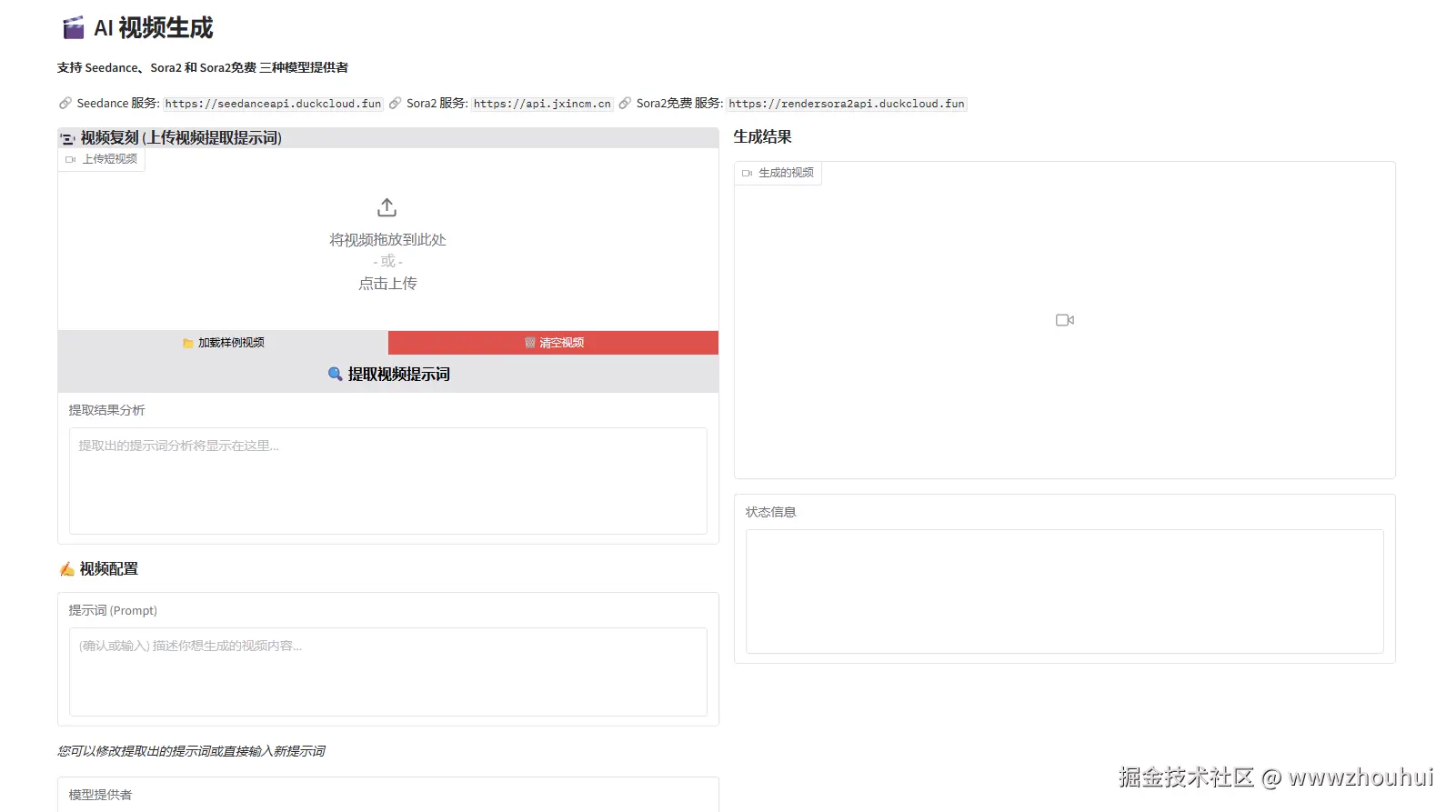

启动成功后,让我们来测试各个核心功能!

输入请求地址http://127.0.0.1:7860

文生视频测试

- 选择模型提供者(seedance / sora2 / sora2free)

- 输入视频描述提示词,例如:

一只可爱的橘猫在阳光下打盹,毛发在微风中轻轻飘动 - 选择模型、时长和比例

- 点击"生成视频"按钮

视频复刻测试(核心功能)

这是本项目最强大的功能!操作步骤如下:

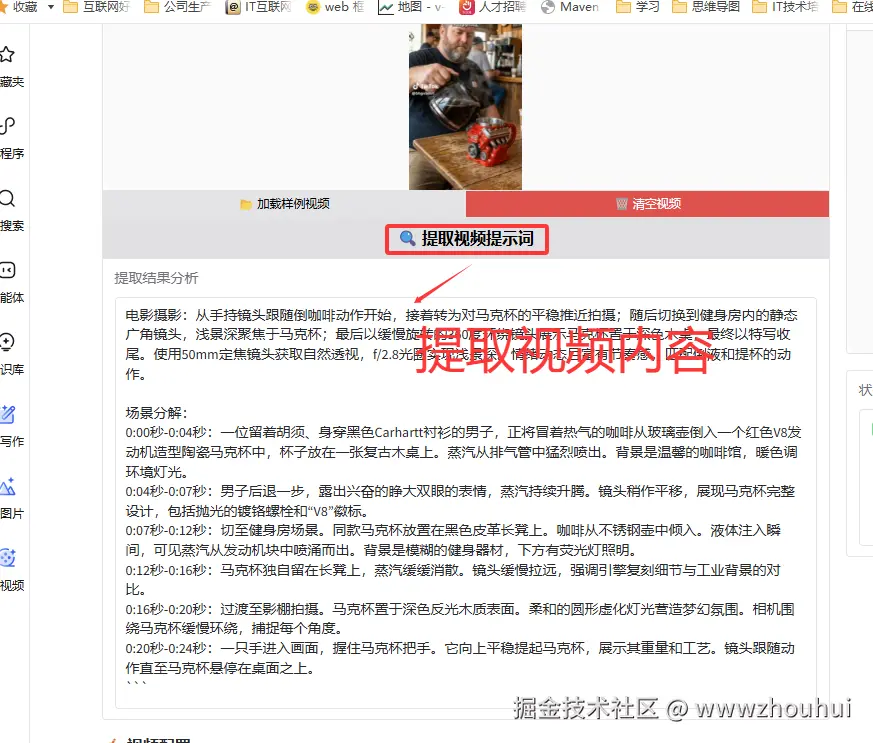

Step 1: 点击"加载样例视频"或上传想要复刻的短视频

Step 2: 点击"提取视频提示词"按钮

Step 3: 系统会自动分析视频并生成 SORA2 风格提示词

提取的提示词采用专业的三段式结构:

- Style: 视觉纹理、光照质量、色彩调板、氛围

- Cinematography: 摄像机运动、镜头特性、布光方案、情绪基调

- Scene Breakdown: 场景分解、动作序列、背景音

Step 4: 确认或修改提示词,选择模型参数后生成新视频

Step 5: 等待生成完成,查看复刻效果

视频:

通过对比来看效果还不错吧?呵呵,是不是非常简单!

体验地址:

总结

今天主要带大家了解并实现了 AI-video-Replicate 这款AI视频生成与复刻工具的完整部署流程,该工具以"多模型集成 + Qwen3-VL视频分析"为核心优势,结合短视频创作和内容复刻需求,通过 Gradio Web界面与 Python后端,形成了一套从文本/图片/视频输入到AI视频生成的全链路解决方案。

通过这套实践方案,内容创作者能够高效突破传统视频制作的痛点------借助一键部署(包括环境配置、依赖安装、API Key配置),无需专业的视频剪辑技能和昂贵的设备投入,就能快速生成Sora2级别的AI视频(如本次演示的"视频复刻"功能)。无论是文生视频、图生视频,还是视频提示词提取、一键复刻同款,都能通过简单的Web界面操作完成,极大提升创作效率和内容产出速度。

感兴趣的小伙伴可以按照文中提供的步骤进行实践,根据实际创作需求调整模型选择和提示词参数。今天的分享就到这里结束了,我们下一篇文章见。