说实话,玩了这么久的语音助手,最让我难受的不是它听不懂,而是那种明显的"割裂感"。

你说完一句话,系统开始转圈,把声音转成字,丢给大模型思考,生成文字,再找个TTS念出来。这一套流程下来,哪怕延迟只有一两秒,那种"我在跟机器说话"的感觉也挥之不去。

但在2025年年底,这个局面可能真的要变了。

就在12月23日,阿里通义大模型团队悄悄扔出了一个重磅炸弹:Fun-Audio-Chat-8B。这不是又一个普通的语音助手,而是通义百聆家族里首个主打**端到端"语音对语音"**交互的模型。

最关键的是,它直接开源了。

为什么这次不一样?

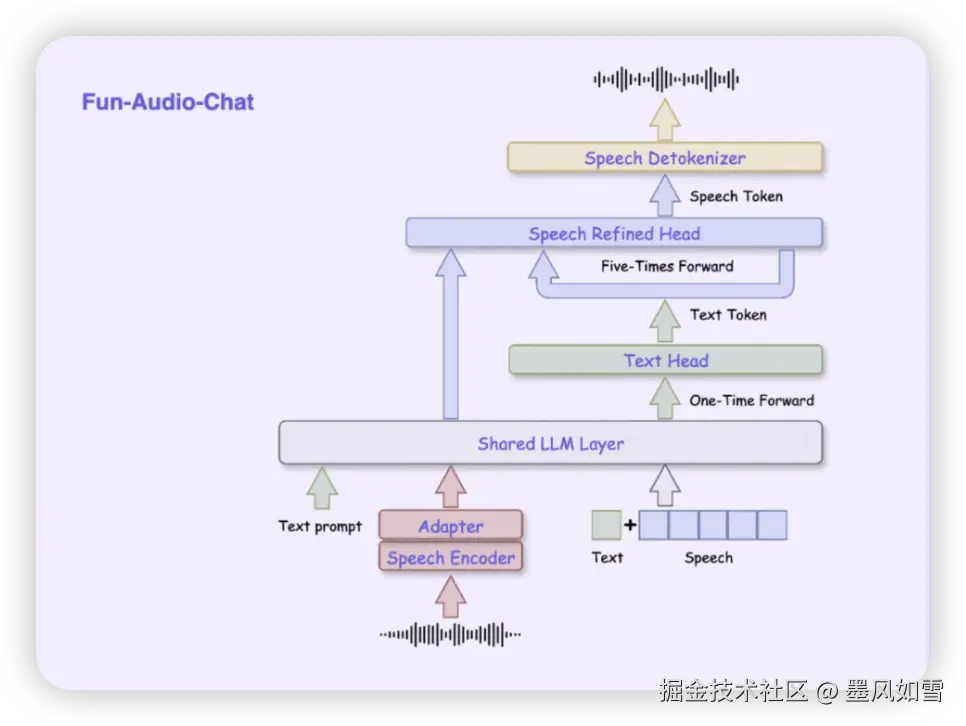

以前我们做语音交互,像是搞接力赛,耳朵(ASR)、大脑(LLM)和嘴巴(TTS)各跑各的。Fun-Audio-Chat直接把这个流程打通了,它采用了一种叫**端到端S2S(Sequence-to-Sequence)**的架构。简单来说,模型直接听声音,然后直接吐声音。

这种改变带来的体验升级是质的。没有了中间商赚差价,延迟被压到了极低。而且它支持"全双工交互",你可以像跟真人聊天一样随时打断它,它也能一边听一边想一边说。这种"边听边说"的能力,才是通义这个新模型最吓人的地方。

聪明的"双分辨率"设计

你可能会担心,直接处理音频数据,算力扛得住吗?

这就要提到通义团队这次搞的一个很骚的操作:双分辨率架构。

他们发现,人类说话的语速其实并不快,但声音的细节(音色、情感)需要高采样率。于是他们让模型的大脑(LLM层)以5Hz的低帧率去处理语义,省劲又快;然后专门配了一个"语音重合成头",以25Hz的高帧率去还原声音细节。

结果就是,这玩意儿比原本的方案省了近50%的GPU计算开销。对于想在本地部署(比如你有一张RTX 3090或4090)的开发者来说,这简直是福音。

它真的懂你的情绪

除了快,Fun-Audio-Chat最让我惊喜的是它的"情商"。

以前的语音助手全是莫得感情的读稿机器。但Fun-Audio-Chat引入了Core-Cocktail训练策略,在保留强大文本逻辑的同时,疯补了百万小时的语音数据。

这意味着什么?意味着它不需要你打字备注[悲伤],光听你说话的语气、停顿、叹气,它就能get到你的情绪。它会根据你的状态,调整自己的语调来安慰你或者陪你开心。这种无提示的情绪感知,才是通义百聆想做的"AI语音搭子"。

不仅能聊,还能干活

别以为它只是个聊天机器人。在语音功能调用这块,它也做得相当扎实。你可以直接用大白话让它"放首轻松的歌,顺便查查去机场堵不堵",它能直接调用函数去执行,而不是傻傻地回你一句"我不明白您的意思"。

实测成绩单

在这个圈子,光吹技术没用,还得看跑分。

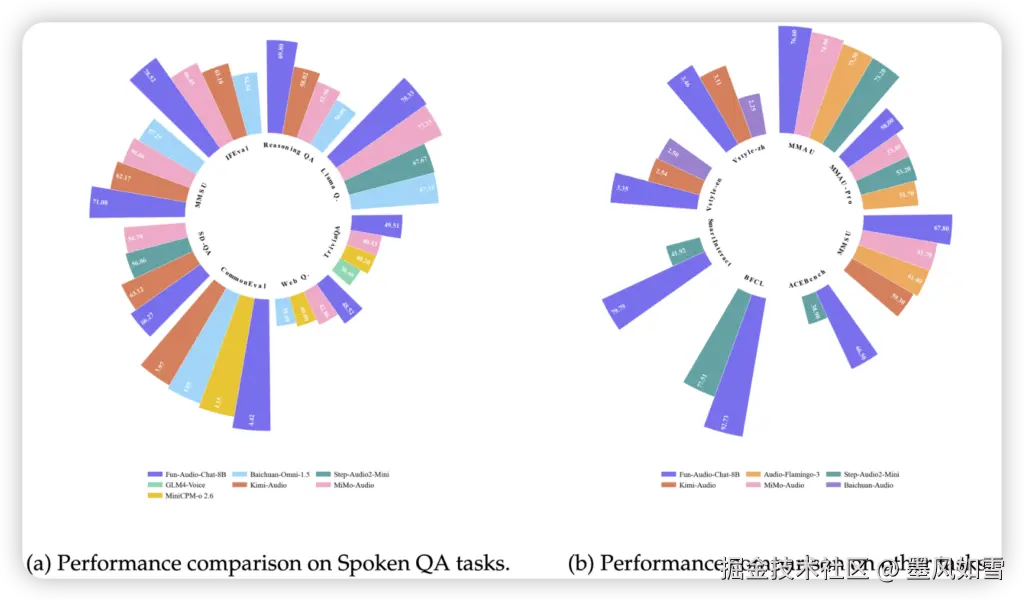

在OpenAudioBench、MMAU这些硬核评测里,Fun-Audio-Chat-8B面对同尺寸(8B)的竞品,比如GLM4-Voice和Kimi-Audio,几乎是压倒性的优势。特别是在语音理解和生成质量上,它确实拿出了榜一大哥的实力。

写在最后

目前,Fun-Audio-Chat-8B的权重、推理代码都已经扔到了Hugging Face、魔搭社区和GitHub上。

如果你是一个对语音交互有执念的开发者,或者想给自己的应用加上一个真的"像人"的语音接口,这个模型绝对值得你去跑一下。

2025年的尾巴,通义不仅卷了技术,还把门槛给打下来了。语音交互的iPhone时刻,可能真的不远了。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站