我自己的原文哦~ https://blog.51cto.com/whaosoft143/14402408

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#xxx

....

#突发,小.鹏副总裁离职......

据云见 Inisight报道,小鹏产品中心副总裁陈永海已于 2025 年 12 月离职,其职务暂由总裁王凤英接替。

陈永海于22年1月加入小鹏汽车,可以说陪着何小鹏渡过了最艰难的时期。当时小鹏互联网中心副总裁纪宇提出离职,陈永海接替其负责互联网中心。同年,小鹏 G9 上市失利,小鹏重新调整产品布局,陈永海转而负责产品中心。

今年小鹏汽车全年交付429,445辆,同比增长125.94%,达成率122.7%,虽12月交付量(37,508辆)未达四季度指引,但全年增长势头强劲。在新势力中排名第二,仅次于零跑的59.7 万辆。

接棒的王凤英曾在长城汽车任职 31 年,于 2023 年加入小鹏担任总裁,负责产品、营销、销售及供应链等业务。可以说,王凤英的加入是小鹏翻身仗成功的重要一环。

....

#为什么蔚来会押注世界模型?

这两天蔚来NWM2.0集中宣发,效果号称还不错。根据之前蔚来公开的信息,世界模型可能会有惊喜。任少卿认为智能驾驶真正的上限在世界模型,即以视频为核心,通过跨模态的互相预测和重建,让系统学习时空和物理规律,让机器能像人一样理解环境。

世界模型解决的是时空认知 ,语言模型解决的是概念认知 。语言模型低带宽和稀疏性无法真正有效的建模真实世界的四维时空(时间+空间)。 世界模型的认知包含两个层面:

- 物理规律的内建:比如重力、惯性、速度变化,这些规律必须在模型内部形成;

- 时空操作能力:能理解和预测物体在三维空间 + 时间维度的运动,比如车辆绕行、机器人搬运。

世界模型不是 "语言加法",而是要建立一套高带宽的认知系统,所以直接在视频端建立能力,而不是先转成语言。所以我们看到一些AI巨头在做通用世界模型,李飞飞Marble、yann lecun的V-JEPA 2、DeepMind发布Genie 3。

而在自动驾驶领域,常见的方向是视频生成/OCC生成 ,此外还有Lidar点云生成等方向。很多公司基于这些开源算法搭建自己的云端/车端世界模型,用于长尾数据生成或者闭环仿真/评测。一些公司也在尝试基于世界模型直接赋能车端驾驶能力。

....

#DriveLaW

超越DriveVLA-W0!DriveLaW:世界模型表征一统生成与规划(华科&小米)

近年来,得益于感知(如 BEVFormer, MapTR, BEVDet 等)和规划(如 UniAD, VAD, DiffusionDrive, ReCogDrive 等)的突破性进展,自动驾驶技术取得了长足进步。然而,现有系统在面对长尾场景 时依然显得脆弱,严重制约了闭环驾驶的性能。为了解决这一难题,近期大量研究工作尝试运用 世界模型(World Models),旨在通过预测驾驶场景的未来演变来增强系统的泛化性与鲁棒性来解决长尾问题。

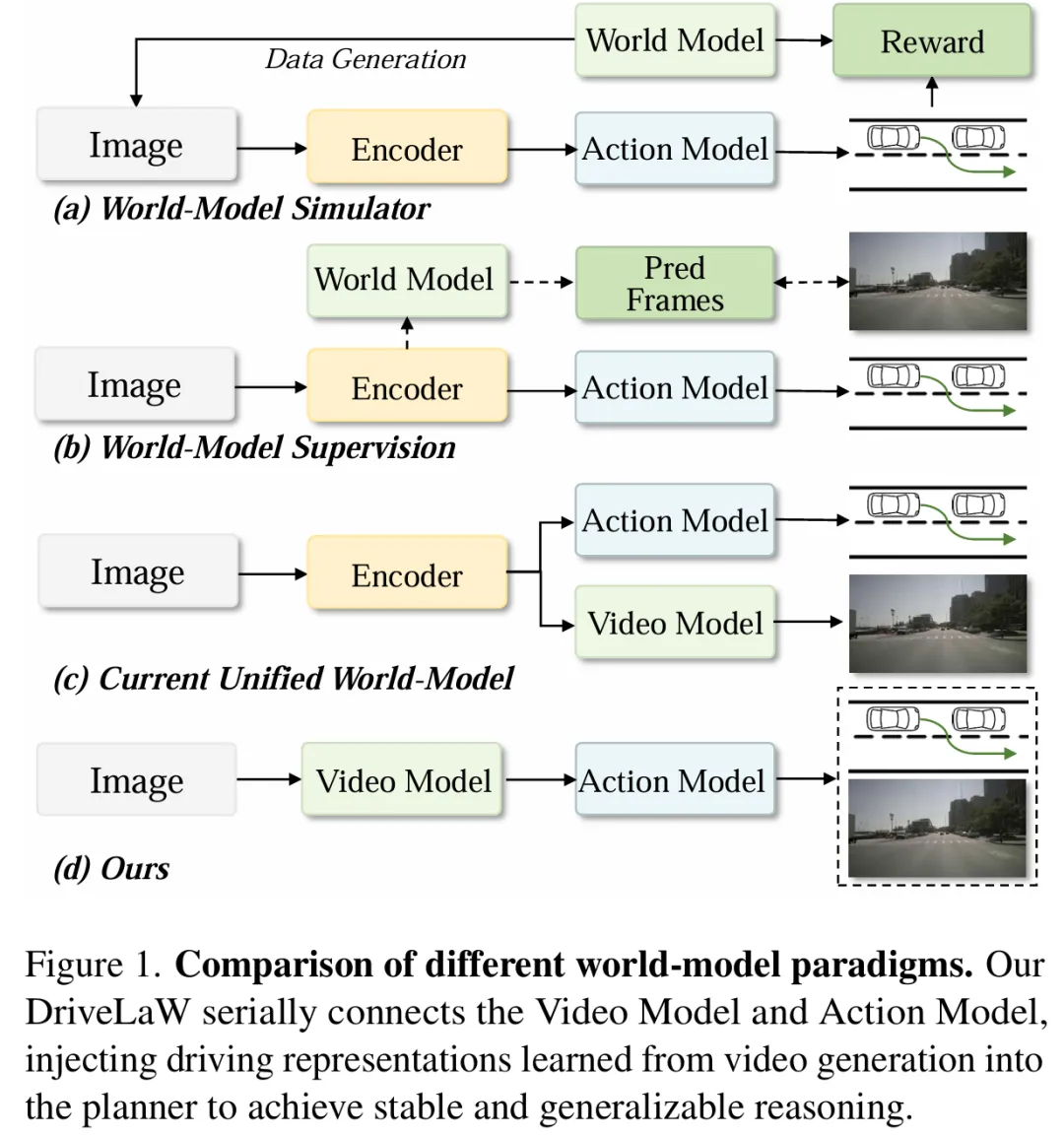

目前,世界模型在自动驾驶中的应用已百花齐放:一类致力于合成下游任务数据以应对罕见场景(如 VISTA, GAIA, MagicDrive, DriveDreamer, DrivingDiffusion);另一类利用模拟环境进行策略学习(如 RAD, ReSim, OmniNWM);还有一类则提供未来的视觉预测作为辅助监督信号(如 DriveVLA, DriveWorld 等)。尽管通过大规模视频生成学习物理规律带来了泛化性的提升,但现有的世界模型在规划 层面的贡献往往是间接的或与规划器并行的,缺乏与决策过程的紧密耦合。具体而言,现有方法主要分为以下三类:

- 世界模型模拟器(World-model Simulators):仅用于合成数据或作为闭环环境引导策略学习,模型的物理理解无法直接传递到规划器的内部状态中。

- 世界模型监督(World-model Supervision):仅预测未来视觉或信号来监督轨迹,规划过程依然是外部指定的。

- 统一世界模型(Unified World-model):虽然尝试联合生成视频和轨迹(如 Epona, DriveVLA-W0),但这些方法往往将视频生成器与策略头(Policy Head)解耦,未能利用生成器强大的 内部潜在特征 作为规划依据,导致"视觉想象"与"动作决策"之间存在鸿沟。

针对上述痛点,我们提出了 DriveLaW ,一种基于共享潜在空间表征的端到端世界模型。受 Genie Envisioner 等工作的启发,DriveLaW 创新性地将生成与规划从并行 转变为链式结构。其核心思想在于:大规模视频生成模型学习到的潜在特征蕴含了丰富的场景语义、智能体动力学和物理规律。DriveLaW 不再浪费这些宝贵的先验知识,而是直接将视频生成器的紧凑潜在表征注入到基于 DiT(Diffusion Transformer) 的规划器中。

DriveLaW 的核心优势与创新包括:

- 链式生成与规划:通过共享潜在空间,模型充分利用了视频预训练学到的强大表征,避免了生成器与规划器之间的梯度干扰,并确保了生成的视觉细节与规划轨迹的一致性。

- 架构设计:包含 DriveLaW-Video 和 DriveLaW-Act。前者引入了噪声重注入机制以平衡高压缩率与视觉保真度;后者则利用 Flow-matching 目标训练,直接在视频潜在特征的条件下生成平滑、鲁棒的轨迹。

- 渐进式学习:采用三阶段训练策略,有效解决了高保真视频合成与稳定轨迹生成之间的优化冲突。

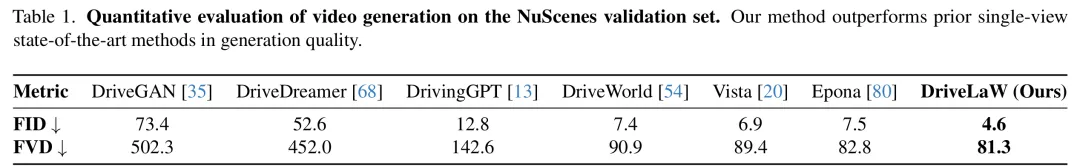

我们在 nuScenes 视频生成任务和 NAVSIM 轨迹规划任务上进行了广泛验证。结果显示,DriveLaW 不仅在视频生成质量上达到了 4.6FID,81.3FVD 分数 ,超过之前的世界模型方案,更在 NAVSIM 闭环规划基准测试中,无需任何强化学习(RL)微调或后处理,便达到了 89.1 PDMS 分数,超越了以往的纯视觉世界模型方案,充分证明了利用生成式先验进行决策控制的巨大潜力。

- 论文题目:DriveLaW: Unifying Planning and Video Generation in a Latent Driving World

- 论文链接:https://arxiv.org/abs/2512.23421

- 代码链接:https://github.com/wm-research/DriveLaW(将陆续开源模型、代码、权重)

二、相关工作自动驾驶中的世界模型

世界模型旨在将物理世界的结构与动力学内化为预测性的潜在表征。早期研究(如 GAIA、MagicDrive、VISTA)将其视为条件视频生成任务,侧重几何一致性;OccWorld 和 OccSora 引入占据栅格表征以捕捉 3D 时空结构;UniScenes 和 Genesis 进一步实现了 RGB-LiDAR-Occupancy 的多模态联合生成。另一类工作(如 ReSim、OmniNWM、RAD、HUGSIM)将世界模型作为仿真引擎,通过 3DGS 重建或行为模拟支持闭环评估与强化学习。近期,DrivingGPT、Epona 和 DriveVLA-W0 尝试在统一模型中联合生成视频与轨迹,但这些方法通常将视频生成与策略头解耦为独立的输出流,导致规划轨迹未能与视频生成的内部特征对齐。而我们的 DriveLaW 首次利用视频生成器的中层潜在特征直接作为规划表征,填补了视觉想象与动作选择之间的鸿沟,实现更稳定的闭环驾驶。

视频生成技术

视频生成已成为以视觉为中心的世界模型的核心。GAIA-1 采用自回归框架生成驾驶场景视频;DriveDreamer、Panacea、DrivingDiffusion 和 MagicDrive 利用扩散模型,结合 BEV 和 3D 框等几何特征生成可控场景;MagicDrive-V2、MiLA 和 GAIA-2 通过潜在扩散模型实现了长时序、高保真的驾驶视频生成;TeraSim-World 和 Cosmos-Drive 则构建了大规模合成数据流水线以服务于下游任务。尽管现有方法在视觉合成上取得了显著进展,但它们主要将视频生成器视为"渲染器"。而 DriveLaW 将视频生成器重新定位为"特征提取器",认为其内部激活值编码了丰富的时空动力学理解,并将其与扩散规划器配对以实现端到端驾驶。

自动驾驶中的扩散策略(Diffusion Policy)

扩散模型在时序动作建模方面的成功推动了其在自动驾驶中的应用。DiffusionDrive 引入截断扩散与锚点初始化噪声实现实时多模态规划;Diffusion Planner 将规划任务重定义为未来轨迹生成,联合预测自车与周边车辆轨迹;ReCogDrive 将 VLM 与扩散规划器耦合,注入认知先验;GoalFlow 利用流匹配(Flow Matching)生成目标点引导以确保行驶安全。不同于上述工作,我们创新性地将 Video DiT 与扩散规划器进行"链式"连接,从大规模驾驶视频中蒸馏驾驶先验并注入规划器,从而显著提升闭环驾驶的稳定性。

三、方法

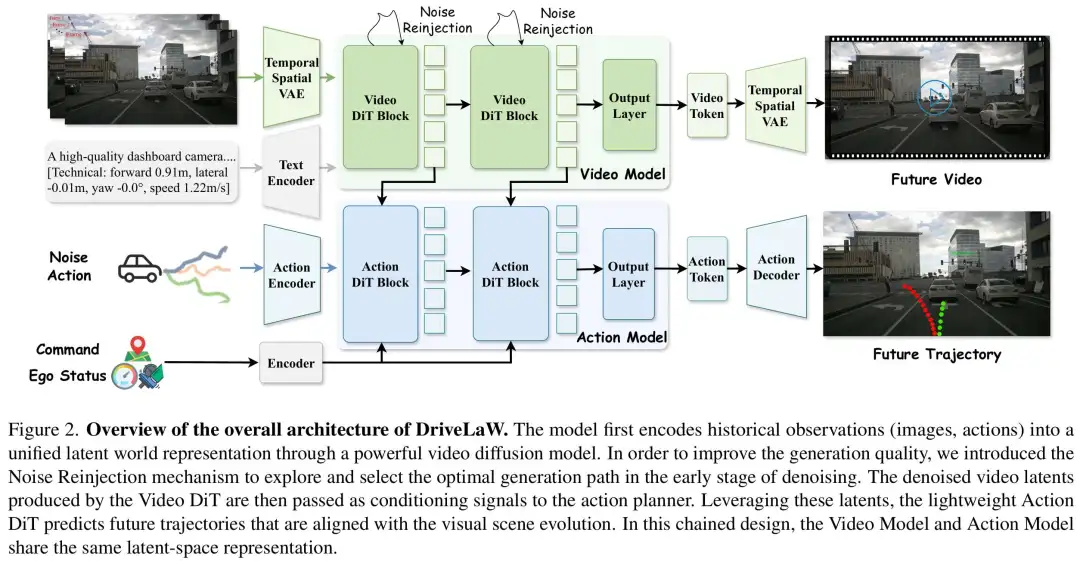

DriveLaW 是一个统一的世界模型框架,旨在通过共享潜在空间表征将视频生成与轨迹规划深度耦合。其核心由两部分组成:时空视频生成器 DriveLaW-Video 和基于扩散的规划器 DriveLaW-Act。推理时,DriveLaW-Video 首先将历史帧、文本提示等编码为潜在特征并进行去噪生成视频,同时,其中间层的潜在特征被提取出来作为关键的感知信号,连同自车状态、高层指令一起输入给 DriveLaW-Act,后者通过流匹配(Flow Matching)生成最终的平滑轨迹。最后,为了兼顾高保真视频生成与稳定规划,我们设计了三阶段渐进式训练框架。

3.1 从视频生成器学习可泛化的驾驶表示

世界模型(如 Genie、Cosmos)通过大规模视频生成训练习得真实世界结构;多项研究表明,视频生成器内化了物理规律,具备强零样本学习能力。在自动驾驶中,真实场景几乎可提供无限视频,而稠密标注代价高昂。因此,我们提出:像人类获得驾驶技能一样,从大规模驾驶视频生成中学习驾驶表征。

具体地,设视频编码器为 ,片段 的潜变量为 。通用去噪器在条件 下通过单步更新产生潜去噪轨迹 :

其中 为学得的去噪算子, 为推理时刻。我们提取"中去噪"特征:

并选取一个或少部分时刻 组成感知潜变量 。该潜变量编码了从生成中蒸馏出的驾驶认知先验,并输入规划模块以实现稳定闭环驾驶。

3.2 DriveLaW

如图 2 所示,DriveLaW 是一个统一框架,由 DriveLaW-Video 与 DriveLaW-Act 组成。视频模型(如 LTX-Video)先用时空 VAE 编码历史驾驶帧,并用文本编码器编码文本提示;随后一堆 Video DiT 块在潜空间完成去噪,最后 VAE 解码器重建视频。与此同时,动作噪声、自车状态与高层指令被编码并送入动作模型。Video DiT 输出的视频潜变量作为条件信号,引导 Action DiT 输出最终轨迹。Video DiT 与 Action DiT 链式连接,并联合训练以从大规模视频生成中学习驾驶表征,为规划提供共享基础。

3.3 DriveLaW-Video:时空世界生成器时空 VAE

我们采用高压缩比 (pixel-to-token ratio )的时空 VAE,将视频片段编码至 时空分辨率、128 通道的因果潜空间,显著优于常见 或 的压缩率,可在相同算力下延长预测时域------对建模红绿灯变化、车辆动态等长程依赖至关重要。编码器使用 3D 因果卷积,确保每帧仅依赖过去与当前帧,避免时序信息泄露。

不同于常规方案"潜空间全部反向扩散后再一次性解码",我们采用混合策略:在整流流调度较晚阶段 时解码,并在像素空间做最后精修:

where

时间条件去噪解码器 仅用最后一步将潜变量映射回像素,可在不引入额外超分模块的前提下恢复高频细节(高光、动态阴影、精细路面纹理),开销极小。

视频 Transformer 结构

压缩后的高维时空令牌由三维 Transformer 处理(改自 PixArt-)。每块使用自注意力完成全局时空建模,并用交叉注意力融合任务条件(导航指令、视觉提示)。我们对 Q/K 做 RMSNorm 保证注意力稳定,采用 旋转位置编码 RoPE 与归一化坐标,增强跨分辨率/帧率一致性。

运动条件方面,我们将自车运动学转化为自然语言提示,而非专用运动编码器,可直接利用预训练文本到视频架构,提供可解释控制,统一静态与动态条件,并避免数值编码与数据集尺度耦合,提升跨数据集泛化。

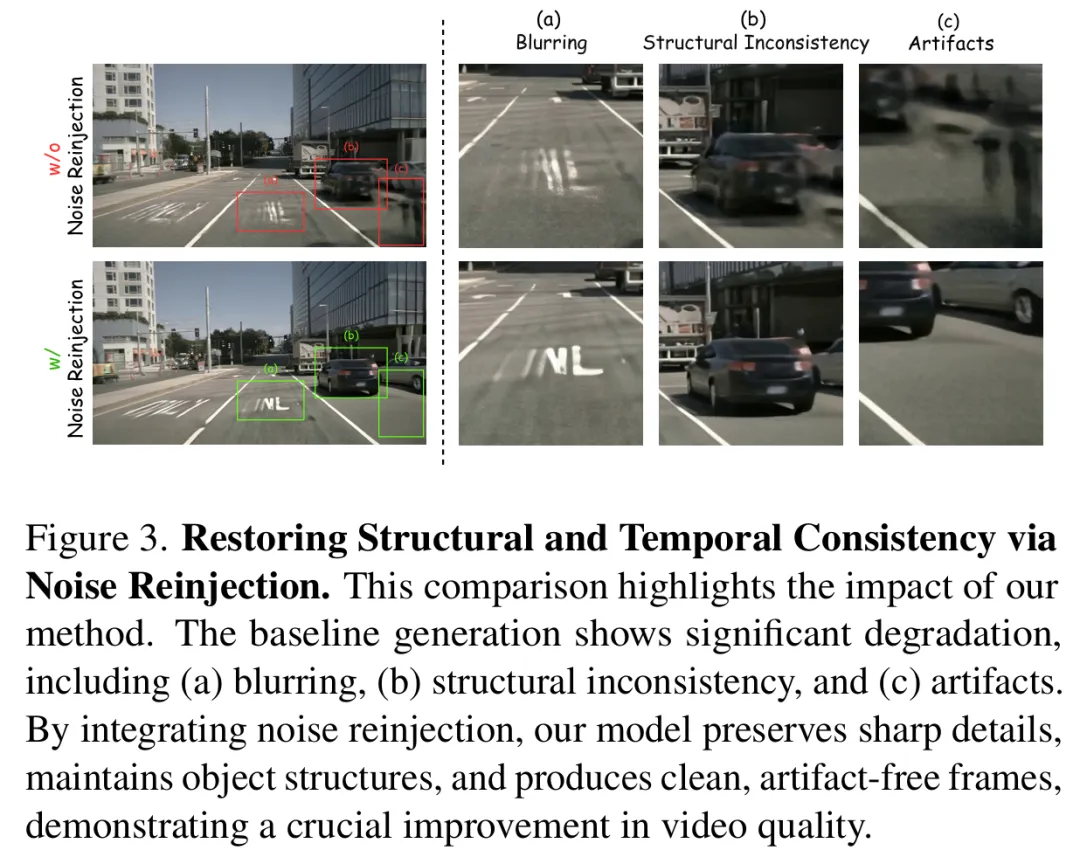

噪声重注入

高速驾驶视频生成中,长程运动与大位移常导致感知退化:边界过平滑、细纹理消失、模糊与伪影累积,破坏车辆、车道线与远景结构一致性。受 DiffuseSlide 等迭代精修思想启发,我们提出更有针对性的策略:在每次主去噪前,选择性向高频区域重注入噪声,迫使模型主动再生细节而非平滑覆盖。

在任意去噪步 ,设当前隐向量为 ,我们首先预测干净隐向量的初始估计值 。关键步骤在于,通过 VAE 解码器将该隐向量解码为像素空间的临时图像 ,并将每一帧转换为灰度图 。整个高频掩码计算流程均在像素域执行,以保证精度。随后,我们应用离散拉普拉斯核 生成响应图 ,计算自适应阈值 ,并定义高频掩码:

为将掩码映射回隐空间,我们采用最近邻插值,将像素级掩码 从图像分辨率()下采样至隐空间分辨率(),得到最终的隐空间掩码 。接着,仅在掩码区域注入可控小幅度噪声,生成扰动后的隐向量:

其中为噪声重注入步骤的人工调优噪声强度,为高频掩码。

最终,扰动隐向量 被输入基于变换器的完整去噪算子 ,计算得到下一步隐向量 。这一机制迫使模型利用强大的生成先验知识,在噪声区域"补绘"与场景其余部分一致的合理高频细节。该针对性策略既能恢复动态目标与车道线的锐度和纹理,又能保持天空等区域的自然平滑度,实现细节重建与伪影抑制的平衡。噪声重注入效果图如图三所示。

3.4 DriveLaW-Act:基于扩散的规划器

受相关研究启发(DiffusionDrive, ReCogDrive),我们采用基于扩散的规划器,生成连续且时间平滑的行驶轨迹。具体而言,带噪动作 、自车状态 与高层指令 分别通过动作编码器和上下文编码器进行编码:

其中, and 。同时,在 Video DiT 的首个去噪步,将各 Transformer 块的潜特征缓存为 。流匹配每一步,Action DiT(记为 )以编码动作噪声 与连续时刻 为输入,条件于上下文嵌入 与缓存视频特征 :

其中 表示连续的时间步。

我们使用流匹配目标训练规划器,使模型的预测输出 与目标流对齐:

这鼓励生成与学习到的驾驶动力学一致的平滑、稳定的轨迹。

3.5 三阶段渐进式训练

为了生成高质量、稳定的驾驶视频,同时为规划器提供强大的表征,我们采用三阶段渐进式训练方案。

在第一阶段,我们通过在降低的空间分辨率 (width height frames)下的长片段上进行训练,专注于学习鲁棒的运动模式。此配置优先考虑时间跨度而非空间细节,使模型能够学习平滑、连续的驾驶行为,如车道保持、转弯和速度变化。由于视频扩散中的显存占用随空间和时间范围扩展,降低分辨率允许处理更多帧,这对于建模长视距场景至关重要。

随后,我们切换到更高的空间分辨率但较短的片段 ,以进一步增强视觉质量和细粒度细节,如车道标记、周围车辆和环境纹理。在这个阶段,帧数较少但空间尺寸较大,将容量分配给空间保真度,同时保留第一阶段建立的时间连贯性。

最后,基于这个学习了符合物理规律的驾驶动力学的强大视频生成器,我们将 DriveLaW-Act 以 DriveLaW-Video 的潜在特征为条件,并对其进行轨迹规划训练。这一第三阶段通过使用视频潜变量作为规划器的紧凑感知,将生成和规划耦合起来。这三阶段课程为 DriveLaW 配备了高保真视频合成能力和可靠、稳定的轨迹规划能力。

四、实验

表 1 报告了我们的方法在 nuScenes 数据集上生成评估的定量结果。在两项指标上,DriveLaW 均超越了以往所有的单视图方法,达到了最先进的性能(SOTA),FID 为 4.6,FVD 为 81.3。结果证明了我们的方法在高保真驾驶视频生成方面的有效性。

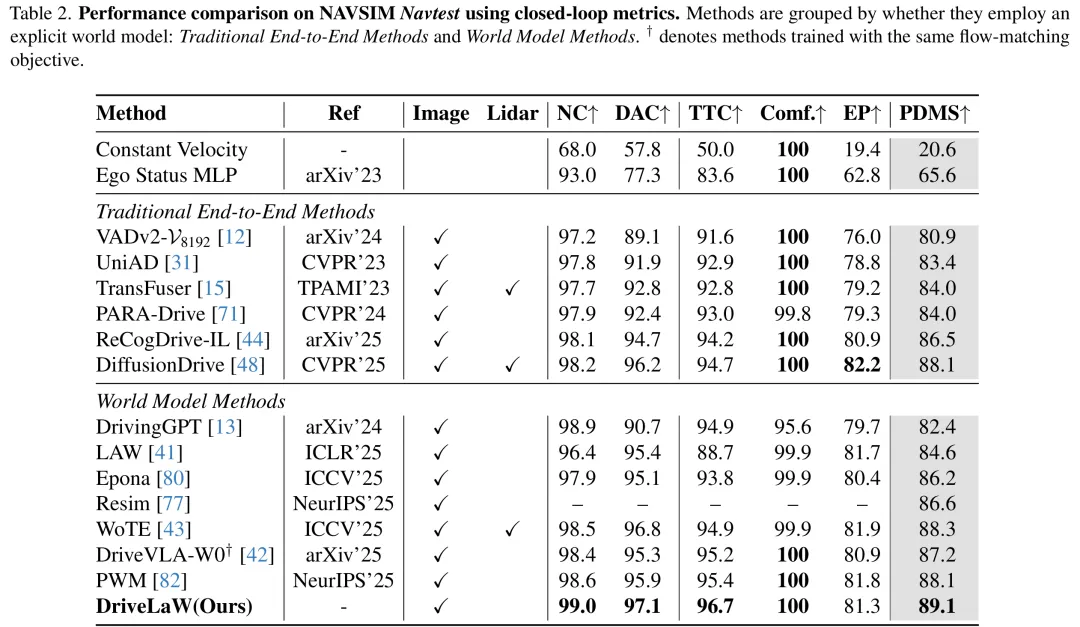

表 2 报告了我们的方法在 NAVSIM 的结果。DriveLaW 获得了 89.1 的 PDMS,取得了新的 SOTA,且没有任何后训练(如强化学习)或后处理(如可学习的评分器)。它超越了传统的端到端规划器,包括融合相机和激光雷达的 DiffusionDrive ,以及依赖视觉语言模型的 ReCogDrive 。与世界模型方法相比,DriveLaW 比采用并行生成-规划设计的 Epona 提高了 2.9 PDMS;比使用 VLM 和世界模型监督的 DriveVLA-W0 和 PWM 分别提高了 1.9 和 1.0 PDMS,这证明了将生成与规划级联起来的有效性。

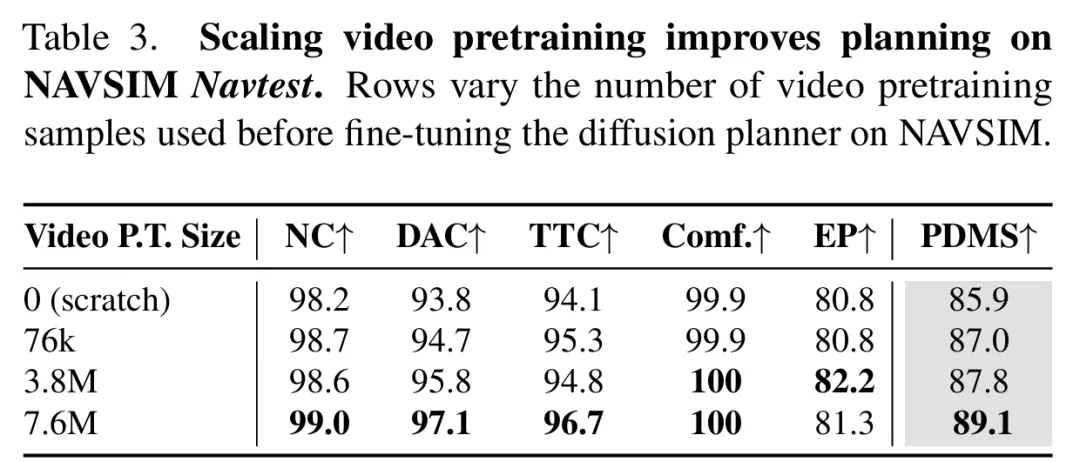

如表 3 所示,增加视频生成器的预训练样本量持续提升了 DriveLaW 在 NAVSIM 上的闭环性能。一个完全预训练的生成器比没有经过驾驶域预训练的生成器带来了 +3.2 PDMS 的提升,这表明更大的语料库加深了模型对驾驶物理规律的掌握,并转化为更强的规划能力,表现出明显的规模定律(scaling law)。

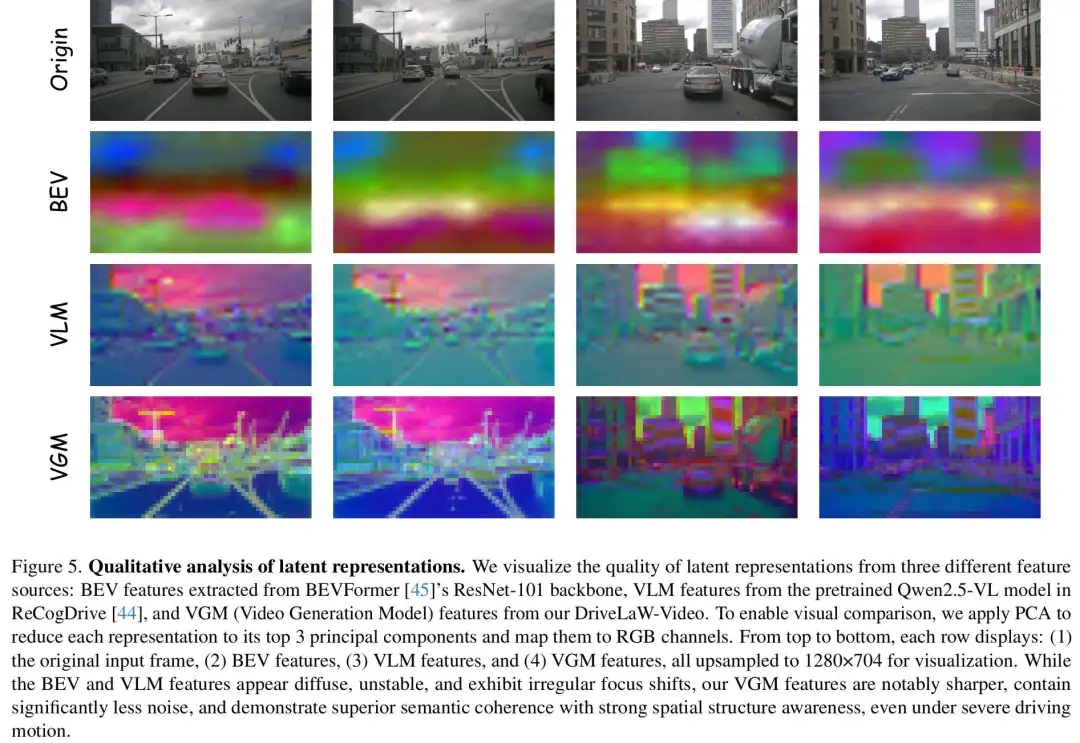

为了证明 VGM(视频生成模型)潜在特征可以作为动作学习更高效且信息丰富的条件,我们进行了系统分析。如图 5 所示,我们可视化并比较了三种类型的潜在表征。我们应用 PCA(主成分分析)将每种表征投影到映射为 RGB 通道的 3 个主成分上,所有表征均上采样至 1280×704 。可视化清晰地显示,BEV 和 VLM 特征是弥散的、不稳定的,并表现出不规则的聚焦模式。相比之下,VGM 特征更锐利、噪声更少,并表现出卓越的语义连贯性和强大的空间结构感知能力,即使在具有挑战性的驾驶条件下也是如此。这表明 VGM 特征为自动驾驶中的动作学习提供了更合适的表征。

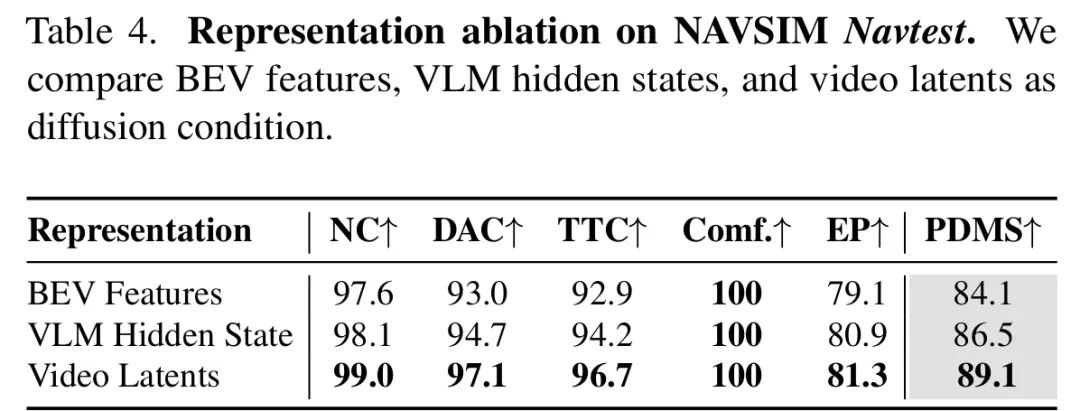

表 4 报告了不同驾驶表征的结果。在相同的基于扩散的规划器下,视频生成器潜在特征比 BEV 特征提高了 5.0 PDMS,比 VLM 隐藏状态提高了 2.6 PDMS,证明了该表征的有效性。

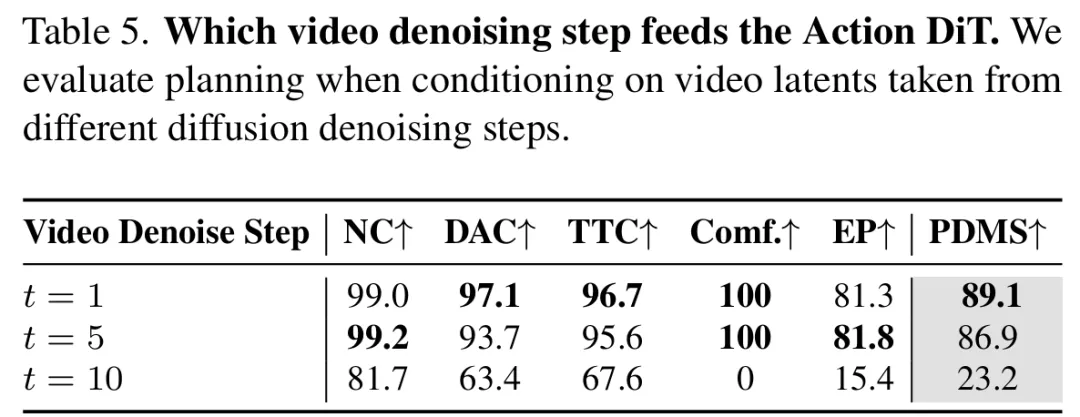

如表 5 所示,我们对哪一视频去噪步骤为 Action DiT 提供潜在条件进行了消融实验。以来自早期去噪步骤的潜变量为条件会产生更强的规划能力,而来自后期步骤的潜变量表现较差。这是因为原始像素格式的视频经常包含冗余的、非必要的信息,这可能会阻碍决策的有效性。

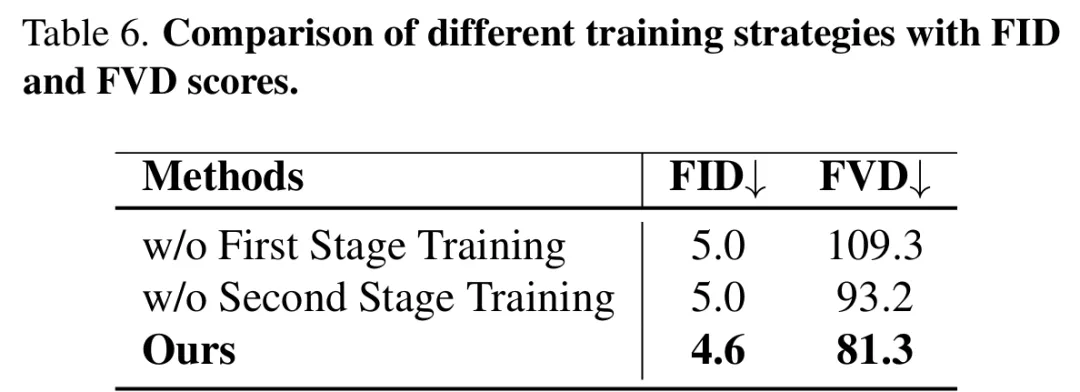

表 6 展示了不同训练策略的消融结果。移除第一阶段会导致相当的 FID,但 FVD 显著升高,表明由于缺乏长视距运动建模而导致时间连贯性的明显丧失。省略第二阶段保留了时间稳定性,但空间细节略有下降,这反映在 FVD 的少量增加上。完整的多阶段训练策略实现了最佳平衡,产生了最低的 FID 和 FVD,证实了每个阶段在确保高质量和时间一致的驾驶视频生成中发挥着互补作用。

五、结论

在这项工作中,我们提出了 DriveLaW,一个统一的潜在世界模型,旨在解决自动驾驶中视频生成与运动规划之间长期存在的脱节问题。我们首先介绍了 DriveLaW-Video,这是一个通过噪声重注入机制增强的时空生成模块,以确保高保真且时间一致的视频合成。在此基础上,我们设计了 DriveLaW-Act,这是一个基于扩散的规划器,它利用视频潜变量生成平滑且可靠的轨迹。为了进一步协调生成与规划之间的优化,我们采用了三阶段渐进式训练策略。在 nuScenes 和 NAVSIM 基准上的广泛实验表明,DriveLaW 达到了最先进的性能,验证了通过共享潜在表征统一驾驶世界生成与决策对于下一代端到端自动驾驶系统的有效性。

....