在 AI 编程工具百花齐放的今天,Cursor 凭借精准的代码理解、流畅的交互体验,成为无数开发者的日常主力 ------ 实时代码补全、逻辑优化、对话式解疑,轻松减轻重复编码的心智负担。但金融科技、政务系统等场景的严苛隐私要求,让核心代码与敏感数据绝不能脱离本地环境;而在线模型的网络延迟、API 调用成本、定制化不足等问题,也一直影响开发体验。

直到 OpenStation 的出现,终于找到了解决方案。这款本地大模型部署与管理平台,能一键打通本地大模型与 Cursor 的协同链路,既保留 Cursor 的高效交互,又满足数据本地化、定制化开发的核心需求,彻底重构 AI 编程体验。

一、基于 OpenStation 部署本地大模型服务

OpenStation 通过可视化操作简化部署流程,无需编写脚本即可完成本地模型服务搭建。以Qwen3-1.7B 模型(1.7B 参数量,4GB 显存需求)为例,具体步骤如下:

-

部署初始化:登录 OpenStation 后,进入 "模型服务> 新增部署",系统自动提示 "确认目标节点已添加""模型已下载",规避前置操作遗漏;

-

模型来源选择:支持平台模型库下载或本地路径上传,此处直接选取模型库中预下载的 Qwen3-1.7B,页面同步显示模型参数量、数据类型(BF16)、显存需求等关键信息;

-

部署模式

- Single(单机部署):支持选择 1 个 GPU 节点及至少 1 张加速卡部署单个实例;推理引擎可选 SGLang (GPU)、vLLM (GPU),适用于中小参数量模型的独立部署;

- Distributed( 分布式部署 ):需选择 2 个及以上节点,且每个节点选择相同数量的加速卡;平台自动采用张量并行、流水线并行方式部署,推理引擎可选 vLLM (GPU),适配大参数量模型的分布式需求;

- CPU-Only(纯 CPU 部署):支持选择 1 个 GPU/CPU 节点部署单个实例,推理引擎可选 vLLM (CPU-only),满足无 GPU 环境下的轻量化部署需求。

4. 节点选择

- **单机部署:**开发者可选择任意 1 张加速卡部署模型,避免整机资源占用;

- 分布式部署 **:**可跨节点分别在不同节点选择加速卡进行分布式部署,平台自动完成节点间协同;

- **CPU部署:**可以选择在任意节点上进行部署;

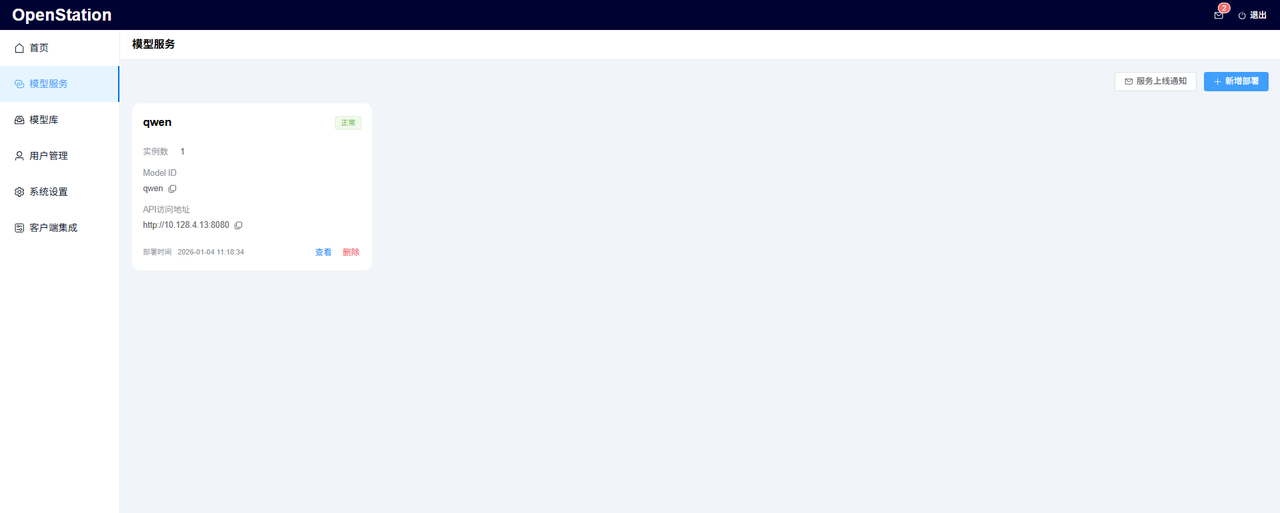

- **部署后管理:**服务上线后,平台界面可清晰展示实例状态、Model ID、API 访问地址及部署时间,支持实例查看与删除操作,便于运维管理。

模型服务部署完成后如下图:

二、本地模型服务对接Cursor客户端

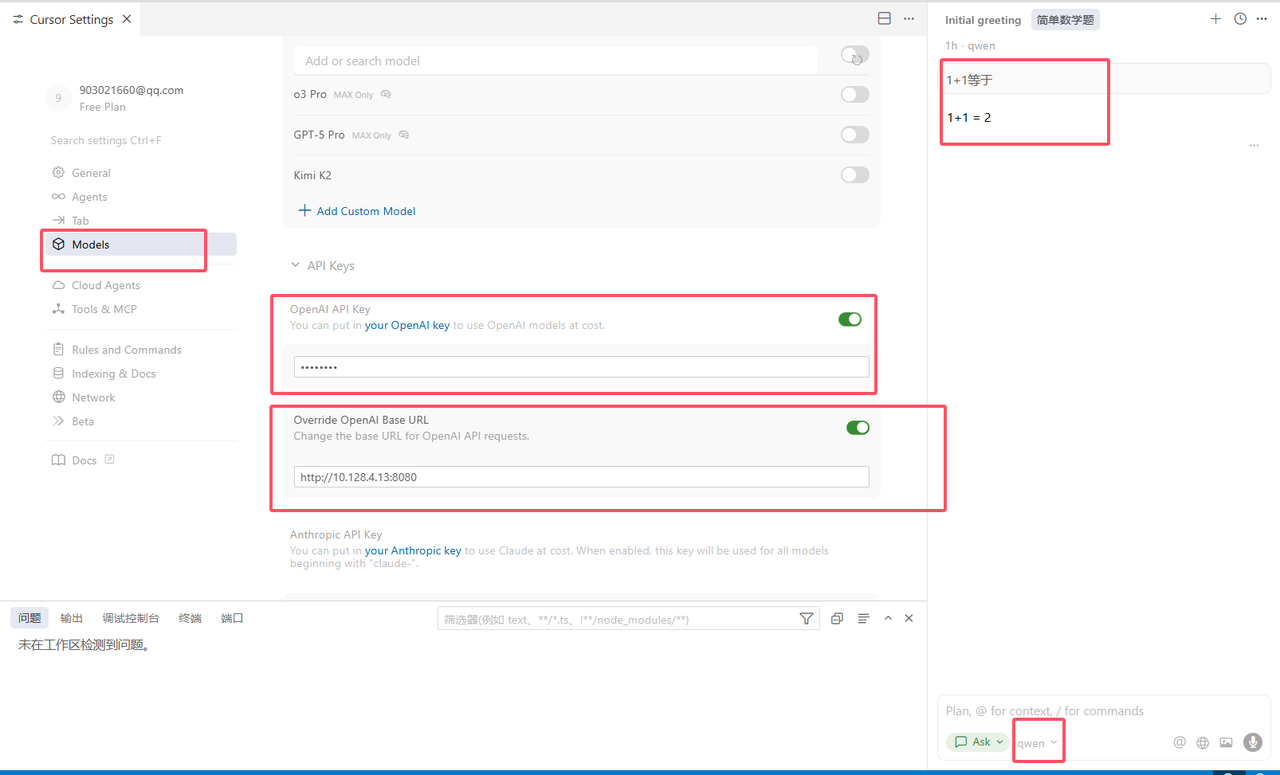

将 OpenStation 部署生成的服务信息配置至 Cursor,实现大模型服务端与客户端的联动:

-

打开Cursor设置(Settings);

-

选择"Models" > "Add Custom Model",填写本地大模型名称 "Model ID"(例如:qwen)

-

API key中填写个人Key及API访问地址(从上述OpenStation平台中已部署的模型服务中获取);

-

最后在右下角聊天窗口中选择本地模型服务(例如:"qwen"模型)。

三、OpenStation 快速部署指南

项目地址 :https://github.com/fastaistack/OpenStation

- 在线安装(支持Ubuntu22.04 / 20.04 / 18.04系列及Centos7系列)

bash

curl -O https://fastaistack.oss-cn-beijing.aliyuncs.com/openstation/openstation-install-online.sh

bash openstation-install-online.sh --version 0.6.7也可直接下载在线安装包(openstation-pkg-online-v0.6.7.tar.gz),上传至Linux服务器后执行:

bash

tar -xvzf openstation-pkg-online-v0.6.7.tar.gz

cd openstation-pkg-online-v0.6.7/deploy

bash install.sh true- 离线安装(仅支持Ubuntu 22.04.2/20.04.6/18.04.6)

点击「离线 OpenStation 安装包下载 」,参考上述**OpenStation项目地址**中离线安装文档。

部署完成后,登录页面如下:

四、结语:工具协同是 AI 编程的未来趋势

作为开发者,我们追求的从来不是 "更复杂的工具",而是 "更贴合需求的解决方案"。Cursor 凭借其易用性与精准的 AI 辅助能力,成为了开发流程中的核心入口;而 OpenStation 则解决了本地大模型部署的技术门槛,为工具提供了安全、高效的底层动力。两者的协同,不仅实现了 "1+1>2" 的效果,更代表了 AI 编程工具的未来趋势 ------ 将专业的能力封装为标准化服务,让开发者无需关注底层技术细节,只需聚焦核心业务逻辑。