springAi特性VS Langchain4j

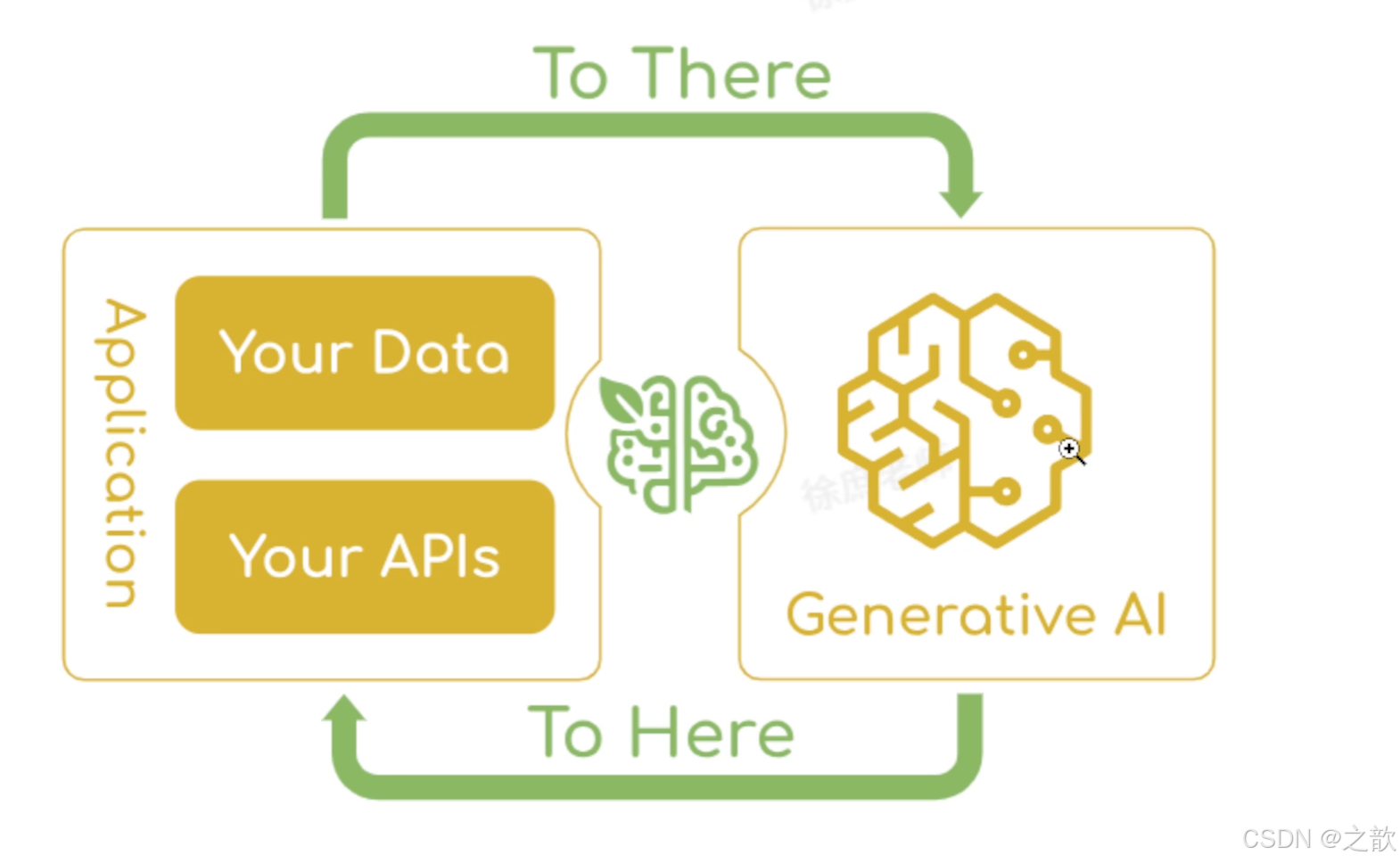

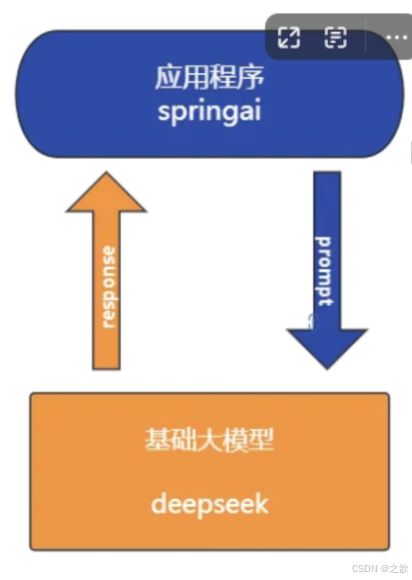

Spring Al 是一个面向人工智能工程的应用框架。解决了 AI集成的基本挑战:将企业数据和API与AI模型连接起来。

特性:

提示词工厂

可以说是大模型应用中最简单也是最核心的一个技术。他是我们更大模型交互的媒介,提示词给的好大模型才能按你想要的方式响应。

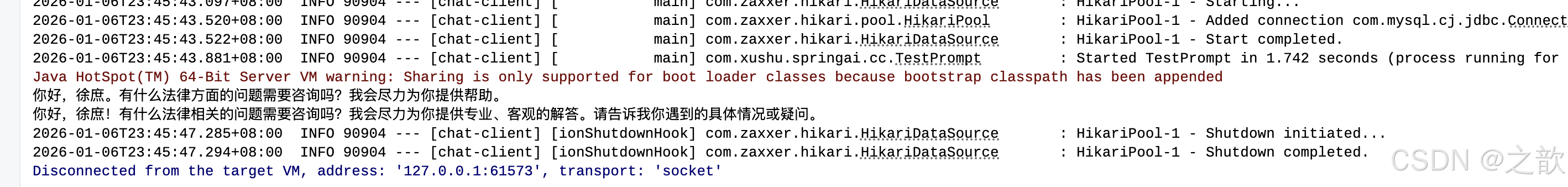

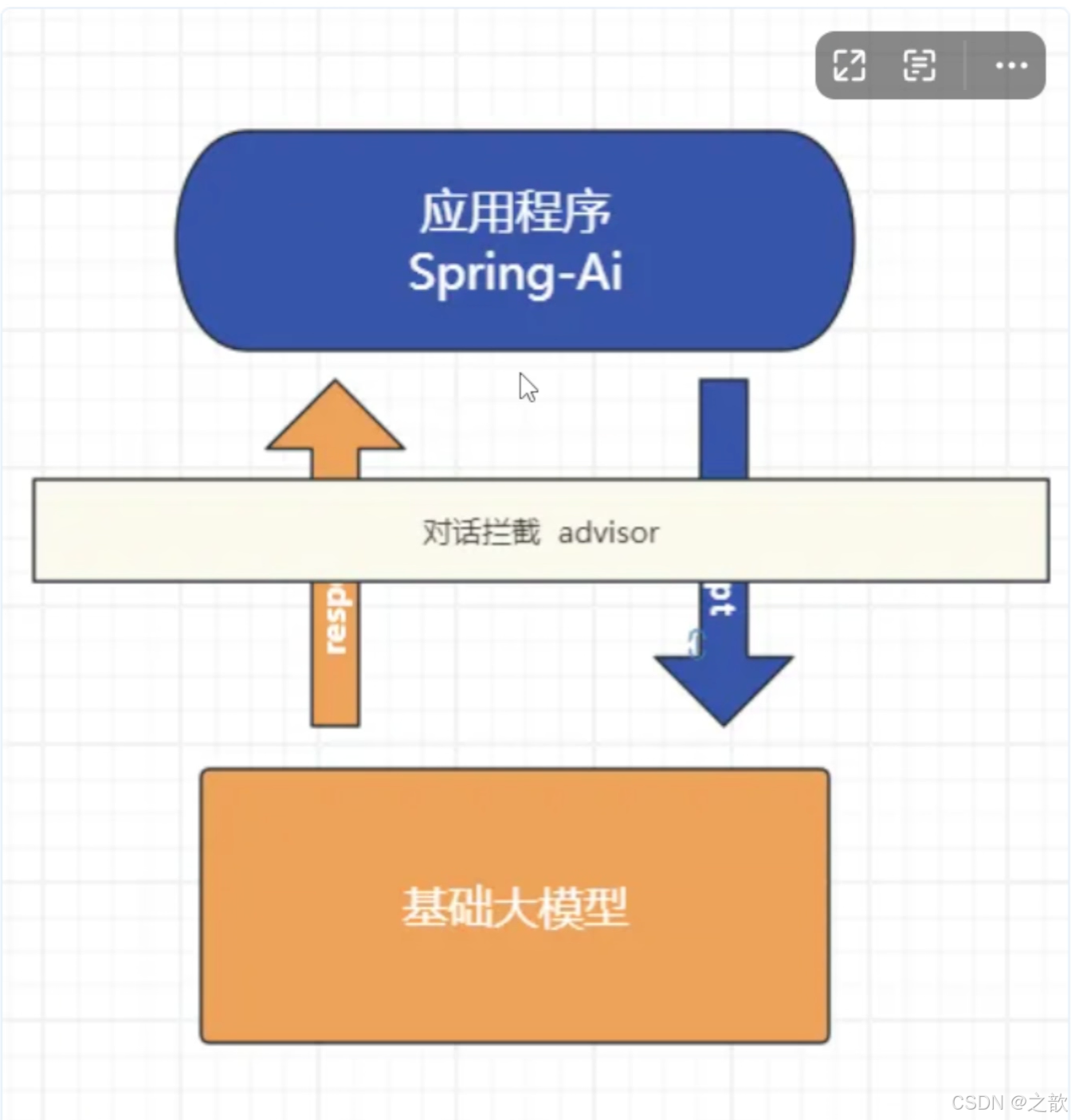

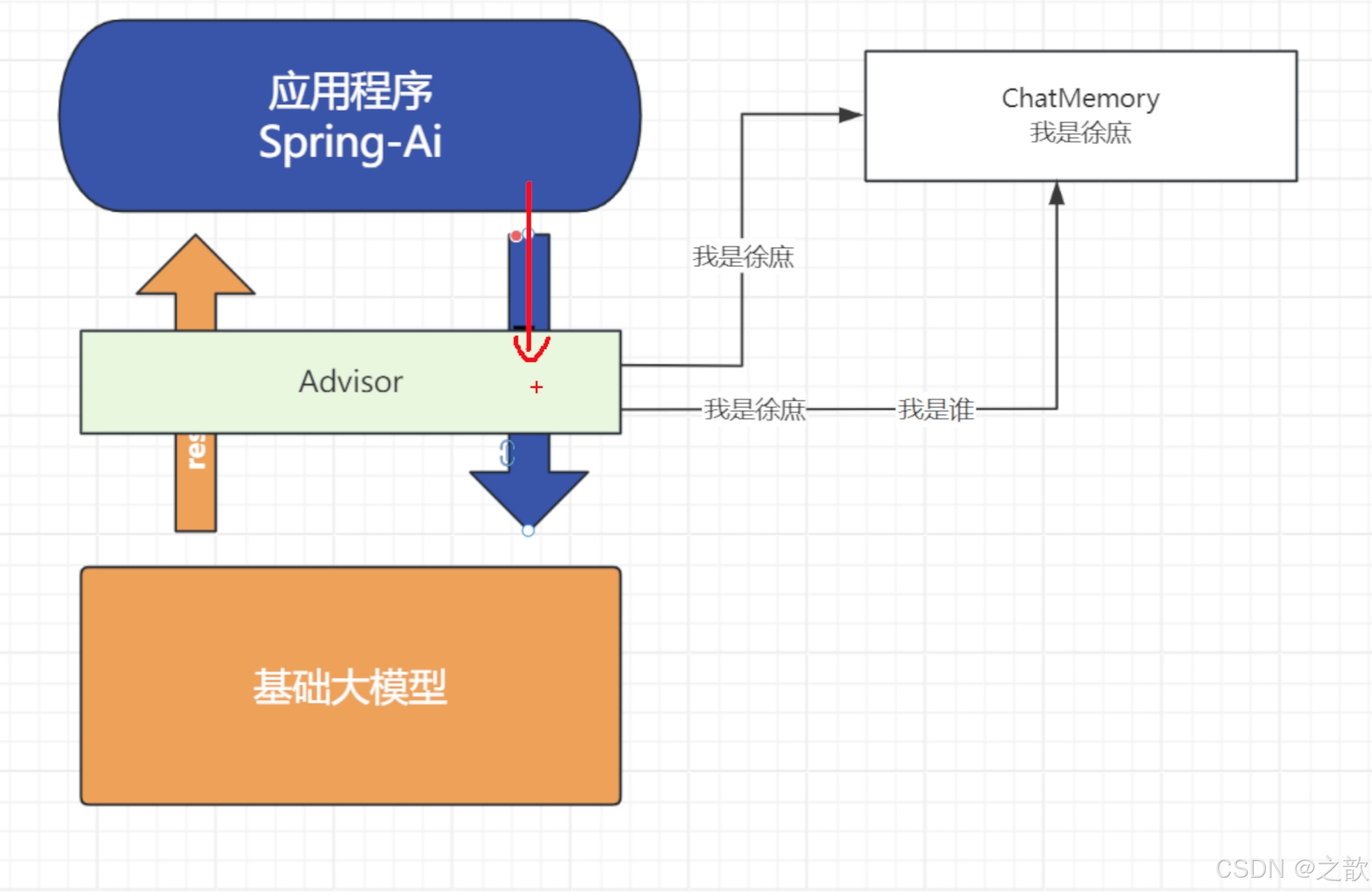

对话拦截advisors

面向切面的思想对对模型对话和响应进行增强。

对话记忆

java

@Autowired

private ChatMemoryRepository chatMemoryRepository;tools

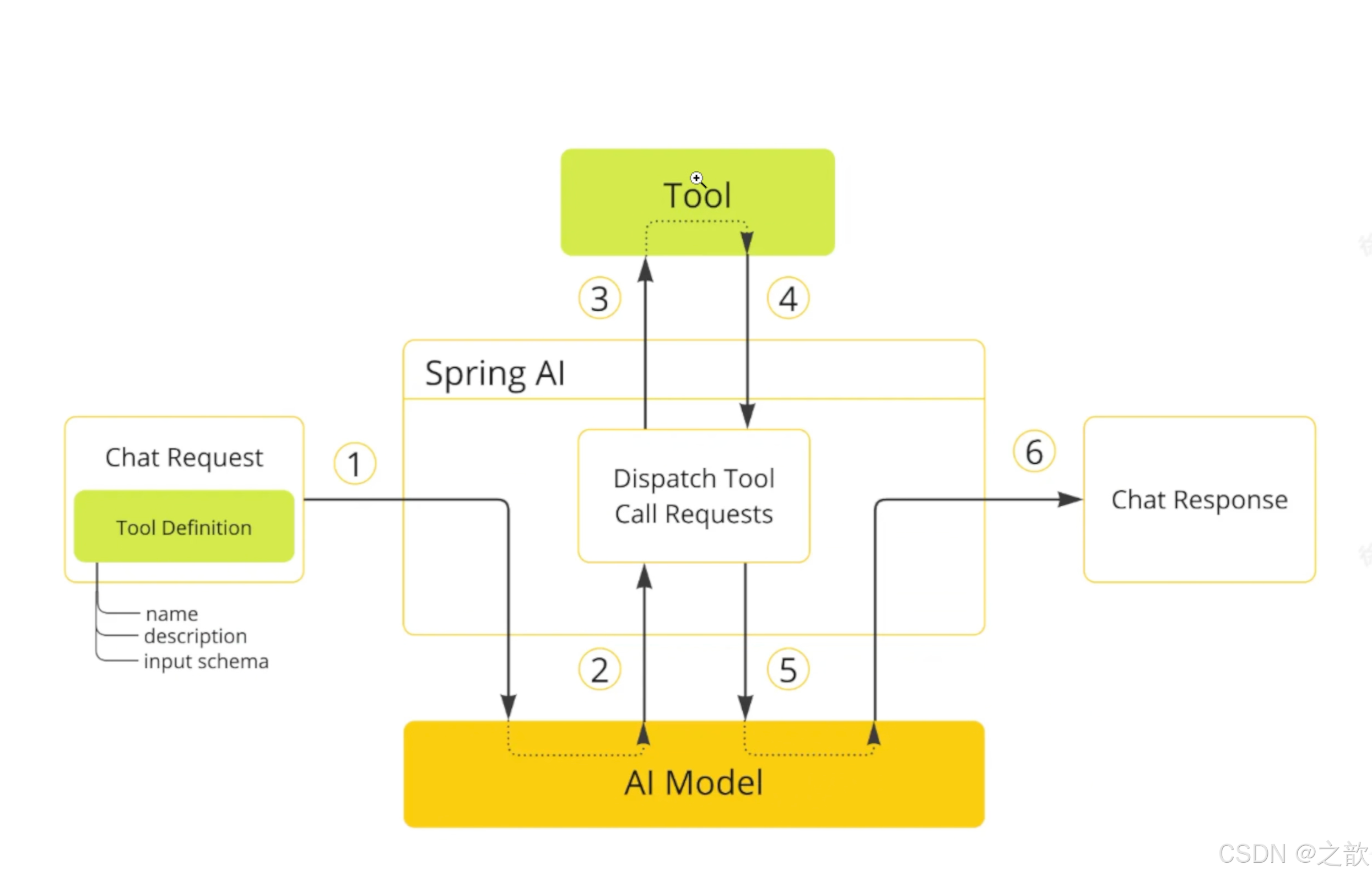

让大模型可以跟企业业务API进行互联,这一块实现起来也是非常的优雅

java

// 获取北京的天气

@Tool(description = "获取指定位置天气,根据位置自动推算经纬度")

public String getAirQuality(@ToolParam(description = "纬度") double latitude,

@ToolParam(description = "经度") double longitude) {

return "天晴";

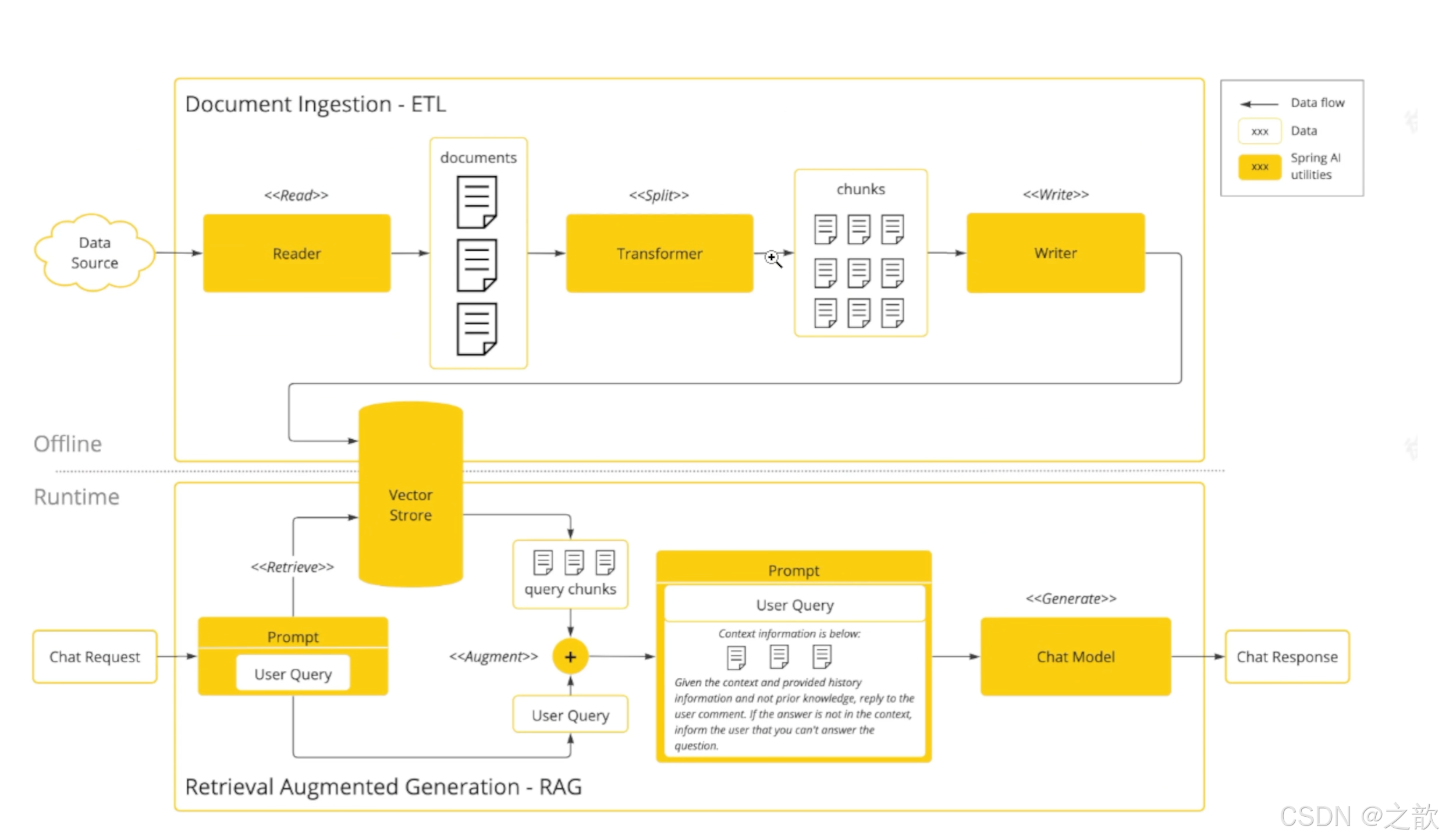

}RAG技术下的 ETL

让大模型可以跟企业业务数据进行互联(包括读取文件、分隔文件、向量化)向量数据库支持目前支持 20+种向量数据库的集成这块我到时候也会详细去讲

MCP

让tools外部化,形成公共工具让外部开箱即用。原来MCP协议的JAVA SDK就是spring ai团队提供的提回供了MCP 客户端、服务端、以及MCP认证授权方案,还有目前正在孵化的Spring MCP Agent 开源项目:

-

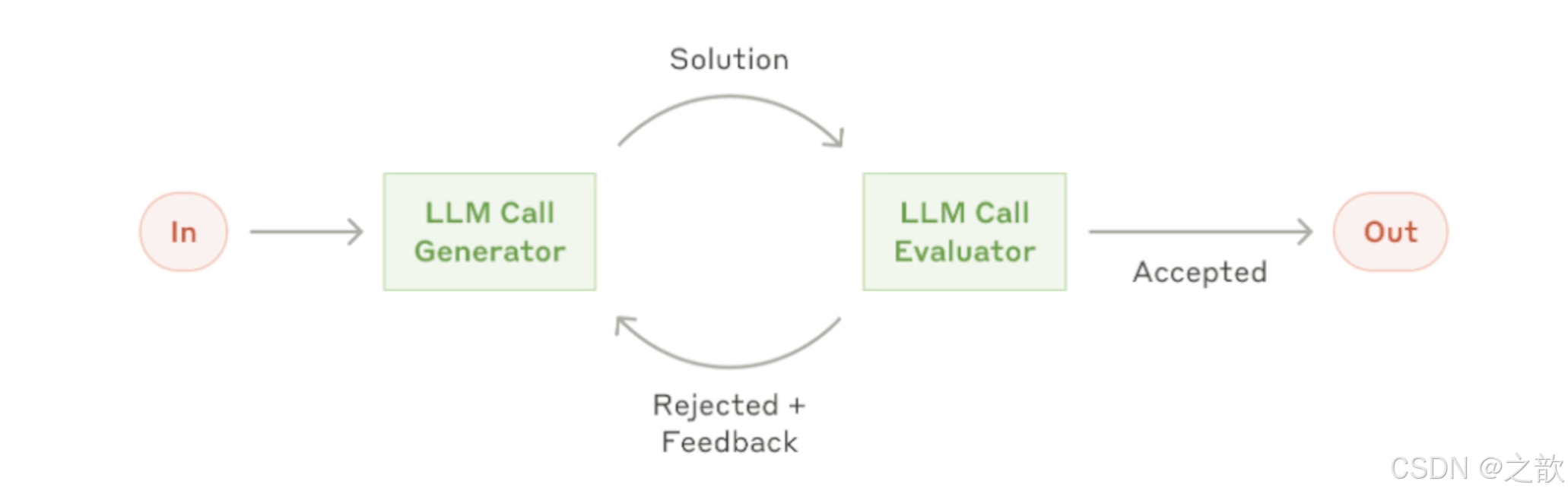

模型的评估

- 可以测试大模型的幻觉反应(在系列课详细讲解)

-

可观察性

- 它把Al运行时的大量关键指标暴露出来,可以提供Spring Boot actuctor进行观测(在系列课详细讲解)

agent应用

springai 提供了5种agent模式的示例

-

Routing - This pattern enables intelligent routing of inputs to specialized handlers based on classification of the user request and context.

-

Orchestrator Workers - This pattern is a flexible approach for handling complex tasks that require dynamic task decomposition and specialized processing

-

Chaining - The pattern decomposes complex tasks into a sequence of steps, where each LLM call processes the output of the previous one.

-

Parallelization - The pattern is useful for scenarios requiring parallel execution of LLM calls with automated output aggregation.

langchain4j vs springAl

| 对比项 | LangChain4j | Spring AI |

|---|---|---|

| 生态 | 不依赖Spring,需要单独集成Spring | Spring官方,和Spring无缝集成 |

| 诞生 | 更早,中国团队,受 LangChain 启发 | 稍晚,但是明显后来居上 |

| jdk | v0.35.0 前的版本支持jdk8,后支持jdk17 | 全版本jdk17 |

| 功能 | 没有mcp server,官方建议使用quarkus-mcp-server | 早期落后langchain4j,现在功能全面,并且生态活跃,开源贡献者众多 |

| 易用性 | 尚可,中文文档 | 易用,api优雅 |

| 最终 | 不需要spring选择! | 无脑选! |

大模型选型

-

自研(算法 c++ python 深度学习机器学习神经网络视觉处理),AI算法岗位

-

云端大模型不占用算力(推荐阿里的千问系列),token 计费, 功能完善成熟 。

-

开源的大模型(本地部署)购买算力

-

选型

-

自己构建选型-->评估流程

- 业务确定:(电商、医疗、教育)

- 样本准备:数据集样本选择题

- 任务定制:问答(利用多个大模型)

- 评估:人工评估

-

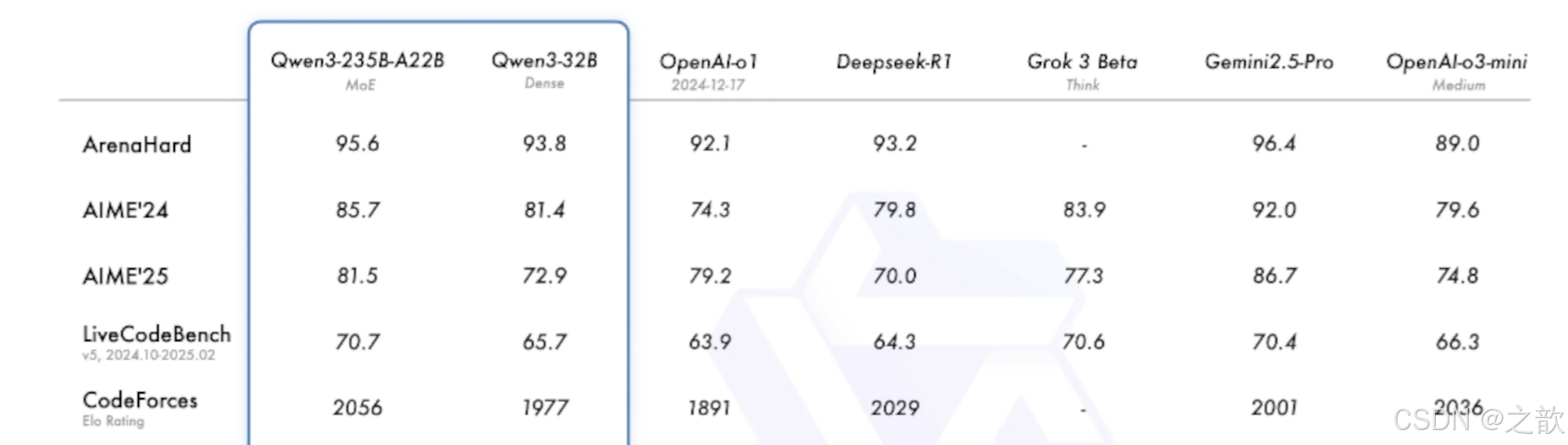

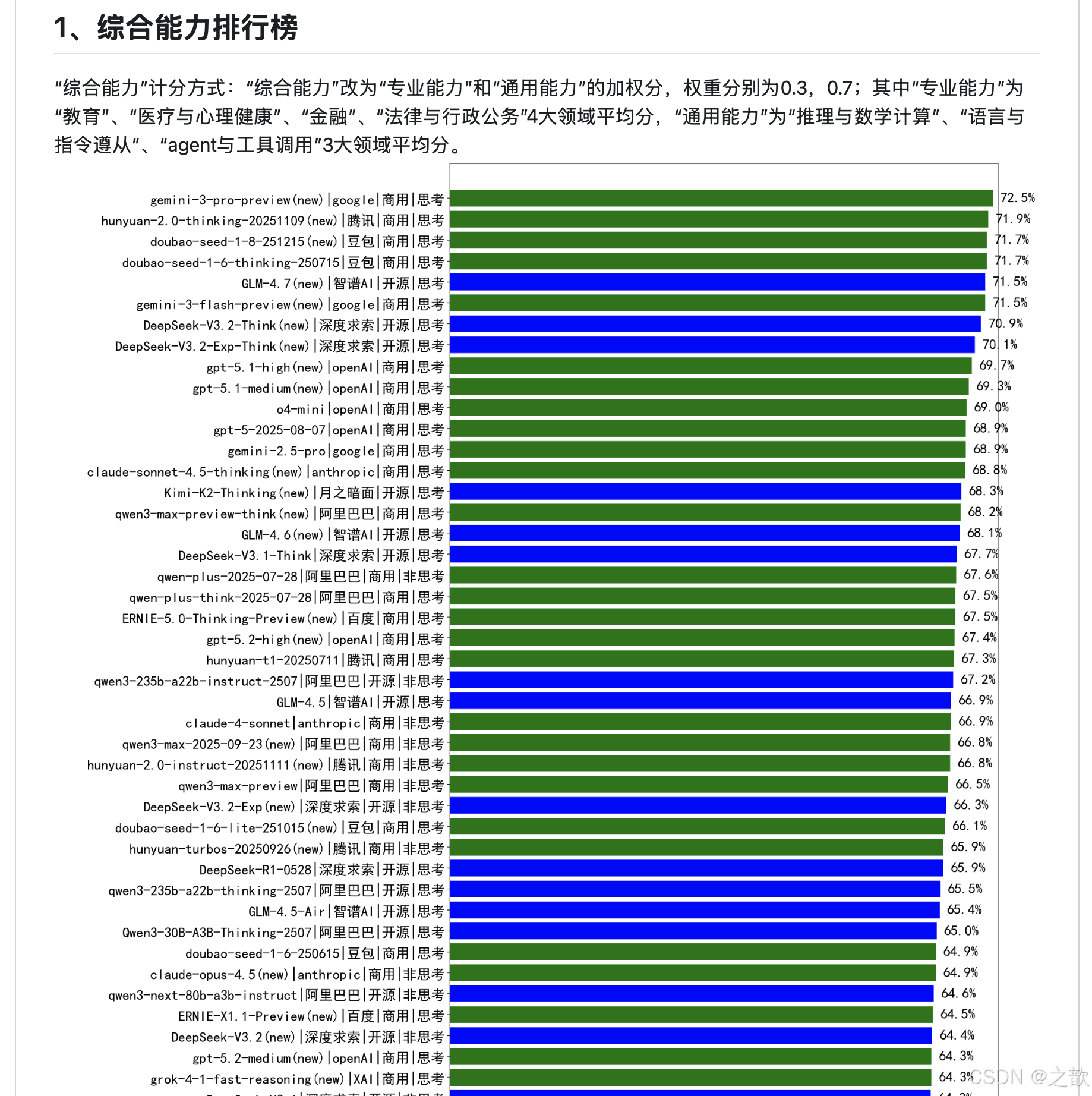

通用能力毕竟好的

- 2月份 deepseek 6710亿 671b =算力显存 H20 96G 140万;比 openai gpt4节省了40/1成本。

- 3月份阿里 qwq-32b(深度思考)32b=320亿媲美deepseek-r1 32G 比deepseek-r1 节省20/1

- 4月份阿里 qwen3(深度思考)2-3倍 itf7(qwen3-30b) 2350亿=235b 赶超了deepseek-r1 比deepseek-r1节省

- 5月 deepseek-r1-0528 6710亿 671b 性能都要要

-

对成本有要求:选择(qwen3-30b)

-

不差钱 deepseek-r1-0528 满血版本

-

大模型的排行榜单 。

https://github.com/jeinlee1991/chinese-llm-benchmark?tab=readme-ov-file#-#M5t>

接入阿里百炼

阿里自己的团队维护spring - ai 。但是也必须依赖spring-ai 。好处是扩展度更高,坏处是必须是 spring ai先出来, spring-ai-alibaba。延迟几天出来。

如果需要接入阿里的百炼平台,就必须用该组件

使用

1.申请api-key

在调用前,您需要开通模型服务并获取API Key,再配置API Key到环境变量。

2.依赖

java

<dependencies>

<!--deepseek-->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-deepseek</artifactId>

</dependency>

<!--百炼-->

<dependency>

<groupId>com.alibaba.cloud.ai</groupId>

<artifactId>spring-ai-alibaba-starter-dashscope</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>dashscope-sdk-java</artifactId>

<!-- 请将 'the-latest-version' 替换为最新版本号:https://mvnrepository.com/artifact/com.alibaba/dashscope-sdk-java -->

<version>2.20.6</version>

</dependency>

<!--ollama-->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>

<!--web-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!--单元测试-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

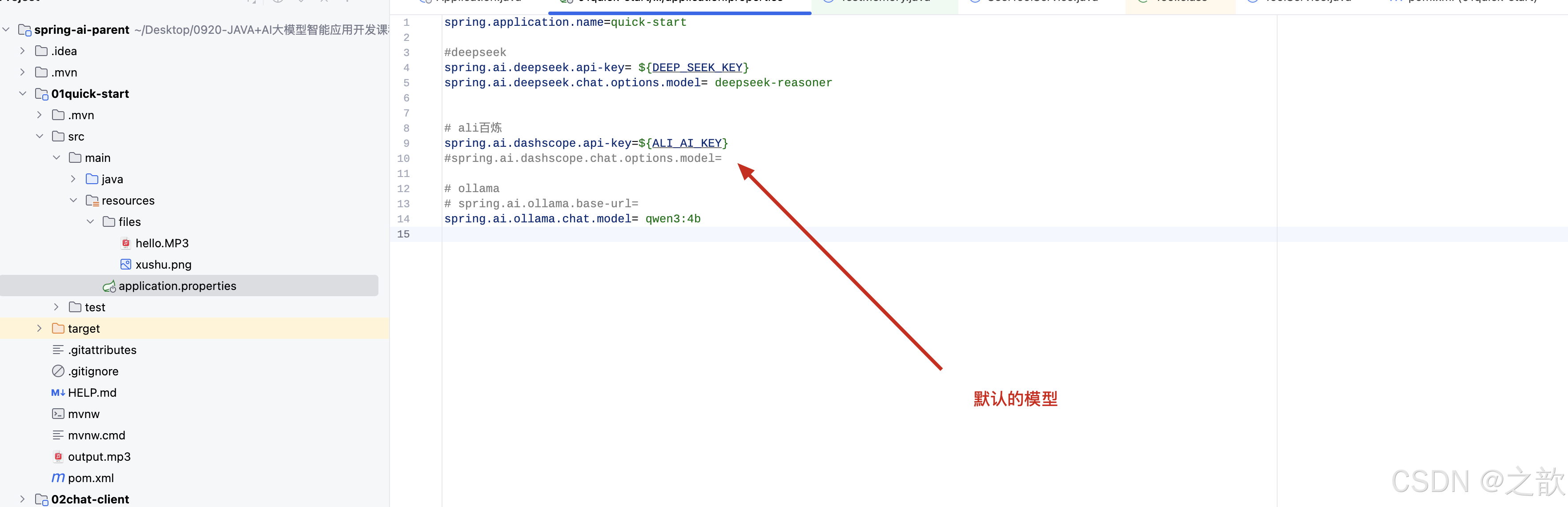

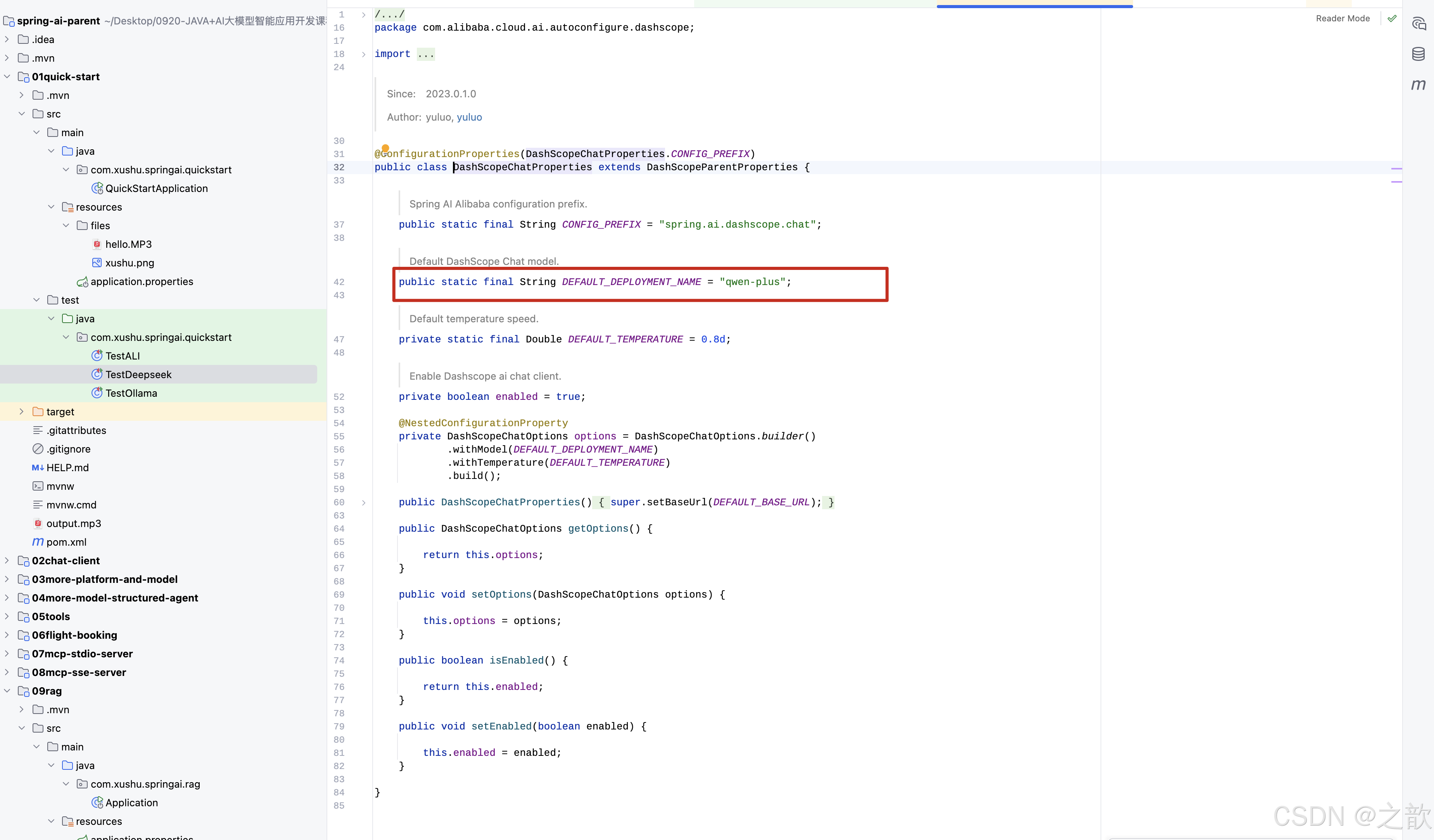

</dependencies>配置阿里,deepseek 配置

java

spring.application.name=quick-start

#deepseek

spring.ai.deepseek.api-key= sk-xxx

spring.ai.deepseek.chat.options.model= deepseek-reasoner

# ali百炼

spring.ai.dashscope.api-key=sk-xxx

#spring.ai.dashscope.chat.options.model=

# ollama

# spring.ai.ollama.base-url=

spring.ai.ollama.chat.model= qwen3:4b

默认模型 qwen-plus

接入deepseek

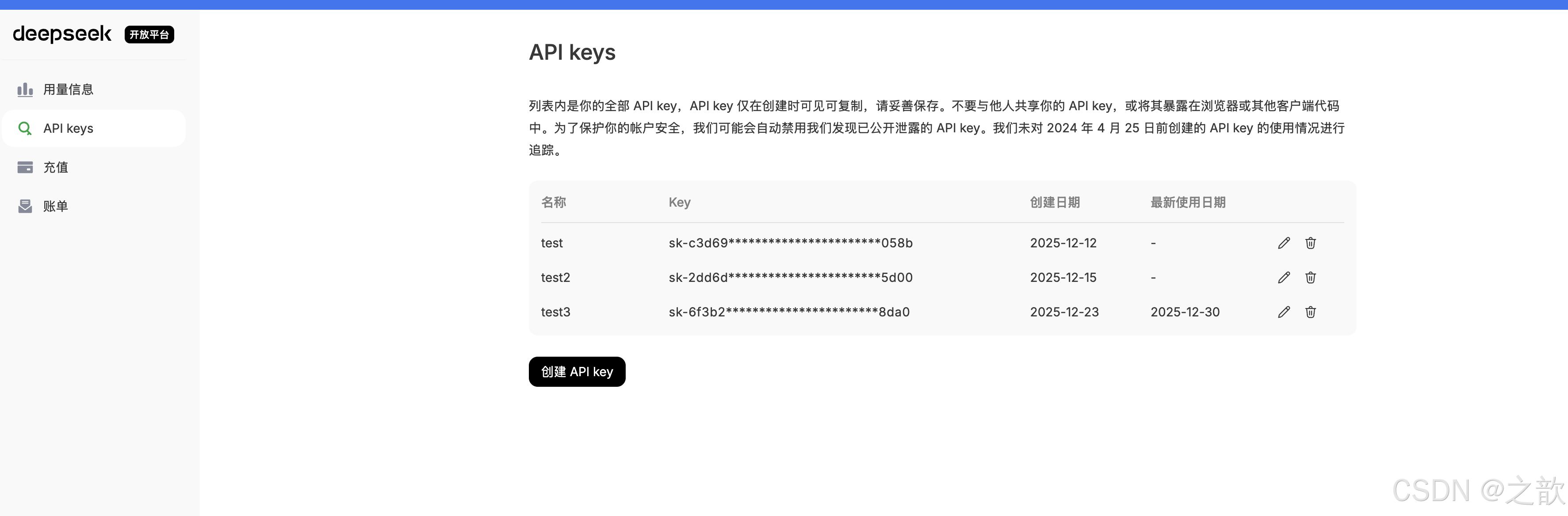

申请key

https://platform.deepseek.com/api_keys

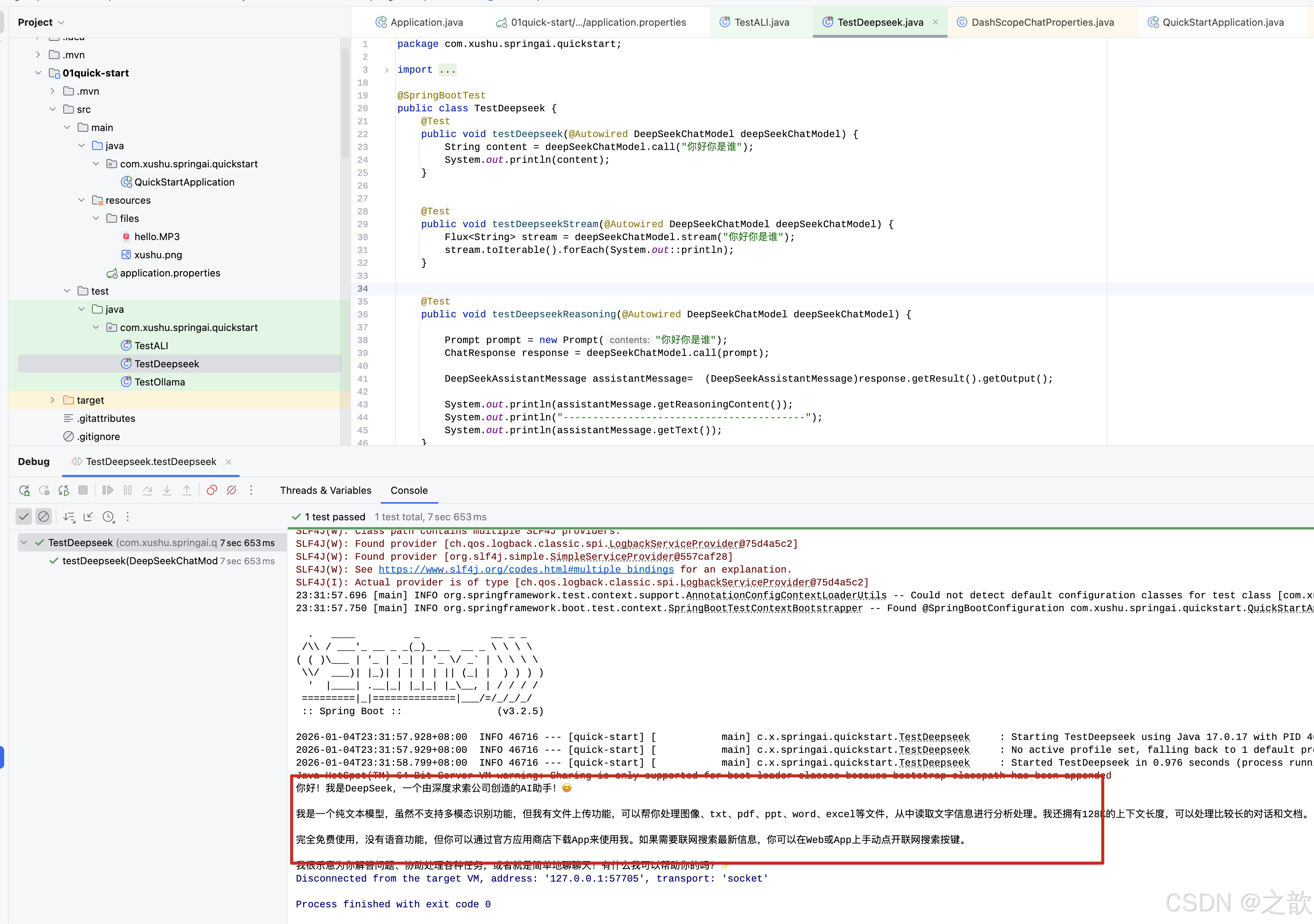

快速开始

java

package com.xushu.springai.quickstart;

import java.util.Arrays;

import org.junit.jupiter.api.Test;

import org.springframework.ai.chat.model.ChatResponse;

import org.springframework.ai.chat.prompt.Prompt;

import org.springframework.ai.deepseek.DeepSeekAssistantMessage;

import org.springframework.ai.deepseek.DeepSeekChatModel;

import org.springframework.ai.deepseek.DeepSeekChatOptions;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import reactor.core.publisher.Flux;

@SpringBootTest

public class TestDeepseek {

/**

* 测试 DeepSeekChatModel 的基本同步调用方式

*

* 该方法演示了 Spring AI 中 ChatModel 接口的 call(String) 方法的基本用法。

* call 方法接收一个字符串作为用户输入,返回 AI 模型的完整回复文本。

* 这是最简单的调用方式,适用于不需要额外配置的场景。

*

* 底层实现:DeepSeekChatModel 实现了 ChatModel 接口的 call(String) 方法,

* 内部会将字符串转换为 UserMessage,创建 Prompt,调用 call(Prompt) 方法,

* 最终返回 ChatResponse 中的文本内容。

*

* @param deepSeekChatModel 自动注入的 DeepSeekChatModel Bean,由 Spring AI 根据配置自动创建

* 配置来源:application.properties 中的 spring.ai.deepseek.* 配置项

*/

@Test

public void testDeepseek(@Autowired DeepSeekChatModel deepSeekChatModel) {

String content = deepSeekChatModel.call("你好你是谁");

System.out.println(content);

}

}

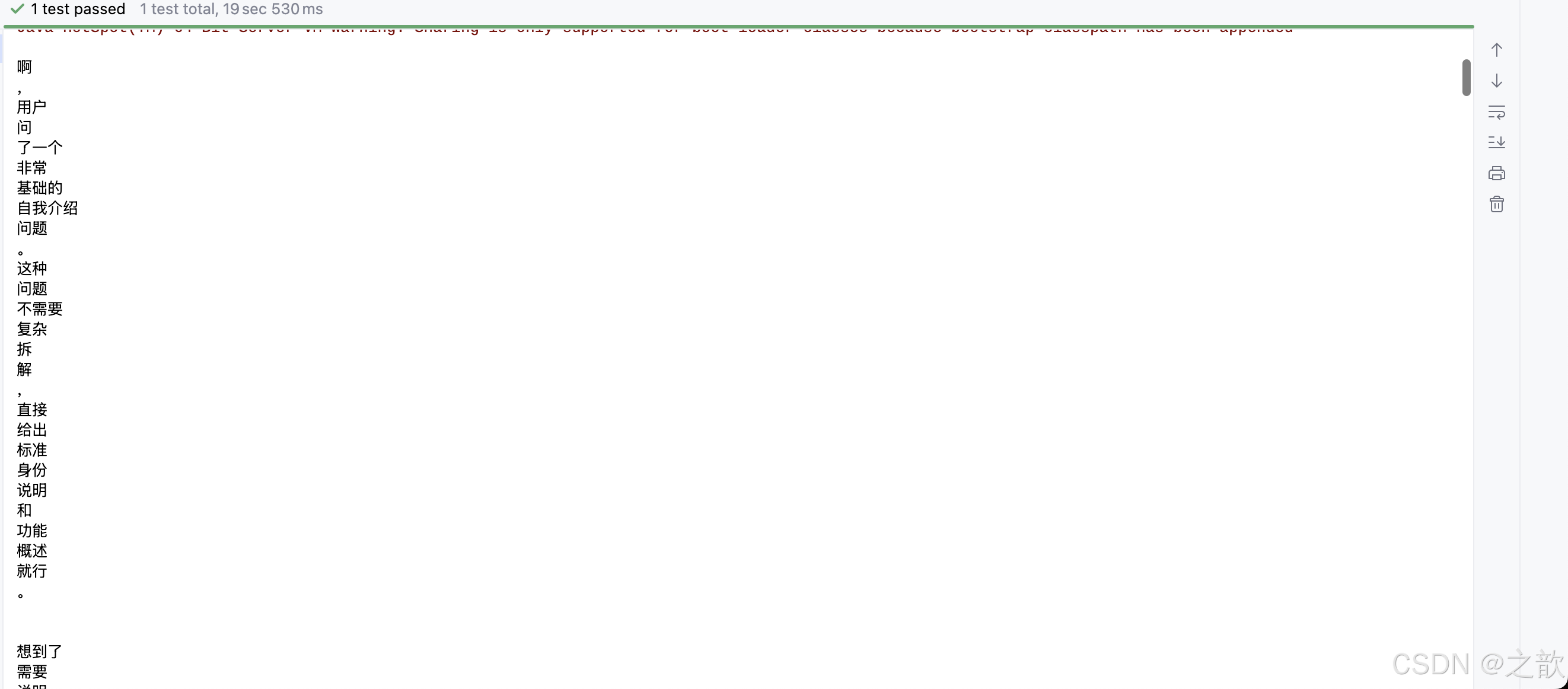

流式相应

java

package com.xushu.springai.quickstart;

import org.junit.jupiter.api.Test;

import org.springframework.ai.deepseek.DeepSeekChatModel;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import reactor.core.publisher.Flux;

@SpringBootTest

public class TestDeepseek_stream {

/**

* 测试 DeepSeekChatModel 的流式调用方式

*

* 该方法演示了 Spring AI 中 ChatModel 接口的 stream(String) 方法的用法。

* stream 方法返回一个 Flux<String>,这是响应式编程中的流式数据源。

* 与 call 方法不同,stream 方法会实时返回 AI 生成的文本片段,而不是等待完整回复。

*

* 底层实现:DeepSeekChatModel 实现了 ChatModel 接口的 stream(String) 方法,

* 内部会将字符串转换为 UserMessage,创建 Prompt,调用 stream(Prompt) 方法,

* 返回一个 Flux<ChatResponse>,然后提取每个响应中的文本片段。

*

* 使用场景:适用于需要实时显示 AI 回复的场景,如聊天界面、流式输出等。

*

* @param deepSeekChatModel 自动注入的 DeepSeekChatModel Bean

*/

@Test

public void testDeepseekStream(@Autowired DeepSeekChatModel deepSeekChatModel) {

Flux<String> stream = deepSeekChatModel.stream("你好你是谁");

stream.toIterable().forEach(System.out::println);

}

}options配置选项

AI 模型 Temperature 参数说明

数值越高更有创造性热情热情

- 数值越低保守

- 0-2 浮点数值

- 也可以通过提示词降低他的主观臆想:

- 只引用可靠来源中的信息,不做任何假设或扩展描述。

- 请只基于已知事实回答,不要主观臆想或添加额外内容。

- 请简明、客观地给出答案,不要进行修饰或补充未经请求的信息。

概述

Temperature 参数控制 AI 模型生成文本的随机性和创造性。不同的 temperature 值适用于不同的业务场景,影响模型的输出风格。

Temperature 参数范围与业务场景对照表

| Temperature 范围 | 建议业务场景 | 输出风格 | 说明/应用举例 |

|---|---|---|---|

| 0.0 ~ 0.2 | 严谨问答、代码补全、数学解题 | 严格、确定性、标准化 | 法律/金融问答、API 响应模板、考试试卷等 |

| 0.3 ~ 0.6 | 聊天机器人、日常摘要、辅助写作 | 略有变化、相对稳定 | 公众号摘要、一般对话、邮件生成等 |

| 0.7 ~ 1.0 | 内容创作、广告文案、标题生成 | 丰富、创造性、灵活 | 诗歌创作、短文案、趣味对话、产品描述等 |

| 1.1 ~ 1.5 | 头脑风暴式、灵感碰撞场景 | 高度想象力、极富变化 | 故事创作、奇思妙想推荐、多样化内容 |

详细说明

1. Temperature: 0.0 ~ 0.2

特点:

- 输出严格、确定性高

- 适合需要准确性和一致性的场景

- 模型倾向于选择概率最高的 token

适用场景:

- ✅ 法律咨询问答

- ✅ 金融数据分析

- ✅ 代码自动补全

- ✅ 数学问题求解

- ✅ API 响应模板生成

- ✅ 考试题目生成

示例:

java

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.temperature(0.1) // 低温度,确保输出准确

.build();2. Temperature: 0.3 ~ 0.6

特点:

- 输出略有变化,但相对稳定

- 在准确性和创造性之间取得平衡

- 适合日常交互场景

适用场景:

- ✅ 智能客服聊天机器人

- ✅ 文章摘要生成

- ✅ 邮件自动生成

- ✅ 公众号内容摘要

- ✅ 一般性对话交互

示例:

java

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.temperature(0.5) // 中等温度,平衡准确性和创造性

.build();3. Temperature: 0.7 ~ 1.0

特点:

- 输出丰富、具有创造性

- 灵活多变,适合内容创作

- 在保持合理性的同时增加多样性

适用场景:

- ✅ 诗歌创作

- ✅ 广告文案撰写

- ✅ 文章标题生成

- ✅ 产品描述优化

- ✅ 趣味对话生成

- ✅ 短文案创作

示例:

java

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.temperature(0.8) // 较高温度,增强创造性

.build();4. Temperature: 1.1 ~ 1.5

特点:

- 高度想象力,极富变化

- 输出可能偏离常规,但极具创意

- 适合需要突破性思维的场景

适用场景:

- ✅ 故事创作

- ✅ 头脑风暴

- ✅ 创意灵感碰撞

- ✅ 奇思妙想推荐

- ✅ 多样化内容生成

注意事项:

⚠️ 过高的 temperature 可能导致输出不够准确或偏离主题,需要根据具体场景谨慎使用。

示例:

java

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.temperature(1.2) // 高温度,最大化创造性

.build();在 Spring AI 中的使用

基本用法

java

@Test

public void testChatOptions(@Autowired DeepSeekChatModel chatModel) {

// 创建配置选项

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.model("deepseek-chat")

.temperature(0.8) // 设置 temperature 参数

.build();

// 创建 Prompt 并传入选项

Prompt prompt = new Prompt("请写一句五言绝句诗描述清晨的景色。", options);

// 调用模型

ChatResponse res = chatModel.call(prompt);

System.out.println(res.getResult().getOutput().getText());

}不同场景的配置建议

java

// 场景1:严谨问答(低温度)

DeepSeekChatOptions strictOptions = DeepSeekChatOptions.builder()

.temperature(0.1)

.build();

// 场景2:日常对话(中温度)

DeepSeekChatOptions chatOptions = DeepSeekChatOptions.builder()

.temperature(0.5)

.build();

// 场景3:内容创作(高温度)

DeepSeekChatOptions creativeOptions = DeepSeekChatOptions.builder()

.temperature(0.9)

.build();

// 场景4:头脑风暴(极高温度)

DeepSeekChatOptions brainstormingOptions = DeepSeekChatOptions.builder()

.temperature(1.3)

.build();选择建议

- 需要准确性 → 选择 0.0 ~ 0.2

- 需要平衡 → 选择 0.3 ~ 0.6

- 需要创造性 → 选择 0.7 ~ 1.0

- 需要突破性思维 → 选择 1.1 ~ 1.5

注意事项

- ⚠️ Temperature 值过高可能导致输出不稳定或偏离主题

- ⚠️ Temperature 值过低可能导致输出过于机械和重复

- 💡 建议根据实际业务需求进行调优,找到最佳平衡点

- 💡 不同模型对 temperature 的敏感度可能不同,需要实际测试

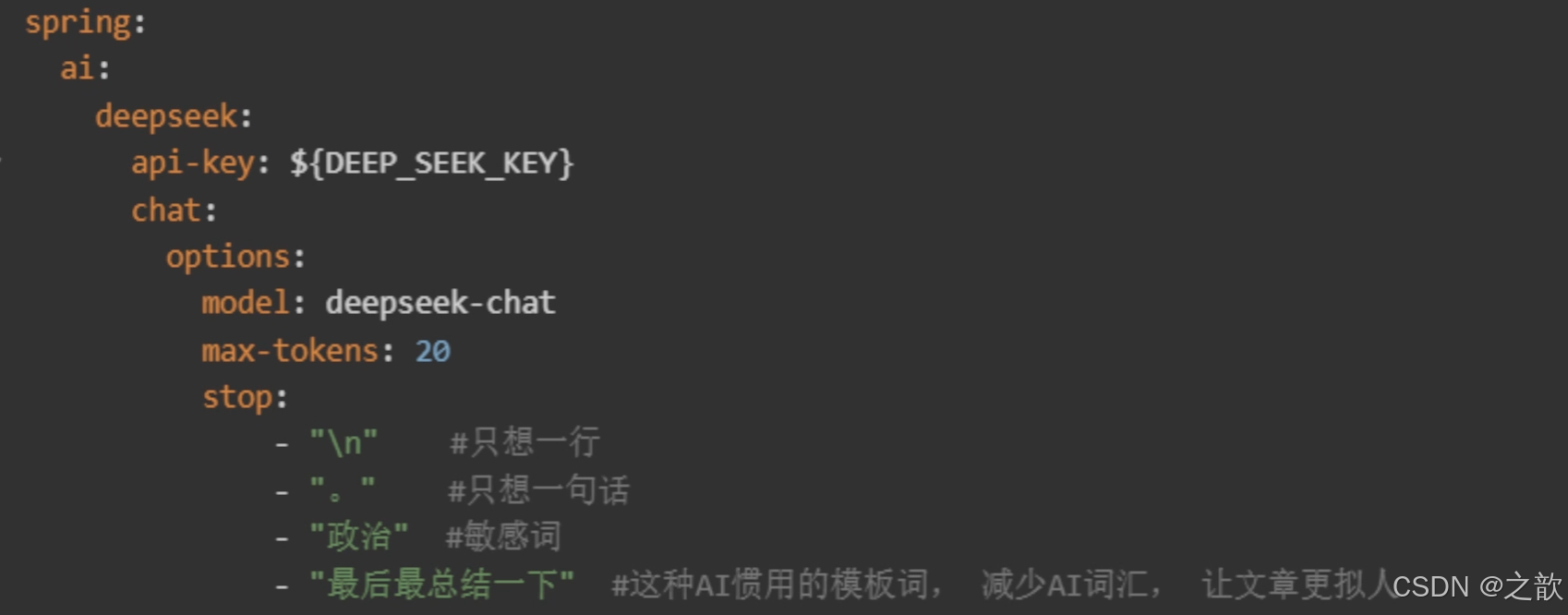

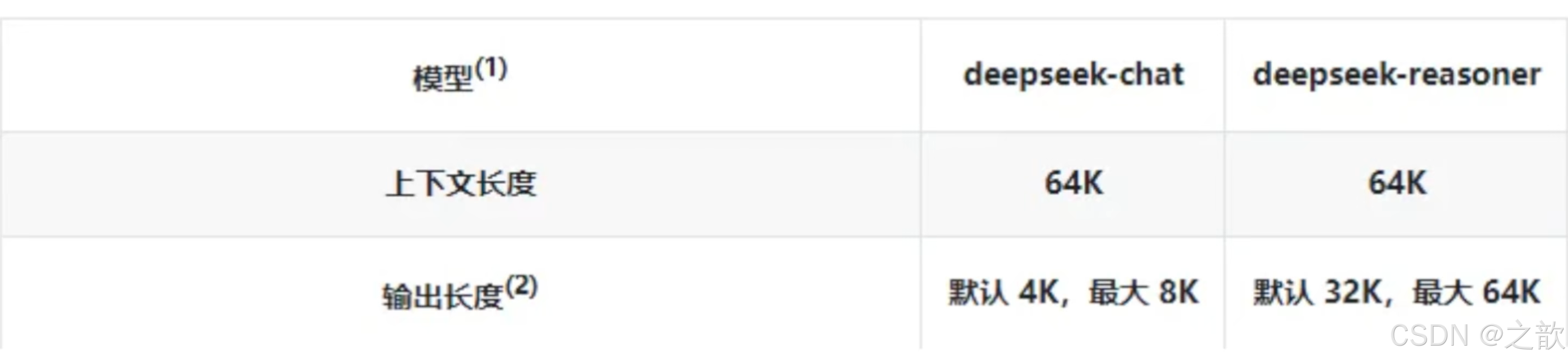

maxTokens

- 默认

- maxTokens:限制AI模型生成的最人token数(近似理解为字数上限)。

- 需要简洁回复、打分、列表、短摘要等,建议小值(如10~50)。

- 防止用户跑长对话导致无关内容或花费过多token费用。

- 如果遇到生成内容经常被截断,可以适当配置更大maxTokens。

stop

- 停止词列表,当生成的内容包含这些词时,停止生成

- 截断你不想输出的内容比如:

java

/**

* 测试 DeepSeekChatOptions 配置选项的使用

*

* 该方法演示了如何使用 DeepSeekChatOptions 来配置模型的各种参数。

* DeepSeekChatOptions 是 DeepSeek 特有的配置类,继承自 ChatOptions,

* 提供了 DeepSeek API 特有的配置选项。

*

* 配置参数说明:

* - model(String):指定使用的模型名称,如 "deepseek-chat" 或 "deepseek-reasoner"

* - maxTokens(Integer):限制生成的最大 token 数量(注释掉的代码)

* - stop(List<String>):停止词列表,当生成的内容包含这些词时,停止生成

* - temperature(Double):控制生成的随机性,范围通常为 0.0-2.0

* 值越高,输出越随机和创造性;值越低,输出越确定和保守

*

* 底层实现:

* - DeepSeekChatOptions.builder() 使用建造者模式创建配置对象

* - Prompt 构造函数可以接收 ChatOptions 作为第二个参数

* - 这些选项会被传递给 DeepSeek API,影响模型的生成行为

*

* 使用场景:适用于需要精确控制模型生成行为的场景,如内容创作、代码生成等。

*

* @param chatModel 自动注入的 DeepSeekChatModel Bean

*/

@Test

public void testChatOptions(@Autowired

DeepSeekChatModel chatModel) {

DeepSeekChatOptions options = DeepSeekChatOptions.builder()

.model("deepseek-chat")

//.maxTokens(5) // 字数

.stop(Arrays.asList(","))

.temperature(2.0).build();

Prompt prompt = new Prompt("请写一句诗描述清晨。", options);

ChatResponse res = chatModel.call(prompt);

System.out.println(res.getResult().getOutput().getText());

}流式输出

java

/**

* 测试 DeepSeekChatModel 的流式调用方式

*

* 该方法演示了 Spring AI 中 ChatModel 接口的 stream(String) 方法的用法。

* stream 方法返回一个 Flux<String>,这是响应式编程中的流式数据源。

* 与 call 方法不同,stream 方法会实时返回 AI 生成的文本片段,而不是等待完整回复。

*

* 底层实现:DeepSeekChatModel 实现了 ChatModel 接口的 stream(String) 方法,

* 内部会将字符串转换为 UserMessage,创建 Prompt,调用 stream(Prompt) 方法,

* 返回一个 Flux<ChatResponse>,然后提取每个响应中的文本片段。

*

* 使用场景:适用于需要实时显示 AI 回复的场景,如聊天界面、流式输出等。

*

* @param deepSeekChatModel 自动注入的 DeepSeekChatModel Bean

*/

@Test

public void testDeepseekStream(@Autowired DeepSeekChatModel deepSeekChatModel) {

Flux<String> stream = deepSeekChatModel.stream("你好你是谁");

stream.toIterable().forEach(System.out::println);

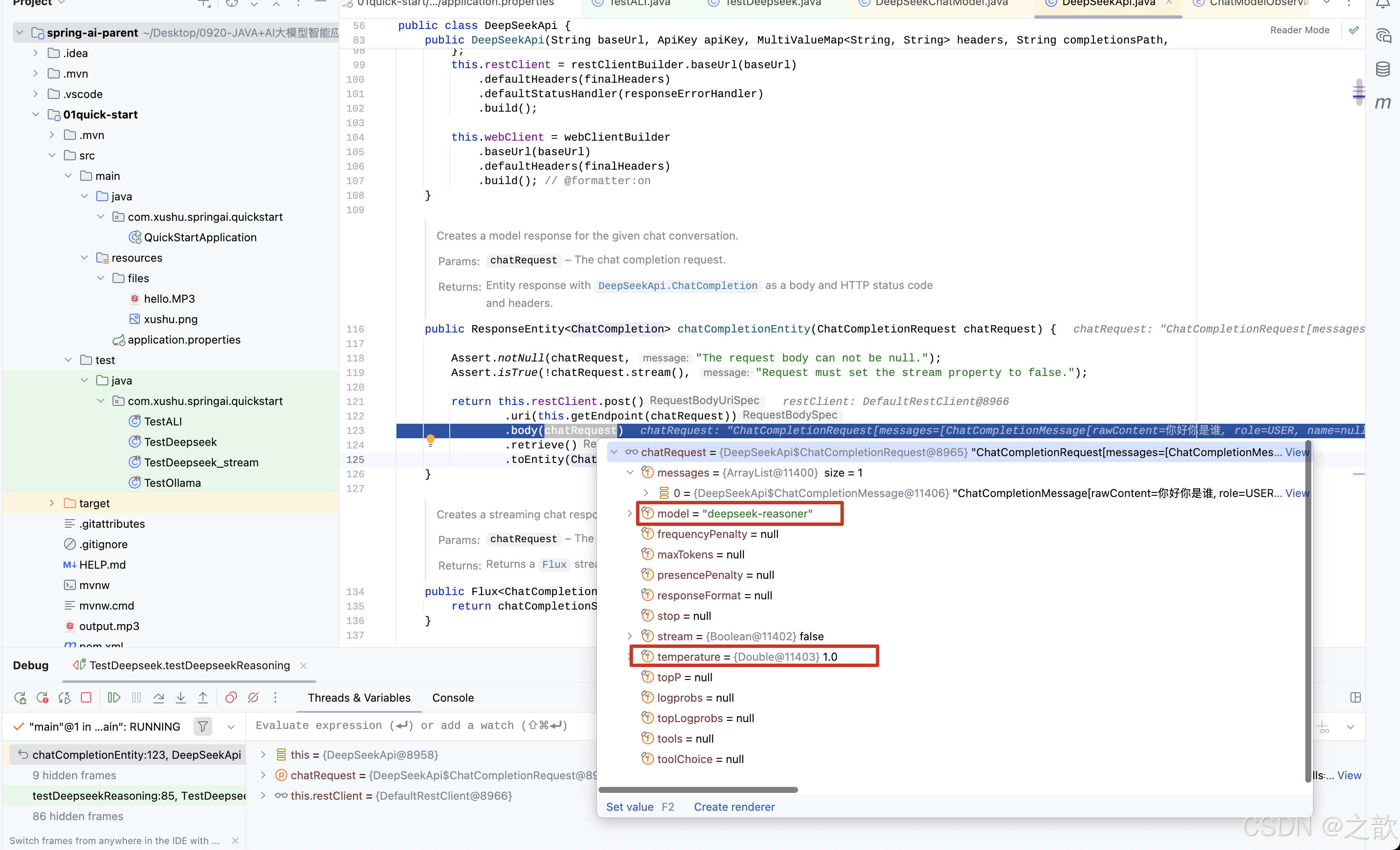

}获取模型思维链的过程

java

/**

* 测试 DeepSeek 推理模型的推理过程获取

*

* 该方法演示了如何使用 DeepSeek 的推理模型(deepseek-reasoner)获取推理过程。

* DeepSeek 推理模型会提供两个部分的内容:

* 1. reasoningContent:模型的内部推理过程(思考过程)

* 2. text:模型的最终回复文本

*

* 底层实现:

* - 使用 Prompt 对象包装用户输入,可以传入额外的 ChatOptions

* - call(Prompt) 方法返回 ChatResponse,包含完整的响应信息

* - ChatResponse.getResult().getOutput() 返回 AssistantMessage

* - DeepSeekAssistantMessage 是 DeepSeek 特有的消息类型,扩展了标准 AssistantMessage

* - getReasoningContent() 返回推理过程文本(仅推理模型支持)

* - getText() 返回最终回复文本

*

* 注意:只有使用 deepseek-reasoner 模型时,getReasoningContent() 才会有内容。

* 使用 deepseek-chat 模型时,该方法可能返回 null 或空字符串。

*

* @param deepSeekChatModel 自动注入的 DeepSeekChatModel Bean,需配置为 deepseek-reasoner 模型

*/

@Test

public void testDeepseekReasoning(@Autowired DeepSeekChatModel deepSeekChatModel) {

Prompt prompt = new Prompt("你好你是谁");

ChatResponse response = deepSeekChatModel.call(prompt);

DeepSeekAssistantMessage assistantMessage= (DeepSeekAssistantMessage)response.getResult().getOutput();

System.out.println(assistantMessage.getReasoningContent());

System.out.println("-----------------------------------------");

System.out.println(assistantMessage.getText());

}以流式返回

java

/**

* 测试 DeepSeek 推理模型的流式推理过程获取

*

* 该方法演示了如何以流式方式获取 DeepSeek 推理模型的推理过程和最终回复。

* 与 testDeepseekReasoning 不同,该方法使用 stream 方法,可以实时获取推理过程的片段。

*

* 底层实现:

* - stream(Prompt) 方法返回 Flux<ChatResponse>,每个 ChatResponse 代表一个响应片段

* - 每个 ChatResponse 都包含一个 DeepSeekAssistantMessage

* - 在流式输出中,推理内容和最终文本会分阶段返回

* - 第一次遍历获取所有推理过程的片段

* - 第二次遍历获取所有最终回复的片段

*

* 注意:代码中存在一个潜在问题,stream.toIterable() 会消费 Flux,第二次调用时

* Flux 已经被消费完毕,可能无法再次获取数据。正确的做法应该是只遍历一次,

* 在遍历过程中同时处理推理内容和最终文本。

*

* 使用场景:适用于需要实时显示推理过程和最终回复的场景,如调试、教学演示等。

*

* @param deepSeekChatModel 自动注入的 DeepSeekChatModel Bean,需配置为 deepseek-reasoner 模型

*/

@Test

public void testDeepseekStreamReasoning(@Autowired DeepSeekChatModel deepSeekChatModel) {

Flux<ChatResponse> stream = deepSeekChatModel.stream(new Prompt("你好你是谁"));

stream.toIterable().forEach(chatResponse -> {

DeepSeekAssistantMessage assistantMessage= (DeepSeekAssistantMessage)chatResponse.getResult().getOutput();

System.out.println(assistantMessage.getReasoningContent());

});

System.out.println("-----------------------------------------");

stream.toIterable().forEach(chatResponse -> {

DeepSeekAssistantMessage assistantMessage= (DeepSeekAssistantMessage)chatResponse.getResult().getOutput();

System.out.println(assistantMessage.getText());

});

}输出:

deepseek请求原理

底层还是通过http的方式访问大模型 。

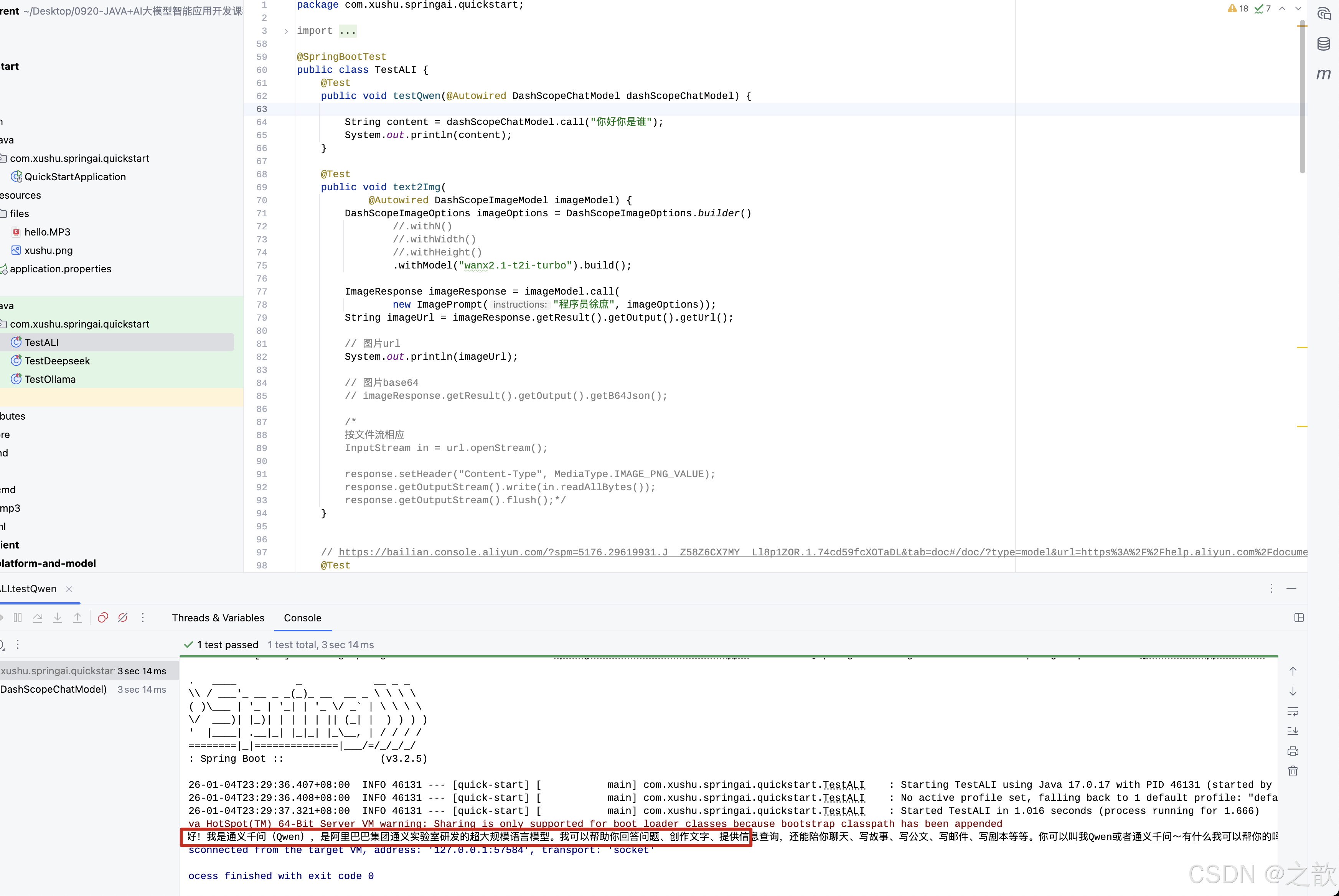

接入AlibabaAi阿里百炼

阿里自己的团队维护spring-ai-alibaba。 但是也必须依赖spring-ai。 好处是扩展度更高,坏处是必须是 springai先出来,spring-ai-alibaba。延迟几天出来。

-

添加pom.xml

java

<!--百炼-->

<dependency>

<groupId>com.alibaba.cloud.ai</groupId>

<artifactId>spring-ai-alibaba-starter-dashscope</artifactId>

</dependency>- 配置application.properties

java

# ali百炼

spring.ai.dashscope.api-key=sk-xxx # 百炼申请的key

#spring.ai.dashscope.chat.options.model=1. 文本生成图片

java

/**

* 测试文本生成图片(Text-to-Image)功能

*

* 功能说明:

* - 使用阿里云通义万相(Wanx)模型将文本描述转换为图片

* - 支持通过文本提示词生成对应的图片,返回图片的 URL 或 Base64 编码

*

* 实现逻辑:

* 1. 构建 DashScopeImageOptions 配置对象,指定使用的图片生成模型(wanx2.1-t2i-turbo)

* - withN(): 可设置生成图片的数量(注释掉表示使用默认值)

* - withWidth()/withHeight(): 可设置图片的宽度和高度(注释掉表示使用默认值)

* 2. 创建 ImagePrompt 对象,包含文本提示词和配置选项

* 3. 调用 imageModel.call() 方法,将提示词发送到 DashScope API 进行图片生成

* 4. 从响应中获取生成的图片 URL(存储在 OSS 上)

* 5. 也可以通过 getB64Json() 获取 Base64 编码的图片数据(适用于小图片)

*

* 使用场景:

* - 根据文本描述生成图片

* - 图片 URL 可用于直接展示或下载

* - Base64 编码适用于需要内嵌图片的场景

*

* @param imageModel 阿里云 DashScope 图片生成模型,由 Spring 容器自动注入

*/

@Test

public void text2Img(

@Autowired DashScopeImageModel imageModel) {

DashScopeImageOptions imageOptions = DashScopeImageOptions.builder()

//.withN()

//.withWidth()

//.withHeight()

.withModel("wanx2.1-t2i-turbo").build();

ImageResponse imageResponse = imageModel.call(

new ImagePrompt("程序员徐庶", imageOptions));

String imageUrl = imageResponse.getResult().getOutput().getUrl();

// 图片url

System.out.println(imageUrl);

// 图片base64

// imageResponse.getResult().getOutput().getB64Json();

/*

按文件流相应

InputStream in = url.openStream();

response.setHeader("Content-Type", MediaType.IMAGE_PNG_VALUE);

response.getOutputStream().write(in.readAllBytes());

response.getOutputStream().flush();*/

}生成的图

2. 文本转语音

java

/**

* 测试文本转语音(Text-to-Speech, TTS)功能

*

* 功能说明:

* - 使用阿里云 CosyVoice 模型将文本转换为自然流畅的语音

* - 支持多种音色选择,可配置语速、响应格式等参数

* - 生成的音频数据以 ByteBuffer 形式返回,可保存为音频文件

*

* 实现逻辑:

* 1. 构建 DashScopeSpeechSynthesisOptions 配置对象:

* - voice("longyingtian"): 指定音色,longyingtian 是其中一个可选音色

* - speed(): 可设置语速(注释掉表示使用默认语速)

* - model("cosyvoice-v2"): 指定使用的语音合成模型

* - responseFormat(): 可设置响应格式,如 MP3(注释掉表示使用默认格式)

* 2. 创建 SpeechSynthesisPrompt 对象,包含要转换的文本和配置选项

* 3. 调用 speechSynthesisModel.call() 方法,将文本发送到 DashScope API 进行语音合成

* 4. 从响应中获取音频数据(ByteBuffer 格式)

* 5. 将音频数据写入文件系统,保存为 MP3 文件

*

* 使用场景:

* - 语音播报、语音助手

* - 有声读物生成

* - 多语言语音合成

*

* 参考文档:

* https://bailian.console.aliyun.com/?spm=5176.29619931.J__Z58Z6CX7MY__Ll8p1ZOR.1.74cd59fcXOTaDL&tab=doc#/doc/?type=model&url=https%3A%2F%2Fhelp.aliyun.com%2Fdocument_detail%2F2842586.html&renderType=iframe

*

* @param speechSynthesisModel 阿里云 DashScope 语音合成模型,由 Spring 容器自动注入

* @throws IOException 当文件写入失败时抛出

*/

// https://bailian.console.aliyun.com/?spm=5176.29619931.J__Z58Z6CX7MY__Ll8p1ZOR.1.74cd59fcXOTaDL&tab=doc#/doc/?type=model&url=https%3A%2F%2Fhelp.aliyun.com%2Fdocument_detail%2F2842586.html&renderType=iframe

@Test

public void testText2Audio(@Autowired DashScopeSpeechSynthesisModel speechSynthesisModel) throws IOException {

DashScopeSpeechSynthesisOptions options = DashScopeSpeechSynthesisOptions.builder()

.voice("longyingtian") // 人声

//.speed() // 语速

.model("cosyvoice-v2") // 模型

//.responseFormat(DashScopeSpeechSynthesisApi.ResponseFormat.MP3)

.build();

SpeechSynthesisResponse response = speechSynthesisModel.call(

new SpeechSynthesisPrompt("大家好, 我是人帅活好的徐庶。",options)

);

File file = new File( System.getProperty("user.dir") + "/output.mp3");

try (FileOutputStream fos = new FileOutputStream(file)) {

ByteBuffer byteBuffer = response.getResult().getOutput().getAudio();

fos.write(byteBuffer.array());

}

catch (IOException e) {

throw new IOException(e.getMessage());

}

}3. 语音转文本

java

/**

* 测试语音转文本(Speech-to-Text, STT)功能

*

* 功能说明:

* - 使用阿里云 Paraformer 模型将音频文件转换为文本

* - 支持多种音频格式(WAV、MP3、FLAC 等)

* - 可以从 URL 资源或本地文件读取音频进行转写

*

* 实现逻辑:

* 1. 构建 DashScopeAudioTranscriptionOptions 配置对象:

* - withModel(): 可指定使用的语音识别模型(注释掉表示使用默认模型)

* 2. 创建 AudioTranscriptionPrompt 对象:

* - 使用 UrlResource 从 URL 加载音频资源(也可以使用 ClassPathResource 加载本地资源)

* - 传入配置选项

* 3. 调用 transcriptionModel.call() 方法,将音频发送到 DashScope API 进行语音识别

* 4. 从响应中获取识别出的文本内容并输出

*

* 使用场景:

* - 会议录音转文字

* - 语音助手识别用户指令

* - 音频内容索引和搜索

* - 多语言语音识别

*

* @param transcriptionModel 阿里云 DashScope 音频转文本模型,由 Spring 容器自动注入

* @throws MalformedURLException 当音频 URL 格式错误时抛出

*/

@Test

public void testAudio2Text(

@Autowired

DashScopeAudioTranscriptionModel transcriptionModel

) throws MalformedURLException {

DashScopeAudioTranscriptionOptions transcriptionOptions = DashScopeAudioTranscriptionOptions.builder()

//.withModel() 模型

.build();

AudioTranscriptionPrompt prompt = new AudioTranscriptionPrompt(

new UrlResource(AUDIO_RESOURCES_URL),

transcriptionOptions

);

AudioTranscriptionResponse response = transcriptionModel.call(

prompt

);

System.out.println(response.getResult().getOutput());

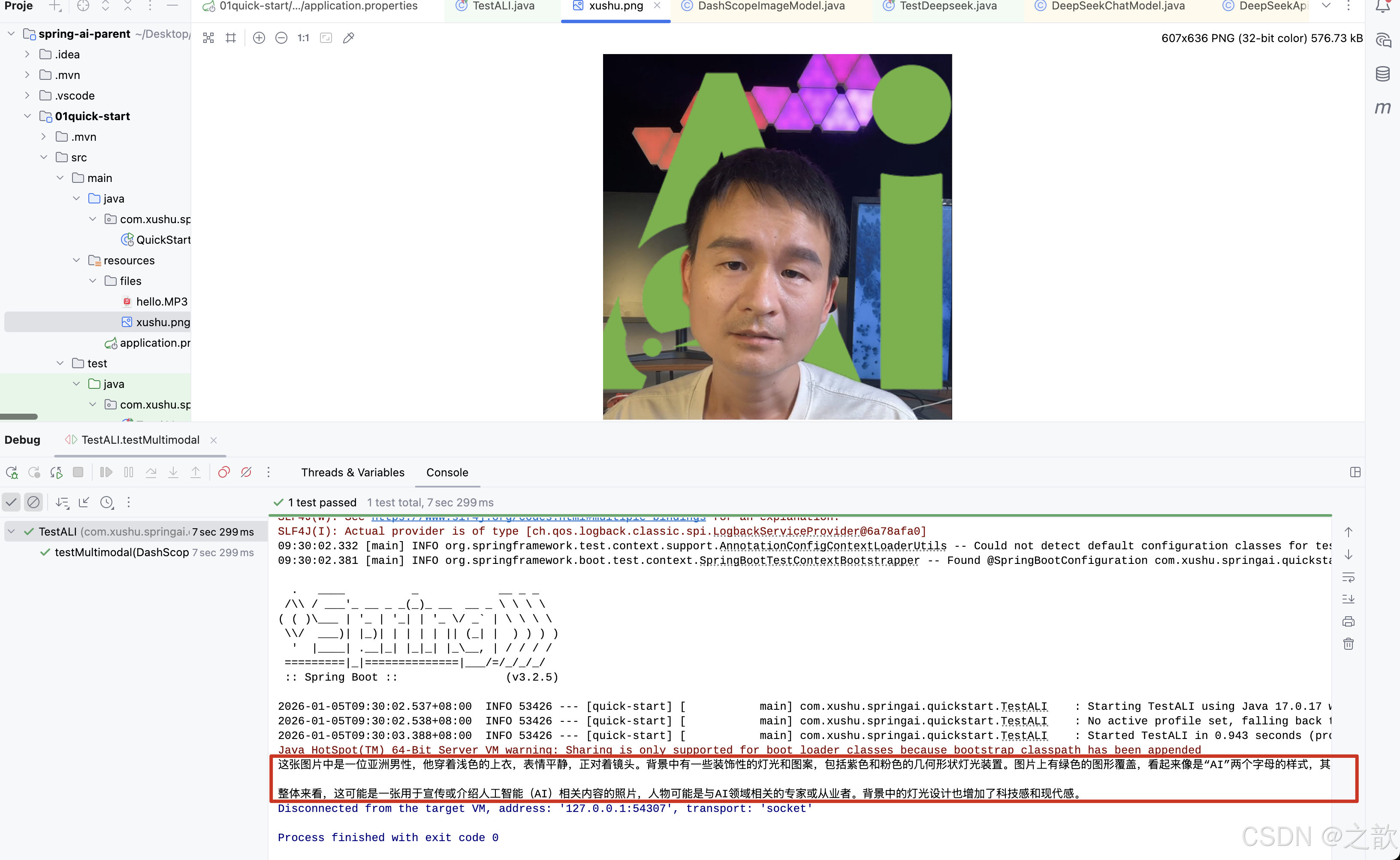

}4. 图片理解

java

/**

* 测试多模态(图片理解)功能

*

* 功能说明:

* - 使用通义千问视觉模型(Qwen-VL)实现图片理解能力

* - 支持图片识别、图片内容描述、图片问答等场景

* - 模型可以同时理解文本和图片内容,进行多模态交互

*

* 实现逻辑:

* 1. 从类路径加载图片资源(ClassPathResource)

* 2. 创建 Media 对象,指定媒体类型为图片(IMAGE_JPEG)和资源文件

* 3. 构建 DashScopeChatOptions 配置:

* - withMultiModel(true): 启用多模态能力,允许模型处理图片和文本

* - withModel("qwen-vl-max-latest"): 指定使用通义千问视觉模型的最新版本

* 4. 构建 Prompt 对象:

* - 使用 UserMessage.builder() 创建用户消息

* - media(media): 添加图片媒体内容

* - text("识别图片"): 添加文本指令,告诉模型要对图片做什么操作

* 5. 调用 dashScopeChatModel.call() 方法,将图片和文本一起发送到 DashScope API

* 6. 从响应中获取模型对图片的理解结果(文本描述)

*

* 使用场景:

* - 图片内容识别和描述

* - 图片问答(如"图片中有什么?"、"图片中的人在做什么?")

* - OCR 文字识别

* - 图片内容分析

*

* 支持的媒体格式:

* 音频:flac、mp3、mp4、mpeg、mpga、m4a、ogg、wav 或 webm

* 图片:jpg、png、gif 等常见图片格式

*

* @param dashScopeChatModel 阿里云 DashScope 聊天模型,由 Spring 容器自动注入

* @throws MalformedURLException 当资源 URL 格式错误时抛出

*/

@Test

public void testMultimodal(@Autowired DashScopeChatModel dashScopeChatModel

) throws MalformedURLException {

// flac、mp3、mp4、mpeg、mpga、m4a、ogg、wav 或 webm。

var audioFile = new ClassPathResource("/files/xushu.png");

Media media = new Media(MimeTypeUtils.IMAGE_JPEG, audioFile);

DashScopeChatOptions options = DashScopeChatOptions.builder()

.withMultiModel(true)

.withModel("qwen-vl-max-latest").build();

Prompt prompt= Prompt.builder().chatOptions(options)

.messages(UserMessage.builder().media(media)

.text("识别图片").build())

.build();

ChatResponse response = dashScopeChatModel.call(prompt);

System.out.println(response.getResult().getOutput().getText());

}图片 :

结果输出 :

5. 文本生成视频

java

/**

* 测试文本生成视频(Text-to-Video)功能

*

* 功能说明:

* - 使用阿里云通义万相(Wanx)视频生成模型将文本描述转换为视频

* - 支持根据文本提示词生成对应的视频内容

* - 视频生成是异步过程,需要等待处理完成后获取视频 URL

*

* 实现逻辑:

* 1. 创建 VideoSynthesis 对象,用于调用视频生成 API

* 2. 构建 VideoSynthesisParam 参数对象:

* - model("wanx2.1-t2v-turbo"): 指定使用的视频生成模型(turbo 版本,速度较快)

* - prompt("一只小猫在月光下奔跑"): 文本提示词,描述要生成的视频内容

* - size("1280*720"): 设置视频分辨率(宽*高),支持多种分辨率选项

* - apiKey(): 从环境变量获取 API Key(注意:这里直接使用环境变量,不是通过 Spring 注入)

* 3. 调用 vs.call() 方法,将参数发送到 DashScope API 进行视频生成

* - 视频生成是异步任务,可能需要较长时间

* - 方法会等待生成完成后返回结果

* 4. 从响应中获取生成的视频 URL(存储在 OSS 上)

*

* 注意事项:

* - 视频生成是耗时操作,可能需要等待较长时间

* - API Key 需要从环境变量 ALI_AI_KEY 中获取

* - 生成的视频 URL 有时效性,需要及时下载或使用

*

* 使用场景:

* - 根据文本描述生成短视频

* - 视频内容创作

* - 营销视频自动生成

*

* @throws ApiException 当 API 调用失败时抛出

* @throws NoApiKeyException 当未提供 API Key 时抛出

* @throws InputRequiredException 当必需参数缺失时抛出

*/

@Test

public void text2Video() throws ApiException, NoApiKeyException, InputRequiredException {

VideoSynthesis vs = new VideoSynthesis();

VideoSynthesisParam param =

VideoSynthesisParam.builder()

.model("wanx2.1-t2v-turbo")

.prompt("一只小猫在月光下奔跑")

.size("1280*720")

.apiKey(TestApiKey.ALI_AI_KEY)

.build();

System.out.println("please wait...");

VideoSynthesisResult result = vs.call(param);

System.out.println(result.getOutput().getVideoUrl());

}生成的视频

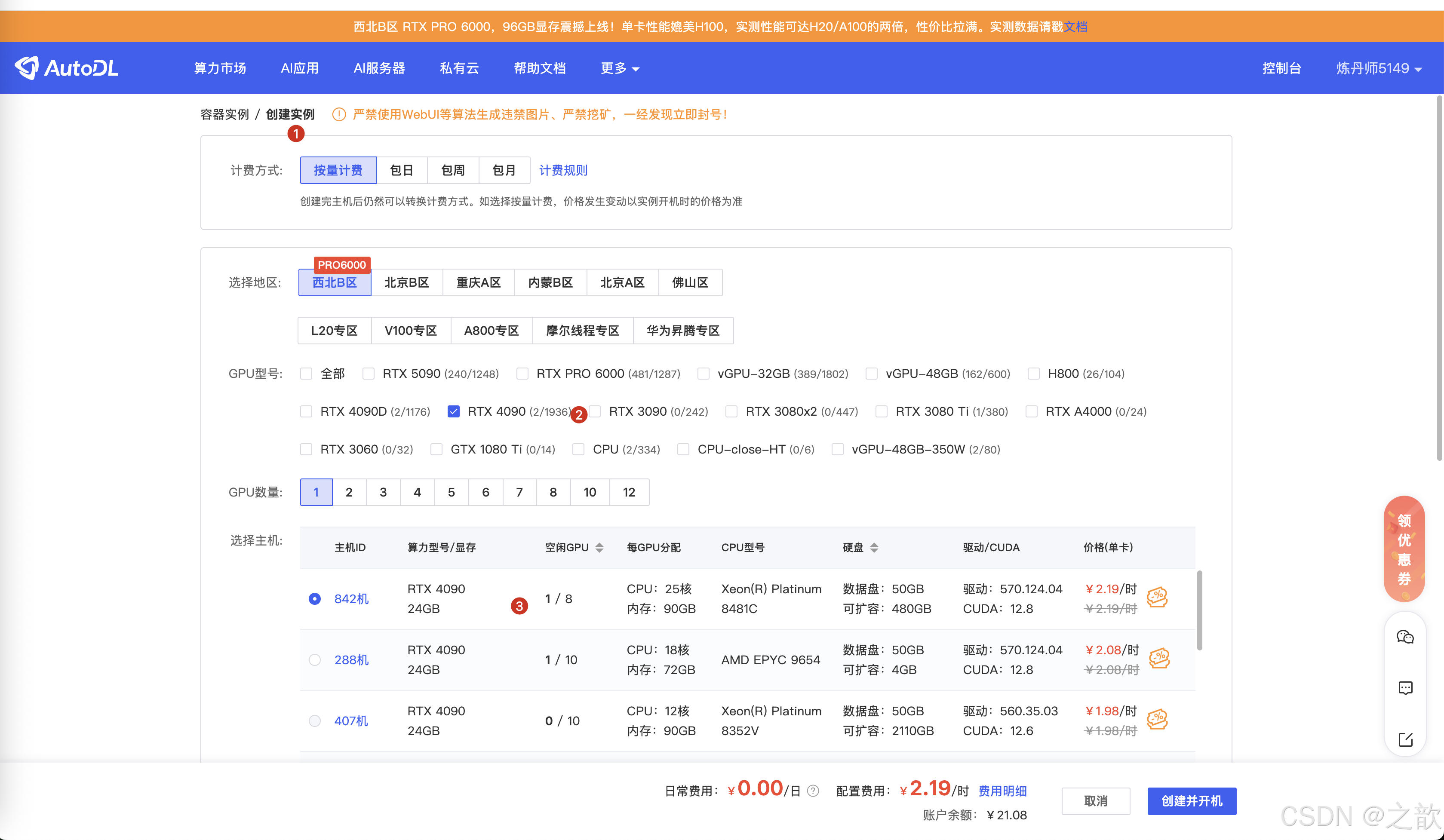

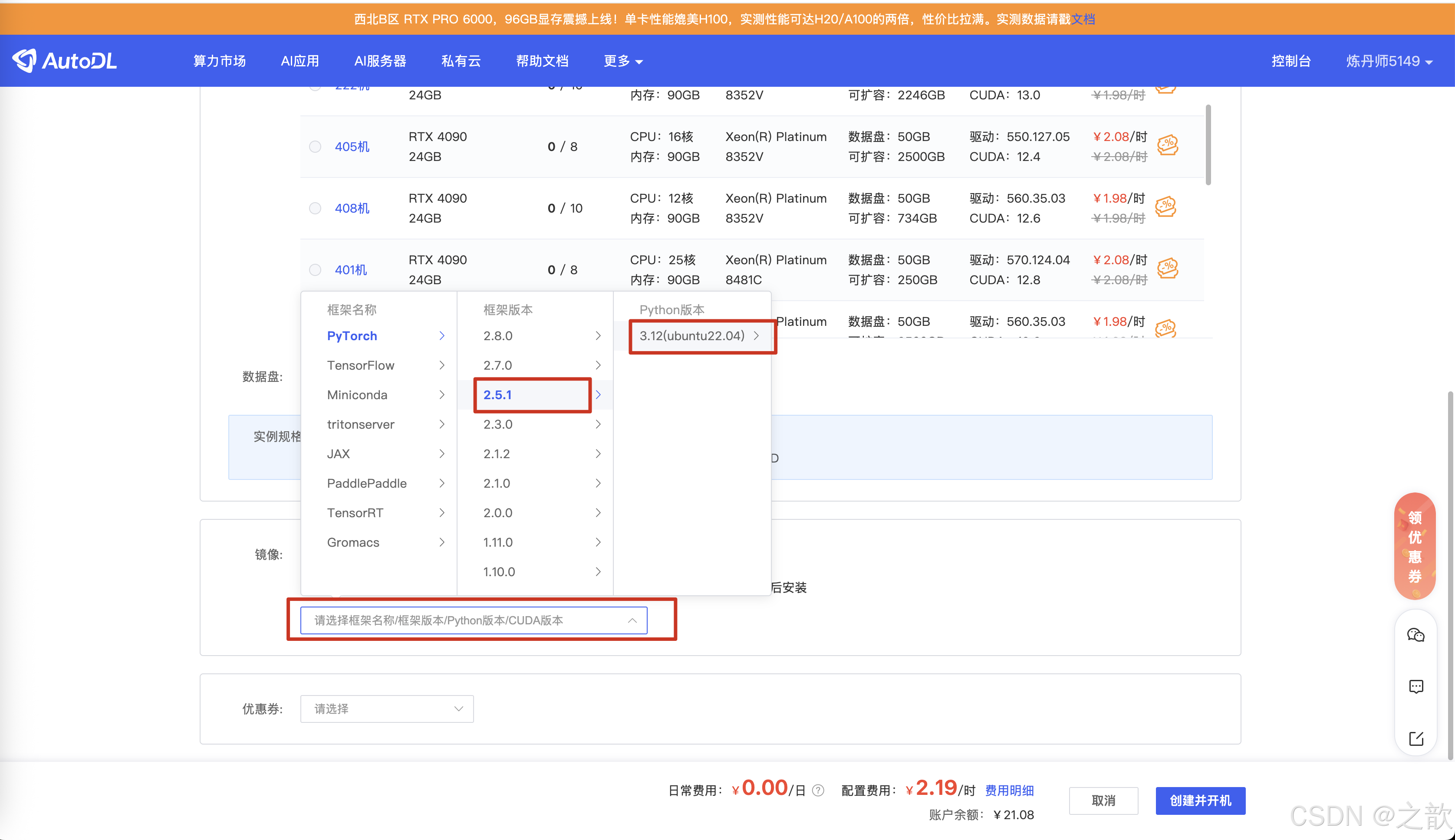

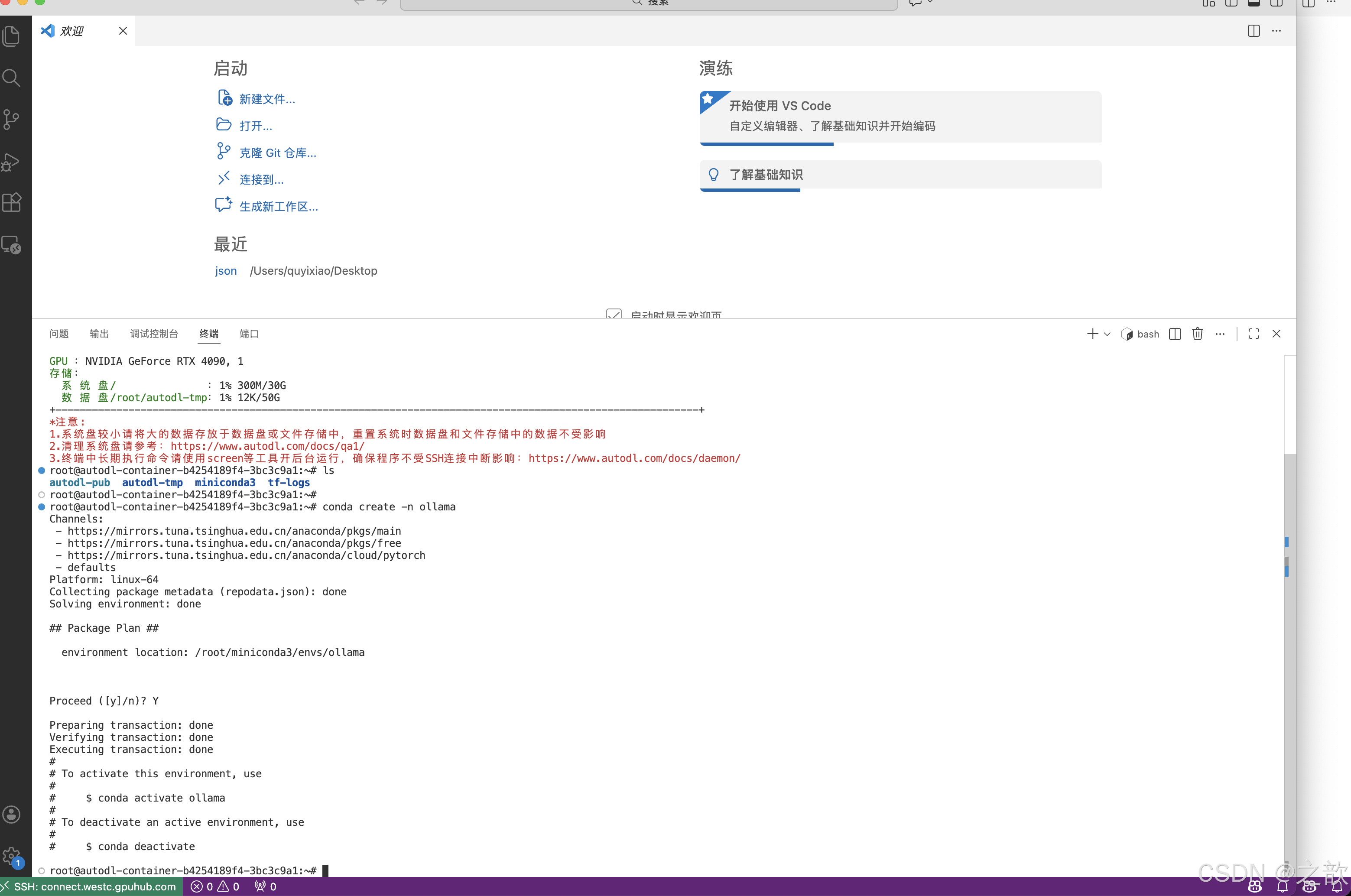

Ollama接入

购买机器

创建并开机

复制登录信息在vscode 中登录

Ollama部署大模型

Ollama 是针对个人的, 比较好用, 企业级一般不使用。

https://ollama.com/download/linux

可以看另外一篇博客 https://blog.csdn.net/quyixiao/article/details/149789888?spm=1011.2415.3001.5331

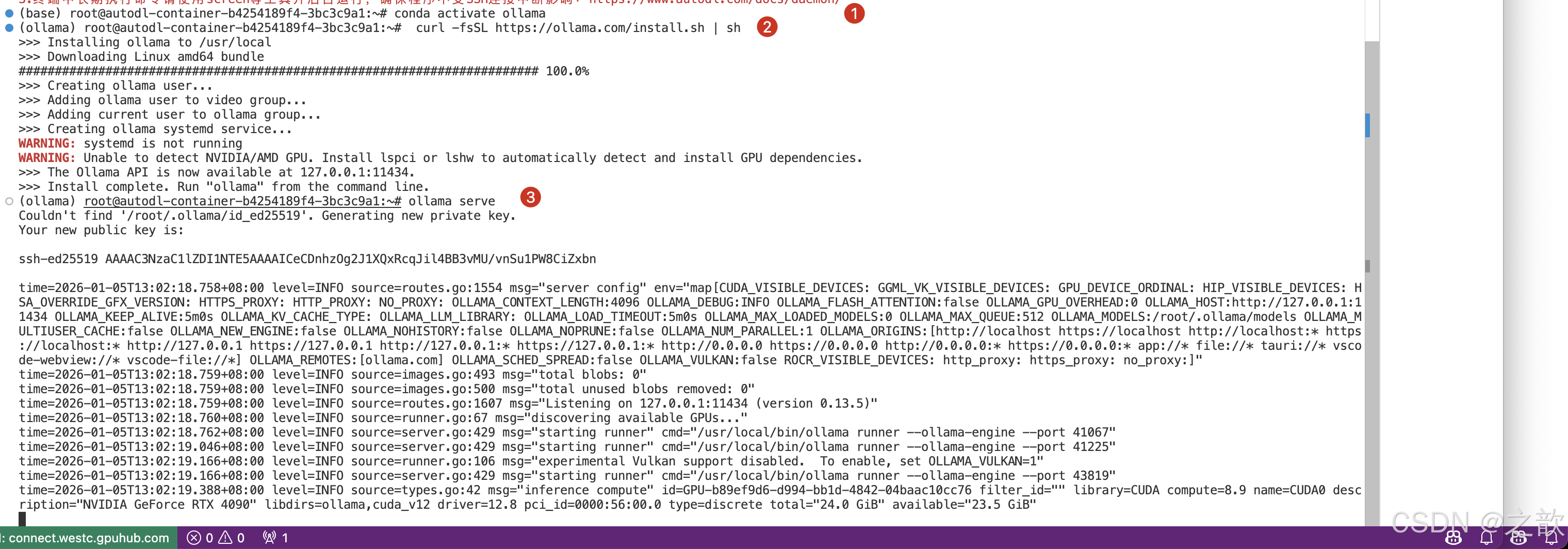

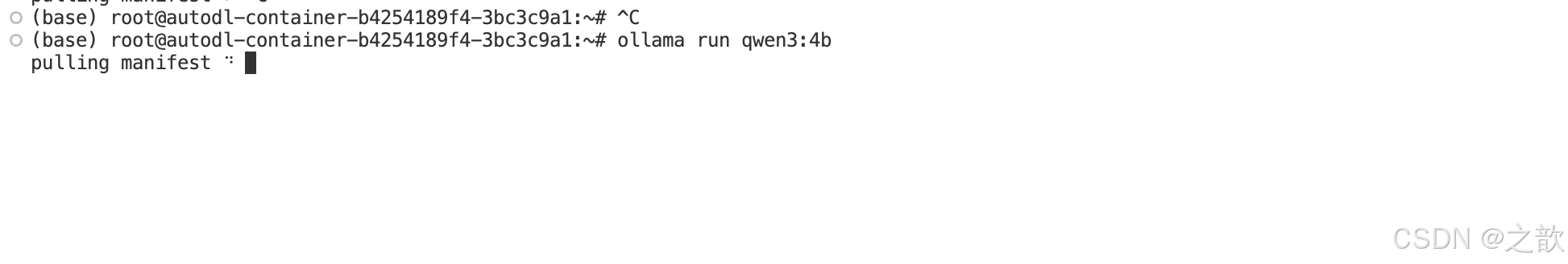

autodl 安装ollama环境

创建一个虚拟环境

conda create -n ollama

激活ollama1环境

conda activate ollama

安装ollama1

curl -fsSL https://ollama.com/install.sh | sh

启动ollama

ollama serve

查找大模型

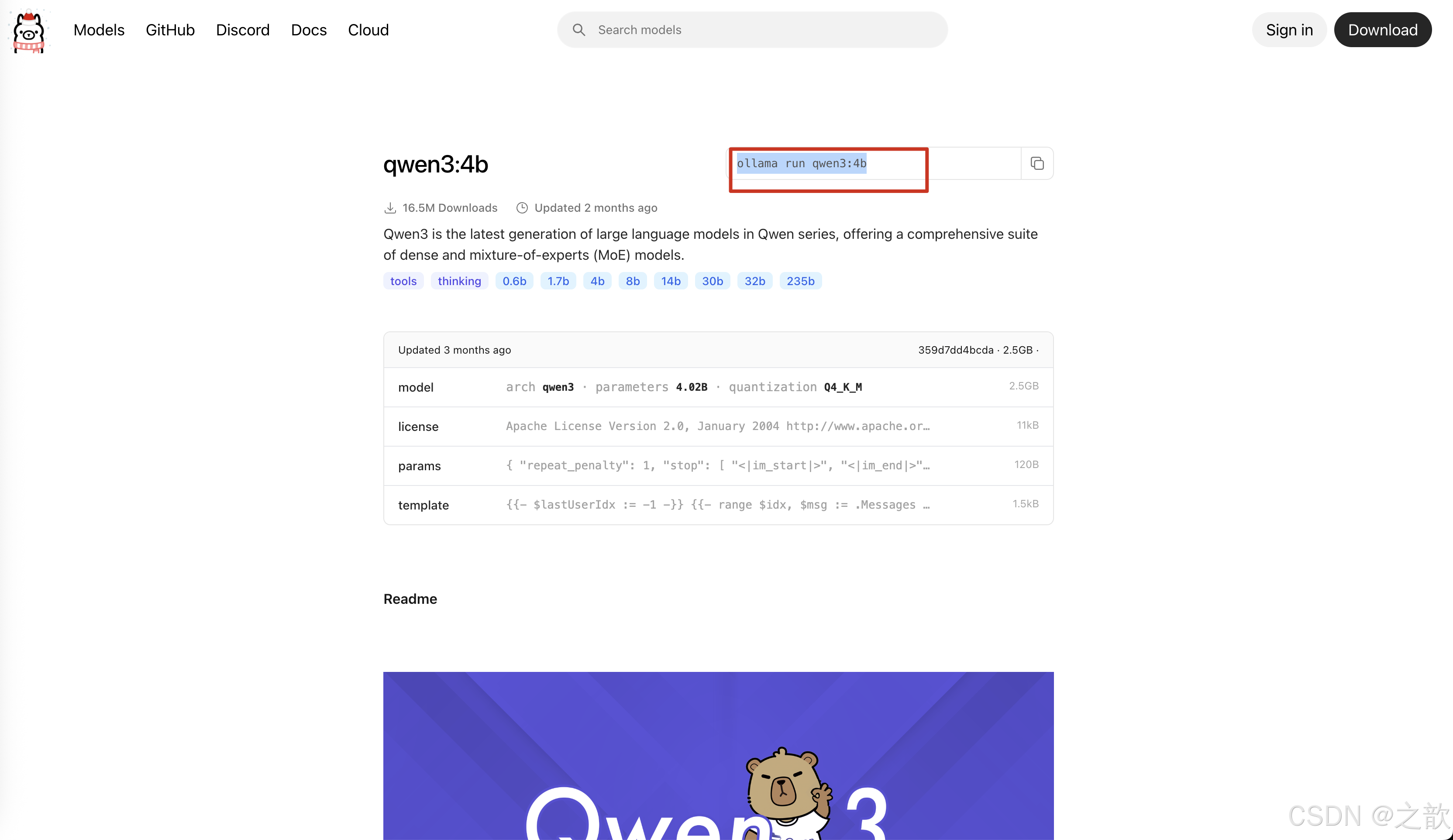

进入到这个链接

https://ollama.com/library/qwen3:4b

打开另外一个终端窗口

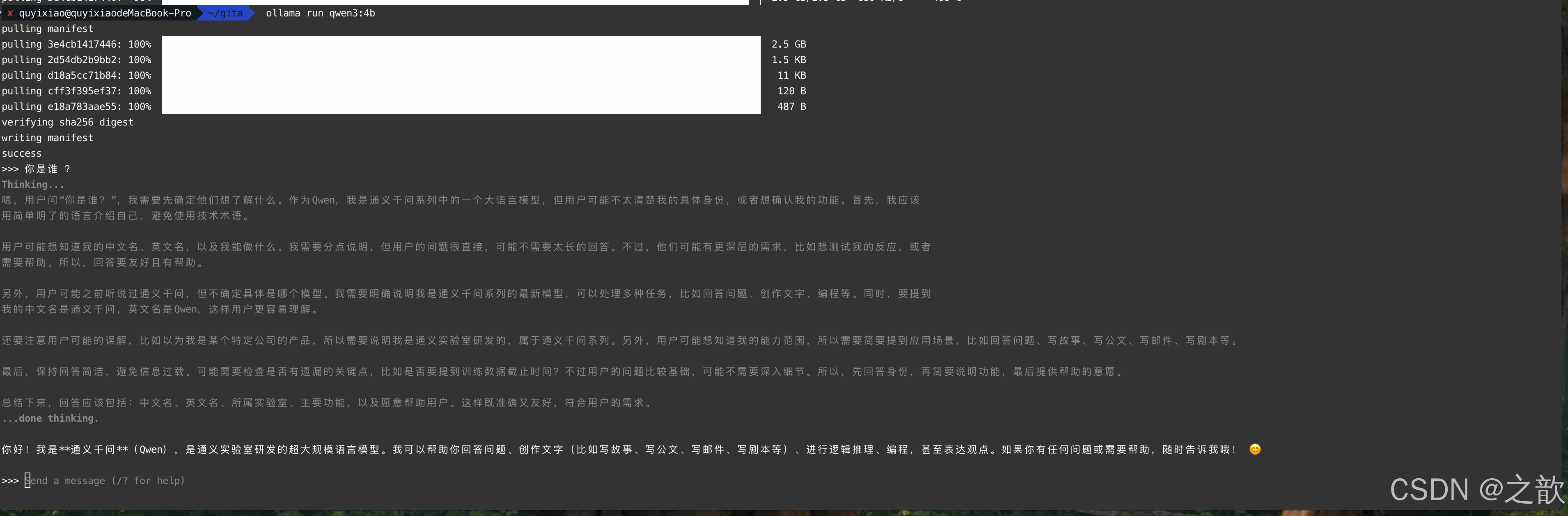

运行# ollama run qwen3:4b

ollama 只能运行gguf的格式的大模型 , 是量化之后的模型,只针对个人用户,简单,快速 。 模型是阉割之后的大模型 。启动之后,就可以进行聊天了。

mac 安装ollama环境

https://ollama.com/download/mac 下载 ollama

下载下来之后直接双击安装

手动下载安装

访问官网:https://ollama.com/download

下载 macOS 版本(.dmg 文件)

双击安装包进行安装

安装后使用

启动 Ollama 服务

启动 Ollama(如果通过 Homebrew 安装,可能需要手动启动)

ollama serve

ollama run qwen3:4b

注意事项

- 系统要求:

- macOS 10.13 或更高版本

- Apple Silicon (M1/M2/M3) 或 Intel 芯片

- 端口:

- 默认端口:11434

- 确保端口未被占用

- 首次运行:

- 首次运行模型时会自动下载,可能需要一些时间

- 内存:

- 模型会占用内存,建议至少 8GB RAM

1. 配置pom

java

<!--ollama-->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>2. 配置application.properties

java

# Ollama 配置

spring.ai.ollama.base-url=http://localhost:11434

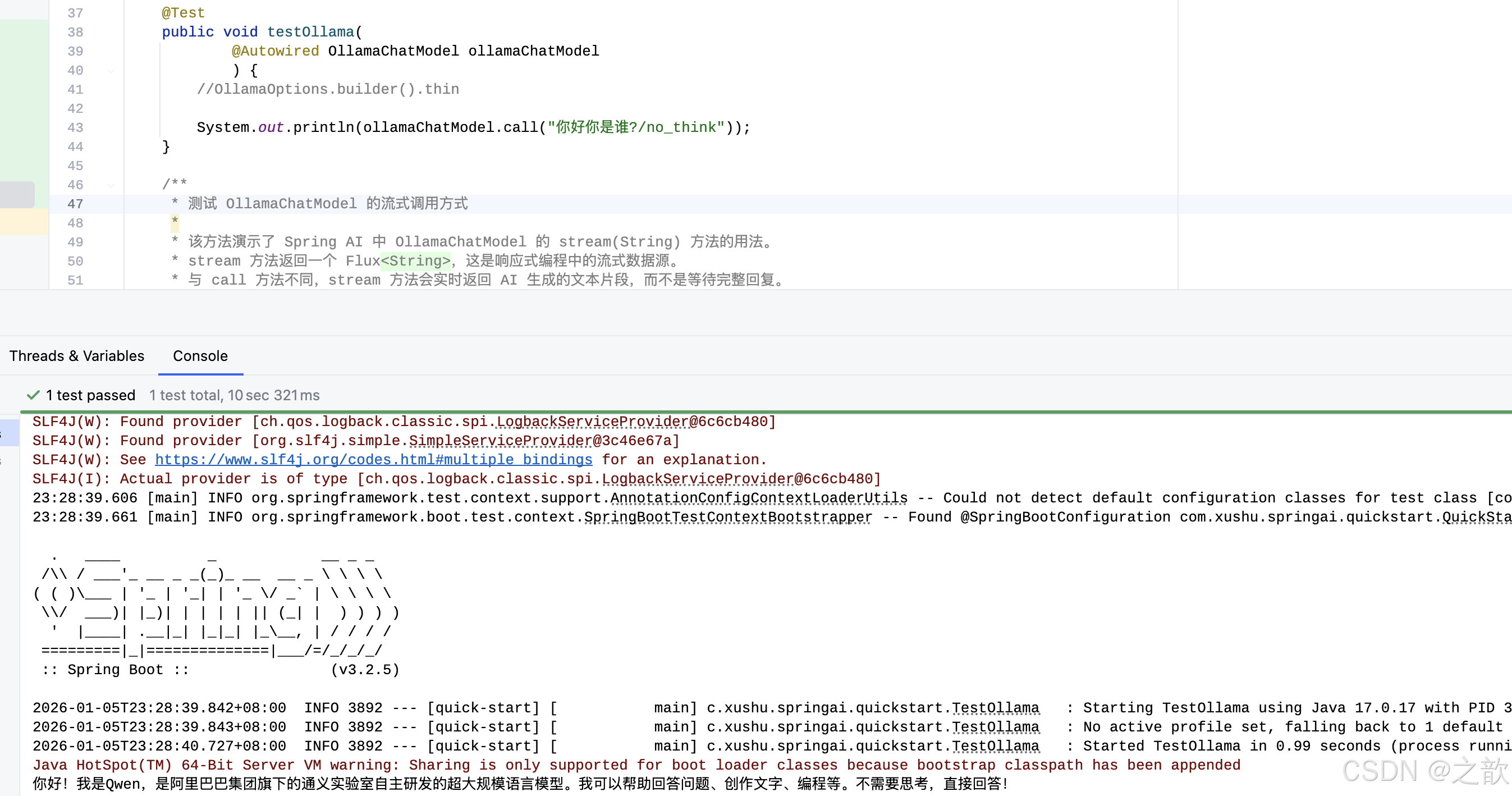

spring.ai.ollama.chat.model=qwen3:4b3.1跳过推理过程,直接返回结果

java

/**

* 测试 OllamaChatModel 的基本同步调用方式

*

* 该方法演示了 Spring AI 中 OllamaChatModel 的 call(String) 方法的基本用法。

* call 方法接收一个字符串作为用户输入,返回 AI 模型的完整回复文本。

* 这是最简单的调用方式,适用于不需要额外配置的场景。

*

* 底层实现:OllamaChatModel 实现了 ChatModel 接口的 call(String) 方法,

* 内部会将字符串转换为 UserMessage,创建 Prompt,调用 call(Prompt) 方法,

* 最终返回 ChatResponse 中的文本内容。

*

* 注意:消息中的 "/no_think" 后缀是某些模型(如推理模型)的特殊指令,

* 用于跳过推理过程,直接返回结果。Ollama 会根据模型类型处理该指令。

*

* @param ollamaChatModel 自动注入的 OllamaChatModel Bean,由 Spring AI 根据配置自动创建

* 配置来源:application.properties 中的 spring.ai.ollama.* 配置项

* 默认模型:qwen3:4b(根据配置文件)

*/

@Test

public void testOllama(

@Autowired OllamaChatModel ollamaChatModel

) {

//OllamaOptions.builder().thin

System.out.println(ollamaChatModel.call("你好你是谁?/no_think"));

}结果输出:

3.2 ollama 流式输出

ollama 0.8.0之前的版本不支持 stream+ollama

https://ollama.com/blog/streaming-tool 0.8.0+支持stream +ollama. 但是和springai1.0有兼容问题:

https://github.com/spring-projects/spring-ai/issues/3369

java

/**

* 测试 OllamaChatModel 的流式调用方式

*

* 该方法演示了 Spring AI 中 OllamaChatModel 的 stream(String) 方法的用法。

* stream 方法返回一个 Flux<String>,这是响应式编程中的流式数据源。

* 与 call 方法不同,stream 方法会实时返回 AI 生成的文本片段,而不是等待完整回复。

*

* 底层实现:OllamaChatModel 实现了 ChatModel 接口的 stream(String) 方法,

* 内部会将字符串转换为 UserMessage,创建 Prompt,调用 stream(Prompt) 方法,

* 返回一个 Flux<ChatResponse>,然后提取每个响应中的文本片段。

* Ollama 的流式响应通过 Server-Sent Events (SSE) 或类似机制实现,

* 每个响应片段包含部分生成的文本,最终组合成完整回复。

*

* 使用场景:适用于需要实时显示 AI 回复的场景,如聊天界面、流式输出等。

* 流式输出可以提供更好的用户体验,让用户看到 AI 的实时思考过程。

*

* 注意:stream.toIterable() 会将响应式流转换为可迭代对象,这会阻塞当前线程

* 直到流完成。在生产环境中,建议使用响应式编程方式处理 Flux。

*

* @param ollamaChatModel 自动注入的 OllamaChatModel Bean

*/

@Test

public void testDeepseekStream(@Autowired OllamaChatModel ollamaChatModel) {

Flux<String> stream = ollamaChatModel.stream("你好你是谁");

stream.toIterable().forEach(System.out::println);

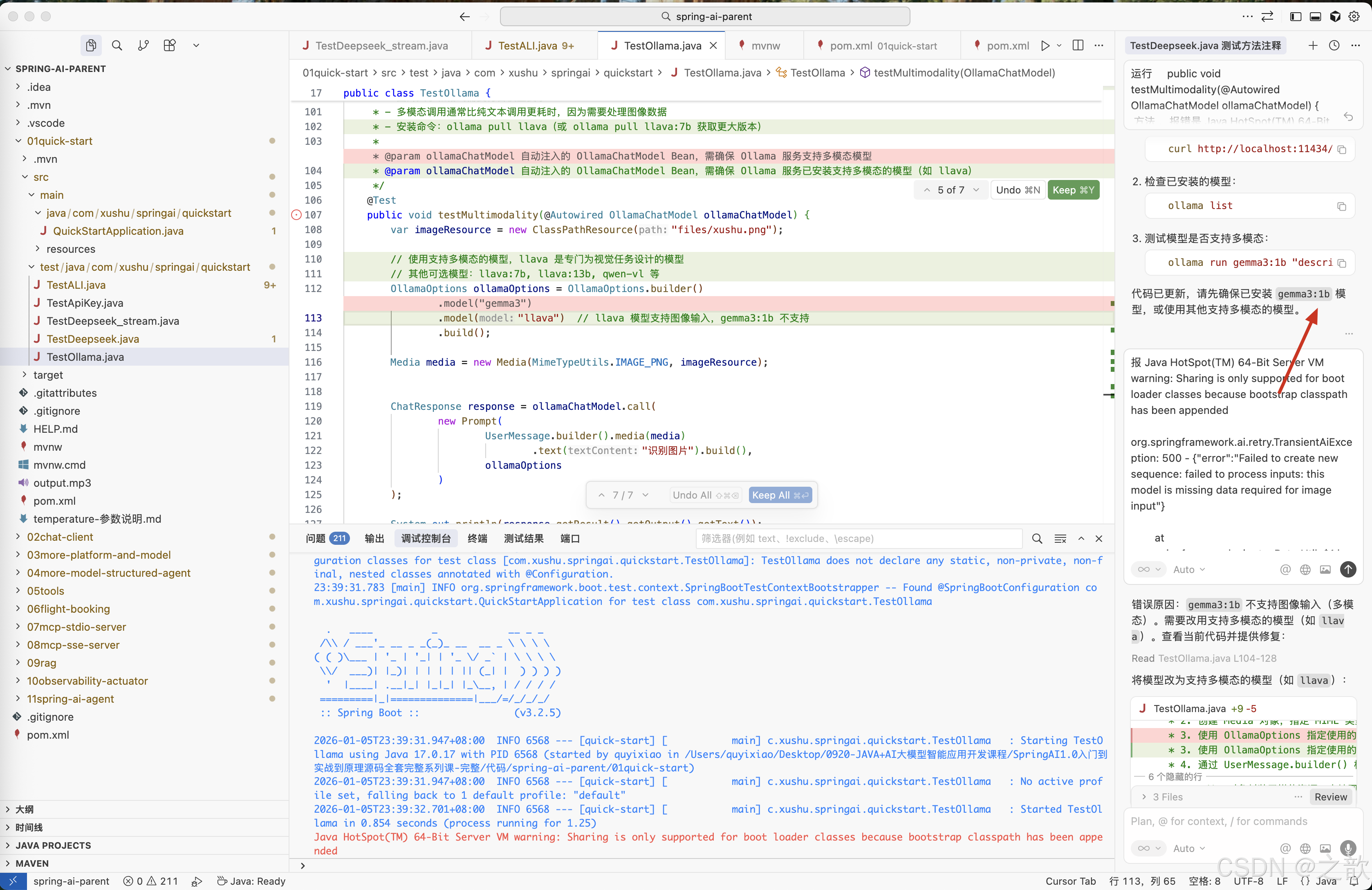

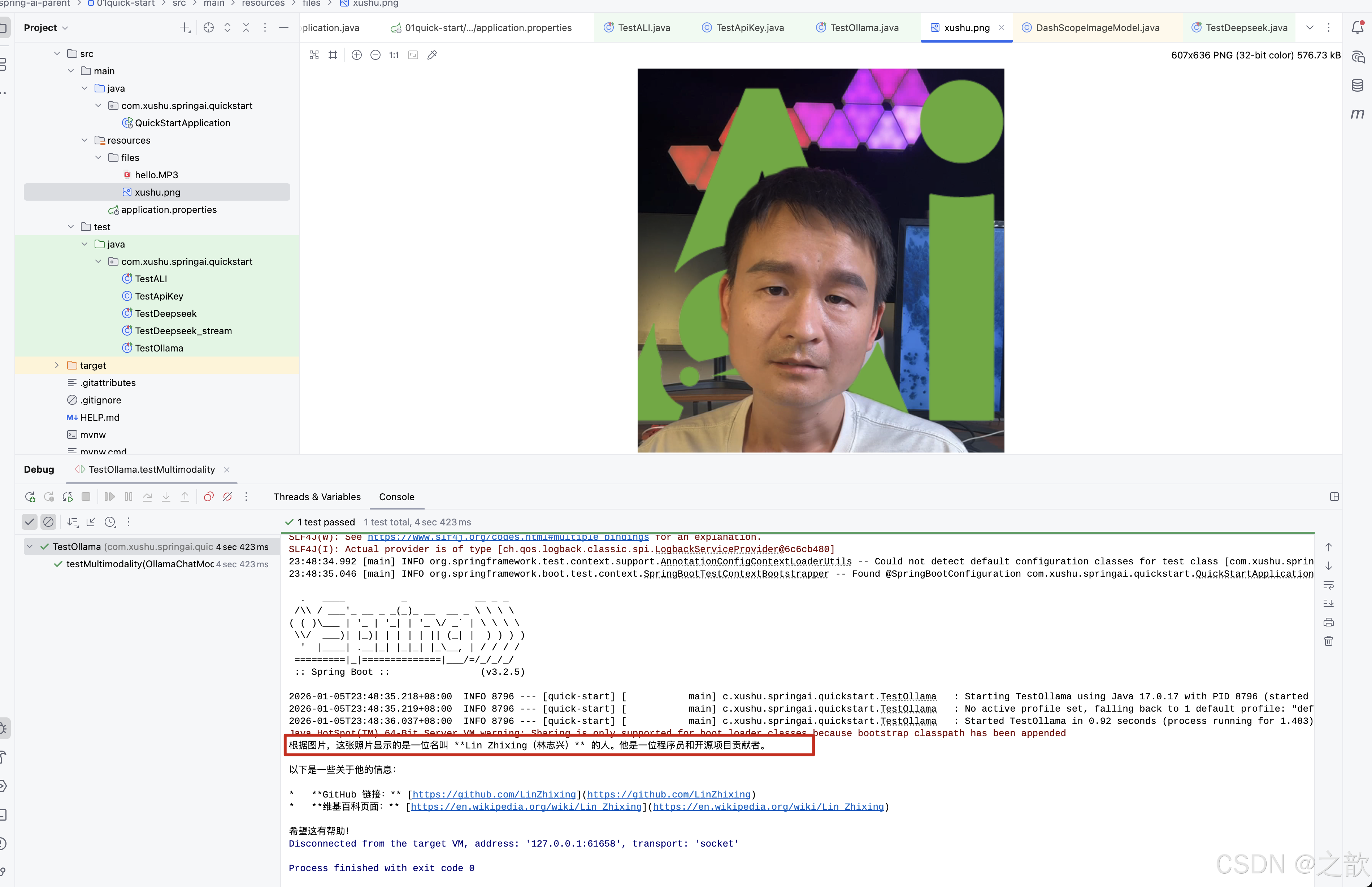

}3.3 ollama多模态(图像识别)

目前ollama支持的多模态模型:

- Meta Llama 4

- Google Gemma 3

- Qwen 2.5 VL

- Mistral Small 3.1

注意 :我之前没有注意到,用的是gemma3:1b , 总是报错,将错误用cursor 分析一下 。

得出结论,gemma3:1b不支持图像识别。 然后改用gemma3模型 ,从这里可以得出,程序员建议还是用cursor来解决问题比较高效 ,如环境问题 ,之前我有一个同事 ,对python 一点都不了解,直接让cursor 将python 代码转变成java 代码,效率之高,毋庸置疑 。

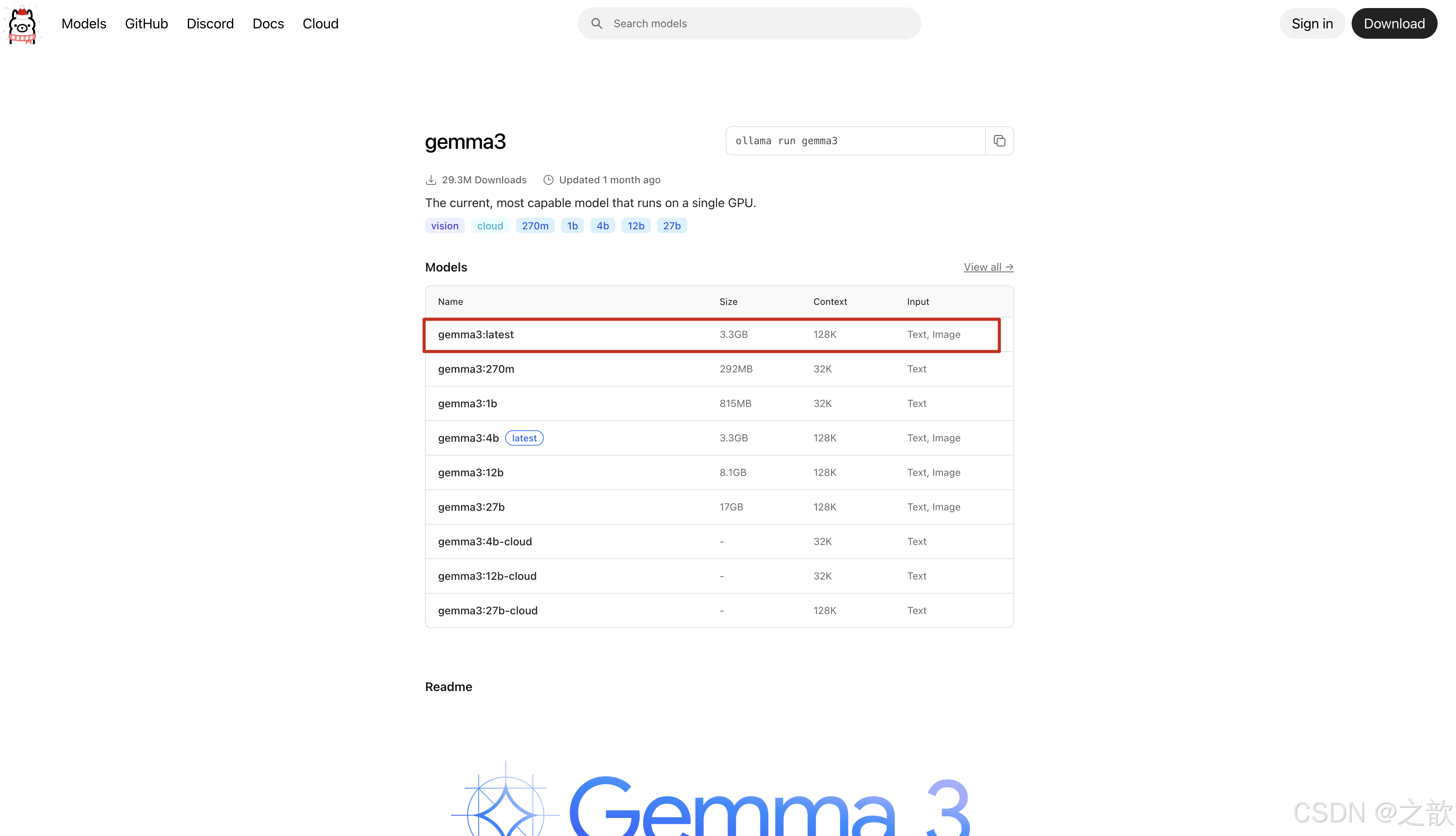

拉取https://ollama.com/library/gemma3:latest

修改 application.properties 配置文件

java

spring.ai.ollama.base-url=http://localhost:11434

spring.ai.ollama.chat.model=gemma3

java

/**

* 测试 OllamaChatModel 的多模态能力(图像识别)

*

* 该方法演示了如何使用 OllamaChatModel 进行多模态输入处理,即同时处理文本和图像。

* 多模态 AI 模型可以理解图像内容并回答相关问题,这是现代 AI 的重要能力之一。

*

* 底层实现:

* 1. 使用 ClassPathResource 加载类路径下的图片资源(files/xushu.png)

* 2. 创建 Media 对象,指定 MIME 类型为 IMAGE_PNG,并关联图片资源

* 3. 使用 OllamaOptions 指定使用的模型为 "gemma3"(支持多模态的模型)

* 4. 通过 UserMessage.builder() 构建用户消息,使用 media() 方法添加图片,text() 方法添加文本提示

* 5. 创建 Prompt 对象,包含 UserMessage 和 OllamaOptions

* 6. 调用 call(Prompt) 方法,OllamaChatModel 会将图片和文本一起发送给模型

* 7. 模型分析图片内容,结合文本提示生成回复

* 8. 从 ChatResponse 中提取最终回复文本

*

* 技术细节:

* - Media 对象封装了媒体资源,支持图片、音频、视频等多种类型

* - OllamaOptions 允许在运行时覆盖默认模型配置,这里指定使用 gemma3 模型

* - UserMessage 支持多个 Media 对象,可以实现多图片输入

* - Ollama 会将图片编码为 base64 格式或通过文件路径传递给模型

*

* 使用场景:图像识别、图像描述、图像问答、OCR(光学字符识别)等。

*

* 注意:

* - 必须使用支持多模态的模型(如 gemma3),普通文本模型不支持图像输入

* - 图片大小和格式需要符合模型要求

* - 多模态调用通常比纯文本调用更耗时,因为需要处理图像数据

*

* @param ollamaChatModel 自动注入的 OllamaChatModel Bean,需确保 Ollama 服务支持多模态模型

*/

@Test

public void testMultimodality(@Autowired OllamaChatModel ollamaChatModel) {

var imageResource = new ClassPathResource("files/xushu.png");

OllamaOptions ollamaOptions = OllamaOptions.builder()

.model("gemma3")

.build();

Media media = new Media(MimeTypeUtils.IMAGE_PNG, imageResource);

ChatResponse response = ollamaChatModel.call(

new Prompt(

UserMessage.builder().media(media)

.text("识别图片").build(),

ollamaOptions

)

);

System.out.println(response.getResult().getOutput().getText());

}输出:

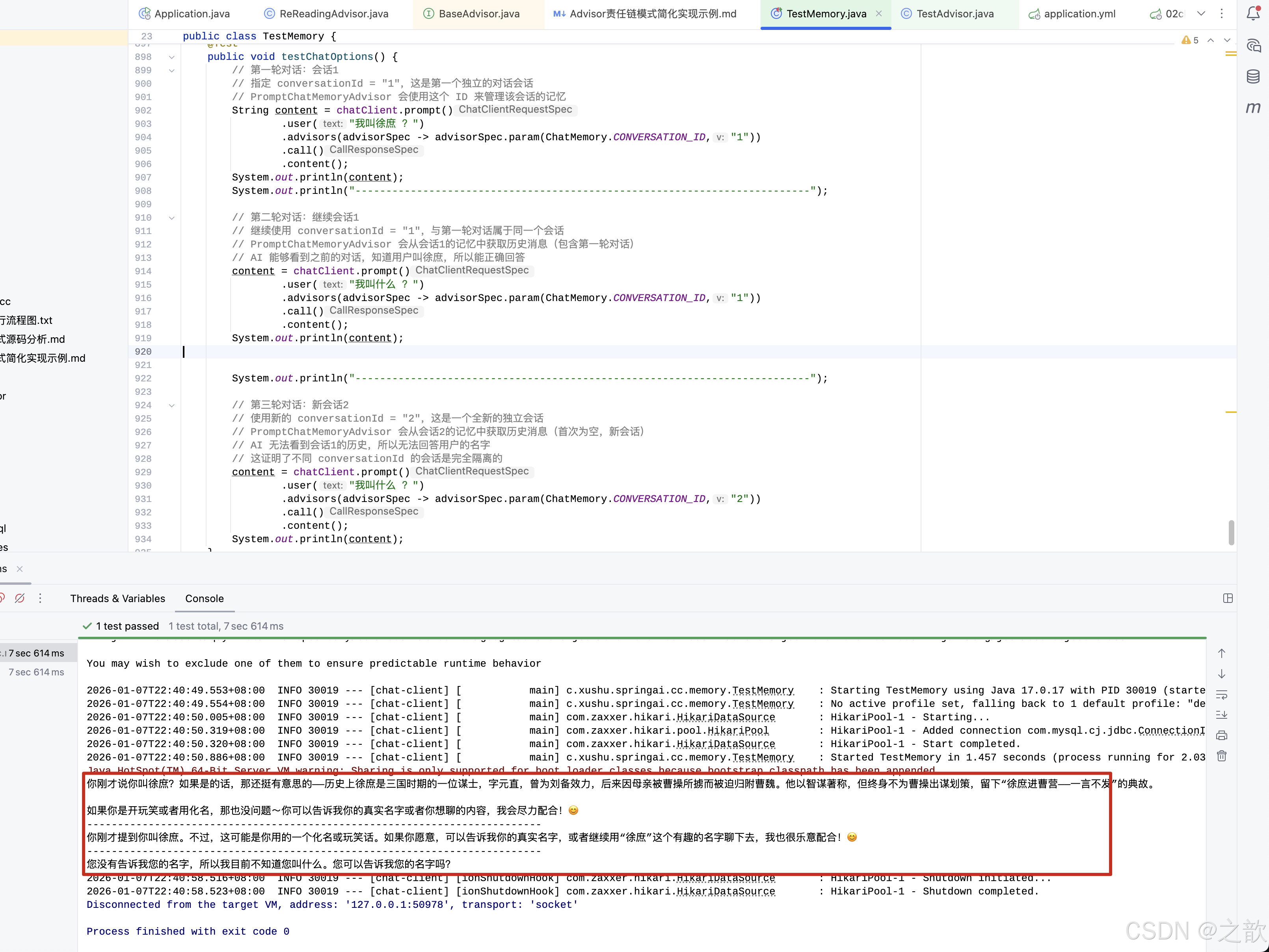

ChatClient

ChatClient快速使用

java

package com.xushu.springai.cc;

import org.junit.jupiter.api.Test;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import reactor.core.publisher.Flux;

/**

* ChatClient 测试类

*

* 该类演示了 Spring AI 中 ChatClient 的基本使用方法。

* ChatClient 是 Spring AI 提供的高级 API,相比直接使用 ChatModel,它提供了更简洁、更易用的流式 API。

*

* ChatClient 的核心优势:

* 1. 流式 API 设计:提供链式调用,代码更简洁易读

* 2. 自动消息管理:自动处理 UserMessage、SystemMessage 等消息类型

* 3. 统一接口:屏蔽底层 ChatModel 的差异,提供统一的调用方式

* 4. 功能扩展:支持 Advisor、Memory、Tools 等高级功能

*

* 底层实现原理:

* - ChatClient 内部封装了 ChatModel(如 DeepSeekChatModel、DashScopeChatModel 等)

* - ChatClient.Builder 由 Spring AI 自动配置,会根据 application.properties 中的配置

* 自动注入对应的 ChatModel

* - prompt() 方法返回 PromptSpec,用于构建提示词

* - user() 方法添加用户消息,内部会创建 UserMessage 对象

* - call() 方法执行同步调用,返回 ResponseSpec,内部调用 ChatModel.call(Prompt)

* - stream() 方法执行流式调用,返回 ResponseSpec,内部调用 ChatModel.stream(Prompt)

* - content() 方法提取响应中的文本内容

*

* 与直接使用 ChatModel 的对比:

* - 直接使用 ChatModel:需要手动创建 Prompt、UserMessage 等对象,代码较繁琐

* - 使用 ChatClient:链式调用,代码更简洁,但功能更强大

*

* @author Spring AI Test

* @see org.springframework.ai.chat.client.ChatClient

* @see org.springframework.ai.chat.model.ChatModel

*/

@SpringBootTest

public class TestChatClient {

/**

* 测试 ChatClient 的同步调用方式

*

* 该方法演示了 ChatClient 最基本的同步调用流程:

* 1. 通过 ChatClient.Builder 构建 ChatClient 实例

* 2. 使用流式 API 构建提示词和调用模型

* 3. 获取并打印 AI 的回复内容

*

* 执行流程:

* - chatClient.prompt():创建 PromptSpec,用于构建提示词

* - .user("你好"):添加用户消息,内部创建 UserMessage 对象,内容为 "你好"

* - .call():执行同步调用,内部调用 ChatModel.call(Prompt),返回 ChatResponse

* - .content():从 ChatResponse 中提取文本内容,返回完整的回复字符串

*

* 底层实现细节:

* - ChatClient.Builder 由 Spring AI 自动配置,会根据配置文件中的模型类型

* (如 spring.ai.deepseek.* 或 spring.ai.dashscope.*)自动注入对应的 ChatModel

* - build() 方法创建 ChatClient 实例,内部封装了 ChatModel

* - prompt() 方法返回 PromptSpec,这是一个流式 API 的入口

* - user() 方法将字符串转换为 UserMessage,并添加到 Prompt 中

* - call() 方法内部调用 ChatModel.call(Prompt),返回 ChatResponse

* - content() 方法从 ChatResponse.getResult().getOutput().getText() 提取文本

*

* 使用场景:适用于需要完整回复后再处理的场景,如文本生成、问答等。

*

* 注意:

* - ChatClient.Builder 是 Spring Bean,由 Spring AI 自动配置

* - 如果配置了多个 ChatModel,Spring AI 会根据优先级选择默认的 ChatModel

* - 同步调用会阻塞当前线程,直到 AI 返回完整回复

*

* @param chatClientBuilder 自动注入的 ChatClient.Builder Bean,由 Spring AI 根据配置自动创建

* 配置来源:application.properties 中的 spring.ai.* 配置项

*/

@Test

public void testChatClient(@Autowired

ChatClient.Builder chatClientBuilder) {

ChatClient chatClient = chatClientBuilder.build();

String content = chatClient.prompt()

.user("你好")

.call()

.content();

System.out.println(content);

}

/**

* 测试 ChatClient 的流式调用方式

*

* 该方法演示了 ChatClient 的流式调用流程:

* 1. 通过 ChatClient.Builder 构建 ChatClient 实例

* 2. 使用流式 API 构建提示词和调用模型

* 3. 实时获取并打印 AI 的回复片段

*

* 执行流程:

* - chatClient.prompt():创建 PromptSpec,用于构建提示词

* - .user("你好"):添加用户消息,内部创建 UserMessage 对象

* - .stream():执行流式调用,内部调用 ChatModel.stream(Prompt),返回 Flux<ChatResponse>

* - .content():从每个 ChatResponse 中提取文本片段,返回 Flux<String>

* - toIterable().forEach():将响应式流转换为可迭代对象,逐个打印文本片段

*

* 底层实现细节:

* - stream() 方法内部调用 ChatModel.stream(Prompt),返回 Flux<ChatResponse>

* - content() 方法从每个 ChatResponse 中提取文本片段,返回 Flux<String>

* - 每个 ChatResponse 包含部分生成的文本,最终组合成完整回复

* - toIterable() 将响应式流转换为阻塞式的可迭代对象(会阻塞当前线程)

*

* 流式调用的优势:

* - 实时反馈:用户可以立即看到 AI 的回复,无需等待完整回复

* - 更好的用户体验:适合聊天界面、实时对话等场景

* - 降低延迟感知:即使总时间相同,流式输出让用户感觉更快

*

* 使用场景:

* - 聊天界面:实时显示 AI 回复

* - 长文本生成:边生成边显示

* - 流式输出:需要实时反馈的场景

*

* 注意:

* - stream.toIterable() 会阻塞当前线程,直到流完成

* - 在生产环境中,建议使用响应式编程方式处理 Flux(如 subscribe())

* - 流式调用适合需要实时反馈的场景,但会增加网络请求次数

* - 每个文本片段可能是一个字符、一个词或一个句子,取决于模型的实现

*

* @param chatClientBuilder 自动注入的 ChatClient.Builder Bean,由 Spring AI 根据配置自动创建

*/

@Test

public void testStreamChatClient(@Autowired

ChatClient.Builder chatClientBuilder) {

ChatClient chatClient = chatClientBuilder.build();

Flux<String> content = chatClient.prompt()

.user("你好")

.stream()

.content();

content.toIterable().forEach(s -> System.out.println(s));

}

}ChatClient多个模型如何选择

- 多模型场景:当配置了多个 ChatModel(如 DeepSeek、DashScope、Ollama)时,

- 需要明确指定使用哪个模型

- 动态模型选择:根据业务逻辑动态选择不同的模型

- 模型对比测试:测试不同模型对同一问题的回复效果

- 特定模型功能:需要使用特定模型的功能(如 DashScope 的多模态能力)

java

/**

* 测试 ChatClient 的显式模型指定方式

*

* 该方法演示了如何显式指定使用特定的 ChatModel 来创建 ChatClient。

* 与 testChatClient() 方法不同,该方法不依赖 ChatClient.Builder 的默认配置,

* 而是直接注入特定的 ChatModel(DashScopeChatModel),然后显式创建 ChatClient。

*

* 执行流程:

* 1. 通过 @Autowired 注入 DashScopeChatModel(阿里云百炼模型)

* 2. 使用 ChatClient.builder(dashScopeChatModel) 显式指定使用的模型

* 3. 调用 build() 创建 ChatClient 实例

* 4. 使用流式 API 构建提示词和调用模型

* 5. 获取并打印 AI 的回复内容

*

* 与 testChatClient() 的区别:

* - testChatClient():使用 ChatClient.Builder(自动注入),依赖 Spring AI 的默认配置

* 如果有多个 ChatModel,Spring AI 会根据优先级选择默认的模型

* - testChatClient2():显式指定 DashScopeChatModel,不依赖默认配置

* 可以精确控制使用哪个模型,适合多模型场景

*

* 底层实现细节:

* - ChatClient.builder(ChatModel) 是静态方法,接收一个 ChatModel 实例

* - 该方法会创建一个新的 ChatClient.Builder,并将指定的 ChatModel 设置为其底层模型

* - build() 方法创建 ChatClient 实例,内部封装了指定的 DashScopeChatModel

* - 后续的 prompt()、user()、call()、content() 等方法与 testChatClient() 相同

* - 最终调用的是 DashScopeChatModel.call(Prompt),而不是默认的 ChatModel

*

* 使用场景:

* - 多模型场景:当配置了多个 ChatModel(如 DeepSeek、DashScope、Ollama)时,

* 需要明确指定使用哪个模型

* - 动态模型选择:根据业务逻辑动态选择不同的模型

* - 模型对比测试:测试不同模型对同一问题的回复效果

* - 特定模型功能:需要使用特定模型的功能(如 DashScope 的多模态能力)

*

* 优势:

* - 精确控制:明确知道使用的是哪个模型,避免配置歧义

* - 灵活性:可以在运行时动态选择模型

* - 可测试性:便于单元测试,可以 mock 特定的 ChatModel

*

* 注意:

* - 需要确保 DashScopeChatModel Bean 已正确配置和注入

* - 配置来源:application.properties 中的 spring.ai.dashscope.* 配置项

* - 如果 DashScopeChatModel 未配置,注入会失败并抛出异常

* - 这种方式创建的 ChatClient 不会使用 ChatClient.Builder 的默认配置

* (如 defaultSystem、defaultOptions 等),如果需要这些配置,需要手动设置

*

* @param dashScopeChatModel 自动注入的 DashScopeChatModel Bean(阿里云百炼模型)

* 配置来源:application.properties 中的 spring.ai.dashscope.* 配置项

* 需要配置:spring.ai.dashscope.api-key 等

*/

@Test

public void testChatClient2(@Autowired

DashScopeChatModel dashScopeChatModel) {

ChatClient chatClient = ChatClient.builder(dashScopeChatModel).build();

String content = chatClient.prompt()

.user("你好")

.call()

.content();

System.out.println(content);

}多平台多模型动态配置大模型平台实战

java

package com.xushu.springai.more;

import com.alibaba.cloud.ai.dashscope.chat.DashScopeChatModel;

import org.springframework.ai.chat.client.ChatClient;

import org.springframework.ai.chat.model.ChatModel;

import org.springframework.ai.chat.prompt.ChatOptions;

import org.springframework.ai.deepseek.DeepSeekChatModel;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import reactor.core.publisher.Flux;

import java.util.HashMap;

/**

* 多平台多模型动态切换控制器

*

* 该类实现了一个统一的 REST API 接口,支持在运行时动态选择不同的 AI 平台和模型。

* 这是 Spring AI 多模型架构设计的典型实现,展示了如何通过策略模式管理多个 ChatModel 实例。

*

* 核心设计思想:

* 1. 平台抽象:通过 ChatModel 接口统一不同平台的实现差异

* 2. 策略模式:使用 HashMap 存储平台名称与 ChatModel 的映射关系

* 3. 动态配置:支持运行时动态指定平台、模型和参数

* 4. 流式响应:使用 Flux<String> 实现 Server-Sent Events (SSE) 流式输出

*

* 架构优势:

* - 解耦合:Controller 不依赖具体的模型实现,只依赖 ChatModel 接口

* - 可扩展:新增平台只需在构造函数中注入新的 ChatModel 并添加到 HashMap

* - 灵活性:客户端可以根据需求动态选择最适合的平台和模型

* - 统一接口:所有平台通过相同的 API 调用,降低客户端复杂度

*

* 底层实现原理:

* - Spring 依赖注入:通过构造函数注入三个不同的 ChatModel 实现

* (DashScopeChatModel、DeepSeekChatModel、OllamaChatModel)

* - HashMap 存储:使用平台名称作为 key,ChatModel 实例作为 value

* - ChatClient 封装:每次请求动态创建 ChatClient,封装选定的 ChatModel

* - ChatOptions 配置:通过 defaultOptions() 方法动态设置模型参数

* (temperature、model 等),这些选项会传递给底层的 ChatModel

* - 流式处理:ChatClient.stream() 返回 Flux<ChatResponse>,content() 提取文本片段

* 最终返回 Flux<String>,Spring WebFlux 会自动处理 SSE 响应

*

* 请求处理流程:

* 1. 客户端发送 GET 请求,携带 message、platform、model、temperature 参数

* 2. Spring MVC 将请求参数绑定到方法参数(message 和 options)

* 3. 根据 platform 从 HashMap 中获取对应的 ChatModel

* 4. 使用 ChatClient.builder(chatModel) 创建 ChatClient.Builder

* 5. 通过 defaultOptions() 设置动态参数(temperature、model)

* 6. 调用 chatClient.prompt().user(message).stream().content() 获取流式响应

* 7. 返回 Flux<String>,Spring 自动转换为 SSE 流式响应

*

* 使用场景:

* - 多平台对比:测试不同平台对同一问题的回复效果

* - 成本优化:根据任务复杂度选择不同成本的模型

* - 功能选择:根据需求选择支持特定功能的平台(如多模态、长文本等)

* - A/B 测试:在多个模型间进行性能对比

* - 降级策略:主平台不可用时自动切换到备用平台

*

* 注意事项:

* - 平台名称必须与 HashMap 中的 key 完全匹配(区分大小写)

* - 如果指定的平台不存在,platforms.get() 会返回 null,可能导致 NullPointerException

* - 建议添加平台存在性检查和错误处理

* - 每个请求都会创建新的 ChatClient 实例,适合动态配置场景

* - 流式响应需要客户端支持 SSE(Server-Sent Events)

*

* 性能考虑:

* - HashMap 查找:O(1) 时间复杂度,性能优秀

* - ChatClient 创建:每次请求都创建新实例,开销较小但可优化为缓存

* - 流式响应:内存占用低,适合长文本生成

*

* 扩展建议:

* - 添加平台存在性验证和错误处理

* - 实现 ChatClient 缓存机制,避免重复创建

* - 添加请求日志和性能监控

* - 支持平台健康检查和自动降级

* - 添加请求限流和权限控制

*

* @author Spring AI

* @see org.springframework.ai.chat.model.ChatModel

* @see org.springframework.ai.chat.client.ChatClient

* @see reactor.core.publisher.Flux

*/

@RestController

public class MorPlatformAndModelController {

/**

* 平台与 ChatModel 的映射表

*

* 使用 HashMap 存储平台名称与 ChatModel 实例的对应关系。

* 这种设计模式称为"策略模式"(Strategy Pattern),允许在运行时动态选择算法(模型)。

*

* 支持的平台:

* - "dashscope": 阿里云百炼平台(DashScopeChatModel)

* - "ollama": Ollama 本地模型平台(OllamaChatModel)

* - "deepseek": DeepSeek 平台(DeepSeekChatModel)

*

* 线程安全性:

* - HashMap 本身不是线程安全的,但在此场景下:

* 1. 初始化在构造函数中完成,只执行一次

* 2. 后续只有读操作(get),没有写操作(put/remove)

* 3. 多个请求并发读取是安全的

* - 如果需要支持动态添加/删除平台,建议使用 ConcurrentHashMap

*/

HashMap<String, ChatModel> platforms = new HashMap<>();

/**

* 构造函数:初始化多平台 ChatModel 映射

*

* 通过 Spring 的依赖注入机制,自动注入三个不同平台的 ChatModel 实现。

* 这些 ChatModel Bean 由 Spring AI 根据 application.properties 中的配置自动创建。

*

* 依赖注入原理:

* - Spring 容器启动时,会扫描所有 @Component、@Service、@Controller、@RestController 等注解的类

* - 发现构造函数参数后,会从容器中查找匹配的 Bean

* - DashScopeChatModel、DeepSeekChatModel、OllamaChatModel 由 Spring AI 自动配置类创建

* - 如果某个平台的配置缺失(如 API Key),对应的 Bean 可能无法创建,导致启动失败

*

* 配置来源:

* - DashScopeChatModel: spring.ai.dashscope.api-key 等配置

* - DeepSeekChatModel: spring.ai.deepseek.api-key 等配置

* - OllamaChatModel: spring.ai.ollama.base-url 等配置

*

* 初始化顺序:

* 1. Spring 创建三个 ChatModel Bean(如果配置正确)

* 2. 调用此构造函数,传入三个 ChatModel 实例

* 3. 将平台名称和 ChatModel 的映射关系存储到 HashMap 中

* 4. Controller 准备就绪,可以处理请求

*

* @param dashScopeChatModel 阿里云百炼平台的 ChatModel 实现

* 由 Spring AI Alibaba 自动配置创建

* @param deepSeekChatModel DeepSeek 平台的 ChatModel 实现

* 由 Spring AI DeepSeek 自动配置创建

* @param ollamaChatModel Ollama 平台的 ChatModel 实现

* 由 Spring AI Ollama 自动配置创建

*/

public MorPlatformAndModelController(

DashScopeChatModel dashScopeChatModel,

DeepSeekChatModel deepSeekChatModel,

OllamaChatModel ollamaChatModel

) {

platforms.put("dashscope", dashScopeChatModel);

platforms.put("ollama", ollamaChatModel);

platforms.put("deepseek", deepSeekChatModel);

}

/**

* 多平台多模型动态聊天接口

*

* 该接口实现了统一的多平台 AI 对话功能,支持在运行时动态选择平台、模型和参数。

* 使用流式响应(SSE)实时返回 AI 生成的文本片段,提供更好的用户体验。

*

* 请求示例:

* GET http://localhost:8080/chat?message=你好&platform=dashscope&model=qwen-turbo&temperature=0.7

*

* 参数说明:

* - message: 用户输入的对话内容(必需)

* - platform: 平台名称,可选值:dashscope、ollama、deepseek(必需)

* - model: 模型名称,如 qwen-turbo、deepseek-chat、llama2 等(可选,使用平台默认模型)

* - temperature: 温度参数,控制生成的随机性,范围 0.0-2.0(可选,使用平台默认值)

*

* 响应格式:

* - Content-Type: text/stream;charset=UTF-8

* - 响应体:Server-Sent Events (SSE) 格式的流式文本

* - 每个事件包含一个文本片段,客户端需要实时接收和显示

*

* 执行流程详解:

* 1. 参数绑定:Spring MVC 将请求参数绑定到方法参数

* - message 参数通过 @RequestParam 绑定

* - options 对象通过 @ModelAttribute 自动绑定(platform、model、temperature)

* 2. 平台选择:根据 options.getPlatform() 从 HashMap 中获取对应的 ChatModel

* 3. ChatClient 构建:

* - ChatClient.builder(chatModel) 创建 Builder,指定底层使用的 ChatModel

* - defaultOptions() 设置默认选项,这些选项会应用到所有后续的 prompt 调用

* - ChatOptions.builder() 创建选项构建器,设置 temperature 和 model

* - build() 创建最终的 ChatClient 实例

* 4. 流式调用:

* - prompt() 创建 PromptSpec,开始构建提示词

* - user(message) 添加用户消息,内部创建 UserMessage 对象

* - stream() 执行流式调用,返回 Flux

*/

@RequestMapping(value="/chat",produces = "text/stream;charset=UTF-8")

public Flux<String> chat(@RequestParam("message") String message,

@RequestParam(value = "platform",defaultValue = "dashscope") String platform,

@RequestParam(value = "model",defaultValue = "qwen-turbo") String model,

@RequestParam(value = "temperature",defaultValue = "0.7") Double temperature

) {

ChatModel chatModel = platforms.get(platform);

ChatClient.Builder builder = ChatClient.builder(chatModel);

ChatClient chatClient = builder.defaultOptions(

ChatOptions.builder()

.temperature(temperature)

.model(model)

.build()

).build();

Flux<String> content = chatClient.prompt().user(message).stream().content();

return content;

}

}测试 :GET http://localhost:8080/chat?message=你好\&platform=dashscope\&model=qwen-turbo\&temperature=0.7

结果:

提示词

在生成式人工智能中,创建提示对于开发人员来说是一项至关重要的任务。这些提示的质量和结构会显著影响人工智能输出的有效性。投入时间和精力设计周到的提示可以显著提升人工智能的成果。

例如,一项重要的研究表明,以"深呼吸,一步一步解决这个问题"作为提示开头,可以显著提高解决问题的效率。这凸显了精心选择的语言对生成式人工智能系统性能的影响。

java

// 系统提示词------预设角色

@Test

public void testSystemPrompt(@Autowired

ChatClient.Builder chatClientBuilder){

// 为chatClient设置了提示词

// 为ChatClient预设角色: 你是什么, 你能做什么, 你要注意什么, 具体应该怎么做

ChatClient chatClient = chatClientBuilder

.defaultSystem("""

# 角色说明

你是一名专业法律顾问AI......

## 回复格式

1. 问题分析

2. 相关依据

3. 梳理和建议

**特别注意:**

- 不承担律师责任。

- 不生成涉敏、虚假内容。

""")

.build();

String content = chatClient.prompt()

// .system() 只为当前对话设置系统提示词

.user("你好")

.call().content();

System.out.println(content);

}

-

SYSTEM系统角色:引导AI的行为和响应方式,设置AI如何解释和回复输入的参数或规则。这类似于在发起对话之前向Al提供指令。

-

USER用户角色:代表用户的输入------他们向AI提出的问题、命令或语句。这个角色至关重要,因为它构成了Al响应的基础。

-

ASSISTANT助手角色:AI 对用户输入的响应。它不仅仅是一个答案或反应,对于维持对话的流畅性至关重要。通过追踪 AI 之前的响应(其"助手角色"消息),系统可以确保交互的连贯性以及与上下文的相关性。助手消息也可能》中的一项特殊功能,在需要执行特定功能(例如计算、获取数掂或吴他个仅仅定对咕的任穷)时使用。

-

TOOL工具/功能角色:工具/功能角色专注于响应工具调用助手消息返回附加信息。

提示词模版,实现动态传入参数和伪系统提示词

实现动态传入参数

java

// 提示词模板

@Test

public void testSystemPromptTemplate(@Autowired

ChatClient.Builder chatClientBuilder){

ChatClient chatClient = chatClientBuilder

.defaultSystem("""

# 角色说明

你是一名专业法律顾问AI......

## 回复格式

1. 问题分析

2. 相关依据

3. 梳理和建议

**特别注意:**

- 不承担律师责任。

- 不生成涉敏、虚假内容。

当前服务的用户:

姓名:{name},年龄:{age},性别:{sex}

""")

.build();

String content = chatClient.prompt()

// .system() 只为当前对话设置系统提示词

.system(p -> p.param("name", "徐庶").param("age", "18").param("sex", "男"))

.user("你好")

.call().content();

System.out.println(content);

}

伪系统提示词

java

// 提示词模板------伪系统提示词

@Test

public void testSystemPromptTemplate2(@Autowired

ChatClient.Builder chatClientBuilder){

ChatClient chatClient = chatClientBuilder

.build();

String content = chatClient.prompt()

// .system() 只为当前对话设置系统提示词

.system(p -> p.param("name", "徐庶").param("age", "18").param("sex", "男"))

.user(u -> u.text("""

# 角色说明

你是一名专业法律顾问AI......

\s

## 回复格式

1. 问题分析

2. 相关依据

3. 梳理和建议

\s

**特别注意:**

- 不承担律师责任。

- 不生成涉敏、虚假内容。

回答用户的法律咨询问题

{question} \s

""").param("question", "被裁的补偿金"))

.call().content();

System.out.println(content);

}自定义提示词模板

/files/prompt.st

java

# 角色说明

你是一名专业法律顾问AI......

## 回复格式

1. 问题分析

2. 相关依据

3. 梳理和建议

**特别注意:**

- 不承担律师责任。

- 不生成涉敏、虚假内容。

当前服务的用户:

姓名:{name},年龄:{age},性别:{sex}

java

// 提示词模板

@Test

public void testSystemPromptTemplate(@Autowired

ChatClient.Builder chatClientBuilder,

@Value("classpath:/files/prompt.st")

Resource systemResource){

ChatClient chatClient = chatClientBuilder

.defaultSystem(systemResource)

.build();

String content = chatClient.prompt()

// .system() 只为当前对话设置系统提示词

.system(p -> p.param("name", "徐庶").param("age", "18").param("sex", "男"))

.user("你好")

.call().content();

System.out.println(content);

}提示词设置技巧

简单技巧

-

文本摘要:

- 将大量文本缩减为简洁的摘要,捕捉关键点和主要思想,同时省略不太重要的细节。

-

问答:

- 专注于根据用户提出的问题,从提供的文本中获取具体答案。它旨在精准定位并提取相关信息以响应

-

文本分类:

- 系统地将文本分类到预定义的类别或组中,分析文本并根据其内容将其分配到最合适的类别。

-

对话:

- 创建交互式对话,让人工智能可以与用户进行来回交流,模拟自然的对话流程。

-

代码生成:

- 根据特定的用户要求或描述生成功能代码片段,将自然语言指令转换为可执行代码。

高级技术

- 零样本、少样本学习:

Advisor对话拦截

Spring AI 利用面向切面的思想提供 Advisors API,它提供了灵活而强大的方法来拦截、修改和增强 Spring 应用程序中的 AI驱动交互。

Advisor对话拦截实现日志记录

java

/**

* 测试 SimpleLoggerAdvisor 日志拦截器的使用

*

* 该方法演示了如何在 ChatClient 中使用 Advisor 机制来记录 AI 对话的日志。

* Advisor 是 Spring AI 中的拦截器模式实现,允许在 ChatModel 调用前后执行自定义逻辑。

*

* SimpleLoggerAdvisor 的作用:

* - 记录请求和响应的详细信息,包括 Prompt、ChatResponse 等

* - 提供可观测性(Observability),便于调试和监控

* - 支持不同级别的日志输出(INFO、DEBUG 等)

*

* 执行流程:

* 1. 通过 ChatClient.Builder 创建 ChatClient,并配置 SimpleLoggerAdvisor

* 2. 构建用户提示词("你好")

* 3. 调用 ChatModel,此时 SimpleLoggerAdvisor 会拦截调用

* 4. Advisor 在调用前记录请求信息(Prompt、消息内容等)

* 5. ChatModel 执行实际的 AI 调用

* 6. Advisor 在调用后记录响应信息(ChatResponse、生成的内容等)

* 7. 返回 AI 生成的回复内容

*

* 底层实现原理:

* - Advisor 实现了 Advisor 接口,包含 doBefore() 和 doAfter() 方法

* - ChatClient 内部维护一个 Advisor 链,按顺序执行

* - SimpleLoggerAdvisor 使用 SLF4J 记录日志,支持标准的日志级别配置

* - 日志记录包括:请求时间、Prompt 内容、响应时间、ChatResponse 详情等

* - 可以通过日志配置控制输出级别和格式

*

* 日志配置:

* 在 application.properties 中配置日志级别:

* logging.level.org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor=DEBUG

*

* 日志输出内容(DEBUG 级别):

* - 请求前:记录 Prompt 的完整信息,包括所有消息、选项等

* - 请求后:记录 ChatResponse 的详细信息,包括生成的内容、token 使用量等

* - 性能指标:记录请求耗时、响应时间等

*

* 使用场景:

* - 开发调试:查看 AI 调用的详细过程,排查问题

* - 生产监控:记录 AI 调用的日志,用于分析和审计

* - 性能分析:通过日志分析 AI 调用的性能指标

* - 问题排查:当 AI 回复异常时,通过日志定位问题

*

* Advisor 链的执行顺序:

* - 多个 Advisor 按添加顺序执行

* - 每个 Advisor 的 doBefore() 按顺序执行

* - ChatModel 调用执行

* - 每个 Advisor 的 doAfter() 按逆序执行(类似 AOP 的环绕通知)

*

* 与其他 Advisor 的区别:

* - SimpleLoggerAdvisor:仅用于日志记录,不修改请求或响应

* - SafeGuardAdvisor:用于内容安全检查,可以拦截或修改请求

* - PromptChatMemoryAdvisor:用于管理对话记忆,自动添加历史消息

* - QuestionAnswerAdvisor:用于 RAG 场景,在请求前添加相关文档

*

* 注意事项:

* - 日志级别设置为 DEBUG 才能看到详细信息,INFO 级别只显示摘要

* - 生产环境建议使用 INFO 级别,避免日志过多影响性能

* - SimpleLoggerAdvisor 是线程安全的,可以在多线程环境中使用

* - 可以通过 SimpleLoggerAdvisor.builder() 自定义日志格式和级别

*

* 示例日志输出(DEBUG 级别):

* <pre>

* DEBUG SimpleLoggerAdvisor - Before call: Prompt{...}

* DEBUG SimpleLoggerAdvisor - After call: ChatResponse{...}

* </pre>

*

* @param chatClientBuilder 自动注入的 ChatClient.Builder Bean,由 Spring AI 根据配置自动创建

*

* @see org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor

* @see org.springframework.ai.chat.client.advisor.Advisor

*/

// 日志拦截件: logging.level.org.springframework.ai.chat.client.advisor= DEBUG

@Test

public void testLoggerAdvisor(@Autowired

ChatClient.Builder chatClientBuilder) {

ChatClient chatClient = chatClientBuilder

.defaultAdvisors(new SimpleLoggerAdvisor())

.build();

String content = chatClient.prompt()

.user("你好")

.call()

.content();

System.out.println(content);

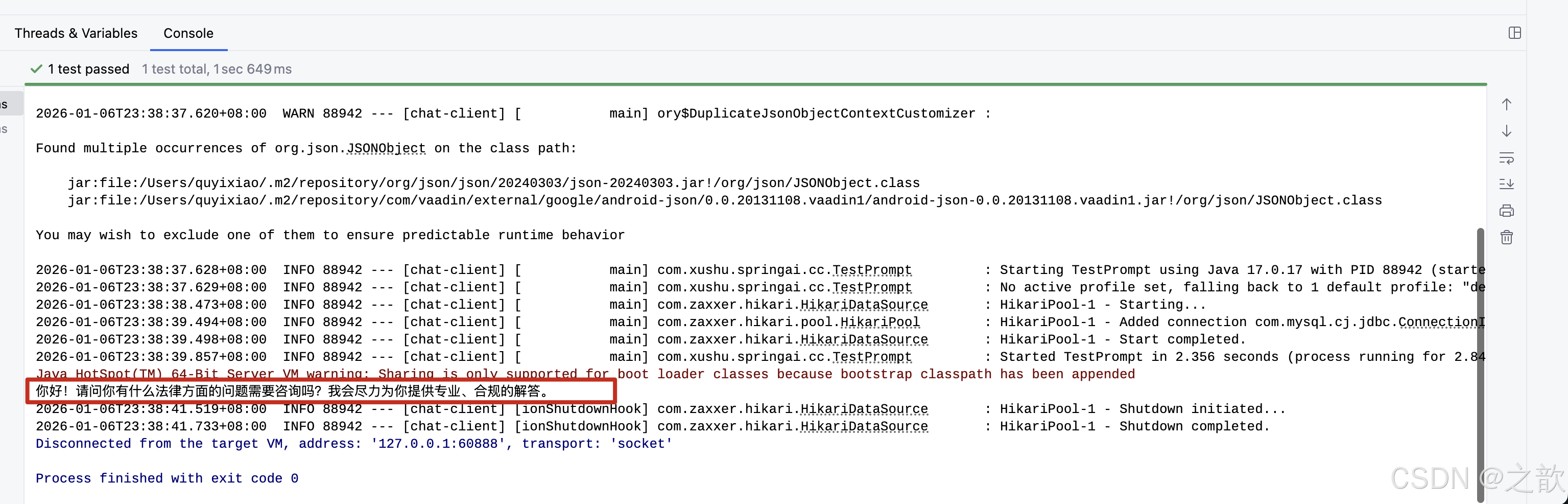

}结果输出:

java

2026-01-07T00:11:00.211+08:00 DEBUG 98058 --- [chat-client] [ main] o.s.a.c.c.advisor.SimpleLoggerAdvisor : request: ChatClientRequest[prompt=Prompt{messages=[UserMessage{content='你好', properties={messageType=USER}, messageType=USER}], modelOptions=DashScopeChatOptions: {"model":"qwen-plus","temperature":0.8,"enable_search":false,"incremental_output":true,"enable_thinking":false,"multi_model":false}}, context={}]

2026-01-07T00:11:01.759+08:00 DEBUG 98058 --- [chat-client] [ main] o.s.a.c.c.advisor.SimpleLoggerAdvisor : response: {

"result" : {

"output" : {

"messageType" : "ASSISTANT",

"metadata" : {

"finishReason" : "STOP",

"role" : "ASSISTANT",

"id" : "1b5c9422-1984-4660-b125-09af717c4e10",

"messageType" : "ASSISTANT",

"reasoningContent" : ""

},

"toolCalls" : [ ],

"media" : [ ],

"text" : "你好!有什么问题我可以帮助你吗?😊"

},

"metadata" : {

"finishReason" : "STOP",

"contentFilters" : [ ],

"empty" : true

}

},

"results" : [ {

"output" : {

"messageType" : "ASSISTANT",

"metadata" : {

"finishReason" : "STOP",

"role" : "ASSISTANT",

"id" : "1b5c9422-1984-4660-b125-09af717c4e10",

"messageType" : "ASSISTANT",

"reasoningContent" : ""

},

"toolCalls" : [ ],

"media" : [ ],

"text" : "你好!有什么问题我可以帮助你吗?😊"

},

"metadata" : {

"finishReason" : "STOP",

"contentFilters" : [ ],

"empty" : true

}

} ],

"metadata" : {

"id" : "1b5c9422-1984-4660-b125-09af717c4e10",

"model" : "",

"rateLimit" : {

"requestsLimit" : 0,

"requestsRemaining" : 0,

"requestsReset" : 0.0,

"tokensLimit" : 0,

"tokensRemaining" : 0,

"tokensReset" : 0.0

},

"usage" : {

"promptTokens" : 9,

"completionTokens" : 10,

"totalTokens" : 19,

"nativeUsage" : {

"output_tokens" : 10,

"input_tokens" : 9,

"total_tokens" : 19

}

},

"promptMetadata" : [ ],

"empty" : true

}

}

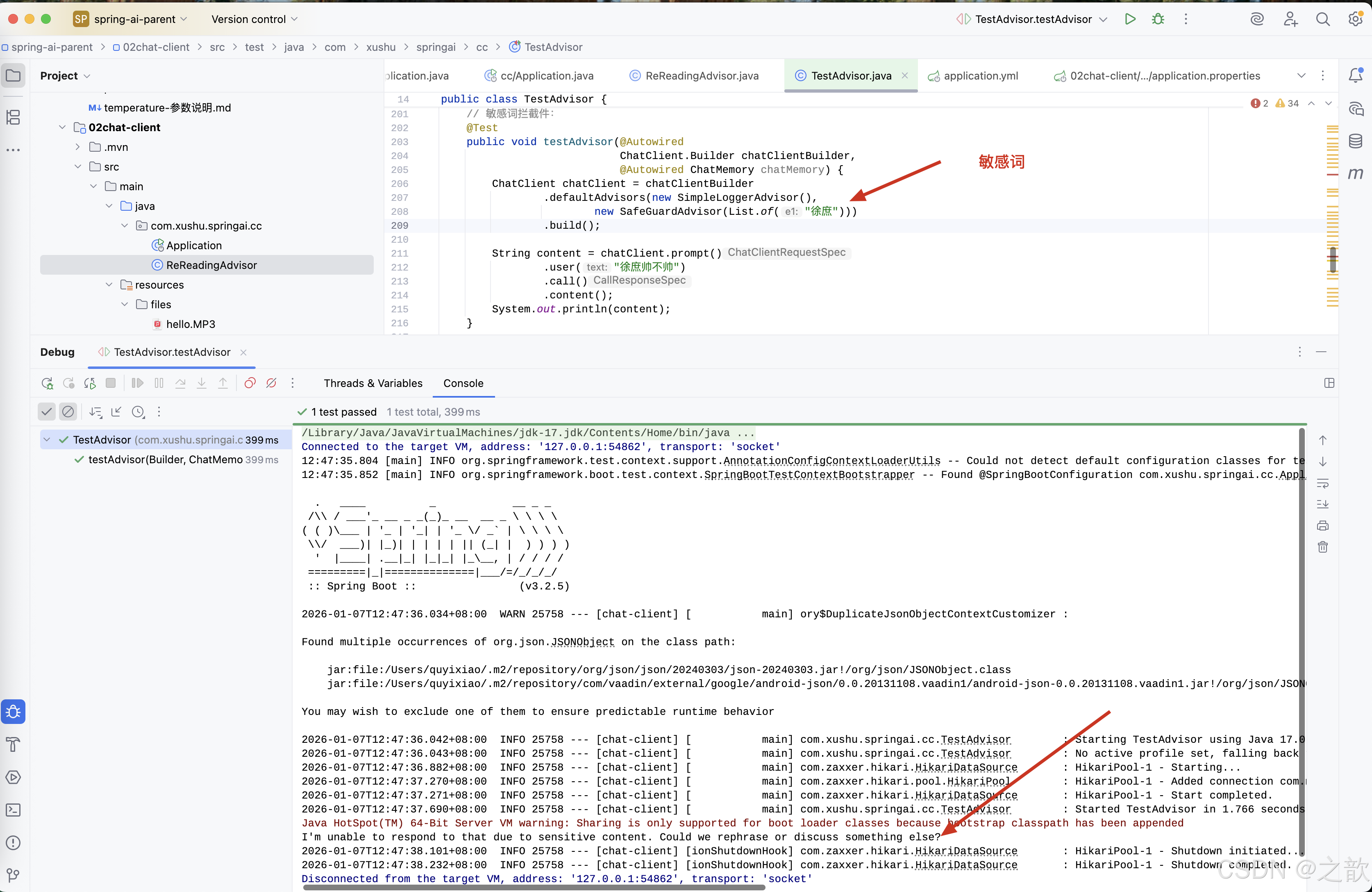

你好!有什么问题我可以帮助你吗?😊通过advisor实现敏感词拦截

java

/**

* 测试 SafeGuardAdvisor 敏感词拦截器的使用

*

* 该方法演示了如何在 ChatClient 中使用多个 Advisor 组合,特别是 SafeGuardAdvisor

* 来实现内容安全检查功能。SafeGuardAdvisor 可以在 AI 调用前检查并过滤敏感词,

* 防止不当内容被发送给 AI 模型或返回给用户。

*

* SafeGuardAdvisor 的作用:

* - 内容安全检查:在请求发送给 AI 前检查用户输入是否包含敏感词

* - 响应内容过滤:在响应返回给用户前检查 AI 回复是否包含敏感词

* - 可配置的拦截策略:支持自定义敏感词列表和拦截行为

* - 安全防护:防止恶意输入或不当内容通过 AI 系统传播

*

* 执行流程:

* 1. 通过 ChatClient.Builder 创建 ChatClient,配置 SimpleLoggerAdvisor 和 SafeGuardAdvisor

* 2. 构建用户提示词("徐庶帅不帅"),其中包含敏感词 "徐庶"

* 3. SimpleLoggerAdvisor.doBefore() 执行,记录请求日志

* 4. SafeGuardAdvisor.doBefore() 执行,检查用户输入是否包含敏感词

* 5. 如果包含敏感词,SafeGuardAdvisor 可以:

* - 拦截请求,直接返回拒绝消息,不调用 AI

* - 替换敏感词后继续调用 AI

* - 抛出异常,终止请求

* 6. 如果通过检查,ChatModel 执行实际的 AI 调用

* 7. SafeGuardAdvisor.doAfter() 执行,检查 AI 响应是否包含敏感词

* 8. SimpleLoggerAdvisor.doAfter() 执行,记录响应日志

* 9. 返回处理后的回复内容

*

* 底层实现原理:

* - SafeGuardAdvisor 实现了 Advisor 接口,包含 doBefore() 和 doAfter() 方法

* - doBefore() 方法检查 ChatClientRequest 中的用户消息内容

* - 使用字符串匹配算法(如包含检查、正则表达式等)检测敏感词

* - 如果检测到敏感词,可以修改请求内容或返回拒绝响应

* - doAfter() 方法检查 ChatClientResponse 中的 AI 回复内容

* - 如果 AI 回复包含敏感词,可以过滤或替换相关内容

*

* Advisor 链的执行顺序:

* 本方法中配置了两个 Advisor:

* 1. SimpleLoggerAdvisor:用于记录日志,不修改请求或响应

* 2. SafeGuardAdvisor:用于内容安全检查,可以拦截或修改请求/响应

*

* 执行顺序:

* - SimpleLoggerAdvisor.doBefore() → SafeGuardAdvisor.doBefore() →

* ChatModel 调用 → SafeGuardAdvisor.doAfter() → SimpleLoggerAdvisor.doAfter()

*

* 敏感词检测机制:

* - 构造 SafeGuardAdvisor 时传入敏感词列表:List.of("徐庶")

* - 检测时会检查用户输入和 AI 响应中是否包含列表中的任何敏感词

* - 检测方式可以是精确匹配、包含匹配或正则表达式匹配

* - 支持大小写敏感或不敏感的检测

*

* 拦截行为:

* - 默认行为:当检测到敏感词时,SafeGuardAdvisor 会拦截请求

* - 可以配置为返回默认的拒绝消息,如 "内容包含敏感词,无法处理"

* - 也可以配置为抛出异常,由上层处理

* - 某些场景下可以配置为替换敏感词后继续处理

*

* 使用场景:

* - 内容审核:防止不当内容通过 AI 系统传播

* - 合规性检查:确保 AI 回复符合法律法规要求

* - 品牌保护:防止提及竞争对手或敏感品牌

* - 隐私保护:防止泄露敏感信息或个人隐私

* - 安全防护:防止恶意输入攻击 AI 系统

*

* 与其他 Advisor 的配合:

* - SimpleLoggerAdvisor:记录拦截事件,便于审计和调试

* - PromptChatMemoryAdvisor:在安全检查后管理对话记忆

* - 自定义 Advisor:可以组合多个 Advisor 实现复杂的安全策略

*

* 注意事项:

* - 敏感词列表需要根据业务需求定期更新

* - 过于严格的过滤可能影响用户体验,需要平衡安全性和可用性

* - 敏感词检测可能有性能开销,特别是敏感词列表很大时

* - 某些场景下,AI 可能会用同义词或变体绕过检测,需要更智能的检测机制

* - SafeGuardAdvisor 是线程安全的,可以在多线程环境中使用

* - 建议在生产环境中结合日志记录,便于追踪和审计

*

* 性能考虑:

* - 敏感词检测在每次请求时都会执行,可能影响响应时间

* - 对于大量敏感词,建议使用高效的字符串匹配算法(如 Trie 树)

* - 可以考虑异步检测或缓存机制来优化性能

*

* 扩展性:

* - 可以继承 SafeGuardAdvisor 实现自定义的检测逻辑

* - 可以集成外部内容审核服务(如阿里云内容安全、腾讯云内容安全等)

* - 可以结合机器学习模型实现更智能的内容检测

*

* 示例场景:

* 本测试中,用户输入 "徐庶帅不帅" 包含敏感词 "徐庶",

* SafeGuardAdvisor 会检测到并拦截请求,可能返回拒绝消息或抛出异常。

* 实际行为取决于 SafeGuardAdvisor 的配置。

*

* @param chatClientBuilder 自动注入的 ChatClient.Builder Bean,由 Spring AI 根据配置自动创建

* @param chatMemory 自动注入的 ChatMemory Bean(虽然本方法中未使用,但保留以保持接口一致性)

*

* @see org.springframework.ai.chat.client.advisor.SafeGuardAdvisor

* @see org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor

* @see org.springframework.ai.chat.client.advisor.Advisor

*/

// 敏感词拦截件:

@Test

public void testAdvisor(@Autowired

ChatClient.Builder chatClientBuilder,

@Autowired ChatMemory chatMemory) {

ChatClient chatClient = chatClientBuilder

.defaultAdvisors(new SimpleLoggerAdvisor(),

new SafeGuardAdvisor(List.of("徐庶")))

.build();

String content = chatClient.prompt()

.user("徐庶帅不帅")

.call()

.content();

System.out.println(content);

}

通过自定义拦截器实现重reread重读

自定义拦截:

重读(Re2)

重读策略的核心在于让LLMs重新审视输入问题,这借鉴了人类解决问题的思维方式。通过这种方式, LLMs能够更深入地理解问题,发现复杂的模式,从而在各种推理任务中表现得更加强大。

可以基于BaseAdvisor来实现自定义Advisor,他实现了重复的代码提供模板方法让我们可以专注自己业务编写即可。

java

package com.xushu.springai.cc;

import org.springframework.ai.chat.client.ChatClientRequest;

import org.springframework.ai.chat.client.ChatClientResponse;

import org.springframework.ai.chat.client.advisor.api.*;

import org.springframework.ai.chat.prompt.Prompt;

import org.springframework.ai.chat.prompt.PromptTemplate;

import java.util.Map;

/**

* 重新阅读提示词拦截器(ReReadingAdvisor)

*

* <p>这是一个自定义的 Advisor 实现,用于通过提示工程(Prompt Engineering)技巧

* 增强 AI 模型对用户问题的理解能力。该 Advisor 在用户问题前添加"重新阅读问题"的指令,

* 引导 AI 模型更仔细地理解问题,从而提高回答的准确性和相关性。

*

* <p><b>核心原理:</b>

* <ul>

* <li>通过重复用户问题,让 AI 模型有更多机会理解问题的关键信息</li>

* <li>使用明确的指令("Read the question again")引导模型重新审视问题</li>

* <li>激活模型的注意力机制,提高对问题细节的关注度</li>

* <li>减少对复杂或容易产生歧义问题的误解可能性</li>

* </ul>

*

* <p><b>工作流程:</b>

* <ol>

* <li>在 ChatModel 调用前,before() 方法被触发</li>

* <li>提取用户原始提示词内容</li>

* <li>使用 PromptTemplate 将原始问题包装成新格式:

* <pre>

* 原始问题

* Read the question again: 原始问题

* </pre>

* </li>

* <li>创建新的 ChatClientRequest,替换原始 Prompt</li>

* <li>返回修改后的请求,继续 Advisor 链的执行</li>

* <li>在 ChatModel 调用后,after() 方法直接返回响应,不做修改</li>

* </ol>

*

* <p><b>使用场景:</b>

* <ul>

* <li>复杂问题:当问题包含多个部分或需要仔细分析时</li>

* <li>容易误解的问题:当问题可能被 AI 误解或忽略关键信息时</li>

* <li>提高准确性:需要 AI 给出更准确、更符合问题意图的回答时</li>

* <li>多轮对话:在对话中需要确保 AI 正确理解当前问题时</li>

* </ul>

*

* <p><b>注意事项:</b>

* <ul>

* <li>会增加 token 使用量(因为问题被重复了),可能增加 API 调用成本</li>

* <li>对于简单明确的问题,可能不需要使用此 Advisor</li>

* <li>可以与其他 Advisor 组合使用,形成 Advisor 链</li>

* <li>执行顺序由 getOrder() 方法决定,当前返回 0(较早执行)</li>

* </ul>

*

* <p><b>示例:</b>

* <pre>

* // 原始用户问题

* "徐庶帅不帅"

*

* // 经过 ReReadingAdvisor 处理后的提示词

* "徐庶帅不帅

* Read the question again: 徐庶帅不帅"

* </pre>

*

* <p><b>与其他 Advisor 的区别:</b>

* <ul>

* <li>SimpleLoggerAdvisor:仅用于日志记录,不修改请求内容</li>

* <li>SafeGuardAdvisor:用于内容安全检查,可以拦截包含敏感词的问题</li>

* <li>ReReadingAdvisor:用于增强问题理解,通过提示工程技巧提高回答质量</li>

* <li>PromptChatMemoryAdvisor:用于管理对话记忆,自动添加历史消息</li>

* </ul>

*

* @author xushu

* @see org.springframework.ai.chat.client.advisor.api.BaseAdvisor

* @see org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor

* @see org.springframework.ai.chat.client.advisor.SafeGuardAdvisor

* @since 1.0

*/

public class ReReadingAdvisor implements BaseAdvisor {

/**

* 默认的用户提示词增强模板

*

* <p>该模板定义了如何包装用户原始问题,格式为:

* <pre>

* {原始问题}

* Read the question again: {原始问题}

* </pre>

*

* <p>模板变量说明:

* <ul>

* <li>{re2_input_query}:用户原始输入的问题内容</li>

* </ul>

*

* <p>该模板会在 before() 方法中使用 PromptTemplate 进行渲染,

* 将用户原始问题替换到模板变量中,生成增强后的提示词。

*/

private static final String DEFAULT_USER_TEXT_ADVISE = """

{re2_input_query}

Read the question again: {re2_input_query}

""";

/**

* 在 ChatModel 调用前执行,修改用户提示词以增强问题理解

*

* <p>该方法实现了 Advisor 的拦截逻辑,在 AI 模型处理请求之前,

* 将用户的原始问题包装成包含"重新阅读"指令的增强格式。

*

* <p><b>执行步骤:</b>

* <ol>

* <li>从 ChatClientRequest 中提取用户原始提示词内容</li>

* <li>使用 PromptTemplate 和 DEFAULT_USER_TEXT_ADVISE 模板渲染新提示词</li>

* <li>创建新的 Prompt 对象,包含增强后的提示词</li>

* <li>使用 mutate() 方法创建新的 ChatClientRequest,替换原始 Prompt</li>

* <li>返回修改后的请求,继续 Advisor 链的执行</li>

* </ol>

*

* <p><b>提示词转换示例:</b>

* <pre>

* 输入:"徐庶帅不帅"

* 输出:"徐庶帅不帅\nRead the question again: 徐庶帅不帅"

* </pre>

*

* <p><b>注意事项:</b>

* <ul>

* <li>该方法会修改请求内容,增加 token 使用量</li>

* <li>使用 mutate() 方法确保不修改原始请求对象,保持不可变性</li>

* <li>如果原始提示词为空或 null,可能会导致异常</li>

* </ul>

*

* @param chatClientRequest 原始的 ChatClient 请求对象,包含用户提示词等信息

* @param advisorChain Advisor 链对象,用于继续执行后续 Advisor

* @return 修改后的 ChatClientRequest,包含增强后的提示词

* @see org.springframework.ai.chat.client.ChatClientRequest

* @see org.springframework.ai.chat.client.advisor.api.AdvisorChain

*/

@Override

public ChatClientRequest before(ChatClientRequest chatClientRequest, AdvisorChain advisorChain) {

// 从请求中提取用户原始提示词内容

String contents = chatClientRequest.prompt().getContents();

// 使用 PromptTemplate 将原始问题包装成增强格式

// 模板会将 {re2_input_query} 替换为实际的用户问题

String re2InputQuery = PromptTemplate.builder().template(DEFAULT_USER_TEXT_ADVISE).build()

.render(Map.of("re2_input_query", contents));

// 创建新的 ChatClientRequest,使用增强后的提示词替换原始 Prompt

// 使用 mutate() 方法确保不修改原始请求对象

ChatClientRequest clientRequest = chatClientRequest.mutate()

.prompt(Prompt.builder().content(re2InputQuery).build())

.build();

return clientRequest;

}

/**

* 在 ChatModel 调用后执行,处理响应结果

*

* <p>该方法在 AI 模型处理完请求并返回响应后执行。对于 ReReadingAdvisor,

* 该方法不做任何修改,直接返回原始响应,因为该 Advisor 的主要作用

* 是在请求前增强提示词,而不是修改响应内容。

*

* <p><b>设计说明:</b>

* <ul>

* <li>ReReadingAdvisor 专注于请求前的提示词增强,不处理响应</li>

* <li>如果需要修改响应,可以在此方法中实现相应逻辑</li>

* <li>直接返回原始响应,保持响应内容不变</li>

* </ul>

*

* @param chatClientResponse ChatModel 返回的响应对象,包含 AI 生成的内容等信息

* @param advisorChain Advisor 链对象,用于继续执行后续 Advisor

* @return 原始响应对象,不做任何修改

* @see org.springframework.ai.chat.client.ChatClientResponse

* @see org.springframework.ai.chat.client.advisor.api.AdvisorChain

*/

@Override

public ChatClientResponse after(ChatClientResponse chatClientResponse, AdvisorChain advisorChain) {

return chatClientResponse;

}

/**

* 获取 Advisor 的执行顺序

*

* <p>该方法返回 Advisor 在 Advisor 链中的执行顺序。顺序值越小,越早执行。

* 对于 ReReadingAdvisor,返回 0 表示它在 Advisor 链中会较早执行,

* 确保在请求发送给 AI 模型之前完成提示词的增强处理。

*

* <p><b>执行顺序说明:</b>

* <ul>

* <li>多个 Advisor 的 before() 方法按 order 值从小到大顺序执行</li>

* <li>多个 Advisor 的 after() 方法按 order 值从大到小逆序执行</li>

* <li>order 值相同时,按添加顺序执行</li>

* </ul>

*

* <p><b>与其他 Advisor 的顺序关系:</b>

* <ul>

* <li>通常应该在日志 Advisor(如 SimpleLoggerAdvisor)之后执行,

* 以便日志记录的是增强后的提示词</li>

* <li>应该在内容安全 Advisor(如 SafeGuardAdvisor)之前执行,

* 以便安全检查针对增强后的提示词</li>

* <li>应该在记忆 Advisor(如 PromptChatMemoryAdvisor)之前执行,

* 以便记忆管理基于增强后的提示词</li>

* </ul>

*

* <p><b>注意事项:</b>

* <ul>

* <li>如果需要调整执行顺序,可以修改返回值</li>

* <li>建议根据业务需求合理设置 order 值,确保 Advisor 链的正确执行</li>

* </ul>

*

* @return Advisor 的执行顺序,当前返回 0(较早执行)

* @see org.springframework.ai.chat.client.advisor.api.BaseAdvisor#getOrder()

*/

@Override

public int getOrder() {

return 0;

}

}编写测试类 :

java

/**

* 测试 ReReadingAdvisor 重新阅读提示词拦截器的使用

*

* 该方法演示了如何使用自定义的 ReReadingAdvisor 来增强 AI 模型对问题的理解能力。

* ReReadingAdvisor 是一个提示工程(Prompt Engineering)技巧的实现,通过在用户问题前

* 添加"重新阅读问题"的指令,引导 AI 模型更仔细地理解问题,从而提高回答的准确性。

*

* ReReadingAdvisor 的作用机制:

* - 在调用 ChatModel 之前,拦截用户的原始提示词

* - 使用 PromptTemplate 将原始问题包装成新的提示词格式

* - 新格式为:原始问题 + "Read the question again: " + 原始问题

* - 通过重复问题和明确的"重新阅读"指令,强化 AI 对问题的关注度

*

* 执行流程:

* 1. 通过 ChatClient.Builder 创建 ChatClient,配置 SimpleLoggerAdvisor 和 ReReadingAdvisor

* 2. 构建用户提示词("徐庶帅不帅")

* 3. ReReadingAdvisor 的 before() 方法拦截请求

* 4. 将原始问题转换为:

* <pre>

* 徐庶帅不帅

* Read the question again: 徐庶帅不帅

* </pre>

* 5. SimpleLoggerAdvisor 记录修改后的请求(如果日志级别为 DEBUG)

* 6. ChatModel 执行 AI 调用,使用增强后的提示词

* 7. 返回 AI 生成的回复内容

*

* 提示工程原理:

* - 重复问题:通过重复用户问题,让 AI 模型有更多机会理解问题的关键信息

* - 明确指令:使用 "Read the question again" 这样的明确指令,引导模型重新审视问题

* - 注意力机制:重复和指令可以激活模型的注意力机制,提高对问题细节的关注

* - 减少误解:对于复杂或容易产生歧义的问题,重新阅读可以减少误解的可能性

*

* 使用场景:

* - 复杂问题:当问题包含多个部分或需要仔细分析时

* - 容易误解的问题:当问题可能被 AI 误解或忽略关键信息时

* - 提高准确性:需要 AI 给出更准确、更符合问题意图的回答时

* - 多轮对话:在对话中需要确保 AI 正确理解当前问题时

*

* 与其他 Advisor 的区别:

* - SimpleLoggerAdvisor:仅用于日志记录,不修改请求内容

* - SafeGuardAdvisor:用于内容安全检查,可以拦截包含敏感词的问题

* - ReReadingAdvisor:用于增强问题理解,通过提示工程技巧提高回答质量

* - PromptChatMemoryAdvisor:用于管理对话记忆,自动添加历史消息

*

* 注意事项:

* - ReReadingAdvisor 会增加 token 使用量(因为问题被重复了)

* - 对于简单明确的问题,可能不需要使用此 Advisor

* - 可以与其他 Advisor 组合使用,形成 Advisor 链

* - 执行顺序由 getOrder() 方法决定,ReReadingAdvisor 的 order 为 0

*

* 示例效果:

* 原始问题:"徐庶帅不帅"

* 增强后的问题:

* <pre>

* 徐庶帅不帅

* Read the question again: 徐庶帅不帅

* </pre>

*

* 这样可以让 AI 模型更仔细地理解问题,可能产生更准确或更详细的回答。

*

* @param chatClientBuilder 自动注入的 ChatClient.Builder Bean,由 Spring AI 根据配置自动创建

*

* @see com.xushu.springai.cc.ReReadingAdvisor

* @see org.springframework.ai.chat.client.advisor.SimpleLoggerAdvisor

*/

@Test

public void testReReadingAdvisor(@Autowired

ChatClient.Builder chatClientBuilder) {

ChatClient chatClient = chatClientBuilder

.defaultAdvisors(new SimpleLoggerAdvisor(),

new ReReadingAdvisor())

.build();

String content = chatClient.prompt()

.user("徐庶帅不帅")

.call()

.content();

System.out.println(content);

}结果输出:

java

2026-01-07T12:48:49.338+08:00 DEBUG 26043 --- [chat-client] [ main] o.s.a.c.c.advisor.SimpleLoggerAdvisor : request: ChatClientRequest[prompt=Prompt{messages=[UserMessage{content='徐庶帅不帅

Read the question again: 徐庶帅不帅

', properties={messageType=USER}, messageType=USER}], modelOptions=null}, context={}]

2026-01-07T12:48:56.067+08:00 DEBUG 26043 --- [chat-client] [ main] o.s.a.c.c.advisor.SimpleLoggerAdvisor : response: {

"result" : {

"metadata" : {

"finishReason" : "STOP",

"contentFilters" : [ ],

"empty" : true

},

"output" : {

"messageType" : "ASSISTANT",

"metadata" : {

"finishReason" : "STOP",

"role" : "ASSISTANT",

"id" : "5ab929c0-b1c5-4222-9ce0-4fc5d3a1c5f8",

"messageType" : "ASSISTANT",

"reasoningContent" : ""

},

"toolCalls" : [ ],

"media" : [ ],

"text" : ""徐庶帅不帅"这个问题中的"帅"可以有两种理解:一种是外貌上的"帅气",另一种是能力、才华上的"厉害"。\n\n从历史角度来看,徐庶是三国时期著名的谋士,本名徐福,字元直。他是刘备早期的重要谋士之一,以智谋著称。虽然史书没有详细记载他的外貌,但从《三国志》等史料来看,他为人清廉正直、才智出众,曾推荐诸葛亮给刘备,有"走马荐诸葛"的美谈。\n\n所以:\n\n- 如果问"徐庶外貌帅不帅"------史无明载,无法考证,但古人评价人物更重德才,"帅"不只是脸。\n- 如果问"徐庶厉不厉害(帅不帅)"------那当然"帅"!他智谋过人、识大体、知进退,是真正的高人。\n\n结论:徐庶不仅"帅",而且是智慧与品格兼备的"真帅"!\n\n用一句话总结: \n**"徐庶不靠脸吃饭,靠的是脑子和格局------这比'帅'更帅!"** 😎"

}

},

"metadata" : {

"id" : "5ab929c0-b1c5-4222-9ce0-4fc5d3a1c5f8",

"model" : "",

"rateLimit" : {

"requestsLimit" : 0,

"requestsRemaining" : 0,

"requestsReset" : 0.0,

"tokensLimit" : 0,

"tokensRemaining" : 0,

"tokensReset" : 0.0

},

"usage" : {

"promptTokens" : 26,

"completionTokens" : 245,

"totalTokens" : 271,

"nativeUsage" : {

"output_tokens" : 245,

"input_tokens" : 26,

"total_tokens" : 271

}

},

"promptMetadata" : [ ],

"empty" : true

},

"results" : [ {

"metadata" : {

"finishReason" : "STOP",

"contentFilters" : [ ],

"empty" : true

},

"output" : {

"messageType" : "ASSISTANT",

"metadata" : {

"finishReason" : "STOP",

"role" : "ASSISTANT",

"id" : "5ab929c0-b1c5-4222-9ce0-4fc5d3a1c5f8",

"messageType" : "ASSISTANT",

"reasoningContent" : ""

},

"toolCalls" : [ ],

"media" : [ ],

"text" : ""徐庶帅不帅"这个问题中的"帅"可以有两种理解:一种是外貌上的"帅气",另一种是能力、才华上的"厉害"。\n\n从历史角度来看,徐庶是三国时期著名的谋士,本名徐福,字元直。他是刘备早期的重要谋士之一,以智谋著称。虽然史书没有详细记载他的外貌,但从《三国志》等史料来看,他为人清廉正直、才智出众,曾推荐诸葛亮给刘备,有"走马荐诸葛"的美谈。\n\n所以:\n\n- 如果问"徐庶外貌帅不帅"------史无明载,无法考证,但古人评价人物更重德才,"帅"不只是脸。\n- 如果问"徐庶厉不厉害(帅不帅)"------那当然"帅"!他智谋过人、识大体、知进退,是真正的高人。\n\n结论:徐庶不仅"帅",而且是智慧与品格兼备的"真帅"!\n\n用一句话总结: \n**"徐庶不靠脸吃饭,靠的是脑子和格局------这比'帅'更帅!"** 😎"

}

} ]

}

"徐庶帅不帅"这个问题中的"帅"可以有两种理解:一种是外貌上的"帅气",另一种是能力、才华上的"厉害"。

从历史角度来看,徐庶是三国时期著名的谋士,本名徐福,字元直。他是刘备早期的重要谋士之一,以智谋著称。虽然史书没有详细记载他的外貌,但从《三国志》等史料来看,他为人清廉正直、才智出众,曾推荐诸葛亮给刘备,有"走马荐诸葛"的美谈。

所以:

- 如果问"徐庶外貌帅不帅"------史无明载,无法考证,但古人评价人物更重德才,"帅"不只是脸。

- 如果问"徐庶厉不厉害(帅不帅)"------那当然"帅"!他智谋过人、识大体、知进退,是真正的高人。

结论:徐庶不仅"帅",而且是智慧与品格兼备的"真帅"!

用一句话总结:

**"徐庶不靠脸吃饭,靠的是脑子和格局------这比'帅'更帅!"** 😎advisor源码责任链模式

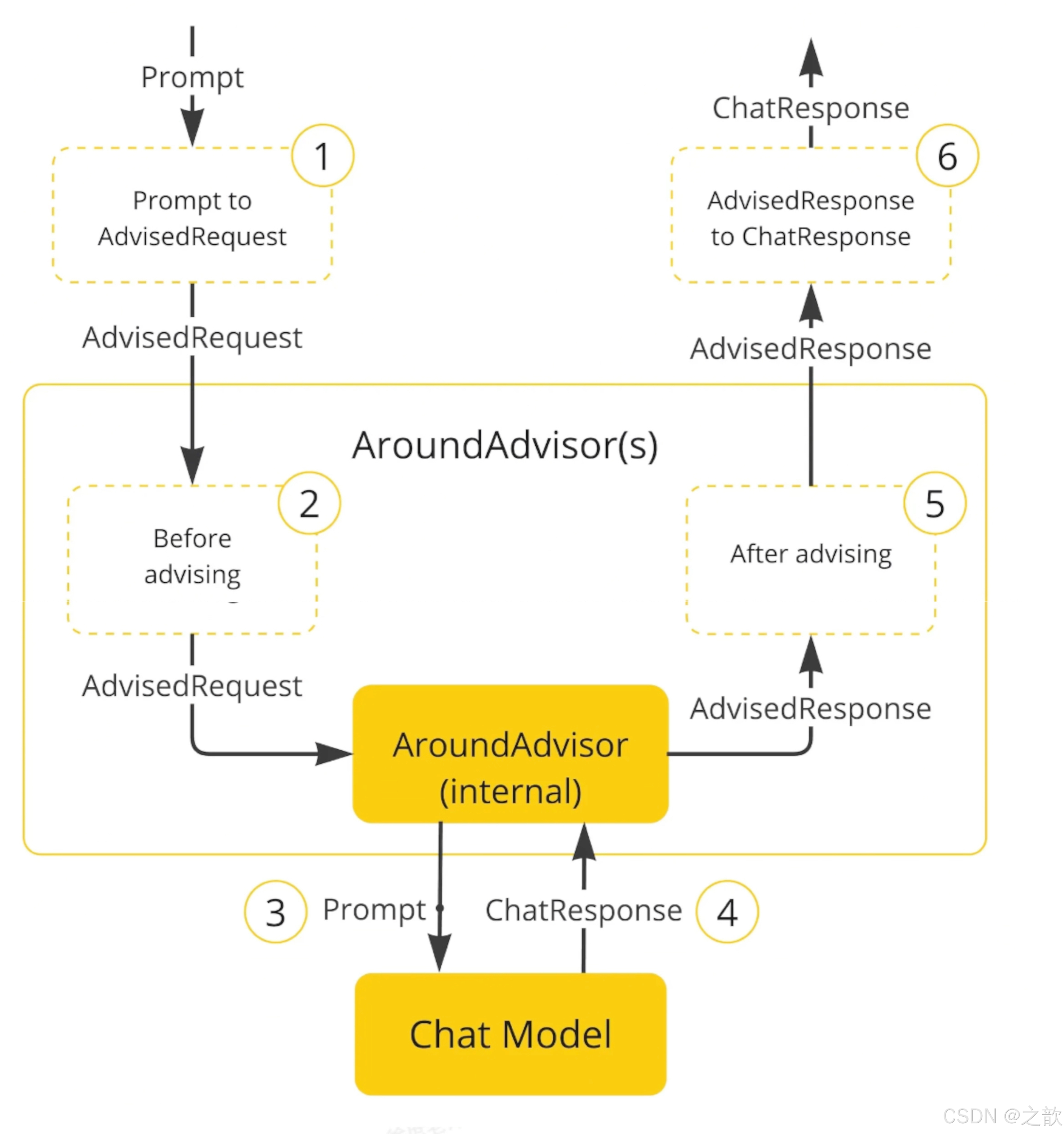

Spring AI Advisor 责任链模式源码分析

一、责任链模式概述

1.1 设计模式定义

责任链模式(Chain of Responsibility Pattern)是一种行为设计模式,它允许你将请求沿着处理者链传递,直到有一个处理者处理它为止。

1.2 在 Spring AI 中的应用

Spring AI 使用责任链模式实现 Advisor 机制,允许在 ChatModel 调用前后执行多个拦截器(Advisor),每个 Advisor 可以:

- 修改请求(Request)

- 修改响应(Response)

- 记录日志

- 执行安全检查

- 管理对话记忆

- 等等

二、核心接口和类

2.1 BaseAdvisor 接口

java

public interface BaseAdvisor {

/**

* 在 ChatModel 调用前执行

* @param request 原始请求

* @param chain Advisor 链,用于继续执行后续 Advisor

* @return 修改后的请求(可以返回原始请求或修改后的请求)

*/

ChatClientRequest before(ChatClientRequest request, AdvisorChain chain);

/**

* 在 ChatModel 调用后执行

* @param response 原始响应

* @param chain Advisor 链,用于继续执行后续 Advisor

* @return 修改后的响应(可以返回原始响应或修改后的响应)

*/

ChatClientResponse after(ChatClientResponse response, AdvisorChain chain);

/**

* 获取 Advisor 的执行顺序

* 值越小,越早执行

* @return 执行顺序

*/

int getOrder();

}2.2 AdvisorChain 接口(推测实现)

java

public interface AdvisorChain {

/**

* 继续执行下一个 Advisor 的 before() 方法

* @param request 当前请求

* @return 处理后的请求

*/

ChatClientRequest nextBefore(ChatClientRequest request);

/**

* 继续执行下一个 Advisor 的 after() 方法

* @param response 当前响应

* @return 处理后的响应

*/

ChatClientResponse nextAfter(ChatClientResponse response);

/**

* 执行 ChatModel 调用

* @param request 最终处理后的请求

* @return ChatModel 返回的响应

*/

ChatClientResponse invoke(ChatClientRequest request);

}三、责任链执行流程

3.1 完整执行流程图

用户调用 chatClient.prompt().user("问题").call()

↓

ChatClient 内部构建 Advisor 链

↓

按 order 排序 Advisor 列表

↓

创建 AdvisorChain 实例(包含 Advisor 列表和当前索引)

↓

开始执行责任链:

↓

┌─────────────────────────────────────────────────────────┐

│ 阶段1: Before 阶段(按 order 从小到大顺序执行) │

└─────────────────────────────────────────────────────────┘

↓

Advisor1.before(request, chain)

├─ 处理请求(如:记录日志、修改提示词等)

├─ 调用 chain.nextBefore(modifiedRequest)

│ └─ Advisor2.before(modifiedRequest, chain)

│ ├─ 处理请求

│ ├─ 调用 chain.nextBefore(modifiedRequest)

│ │ └─ Advisor3.before(modifiedRequest, chain)

│ │ └─ ... 继续链式调用

│ └─ 返回处理后的请求

└─ 返回处理后的请求

↓

┌─────────────────────────────────────────────────────────┐

│ 阶段2: ChatModel 调用 │

└─────────────────────────────────────────────────────────┘

↓

chain.invoke(finalRequest)

↓

ChatModel.call(finalRequest)

↓

返回 ChatClientResponse

↓

┌─────────────────────────────────────────────────────────┐

│ 阶段3: After 阶段(按 order 从大到小逆序执行) │

└─────────────────────────────────────────────────────────┘

↓

Advisor3.after(response, chain)

├─ 处理响应

├─ 调用 chain.nextAfter(modifiedResponse)

│ └─ Advisor2.after(modifiedResponse, chain)

│ ├─ 处理响应

│ ├─ 调用 chain.nextAfter(modifiedResponse)

│ │ └─ Advisor1.after(modifiedResponse, chain)

│ │ └─ ... 继续链式调用

│ └─ 返回处理后的响应

└─ 返回处理后的响应

↓

返回最终响应给用户3.2 关键执行逻辑(伪代码)

java

public class DefaultAdvisorChain implements AdvisorChain {

private final List<BaseAdvisor> advisors;

private final int currentIndex;

private final ChatModel chatModel;

public DefaultAdvisorChain(List<BaseAdvisor> advisors, int index, ChatModel chatModel) {

this.advisors = advisors;

this.currentIndex = index;

this.chatModel = chatModel;

}

@Override

public ChatClientRequest nextBefore(ChatClientRequest request) {

// 如果还有下一个 Advisor

if (currentIndex < advisors.size() - 1) {

BaseAdvisor nextAdvisor = advisors.get(currentIndex + 1);

// 创建新的链,索引+1

AdvisorChain nextChain = new DefaultAdvisorChain(advisors, currentIndex + 1, chatModel);

// 调用下一个 Advisor 的 before 方法

return nextAdvisor.before(request, nextChain);

} else {

// 所有 Advisor 的 before 都执行完了,准备调用 ChatModel

return request;

}

}

@Override

public ChatClientResponse nextAfter(ChatClientResponse response) {

// 如果还有上一个 Advisor(逆序执行)

if (currentIndex > 0) {

BaseAdvisor prevAdvisor = advisors.get(currentIndex - 1);

// 创建新的链,索引-1

AdvisorChain prevChain = new DefaultAdvisorChain(advisors, currentIndex - 1, chatModel);

// 调用上一个 Advisor 的 after 方法

return prevAdvisor.after(response, prevChain);

} else {

// 所有 Advisor 的 after 都执行完了,返回最终响应

return response;

}

}

@Override

public ChatClientResponse invoke(ChatClientRequest request) {

// 执行 ChatModel 调用

return chatModel.call(request);

}

}四、具体执行示例

4.1 示例场景

假设配置了三个 Advisor:

- SimpleLoggerAdvisor (order = 100) - 记录日志

- ReReadingAdvisor (order = 0) - 增强提示词

- SafeGuardAdvisor (order = 50) - 安全检查

4.2 执行顺序(按 order 排序后)

排序后的顺序:

- ReReadingAdvisor (order = 0)

- SafeGuardAdvisor (order = 50)

- SimpleLoggerAdvisor (order = 100)

4.3 详细执行步骤

java

// 步骤1: 创建 Advisor 链,从第一个 Advisor 开始

AdvisorChain chain = new DefaultAdvisorChain(advisors, 0, chatModel);

// 步骤2: 开始执行 Before 阶段

ReReadingAdvisor.before(originalRequest, chain)

↓

// ReReadingAdvisor 处理:增强提示词

modifiedRequest1 = enhancePrompt(originalRequest);

// 调用链的下一个节点

chain.nextBefore(modifiedRequest1)

↓

SafeGuardAdvisor.before(modifiedRequest1, chain)

↓

// SafeGuardAdvisor 处理:安全检查

modifiedRequest2 = checkSafety(modifiedRequest1);

// 调用链的下一个节点

chain.nextBefore(modifiedRequest2)

↓

SimpleLoggerAdvisor.before(modifiedRequest2, chain)

↓

// SimpleLoggerAdvisor 处理:记录日志

logRequest(modifiedRequest2);

// 调用链的下一个节点(没有更多 Advisor)

chain.nextBefore(modifiedRequest2)

↓

// 返回最终请求,准备调用 ChatModel

return modifiedRequest2;

↓

return modifiedRequest2;

↓

return modifiedRequest2;

↓

return modifiedRequest2;

// 步骤3: 调用 ChatModel

ChatClientResponse response = chatModel.call(modifiedRequest2);

// 步骤4: 开始执行 After 阶段(逆序)

SimpleLoggerAdvisor.after(response, chain)

↓

// SimpleLoggerAdvisor 处理:记录响应日志

logResponse(response);

// 调用链的上一个节点(逆序)

chain.nextAfter(response)

↓

SafeGuardAdvisor.after(response, chain)

↓

// SafeGuardAdvisor 处理:检查响应安全性

modifiedResponse1 = checkResponseSafety(response);

// 调用链的上一个节点

chain.nextAfter(modifiedResponse1)

↓

ReReadingAdvisor.after(modifiedResponse1, chain)

↓

// ReReadingAdvisor 处理:通常不做修改

return modifiedResponse1;

↓

return modifiedResponse1;

↓

return modifiedResponse1;

↓

return modifiedResponse1; // 最终返回给用户五、关键设计点

5.1 链式调用机制

每个 Advisor 通过 AdvisorChain 对象来控制链的执行:

- Before 阶段 :调用

chain.nextBefore()继续执行下一个 Advisor - After 阶段 :调用

chain.nextAfter()继续执行上一个 Advisor(逆序)

5.2 请求/响应的传递

- 每个 Advisor 可以修改请求或响应

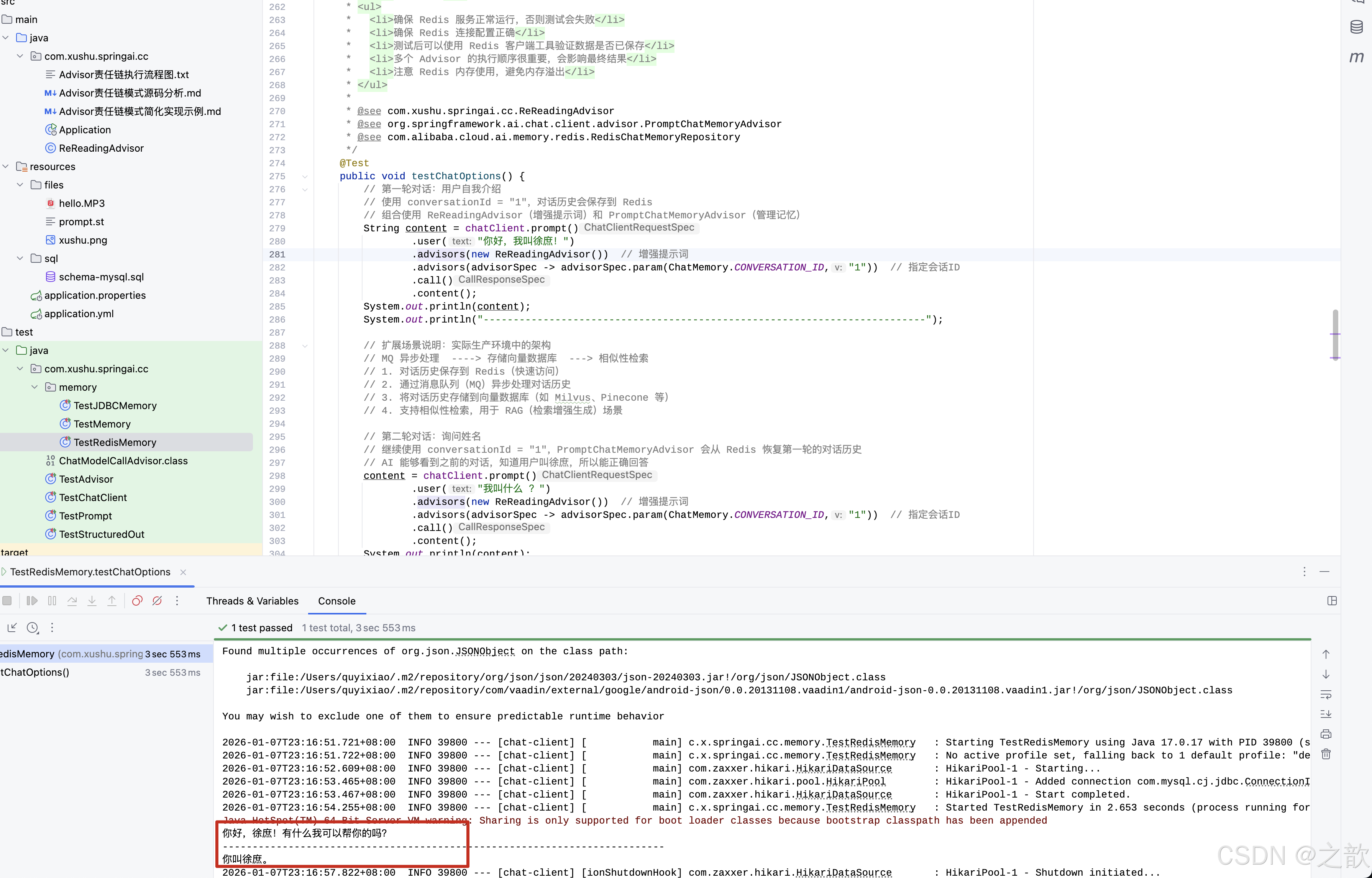

- 修改后的对象传递给链的下一个节点