作者:互联网运维技术保障团队-Mo Han、Zhou Jianhua

在飞速发展的互联网信息化时代下,抓住并充分利用"流量"将为业务增长带来"泼天"富贵,已成为共识。如何通过真实、海量的数据打造一个集成本、质量、效率于一体的融合流量管理平台,也成了各行各业的关注焦点,本文通过"拨测"与"融合流量管理"两个维度,来分享vivo在流量管理领域的一些实践和探索。

本文为2025年 vivo 开发者大会互联网技术专场分享内容之一,在公众号对话框回复【2025VDC】获取 2025VDC 互联网技术会场议题相关资料。

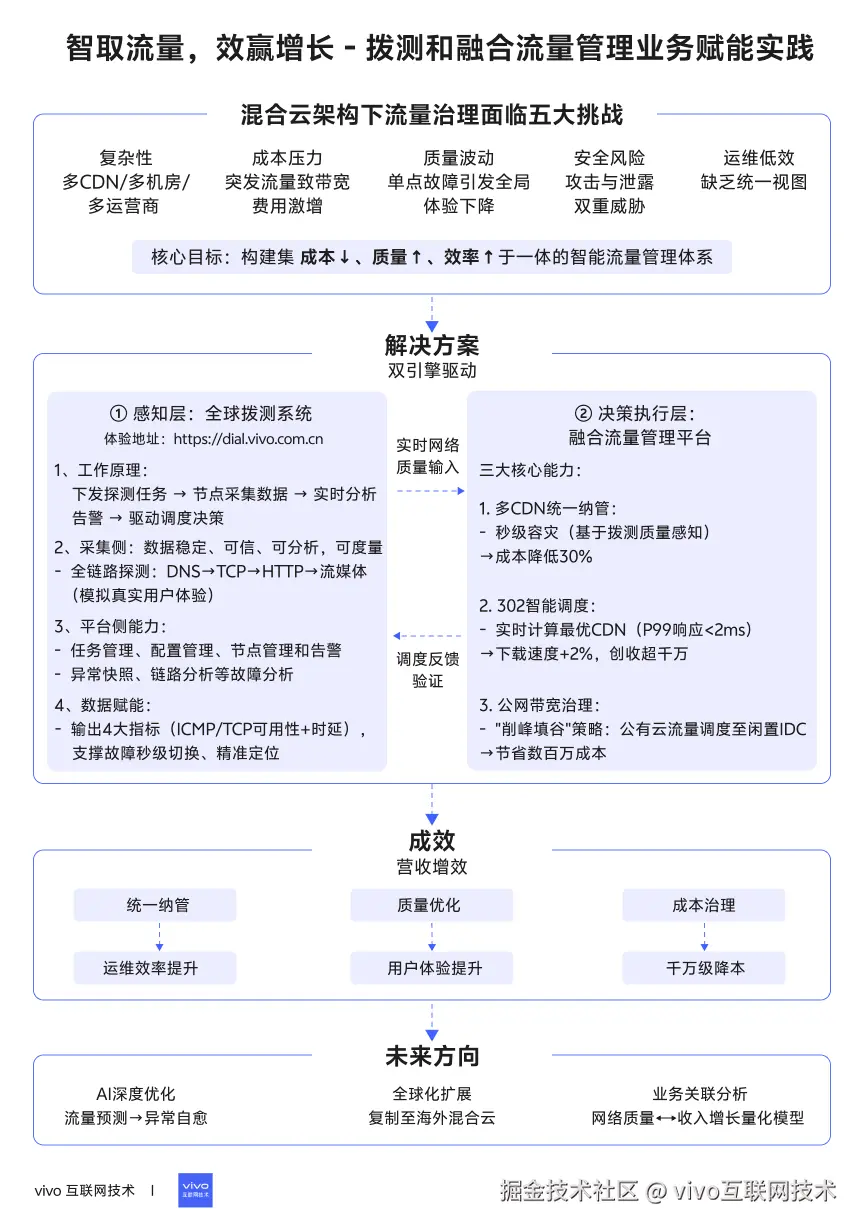

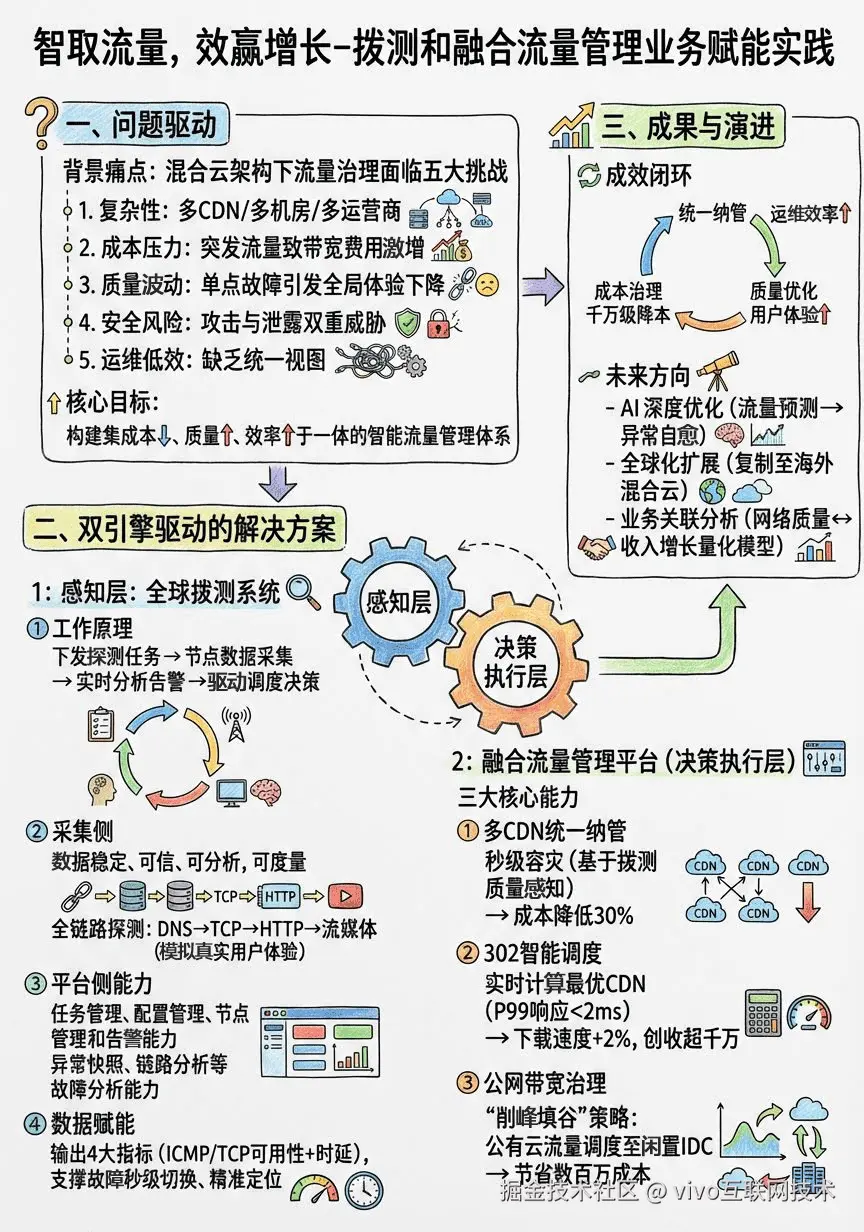

1分钟看图掌握核心观点👇

图1 VS 图2,您更倾向于哪张图来辅助理解全文呢?

一、背景

在飞速发展的互联网信息化时代下,抓住并充分利用"流量"将为业务增长带来"泼天"富贵,已成为共识。如何通过真实、海量的数据打造一个集成本、质量、效率于一体的融合流量管理平台,也成了各行各业的关注焦点,本文通过"拨测"与"融合流量管理"两个维度,来分享vivo在流量管理领域的一些实践和探索。

二、全球拨测

2.1 什么是拨测

简单来说,拨测就是一套模拟真实用户行为,主动进行健康检查和性能测量的旁路监控系统。 它就像我们派出去的无数"观察者",通过这些"观察者",我们主要可以实现三大目标:

**一是性能监控:**它可以模拟用户对某个网络接口或者网址,发起主动探测,检测网络的延迟、丢包,错误,及时发现网络风险和故障。

**二是产品优化:**从用户视角去对比不同版本的性能差异,为产品迭代提供数据支持。

**三是可用性监控:**模拟用户使用业务场景和完整流程,评估业务的真实质量,及时发现业务可用性问题。

2.2 vivo拨测平台介绍

在vivo,拨测的核心使命,就是为所有业务和产品高可用保驾护航,网络性能监控、业务可用性监控,产品优化分析、这是基础能力,确保我们的服务稳定可靠。

在这基础能力之上以及结合本次分享的主题,我们孵化了另外一种场景-"网络调度检测",我们会持续地对CDN、机房、运营商这些基础链路进行探测和分析,一旦发现问题,就可以基于拨测数据动态调整网络策略,以实现流量和故障智能调度目的。

2.3 vivo拨测的原理介绍

了解了vivo自有节点规模后,那么拨测如何工作的?下面这张图清晰展示了vivo拨测系统的基本工作原理,它主要分为三步:

第一步,下发执行探测任务。

平台会向分布在全球的边缘探测节点,下发探测指令,比如去访问某个网址,或者访问某一接口,也或者下载某个APP等。

第二步,数据采集与分析。

节点在执行任务时,会收集网络丢包率,响应时间、可用性等性能数据,并进行实时分析。

第三步,阈值和可用性告警。

如果发现探测结果超出了我们设定的阈值,比如访问超时、不可用,检测告警系统就会立即触发告警,并可以联动 智能调度策略 进行自动处理,比如切换线路,切换灾备机房,切换运营商等。

2.4 vivo拨测能力介绍-采集侧

为了管理如此庞大的节点网络并执行复杂的任务,我们的拨测平台构建哪些技术能力呢?大家可以看下面这张架构图,

首先、在采集侧,我们具备了从底层的DNS解析、TCP建联,到上层的HTTP可用性、私有协议,再到网页首屏、流媒体等全方位的用户体验检测能力。

同时,我们对执行拨测节点的耗电,网络环境,执行策略,配置管控都做了精细化管理 保障采集的拨测数据稳定、可信、可分析,可度量。

2.5 vivo拨测能力介绍-平台侧

在平台侧,我们同样具备任务管理、配置管理、节点管理和告警能力。可以实现多维度的任务下发,比如可以按国家、省份、城市、地区、运营商、机型,网络等维度下发。

同时,我们也具备了劫持,CDN故障等场景的检测告警能力、以及异常快照、链路分析等故障分析能力 确保收集到的拨测数据得到充分的应用,同时经过大数据分析和AI能力加持,做到业务问题 一分钟发现、即时告警。

vivo拨测平台免费体验地址: https://dial.vivo.com.cn

2.6 拨测如何支撑智能流量调度

如此海量的拨测数据,究竟是如何支撑流量调度的呢?

下面这张图清晰展示了其工作原理。

首先,是"输入"环节。

IP元数据管理平台会将公网服务IP信息同步到拨测平台,其中IP元数据包含6大关键维度:

-

IP信息

-

归属运营

-

归属业务

-

归属机房

-

归属集群

-

归属IDC

其次,是"执行"环节。

这些带有元数据的服务公网IP信息,会生成具体的"IP任务",通过"任务调度"系统,下发给我们遍布全球的"边缘探测节点",执行探测任务。

接着,是数据分析处理环节。

探测结果数据会通过统一网关实时存入时序数据库中,其中、结果数据包含四大关键指标:

-

ICMP Ping 可用性

-

TCP Ping 可用性

-

ICMP Ping 时延

-

TCP Ping 时延

这些指标,最终构成了智能调度的核心数据基础。

最后,就是流量智能调度的应用。

有了这些精准、实时的数据,我们就能赋能一系列上层的智能调度场景,比如:

-

**故障快速恢复:**一旦拨测发现某个IP不可用,调度系统可以秒级将它切换走。

-

**故障精准定位:**我们可以快速定位到问题出在哪个地域、哪个运营商,以及哪个线路。

-

**流量异常检测:**通过持续的性能数据对比分析,发现潜在的流量攻击和质量恶化 风险。

-

**流量智能调度:**基于质量和成本目标,结合业务场景、动态调整流量分配。

三、融合流量管理

3.1 技术背景

vivo采用了自建私有云和公有云结合的混合云架构。用户的访问流量,会通过DNS、CDN、负载均衡等一系列网络基础设施,最终到达我们的业务服务。

这个架构非常典型,但它也给我们带来了五大核心挑战。

-

**复杂性:**多运营商、多CDN、多机房,管理难度巨大。

-

**成本压力:**带宽费用,特别是突发流量带来的额外开销,非常高昂。

-

**质量挑战:**任何一个环节的网络波动,都会影响用户体验。

-

**安全风险:**内部主动上网和外部攻击,都是潜在的威胁。

-

**运维效率:**缺乏统一视图和自动化能力,排障和变更操作将非常耗时。

面对这些问题,我们的目标很明确:就是要构建一个智能、高效、安全的一体化解决方案,最终实现降成本、提质量、强安全、提效率!

为了实现这些,平台落地为一系列具体的解决方案,比如:通过DNS域名解析、CDN加速接入来统一流量入口;通过302智能调度、机房带宽调度来实现智能决策;通过WAF拦截、外发流量检测来保障安全;并通过全链路监控和故障预案来实现自动化运维。

3.2 平台实践

那么,我们是如何做的呢?

下面是平台的整体技术架构,它是一个典型的分层架构。

-

最底层 是网络资源,包括了我们对接的DNS、CDN、机房网络等所有供应商。

-

往上是数据采集层,它会从机房、CDN、业务埋点、拨测系统等各个源头,全面地采集流量、日志和监控指标数据。

-

数据之上,是数据处理与分析层,我们使用大数据平台对数据进行实时和离线处理,并利用调度和检测算法,来挖掘数据背后的价值。

-

架构的核心是控制与执行层,它通过API网关和自动化编排能力,去实际地配置和调度底层的网络资源。

-

最上层是展现与交互层,通过一个统一的管理门户,面向业务和运维人员,提供接入、管控、报表等一系列服务。

通过这个架构,我们将复杂的流量管理工作,平台化、系统化了。

3.2.1 多CDN统一接入纳管

我们深入到具体的实践场景。

首先是CDN的治理。

我们打造的"融合CDN"平台,核心价值体现在六个方面:

-

**配置融合:**统一了不同厂商的配置标准,大大提升了管理效率。

-

**流量调度:**支持多种策略,让调度既精准又灵活。

-

**数据融合:**在一个平台就能看到所有厂商的数据指标。

-

**成本优化:**通过一系列运营手段,我们成功将成本降低了30%。

-

**秒级容灾:**基于全网拨测点的质量感知,一旦发生故障,可以自动调度,实现秒级容灾。

-

**智能运维:**同样基于拨测节点,可以智能地进行故障的根因定位。

3.2.2 融合CDN产品架构

下面这张架构图展示了我们如何实现这些价值。大家可以看到,我们通过一个"融合CDN管理平台",把全球主流CDN厂商的API都接入进来,屏蔽了底层的差异。

对于业务方来说,他们只需要通过我们统一的控制台或OpenAPI进行操作。同时,平台集成了我们的端侧质量埋点、智能解析、302智能调度等核心能力,形成了一个强大的调度中心,为用户提供最优的加速体验。

在融合CDN中,302智能调度是我们最核心、最有价值的能力之一。

如图,即使是在同一个地区,不同的CDN厂商,在同一时间的下载速度,是不一样的。蓝色的线可能在某个小时最快,但下一个小时,也许绿色的线就反超了。

这就带来一个核心问题:我们如何保证我们的用户,总能用到当下那个最快的CDN呢?同时,当某个厂商出现故障时,我们又如何快速地把用户切换走,实现容灾呢?这就是302智能调度要解决的问题。

3.2.3 302智能调度

为了解决这个问题,我们设计了这套技术方案。它非常巧妙,主要分为四步:

-

第一步,客户端,也就是我们的业务服务端,在响应用户请求时,它不会直接返回一个写死的下载地址。

-

**第二步,**它会先向我们的"302调度服务"发起一次请求,问一个问题:"现在哪个CDN最快?"

-

第三步,我们的调度服务,会根据海量的埋点数据,通过智能算法进行实时计算,然后立刻告诉业务服务端一个最优的厂商域名。

-

**第四步,**业务服务端拿到这个最优域名后,再通过302跳转的方式,把用户引导过去。

整个过程对用户是完全透明的,但我们确保了用户的每一次下载,走的都是当下最优的路径。

这套方案的背后,是一个强大的技术架构在支撑。 大家可以看到,它包含了完整的指标数据采集处理层和调度执行层。

我们通过ETL、Druid等大数据技术,对海量的业务指标数据进行实时处理。 在控制层,我们有灵活的调度策略管理和多重调度算法。

在调度执行层,我们通过统一的网关,为商店、游戏、系统升级等八十多个业务场景提供服务。

整个架构的设计,核心就是为了保证四点:精细化控制 、故障快速切换 、实时性与动态适应 ,以及灵活可扩展。

正是这些,才让我们的调度服务既快又准。

最终带来了什么样的效果呢?

-

首先是性能:我们的服务端P99响应时间做到了小于2毫秒!这对用户来说是完全无感的。同时,配置变更可以秒级生效,实现了真正的实时。

-

其次是规模:目前每天的调度执行次数,超过了60亿次!覆盖了我们80多个核心业务场景。

-

最后是业务价值:通过这套系统,我们为应用商店等业务,带来了整体下载速度提升超过2%!

-

**更关键的是,**它为我们的商业化带来了超过千万元的收入提升!这就是技术驱动业务增长最直接体现!

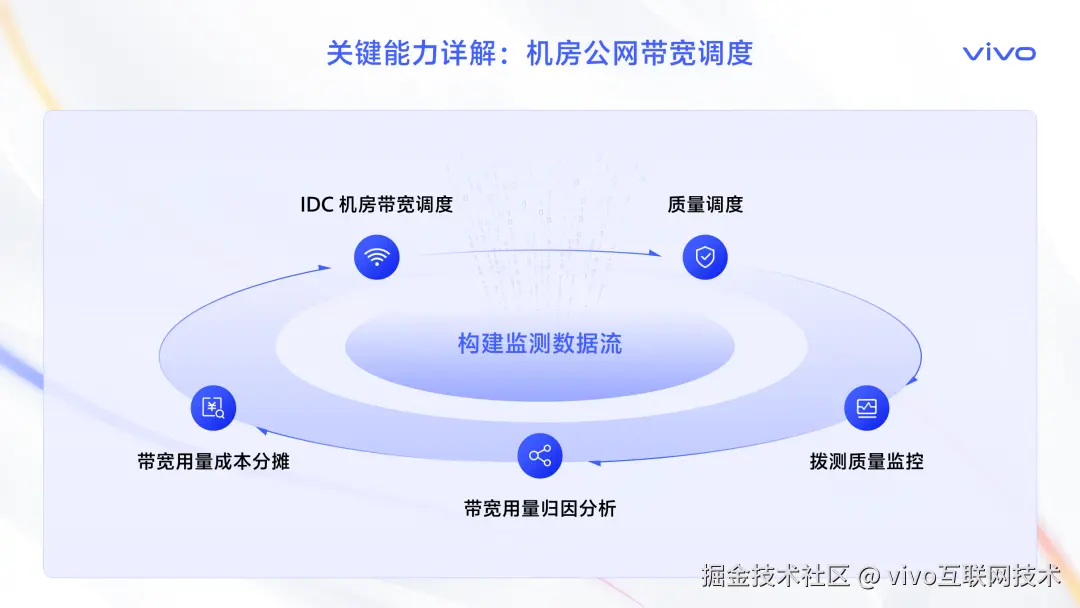

3.2.4 公网带宽治理

讲完了CDN,我们再来看另一个成本大头:机房公网带宽。 从这张全网公网带宽的趋势图。可以看到,在2022年之前,我们的带宽增幅是比较大的,成本压力也随之而来。

但是,从2023年开始,增幅明显趋于平稳。 这不是因为业务停滞了,而是因为我们进行了一系列持续的成本治理和运营。比如,我们重点针对主动上网、埋点业务和出入向均衡进行了专项优化,成功地将带宽增长控制在了可预期的范围内。

接下来,我就为大家介绍一下我们实现这个目标的关键能力。 要实现公网带宽降本,我们同样打造了一套公网带宽调度体系。

这套体系主要包含了几个核心能力:

-

首先,是IDC机房带宽的智能调度,这是我们进行流量腾挪的基础。

-

其次,是带宽用量的归因分析和成本分摊,让我们清楚每一分开销花在了哪里。

-

最后,也是最重要的,是基于拨测数据的质量调度和监控,确保我们在优化成本的同时,不牺牲用户体验。

如下产品架构图,展示了我们全球混合云环境下,公网带宽调度的全貌。 当一个vivo的全球用户发起访问时,我们的智能解析系统(VHS),会成为第一个决策入口。

它会结合来自我们全球拨测点的源站质量监测数据,以及我们VIP地址池的管理策略,智能地判断,应该把这个用户的请求,解析到哪个地域的哪个机房。

这个机房,可能是我们在北京的自建IDC,也可能是我们在新加坡、德国的火山云或谷歌云。

整个决策过程,都会在我们的统一控制台上进行可视化的管理和干预,包括成本调度、质量调度、故障分析等等。通过这套架构,我们实现了对全球流量的"宏观调控"。

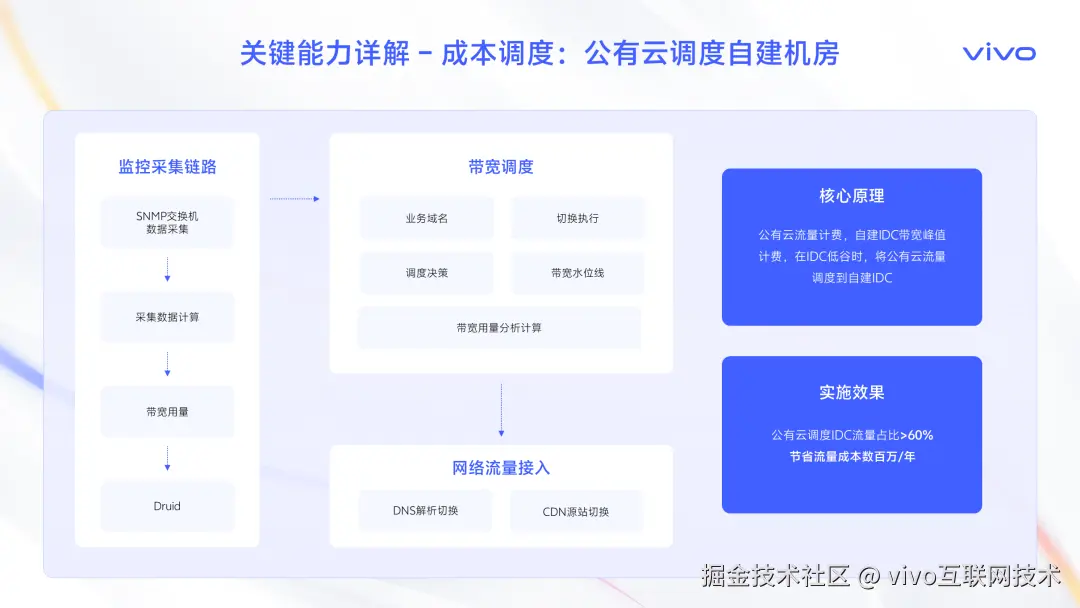

在众多调度策略中,有一个非常有效的成本调度策略,就是"公有云调度自建机房"。

它的核心原理,其实就是利用了不同资源的计费模型差异。大家知道,公有云是按流量计费,用多少算多少;而我们的自建IDC,是按带宽峰值计Fèi,就像包月套餐。

那么,这里就有了一个巨大的优化空间。大家看这张图,我们的监控系统会实时采集自建IDC的带宽用量。当发现IDC处于带宽低谷时,比如凌晨,流量很少,带宽大量闲置,非常浪费。

这时,我们的调度决策系统就会自动执行切换,通过DNS解析或者CDN源站变更,把一部分原本跑在公有云上的流量,调度到我们闲置的自建IDC上来。

这个"削峰填谷"的动作,效果非常显著:公有云调度到IDC的流量占比超过了60%,每年为我们节省了数百万的流量成本!

四、总结与展望

通过"拨测监控"和"融合流量管理平台"的这一系列实践,我们取得了哪些显著的成效呢?

-

首先,在统一纳管上,我们屏蔽了底层供应商的差异,对外提供了一致的接口能力,大大提升了运维效率。

-

其次,在提升质量上,我们为核心业务,比如应用商店,带来了整体下载速度超过2%的提升,这对用户体验是实实在在的改善。

-

第三,在降低成本上,我们通过一系列智能调度手段,实现了CDN和公网带宽的千万级降本,这是非常可观的经济效益。

-

最后,也是最重要的,我们实现了营收增效!质量的提升和成本的优化,最终转化为了商业化运营收入的显著提升!

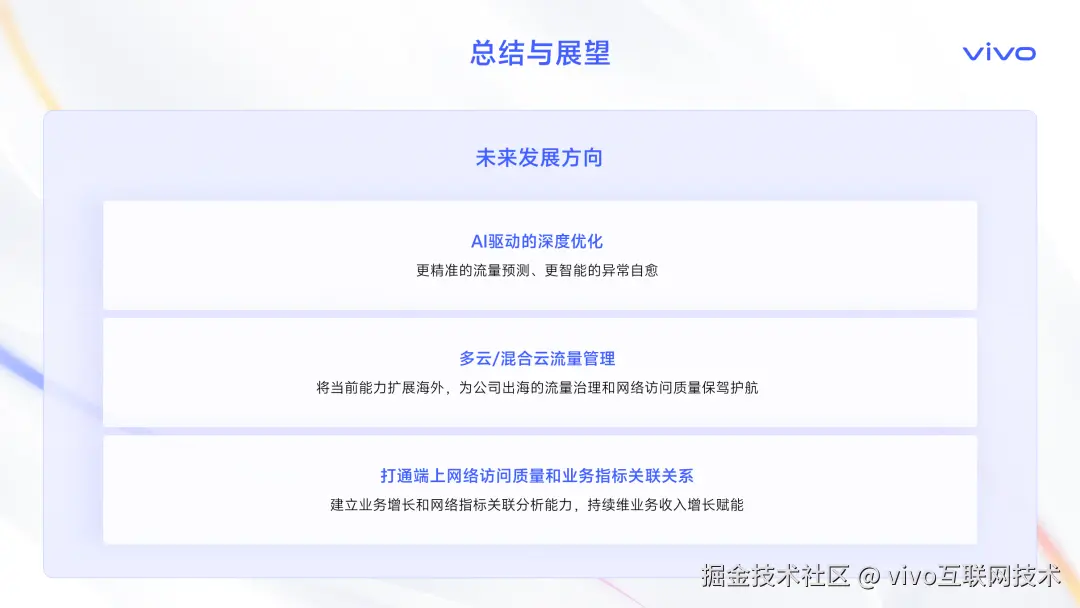

我们的探索和实践还在路上,接下来,我们主要有三个发展方向:

-

第一,是AI驱动的深度优化。我们将引入更强大的AI能力,去实现更精准的流量预测和更智能的异常自愈。

-

第二,是多云/混合云流量管理的持续深化。我们会将当前的成功经验,扩展到更广阔的海外市场,为公司全球化的出海业务保驾护航。

-

第三,也是我们认为极具价值的一点,是打通网络质量和业务指标的关联。我们要建立起业务增长和网络指标的关联分析能力,用数据证明每一次网络优化,是如何实实在在地为业务收入增长赋能的!