1. 引言:当 AI 变成"复读机"

在上一篇博客中,我们聊到了 Temperature(温度) 这个参数。我们将它比作 AI 的"性格旋钮":调低了,它像个严谨的老教授;调高了,它就是个疯癫的艺术家。

但你有没有遇到过这种情况?哪怕你把温度调得很高,试图激发 AI 的创造力,它有时依然会陷入死循环,不断重复"我不知道我不知道",或者像卡带的唱片一样,车轱辘话来回说。

这时候,光调"温度"已经失效了。你需要动用另外两个强力武器------Frequency Penalty(频率惩罚) 和 Presence Penalty(存在惩罚)。

如果说 Temperature 决定了 AI "敢不敢"乱说话,那么 Penalty 机制就是为了专治它的"复读机"顽疾。

2. 什么是"惩罚" (Penalty)?

在 LLM(大语言模型)的生成机制里,"惩罚"的核心逻辑非常简单粗暴:干预模型对下一个词(Token)的选择概率。

我们可以这样理解两者的分工:

- Temperature 负责 "切蛋糕"(分配概率分布):决定每个词能分到多少机会,让分布更平滑或更尖锐。

- Penalty 负责 "扣分"(直接干预):模型在生成下一个词之前,会回头看一眼"之前已经写了什么"。如果某些词已经被用过了,Penalty 机制就会强制扣除这些词的分数(Logits),让它们更难被选中。

为什么要这么做?目的主要有三:

- 避免死循环 (Anti-repetition): 防止模型陷入无限自我重复。

- 增加多样性 (Diversity): 逼迫模型使用词库中被冷落的词汇。

- 控制话题转移 (Topic shifting): 强迫 AI 聊完一个点后,必须寻找新的话题。

3. 深入解析:Frequency Penalty vs. Presence Penalty

这是开发者最容易混淆的地方。虽然都是"惩罚重复",但这把手术刀下刀的逻辑完全不同。

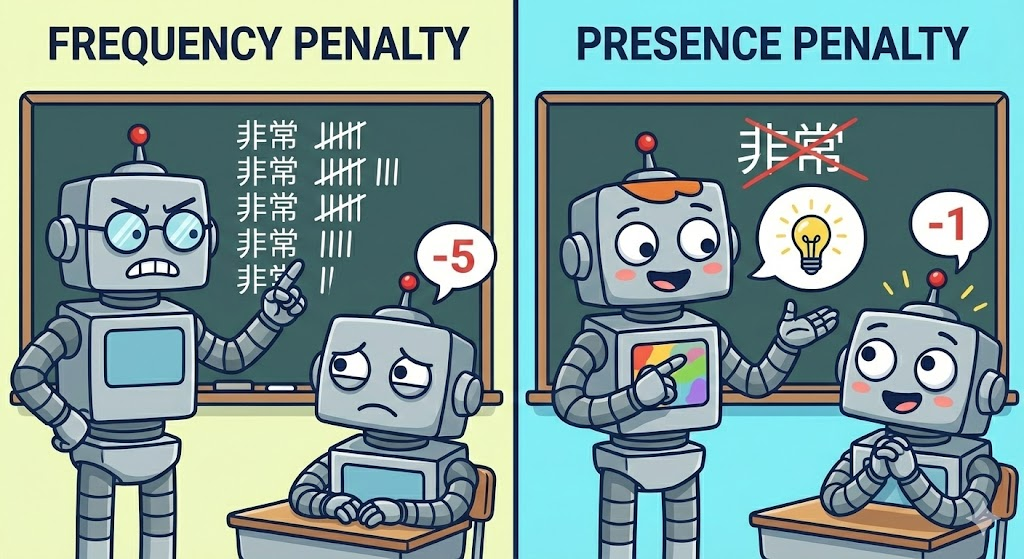

A. Frequency Penalty(频率惩罚):拒绝啰嗦

- 核心逻辑 :针对次数。根据一个词在文本中已经出现的频率来累积惩罚。

- 潜台词:"这个词你用得越多,我扣分越重。"

- 数学直觉:如果词 A 出现了 5 次,它受到的惩罚力度大约是只出现 1 次时的 5 倍。

- 效果对比:

- 无惩罚:"The dog is barking. The dog is playing. The dog is running."(主语不断重复)

- 有频率惩罚 :"The dog is barking. It is playing. The cat is running."(强制换词)

- 适用场景:当你希望保持话题连贯(比如技术写作或摘要),但不想让 AI 像复读机一样反复堆砌同一个词时,这个参数最有效。

B. Presence Penalty(存在惩罚):鼓励尝鲜

- 核心逻辑 : 针对有无。只要一个词在文本中出现过(哪怕只有一次),就给予一个固定的惩罚。

- 潜台词:"不管你用了几次,只要你用过这个词,我就扣你一次分。"

- 数学直觉:它对"出现 1 次"和"出现 100 次"的惩罚是一视同仁的。

- 效果 :它不像是在微调修辞,更像是在强迫模型 转移话题。因为旧概念相关的词都被"扣分"了,模型为了维持高概率,不得不引入全新的词汇和概念。

- 适用场景:创意写作、头脑风暴,或者你想强迫 AI 聊完一个点后立刻转向下一个点。

C. 秒懂类比:作文课上的老师

如果技术解释太枯燥,我们可以把 AI 想象成一个正在写作文的学生,而 Penalty 是旁边的老师:

Frequency Penalty 像是严厉的数学老师: "'非常'这个词你用了两次了,扣两分!再用扣三分!绝对不许再啰嗦!" ------ 它禁止你反复念叨同一个词。

Presence Penalty 像是引导创新的语文老师: "'非常'这个词你刚才已经用过了,哪怕只用了一次也别再用了。换个词,比如'格外',或者干脆换个话题去写风景。" ------ 它逼你去寻找新词和新意象。

4. 实战指南:参数怎么设?

在 OpenAI 或 Anthropic 等主流 API 中,这两个参数的取值范围通常在 -2.0 到 2.0 之间。

- **正值 (> 0)**:最常用。数值越大,惩罚越重,重复越少,AI 越倾向于用新词。

- **0 (默认)**:不进行任何惩罚。

- 负值 (< 0):这会鼓励重复。除非你想写那种充满排比句的诗歌,或者某种特定强调效果,否则一般不用。

📝 避坑建议:

- **日常微调 (0.1 - 0.6)**:如果你只是觉得 AI 有点啰嗦,设在这个区间就够了。它能减少重复,但不会破坏句子的通顺度。

- **强力抑制 (1.0 - 2.0)**:这属于"猛药"。虽然能彻底根治复读机,但可能会导致生成的句子变得怪异。因为 AI 为了避嫌,可能会强行选用生僻词,甚至毫无逻辑地跳跃话题。

5. 进阶玩法:Penalty 与 Temperature 的组合拳

很多开发者会问:Temperature 和 Penalty 都是控制随机性的,它们怎么配合?

首先,我们要理解它们生效的顺序。LLM 生成内容像是一条流水线:

- **原始打分 (Logits)**:模型先根据上下文给所有可能的词打分。

- Penalty 惩罚:根据之前写过的内容,对候选词进行"扣分"打击,压低重复词的得分。

- Temperature 调整:把经过惩罚后的分数拉平或变尖(决定敢不敢冒险)。

- **采样 (Sampling)**:最后根据概率选出下一个词。

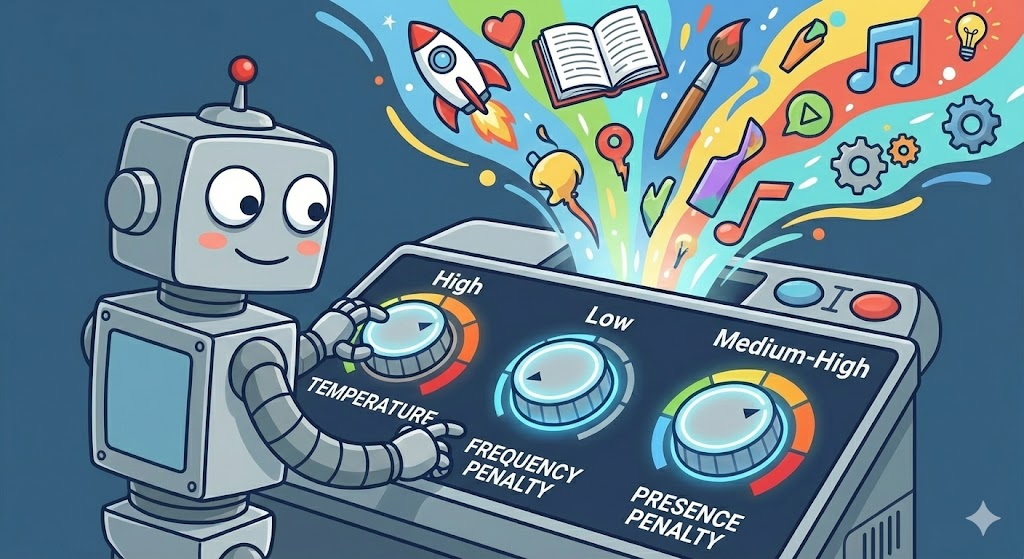

基于这个逻辑,我们可以总结出几套**"独家配方"**:

🧪 配方 1:精准任务 (代码、数学、事实问答)

- 设置:Temperature 低 (0 - 0.2) + Penalty 设为 0。

- 理由 :写代码时,变量名

i可能会出现很多次。如果你开了 Penalty,AI 可能会因为不想重复i而强行编造一个变量名j,导致代码报错。在这种场景下, 重复是必要的精确性。

☕ 配方 2:日常对话 / 摘要生成

- 设置:Temperature 中 (0.5 - 0.7) + Frequency Penalty 微量 (0.1 - 0.3)。

- 理由:你需要 AI 说话自然流畅,但不要絮絮叨叨。一点点 Frequency Penalty 足以让它把车轱辘话收回去,同时保持话题不跑偏。

🎨 配方 3:创意爆发 (写小说、头脑风暴)

- 设置:Temperature 高 (0.8 - 1.2) + Presence Penalty 中高 (0.5 - 1.0)。

- 理由:高温提供了随机性,而较高的 Presence Penalty 像鞭子一样赶着 AI 往前走:"这个情节写过了,换下一个!这个词用过了,换新的!"这能产生极具跳跃性和创意的内容。

6. 结语

如果把 AI 比作一个人:

- Temperature(温度) 控制的是它的 "性格" ------ 是保守严谨,还是奔放自由;

- Penalty(惩罚) 控制的是它的 "说话习惯" ------ 是喜欢念旧老词,还是喜欢喜新厌旧。

下次当你觉得 AI 说话太单调,或者陷入"鬼打墙"的死循环时,别只盯着温度调了。试着给 Frequency Penalty 加个 0.5,说不定它立刻就变得聪明伶俐起来了。

本文由mdnice多平台发布