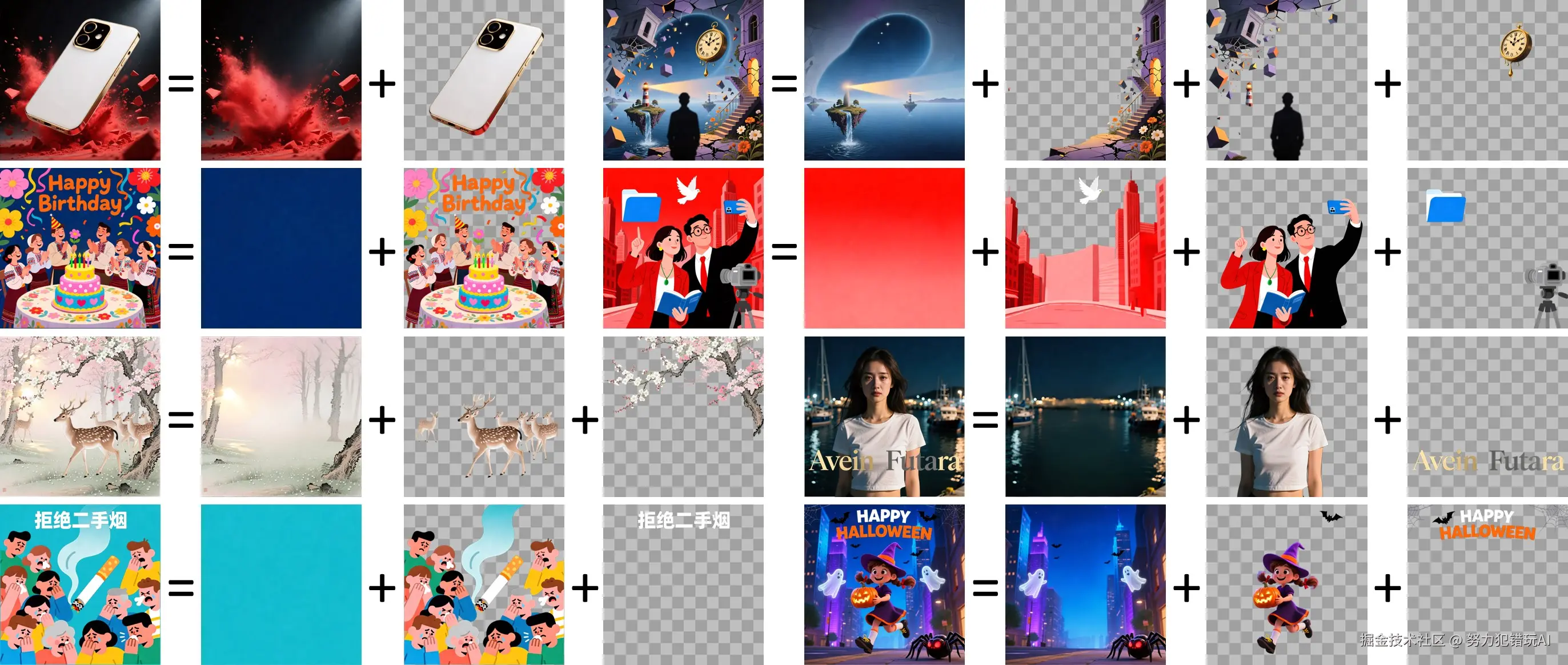

传统的图像编辑需要手动创建蒙版、复杂的选区操作,以及在Photoshop等工具中耗费数小时的精细工作。如果你能一键自动将任何图像分解为可编辑的图层,会怎么样?这正是Qwen-Image-Layered为ComfyUI带来的革命性功能。

Qwen-Image-Layered由阿里巴巴Qwen团队开发,是一个革命性的AI模型,能够自动将图像分解为多个独立的RGBA图层。每个图层包含特定的语义组件------背景、前景对象、文本和装饰元素------可以独立编辑而不影响图像的其他部分。

GGUF(GPT-Generated Unified Format)版本使这项强大的技术对显存有限的用户也变得可用。在这份综合指南中,你将学习如何在ComfyUI中安装和使用Qwen-Image-Layered GGUF,即使你使用的是消费级硬件。

什么是Qwen-Image-Layered?

Qwen-Image-Layered是一个先进的图像分解模型,能够将平面光栅图像转换为结构化的多层表示。与传统的图像分割只提供蒙版不同,这个模型为每个图层生成完整的RGBA图像,包括:

- 背景图层,完整的场景重建

- 前景对象,带有适当的Alpha通道

- 文本元素,隔离以便轻松编辑

- 装饰效果和半透明元素

- 被遮挡区域,智能重建

该模型支持可变的图层数量(3、4、8层或更多),甚至支持递归分解,任何图层都可以进一步分解为子图层。这种灵活性使其适用于从简单的产品照片到复杂的艺术作品的各种场景。

为什么选择GGUF格式?

GGUF格式结合量化技术为ComfyUI用户提供了显著优势,特别是对于硬件资源有限的用户。

GGUF量化的核心优势

1. 大幅降低显存需求

量化通过降低数值权重的精度,将模型大小缩小50-75%。通常需要16GB+显存的模型,使用GGUF量化后可以在8GB甚至更少显存的GPU上运行。

2. 更快的推理速度

较低精度的权重意味着更快的计算。GGUF优化的二进制格式还支持快速加载和保存,减少启动时间。

3. 经济实惠的AI生成

通过降低硬件要求,GGUF量化消除了对昂贵高端GPU的需求。你可以在消费级硬件上运行强大的图像编辑模型。

4. 灵活的量化级别

GGUF支持多种量化级别(Q2、Q4、Q5、Q6、Q8),让你可以在模型大小、速度和输出质量之间取得平衡。Q4_K_M级别通常被推荐。

5. 无缝的ComfyUI集成

ComfyUI-GGUF等自定义节点提供了直接将GGUF模型加载到工作流的原生支持。

系统要求和准备工作

在ComfyUI中安装Qwen-Image-Layered GGUF之前,确保你的系统满足以下要求:

最低硬件要求

- GPU: 8GB显存(GGUF Q4版本)或12GB+显存(FP8/BF16版本)

- 内存: 推荐16GB系统内存

- 存储: 15-20GB可用空间用于模型文件

- 操作系统: Windows 10/11、Linux或macOS

软件前提条件

- ComfyUI: 最新版本(更新以支持原生Qwen-Image-Layered节点)

- Python: 3.10或更新版本

- CUDA: 11.8或更新版本(适用于NVIDIA GPU)

性能预期

基于实际测试:

- RTX 4090: BF16版本几乎完全占用显存

- RTX 3060 (12GB): GGUF Q4版本运行舒适

- RTX 3050 (8GB): 在640px分辨率下可使用GGUF Q4

- 生成时间: 640px约60-120秒,1024px约120-180秒(50推理步数)

分步安装指南

按照以下步骤在ComfyUI中安装Qwen-Image-Layered GGUF:

步骤1: 更新ComfyUI

首先,确保你运行的是最新版本的ComfyUI:

bash

cd ComfyUI

git pull最新版本的ComfyUI包含对Qwen-Image-Layered的原生支持。

步骤2: 下载必需的模型文件

你需要三个核心模型文件。从Hugging Face或ModelScope下载:

必需文件:

- 文本编码器 :

qwen_2.5_vl_7b_fp8_scaled.safetensors(~4.5GB) - 扩散模型 (选择一个):

- GGUF Q4:

qwen_image_layered_Q4_K_M.gguf(~3.2GB) - 推荐用于8-12GB显存 - FP8:

qwen_image_layered_fp8mixed.safetensors(~6.8GB) - 适用于12-16GB显存 - BF16:

qwen_image_layered_bf16.safetensors(~13GB) - 适用于16GB+显存

- GGUF Q4:

- VAE :

qwen_image_layered_vae.safetensors(~320MB)

下载来源:

- Hugging Face: Qwen/Qwen-Image-Layered

- GGUF版本: QuantStack/Qwen-Image-Layered-GGUF

步骤3: 将文件放置在正确的目录

在ComfyUI安装目录中组织下载的文件:

bash

ComfyUI/models/

├── text_encoders/

│ └── qwen_2.5_vl_7b_fp8_scaled.safetensors

├── diffusion_models/

│ └── qwen_image_layered_Q4_K_M.gguf

└── vae/

└── qwen_image_layered_vae.safetensors重要提示: VAE文件专为Qwen-Image-Layered设计,处理四个通道(RGBA)而不是标准的三个通道(RGB)。

步骤4: 安装GGUF支持(如需要)

如果使用GGUF版本且ComfyUI没有内置GGUF支持,安装ComfyUI-GGUF自定义节点:

bash

cd ComfyUI/custom_nodes

git clone https://github.com/city96/ComfyUI-GGUF

cd ComfyUI-GGUF

pip install -r requirements.txt安装后重启ComfyUI。

配置ComfyUI工作流

模型安装完成后,你可以在ComfyUI中设置Qwen-Image-Layered工作流。

基础工作流结构

典型的Qwen-Image-Layered工作流包含以下关键节点:

- Load Image: 输入源图像

- GGUF Unet Loader: 加载Qwen-Image-Layered模型

- GGUF CLIP Loader: 加载文本编码器

- Load VAE: 加载专用的Qwen VAE

- Sampler: 配置生成参数

- Save Image: 输出生成的图层

推荐的采样器设置

为了获得最佳效果:

- 推理步数: 50(推荐最小值)

- CFG比例: 4.0

- 采样器: Euler或DPM++ 2M

- 调度器: Normal或Karras

分辨率设置

根据硬件和质量需求选择:

- 640px: 平衡质量和速度,适用于8GB显存

- 768px: 更高质量,需要10GB+显存

- 1024px: 最高质量,GGUF需要12GB+显存

实际应用案例

1. 电商产品编辑

场景: 产品照片需要颜色变体或背景更换。

工作流程:

- 将产品图像分解为图层

- 从背景中隔离产品图层

- 为不同变体重新着色产品图层

- 用新场景替换背景图层

优势: 在几分钟内创建多个产品变体。

2. 营销和广告创作

场景: 用新文本或季节性元素更新促销材料。

工作流程:

- 加载现有广告图像

- 分解为图层(背景、产品、文字、装饰)

- 用更新的文案替换文字图层

- 为季节性主题交换装饰元素

优势: 快速迭代营销材料。

优化技巧和故障排除

性能优化

1. 选择合适的量化级别

- Q4_K_M: 大多数用户的最佳平衡(节省3-4GB显存)

- Q5_K_M: 质量稍好,中等显存节省

- Q6_K: 接近原始质量,最小显存节省

2. 根据硬件调整分辨率

从640px开始,只有在硬件能够处理时才增加。

3. 启用内存优化

在ComfyUI设置中启用:

- "自动卸载模型"

- "显存管理: 自动"

- "激进的内存清理"

常见问题和解决方案

问题1: "内存不足"错误

解决方案:

- 切换到较低量化(Q4而不是Q5/Q6)

- 降低输入分辨率(640px而不是1024px)

- 关闭其他GPU密集型应用程序

问题2: 图层分离质量差

解决方案:

- 将推理步数增加到60-70

- 调整CFG比例(尝试3.5-4.5范围)

- 提供关于图像内容的描述性提示词

- 确保使用正确的Qwen VAE

为什么使用ComfyUI而不是在线工具?

虽然存在在线AI图像编辑器,但在ComfyUI中本地运行Qwen-Image-Layered GGUF提供了明显的优势:

隐私和成本效益

本地处理:

- 你的图像永远不会离开你的计算机

- 没有数据上传到第三方服务器

- 免费、开源软件

- 无限生成,无订阅费用

在线工具:

- 图像上传到外部服务器

- 每月订阅费用

- 基于积分的系统

定制和控制

ComfyUI提供完全的工作流定制、参数控制和结合多个模型的能力。不过,如果你想在不安装的情况下快速测试Qwen-Image-Layered功能,像 ZImage.run 这样的平台提供了方便的在线访问各种AI图像生成模型。

这对以下情况很有用:

- 在承诺本地设置之前快速实验

- 比较不同的模型和参数

- 在没有GPU的设备上生成样本

一旦验证了工作流,过渡到本地ComfyUI可以提供最大的灵活性和控制。

结论

ComfyUI中的Qwen-Image-Layered GGUF代表了可访问的AI驱动图像编辑的重大进步。通过自动将图像分解为可编辑图层,它消除了数小时的手动蒙版工作,同时保持专业级质量的结果。

关键要点

- GGUF量化在不显著降低质量的情况下将显存需求减少50-75%

- Q4_K_M量化为大多数拥有8-12GB显存的用户提供最佳平衡

- 原生ComfyUI支持简化了安装和工作流创建

- 可变图层数量和递归分解提供最大灵活性

- 本地处理确保隐私、成本效益和无限使用

今天开始

- 将ComfyUI更新到最新版本

- 下载Qwen-Image-Layered GGUF模型(推荐Q4_K_M)

- 将文件放置在正确的ComfyUI目录中

- 加载示例工作流或创建自己的工作流

- 从640px分辨率和50推理步数开始

- 尝试不同的图像和图层数量

其他资源

官方文档:

社区资源:

今天就开始在ComfyUI中尝试Qwen-Image-Layered GGUF,发现基于图层的AI编辑如何改变你的创意工作流。

准备尝试AI图像生成? 访问 zimage.run 探索各种AI模型和工作流,或设置本地ComfyUI安装以获得无限创意可能性。