大家好,我是你们的老朋友。今天我们要聊的事情,可能真的标志着AI语音交互的一个分水岭。

长久以来,我们对语音助手的印象大概还停留在"听写员"的阶段。你说话,它转成文字,然后用文字大模型处理,最后再读出答案。这个过程最大的问题是什么?是丢失了灵魂。你语气里的无奈、急促,甚至背景里的环境音,在这个转化过程中统统被过滤掉了。

但就在2026年1月,一家来自上海的创业公司------阶跃星辰(StepFun),用他们的新模型 Step-Audio-R1.1 给整个行业上了一课。

这一战,赢得漂亮

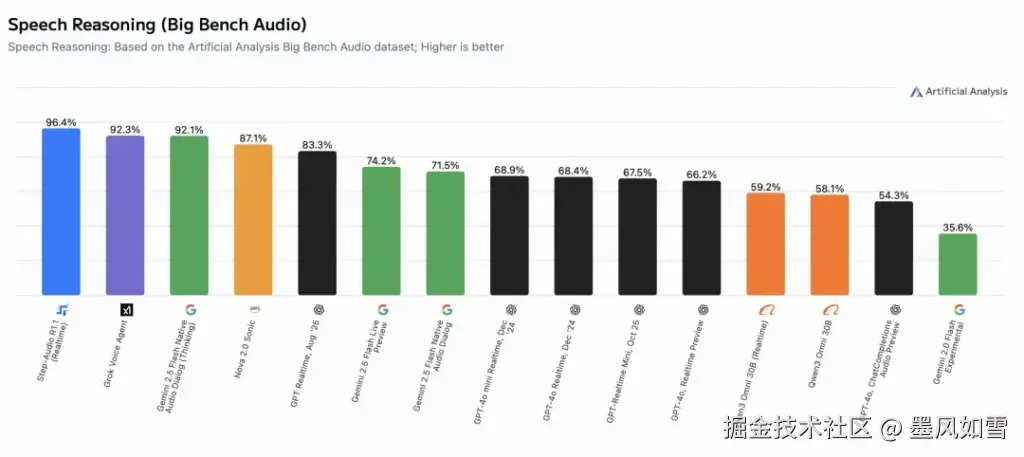

这不是我的一家之言,数据摆在那儿。

在全球权威的 Artificial Analysis Speech Reasoning 评测中,Step-Audio-R1.1 拿下了 96.4% 的准确率。这个数字意味着什么?意味着它直接登顶榜首,把大名鼎鼎的 Grok、Google 的 Gemini,甚至是 OpenAI 的 GPT-Realtime 都甩在了身后。

要知道,这可是一个专门针对原生语音推理的"魔鬼考场",它不考你的听写速度,考的是你能不能像人一样,直接通过声音去思考。

它凭什么这么强?

Step-Audio-R1.1 的核心逻辑,在于它抛弃了传统的"二传手"模式。

以前的模型是"耳朵听见 -> 脑子翻译成字 -> 再思考",而 Step-Audio-R1.1 是原生音频模型(Native Audio Model)。简单说,它拥有了直觉。它不需要把声音变成干巴巴的文字,而是直接处理音频信号。

这里有个很有意思的技术概念,叫做"模态锚定推理蒸馏"。听着挺拗口,其实道理很性感:它让AI在推理时,不仅仅基于字面意思,而是死死"锚定"在声音的物理特征上。

举个生动的例子:如果背景里放着那种魔性的"海豹舞"音乐,普通AI可能只会识别出里面的韩语歌词;但 Step-Audio-R1.1 能听出这是在搞怪,甚至判断出这是一种发音练习场景。它能听懂你的笑声是尴尬还是开心,能听懂你的停顿是在思考还是在犹豫。

这就是从"听得清"到"听得懂"的质变。

边听边想,拒绝尴尬沉默

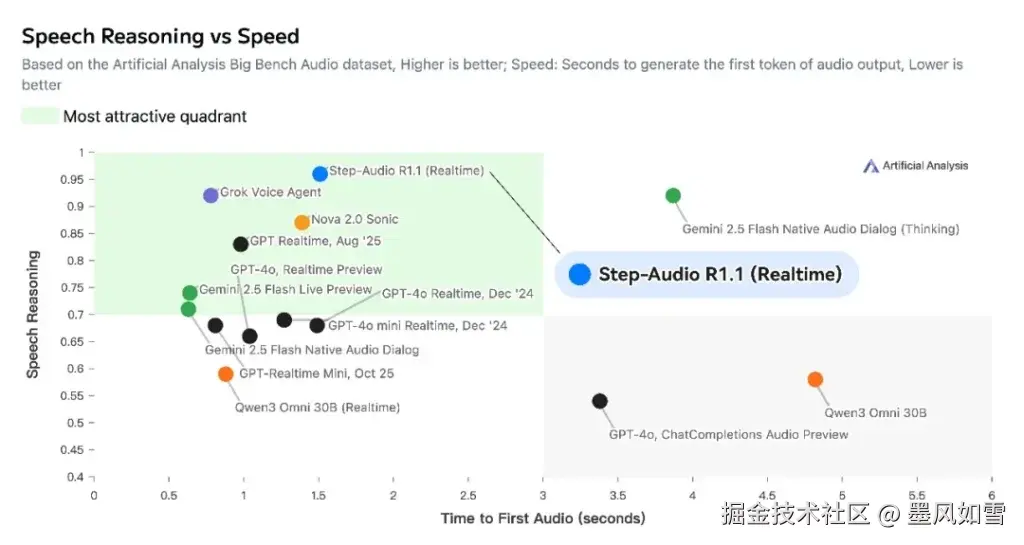

除了聪明,这模型还有一个杀手锏:快。

大家用过语音助手的都知道,你说完话,对面往往要沉默个几秒,空气突然安静。Step-Audio-R1.1 把首包延迟降低了30%以上,做到了"流式推理"。这意味着当你话音未落,它的大脑已经在高速运转组织语言了,就像我们人类聊天一样,话赶话,没有那种令人脚趾扣地的等待感。

给开发者的一份大礼

最让我兴奋的不是它有多强,而是它开源了。

阶跃星辰这次非常大方,直接把模型权重放在了 Hugging Face 和 ModelScope 上。对于我们这些在应用层的开发者来说,这简直是天上掉馅饼。你不需要再去死磕那些昂贵的闭源API,完全可以基于这个地表最强的开源模型,去搭建自己的智能客服、同声传译或者游戏NPC。

而且,据说完整的实时语音API会在2026年2月上线。那时候,集成的门槛会更低。

写在最后

我们常说国产大模型在追赶,但这次,Step-Audio-R1.1 的表现更像是一次弯道超车。它证明了在多模态、尤其是语音推理这个细分赛道上,单纯堆算力不一定是唯一解,架构的创新和对声音本质的理解同样关键。

如果你也是一名开发者,或者对人机交互感兴趣,我强烈建议你去试试这个模型。毕竟,能听懂"弦外之音"的AI,才是我们真正想要的未来。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站