《博主简介》

小伙伴们好,我是阿旭。

专注于计算机视觉领域,包括目标检测、图像分类、图像分割和目标跟踪等项目开发,提供模型对比实验、答疑辅导等。

《------往期经典推荐------》

二、机器学习实战专栏【链接】 ,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

目录

引言

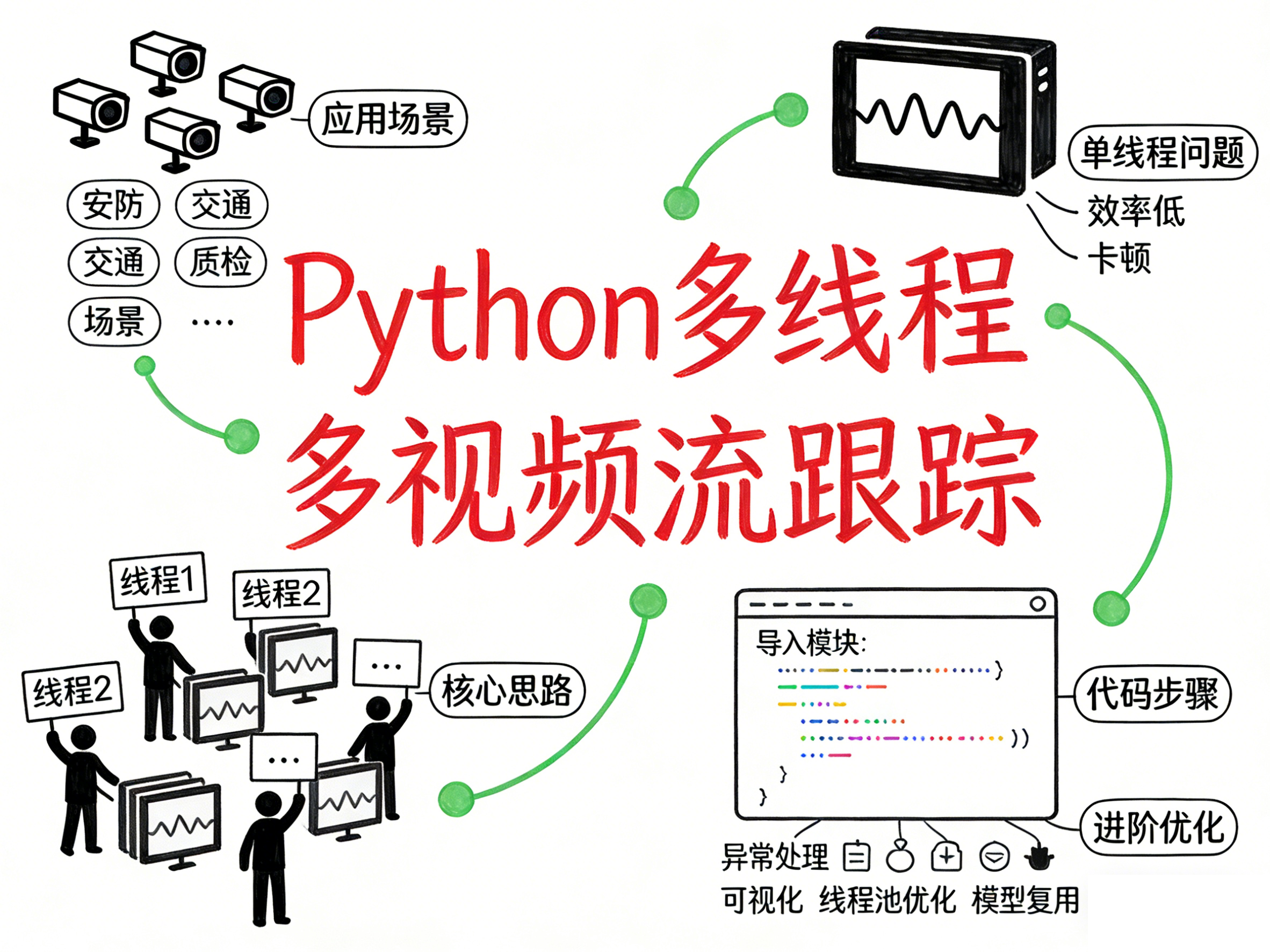

在安防监控、智能交通、工业质检等场景中,我们经常需要同时处理多个视频流的对象跟踪任务------比如同时监控多个摄像头画面,识别并跟踪行人、车辆、工件等目标。但如果用单线程逐个处理视频流,不仅效率极低,还会出现严重的卡顿,完全无法满足实时处理的需求。

有没有简单又高效的解决办法?当然有!今天就带大家学习 :如何用Python的threading模块结合YOLO模型,实现多视频流的并发对象跟踪,让多个视频流的处理"并行"进行,彻底解决单流处理的卡顿问题。

一、核心思路:多线程处理多视频流

想要同时处理多个视频流,核心是利用Python的多线程机制:为每个视频流分配一个独立的线程,每个线程单独加载YOLO模型并处理对应的视频流,线程之间互不干扰,从而实现并发处理。

在开始编码前,先确保安装好必要的依赖库:

bash

pip install opencv-python ultralyticsopencv-python(cv2):负责视频流的读取、窗口管理等基础操作;ultralytics:YOLO模型的官方封装库,可一键实现对象检测与跟踪。

二、完整代码+逐行详解

下面是实现多视频流对象跟踪的完整代码:

python

# 导入核心模块

import threading # 多线程管理模块

import cv2 # 视频处理模块

from ultralytics import YOLO # YOLO模型模块

# 1. 配置模型和视频源

# 可替换为自己的YOLO模型文件(如yolov8n.pt)

MODEL_NAMES = ["yolo26n.pt", "yolo26n-seg.pt"]

# 视频源:本地视频路径/摄像头编号(0=电脑自带摄像头,1=外接摄像头)

SOURCES = ["path/to/video.mp4", "0"]

# 2. 定义单线程跟踪函数

def run_tracker_in_thread(model_name, filename):

"""

单个线程执行的函数:处理单个视频流的对象跟踪

Args:

model_name (str): YOLO模型文件名

filename (str): 视频文件路径/摄像头编号

"""

# 加载指定的YOLO模型

model = YOLO(model_name)

# 启动对象跟踪:save=True保存处理结果,stream=True流式处理(节省内存)

results = model.track(filename, save=True, stream=True)

# 遍历每帧跟踪结果(可在此处添加自定义逻辑,如绘制跟踪框)

for r in results:

pass

# 3. 创建并启动多线程

tracker_threads = [] # 存储所有线程,方便管理

# 为每个视频流+模型组合创建线程

for video_file, model_name in zip(SOURCES, MODEL_NAMES):

# 创建线程:daemon=True表示主线程结束时子线程自动结束

thread = threading.Thread(

target=run_tracker_in_thread,

args=(model_name, video_file),

daemon=True

)

tracker_threads.append(thread) # 加入线程列表

thread.start() # 启动当前线程

# 4. 等待所有线程执行完毕

for thread in tracker_threads:

thread.join()

# 5. 清理资源:关闭所有OpenCV窗口

cv2.destroyAllWindows()代码逐行解析

-

模块导入:

threading:Python内置模块,无需额外安装,是实现多线程的核心;cv2:处理视频流的基础工具,负责读取视频帧、关闭窗口等;YOLO:从ultralytics导入,封装了YOLO模型的所有功能,一行代码就能启动跟踪。

-

配置模型与视频源:

MODEL_NAMES:存放YOLO模型文件的列表,每个模型可对应一个视频流(也可多个流复用同一个模型,减少内存占用);SOURCES:视频源列表,支持本地视频文件(需替换为实际路径)和摄像头设备编号。

-

核心函数

run_tracker_in_thread:这是每个线程的"工作内容",专门处理单个视频流的跟踪:

model = YOLO(model_name):加载指定的YOLO模型,准备跟踪;model.track(...):启动跟踪任务,save=True会自动保存处理后的视频/帧,stream=True表示逐帧流式处理(避免一次性加载整个视频,节省内存);for r in results:遍历每帧的跟踪结果,此处的pass可替换为自定义逻辑(比如用cv2绘制跟踪框、解析目标坐标等)。

-

创建并启动线程:

- 用

zip将视频源和模型一一配对,确保每个视频流有对应的模型处理; threading.Thread(...):创建线程对象,target指定线程要执行的函数,args传递函数参数;thread.start():启动线程,此时多个线程会同时开始处理各自的视频流。

- 用

-

等待线程&清理资源:

thread.join():让主线程等待所有子线程执行完毕,避免主线程提前退出导致程序中断;cv2.destroyAllWindows():程序结束后关闭所有OpenCV窗口,释放系统资源。

三、进阶优化

学会基础实现后,可根据实际需求优化:

- 异常处理 :在

run_tracker_in_thread函数中添加try-except,处理视频源读取失败、模型加载错误等问题; - 结果可视化 :在

for r in results循环中,用cv2.imshow()显示带跟踪框的视频帧,直观查看效果; - 线程池优化 :若处理大量视频流,可使用

concurrent.futures.ThreadPoolExecutor限制线程数量,避免资源耗尽; - 模型复用:将模型加载逻辑移到函数外,多个线程复用同一个模型,减少内存占用。

总结

本文通过Python多线程+YOLO模型,实现了多视频流的并发对象跟踪,核心逻辑就是"为每个视频流分配独立线程,并行处理"。这种方法简单易上手,能彻底解决单线程处理多视频流的卡顿问题,适用于安防监控、智能交通等绝大多数实时跟踪场景。

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!