一、Java 基础(高频 & 深度)

HashMap 扩容是 2 倍,为什么必须是 2 的幂。

"HashMap 扩容是 2 倍"并且容量必须是 2 的幂(如 16, 32, 64...) ,这是 Java 中 HashMap(以及 ConcurrentHashMap 等)设计的核心优化之一。其根本原因在于:为了高效、均匀地计算元素在数组中的存储位置(即哈希槽 index),并支持快速扩容时的 rehash(重新散列)。

下面我们从 哈希定位、位运算优化、扩容重分布 三个角度深入解释。

一、核心目的:用位运算替代取模(%)

❌ 普通做法(非 2 的幂)

如果数组长度为 length(任意正整数),要将哈希值 hash 映射到 [0, length-1] 范围,通常用:

java

index = hash % length;但 **%**** 运算涉及除法,在 CPU 层面开销较大**。

✅ HashMap 的优化(仅当 length 是 2 的幂时成立)

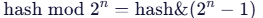

当 length = 2^n 时,有数学恒等式:

例如:

length = 16 (2^4)→index = hash & 15(因为 15 = 1111₂)length = 32 (2^5)→index = hash & 31(31 = 11111₂)

💡 位与(&)运算比取模(%)快几十倍!

🔍 Java 源码验证(JDK 8+)

java

// HashMap.java

static int indexFor(int h, int length) {

return h & (length - 1); // 关键:依赖 length 是 2 的幂

}注意:JDK 8 后该方法内联到 putVal 中,但逻辑不变。

二、为什么必须是 2 的幂?------ 均匀分布 + 避免冲突

假设 length 不是 2 的幂,比如 length = 10,那么 length - 1 = 9(二进制 1001)。

此时 hash & 9 的结果只取决于 hash 的第 0 位和第 3 位,中间两位被屏蔽了!

| hash (二进制) | hash & 9 (二进制) | index |

|---|---|---|

| ...0000 | 0000 | 0 |

| ...0001 | 0001 | 1 |

| ...0010 | 0000 | 0 |

| ...0011 | 0001 | 1 |

| ...1000 | 1000 | 8 |

| ...1001 | 1001 | 9 |

| ...1010 | 1000 | 8 |

→ 大量不同 hash 值映射到相同 index,哈希冲突剧增,退化成链表/红黑树,性能暴跌!

而当 length = 16(length-1=15=1111₂)时:

hash & 15会用到 hash 的最低 4 位- 只要 hash 函数足够随机,这 4 位就能均匀分布 → index 均匀分布

✅ 2 的幂保证 **(length - 1)** 的二进制全是 1,从而充分利用 hash 的低位信息,实现均匀散列。

三、扩容时的高效 rehash(关键优势!)

当 HashMap 从 oldCap = 16 扩容到 newCap = 32 时,不需要重新计算所有元素的 hash!

📌 规律(仅当容量是 2 的幂时成立):

对于任意元素,其在新数组中的位置只有两种可能:

- 保持原位置 (

index不变) - 移动到

**index + oldCap**位置

🔍 原因分析

设:

oldCap = 2^nnewCap = 2^{n+1}- 元素原 index =

hash & (oldCap - 1) - 新 index =

hash & (newCap - 1)

由于 newCap - 1 比 oldCap - 1多一位 1 (例如 15=01111 → 31=11111),

所以新 index 是否变化,只取决于 hash 的第 n 位(从 0 开始)是否为 1:

- 如果第 n 位 = 0 → 新 index = 原 index

- 如果第 n 位 = 1 → 新 index = 原 index + oldCap

✅ Java 源码(JDK 8 扩容逻辑)

java

// 在 resize() 方法中

if ((e.hash & oldCap) == 0) {

// 保持原位置

loHead = e;

} else {

// 移动到 index + oldCap

hiHead = e;

}⚡ 只需一次位与操作 ( **e.hash & oldCap**),即可决定元素去向,无需重新计算 hash!

❌ 如果容量不是 2 的幂?

- 扩容后

newCap和oldCap无倍数关系 - **每个元素都必须重新执行 **

**hash % newCap** - 时间复杂度从 O(1) per element 变成 O(n) per element,扩容成本极高!

四、总结:为什么必须是 2 的幂?

| 优势 | 说明 |

|---|---|

| ✅ 高效定位 | index = hash & (length-1)比 % 快一个数量级 |

| ✅ 均匀分布 | (length-1) 全为 1,充分利用 hash 低位,减少冲突 |

| ✅ 快速扩容 | 扩容时只需判断 hash & oldCap,元素要么不动,要么移 +oldCap |

| ✅ 内存对齐 | 2 的幂更利于 CPU 缓存行对齐(次要因素) |

🚫 如果不用 2 的幂:

- 定位慢(% 运算)

- 冲突多(分布不均)

- 扩容慢(全量 rehash)

→ 完全丧失 HashMap 的高性能优势!

补充:其他语言/容器的选择

| 语言/容器 | 容量策略 | 原因 |

|---|---|---|

| Java HashMap | 2 的幂 | 上述优化 |

| Python dict | 2 的幂 | 类似优化(CPython 实现) |

| C++ std::unordered_map | 质数 | 避免用户自定义 hash 的周期性冲突(牺牲速度换鲁棒性) |

💡 Java 选择 2 的幂,是在假设 hash 函数质量较高(如 Object.hashCode() 经过扰动)的前提下,追求极致性能的设计决策。

因此,"HashMap 容量必须是 2 的幂"不是随意规定,而是性能、正确性、扩容效率三者平衡后的最优解。

String 在 JDK 9+ 的底层实现变化是什么?为什么改用 byte[] + coder?

在 JDK 9 中,String 类的底层实现发生了重大变化:从 **char[]** 改为 **byte[] + coder**。这是 Java 平台为了节省内存、提升性能而引入的关键优化(JEP 254: Compact Strings)。

一、JDK 9 之前的实现(JDK 8 及更早)

java

public final class String {

private final char value[]; // 每个字符占 2 字节(UTF-16)

// ...

}- 所有字符串内部都用

char[]存储。 char是 16 位(2 字节),基于 UTF-16 编码。- 问题 :对于只包含 Latin-1 字符(如英文、数字、常见符号,0--255 范围)的字符串,每个字符实际只需 1 字节 ,但 JVM 仍分配 2 字节 ,造成 50% 内存浪费。

💡 据 Oracle 统计,大多数 Java 应用中的字符串都是 Latin-1 兼容的(尤其是 Web 应用、日志、配置等)。

二、JDK 9+ 的新实现

java

public final class String {

private final byte[] value; // 存储字符的字节数据

private final byte coder; // 编码标识:0 = LATIN1, 1 = UTF16

// ...

}关键变化:

| 成员 | 说明 |

|---|---|

byte[] value |

实际存储字符的字节数组 |

byte coder |

编码方式标记: • COMPACT_STRINGS 开启时: -- 0 表示 Latin-1 (1 字节/字符) -- 1 表示 UTF-16(2 字节/字符) |

✅ 默认启用 CompactStrings(可通过 -XX:-CompactStrings 关闭,退回到 char[] 行为)。

三、为什么改用 byte[] + coder?

✅ 核心目标:减少内存占用,提升 GC 和缓存效率

| 优势 | 说明 |

|---|---|

| 内存减半(对 Latin-1 字符串) | 英文字符串内存占用从 2n → n 字节,堆内存显著下降 |

| 减少 GC 压力 | 对象变小 → 更少 GC 次数、更短 STW 时间 |

| 提升 CPU 缓存命中率 | 数据更紧凑 → 更多字符串能放入 L1/L2 缓存 → 性能提升 |

| 兼容性无损 | 对外 API 完全不变,开发者无需修改代码 |

📊 实测效果(Oracle 官方数据):

- 堆内存减少 10%~40%(取决于应用字符串特征)

- GC 时间减少 5%~15%

- 某些字符串操作(如

**indexOf**)速度提升

四、内部如何工作?(以 String 构造为例)

java

// 创建 "Hello"(纯 Latin-1)

String s = "Hello";

// JDK 9+ 内部:

// value = byte[]{72, 101, 108, 108, 111} // ASCII 值

// coder = 0 (LATIN1)

// 创建 "你好"(含非 Latin-1 字符)

String s2 = "你好";

// value = byte[]{... UTF-16 编码的字节 ...}

// coder = 1 (UTF16)所有字符串操作(charAt, substring, equals 等)都会根据 coder 选择不同的实现路径:

java

public char charAt(int index) {

if (isLatin1()) {

return (char)(value[index] & 0xff);

} else {

return StringUTF16.charAt(value, index);

}

}五、对开发者的影响

| 场景 | 影响 |

|---|---|

**正常使用 ****String** |

✅ 完全透明,无感知 |

**反射访问 ****value**字段 |

⚠️ **破坏兼容性!**JDK 9+ value 是 byte[],旧代码假设是 char[]会崩溃 |

| 序列化/反序列化 | ✅ JVM 自动处理,无问题 |

| JNI 或 Unsafe 操作 | ⚠️ 需要适配新结构(不推荐直接操作内部字段) |

🔒 从 Java 9 开始,强烈建议不要通过反射访问 **String** 的内部字段!

六、如何验证?

java

public class StringInternals {

public static void main(String[] args) throws Exception {

String s1 = "Hello"; // Latin-1

String s2 = "你好"; // UTF-16

Field valueField = String.class.getDeclaredField("value");

Field coderField = String.class.getDeclaredField("coder");

valueField.setAccessible(true);

coderField.setAccessible(true);

System.out.println("s1 coder: " + coderField.get(s1)); // 0

System.out.println("s2 coder: " + coderField.get(s2)); // 1

byte[] v1 = (byte[]) valueField.get(s1);

System.out.println(Arrays.toString(v1)); // [72, 101, 108, 108, 111]

}

}总结

| 特性 | JDK 8- | JDK 9+ |

|---|---|---|

| 底层存储 | char[](固定 2 字节/字符) |

byte[] + coder(1 或 2 字节/字符) |

| 内存效率 | 低(Latin-1 浪费 50%) | 高(按需分配) |

| 性能 | 一般 | 更优(缓存友好 + GC 减轻) |

| 兼容性 | --- | 对外 API 不变,内部字段不可依赖 |

💡 这次改动是 Java 在"向后兼容"前提下,对内存模型的一次优雅优化,体现了 JVM 团队对真实应用场景的深刻理解。

record 类和普通 class 的本质区别?它能继承吗?能有静态方法吗?

record 是 Java 14(JEP 359)引入的预览特性 ,Java 16 正式发布,用于简洁地建模不可变的数据载体类(data carrier) 。它与普通 class 在语义、语法和行为上有本质区别。

一、本质区别

| 特性 | record |

普通 class |

|---|---|---|

| 设计目的 | 表示纯数据(值对象),强调"是什么" | 表示行为 + 状态,强调"能做什么" |

| 不可变性 | 所有字段默认 private final,自动提供只读访问器 |

需手动实现不可变性(final字段 + 无 setter) |

| 自动生成代码 | 编译器自动生成: • private final字段 • 公共构造器 • accessor方法(同字段名) • equals()/ hashCode() • toString() |

全部需手动编写(或用 Lombok) |

| 继承 | 不能继承其他类 (隐式 extends java.lang.Record) 不能被继承 (隐式 final) |

可继承一个父类,可被继承 (除非 final) |

| 接口实现 | ✅ 可以 implements接口 |

✅ 可以 |

| 静态成员 | ✅ 可以有静态字段、静态方法、静态初始化块 | ✅ 可以 |

| 实例方法 | ✅ 可以添加自定义实例方法(但不能覆盖 equals/toString/hashCode的核心逻辑) |

✅ 可以 |

| 额外字段 | ❌ 不能声明额外的实例字段(只能通过参数列表定义) | ✅ 可以 |

| 构造器 | 可写紧凑构造器(compact constructor)或规范构造器(canonical constructor) | 可自由定义 |

二、关键问题详解

1. record 能继承吗?

- 不能继承其他类 :因为

record隐式继承自java.lang.Record(抽象类),而 Java 不支持多继承。 - 不能被继承 :

record隐式是final的。

java

// ❌ 编译错误:Cannot extend record

class MyRecord extends Point { }

// ❌ 编译错误:Cannot inherit from final 'Point'

class SubPoint extends Point { }

record Point(int x, int y) { }✅ 但可以实现接口:

java

record Point(int x, int y) implements Comparable<Point> {

public int compareTo(Point other) {

return Integer.compare(this.x, other.x);

}

}2. record 能有静态方法吗?

✅ 完全可以!

java

record Person(String name, int age) {

// 静态字段

private static final String DEFAULT_NAME = "Unknown";

// 静态方法

public static Person unknown() {

return new Person(DEFAULT_NAME, 0);

}

// 静态工厂方法(推荐替代构造器)

public static Person of(String name, int age) {

if (name == null || name.isBlank()) throw new IllegalArgumentException();

return new Person(name, age);

}

// 静态初始化块

static {

System.out.println("Person record loaded");

}

}使用:

java

Person p1 = Person.unknown();

Person p2 = Person.of("Alice", 30);3. record 能有实例方法吗?

✅ 可以,但不能修改状态 (因为字段是 final):

java

record Circle(double radius) {

// 实例方法(只读计算)

public double area() {

return Math.PI * radius * radius;

}

// 重写 toString(不推荐,除非必要)

@Override

public String toString() {

return "Circle[r=" + radius + "]";

}

}三、record 的字节码等价形式(概念上)

java

// record 声明

record Point(int x, int y) { }

// ≈ 等价于以下普通 class(简化版)

public final class Point extends Record {

private final int x;

private final int y;

public Point(int x, int y) {

this.x = x;

this.y = y;

}

public int x() { return x; }

public int y() { return y; }

@Override public boolean equals(Object o) { /* 基于 x, y */ }

@Override public int hashCode() { /* 基于 x, y */ }

@Override public String toString() { /* "Point[x=..., y=...]" */ }

}注意:Record 是 java.lang 中的抽象基类,所有 record 都继承它。

四、何时用 record?何时用 class?

| 场景 | 推荐 |

|---|---|

| DTO、POJO、返回多个值、临时数据结构 | ✅ record |

| 需要封装行为(如策略、状态机) | ✅ 普通 class |

| 需要继承体系 | ✅ 普通 class |

| 需要可变状态 | ✅ 普通 class |

作为 Map key(需正确 equals/hashCode ) |

✅ record (天然支持) |

总结

record是不可变数据类的语法糖,不是普通类的替代品。- 不能继承(自身 final + 已继承 Record)。

- 可以有静态方法、静态字段、实例方法、实现接口。

- 不能有额外实例字段,不能有 setter。

- 适用于数据传输、模式匹配(Java 21+)、函数式编程等场景。

💡 记住:record 是"值",class 是"对象"。

Pattern Matching for instanceof(JDK 14+)如何避免冗余类型转换?编译后字节码有何优化?

Pattern Matching for instanceof 是 Java 14 引入的预览特性 (JEP 305),在 Java 16 正式发布 ,它通过模式匹配(Pattern Matching) 消除了传统 instanceof 后冗余的显式类型转换,使代码更简洁、安全、可读。

一、传统写法 vs 模式匹配

❌ 传统写法(冗余 + 不安全)

java

if (obj instanceof String) {

String s = (String) obj; // 冗余强制转换

System.out.println(s.length());

}问题:

- 需要手动强转,代码啰嗦;

- 如果后续修改了

instanceof类型但忘记改强转,可能出错; - 编译器无法保证强转一定成功(尽管逻辑上安全)。

✅ 模式匹配写法(JDK 16+)

java

if (obj instanceof String s) { // 声明绑定变量 s

System.out.println(s.length()); // 直接使用,无需强转

}优势:

- 自动类型推断 + 范围限定 :

s在if块内是String类型; - 编译器保证类型安全:无需担心强转异常;

- 避免重复计算 :

instanceof和赋值合并为一次操作。

二、如何避免冗余类型转换?

核心机制:绑定变量(Binding Variable)

instanceof String s中的s是一个模式变量(pattern variable);- 它的作用域被智能限制在

instanceof为true的分支中; - 编译器隐式完成类型检查 + 赋值 ,无需程序员写

(String) obj。

✅ 这不是语法糖!而是语言级别的模式匹配能力,未来可扩展到 switch(如 Java 21 的 switch 模式匹配)。

三、编译后字节码有何优化?

我们对比两种写法的字节码:

示例代码

java

// 传统

public void old(Object obj) {

if (obj instanceof String) {

String s = (String) obj;

System.out.println(s.length());

}

}

// 模式匹配

public void modern(Object obj) {

if (obj instanceof String s) {

System.out.println(s.length());

}

}字节码对比(简化版)

传统写法字节码:

plain

aload_1 ; 加载 obj

instanceof String ; 检查类型

ifeq L1 ; 如果 false,跳过

aload_1 ; 再次加载 obj

checkcast String ; 显式强转(冗余 checkcast)

astore_2 ; 存入局部变量 s

...模式匹配字节码:

plain

aload_1 ; 加载 obj

dup ; 复制一份引用(关键!)

instanceof String ; 检查类型

ifeq L1 ; 如果 false,跳过

checkcast String ; 强转(但只做一次)

astore_2 ; 存入局部变量 s

...🔍 关键优化点:

| 优化 | 说明 |

|---|---|

| 减少一次对象加载 | 传统写法需两次 aload_1(一次检查,一次强转); 新模式用 dup复用栈顶引用,只需一次加载 |

**checkcast**仍存在,但语义更安全 |

JVM 仍需做类型检查(安全要求),但编译器确保其不会失败 |

| 局部变量作用域精确控制 | s只在 if块内有效,避免变量污染 |

💡 虽然 checkcast 字节码仍然存在(JVM 安全模型要求),但源码层面消除了冗余强转 ,且运行时性能略优或持平(因减少了一次字段/变量读取)。

四、进阶:与 final 和复杂条件结合

1. 绑定变量是 final 的(隐式)

java

if (obj instanceof String s) {

s = "new"; // ❌ 编译错误!s 是 final

}2. 支持逻辑组合(注意作用域)

java

if (obj instanceof String s && s.length() > 0) {

System.out.println(s); // ✅ s 在此处可用

}

// 但不能这样:

if (obj instanceof String s || flag) {

// ❌ s 在此处不可用!因为 || 右侧为 true 时 s 未初始化

}五、未来演进

- Java 21+ :模式匹配已扩展到

switch表达式:

java

switch (obj) {

case Integer i -> System.out.println(i * 2);

case String s when s.length() > 0 -> System.out.println(s);

default -> System.out.println("unknown");

}- 解构模式(Deconstruction Patterns) :未来可能支持

case Point(int x, int y)。

总结

| 方面 | 传统 instanceof |

模式匹配 instanceof |

|---|---|---|

| 代码冗余 | 需手动强转 | 自动绑定变量,无强转 |

| 类型安全 | 依赖程序员正确性 | 编译器保证 |

| 字节码效率 | 多一次对象加载 | 用 dup优化,略高效 |

| 可读性 | 较差 | 清晰表达"如果它是 X,就当作 X 用" |

| 扩展性 | 无 | 为未来模式匹配(switch等)铺路 |

✅ 结论 :

instanceof 模式匹配不是简单的语法糖 ,而是一种安全、高效、可扩展的语言特性。它在保持 JVM 安全模型的同时,显著提升了开发体验和代码质量。建议在 JDK 16+ 项目中全面采用。

为什么 switch 支持 String 后,底层仍用 hashCode + equals 而非直接跳转表?

这是一个非常深入且经典的问题!

Java 的 **switch** 语句在 JDK 7 开始支持 **String** 类型,但其底层实现并未使用传统的"跳转表(jump table)",而是基于 **hashCode()** + **equals()** 的多层 **if-else** 或查表结构。原因在于: **String**** 的值空间是无限的、稀疏的,且无法在编译时确定所有可能的分支值。**

下面我们从原理、实现和性能角度详细解释。

一、传统 switch(int/enum)为何能用跳转表?

对于 **int**、 **byte**、 **short**、 **char**、 **enum** 等类型:

- 值域有限且连续(或可映射为连续整数,如 enum 的 ordinal);

- 编译器可以在编译时知道所有

case常量; - JVM 可生成高效的 tableswitch 或 lookupswitch 字节码,实现 O(1) 跳转。

java

switch (day) {

case 1: ...

case 2: ...

case 3: ...

}

// → 编译为 tableswitch,直接索引跳转二、String 为什么不能直接用跳转表?

❌ 核心问题:**String**** 的值不是编译时常量整数,且空间巨大**

**String**** 的值域是无限的**- 可能的字符串有无数个("a", "aa", "aaa", ...),无法建立完整跳转表。

**case**** 标签是字符串字面量,但运行时输入是任意**String**对象**- 编译器不知道运行时传入的是什么字符串;

- 必须在运行时动态比较内容,而非简单整数匹配。

- 哈希冲突不可避免

- 即使使用

hashCode()作为"伪索引",不同字符串也可能有相同哈希值(如"Aa"和"BB"的hashCode()都是 2112); - 必须用

**equals()**二次验证,确保语义正确。

- 即使使用

三、JDK 实际如何实现 String switch?

以以下代码为例:

java

switch (str) {

case "apple": return 1;

case "banana": return 2;

case "cherry": return 3;

default: return 0;

}✅ 编译后的逻辑(概念等价于):

java

public static int switchString(String str) {

if (str == null) {

throw new NullPointerException(); // 注意:String switch 不支持 null

}

int hash = str.hashCode();

// 第一层:按 hashCode 快速分组(减少 equals 次数)

if (hash == 96415 || hash == 97281956 || hash == -1998214767) {

// 第二层:精确匹配(防止哈希冲突)

if (str.equals("apple")) {

return 1;

} else if (str.equals("banana")) {

return 2;

} else if (str.equals("cherry")) {

return 3;

}

}

return 0; // default

}🔍 实际字节码可能更优化(如用 lookupswitch 按 hashCode 分支),但**核心仍是 ****hashCode + equals**。

四、为什么不直接用 Map<String, Runnable> 实现?

你可能会想:"为什么不编译成一个 HashMap,然后 map.get(str) 直接跳转?"

- 启动开销大:每次方法调用都要初始化 map(除非静态缓存);

- 内存占用高:每个 switch 都要维护一个 map;

- 小分支场景效率低 :当只有 2~3 个 case 时,

if-else比 hash 查找更快; - JIT 优化友好性 :

if-else更容易被 HotSpot 内联和优化。

📌 实际上,JVM 在 JIT 编译阶段可能会进一步优化热点路径 (如将频繁命中的分支提升),但初始字节码仍基于 hashCode + equals。

五、性能影响 & 最佳实践

| 场景 | 建议 |

|---|---|

| 少量 case(≤3) | String switch 性能接近 if-else,可放心使用 |

| 大量 case(>10) | 考虑手动用 Map<String, ?>预构建,避免线性扫描 |

| 高频调用 | JVM 会 JIT 优化,实际性能差异不大 |

| 避免 null | String switch遇 null会抛 NPE! |

六、验证:查看字节码

编译后反编译(javap -c)可以看到:

plain

// 伪字节码示意

aload_0 ; 加载 str

invokevirtual #hashCode

lookupswitch {

96415: L1,

97281956: L2,

-1998214767: L3,

default: Ldefault

}

L1:

aload_0

ldc "apple"

invokevirtual #equals

ifeq Ldefault

iconst_1

ireturn

...✅ 总结

| 问题 | 答案 |

|---|---|

| 为什么不用跳转表? | String值域无限、非整数,无法建立 O(1) 跳转表 |

为什么用 **hashCode**? |

快速分组,减少 equals()调用次数(避免全量线性扫描) |

为什么还要 **equals()**? |

处理哈希冲突,保证语义正确性 |

| 性能如何? | 小规模 case 效率高;大规模建议手写 Map |

| 安全吗? | 安全,但不支持 null输入 |

💡 本质 :String switch 是语法糖 + 运行时内容比较 ,而非传统整数跳转。这是在通用性、安全性和性能之间取得的最佳平衡。

强引用、软引用、弱引用、虚引用的实际应用场景分别是什么?举例说明。

在 Java 中,引用类型(Reference Types)是内存管理和垃圾回收(GC)机制的重要组成部分。除了最常见的强引用(Strong Reference) ,JDK 还提供了 软引用(SoftReference)、弱引用(WeakReference)、虚引用(PhantomReference),它们在不同场景下控制对象的生命周期和 GC 行为。

下面详细说明四者的定义、GC 行为及典型实际应用场景,并附代码示例。

一、强引用(Strong Reference)

✅ 定义

最常见的引用形式,如:

java

Object obj = new Object();只要强引用存在,GC 永远不会回收该对象,即使发生 OOM(OutOfMemoryError)。

🚫 GC 行为

- 不会被回收 ,直到引用置为

null或超出作用域。

💡 实际应用场景

- 所有常规对象使用:业务实体、服务类、控制器等。

- 必须保证对象存活的场景。

⚠️ 注意:强引用过多且不释放,是内存泄漏的常见原因。

二、软引用(SoftReference)

✅ 定义

java

SoftReference<byte[]> ref = new SoftReference<>(new byte[1024 * 1024]);描述"有用但非必需 "的对象。只有在内存不足(即将 OOM)时,GC 才会回收软引用对象。

🧹 GC 行为

- 内存充足 → 不回收;

- 内存紧张 → 回收(作为最后的缓存清理手段)。

💡 实际应用场景:内存敏感的缓存

✅ 示例:图片缓存(如 Android Bitmap 缓存)

java

public class ImageCache {

private Map<String, SoftReference<Bitmap>> cache = new ConcurrentHashMap<>();

public Bitmap get(String key) {

SoftReference<Bitmap> ref = cache.get(key);

return (ref != null) ? ref.get() : null;

}

public void put(String key, Bitmap bitmap) {

cache.put(key, new SoftReference<>(bitmap));

}

}- 当内存充足时,图片保留在缓存中,快速加载;

- 当系统内存紧张时,GC 自动清理缓存,避免 OOM。

✅ 优势:无需手动管理缓存大小,由 JVM 根据内存压力自动调节。

三、弱引用(WeakReference)

✅ 定义

java

WeakReference<Object> ref = new WeakReference<>(new Object());描述"非必需 "的对象。只要发生 GC(无论内存是否充足),就会回收弱引用对象。

🧹 GC 行为

- 每次 GC 都会回收(比软引用更"弱")。

💡 实际应用场景

场景 1:防止内存泄漏的监听器/回调注册

java

// 错误做法:强引用导致 Activity 无法回收

button.setOnClickListener(this); // this 是 Activity,造成泄漏

// 正确做法:使用弱引用包装

private static class ClickListener implements View.OnClickListener {

private final WeakReference<MainActivity> activityRef;

ClickListener(MainActivity activity) {

this.activityRef = new WeakReference<>(activity);

}

@Override

public void onClick(View v) {

MainActivity activity = activityRef.get();

if (activity != null) {

activity.doSomething();

}

}

}- 即使忘记反注册监听器,Activity 也能被 GC 回收。

场景 2:WeakHashMap ------ 自动清理的映射表

java

// 用作"元数据缓存"或"关联容器"

Map<Object, String> metadata = new WeakHashMap<>();

Object key = new Object();

metadata.put(key, "some info");

key = null; // key 无强引用

System.gc(); // 下次 GC 后,entry 自动消失- Key 是弱引用:当 key 对象无其他强引用时,整个 entry 被自动移除。

- 常用于:类加载器元数据缓存、动态代理缓存、ThreadLocal 替代方案等。

🔍 典型应用:

ThreadLocal内部使用ThreadLocalMap,其 key 是WeakReference<ThreadLocal>,防止 ThreadLocal 对象泄漏。

四、虚引用(PhantomReference)

✅ 定义

java

PhantomReference<Object> ref = new PhantomReference<>(obj, queue);- 最弱的引用 ,不能通过它获取对象 (

get()永远返回null); - 必须与 ReferenceQueue 联用;

- 用途:跟踪对象被 GC 的时机,执行清理操作(类似 C++ 的析构函数)。

🧹 GC 行为

- 对象 finalize() 后、真正回收前,虚引用被加入关联的

ReferenceQueue。

💡 实际应用场景:资源清理(尤其是堆外内存)

✅ 示例:DirectByteBuffer 的内存回收

- Java NIO 的

DirectByteBuffer分配的是堆外内存(native memory); - JVM 无法通过 GC 自动释放堆外内存;

- 解决方案:

Cleaner(内部基于PhantomReference)在对象被回收时触发free()。

java

// 简化版原理

ReferenceQueue<Object> queue = new ReferenceQueue<>();

PhantomReference<MyResource> phantomRef =

new PhantomReference<>(resource, queue);

// 后台线程监控 queue

new Thread(() -> {

try {

PhantomReference<?> ref = (PhantomReference<?>) queue.remove();

// 此时 resource 已不可达,可安全释放 native 资源

releaseNativeResource();

ref.clear(); // 清理引用

} catch (InterruptedException e) {}

}).start();✅ 优势:确保资源最终被释放,即使用户忘记调用 close()。

⚠️ 注意:Java 9+ 推荐使用 Cleaner 类(更安全),而非直接操作 PhantomReference。

五、四类引用对比总结

| 引用类型 | 获取对象 | GC 时机 | 典型用途 |

|---|---|---|---|

| 强引用 | ✅ 可获取 | 永不回收(有引用时) | 普通对象 |

| 软引用 | ✅ 可获取 | 内存不足时回收 | 内存敏感缓存(如图片) |

| 弱引用 | ✅ 可获取 | 下次 GC 时回收 | 防泄漏监听器、WeakHashMap |

| 虚引用 | ❌ 永远 null |

finalize 后、回收前入队 | 堆外资源清理(如 DirectBuffer) |

六、选择建议

- 默认用强引用;

- 做缓存? → 考虑

SoftReference(但注意:现代缓存库如 Caffeine 更推荐基于 size/time 的显式策略); - 防内存泄漏? → 用

WeakReference(如监听器、WeakHashMap); - 管理 native 资源? → 用

PhantomReference或Cleaner(但优先实现AutoCloseable+ try-with-resources)。

💡 重要提醒 :

软/弱引用不能替代良好的资源管理 。对于关键资源(如文件、数据库连接),仍应显式关闭(try-with-resources)。引用类型主要用于辅助性、非关键性的内存优化。

二、并发编程(重点:原理 + 场景)

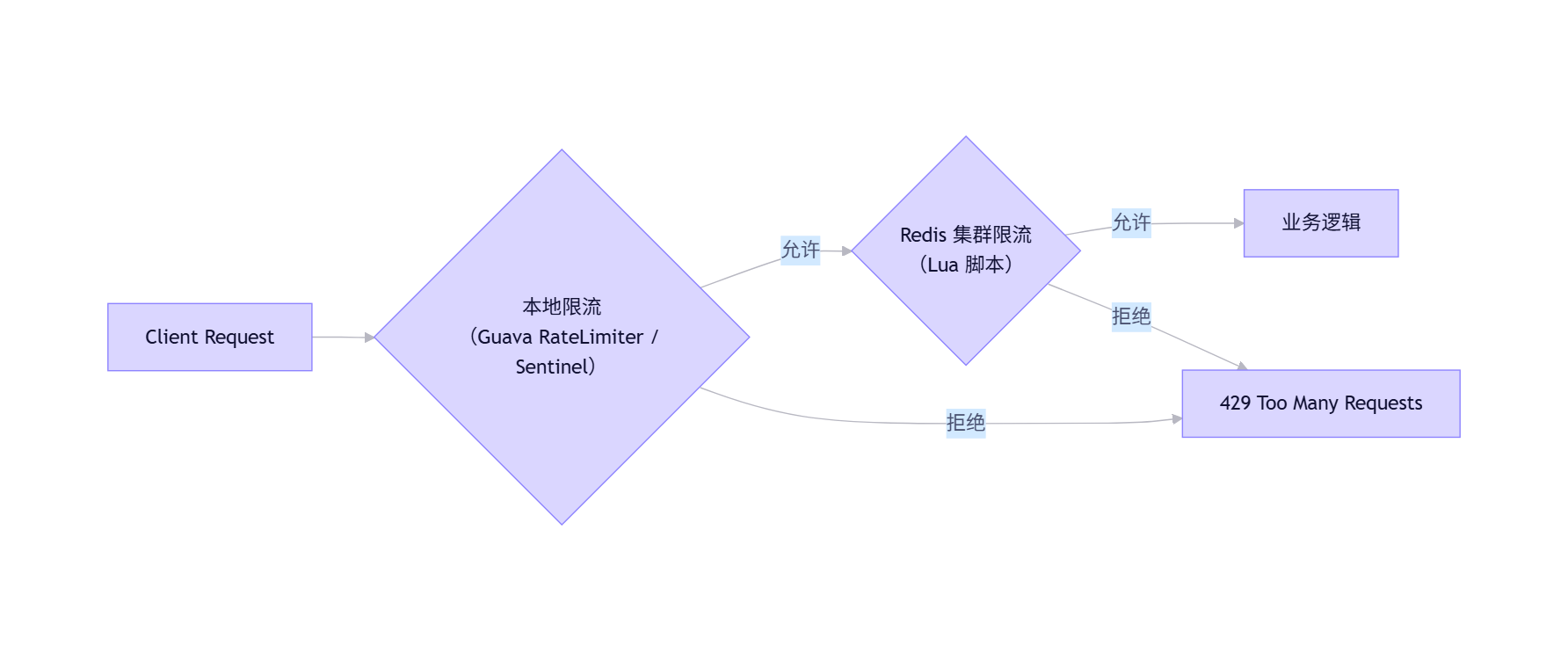

AQS 中的 state 是 volatile 的,为什么还需要 CAS 操作?仅靠 volatile 能保证原子性吗?

这是一个非常关键且常见的并发编程问题。答案是:

**volatile**** 能保证可见性和有序性,但不能保证复合操作的原子性;而 AQS 中对 **state** 的操作(如 **acquire** /**release**)通常是"读-改-写"这类复合操作,必须依赖 CAS(Compare-And-Swap)来保证原子性。**

下面我们从原理、代码和内存模型角度详细解释。

一、AQS 中的 state 定义

在 AbstractQueuedSynchronizer(AQS)中,state 是一个 **volatile int**:

java

// java.util.concurrent.locks.AbstractQueuedSynchronizer

private volatile int state;volatile确保:- 可见性 :一个线程修改

state,其他线程立即看到最新值; - 禁止指令重排序:防止编译器或 CPU 重排导致状态不一致。

- 可见性 :一个线程修改

但这不等于 所有对 state 的操作都是原子的!

二、为什么 volatile 不能保证原子性?

✅ volatile 保证的是 单次读/写 的原子性(对 int、boolean 等 32 位类型)

java

volatile int x = 0;

x = 1; // 原子写

int y = x; // 原子读❌ 但 复合操作 不是原子的!

例如:

java

state++; // 等价于:

// 1. 读取 state

// 2. 加 1

// 3. 写回 state这三步不是原子的 !多个线程同时执行 state++ 会导致丢失更新。

📌 关键结论 :

volatile ≠ 原子性(Atomicity)

它只解决 可见性 + 有序性 ,不解决 竞态条件(Race Condition)

三、AQS 中的实际操作:为什么需要 CAS?

AQS 的核心逻辑是 尝试获取/释放同步状态,典型方法如:

java

protected final boolean compareAndSetState(int expect, int update) {

return unsafe.compareAndSwapInt(this, stateOffset, expect, update);

}场景举例:ReentrantLock 的加锁逻辑

java

if (compareAndSetState(0, 1)) { // 尝试将 state 从 0 改为 1

setExclusiveOwnerThread(Thread.currentThread());

return true;

}这个操作的语义是:

"只有当当前 state 是 0 时,才把它设为 1;否则失败"

这正是 CAS(Compare-And-Swap) 的典型用法。

如果只用 volatile 会怎样?

java

// 错误示例:仅用 volatile

if (state == 0) { // 线程 A 读到 0

state = 1; // 但此时线程 B 也读到 0,并设为 1

}→ 两个线程都认为自己获得了锁! → 严重并发 bug。

四、CAS 如何解决问题?

CAS 是一条 CPU 原子指令 (如 x86 的 cmpxchg),它在硬件层面保证:

"比较内存中的值是否等于预期值,如果是,则更新为新值;整个过程不可中断"

因此:

java

compareAndSetState(0, 1)- 要么成功(返回

true,state 变为 1), - 要么失败(返回

false,说明有其他线程已修改 state)。

这保证了 "检查 + 修改" 的原子性。

五、AQS 的完整协作机制

AQS 并不只是靠 CAS,而是 CAS + volatile + 阻塞队列 协同工作:

- 快速路径(Fast Path) :

- 使用

compareAndSetState()尝试无竞争获取锁; - 成功则直接返回,零阻塞、高性能。

- 使用

- 慢速路径(Slow Path) :

- CAS 失败 → 进入 CLH 阻塞队列;

- 通过

LockSupport.park()挂起线程; - 释放锁时唤醒后继节点。

而 volatile state 的作用是:

- 让所有线程看到最新的锁状态;

- 配合 CAS 实现 happens-before 关系,保证状态变更对后续操作可见。

六、类比理解

| 机制 | 作用 | 类比 |

|---|---|---|

volatile state |

保证状态变更立即可见 | 黑板上的数字,所有人能看到最新值 |

CAS |

保证"看一眼再改"不被干扰 | 多人抢答:"如果黑板是 0,我就改成 1" ------ 必须原子完成 |

💡 没有 CAS,volatile 只能让你"看到别人改了",但无法安全地"自己去改"。

七、扩展:Java 中的原子类也是同样原理

AtomicInteger 内部也是:

java

private volatile int value;

public final int getAndIncrement() {

return unsafe.getAndAddInt(this, valueOffset, 1); // 底层是 CAS 循环

}volatile保证可见性;CAS保证原子性。

✅ 总结

| 问题 | 答案 |

|---|---|

**AQS 的 ****state**为什么是 **volatile**? |

保证多线程间状态变更的可见性 和有序性 |

**仅靠 ****volatile**能保证原子性吗? |

不能! volatile不保证复合操作(如 state++)的原子性 |

| 为什么还需要 CAS? | 因为 AQS 的核心操作是"先检查再修改 ",必须用 CAS 保证该复合操作的原子性 |

| CAS 和 volatile 的关系? | 互补:CAS 提供原子性,volatile 提供可见性,二者缺一不可 |

🔑 核心思想 :

在并发编程中,可见性 ≠ 原子性 。

要实现线程安全的状态机(如锁、信号量),必须同时解决这两个问题 ------ AQS 正是通过 volatile + CAS 的经典组合做到的。

CompletableFuture 的 thenApply 和 thenCompose 有何区别?什么场景下会引发线程阻塞?

当然可以!以下是更清晰、准确、结构化的回答,聚焦于 **thenApply**** 与 **thenCompose** 的本质区别**,以及 **CompletableFuture**** 中真正引发线程阻塞的场景**。

一、thenApply 与 thenCompose 的核心区别

✅ 共同点

- 都用于在前一个阶段完成后,对结果进行处理;

- 都返回一个新的

CompletableFuture; - 默认在完成前一阶段的线程上执行(除非使用

xxxAsync版本)。

❗ 本质区别:是否"扁平化"嵌套的 CompletableFuture

| 方法 | 函数签名 | 输入函数返回类型 | 输出类型 | 类比 |

|---|---|---|---|---|

**thenApply** |

thenApply(Function<T, U>) |

**普通值 ****U** |

CompletableFuture<U> |

Stream.map() |

**thenCompose** |

thenCompose(Function<T, CompletableFuture<U>>) |

**CompletableFuture<U>** |

CompletableFuture<U> (自动扁平) |

Stream.flatMap() |

🔑 一句话总结:

- 用

thenApply:当你想同步转换结果(如格式化、计算); - 用

thenCompose:当你想发起下一个异步操作 (返回另一个CompletableFuture)。

🌰 示例对比

场景:先查用户,再查其订单(两个异步服务)

java

CompletableFuture<User> fetchUser(long id);

CompletableFuture<Order> fetchOrder(User user);✅ 正确:使用 thenCompose

java

CompletableFuture<Order> orderFuture =

fetchUser(123)

.thenCompose(user -> fetchOrder(user)); // 返回 CompletableFuture<Order>- 结果是 扁平的

CompletableFuture<Order>; - 执行顺序:先完成

fetchUser,再启动fetchOrder; - 符合"异步链式调用"语义。

❌ 错误:使用 thenApply

java

CompletableFuture<CompletableFuture<Order>> badFuture =

fetchUser(123)

.thenApply(user -> fetchOrder(user)); // 返回 CompletableFuture<CompletableFuture<Order>>- 产生嵌套 Future ,后续必须手动解包(如

.thenCompose(f -> f)),代码冗余且易错。

💡 口诀 :

"**返回 Future 用 **compose** ,返回值用 ****apply**"

二、什么场景下会引发线程阻塞?

CompletableFuture 本身是非阻塞、异步 的,但以下操作会阻塞当前线程:

⚠️ 1. 显式调用阻塞获取方法

java

future.join(); // 阻塞当前线程,直到 future 完成

future.get(); // 同上,但抛出 checked Exception- 风险:在 Web 请求线程、事件循环线程中调用,会导致线程池耗尽、系统雪崩;

- 正确做法 :用

.thenAccept(result -> ...)等回调方式处理结果,避免阻塞。

✅ 例外 :在程序入口(如 main)或测试中可接受。

⚠️ 2. 在回调中执行阻塞或耗时操作(且未切换线程)

java

CompletableFuture.supplyAsync(() -> fetchData())

.thenApply(data -> {

// ❌ 危险!以下操作会阻塞默认 ForkJoinPool 线程:

Thread.sleep(1000); // 阻塞

httpClient.get("/api"); // 阻塞 I/O

database.query(...); // 阻塞 DB 调用

return process(data);

});- 默认情况下,

thenApply在前一阶段完成的线程 上执行(通常是ForkJoinPool.commonPool()); - 如果该线程被阻塞,无法处理其他任务,降低吞吐量。

✅ 解决方案:使用异步版本 + 自定义线程池

java

ExecutorService ioPool = Executors.newCachedThreadPool();

CompletableFuture.supplyAsync(() -> fetchData(), ioPool)

.thenComposeAsync(user -> callRemoteService(user), ioPool) // 异步 + 指定线程池

.thenApplyAsync(result -> transform(result), commonPool); // CPU 密集用默认池💡 最佳实践:

- I/O 密集型任务 → 使用专用线程池(如

newCachedThreadPool); - CPU 密集型任务 → 使用

ForkJoinPool.commonPool()(默认); - 永远不在回调中阻塞!

⚠️ 3. 错误地串行等待多个 Future(虽不增加总耗时,但语义和异常处理差)

java

// 不推荐(但不会额外阻塞,如果 future 已并行启动)

f1.join();

f2.join();vs

java

// 推荐:语义清晰 + 异常统一

CompletableFuture.allOf(f1, f2).join();- 虽然总耗时相近(因 future 已并行),但

allOf更安全、可读性更好。

三、总结

| 问题 | 答案 |

|---|---|

**thenApply****vs ** **thenCompose** |

thenApply用于同步转换(返回值), thenCompose用于异步拼接(返回 CompletableFuture并扁平化) |

| 何时用哪个? | 函数返回 CompletableFuture→ 用 thenCompose;否则用 thenApply |

| 什么会阻塞线程? | 1. 调用 .join()/ .get() 2. 回调中执行阻塞 I/O 或 sleep 3. 在默认线程池做长时间任务 |

| 如何避免阻塞? | 1. 用回调链代替 join 2. I/O 操作用 xxxAsync(..., executor)+ 自定义线程池 |

✅ 终极建议 :

把 CompletableFuture 当作声明式异步流水线 ,**永远不要在中间 ****.join()** ------ 让异步一直异步到底!

ThreadLocal 内存泄漏的根本原因是什么?为什么 remove() 必须在 finally 块中调用?

ThreadLocal 内存泄漏是一个经典且高频的 Java 并发问题。其根本原因与 **ThreadLocalMap**** 的内部结构** 和 弱引用(WeakReference)的使用方式 密切相关。

下面从原理、内存模型和最佳实践三方面详细解释。

一、内存泄漏的根本原因

✅ 核心结论:

**ThreadLocal**** 本身不会泄漏,但「线程长期存活 + 未调用 **remove()** 」会导致 **ThreadLocalMap** 中的 value 对象无法被回收,从而造成内存泄漏。**

1. ThreadLocal 的存储结构

每个 Thread 对象内部持有一个 **ThreadLocal.ThreadLocalMap**:

java

public class Thread {

ThreadLocal.ThreadLocalMap threadLocals = null;

}而 ThreadLocalMap 的 key 是 **ThreadLocal**** 对象的弱引用(WeakReference)**,value 是用户设置的实际值:

java

static class Entry extends WeakReference<ThreadLocal<?>> {

Object value;

Entry(ThreadLocal<?> k, Object v) {

super(k); // key 是弱引用!

value = v;

}

}2. 弱引用(WeakReference)的作用与局限

- 作用 :当

ThreadLocal实例(即 key)没有外部强引用 时,GC 会自动回收该 key,将其置为null。 - 局限 :value 不会被自动清理! 即使 key 变成

null,value 仍被Entry强引用着。

plain

Thread ──→ ThreadLocalMap ──→ [Entry]

├── key → null (已被 GC)

└── value → YourObject (仍被强引用!)→ **YourObject**** 无法被回收,造成内存泄漏!**

3. 什么情况下会触发泄漏?

| 条件 | 说明 |

|---|---|

| ✅ 线程是长生命周期的 | 如线程池中的线程(Tomcat、Dubbo、Spring Boot 内嵌容器等) |

✅ **未调用 ****ThreadLocal.remove()** |

程序员忘记清理 |

| ✅ ThreadLocal 变量无外部强引用 | 比如它是方法内局部变量,方法结束就没了 |

📌 典型场景 :

Web 应用中,每个请求由线程池中的线程处理,在请求开始时用 ThreadLocal 存放用户上下文(如 userId、traceId),但**未在请求结束时调用 ****remove()**。

→ 随着请求增多,ThreadLocalMap 中积累大量 <null, value> 条目,最终 OOM。

二、为什么 remove() 必须在 finally 块中调用?

✅ 目的:确保无论业务逻辑是否抛异常,都能清理资源

示例:Web Filter 中使用 ThreadLocal

java

public class UserContextFilter implements Filter {

private static final ThreadLocal<String> currentUser = new ThreadLocal<>();

public void doFilter(ServletRequest req, ServletResponse res, FilterChain chain) {

try {

currentUser.set(getUserIdFromToken(req));

chain.doFilter(req, res); // 可能抛异常!

} finally {

currentUser.remove(); // ✅ 必须在 finally 中清理

}

}

}如果不放在 finally 中:

java

currentUser.set(...);

chain.doFilter(...); // 如果这里抛出异常

currentUser.remove(); // ❌ 这行永远不会执行!→ **ThreadLocalMap**** 中残留 entry** → 内存泄漏。

三、JVM 的"自救"机制(但不可依赖!)

ThreadLocalMap 在以下操作时会顺便清理 key 为 null 的 entry:

set()get()remove()

例如 get() 方法内部会调用 expungeStaleEntries() 清理部分过期条目。

⚠️ 但问题在于:

- 如果某个线程**不再访问该 **

**ThreadLocal**(比如请求结束,后续不再读写),就不会触发清理; - 线程池中的线程长期存活,这些"僵尸 entry"会一直堆积。

🔥 因此,不能依赖 JVM 自动清理!必须显式调用 **remove()**!

四、正确使用 ThreadLocal 的最佳实践

✅ 1. 每次使用后,务必调用 remove()

java

try {

threadLocal.set(value);

// ... 业务逻辑

} finally {

threadLocal.remove(); // 关键!

}✅ 2. 避免在线程池任务中滥用 ThreadLocal

- 如果必须用,确保任务结束前清理;

- 考虑使用

InheritableThreadLocal(谨慎)或上下文传递框架(如 SLF4J MDC、TransmittableThreadLocal)。

✅ 3. 不要用 ThreadLocal 存储大对象

- 即使及时清理,频繁分配大对象也会增加 GC 压力。

✅ 4. 静态常量引用 ThreadLocal

java

private static final ThreadLocal<Context> CONTEXT = new ThreadLocal<>();- 避免

ThreadLocal实例本身被回收(导致 key 提前变 null)。

五、内存泄漏示意图

plain

[Thread Pool Thread]

│

└── threadLocals: ThreadLocalMap

│

├── Entry[0]: key=null, value=UserInfo@123 ← 泄漏!

├── Entry[1]: key=null, value=UserInfo@456 ← 泄漏!

└── Entry[2]: key=valid, value=UserInfo@789- 即使

ThreadLocal变量已不可达,UserInfo对象仍被Entry.value强引用; - 线程不销毁 →

ThreadLocalMap不销毁 →value永远无法回收。

✅ 总结

| 问题 | 答案 |

|---|---|

| 内存泄漏根本原因 | ThreadLocalMap的 key 是弱引用(可被 GC),但 value 是强引用; 若不手动 remove(),value 会一直残留 |

**为何需 ****finally****调用 ****remove()** |

确保即使业务代码抛异常,也能清理 ThreadLocal,防止 entry 泄漏 |

| 高危场景 | 线程池(如 Web 容器) + 未清理的 ThreadLocal |

| 解决方案 | **始终在 ****finally****块中调用 ****remove()**,不要依赖 JVM 自动清理 |

💡 记住 :

ThreadLocal 不是"自动清理"的魔法工具,它要求程序员显式管理生命周期 。

在高并发、长生命周期线程环境中,忘记 **remove()** = 内存泄漏 = 系统崩溃。

StampedLock 的乐观读如何避免 ABA 问题?它比 ReadWriteLock 快在哪里?

StampedLock 是 Java 8 引入的一种高性能读写锁,其核心创新在于 "乐观读"(Optimistic Reading) 机制。它在特定场景下比传统的 ReentrantReadWriteLock 更快,但也存在 ABA 问题的隐患。下面我们深入解析:

一、StampedLock 的乐观读如何工作?

✅ 基本流程

java

StampedLock lock = new StampedLock();

long stamp = lock.tryOptimisticRead(); // 1. 获取"乐观读戳"

// 执行读操作(不加锁!)

if (!lock.validate(stamp)) { // 2. 验证期间是否有写发生

stamp = lock.readLock(); // 3. 若有写,则升级为悲观读

try {

// 重新读取

} finally {

lock.unlockRead(stamp);

}

}- 乐观读不阻塞写线程;

- 通过一个 64 位的 stamp(戳) 标识当前读视图;

validate(stamp)检查该 stamp 是否仍有效(即期间无写操作)。

二、ABA 问题是否存在?如何缓解?

❓ 什么是 ABA 问题?

线程 A 读取值为 X → 线程 B 将值改为 Y 又改回 X → 线程 A 再次读取仍为 X,误以为"未被修改"。

🔍 StampedLock 中的 ABA 风险

- stamp 是单调递增的版本号(不是简单的状态标志);

- 每次写锁获取/释放 都会使 stamp 增加(即使值变回原样,stamp 也不同);

- 因此,传统意义上的 ABA(值相同但中间被修改过)会被 detect 到!

✅ 示例:

java

// 初始 stamp = 100

long s1 = lock.tryOptimisticRead(); // s1 = 100

// 其他线程:写入 → stamp 变为 101 → 写完释放 → stamp 变为 102

// 即使数据恢复原状,stamp 已变!

boolean valid = lock.validate(s1); // false! 因为当前 stamp ≠ 100✅ 结论:

StampedLock 通过"单调递增的 stamp 版本号"天然避免了 ABA 问题。

只要发生过写操作(无论数据是否变回),validate() 就会返回 false。

⚠️ 注意:这里的"ABA"指 逻辑上的数据不变但中间被修改 ,而 StampedLock 关心的是 "是否发生过写",不是数据内容本身。

三、StampedLock 比 ReadWriteLock 快在哪里?

| 维度 | ReentrantReadWriteLock |

StampedLock |

|---|---|---|

| 读写互斥 | 读阻塞写,写阻塞读 | 乐观读不阻塞写 |

| 锁开销 | 依赖 AbstractQueuedSynchronizer (AQS),有队列、CAS、线程挂起等开销 | 乐观读无锁、无 CAS、无线程阻塞 |

| 适用场景 | 通用,支持重入 | 高频读、低频写,且读操作可重试 |

| 性能(读多写少) | 中等 | 极高(乐观读接近 volatile 性能) |

✅ 性能优势详解:

1. 乐观读零开销

- 不调用任何 CAS 或 synchronized;

- 仅读取一个

volatile long(stamp); - 读操作本身可完全并行,写线程无需等待读完成。

2. 写操作更轻量

- 写锁内部使用 CAS + 自旋,避免立即进入重量级阻塞;

- 在竞争不激烈时,性能优于 AQS 的 park/unpark。

3. 无"写饥饿"问题

ReentrantReadWriteLock允许读线程无限抢占,导致写线程饿死;StampedLock的写优先级更高,且乐观读不持有锁,写更容易成功。

四、StampedLock 的局限性(代价)

| 缺点 | 说明 |

|---|---|

| ❌ 不支持重入 | 同一线程不能重复获取读/写锁(会死锁) |

| ❌ 不支持条件变量(Condition) | 无法像 ReadWriteLock.newCondition() 那样等待通知 |

| ❌ API 复杂 | 需手动管理 stamp,容易出错(如忘记 validate) |

| ❌ 仅适用于"可重试读"场景 | 如果读操作有副作用(如 I/O),重试可能不安全 |

📌 典型适用场景:

- 缓存读取(如配置、统计数据)

- 几何计算(如 Point 的 x/y 坐标读取)

- 任何"读操作无副作用 + 可重试"的场景

五、正确使用示例(避免常见错误)

java

class Point {

private double x, y;

private final StampedLock sl = new StampedLock();

double distanceFromOrigin() {

long stamp = sl.tryOptimisticRead();

// 读取多个字段(必须保证原子性视图!)

double currentX = x, currentY = y;

if (!sl.validate(stamp)) { // 如果期间有写

stamp = sl.readLock(); // 升级为悲观读

try {

currentX = x;

currentY = y;

} finally {

sl.unlockRead(stamp);

}

}

return Math.sqrt(currentX * currentX + currentY * currentY);

}

}⚠️ 注意:乐观读期间不能有写操作,且读取多个字段时需确保"一致性视图"(要么全旧,要么全新)。

✅ 总结

| 问题 | 答案 |

|---|---|

| 如何避免 ABA? | 使用单调递增的 stamp 版本号 ,只要发生写,stamp 改变,validate()返回 false |

| 比 ReadWriteLock 快在哪? | 1. 乐观读无锁、无阻塞、无 CAS 2. 写操作更轻量 3. 无写饥饿 |

| 适用场景 | 读多写少、读操作可重试、无副作用 |

| 慎用场景 | 需要重入、条件等待、或读操作不可重试 |

💡 最佳实践 :

在高频读、低频写的纯内存数据结构 中,优先考虑 StampedLock;

在通用业务逻辑中,仍推荐 ReentrantReadWriteLock(更安全、易用)。

虚拟线程(Virtual Threads, JDK 21)如何解决传统线程栈占用大的问题?适用 IO 密集型还是 CPU 密集型?

虚拟线程(Virtual Threads)是 Java 21(Loom 项目)引入的革命性并发模型,其核心目标是以极低的资源开销支持海量并发任务 。它通过解耦 Java 线程与操作系统线程,从根本上解决了传统线程栈占用大的问题。

一、传统线程(Platform Threads)的问题

❌ 栈内存占用大

- 每个传统线程默认分配 1MB 栈空间 (可通过

-Xss调小,但仍有几十 KB); - 创建 10,000 个线程 → 至少占用 10GB 栈内存;

- 操作系统对线程数量有限制(通常几千到几万),易导致

OutOfMemoryError: unable to create native thread。

❌ 上下文切换开销高

- 线程调度由 OS 内核完成,涉及内核态/用户态切换,成本高;

- 高并发下 CPU 大量时间花在调度而非业务逻辑上。

📌 根本原因 :

Java 线程 = 1:1 映射 OS 线程 → 受限于 OS 资源。

二、虚拟线程如何解决栈占用问题?

✅ 核心机制:轻量级、堆分配的栈 + 调度器复用

| 特性 | 传统线程(Platform Thread) | 虚拟线程(Virtual Thread) |

|---|---|---|

| 栈存储位置 | OS 内存(native stack) | JVM 堆内存(Java heap) |

| 默认栈大小 | ~1 MB | 初始仅几百字节,按需增长(类似递归调用的栈帧) |

| 创建开销 | 高(OS 系统调用) | 极低(纯 Java 对象) |

| 调度方式 | OS 内核调度 | JVM 用户态调度器(ForkJoinPool) |

| 映射关系 | 1 Java 线程 : 1 OS 线程 | N 虚拟线程 : 1 OS 线程(Carrier Thread) |

🔍 关键技术细节:

1. 栈在堆上分配

- 虚拟线程的栈帧存储在 Java 堆 中,由 JVM 管理;

- 初始只分配少量内存,方法调用时动态扩展(类似链表式栈);

- 不再受 OS 栈大小限制,百万级虚拟线程内存占用仅几百 MB。

2. 挂起/恢复(Continuations)

- 当虚拟线程执行阻塞操作(如

socket.read())时:- JVM 挂起该虚拟线程(保存其执行状态);

- 底层 OS 线程(Carrier Thread)立即释放,去执行其他虚拟线程;

- I/O 完成后,JVM 恢复虚拟线程到任意 OS 线程继续执行。

- 全程无需 OS 线程阻塞!

💡 这就是为什么虚拟线程能高效处理 阻塞 I/O ------ 底层 OS 线程永不空等。

三、适用场景:IO 密集型 vs CPU 密集型?

✅ 强烈适用于:IO 密集型(I/O-bound)任务

- 典型场景:Web 服务器、数据库查询、远程 API 调用、文件读写;

- 优势 :

- 单个 OS 线程可同时处理成千上万个虚拟线程;

- 阻塞 I/O 不再浪费 OS 线程;

- 吞吐量(requests/sec)提升 10~100 倍;

- 编程模型简单:直接写同步阻塞代码,无需回调或异步框架。

示例(Spring Boot + 虚拟线程):

java

@RestController

public class UserController {

// 每个请求由一个虚拟线程处理

@GetMapping("/user/{id}")

public User getUser(@PathVariable Long id) {

return userService.findById(id); // 内部可能有 DB 查询(阻塞)

}

}→ 无需 CompletableFuture 或 WebFlux,同步代码获得异步性能!

⚠️ 不适用于:CPU 密集型(CPU-bound)任务

- 原因 :

- 虚拟线程仍运行在有限的 OS 线程池 (默认

ForkJoinPool.commonPool(),大小 = CPU 核数); - 如果所有虚拟线程都在做纯计算(无 I/O 阻塞),则无法利用更多 OS 线程;

- 创建过多虚拟线程反而增加调度开销,性能不如直接使用平台线程池。

- 虚拟线程仍运行在有限的 OS 线程池 (默认

正确做法:

java

// CPU 密集型:使用固定大小的平台线程池

ExecutorService cpuPool = Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors());

cpuPool.submit(() -> {

// 纯计算任务

});📌 经验法则:

- 有阻塞 I/O? → 用虚拟线程;

- 纯计算? → 用传统线程池(大小 ≈ CPU 核数)。

四、虚拟线程 vs 异步编程(如 CompletableFuture)

| 维度 | 虚拟线程 | 异步回调(CompletableFuture / Reactor) |

|---|---|---|

| 编程模型 | 同步、直观(try-catch, for-loop) | 异步、回调链(易出现"回调地狱") |

| 调试难度 | 低(完整栈跟踪) | 高(栈被切断,上下文丢失) |

| 资源效率 | 极高(百万级并发) | 高(但需手动管理背压、错误传播) |

| 适用性 | 任何阻塞 I/O | 需重写为非阻塞 API(如 Netty, R2DBC) |

✅ 虚拟线程让"简单即高效"成为可能:开发者写最自然的同步代码,JVM 自动实现高并发。

五、注意事项

- 不要池化虚拟线程

java

// ❌ 错误!虚拟线程是廉价的,无需池化

ExecutorService pool = Executors.newCachedThreadPool(); // 这仍是平台线程池!

// ✅ 正确:直接创建

Thread.startVirtualThread(() -> { ... });

// 或使用虚拟线程专用 Executor

try (var executor = Executors.newVirtualThreadPerTaskExecutor()) {

executor.submit(task);

}- 避免在虚拟线程中长时间占用 CPU

- 如需 CPU 密集计算,应提交到专用平台线程池。

- 监控工具需升级

- 传统线程 dump 会显示海量虚拟线程,需 JDK 21+ 工具支持过滤。

✅ 总结

| 问题 | 答案 |

|---|---|

| 如何解决栈占用大? | 栈分配在堆内存 ,初始很小、按需增长;通过挂起/恢复复用少量 OS 线程 |

| 适用 IO 还是 CPU 密集? | IO 密集型 (完美匹配)CPU 密集型(不适用,用传统线程池) |

| 最大优势 | 同步编程模型 + 异步级并发性能 |

| 典型应用 | 高并发 Web 服务、微服务、消息处理等 I/O 密集场景 |

💡 未来趋势 :

虚拟线程将使 Java 成为构建高吞吐、低延迟、简单代码服务的理想选择,大幅降低并发编程门槛。

三、JVM(深度调优 & 故障排查)

ZGC 的"着色指针"和"读屏障"如何实现 <10ms 的停顿?为什么它不需要分代?

ZGC(Z Garbage Collector)是 Oracle 从 JDK 11 开始引入的一种低延迟、可扩展、并发的垃圾回收器 ,目标是实现 始终 <10ms 的 GC 停顿时间 ,即使堆大小达到 TB 级别。它之所以能做到这一点,核心依赖两大创新技术:着色指针(Colored Pointers) 和 读屏障(Load Barriers) 。同时,ZGC 不采用分代收集(non-generational),这与其设计哲学密切相关。

下面我们深入解析这两个机制如何协同工作,并解释为何 ZGC 可以放弃分代。

一、着色指针(Colored Pointers)------ 把元数据"塞进指针里"

🎯 核心思想:

不在对象头中存储 GC 状态,而是将状态信息编码到对象指针的高位(unused bits)中。

🔍 技术细节:

- 在 64 位系统中,虚拟地址空间通常只使用低 48 位(如 x86-64),高 16 位是保留/未使用的。

- ZGC 利用其中 4 个高位比特 (称为"颜色位")来存储 GC 元数据,例如:

Marked0/Marked1:用于标记阶段区分两轮并发标记;Remapped:表示该指针已更新为新地址(在压缩/移动后);Finalizable:标记需执行 finalize 的对象(JDK 16+ 已弃用 finalize,此位可能不再使用)。

✅ 示例(简化):

plain

原始指针: 0x00007f8b12345678

ZGC 指针: 0x00107f8b12345678 ← 第 52 位设为 1 表示 "Marked0"✅ 优势:

- 无需修改对象头:避免了在对象上写元数据的开销和同步问题;

- 指针本身携带状态:GC 线程和 mutator(应用线程)都能通过指针直接判断对象状态;

- 支持并发处理:多个阶段可基于指针颜色并行操作,无需全局暂停。

二、读屏障(Load Barrier)------ 在"读取引用"时自动修复指针

🎯 核心思想:

每当应用线程从堆中加载一个对象引用时,ZGC 自动插入一小段代码(读屏障),检查并修正指针。

🔍 工作流程(以"并发标记 + 并发重定位"为例):

- 应用线程执行 :

Object obj = ref;

→ JVM 在字节码层面插入 读屏障。 - 读屏障逻辑(伪代码):

java

if (pointer is not Remapped) {

// 说明该对象可能已被移动(重定位)

// 调用 GC helper 函数,查找 forwarding table

new_addr = resolve_forwarding(pointer);

// 原子地更新指针为新地址(CAS)

CAS(ref, old_pointer, new_addr | REMAPPED_COLOR);

return new_addr;

}- 结果 :

- 应用线程总是拿到最新、有效的对象地址;

- 对象移动(压缩)可以在应用运行时并发完成;

- 无需 STW 来更新所有引用(传统 GC 如 G1 需要 STW 来"清理"旧引用)。

✅ 优势:

- 停顿极短:读屏障只在访问对象时触发,且每次只处理一个指针;

- 完全并发:标记、重定位、引用更新全部与应用线程并发执行;

- 自愈性:一旦某个引用被修复,后续访问不再触发屏障。

💡 注意:ZGC 只有读屏障,没有写屏障,因此对写操作无额外开销,这对高吞吐场景非常友好。

三、为什么 ZGC 不需要分代(Non-Generational)?

传统 GC(如 G1、Parallel GC)采用分代假说(Generational Hypothesis):

"大多数对象朝生暮死,老年代对象存活率高。"

但 ZGC 主动放弃分代,原因如下:

1. 分代会引入复杂性和停顿

- 分代需要维护 Remembered Sets(RSet) 来跟踪跨代引用;

- RSet 的维护(尤其是写屏障记录)带来显著开销;

- Young GC 虽快,但 Full GC(Mixed GC)仍可能产生长停顿。

2. ZGC 的并发能力已足够高效

- 由于整个堆并发标记 + 并发重定位,无论对象年龄如何,回收成本几乎一致;

- 即使回收"年轻对象",ZGC 也能在 <10ms 内完成,无需专门优化 young gen。

3. 简化设计,提升可扩展性

- 不分代 → 无 RSet → 内存占用更低;

- 无 young/old 区域划分 → 堆布局更简单,适合超大堆(TB 级);

- 避免"晋升失败"、"to-space exhausted"等分代 GC 特有问题。

4. 现代应用模式变化

- 微服务、缓存、大数据应用中,长生命周期对象比例上升,分代假说不再普适;

- ZGC 更适合稳定、低延迟的长期运行服务。

📌 补充:从 JDK 17 开始,ZGC 实验性支持分代(Generational ZGC),目标是在保持低延迟的同时进一步降低 CPU 开销。但这属于演进而非必需。

四、总结:ZGC 如何实现 <10ms 停顿?

| 技术 | 作用 | 对停顿的影响 |

|---|---|---|

| 着色指针 | 将 GC 状态嵌入指针 | 避免修改对象头,支持无锁并发 |

| 读屏障 | 在加载引用时自动修复地址 | 消除 STW 引用更新,实现完全并发重定位 |

| 不分代 | 简化堆结构,避免 RSet | 减少内存开销和复杂性,提升大堆稳定性 |

✅ 最终效果 :ZGC 的 STW 阶段仅用于 线程栈扫描(root scanning) 和 部分元数据同步 ,通常 <1ms,远低于 10ms 目标。

🚀 适用场景

- 要求 严格低延迟 的系统(金融交易、实时游戏、高频 API);

- 大内存堆(数百 GB 到 TB 级);

- 可接受 略高 CPU 开销(约 10-20%)换取确定性延迟。

ZGC 代表了 GC 设计从"吞吐优先"向"延迟确定性"的范式转变,其核心思想------用并发和指针元数据换取停顿时长------已成为现代低延迟 GC 的标杆。

Metaspace OOM 的常见原因有哪些?如何通过 jcmd 动态调整 CompressedClassSpaceSize?

Metaspace(元空间)是 Java 8 引入的用于替代永久代(PermGen)的内存区域,用于存储类的元数据 (如 Class 对象、方法字节码、常量池、JIT 编译代码等)。当应用加载大量类(如动态代理、反射、Groovy 脚本、OSGi 模块等),可能触发 java.lang.OutOfMemoryError: Metaspace。

一、Metaspace OOM 的常见原因

✅ 1. 类加载器泄漏(ClassLoader Leak)

- 最常见原因!

- 应用(尤其是 Web 容器如 Tomcat)在热部署/重载时,旧的

ClassLoader未被回收,其加载的所有类仍驻留在 Metaspace。 - 即使对象不再使用,只要

ClassLoader存活,其加载的类元数据就不会释放。 - 典型场景:Spring Boot DevTools、Tomcat Context Reload、OSGi Bundle 动态卸载失败。

✅ 2. 动态生成类过多

- 使用 CGLib、ASM、ByteBuddy 等库动态生成代理类;

- Groovy、JRuby、Scala 等 JVM 语言运行时会生成大量中间类;

- Lambda 表达式 在早期 JDK 中也会生成合成类(JDK 8u60+ 已优化)。

✅ 3. Metaspace 配置不合理

- 默认

MaxMetaspaceSize为 无上限(unlimited),但在容器环境(Docker/K8s)中,若未显式限制,可能耗尽物理内存导致 OOM Killer 杀进程。 - 若人为设置了过小的

-XX:MaxMetaspaceSize(如 64m),而应用实际需要更多,也会触发 OOM。

✅ 4. Compressed Class Space 耗尽

- 当启用指针压缩(

-XX:+UseCompressedOops,默认开启)时,Klass 指针(指向类元数据的指针)会被压缩。 - 这些 Klass 元数据被单独放在 Compressed Class Space (默认大小 1G),由

-XX:CompressedClassSpaceSize控制。 - 如果类数量极大(>50万),即使 Metaspace 总量未满,Compressed Class Space 可能先耗尽,抛出:

plain

java.lang.OutOfMemoryError: Compressed class space二、如何通过 jcmd 动态调整 CompressedClassSpaceSize?

❌ 重要结论:无法动态调整!

**-XX:CompressedClassSpaceSize**** 是一个"不可变"(non-manageable)JVM 参数,启动后无法通过 **jcmd** 或 JMX 修改。**

🔍 验证方法:

bash

# 查看所有可动态调整的 VM 参数

jcmd <pid> VM.flags -all | grep manageable

# 尝试修改 CompressedClassSpaceSize(会失败)

jcmd <pid> VM.set_flag CompressedClassSpaceSize 2147483648输出:

plain

Could not set flag - flag 'CompressedClassSpaceSize' is not writable✅ 正确做法:

| 场景 | 解决方案 |

|---|---|

| 预防性配置 | 启动时通过 -XX:CompressedClassSpaceSize=2g显式设置足够大的值(最大支持 3G) |

| 已发生 OOM | 1. 分析类加载情况; 2. 修复类加载器泄漏; 3. 重启 JVM 并调大该参数 |

| 监控使用量 | 使用 jcmd 查看当前使用情况(见下文) |

三、使用 jcmd 监控 Metaspace 和 Compressed Class Space

虽然不能动态调整,但可通过 jcmd查看实时使用情况:

bash

# 查看 Metaspace 详细信息

jcmd <pid> VM.metaspace

# 示例输出(关键部分):

Virtual space:

Compressed class space Used: 150M, Capacity: 250M, Reserved: 1024M

Non-class space Used: 300M, Capacity: 350M, Reserved: ...

Total used: 450M

# 查看 GC 后的 Metaspace 统计(更准确)

jcmd <pid> GC.run_finalization # 触发清理(谨慎使用)

jcmd <pid> VM.metaspace你也可以通过 JMX 或 jstat 监控:

bash

# jstat 查看 Metaspace(CCS = Compressed Class Space)

jstat -gcmetacapacity <pid>

# 输出示例:

MCMN MCMX MC CCSMN CCSMX CCSC YGC FGC FGCT GCT

0.0 1048576.0 450560.0 0.0 1048576.0 153600.0 123 5 0.500 1.200

# CCSC = Compressed Class Space Capacity (KB)四、排查与解决建议

🔧 1. 分析类加载情况

bash

# 查看已加载类数量

jcmd <pid> VM.class_hierarchy

# 或使用 jmap(慎用,会 STW)

jmap -clstats <pid>🔧 2. 检测 ClassLoader 泄漏

- 使用 Eclipse MAT 或 JProfiler 分析堆转储(heap dump);

- 查找

org.apache.catalina.loader.WebappClassLoader(Tomcat)或自定义 ClassLoader 的实例是否异常增多; - 检查是否有静态引用持有 ClassLoader。

🔧 3. 合理配置 JVM 参数

bash

# 推荐配置(根据应用规模调整)

-XX:MetaspaceSize=256m \

-XX:MaxMetaspaceSize=512m \

-XX:CompressedClassSpaceSize=256m # 默认 1G,通常无需调大,除非类 > 20万💡 注意:CompressedClassSpaceSize不需要设得过大,1G 可容纳约 50~100 万个类。只有极端场景才需调整。

✅ 总结

| 问题 | 答案 |

|---|---|

| Metaspace OOM 主因 | ClassLoader 泄漏、动态类爆炸、配置过小 |

**能否动态调大 ****CompressedClassSpaceSize** |

❌ 不能,必须重启 JVM |

| 如何监控 | jcmd <pid> VM.metaspace 或 jstat -gcmetacapacity |

| 根本解决 | 修复 ClassLoader 泄漏 + 合理设置 -XX:MaxMetaspaceSize |

📌 最佳实践 :在容器化环境中,**务必显式设置 ****-XX:MaxMetaspaceSize**,避免 Metaspace 无限增长导致容器 OOMKilled。

逃逸分析失败的典型场景?为什么 synchronized 锁消除有时不生效?

这是一个深入 JVM 优化机制的高质量问题。逃逸分析(Escape Analysis)和锁消除(Lock Elimination)是 HotSpot JVM 的重要 JIT 优化技术,但它们并非总能生效 。下面我们系统分析"逃逸分析失败"的典型场景,并解释为何 synchronized 锁消除有时不工作。

一、逃逸分析(Escape Analysis)是什么?

逃逸分析是 JVM 在 JIT 编译时进行的一项静态分析技术,用于判断:

一个对象的引用是否"逃逸"出当前方法或线程的作用域。

如果对象未逃逸,JVM 可以进行以下优化:

- 栈上分配(Stack Allocation):对象分配在栈上而非堆上,避免 GC 压力;

- 标量替换(Scalar Replacement):将对象拆解为若干基本类型字段,直接存储在寄存器或栈中;

- 同步消除(Synchronization Elimination) :如果对象仅被单线程访问,

synchronized锁可被完全移除。

⚠️ 注意:目前 OpenJDK/HotSpot 并未真正实现"栈上分配" ,而是通过标量替换达到类似效果(对象不实际分配)。

二、逃逸分析失败的典型场景

即使对象看似"局部",也可能因以下原因导致逃逸分析失败,无法优化:

✅ 场景 1:对象被赋值给成员变量(实例/静态字段)

java

public class Example {

private Object field; // 成员变量

void method() {

Object obj = new Object();

this.field = obj; // ← 逃逸!obj 被外部可见

}

}→ 对象逃逸到堆上,无法栈分配或锁消除。

✅ 场景 2:对象作为方法参数传递给其他方法

java

void method() {

Object obj = new Object();

helper(obj); // ← 可能逃逸(除非 helper 是内联且无逃逸)

}

void helper(Object o) {

// 如果 helper 未被内联,或内部将 o 存入全局变量,则逃逸

}→ 关键点 :只有当 helper 被 JIT 内联(inlined) 且其内部也无逃逸,才可能不逃逸。

✅ 场景 3:对象被返回(return)

java

Object create() {

Object obj = new Object();

return obj; // ← 明确逃逸

}✅ 场景 4:对象被捕获到异常处理或 lambda 表达式中

java

void method() {

Object obj = new Object();

try {

// ...

} catch (Exception e) {

log(obj); // obj 被异常处理引用 → 可能逃逸

}

Runnable r = () -> System.out.println(obj); // lambda 捕获 obj → 逃逸

}→ Lambda 会生成合成类,持有对 obj 的引用,导致逃逸。

✅ 场景 5:对象调用了native 方法

java

void method() {

ByteBuffer buf = ByteBuffer.allocateDirect(1024);

buf.put((byte)1); // 内部调用 native 方法

// DirectByteBuffer 通常会被视为逃逸(因 native 代码可能持有引用)

}✅ 场景 6:JIT 尚未编译该方法

- 逃逸分析只在 C2 编译器(-XX:+TieredCompilation 默认开启) 中进行;

- 方法需达到一定调用阈值(如 10,000 次)才会被 C2 编译;

- 在解释执行或 C1 编译阶段,不会进行逃逸分析。

三、为什么 synchronized 锁消除有时不生效?

即使你写了一个"明显只在本地使用的对象加锁",锁消除仍可能失败。原因如下:

🔒 原因 1:对象逃逸了(最常见)

java

void badExample() {

Object lock = new Object();

synchronized (lock) {

// do something

}

store(lock); // ← 如果 lock 被传出去,JVM 无法确定是否安全消除锁

}🔒 原因 2:锁对象是非局部新建的

java

final Object lock = new Object(); // 类成员

void method() {

synchronized (lock) { ... } // ← 锁对象是共享的,不能消除!

}🔒 原因 3:方法未被 JIT 编译或未内联

- 锁消除只在 C2 编译后的代码中生效;

- 如果方法太复杂、太大(超过

-XX:MaxInlineSize),可能不被内联,导致跨方法锁无法分析。

🔒 原因 4:使用了非平凡的锁对象

java

synchronized (this) { ... } // this 可能被外部引用 → 不消除

synchronized (MyClass.class) { ... } // Class 对象全局唯一 → 不消除🔒 原因 5:Monitor 被升级为重量级锁

- 即使锁消除逻辑成立,但如果在解释执行阶段已发生锁竞争,对象 monitor 已膨胀为重量级锁(OS mutex),JIT 也无法回退消除。

四、如何验证锁是否被消除?

方法 1:使用 -XX:+PrintEliminateLocks

bash

java -XX:+UnlockDiagnosticVMOptions -XX:+PrintEliminateLocks YourApp输出示例:

plain

[eliminate locks] eliminated 1 locks方法 2:使用 JMH + perf 或 async-profiler

观察汇编代码中是否还存在 monitorenter / monitorexit 指令。

方法 3:对比性能

java

// 测试1:局部对象加锁

Object lock = new Object();

synchronized (lock) { ... }

// 测试2:无锁

// ...

// 如果两者性能几乎一致,说明锁被消除了✅ 最佳实践建议

| 场景 | 建议 |

|---|---|

| 需要局部锁 | 使用 局部新建对象 ,且不传递、不返回、不存成员变量 |

| 高频小临界区 | 考虑用 synchronized(若可消除)比 ReentrantLock更轻量 |

| 怀疑未优化 | 用 -XX:+PrintEliminateLocks验证 |

| 大方法锁 | 尽量缩小 synchronized 块范围,提高内联概率 |

📌 总结

| 问题 | 根本原因 |

|---|---|

| 逃逸分析失败 | 对象引用超出局部作用域(成员变量、参数传递、返回、lambda 捕获等) |

| 锁消除不生效 | 1. 对象逃逸; 2. 锁对象非局部; 3. 方法未 JIT 编译/内联; 4. Monitor 已膨胀 |

💡 记住 :JVM 优化是保守的 ------只要存在任何不确定性 ,它宁可不做优化,也要保证正确性。

因此,写出"易于优化"的代码(小方法、局部对象、无副作用)是开发者的重要责任。

G1 的 Mixed GC 触发条件是什么?如何通过 -XX:G1HeapWastePercent 优化?

G1(Garbage-First)GC 是 Java 9+ 的默认垃圾回收器,其核心思想是将堆划分为多个 Region ,并优先回收垃圾比例高 的 Region(即"Garbage-First")。在并发标记(Concurrent Marking)完成后,G1 会进入 Mixed GC 阶段------即同时回收 Young Regions + 部分 Old Regions。

一、Mixed GC 的触发条件

Mixed GC 不会在每次 Young GC 时发生 ,而是在满足以下全部条件后启动:

✅ 条件 1:完成一次并发标记周期(Initial Mark → Remark → Cleanup)

- Mixed GC 只能在并发标记完成之后进行;

- 并发标记由 Initial Mark (伴随一次 Young GC)触发,通常在堆使用率达到

-XX:InitiatingHeapOccupancyPercent(IHOP,默认 45%)时启动。

✅ 条件 2:存在"可回收"的 Old Regions

- 在并发标记的 Cleanup 阶段 ,G1 会统计每个 Old Region 的存活对象比例;

- 只有那些垃圾比例足够高(即存活率低)的 Old Region 才会被选入候选集(Candidate Set)。

✅ 条件 3:候选 Old Regions 的总垃圾量 ≥ -XX:G1HeapWastePercent 阈值

这是最关键但常被误解的条件!

- G1 不会回收所有候选 Region,而是按回收效率排序(垃圾多、存活少的优先);

- 它会持续选择 Region,直到:

plain

已选 Region 的总垃圾量 ≥ (总堆大小 × G1HeapWastePercent / 100)- 默认

G1HeapWastePercent = 5,即:只要能回收 ≥5% 堆空间的垃圾,就值得做 Mixed GC。

✅ 条件 4:未达到 Mixed GC 最大轮次限制

- 通过

-XX:G1MixedGCCountTarget(默认 8)控制 Mixed GC 轮数; - 每轮 Mixed GC 会回收一部分 Old Region,最多执行 N 轮(避免长时间停顿)。

二、-XX:G1HeapWastePercent 的作用与优化

🔧 参数含义

| 参数 | 默认值 | 含义 |

|---|---|---|

-XX:G1HeapWastePercent |

5 |

触发 Mixed GC 的最小可回收垃圾比例(占整个堆) |

🎯 优化逻辑

▶ 场景 1:希望更早触发 Mixed GC(积极回收 Old 区)

- 调低该值 (如

1或2) - 效果 :

- 即使只有少量 Old 垃圾,也会启动 Mixed GC;

- 减少 Old 区碎片,降低 Full GC 风险;

- 代价:Mixed GC 频率增加,CPU 开销上升,停顿次数增多。

✅ 适用:内存敏感型应用(如容器环境),需严格控制堆使用率。

▶ 场景 2:希望减少 Mixed GC 频率(降低 CPU 开销)

- 调高该值 (如

10或15) - 效果 :

- 只有当 Old 区积累大量垃圾时才回收;

- Mixed GC 次数减少,吞吐量提升;

- 风险 :Old 区可能快速填满,触发 Full GC(Serial GC),造成秒级停顿!

✅ 适用:吞吐优先、延迟容忍度较高的应用。

三、典型问题与调优建议

❗ 问题 1:Mixed GC 后 Old 区仍在增长,最终 Full GC

- 原因 :

G1HeapWastePercent设置过高,或 Old 对象太多无法有效回收; - 对策:

bash

-XX:G1HeapWastePercent=2 # 更积极回收

-XX:G1MixedGCCountTarget=16 # 增加轮次,每轮回收更少

-XX:G1MixedGCLiveThresholdPercent=85 # 只回收存活率 <85% 的 Region(默认 85)❗ 问题 2:Mixed GC 太频繁,影响吞吐

- 原因 :

G1HeapWastePercent过低,或应用产生大量短期 Old 对象; - 对策:

bash

-XX:G1HeapWastePercent=8

-XX:G1UseAdaptiveIHOP=true # 动态调整 IHOP(默认开启)🔍 监控 Mixed GC 行为

使用 jstat 或 GC 日志分析:

bash

# jstat 查看 Mixed GC 次数和耗时

jstat -gc <pid> 1s

# GC 日志关键字段(需开启 -Xlog:gc*)

[GC pause (G1 Evacuation Pause) (mixed), 0.025 secs]

[Eden: 128M(128M)->0B(128M) Survivors: 16M->16M Heap: 512M(1024M)->384M(1024M)]- 观察

Heap使用量是否在 Mixed GC 后显著下降; - 若 Mixed GC 后堆使用率降幅很小(如 <2%),说明

G1HeapWastePercent可能设得太低。

四、与其他参数的协同

| 参数 | 作用 | 与 G1HeapWastePercent 关系 |

|---|---|---|

-XX:G1MixedGCLiveThresholdPercent |

Old Region 存活率阈值(默认 85%) | 决定哪些 Region 进入候选集 |

-XX:G1MixedGCCountTarget |

Mixed GC 轮次目标(默认 8) | 控制每轮回收量,避免单次停顿过长 |

-XX:G1HeapRegionSize |

Region 大小(1~32MB) | 影响回收精度,小 Region 更灵活 |

💡 黄金组合建议(低延迟场景):

bash

-XX:G1HeapWastePercent=2

-XX:G1MixedGCLiveThresholdPercent=80

-XX:G1MixedGCCountTarget=16✅ 总结

| 问题 | 答案 |

|---|---|

| Mixed GC 触发条件 | 1. 并发标记完成; 2. 存在可回收 Old Region; 3. 可回收垃圾 ≥ G1HeapWastePercent% 堆; 4. 未达最大轮次 |

**G1HeapWastePercent**作用 |

控制 Mixed GC 的"启动门槛"------值越小,越积极回收 Old 区 |

| 如何优化 | - 内存敏感 → 调低 (1~3) - 吞吐优先 → 调高 (8~10) - 避免 Full GC → 不宜 >10 |

📌 记住 :G1 的目标是避免 Full GC ,而 G1HeapWastePercent 是平衡 "回收积极性" vs "CPU 开销" 的关键旋钮。合理设置可显著提升系统稳定性。

如何用 Async-Profiler 定位 CPU 占用高的 Java 方法?(要求说出具体命令)

使用 Async-Profiler 定位 Java 应用中 CPU 占用高的方法,是一种低开销、高精度、生产友好 的方式。它基于 perf_events(Linux) 或 DTrace(macOS) 实现采样,不会像 jstack 那样频繁 STW,也不会显著影响应用性能。

✅ 前提条件

- 目标 Java 进程正在运行(获取 PID);

- 已安装 Async-Profiler (GitHub 地址);

- Linux 系统 (推荐),且用户有权限访问

/proc/<pid>和 perf; - Java 应用以

**-XX:+PreserveFramePointer**启动(JDK 8u60+ 默认支持,非必须但推荐,可提升栈展开准确性)。

🔧 核心命令:定位 CPU 热点方法

步骤 1:获取 Java 进程 PID

bash

jps -l

# 或

ps aux | grep YourApp假设 PID 为 12345。

步骤 2:使用 Async-Profiler 采样 CPU(默认模式即为 CPU)

bash

# 采样 30 秒,生成火焰图(HTML)

./profiler.sh -d 30 -f profile.html 12345📌 参数说明:

-d 30:采样持续 30 秒(可根据负载调整,建议 10~60 秒);-f profile.html:输出为交互式火焰图(推荐);12345:目标 Java 进程 PID。

步骤 3:查看结果

- 在浏览器中打开

profile.html; - 火焰图从上到下表示调用栈深度,宽度表示 CPU 占用比例;

- 最宽的顶部函数即为 CPU 热点;

- 支持搜索、缩放、点击钻取。

🔍 其他常用命令变体

1. 仅输出文本格式(快速查看 top 方法)

bash

./profiler.sh -d 10 -o text 12345输出示例:

plain

45.2% java.lang.String.indexOf

22.1% com.yourcompany.service.DataProcessor.process

10.3% java.util.HashMap.get

...2. 包含 native 和 kernel 栈(全栈分析)

bash

./profiler.sh -d 30 -g -f full_profile.html 12345-g:启用 call graph(完整调用栈),包含 JNI、native、甚至内核函数(需 root 权限)。

3. 只分析 Java 代码(排除 native)

bash

./profiler.sh -d 30 -e cpu -i 1ms --filter-java-only -f java_only.html 12345--filter-java-only:仅显示 Java 方法(Async-Profiler 2.0+ 支持)。

4. 连续监控(类似 top)

bash

# 每 5 秒输出一次 top 方法

./profiler.sh -d 5 -o flat=5 12345⚠️ 注意事项

| 问题 | 解决方案 |

|---|---|

| Permission denied | 使用 sudo,或确保用户在 perf_users组; 执行:`echo -1 |

| 看不到 Java 方法名(只有 [unknown]) | 确保 Java 进程未被 stripped; 检查是否启用了 -XX:+PreserveFramePointer (JDK 11+ 默认开启) |

| 采样结果全是 GC 线程 | 可能是 GC 压力大,尝试结合 --lock或分析内存分配(用 -e alloc) |

| 容器环境(Docker/K8s) | 需挂载 --cap-add=SYS_ADMIN或 --privileged (生产慎用); 或使用 async-profiler的 agent 模式 |

🎯 实战技巧

- 对比优化前后 :采样两次,生成两个火焰图,用 speedscope.app 对比;

- 聚焦特定线程 :先用

jstack 12345找到高 CPU 线程 ID(转 16 进制),再用-t <tid>采样; - 与 GC 日志联动:若 CPU 高伴随 Full GC,优先排查内存泄漏。

✅ 总结:最常用命令

bash

# 通用推荐:30秒采样,生成火焰图

./profiler.sh -d 30 -f cpu_flame.html <PID>

# 快速文本查看

./profiler.sh -d 10 -o text <PID>💡 Async-Profiler 是现代 Java 性能诊断的"瑞士军刀"------不仅支持 CPU,还支持 allocation、lock、cache-misses 等事件。掌握它,能极大提升线上问题排查效率。

四、MySQL(索引 + 事务 + 架构)

InnoDB 的自增锁(AUTO-INC Lock)在 INSERT ... SELECT 场景下为何会退化为表锁?

InnoDB 的自增锁(AUTO-INC Lock)在 INSERT ... SELECT 场景下并非总是退化为表锁 ,而是取决于 **innodb_autoinc_lock_mode** 参数的设置。要理解这个问题,需要先了解 InnoDB 的三种自增锁模式以及 INSERT ... SELECT 语句的特性。

一、InnoDB 自增锁的三种模式(由 **innodb_autoinc_lock_mode** 控制)

| 模式值 | 名称 | 行为 |

|---|---|---|

| 0 | Traditional(传统模式) | 所有插入语句(包括 **INSERT ... SELECT**、 **LOAD DATA**等)都会持有 表级 AUTO-INC 锁,直到语句结束。保证自增值严格连续、可预测。 |

| 1 | Consecutive(连续模式,默认) | 简单插入(如 **INSERT INTO t VALUES (...)** )使用轻量级互斥锁(mutex),不阻塞其他事务;但批量插入(如 **INSERT ... SELECT**、 **REPLACE ... SELECT**、 **LOAD DATA**)会使用 表级 AUTO-INC 锁,直到语句结束。 |

| 2 | Interleaved(交错模式) | 所有插入都不使用表级 AUTO-INC 锁,自增值可能在并发下交错分配(不连续),但性能最高。 |

MySQL 5.7 及以后默认值为 1(Consecutive 模式)

二、为什么 **INSERT ... SELECT** 在 **innodb_autoinc_lock_mode=1** 下会使用表级 AUTO-INC 锁?

**原因:**无法预先知道要插入多少行

- 对于简单插入(如

**INSERT INTO t (id, name) VALUES (NULL, 'A'), (NULL, 'B')**),InnoDB 在解析阶段就能确定需要分配多少个自增值(这里是 2 个),因此可以:- 快速分配连续的 ID(如 101, 102)

- 使用轻量级 mutex 而非表锁

- 分配完立即释放,不阻塞其他插入

- 但对于

**INSERT ... SELECT**:

sql

INSERT INTO t1 (name) SELECT name FROM t2 WHERE condition;- **在执行 SELECT 之前,无法知道最终会返回多少行**

- **因此 InnoDB ****无法预先分配固定数量的自增值**

- **为了保证在语句执行过程中自增值的****连续性和可重复性****(例如用于 binlog 复制的一致性),InnoDB 必须在整个语句执行期间****独占自增计数器**

- **这就导致它必须获取 ****表级别的 AUTO-INC 锁****,直到整个 **`**INSERT ... SELECT**`** 完成**这种"退化"是为了在 性能 和 一致性/可恢复性 之间取得平衡。

三、后果与影响

- 在

**innodb_autoinc_lock_mode=1**下,一个大的**INSERT ... SELECT**会阻塞其他任何需要自增 ID 的插入操作(包括简单插入),因为它们都需要等待 AUTO-INC 锁。 - 如果你不需要严格的自增值连续性(例如主从复制使用基于 GTID 或 row-based binlog),可以考虑将

**innodb_autoinc_lock_mode**设置为 2 ,这样**INSERT ... SELECT**也不会加表锁,但自增值可能不连续或交错。

四、总结

**INSERT ... SELECT**** 在默认配置(**innodb_autoinc_lock_mode=1**)下会使用表级 AUTO-INC 锁,并非"退化",而是一种设计选择:因为无法预知插入行数,为保证语句级的自增连续性和复制一致性,必须在整个语句执行期间锁定自增计数器。**

如果你的应用对自增 ID 的连续性要求不高,且追求高并发插入性能,可以将 **innodb_autoinc_lock_mode** 改为 2(需确保使用 row-based binlog 以避免复制问题)。

✅** 最佳实践建议:**

- **主从复制环境:使用 **row-based binlog +

**innodb_autoinc_lock_mode=2**可安全提升并发性能 - **需要严格连续 ID 的场景(如某些审计系统):保留默认值 1,但避免大事务的 **

**INSERT ... SELECT**

**

**

MySQL 8.0 的隐藏主键(_rowid)在什么情况下存在?对性能有何影响?

在 MySQL 8.0 中,并不存在真正意义上的"隐藏主键"(如某些文档中误传的 **_rowid**)。这是一个常见的误解。我们需要澄清几个关键概念:

一、澄清:MySQL InnoDB 没有 像 Oracle 那样的 _rowid 隐藏主键

- Oracle 确实有

ROWID作为物理行地址。 - MySQL InnoDB****不会自动创建一个名为

**_rowid**的隐藏列。 - 但 InnoDB 确实会为没有显式主键的表创建一个内部的 6 字节"隐式聚簇索引键" ,这个键对用户不可见,也无法通过 SQL 查询(如

SELECT _rowid FROM t会报错)。

✅ 正确说法:InnoDB 在没有主键时会自动生成一个隐式的聚簇索引(clustered index) ,基于一个内部的 6 字节 ROW ID,但它不是用户可见的列 ,也**不叫 ****_rowid**。

二、什么时候 InnoDB 会使用这个隐式 ROW ID?

当表满足以下所有条件时,InnoDB 会生成内部 6 字节 ROW ID 作为聚簇索引:

- 没有定义任何主键(PRIMARY KEY)

- 没有定义任何非空且唯一的索引(NOT NULL + UNIQUE)

InnoDB 会选择第一个符合条件的 NOT NULL UNIQUE 索引作为聚簇索引。只有在完全找不到合适候选时,才会使用内部 ROW ID。

示例:

sql

-- 情况1:无主键,无唯一非空索引 → 使用隐式 ROW ID

CREATE TABLE t1 (a INT, b VARCHAR(10));

-- 情况2:有主键 → 使用主键作为聚簇索引

CREATE TABLE t2 (id INT PRIMARY KEY, name VARCHAR(10));

-- 情况3:无主键,但有 NOT NULL UNIQUE 索引 → 使用该索引作为聚簇索引

CREATE TABLE t3 (email VARCHAR(50) NOT NULL UNIQUE, name VARCHAR(10));三、这个隐式 ROW ID 对性能有何影响?

❌ 负面影响(主要):

- 插入性能下降(高并发下明显)

- 隐式 ROW ID 是全局递增分配的(由一个全局 mutex 保护)

- 所有使用隐式 ROW ID 的表共享同一个计数器

- 高并发插入时,多个线程竞争同一把锁,成为瓶颈

- 无法利用聚簇索引的优势

- 主键通常是业务相关字段(如 user_id),查询时可直接定位数据页

- 隐式 ROW ID 无业务意义,二级索引仍需回表,且无法优化范围查询

- 存储效率略低

- 6 字节 ROW ID 比很多业务主键(如 4 字节 INT)更大

- 二级索引的叶子节点存储的是聚簇索引键(即 ROW ID),导致索引更大

- 主从复制/备份无额外风险,但调试困难

- 无法通过 SQL 查看或引用该"主键",排查问题不便

✅ 几乎没有正面影响

除非你故意不要主键(极少见),否则应避免触发此机制。

四、关于 _rowid 的误解来源

在 MySQL 命令行客户端中,如果你执行:

sql

SELECT _rowid FROM some_table;有时能成功,但这只是因为:

- 如果表的主键是单列且为整数类型 (如

INT、BIGINT),MySQL 会将_rowid别名映射到该主键列 - 这是一种兼容性语法糖 ,并非真实存在

_rowid列

示例:

sql

CREATE TABLE t (id INT PRIMARY KEY, name VARCHAR(10));

SELECT _rowid FROM t; -- 成功,等价于 SELECT id FROM t

CREATE TABLE t2 (a INT, b INT); -- 无主键

SELECT _rowid FROM t2; -- ERROR 1054: Unknown column '_rowid'所以 _rowid 只是一个别名 ,仅在存在单列整数主键时可用,不是隐藏列。

五、最佳实践建议

- 始终为 InnoDB 表定义显式主键

- 推荐使用自增整数(

BIGINT AUTO_INCREMENT)或业务唯一 ID

- 推荐使用自增整数(

- 避免无主键表

- 即使业务无天然主键,也应添加代理主键(surrogate key)

- **不要依赖 **

**_rowid**- 它不是标准功能,行为不一致,且在无主键表中不可用

总结

| 项目 | 说明 |

|---|---|

是否存在 _rowid隐藏列? |

❌ 不存在(用户不可见) |

| 是否存在隐式聚簇键? | ✅ 有(6 字节内部 ROW ID),仅在无主键且无合适唯一索引时使用 |

| 性能影响 | ⚠️ 插入并发差、索引效率低、存储开销略高 |

| 建议 | ✅ 始终定义显式主键 |

通过显式主键,你可以获得更好的性能、可预测性和可维护性。

Binlog 的 ROW 格式下,UPDATE 语句如何记录 before/after image?对主从延迟有何影响?

在 MySQL 的 二进制日志(Binlog) 中,当 binlog_format = ROW(行格式)时,UPDATE 语句的记录方式与语句格式(STATEMENT)有本质区别。它会精确记录被修改行的数据变化 ,包括 Before Image(更新前的值) 和 After Image(更新后的值)。

一、ROW 格式下 UPDATE 如何记录 Before/After Image?

1. 基本结构

对于每一条被 UPDATE 修改的行,Binlog 会记录一个 Table_map_event + Update_rows_event:

- Table_map_event:标识操作的表(数据库名、表名、列类型等)

- Update_rows_event :包含:

- Before Image(BI):该行更新前的列值(用于定位和回滚)

- After Image(AI):该行更新后的列值

注意:并不是所有列都会被记录,具体取决于 binlog_row_image 参数。

2. binog_row_image 的三种模式(MySQL 5.6+ 引入)

| 模式 | Before Image | After Image | 说明 |

|---|---|---|---|

| FULL(默认) | 所有列 | 所有列 | 完整记录整行前后状态 |

| MINIMAL | 仅主键或唯一索引列 + 被 WHERE 条件用到的列 | 仅被 SET 修改的列 | 最小化日志体积 |

| NOBLOB | 同 FULL,但 BLOB 列若未修改则不记录 | 同 FULL,但 BLOB 列若未修改则不记录 | 针对大字段优化 |

示例(假设表 t(id PK, name, age)):

sql

UPDATE t SET age = 30 WHERE id = 1;- FULL 模式 :

- BI:

(id=1, name='Alice', age=25) - AI:

(id=1, name='Alice', age=30)

- BI:

- MINIMAL 模式 :

- BI:

(id=1)(主键用于定位行) - AI:

(age=30)(仅记录被修改的列)

- BI:

✅ MINIMAL 模式显著减少 Binlog 体积,尤其在宽表(列多)或只更新少数列时。

二、对主从延迟(Replication Lag)的影响

ROW 格式对主从延迟的影响是双刃剑,取决于使用场景:

✅ 正面影响(减少延迟)

- 避免从库执行复杂逻辑

- STATEMENT 格式下,

UPDATE ... WHERE func(col) = xxx可能在从库重复执行耗时函数 - ROW 格式直接应用数据变更,执行确定、高效

- STATEMENT 格式下,

- 并行复制(MTS)更高效

- MySQL 5.7+ 支持基于 logical clock 或 writeset 的并行复制

- ROW 格式能精确知道哪些表/行被修改,更容易实现事务并行回放

- 尤其在

binlog_transaction_dependency_tracking = WRITESET时,大幅降低延迟

- 避免非确定性函数问题

- 如

NOW(),RAND()在 STATEMENT 下主从结果可能不一致,需特殊处理;ROW 格式无此问题

- 如

⚠️ 负面影响(可能增加延迟)

- Binlog 体积膨胀(尤其 FULL 模式)

- 更新宽表时,FULL 模式会记录所有列,即使只改了一列

- 网络传输和从库 I/O 压力增大 → IO 瓶颈导致延迟

- 大事务放大问题

- 一个

UPDATE影响 100 万行,在 ROW 格式下会生成 100 万个 Update_rows_event - 主库写 Binlog 慢 + 从库回放大事务慢 → 主从延迟飙升

- 一个

- 无索引 UPDATE 导致全表扫描(从库)

- 如果 UPDATE 的 WHERE 条件列没有索引 ,从库在应用 ROW event 时需逐行比对 Before Image 来定位行

- 实际上是从库对每一行做"全表匹配",性能极差

💡 提示:从库在应用 ROW event 时,会优先使用主键/唯一索引定位行;若无,则退化为逐行比对 BI,非常慢!

三、优化建议(降低主从延迟)

- **设置 **

**binlog_row_image = MINIMAL**- 减少日志量,提升网络和 IO 效率

- 确保 UPDATE 的 WHERE 条件列有索引

- 避免从库回放时全表扫描

- 避免大事务

- 拆分大 UPDATE 为小批次(如每次 1000 行)

- 启用并行复制

sql

SET GLOBAL slave_parallel_workers = 8;

SET GLOBAL binlog_transaction_dependency_tracking = WRITESET;- 监控大事务和无主键表

- 无主键表在 ROW 格式下,Before Image 无法高效定位行,性能极差

四、总结

| 方面 | ROW 格式下的 UPDATE 行为 |

|---|---|

| 记录内容 | 记录每行的 Before Image + After Image |

| 日志大小 | 受 binlog_row_image控制,MINIMAL 可大幅压缩 |

| 主从一致性 | 强一致性,无非确定性问题 |

| 主从延迟 | 通常更优(因执行简单 + 并行复制),但大事务/无索引/宽表 FULL 模式会恶化延迟 |

| 最佳实践 | MINIMAL + 主键/索引 + 小事务 + 并行复制 |

✅ ROW 格式是现代 MySQL 主从复制的推荐选择,只要合理配置和设计表结构,可显著提升复制效率和稳定性。

如何用 pt-archiver 实现亿级表的无锁归档?关键参数有哪些?

使用 pt-archiver 对亿级大表进行无锁归档(lock-free archiving) 是 Percona Toolkit 中非常成熟且生产验证的方案。其核心思想是:通过小批量、基于索引的分页查询 + 事务控制 + 可控删除/迁移,避免长时间持有表锁或阻塞线上业务。

一、基本原理:如何做到"无锁"?

pt-archiver**不使用 ****LOCK TABLES**,而是:

- 利用主键或时间索引进行分页扫描 (如

WHERE id > ? ORDER BY id LIMIT 1000) - 每次只处理一小批数据(默认 1000 行),每批在一个事务中完成

- DELETE 或 INSERT+DELETE 操作快速提交,减少行锁持有时间

- 自动 sleep 控制速率,避免主库压力过大

- 支持断点续传 (通过

--resume)

✅ 因此,它对线上 OLTP 业务影响极小,可视为"近似无锁"。

二、关键参数详解(针对亿级表)

🔑 核心必选参数

| 参数 | 说明 |

|---|---|

--source |

源数据库 DSN(必须包含 h=,D=,t=) |

--dest |

目标归档表 DSN(可选,若只删除则省略) |

--where |

归档条件(如 create_time < '2023-01-01') |

--primary-key |

指定用于分页的主键列(默认自动探测) |

⚙️ 性能与安全关键参数(亿级表重点调优)

| 参数 | 推荐值 | 作用 |

|---|---|---|

--limit |

1000~ 5000 |

每次取多少行(太小效率低,太大易锁行/超时) |

--txn-size |

与 --limit 相同或倍数 |

每多少行提交一次事务(默认 = --limit) |

--sleep |

0.1 ~ 2 |

每批处理后 sleep 秒数,控制 I/O 压力 |

--max-load |

Threads_running=25,Threads_connected=1000 |

超过负载则暂停(保护主库) |

--progress |

10000 |

每 N 行打印进度(监控用) |

--statistics |

(可选) | 打印性能统计 |

--bulk-delete |

(谨慎) | 使用 DELETE ... LIMIT批量删(更快但不可回滚) |

--no-delete |

(若只迁移不删) | 仅复制到归档表,不删除源数据 |

🛡️ 安全与一致性参数

| 参数 | 说明 |

|---|---|

--check-charset |

检查字符集一致性(避免乱码) |

--check-slave-lag |

指定从库,延迟超过阈值则暂停(如 --check-slave-lag h=slave1 --max-lag=60s) |

--why-quit |

显示退出原因(调试用) |

--dry-run |

试运行,不真实操作(上线前必用!) |

--file |

若归档到文件而非表,指定文件路径 |

三、典型使用场景示例

场景 1:将旧数据迁移到归档表并删除源数据(最常见)

bash

pt-archiver \

--source h=localhost,D=mydb,t=orders,u=admin,p=xxx \

--dest h=arch-db,D=archive,t=orders_old,u=admin,p=xxx \

--where "create_time < '2023-01-01'" \

--limit 2000 \

--txn-size 2000 \

--sleep 0.5 \

--progress 10000 \

--statistics \

--check-slave-lag h=replica1 \

--max-lag 60 \

--max-load "Threads_running=30" \

--no-version-check场景 2:仅删除过期数据(不归档)

bash

pt-archiver \

--source h=localhost,D=mydb,t=log_table,u=admin,p=xxx \

--purge \

--where "log_date < CURDATE() - INTERVAL 180 DAY" \

--limit 1000 \

--txn-size 1000 \

--sleep 1 \

--progress 5000注意:--purge 表示只删不归档。

四、亿级表归档最佳实践

✅ 必做事项:

- 确保归档字段有索引

--where条件中的列(如create_time)必须有索引,否则全表扫描会拖垮数据库- 最佳:

(create_time, id)联合索引(覆盖分页和过滤)

- 主键必须是自增整数

pt-archiver依赖主键进行高效分页(WHERE id > ? ORDER BY id)- 非整数主键(如 UUID)会导致性能急剧下降

- 先

**--dry-run**测试

bash

pt-archiver ... --dry-run- 在业务低峰期运行

- 即使无锁,大量 DELETE 仍会产生 binlog 和 undo log

- 监控主从延迟 & 系统负载

- 使用

--check-slave-lag和--max-load自动暂停

- 使用

❌ 避免事项:

- 不要对无主键表使用(性能极差)

- 不要设置

--limit过大(如 > 10000),可能导致长事务或锁等待 - 不要在高并发写入期间归档热点表(可能加剧行锁竞争)

五、性能调优建议

| 问题 | 调优方向 |

|---|---|

| 归档太慢 | 适当增大 --limit(如 5000),减少 round-trip |

| 主库 CPU/I/O 高 | 增大 --sleep(如 1~2 秒),降低速率 |

| 从库延迟飙升 | 启用 --check-slave-lag,设置合理 --max-lag |

| Binlog 增长过快 | 考虑归档后手动清理 binlog,或使用 --bulk-delete(需权衡) |

六、补充:断点续传

pt-archiver 默认会在当前目录生成 .pt-archiver.safe-auto-increment 文件记录上次归档到的主键值。下次加 --resume 即可继续:

bash

pt-archiver ... --resume注意:确保 --where 条件不变,否则可能漏数据或重复。

总结

pt-archiver 通过 小批量、索引分页、事务控制、负载感知 实现了对亿级表的低影响、可中断、可监控的归档。关键在于:

- **合理设置

**--limit**/**--sleep**/ ****--txn-size** - 确保归档条件列和主键有高效索引

- 启用

**--check-slave-lag**和**--max-load**保障稳定性

💡 在生产环境中,建议先在测试库模拟亿级数据验证参数,再上线执行。

官方文档:https://docs.percona.com/percona-toolkit/pt-archiver.html

MGR(MySQL Group Replication)的单主模式 vs 多主模式,冲突检测机制是什么?

MySQL Group Replication(MGR)支持 单主模式(Single-Primary Mode) 和 多主模式(Multi-Primary Mode) ,两者在写入行为和冲突处理上有本质区别。其核心依赖于 基于写集(Write Set)的认证(Certification)机制 来实现分布式一致性。下面详细解析两者的冲突检测机制。

一、MGR 的底层冲突检测机制:Certification Based on Write Sets

无论单主还是多主,MGR 都使用 相同的底层冲突检测逻辑,基于以下原理:

1. 事务提交前生成 Write Set

- 每个事务在本地执行时,会记录它修改的所有 主键(或唯一键)值 ,形成一个 Write Set 。

- 例如:

UPDATE t SET name='Alice' WHERE id=100;→ Write Set 包含(t, id=100)

- 例如:

- Write Set 不包含具体 SQL,只包含 被修改行的唯一标识(即聚簇索引或唯一索引键值)。

2. 事务进入 Group Communication System(GCS)

- 事务在本地 prepare 后,将 Write Set 广播给组内所有节点。

- 所有节点并行进行 Certification(认证)。

3. Certification 规则(冲突判定)

如果当前事务的 Write Set 与任何已提交但尚未全局应用的事务存在"写-写冲突"(即修改同一行),则当前事务被 abort。

具体判断逻辑:

- 比较当前事务的 Write Set 与 全局已提交事务队列中、GTID 大于当前事务的那些事务 的 Write Set。

- 若有交集(即修改了同一主键行)→ 冲突!事务回滚。

✅ 这是一种 乐观并发控制(Optimistic Concurrency Control, OCC):先执行,提交时再验证。

二、单主模式(Single-Primary) vs 多主模式(Multi-Primary)的差异

| 特性 | 单主模式 | 多主模式 |

|---|---|---|

| 写入节点 | 仅 PRIMARY 节点可写 | 所有节点均可写 |

| 冲突发生概率 | 极低(几乎为 0) | 高(多节点并发写同一行) |

| 冲突检测作用 | 主要用于防止从库异常写入(如误操作) | 核心机制,用于解决多写冲突 |

| 默认配置 | MySQL 8.0+ 默认启用 | 需显式设置 group_replication_single_primary_mode=OFF |

▶ 单主模式下的冲突检测

- 正常情况下不会发生冲突 ,因为所有写都集中在 PRIMARY 节点,其他 SECONDARY 节点是只读的(

super_read_only=ON)。 - 冲突检测主要用于:

- 防止管理员手动关闭

super_read_only后在 SECONDARY 上写入 - 网络分区后脑裂场景的防护

- 防止管理员手动关闭

- 结果:SECONDARY 上的写入事务会在 Certification 阶段被 abort,并报错:

plain

ERROR 3098 (HY000): The table does not comply with the requirements by an external plugin.▶ 多主模式下的冲突检测(重点)

- 多个节点可同时写入同一张表的同一行 → 冲突高发场景。

- MGR 不阻止写入 ,而是允许事务在本地执行成功,但在 全局提交阶段通过 Certification 检测冲突。

- 冲突处理策略:后提交者失败(Last Writer Loses)

示例:

sql

-- Node1:

BEGIN;

UPDATE accounts SET balance = balance - 100 WHERE user_id = 1;

COMMIT; -- GTID: aaa:1

-- Node2(几乎同时):

BEGIN;

UPDATE accounts SET balance = balance + 50 WHERE user_id = 1;

COMMIT; -- GTID: bbb:1假设 Node1 的事务先被全局排序(Total Order),则:

- Node1 的事务通过 Certification,成功提交。

- Node2 的事务在 Certification 时发现:

user_id=1已被aaa:1修改 → 冲突!Node2 的事务被回滚。

❗ 用户在 Node2 会看到:ERROR 3098 (HY000): ... certification failed.

三、如何减少多主模式下的冲突?

- 应用层分片(Sharding)

- 按业务维度分配写入节点(如用户 ID 哈希到固定节点)

- 避免多节点操作同一行

- 避免热点行

- 如全局计数器、库存扣减等场景不适合多主写

- 使用

**group_replication_allow_local_disjoint_gtids_join=ON**(谨慎)- 允许节点以不同 GTID 集合加入,但可能增加冲突风险

- 监控冲突指标

sql

SHOW STATUS LIKE 'Group_replication_transaction_conflicts';- 该值 > 0 表示发生了冲突回滚四、重要补充:Write Set 的生成依赖

- 必须有主键或唯一 NOT NULL 索引 !

- 如果表没有主键,InnoDB 会生成隐藏 ROW ID,但 MGR 无法基于它生成有效 Write Set

- 结果:整张表被当作一个"大锁",任何更新都会与其他更新冲突 → 性能灾难!

✅ 强烈建议:所有参与 MGR 的表必须定义显式主键!

五、总结

| 项目 | 说明 |

|---|---|

| 冲突检测机制 | 基于 Write Set 的 Certification(乐观并发控制) |

| 冲突判定依据 | 事务修改的主键/唯一键是否重叠 |

| 单主模式 | 冲突极少,主要用于安全防护 |

| 多主模式 | 冲突常见,采用"后提交者失败"策略 |

| 关键要求 | 表必须有主键,否则 Write Set 无效,冲突率 100% |

| 最佳实践 | 多主模式下应用层需做写入路由,避免热点 |

💡 生产建议 :除非有强多活写入需求,否则优先使用 单主模式,更简单、稳定、易运维。多主模式需谨慎设计业务逻辑以规避冲突。

五、Redis(持久化 + 集群 + 新特性)

Redis 7.0 的 Function 功能如何替代 Lua 脚本?相比 EVALSHA 有何优势?

Redis 7.0 引入了 Function(函数) 功能(通过 FUNCTION LOAD、FCALL 等命令),旨在提供一种比传统 Lua 脚本(EVAL / EVALSHA)更强大、安全、可管理的服务器端编程能力。它不是完全替代 Lua ,而是对 Redis 服务端脚本能力的现代化升级和补充。

一、Function 是什么?

Redis Function 是用 Lua 5.1 编写的脚本,但以 命名函数(named functions) 的形式注册到 Redis 中,并通过 **FCALL function_name** 调用。

✅ 本质仍是 Lua,但运行在新的 "函数沙箱" 环境中,具有更强的隔离性和生命周期管理。

基本使用示例:

lua

-- 定义一个函数(字符串形式)

local code = [[

redis.register_function('my_incr', function(keys, args)

local key = keys[1]

local delta = tonumber(args[1]) or 1

return redis.call('INCRBY', key, delta)

end)

]]

-- 加载函数

FUNCTION LOAD REPLACE "#!lua name=mylib\n" .. code

-- 调用函数

FCALL my_incr 1 mykey 5注意:函数必须通过 redis.register_function(name, func) 注册。

二、Function 相比 EVAL / EVALSHA 的核心优势

| 特性 | EVAL / EVALSHA | Redis Function (7.0+) | 优势说明 |

|---|---|---|---|

| 命名与复用 | 无名脚本,靠 SHA1 调用 | 有明确函数名 (如 my_incr) |

更易读、易维护、语义清晰 |

| 代码组织 | 单个脚本独立 | 支持 库(library) 概念,一个库可包含多个函数 | 模块化开发,逻辑分组 |

| 部署管理 | 需手动缓存 SHA1,或每次传完整脚本 | 通过 FUNCTION LOAD 一次性部署,FCALL 直接按名调用 |

无需客户端管理 SHA1,简化运维 |

| 版本更新 | SCRIPT FLUSH 清空所有,无法原子替换单个脚本 |

支持 FUNCTION LOAD REPLACE 原子替换指定库 |

灰度发布、热更新更安全 |

| 资源隔离 | 所有脚本共享全局 Lua 状态 | 每个库独立 Lua 环境 (独立 _G表) |

避免函数间意外污染,提升安全性 |

| 持久化与同步 | 脚本不持久化,重启后需重载;主从复制需手动同步 | 函数自动持久化到 RDB/AOF ,并通过主从复制自动同步 | 高可用场景下更可靠 |

| 调试与内省 | SCRIPT EXISTS / SCRIPT FLUSH 功能有限 |

提供 FUNCTION LIST 、FUNCTION DUMP 、FUNCTION RESTORE |

可查看函数列表、导出/导入函数集 |

| 权限控制(ACL) | 只能控制 EVAL 命令权限 |

可对具体函数名 设置 ACL 权限(如 +mylib.my_incr) |

细粒度安全控制 |

三、关键机制详解

1. Library(库)概念

- 一个 Function 库是一个逻辑单元,包含:

- 库名(

name=mylib) - 多个注册的函数(

register_function) - 独立的 Lua 全局环境

- 库名(

- 示例:

lua

#!lua name=order_utils

redis.register_function('create_order', ...)

redis.register_function('cancel_order', ...)2. 自动持久化与复制

- 执行

FUNCTION LOAD后:- 函数代码写入 AOF(作为

FUNCTION LOAD命令) - RDB 快照包含函数定义

- 主从复制自动传播函数定义

- 函数代码写入 AOF(作为

- 重启后函数依然存在,无需客户端重新加载

3. 原子更新(REPLACE)

bash

FUNCTION LOAD REPLACE "#!lua name=mylib\n ..."- 替换整个

mylib库,旧版本立即失效 - 避免

SCRIPT FLUSH导致所有脚本丢失的风险

4. ACL 支持(Redis 6+ ACL + 7.0 Function)

bash

ACL SETUSER appuser +mylib.create_order ~orders:*- 精确授权用户只能调用特定函数,操作特定 key 模式

四、Function 并未完全取代 EVAL 的场景

| 场景 | 仍推荐使用 EVAL |

|---|---|

| 简单、一次性的脚本 | 如临时数据修复,无需长期维护 |

| 客户端动态生成脚本 | 脚本内容依赖运行时参数,无法预定义 |

| 兼容旧版本 Redis(<7.0) | Function 仅 Redis 7.0+ 支持 |

💡 实际上,Function 是 EVAL 的"演进形态" ,适用于需要长期维护、复用、管理的业务逻辑。

五、迁移建议:从 EVAL 到 Function

- 将常用 Lua 脚本封装为函数

lua

-- 原 EVAL 脚本

EVAL "return redis.call('INCR', KEYS[1])" 1 counter

-- 改为 Function

redis.register_function('incr_key', function(keys, args)

return redis.call('INCR', keys[1])

end)- 按业务模块划分库

user_funcs:用户相关逻辑order_funcs:订单相关逻辑

- **部署时使用 **

**FUNCTION LOAD REPLACE**- 实现 CI/CD 自动化部署

- 客户端改用

**FCALL**调用- 无需计算 SHA1,代码更清晰

六、总结

| 维度 | EVAL / EVALSHA | Redis Function |

|---|---|---|

| 定位 | 基础脚本执行 | 现代化服务端函数平台 |

| 管理性 | 弱(无名、难追踪) | 强(命名、库、列表、dump) |

| 可靠性 | 重启丢失,需重载 | 自动持久化+复制 |

| 安全性 | 粗粒度(仅命令级) | 细粒度(函数级 ACL) |

| 适用场景 | 临时脚本、简单逻辑 | 核心业务逻辑、长期维护 |

✅ 结论 :对于新项目或可升级到 Redis 7.0+ 的系统,应优先使用 Function 替代 EVAL/EVALSHA 实现复杂业务逻辑;简单场景仍可保留 EVAL。Function 是 Redis 向"可编程数据库"迈出的重要一步。

Redis Cluster 的 slot 迁移过程中,客户端如何感知并重定向?MOVED vs ASK 的区别?

在 Redis Cluster 中,slot(槽)迁移 是实现数据再平衡、扩容/缩容的核心机制。在此过程中,客户端需要正确处理来自服务器的重定向响应,以确保请求被路由到正确的节点。Redis 通过两种关键错误响应:**MOVED** 和 **ASK** 来指导客户端行为。它们的语义和使用场景有本质区别。

一、背景:Slot 迁移的基本流程

Redis Cluster 将 16384 个 slot 分配给多个主节点。当执行 CLUSTER SETSLOT <slot> MIGRATING <target-node-id> 和 CLUSTER SETSLOT <slot> IMPORTING <source-node-id> 后,迁移开始:

- 源节点 将 slot 标记为

MIGRATING - 目标节点 将 slot 标记为

IMPORTING - 使用

MIGRATE命令逐 key 迁移数据 - 迁移完成后,通过

CLUSTER SETSLOT <slot> NODE <target-node-id>正式移交 slot 所有权

在此期间,同一个 slot 的部分 key 在源节点,部分在目标节点,客户端必须能正确处理。

二、客户端如何感知并重定向?

当客户端向一个节点发送命令(如 GET key),该节点会:

- 计算

key所属的 slot - 检查本地是否负责该 slot

- 如果 不负责 → 返回

**MOVED** - 如果 负责但 key 正在迁移中且已迁走 → 返回

**ASK**

- 如果 不负责 → 返回

客户端收到这些响应后,应:

- 解析新节点地址

- 重新连接该节点并重试命令

✅ 所有 Redis 官方及主流客户端(如 Jedis、Lettuce、redis-py)都内置了对 MOVED/ASK 的自动处理逻辑。

三、MOVED vs ASK 的核心区别

| 特性 | MOVED |

ASK |

|---|---|---|

| 触发条件 | 请求的 slot 已永久迁移到其他节点 | 请求的 key 正在迁移中,且已迁移到目标节点 |

| 语义 | "这个 slot 现在归那个节点管,请更新你的 slot 映射表" | "这个 key 现在在那个节点上,请临时去那里查一下" |

| 客户端行为 | 更新本地 slot -> node 映射缓存,后续同 slot 请求直接发往新节点 | 不更新 slot 映射,仅本次请求重定向到目标节点 |

| 是否需要再次请求原节点 | 否 | 是(迁移未完成前,新写入可能仍在原节点) |

| 典型场景 | 扩容/缩容完成后的稳定状态 | slot 迁移过程中(中间状态) |

📌 详细示例说明

假设 slot 1000 正从 Node A 迁移到 Node B。

场景 1:客户端访问一个尚未迁移的 key(仍在 Node A)

- 请求发到 Node A → Node A 仍有该 key → 正常返回

场景 2:客户端访问一个已迁移的 key(现在在 Node B)

- 请求发到 Node A(因为客户端缓存 slot 1000 → Node A)

- Node A 发现 key 已迁走 → 返回:

plain

ASK 1000 192.168.1.2:7002- 客户端:

- 不更新 slot 1000 的映射

- 向

192.168.1.2:7002(Node B)发送ASKING命令(特殊标记) - 紧接着重发原命令(如

GET key) - Node B 因收到

ASKING,会临时允许访问处于IMPORTING状态的 slot

🔑 ASKING 是一个一次性标志,让目标节点"破例"处理本应拒绝的请求。

场景 3:slot 迁移完成,Node B 正式接管 slot 1000

- 客户端仍按旧缓存发请求到 Node A

- Node A 返回:

plain

MOVED 1000 192.168.1.2:7002- 客户端:

- 更新本地 slot 映射表:slot 1000 → Node B

- 后续所有 slot 1000 的请求直接发往 Node B

四、客户端处理流程(伪代码)

python

def send_command(key, command):

node = get_node_by_slot(hash_slot(key))

while True:

try:

return node.execute(command)

except MOVED as e:

# 更新 slot 映射

update_slot_map(e.slot, e.new_node)

node = e.new_node

except ASK as e:

# 临时重定向,不更新映射

temp_node = connect(e.new_node)

temp_node.execute("ASKING") # 关键!

return temp_node.execute(command)⚠️ 忽略 ASKING 会导致目标节点拒绝请求(因 slot 处于 IMPORTING 状态,不允许普通访问)。

五、常见误区澄清

| 误区 | 正确理解 |

|---|---|

"ASK表示 slot 已迁移" |

❌ ASK仅表示该 key 已迁移,slot 本身仍在迁移中 |

"收到 ASK后应更新 slot 映射" |

❌ 不应更新,否则会导致新写入的 key 被发往错误节点 |

"MOVED和 ASK可互换" |

❌ 语义完全不同,客户端必须区分处理 |

六、总结

| 对比项 | MOVED |

ASK |

|---|---|---|

| 阶段 | 迁移完成后 | 迁移进行中 |

| 作用范围 | 整个 slot | 单个 key |

| 客户端动作 | 更新缓存 | 临时重试 + ASKING |

| 持久性 | 永久重定向 | 一次性重定向 |

✅ 简单记忆:

**MOVED**** = "搬家完成,请改地址簿"****ASK**** = "东西已寄出,请去快递点临时取一下"**

正确理解和处理 MOVED/ASK 是构建高可用 Redis Cluster 客户端的关键。现代客户端库已封装这些逻辑,但开发者仍需了解其原理以排查路由问题。

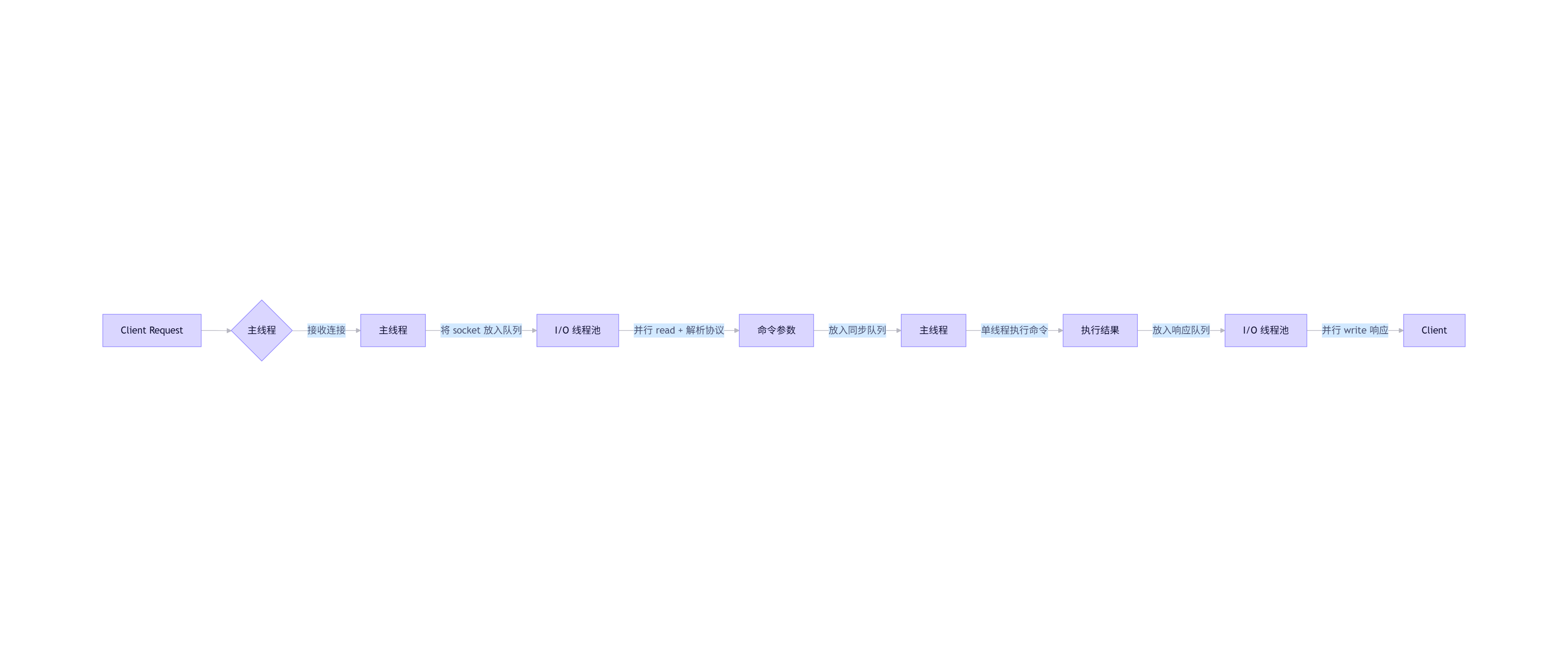

为什么 Redis 6.0 引入多线程 I/O 后,命令执行仍是单线程?如何配置 I/O 线程数?

Redis 6.0 引入的 多线程 I/O(I/O Threading) 是 Redis 历史上一次重要的性能优化,但它仅用于网络 I/O 和协议解析 ,命令执行(command execution)仍然保持单线程 。这是 Redis 核心设计哲学的延续:简单、原子、无锁的数据操作。

一、为什么命令执行仍是单线程?

✅ 核心原因:保证数据操作的原子性和线程安全

- 避免复杂的并发控制

- Redis 的数据结构(如 Hash、ZSet、List)不是线程安全的

- 如果多个线程同时修改同一个 key,需要加锁(如读写锁、细粒度锁),会极大增加复杂度和开销

- 维持"命令原子性"语义

- 用户期望

INCR key、LPUSH list val等操作是原子的 - 单线程天然保证:任意时刻只有一个命令在执行,无需考虑竞态条件

- 用户期望

- 简化内存管理与持久化

- RDB 快照、AOF 重写等操作依赖于"一致的数据状态"

- 多线程执行命令会导致快照内容不一致或需要复杂的 copy-on-write 机制

- 性能瓶颈通常不在 CPU

- Redis 的瓶颈多在 网络带宽、内存带宽、系统调用开销,而非 CPU 计算

- 多线程 I/O 已能显著提升吞吐(尤其在高并发、小请求场景)

💡 Redis 的设计哲学 :

"用单线程保证核心逻辑简单可靠,用多线程加速非核心 I/O 路径"

二、Redis 6.0+ 多线程 I/O 的工作流程

- I/O 线程负责 :

read()从 socket 读取数据- 解析 RESP 协议(将字节流解析为命令和参数)

write()将响应写回 socket

- 主线程负责 :

- 接受新连接(

accept) - 执行所有命令逻辑

- 触发持久化、过期删除、集群通信等

- 接受新连接(

⚠️ 注意:命令解析(parsing)在 I/O 线程,但命令执行(execution)一定在主线程。

三、如何配置 I/O 线程数?

通过 **redis.conf** 或 运行时命令 配置:

1. 启用 I/O 多线程(默认关闭)

plain

io-threads-do-reads yesyes:I/O 线程处理 读 + 写no(默认):I/O 线程仅处理 写(兼容性更好,性能提升较小)

2. 设置 I/O 线程数量

plain

io-threads 4- 建议值:CPU 核数的一半到全部(通常 2~6 足够)

- 不要超过 CPU 核数,否则线程切换开销反而降低性能

- 至少为 2 才生效(1 表示禁用多线程 I/O)

3. 动态配置(Redis 6.0+)

bash

# 查看当前设置

CONFIG GET io-threads*

# 设置(需在 redis-cli 中执行)

CONFIG SET io-threads 4

CONFIG SET io-threads-do-reads yes📌 注意 :修改 io-threads 后必须重启 Redis 才能生效(因为线程池在启动时创建)。

四、性能建议与注意事项

| 场景 | 建议 |

|---|---|

| 高吞吐、小 value(如缓存) | 开启 io-threads-do-reads yes + io-threads 4~6 |

| 大 value(如 > 10KB) | 多线程 I/O 提升明显(减少主线程 read/write 阻塞) |

| 低延迟敏感型应用 | 谨慎开启,线程切换可能增加尾延迟(p99) |