HarmonyOS 6实战(源码教学篇)--- Speech Kit AI字幕深度集成:音频数据处理与性能优化

- [HarmonyOS 6实战(源码教学篇)--- Speech Kit AI字幕深度集成:音频数据处理与性能优化](#HarmonyOS 6实战(源码教学篇)— Speech Kit AI字幕深度集成:音频数据处理与性能优化)

-

- 前言

- 一:核心概念与原理

- [二:Speech Kit 音频数据处理](#二:Speech Kit 音频数据处理)

-

- [1 适用条件](#1 适用条件)

- [2 核心技术:音频格式转换](#2 核心技术:音频格式转换)

-

- [2.1 创建音频重采样工具](#2.1 创建音频重采样工具)

- [2.2 创建音频字幕桥接器](#2.2 创建音频字幕桥接器)

- [2.3 修改AudioRendererController](#2.3 修改AudioRendererController)

- [3 调试技巧](#3 调试技巧)

-

- [3.1 验证音频格式](#3.1 验证音频格式)

- [3.2 监控数据包大小](#3.2 监控数据包大小)

- [3.3 使用DevEco Studio调试工具](#3.3 使用DevEco Studio调试工具)

- [4 常见问题排查](#4 常见问题排查)

- [三:Speech Kit 性能优化](#三:Speech Kit 性能优化)

-

-

- [3.1 使用Worker线程处理重采样](#3.1 使用Worker线程处理重采样)

- [3.2 动态调整批处理大小](#3.2 动态调整批处理大小)

- [3.3 内存池优化](#3.3 内存池优化)

-

- 总结

HarmonyOS 6实战(源码教学篇)--- Speech Kit AI字幕深度集成:音频数据处理与性能优化

前言

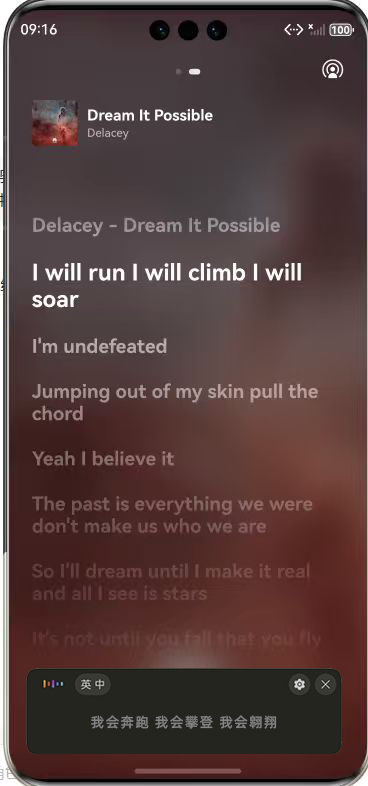

大家好!我是木斯佳,华为云 HDE 认证专家和 OpenTiny 开源社区的布道师。在上一篇文章中,我们一起实现了 HarmonyOS 音乐播放器的基础功能,并集成了系统级的 AI 字幕显示能力。相信很多小伙伴已经体验到了实时字幕为音乐欣赏带来的全新维度。

但技术的探索永无止境------在实际开发中,你是否遇到过这样的问题?

-

为什么某些音频的字幕识别准确率不高?

-

如何处理实时音频流的格式转换和时序同步?

-

如何在高频数据流处理中保持应用性能?

-

如何设计一个可扩展、易维护的字幕处理架构?

今天,我们将深入 HarmonyOS 6 的 Speech Kit 核心,不再是简单的 API 调用,而是从底层原理出发,剖析音频数据的流向、转换、处理全流程。

我们将以"仿某云音乐"的 AI 字幕功能为蓝本,从系统架构、数据流、性能调优三个维度,手把手教你如何构建一个既稳定又高效的智能音乐播放器。

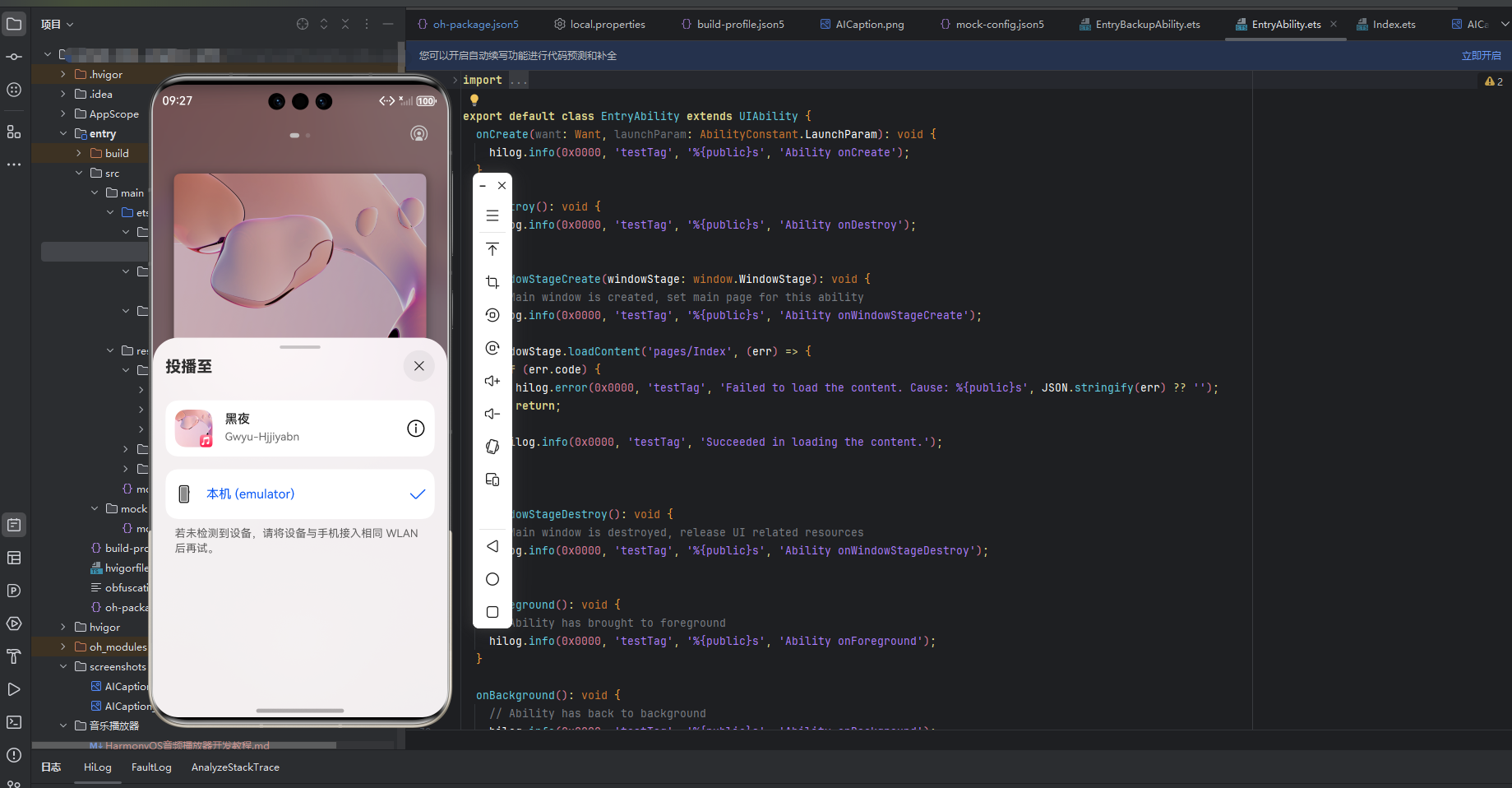

应用回顾

音乐播放器 + AI字幕集成架构

├── entry (UI层)

│ ├── 播放器界面

│ ├── AI字幕显示区

│ └── 控制交互

├── MediaService (服务层)

│ ├── AudioRendererController (音频播放控制)

│ ├── AVSessionController (媒体会话管理)

│ └── BackgroundUtil (后台任务)

└── AI字幕集成模块

├── AICaptionController (字幕控制器)

└── AudioCaptionBridge (音频桥接,)一:核心概念与原理

音频文件 (PCM)

↓

AudioRenderer 播放

↓

音频数据分流 ──→ 格式转换 ──→ AICaptionComponent

↓ ↓

扬声器输出 AI语音识别

↓

字幕实时显示二:Speech Kit 音频数据处理

1 适用条件

- ✅ HarmonyOS 版本 5.0.0(12) ~ 5.1.0(17)

- ✅ 需要精确控制字幕显示时机

- ✅ 需要自定义音频处理逻辑

- ✅ 需要在发送前预处理音频

2 核心技术:音频格式转换

2.1 创建音频重采样工具

创建文件:entry/src/main/ets/common/utils/AudioResampler.ets

typescript

/**

* 音频重采样工具

* 功能:48kHz双声道 → 16kHz单声道

*/

import { hilog } from '@kit.PerformanceAnalysisKit';

const TAG = 'AudioResampler';

export class AudioResampler {

/**

* 音频格式转换:48kHz双声道 → 16kHz单声道

* @param input 输入音频数据(48kHz, 双声道, 16bit)

* @returns 输出音频数据(16kHz, 单声道, 16bit)

*/

static resample48kTo16k(input: ArrayBuffer): Uint8Array {

try {

// 将ArrayBuffer转换为Int16Array(16位采样)

const inputData = new Int16Array(input);

// 输入参数

const inputChannels = 2; // 双声道

const inputSampleRate = 48000; // 48kHz

const outputSampleRate = 16000; // 16kHz

// 计算降采样比例:48000/16000 = 3

// 即每3个输入样本取1个输出样本

const downsampleRatio = inputSampleRate / outputSampleRate;

// 计算输入样本数(每个样本包含左右声道)

const inputSamples = inputData.length / inputChannels;

// 计算输出样本数

const outputSamples = Math.floor(inputSamples / downsampleRatio);

const outputData = new Int16Array(outputSamples);

// 重采样 + 双声道转单声道

for (let i = 0; i < outputSamples; i++) {

// 计算输入位置(每3个样本取1个)

const inputIndex = Math.floor(i * downsampleRatio);

// 获取左右声道数据

const leftChannel = inputData[inputIndex * 2];

const rightChannel = inputData[inputIndex * 2 + 1];

// 取平均值转为单声道

outputData[i] = Math.floor((leftChannel + rightChannel) / 2);

}

// 转换为Uint8Array返回

return new Uint8Array(outputData.buffer);

} catch (error) {

hilog.error(0x0000, TAG, `重采样失败: ${error.message}`);

return new Uint8Array(0);

}

}

/**

* 将数据分割为640字节的块

* @param data 输入数据

* @param chunkSize 块大小(640或1280字节)

* @returns 分割后的数据块数组

*/

static splitToChunks(data: Uint8Array, chunkSize: number = 640): Uint8Array[] {

const chunks: Uint8Array[] = [];

for (let offset = 0; offset < data.length; offset += chunkSize) {

const remainingBytes = data.length - offset;

if (remainingBytes >= chunkSize) {

// 完整的块

chunks.push(data.slice(offset, offset + chunkSize));

} else if (remainingBytes > 0) {

// 最后一块不足640字节,填充0

const paddedChunk = new Uint8Array(chunkSize);

paddedChunk.set(data.slice(offset));

chunks.push(paddedChunk);

}

}

return chunks;

}

/**

* 验证数据包大小是否符合要求

*/

static isValidChunkSize(size: number): boolean {

return size === 640 || size === 1280;

}

}算法说明:

- 降采样:48kHz → 16kHz,比例为 3:1,每3个样本取1个

- 声道转换:双声道 → 单声道,取左右声道平均值

- 数据分块:将连续数据分割为640字节的块

2.2 创建音频字幕桥接器

创建文件:entry/src/main/ets/common/utils/AudioCaptionBridge.ets

typescript

/**

* 音频字幕桥接器

* 负责将音频数据从AudioRenderer传递到AICaptionComponent

*/

import { AICaptionController, AudioData } from '@kit.SpeechKit';

import { AudioResampler } from './AudioResampler';

import { hilog } from '@kit.PerformanceAnalysisKit';

const TAG = 'AudioCaptionBridge';

export class AudioCaptionBridge {

private static instance: AudioCaptionBridge;

private captionController?: AICaptionController;

private isEnabled: boolean = false;

// 性能优化:批量处理

private audioBufferQueue: ArrayBuffer[] = [];

private readonly BATCH_SIZE = 5; // 每5个buffer处理一次

// 错误处理

private errorCount: number = 0;

private readonly MAX_ERROR_COUNT = 5;

// 内存管理

private lastCleanupTime: number = 0;

private readonly CLEANUP_INTERVAL = 30000; // 30秒清理一次

private constructor() {

hilog.info(0x0000, TAG, 'AudioCaptionBridge 初始化');

}

public static getInstance(): AudioCaptionBridge {

if (!AudioCaptionBridge.instance) {

AudioCaptionBridge.instance = new AudioCaptionBridge();

}

return AudioCaptionBridge.instance;

}

/**

* 设置字幕控制器

*/

public setCaptionController(controller: AICaptionController) {

this.captionController = controller;

// 获取并验证音频格式要求

const audioInfo = controller.getAudioInfo();

hilog.info(0x0000, TAG,

`字幕组件要求: ${JSON.stringify(audioInfo)}`);

hilog.info(0x0000, TAG, '字幕控制器注册成功');

}

/**

* 启用字幕功能

*/

public enable() {

this.isEnabled = true;

this.audioBufferQueue = [];

this.errorCount = 0;

hilog.info(0x0000, TAG, 'AI字幕已启用');

}

/**

* 禁用字幕功能

*/

public disable() {

this.isEnabled = false;

this.audioBufferQueue = [];

hilog.info(0x0000, TAG, 'AI字幕已禁用');

}

/**

* 获取启用状态

*/

public getEnabled(): boolean {

return this.isEnabled;

}

/**

* 处理音频数据 - 核心方法

* 从AudioRenderer的writeData回调中调用

*/

public processAudioData(buffer: ArrayBuffer) {

if (!this.isEnabled || !this.captionController) {

return;

}

try {

// 复制buffer(避免被覆盖)

const bufferCopy = buffer.slice(0);

this.audioBufferQueue.push(bufferCopy);

// 批量处理(减少性能开销)

if (this.audioBufferQueue.length >= this.BATCH_SIZE) {

this.processCaptionBuffers();

}

// 成功后重置错误计数

this.errorCount = 0;

// 定期清理内存

const now = Date.now();

if (now - this.lastCleanupTime > this.CLEANUP_INTERVAL) {

this.cleanup();

this.lastCleanupTime = now;

}

} catch (error) {

this.handleError(error as Error);

}

}

/**

* 批量处理字幕数据

*/

private processCaptionBuffers() {

if (this.audioBufferQueue.length === 0 || !this.captionController) {

return;

}

try {

// 合并所有buffer

const totalLength = this.audioBufferQueue.reduce(

(sum, buf) => sum + buf.byteLength, 0

);

const mergedBuffer = new ArrayBuffer(totalLength);

const mergedView = new Uint8Array(mergedBuffer);

let offset = 0;

for (const buf of this.audioBufferQueue) {

mergedView.set(new Uint8Array(buf), offset);

offset += buf.byteLength;

}

// 格式转换:48kHz双声道 → 16kHz单声道

const resampledData = AudioResampler.resample48kTo16k(mergedBuffer);

if (resampledData.length === 0) {

hilog.error(0x0000, TAG, '重采样失败,数据长度为0');

return;

}

// 分割为640字节的块

const chunks = AudioResampler.splitToChunks(resampledData, 640);

// 发送给字幕组件

for (const chunk of chunks) {

if (!AudioResampler.isValidChunkSize(chunk.length)) {

hilog.warn(0x0000, TAG, `数据块大小不符合要求: ${chunk.length}`);

continue;

}

const audioData: AudioData = { data: chunk };

this.captionController!.writeAudio(audioData);

}

// 清空队列

this.audioBufferQueue = [];

} catch (error) {

hilog.error(0x0000, TAG, `字幕处理失败: ${(error as Error).message}`);

this.audioBufferQueue = [];

}

}

/**

* 错误处理

*/

private handleError(error: Error) {

this.errorCount++;

hilog.error(0x0000, TAG,

`处理音频数据失败 (${this.errorCount}/${this.MAX_ERROR_COUNT}): ${error.message}`);

// 错误次数过多,自动禁用字幕功能

if (this.errorCount >= this.MAX_ERROR_COUNT) {

this.disable();

AppStorage.setOrCreate('showAICaption', false);

AppStorage.setOrCreate('captionError', '字幕功能异常,已自动关闭');

hilog.error(0x0000, TAG, 'AI字幕因错误过多已自动禁用');

}

}

/**

* 内存清理

*/

private cleanup() {

this.audioBufferQueue = [];

hilog.info(0x0000, TAG, '内存清理完成');

}

/**

* 重置桥接器状态

*/

public reset() {

this.audioBufferQueue = [];

this.errorCount = 0;

this.lastCleanupTime = 0;

hilog.info(0x0000, TAG, '桥接器已重置');

}

}关键设计说明:

- 单例模式:确保全局只有一个桥接器实例

- 批量处理:每5个buffer合并处理一次,减少调用频率

- 错误处理:错误次数过多自动禁用,避免影响播放

- 内存管理:定期清理缓冲区,防止内存泄漏

2.3 修改AudioRendererController

修改 MediaService/src/main/ets/utils/AudioRendererController.ets:

typescript

// 在文件顶部添加导入

import { AudioCaptionBridge } from '../../../entry/src/main/ets/common/utils/AudioCaptionBridge';

export class AudioRendererController {

// ... 现有属性

private setWriteDataCallback() {

if (!this.audioRenderer) {

Logger.error(TAG, 'writeData fail.audioRenderer is undefined');

return;

}

let secondBufferWalk = SECOND_BUFFER_WALK;

let bufferWalk = 0;

let options: Options | undefined = undefined;

this.audioRenderer.on('writeData', (buffer) => {

if (!this.songRawFileDescriptor) {

return;

}

options = {

offset: this.currentOffset,

length: buffer.byteLength

};

// 读取音频数据

fileIo.readSync(this.songRawFileDescriptor.fd, buffer, options);

// ========== 新增:将音频数据发送到AI字幕组件 ==========

try {

AudioCaptionBridge.getInstance().processAudioData(buffer);

} catch (error) {

Logger.error(TAG, `字幕处理失败: ${error}`);

}

// ====================================================

this.currentOffset += buffer.byteLength;

this.bufferRead = this.currentOffset - this.initOffset;

bufferWalk += buffer.byteLength;

// 更新播放进度

if (this.bufferRead <= this.bufferNeedRead) {

if (bufferWalk >= secondBufferWalk) {

let curMs = MediaTools.getMsFromByteLength(this.bufferRead);

this.seek(curMs);

bufferWalk = 0;

}

} else {

bufferWalk = 0;

let curMs = MediaTools.getMsFromByteLength(this.songRawFileDescriptor.length);

this.seek(curMs);

this.playNext();

}

});

}

// 在播放开始时启用字幕

public async start() {

if (this.audioRenderer) {

try {

await this.audioRenderer.start();

this.updateIsPlay(true);

BackgroundUtil.startContinuousTask(this.context);

// 启用AI字幕

AudioCaptionBridge.getInstance().enable();

Logger.info(TAG, 'start success');

} catch (e) {

Logger.error(TAG, `start failed`);

}

}

}

// 在暂停时禁用字幕

public async pause() {

if (this.audioRenderer) {

try {

await this.audioRenderer.pause();

this.updateIsPlay(false);

// 禁用AI字幕

AudioCaptionBridge.getInstance().disable();

Logger.info(TAG, 'pause success');

} catch (e) {

Logger.error(TAG, `pause failed`);

}

}

}

// 在停止时重置字幕

public async stop() {

if (this.audioRenderer) {

try {

await this.audioRenderer.stop();

this.curMs = 0;

this.updateIsPlay(false);

this.audioRenderer.flush();

// 禁用并重置AI字幕

AudioCaptionBridge.getInstance().disable();

AudioCaptionBridge.getInstance().reset();

AppStorage.setOrCreate('currentTime', "00:00");

AppStorage.setOrCreate('progress', 0);

Logger.info(TAG, 'stop success');

} catch (e) {

Logger.error(TAG, `stop failed`);

}

}

}

}3 调试技巧

3.1 验证音频格式

typescript

// 在组件初始化时验证

aboutToAppear() {

const audioInfo = this.controller.getAudioInfo();

hilog.info(0x0000, TAG, `字幕组件要求: ${JSON.stringify(audioInfo)}`);

// 输出: {audioType:"pcm", sampleRate:16000, soundChannel:1, sampleBit:16}

}3.2 监控数据包大小

typescript

// 在AudioCaptionBridge中添加

private processCaptionBuffers() {

// ... 处理逻辑

for (const chunk of chunks) {

hilog.info(0x0000, TAG, `发送数据包: ${chunk.length} 字节`);

if (!AudioResampler.isValidChunkSize(chunk.length)) {

hilog.error(0x0000, TAG, `❌ 数据包大小错误: ${chunk.length}`);

}

this.captionController!.writeAudio({ data: chunk });

}

}3.3 使用DevEco Studio调试工具

-

HiLog查看器:

bash# 过滤AI字幕相关日志 hdc shell hilog | grep "AICaptionArea\|AudioCaptionBridge\|AudioResampler" -

Profiler工具:

- 监控CPU和内存使用

- 查看方法调用耗时

- 分析内存分配

-

断点调试:

- 在

processAudioData设置断点 - 检查buffer内容

- 验证数据流向

- 在

4 常见问题排查

问题1:字幕不显示

排查步骤:

typescript

// 1. 检查控制器是否注册

hilog.info(0x0000, TAG,

`Controller registered: ${AudioCaptionBridge.getInstance().captionController !== undefined}`);

// 2. 检查音频数据是否到达

hilog.info(0x0000, TAG, `Audio data received: ${buffer.byteLength} bytes`);可能原因:

- 控制器未正确注册(方案B)

- 音频格式不支持

问题2:字幕延迟严重

优化方案:

typescript

// 1. 减小批处理大小

private readonly BATCH_SIZE = 3; // 从5减小到3

// 2. 使用更小的数据块

const chunks = AudioResampler.splitToChunks(resampledData, 640);

// 3. 减少处理时间

// 考虑使用Worker线程进行重采样问题3:内存持续增长

解决方案:

typescript

// 1. 确保定期清理

private readonly CLEANUP_INTERVAL = 10000; // 改为10秒

// 2. 限制队列大小

if (this.audioBufferQueue.length > 10) {

this.audioBufferQueue.shift(); // 移除最旧的

}

// 3. 在停止时清理

public disable() {

this.isEnabled = false;

this.audioBufferQueue = []; // 清空队列

}问题4:错误码401(参数错误)

原因:数据包大小不是640或1280字节

解决方案:

typescript

// 验证数据包大小

for (const chunk of chunks) {

if (chunk.length !== 640 && chunk.length !== 1280) {

hilog.error(0x0000, TAG, `数据包大小错误: ${chunk.length}`);

// 填充或截断到正确大小

const validChunk = new Uint8Array(640);

validChunk.set(chunk.slice(0, Math.min(640, chunk.length)));

this.captionController!.writeAudio({ data: validChunk });

} else {

this.captionController!.writeAudio({ data: chunk });

}

}三:Speech Kit 性能优化

3.1 使用Worker线程处理重采样

创建文件:entry/src/main/ets/workers/AudioResampleWorker.ts

typescript

import { AudioResampler } from '../common/utils/AudioResampler';

import worker, { MessageEvents, ErrorEvent } from '@ohos.worker';

const workerPort = worker.workerPort;

// 监听主线程消息

workerPort.onmessage = (e: MessageEvents) => {

const { buffer } = e.data;

try {

// 在Worker线程中进行重采样

const resampledData = AudioResampler.resample48kTo16k(buffer);

const chunks = AudioResampler.splitToChunks(resampledData);

// 返回结果

workerPort.postMessage({ chunks });

} catch (error) {

workerPort.postMessage({ error: (error as Error).message });

}

};

workerPort.onerror = (e: ErrorEvent) => {

console.error(`Worker error: ${e.message}`);

};在 AudioCaptionBridge 中使用Worker:

typescript

import worker, { MessageEvents } from '@ohos.worker';

export class AudioCaptionBridge {

private resampleWorker?: worker.ThreadWorker;

private constructor() {

// 创建Worker

try {

this.resampleWorker = new worker.ThreadWorker(

'entry/ets/workers/AudioResampleWorker.ts'

);

this.resampleWorker.onmessage = (e: MessageEvents) => {

const { chunks, error } = e.data;

if (error) {

hilog.error(0x0000, TAG, `Worker错误: ${error}`);

return;

}

// 发送给字幕组件

for (const chunk of chunks) {

this.captionController!.writeAudio({ data: chunk });

}

};

hilog.info(0x0000, TAG, 'Worker创建成功');

} catch (error) {

hilog.error(0x0000, TAG, `Worker创建失败: ${error}`);

}

}

private processCaptionBuffers() {

if (!this.resampleWorker) {

// 降级到主线程处理

this.processCaptionBuffersSync();

return;

}

// 合并buffer

const totalLength = this.audioBufferQueue.reduce(

(sum, buf) => sum + buf.byteLength, 0

);

const mergedBuffer = new ArrayBuffer(totalLength);

const mergedView = new Uint8Array(mergedBuffer);

let offset = 0;

for (const buf of this.audioBufferQueue) {

mergedView.set(new Uint8Array(buf), offset);

offset += buf.byteLength;

}

// 发送到Worker处理

this.resampleWorker.postMessage({ buffer: mergedBuffer });

this.audioBufferQueue = [];

}

// 同步处理(降级方案)

private processCaptionBuffersSync() {

// ... 原有的同步处理逻辑

}

}3.2 动态调整批处理大小

typescript

export class AudioCaptionBridge {

private adaptiveBatchSize: number = 5;

private lastProcessTime: number = 0;

private processCaptionBuffers() {

const startTime = Date.now();

// 处理逻辑...

const processTime = Date.now() - startTime;

// 动态调整批处理大小

if (processTime > 50) {

// 处理时间过长,增加批处理大小

this.adaptiveBatchSize = Math.min(10, this.adaptiveBatchSize + 1);

hilog.info(0x0000, TAG, `增加批处理大小: ${this.adaptiveBatchSize}`);

} else if (processTime < 20) {

// 处理时间很短,减小批处理大小

this.adaptiveBatchSize = Math.max(3, this.adaptiveBatchSize - 1);

hilog.info(0x0000, TAG, `减小批处理大小: ${this.adaptiveBatchSize}`);

}

this.lastProcessTime = processTime;

}

public processAudioData(buffer: ArrayBuffer) {

// ...

// 使用动态批处理大小

if (this.audioBufferQueue.length >= this.adaptiveBatchSize) {

this.processCaptionBuffers();

}

}

}3.3 内存池优化

typescript

export class AudioCaptionBridge {

// 对象池

private bufferPool: Uint8Array[] = [];

private readonly POOL_SIZE = 10;

// 从池中获取buffer

private getBufferFromPool(size: number): Uint8Array {

if (this.bufferPool.length > 0) {

const buffer = this.bufferPool.pop()!;

if (buffer.length === size) {

return buffer;

}

}

return new Uint8Array(size);

}

// 归还buffer到池

private returnBufferToPool(buffer: Uint8Array) {

if (this.bufferPool.length < this.POOL_SIZE) {

this.bufferPool.push(buffer);

}

}

private processCaptionBuffers() {

// 使用对象池

const chunks = AudioResampler.splitToChunks(resampledData, 640);

for (const chunk of chunks) {

const pooledChunk = this.getBufferFromPool(640);

pooledChunk.set(chunk);

this.captionController!.writeAudio({ data: pooledChunk });

// 使用后归还

this.returnBufferToPool(pooledChunk);

}

}

}总结

通过本篇深度探索,我们不仅实现了AI字幕的功能集成,更掌握了HarmonyOS音频数据处理的过程。从底层原理到性能优化,从格式转换到架构设计,我们一同构建了一个高效、稳定的音频处理流水线。

技术的价值在于解决真实问题------你已经拥有了在HarmonyOS生态中构建智能音频应用的核心能力。期待看到你将这些技术应用于更多场景------或许是语言学习工具,或许是智能会议系统,或许是创新的无障碍应用。

代码已备,创意由你。 让我们继续在HarmonyOS的舞台上,用技术创造更多可能!🎵🚀

如果你在实践中有任何问题或新发现,欢迎在评论区分享交流! 👇