如何保障分布式IM聊天系统的消息可靠性(即消息不丢)?

本文主要聚焦分布式IM聊天系统消息可靠性问题,即如何保证消息不丢失。

分布式 IM 消息「不丢、不重、必达」的核心思路,本质是三层兜底 + 严格 ACK + 幂等去重的闭环设计。

一、核心目标(IM 可靠性的本质)

- 消息不丢失:网络闪断、App 被杀、服务宕机、发布重启都不能丢

- 消息不重复:重试 / 重传后,接收方只处理一次

- 最终必达:允许短暂延迟,不允许永久丢失

二、核心痛点(消息丢失的全链路风险点)

- 客户端:网络闪断、进程被杀、重启 → 内存消息直接丢

- 服务端:单机宕机、内存未落盘 → 消息丢失

- 网络层:请求超时、ACK 丢失 → 客户端误以为失败重试,服务端重复处理

- 集群:单点故障、副本不同步 → 数据丢失

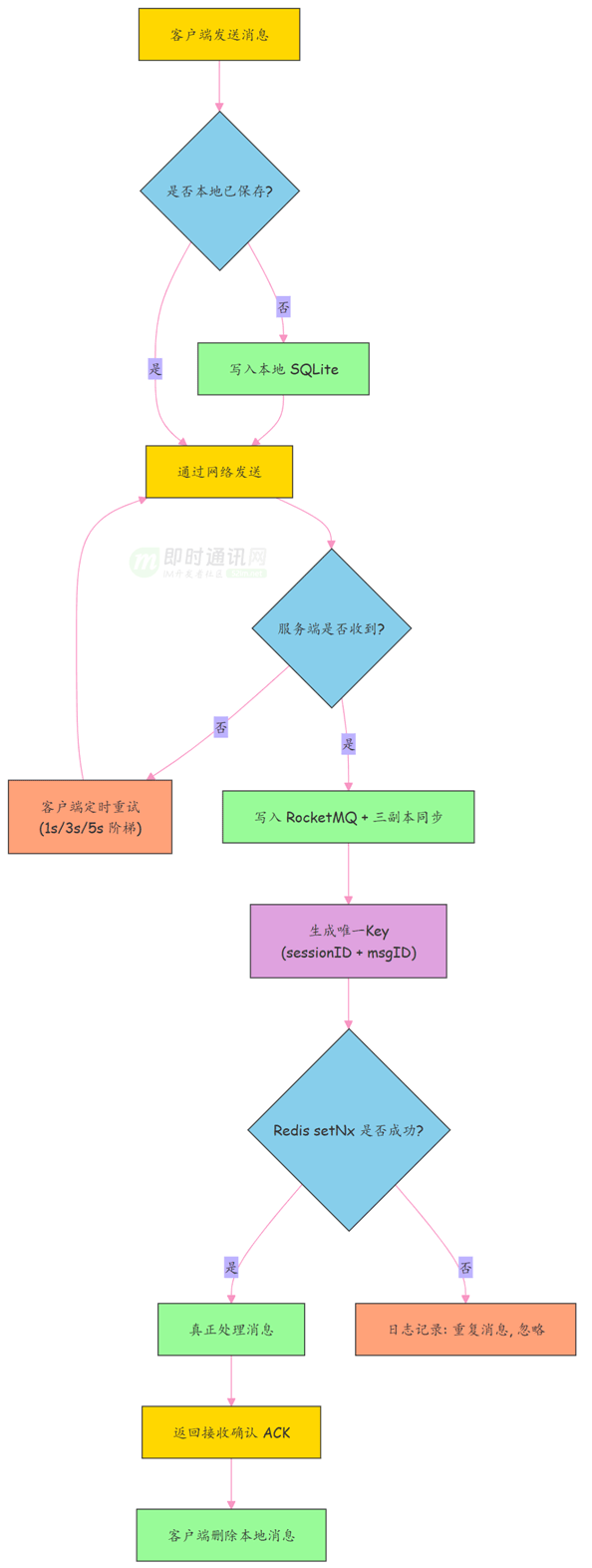

三、三层兜底方案(原文核心,最关键)

第一层:客户端兜底 ------ 本地持久化 + 阶梯重试(解决「发不出就丢」)

核心原则

未收到服务端 ACK = 发送未成功,绝不删除本地消息

落地步骤

- 先发本地库,再发网络消息先写入 SQLite/Realm 本地库,标记「待发送」,再请求服务端。

- 阶梯式重试,防雪崩 失败后按

1s → 3s → 5s → 10s...指数退避,避免密集重试压垮服务。 - ACK 驱动状态变更 只有收到服务端明确成功 ACK,才将本地消息标记为「已发送」;App 崩溃 / 重启后,从本地库读取「待发送」自动续发。

关键代码逻辑(伪代码)

// 1. 先本地持久化(保命)

db.saveLocalMsg(msg, status=PENDING);

// 2. 网络发送

boolean sendOk = network.send(msg);

// 3. 失败则重试,成功等ACK

if (!sendOk) {

scheduleRetryWithBackoff(msg); // 阶梯重试

}

// 4. 收到ACK后更新状态

onReceiveAck(ackMsgId) {

db.updateMsgStatus(ackMsgId, SENT);

}第二层:服务端兜底 ------ 先持久化 + 多副本,再回 ACK(解决「服务端丢」)

核心原则

服务端必须先落盘、同步副本,再返回 ACK;禁止「虚假 ACK」

落地步骤

- 消息先入可靠 MQ(刷盘 + 集群) 使用 RocketMQ/Kafka,开启同步刷盘 + 主从同步,确保断电不丢。

- **多副本同步(≥3 副本)**消息同步到多数副本后,才算「服务端已可靠持有」。

- ACK 时序绝对不能乱落盘 & 副本同步 → 处理业务 → 返回 ACK;任何前置步骤失败,直接返回失败,不回成功 ACK。

伪代码

// 1. MQ同步落盘(必须成功)

mq.syncSendAndFlush(msg);

// 2. 多副本同步(多数派确认)

replicaManager.syncToReplicas(msg, quorum=3);

// 3. 上述都成功,才回ACK

response.sendAck(msg.getUniqueId());第三层:幂等防重 ------ 全局唯一 ID + 原子去重(解决「重试导致重复」)

核心原则

重试是可靠性的必要手段,但必须保证「处理一次且仅一次」

落地步骤

- 全局唯一消息 ID 生成规则:

clientId + sessionId + seqId/ UUID,全局唯一。 - Redis 原子去重(SetNx) 利用

SETNX原子性,多实例并发下也不会重复处理。 - 过期时间兜底去重 key 设置过期(如 24h),避免 Redis 无限膨胀。

伪代码

String uniqueKey = msg.getUniqueId();

// 原子判断:不存在则处理,存在则跳过

if (redis.setNX(uniqueKey, "processed", 86400)) {

processAndPushMsg(msg); // 正常投递

} else {

log.warn("重复消息,忽略: {}", uniqueKey);

}四、全链路可靠投递闭环(IM 核心流程)

- 客户端生成唯一 ID → 本地落库 → 发送

- 服务端收消息 → MQ 刷盘 + 多副本同步 → 回 ACK

- 客户端收 ACK → 更新本地状态

- 网络 / 服务异常 → 客户端重试

- 重复消息到达 → 服务端幂等拦截 → 不重复投递

- 接收方在线 → 实时推送;不在线 → 存入离线库 → 上线拉取

五、IM 场景必补的关键增强

- 离线消息存储接收方不在线时,消息存入 DB/Redis 离线库,上线后拉取,避免「发成功但对方收不到」。

- 分层回执机制

- 已发送(客户端→服务端 ACK)

- 已送达(服务端→接收方 ACK)

- 已读(接收方用户查看回执)

- 消息双写保障MQ 异步 + 业务 DB 同步,防止 MQ 丢失后仍可从 DB 回溯。

- 消息回溯 / 补推客户端上线后主动拉取「未读 / 未送达」消息,兜底网络丢包。

- 集群高可用无状态服务 + 注册中心 + 故障转移,避免单点不可用。

**整条链路形成闭环:**任何环节出问题,都有对应兜底机制接管。

六、极简总结

分布式 IM 消息不丢 =客户端本地持久化 + 阶梯重试 +服务端先落盘多副本再 ACK +全局唯一 ID + 幂等去重 +离线存储 + 分层回执兜底

核心铁律:任何环节,没拿到可靠确认,就当没完成;重试必须幂等。