什么是大模型

大模型(Large Language Model,LLM)本质上是一个数学模型,核心就是通过海量的数据,基于深度学习训练出来的一个"具有思考能力的"知识大脑。可以理解和生成人类语言,具备一定的推理和创作能力。

优点

理解人类语言+具备思考能力=解放人类的一些简单性的、可替代的工作。

缺点

理解人类意图却无法主动发起事件的触发,换句话说大模型(后续以LLM简称)只能在海量数据训练的基础上进行检索思考总结,并无法执行一些动作。

什么是Agent

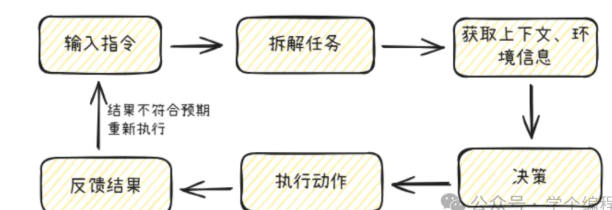

因为LLM不具备执行的能力,所以在LLM的加持下,配合着上下文记忆、工具以及方法(本地/远端)调用,任务规划等等动作,形成一台完整的可闭环的执行链,并且在这个闭环中可以有Agent自行决策也可以加入人类的决策。

agent执行过程:

一个简单的Agent的创建过程,实例代码用python+langchain.

python

from langchain.agents import create_agent

from langchain_openai import ChatOpenAI

import dotenv

#加载配置文件

dotenv.load_dotenv()

llm = ChatOpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

model='qwen3-max',

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

temperature=0.9

)

agent = create_agent(

model=llm

)

agent.invoke({"messages": [{"role": "user", "content": "你是谁"}]})因为LLM是基于一定的数据训练的,所以数据具有一定的时效性,并且对于人类的多变的需求也无法单独靠LLM就可以搞定,所以Agent的可扩展的能力是尤为关键。

记忆能力

LLM是没有记忆能力的,但是在多轮对话的场景下需要记忆能力,以便于更好的分析和给出更加准确的答案。

记忆分为短期记忆(short-term Memory,STM,历史对话等)和长期记忆(long-term Memory,LTM,历史的任务经验等)。

上网能力

LLM的知识是有范围边界的,并且LLM本身没有上网的能力,所以Agent可以结合上网的工具来检索LLM本地知识以外的数据。

本地方法调用/MCP

MCP即Model Context Protocol(模型上下文协议)的缩写,一种AI大模型与外部系统交互的接口协议。比如LLM想查询今天某地的天气预报或者导航信息,LLM自己是无法实现的,可以调用远程的一些服务接口(墨迹天气或者高德地图的接口)来达到目的。这样一来AI大模型也就可以与原先的系统进行很好的融合和接入了。并不会因为引入大模型而摒弃原先的系统。

RAG

RAG 是 Retrieval-Augmented Generation(检索增强生成) 的缩写。如果想搭建某个细小的专业领域的知识库,不希望这部分数据被外界感知,只供内部系统使用,那么则可以搭建一个企业内部RAG知识库,实现数据的隐私性。兵且RAG无需对大模型进行微调,如果数据更新,则只需要对RAG库进行更新即可,在成本方面也是非常友好的。