谁还在被AI"画大饼"?写邮件要自己点发送,列待办要自己去执行,看似智能实则只是 "嘴炮工具",根本落不了地。但 2026 年初这款现象级 AI 产品的出现,彻底改变了这一现状 ------ 它就是被网友亲切称为「那只龙虾」🦞的 OpenClaw ,一款真正能 "动手办事" 的开源 AI 智能体框架。

从Clawdbot到Moltbot,再到如今的OpenClaw,这款开源AI智能体框架在短短一个月内,GitHub星标狂揽1 7 万+ ,朋友圈、开发者社区全是它的身影,TechCrunch、Forbes等外媒争相报道,成为2026年初最现象级的AI产品。有人说它是长了手的Claude,有人直言"用它之后,再也不需要任何独立App了",但狂欢之下,大部分人都卡在了第一步------本地部署,本地部署需设备全天开机、内网穿透复杂且本地算力不足,门槛过高。

今天就给大家解锁OpenClaw的"唯一正确打开方式":依托Lab4AI大模型实验室云端环境快速部署,打造一个24小时永不离线、算力拉满、公网可访问的"数字生命"助手,彻底终结本地部署的所有烦恼!

先搞懂:OpenClaw凭什么爆火?

不同于只会"聊天支招"的普通AI,OpenClaw是一个真正能**"动手办事"的智能体框架**------它就像你的专属数字员工,能听懂自然语言指令,自动完成一系列复杂操作,覆盖工作生活的方方面面:

-

办公减负:自动回复繁琐邮件、整理收件箱,甚至帮你对接客户、生成工作报表;

-

技术赋能:全自动写代码、修Bug、执行Shell命令,哪怕是复杂的多模态任务(识别截图、处理百页PDF)也能轻松搞定;

-

日程管家:精准管理日程、设置定时提醒,凌晨监控论文更新、清晨准时叫你起床都不在话下;

-

全能拓展:支持对接Telegram、飞书、Discord等多平台,还能通过技能插件扩展能力,甚至自己"造工具"完成个性化需求。

更关键的是,它开源免费,数据存储在自己的环境中,隐私安全有保障。

云端部署OpenClaw3大优势

相比门槛重重的本地部署,依托 Lab4AI 大模型实验室进行云端部署,无需折腾硬件、不用配置内网穿透、算力无限续航,几分钟就能拥有一个 24 小时 "在线呼吸" 的数字助理,优势一目了然:

-

7×24h 永在线:云端服务器永不关机。它能在凌晨 3 点为你监控最新的 ArXiv 论文更新,或在早晨 8 点准时通过飞书叫醒你。

-

独占公网环境:无需折腾复杂的内网穿透(DDNS/FRP)。直接稳定对接 Telegram/Discord 或飞书机器人,告别断连焦虑。

-

算力冗余加速:当 OpenClaw 执行重度多模态任务(如识别复杂的论文屏幕截图、处理数百页 PDF)时,云端算力对 Qwen3-VL 的支撑速度,是普通轻薄本无法比拟的。

手把手带你完成云端部署

在Lab4AI大模型实验室项目浮现点击对应项目名称链接,找到页面中的「立即体验」按钮,单击该按钮。

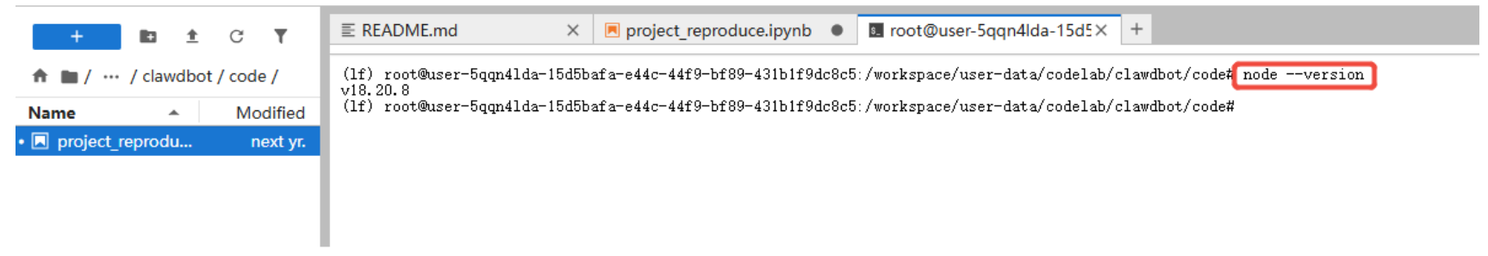

第一步:Node.js 环境安装步骤

OpenClaw 需要 Node.js ≥ 22.12.0。请先检查系统是否已安装:

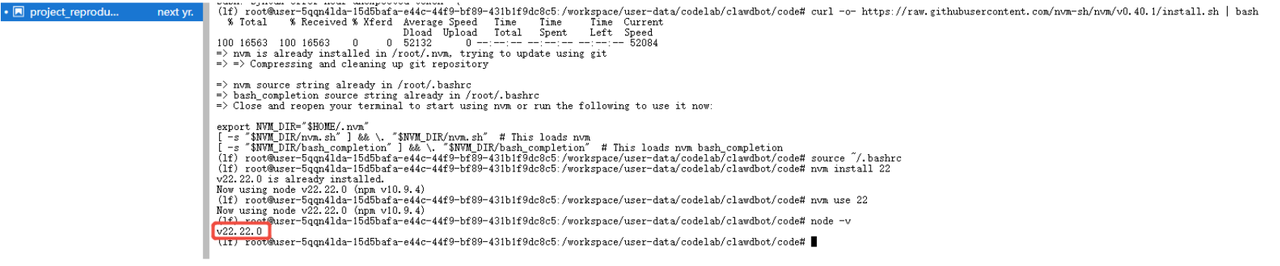

如果版本低于 22.12.0 或未安装,请按照以下命令顺序安装 nvm 并配置 Node.js 22 环境:

# 安装 nvm (Node Version Manager)

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.1/install.sh | bash

# 使配置立即生效

source ~/.bashrc

# 安装并使用 Node 22

nvm install 22

nvm use 22

# 检查版本

node -v # 确保显示 v22.x.x下图为安装成功界面:

第二步:安装 OpenClaw

请根据您的需要选择合适的安装方式:

方法 1:安装脚本(推荐)

这是最快捷的安装方式,会自动处理环境依赖和基础配置。

curl -fsSL https://openclaw.bot/install.sh | bash方法 2:全局 npm 安装

适用于已经配置好 Node.js 22+ 环境的用户,也是 Pod 容器内最常用的方式。

npm install -g openclaw@latest方法 3:从源码安装

如果您需要进行二次开发或自定义插件,请使用此方式。

git clone https://github.com/openclaw/openclaw.git

cd openclaw

pnpm install

pnpm build

openclaw onboard --install-daemon第三步:初始化配置

安装完成后,运行初始化向导:

openclaw onboard --install-daemon向导会引导你完成以下步骤:

-

选择配置文件位置(默认 ~/.openclaw/)

-

设置 Gateway 端口(默认 18789)

-

生成认证 Token

-

安装系统服务(launchd/systemd)

-

配置聊天平台(WhatsApp/Telegram/Discord 等)

Onboard 向导详细步骤

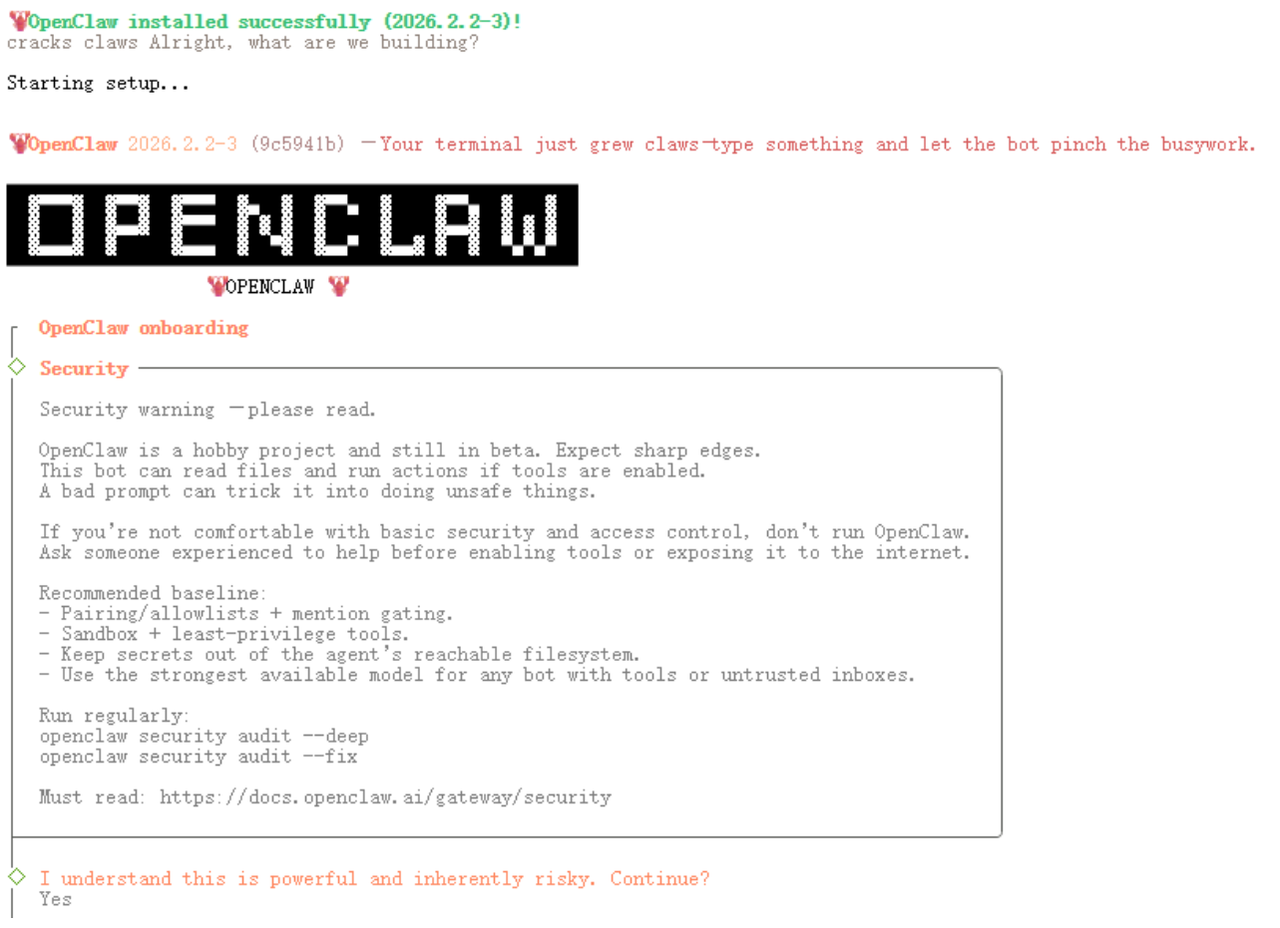

运行 openclaw onboard --install-daemon 后,你会看到类似以下的交互式配置过程:

步骤1:欢迎界面

首先是欢迎界面和安全警告,我们选择 Yes 回车。

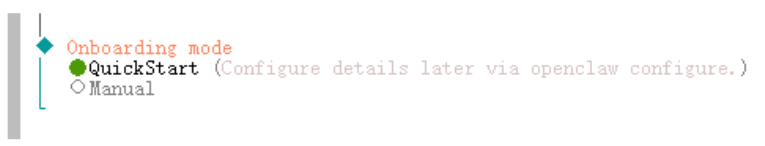

步骤 2:模式选择

选择 QuickStart 回车。

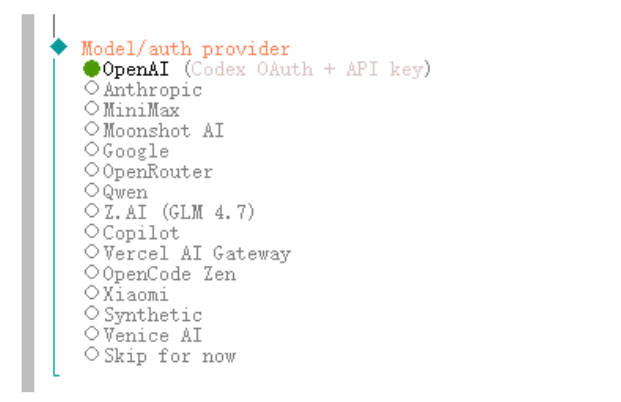

步骤 3:模型选择

建议先选择已有 API Key 的供应商,如果没有你需要的模型供应商,选择 Skip for now 回车跳过,稍后配置。

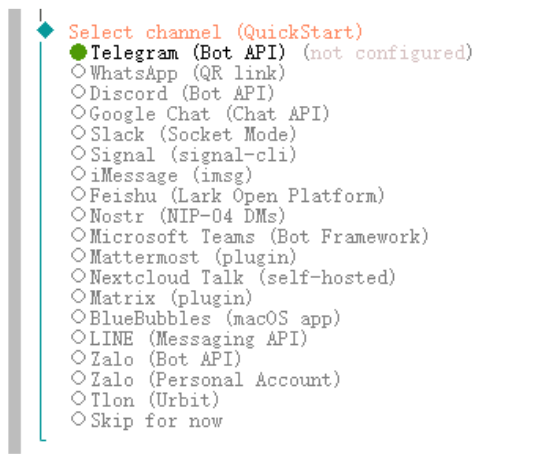

步骤 4:配置消息渠道

同样,可以选择 Skip for now 跳过,稍后配置。

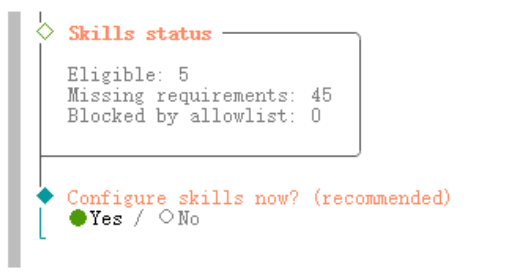

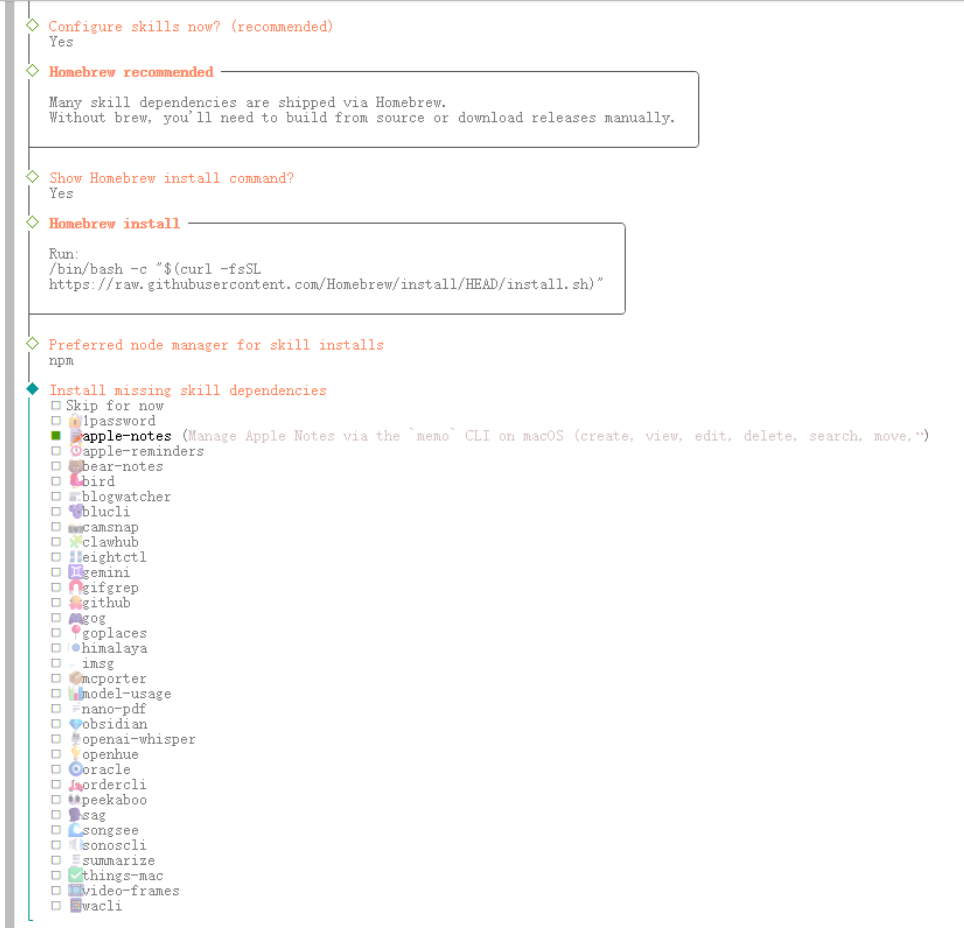

步骤 5:配置 Skills

先任意选择一个,后面我们可以根据自己的需求进行安装。

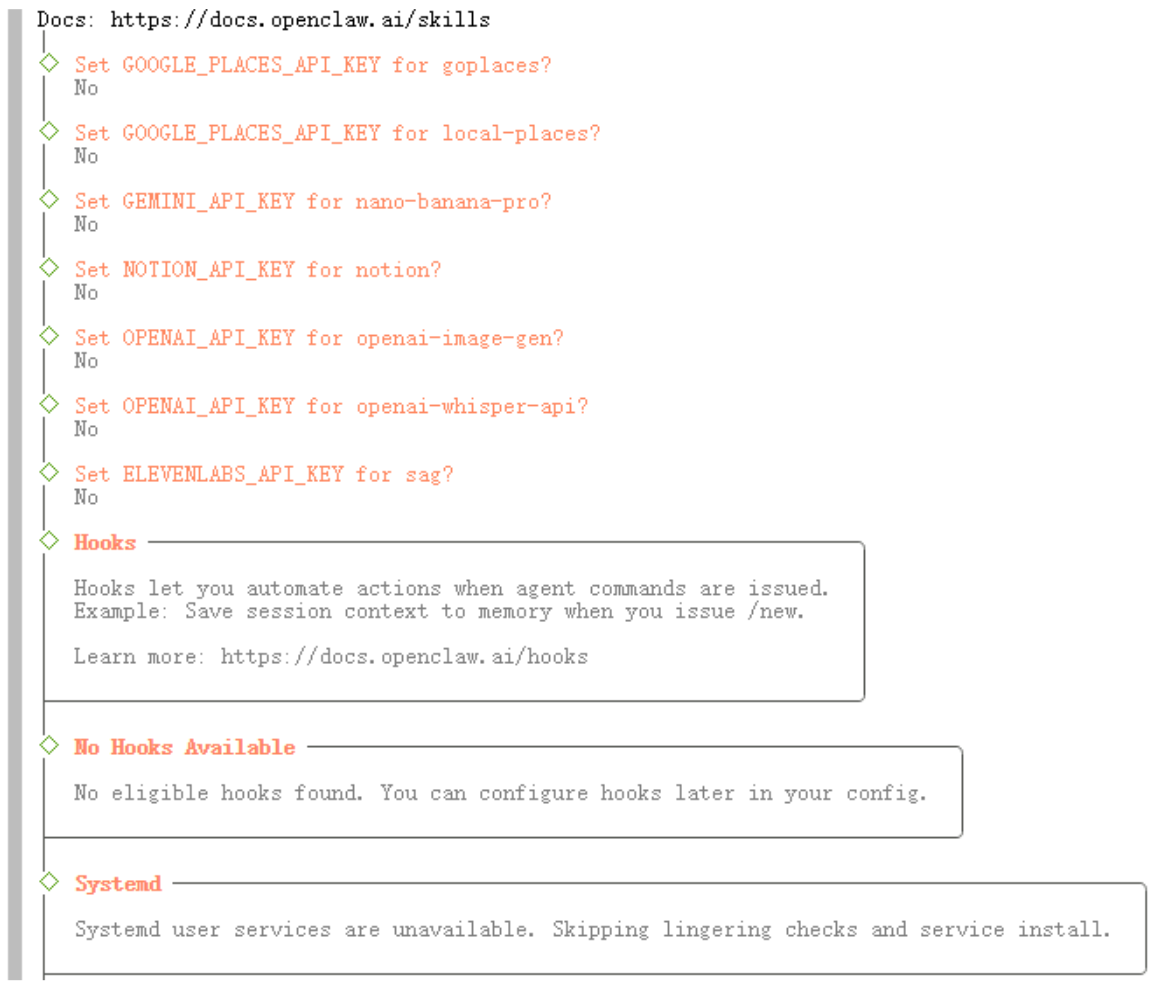

步骤 6:配置各种 Key

提示进行配置各种各样的服务Key,全选 No 回车跳过即可。

步骤 7:安装服务

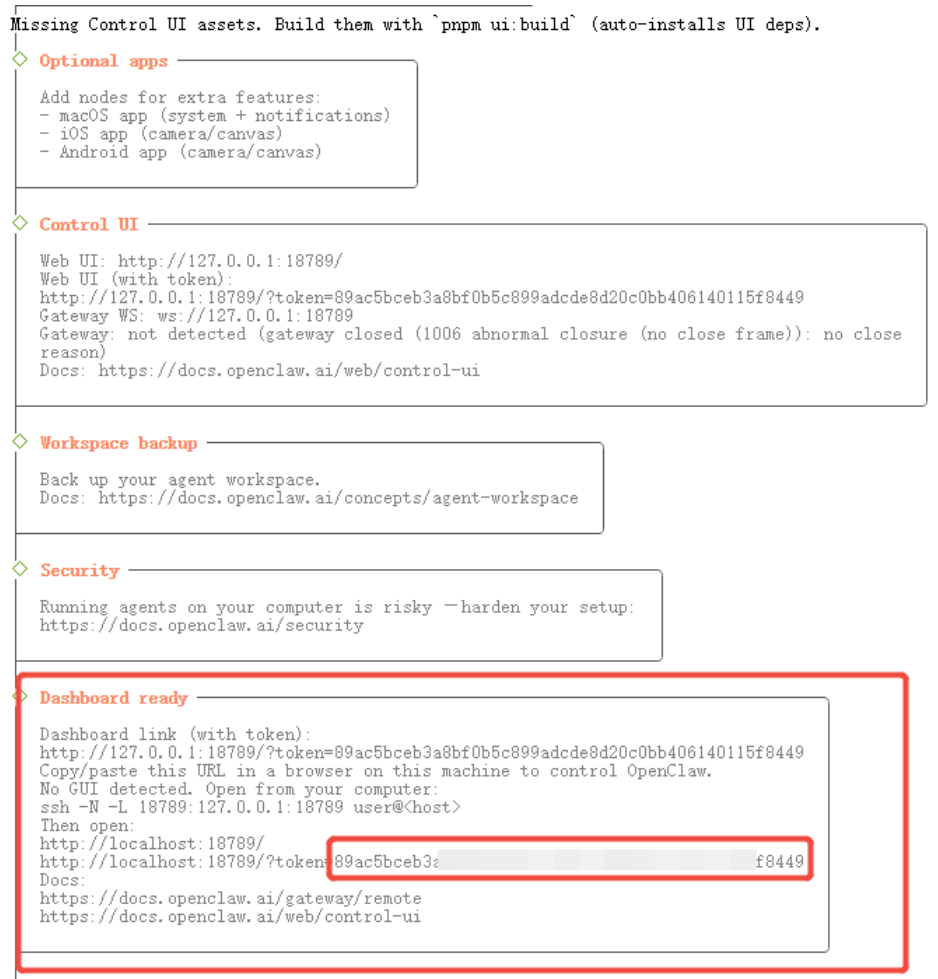

接下来会自动安装服务,安装完成就会给出安装完成的 Gateway 服务信息,包括 Web UI 地址、Gateway WS 地址等。

第四步:启动openclaw

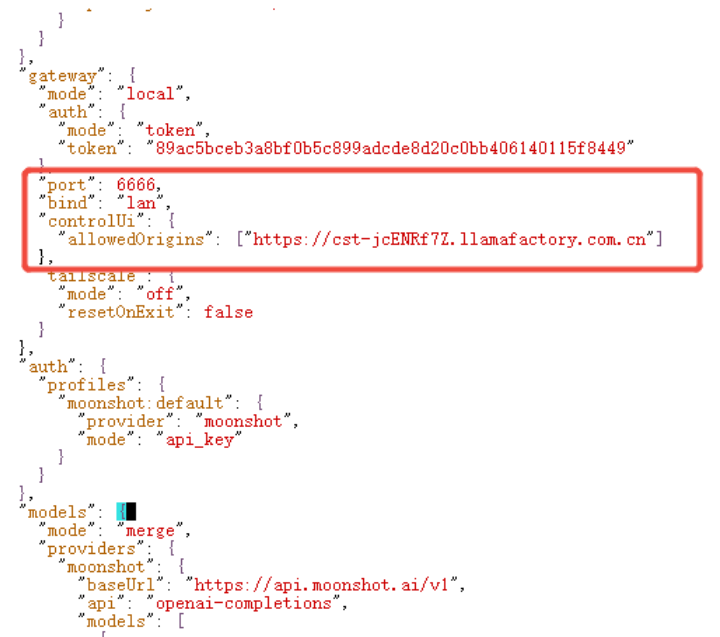

步骤1:修改配置文件

将port 18789 更改为 6666;bind loopback 更改为 lan;

添加云端域名"allowedOrigins": ["https://cst-jcenrf7z.llamafactory.com.cn"] 云端域名见提取对外服务网址。

⚠️重要提示

您在参照本文档进行复现时,需要将"https://cst-jcenrf7z.llamafactory.com.cn"替换为您的实际网关地址。

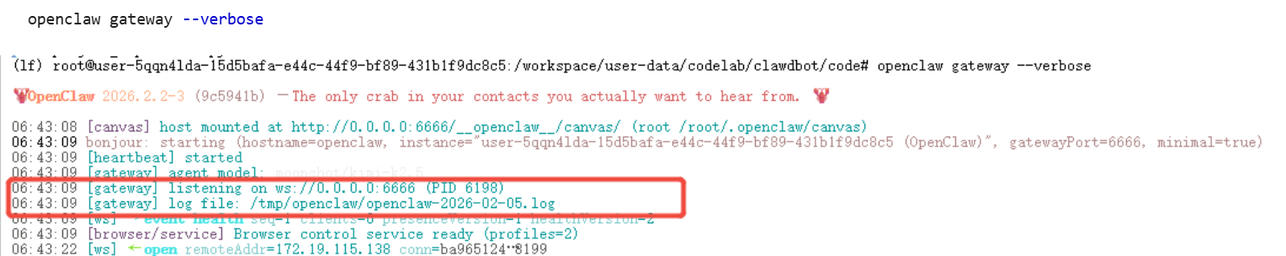

步骤2:启动gateway

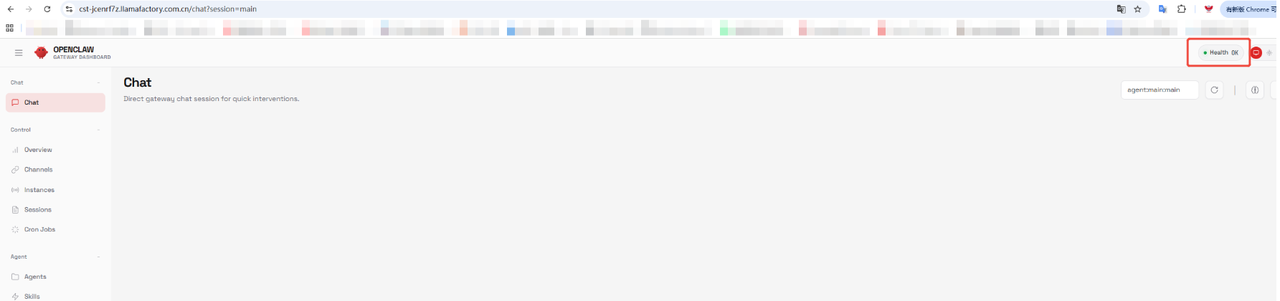

步骤3:web打开

提取token参数:

1、新建一个终端

2、执行

export PATH="/workspace/.nvm/versions/node/v22.22.0/bin:$PATH"3、提取token参数

cat ~/.openclaw/openclaw.json | grep '"token":'将获取的token参数进行拼,并web打开链接,链接结构示例:

https://cst-jcENRf7Z.llamafactory.com.cn?token=89ac5bceb3a8bf0b5c8XXXXXXXXXX406140115f8449

至此,OpenClaw云端部署已全部完成。

至此,OpenClaw云端部署已全部完成。

依托Lab4AI大模型实验室的云端环境,我们彻底摆脱了本地部署的诸多困扰,无需纠结硬件配置、不用折腾内网穿透,轻松拥有了7×24小时永在线、算力充沛、公网可访问的专属数字助理。

无论是日常办公的繁琐事务,还是复杂的多模态任务都能高效落地,真正实现"随口吩咐,全程代办",让这款被网友喜爱的"龙虾"工具,成为我们工作生活中的得力帮手!