大家好,我是孟健。智谱刚发布了新一代旗舰模型 GLM-5,我第一时间上手测了测,跟大家聊聊真实感受。

先说结论:工程能力已经站到了 Opus 同一梯队,某些场景甚至更舒服。这是我第一次对国产编程模型说出能打两个字。

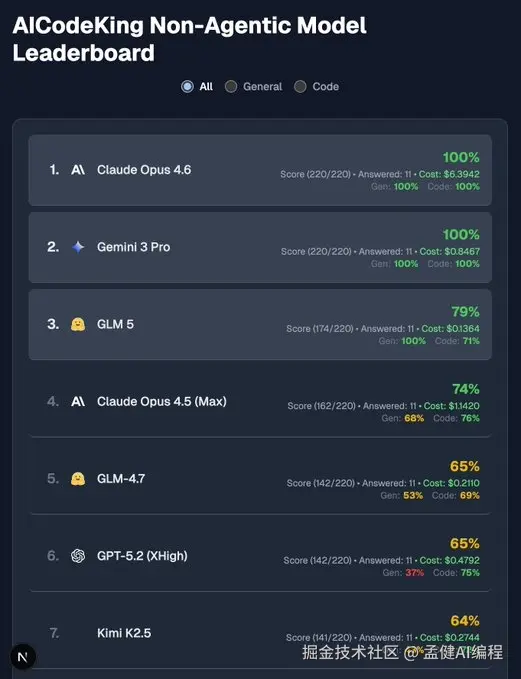

看看评测截图,综合能力已经非常接近 Claude Opus 4.5,部分维度甚至持平。

01 这个模型是什么

GLM-5 是智谱刚发布的新一代旗舰模型。参数规模 744B(激活 40B),预训练数据 28.5T。发布前在海外开发者社区已经引发了不少讨论,不少人评价它的代码能力接近 Claude Opus 4.5。

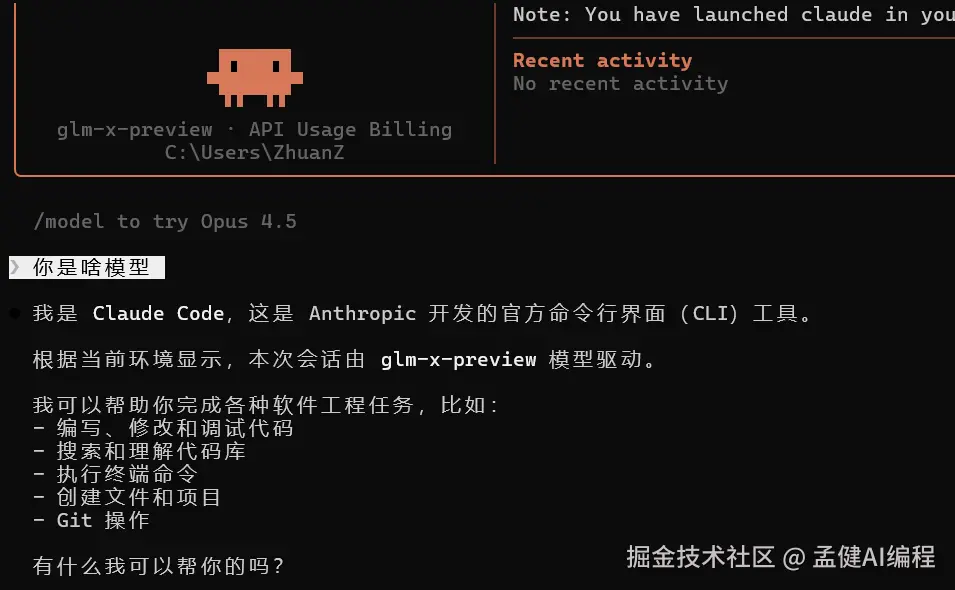

用 Claude Code 接入 GLM-5,直接在熟悉的工作流里测试。

这次的定位很明确------不卷前端炫技,卷后端工程能力。744B 参数(激活 40B),28.5T 预训练数据,代号 Pony Alpha,发布前就在海外开发者圈子里炸了。

我比较好奇的是,它到底能不能在真实开发场景里站住脚。

所以设计了四个测试,从前端到后端到运维,逐个过。

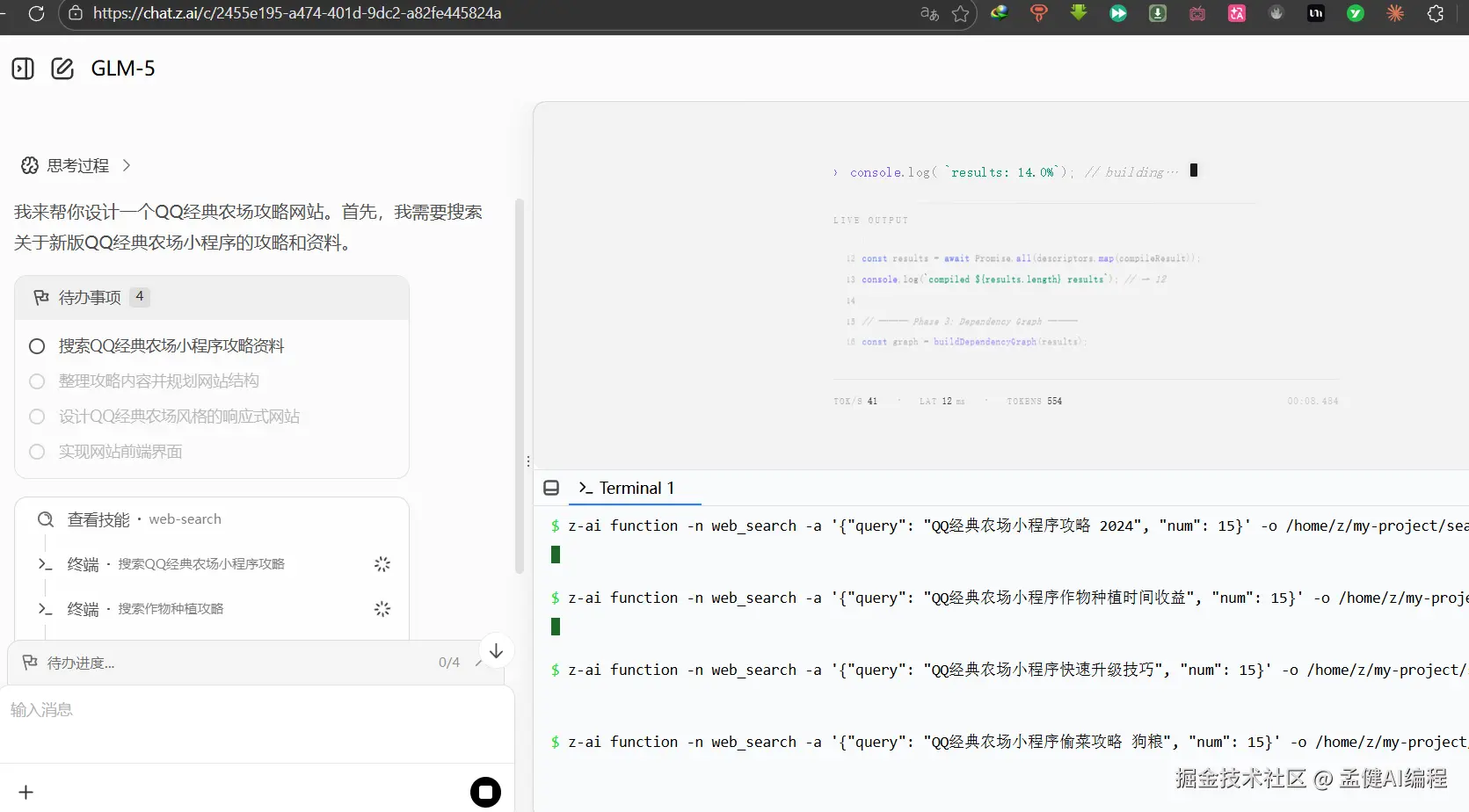

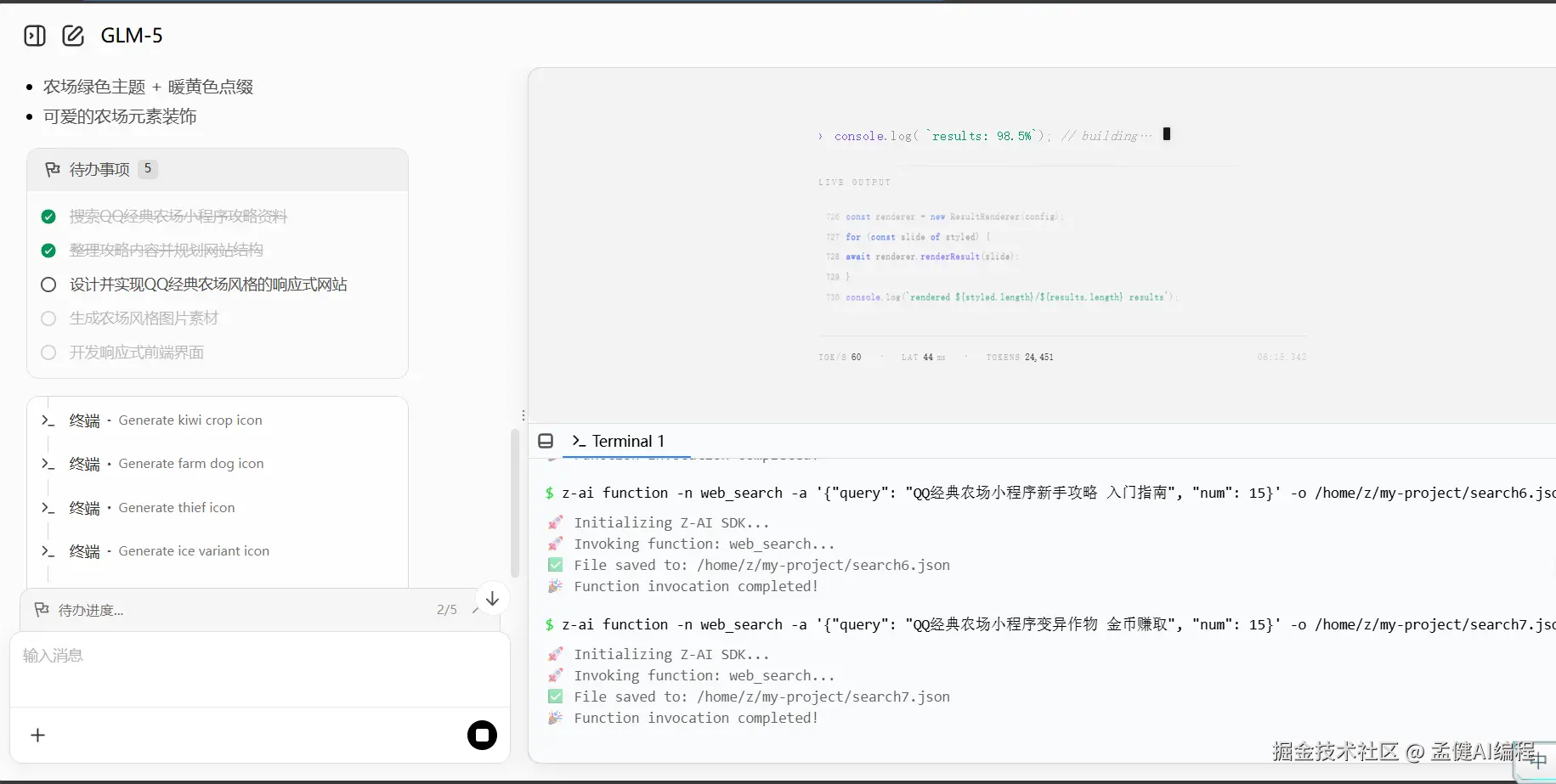

02 测试一: 测试前端 UI 展示

提示词:

帮我设计一个 QQ 经典农场攻略网站,响应式交互。风格也要偏 QQ 经典农场那一款。相关的攻略信息可以去网上调研一下。(我说的是最近新出的 QQ 经典农场,它是小程序的,不是以前的那个网页上面的 QQ 农场。请你去网上搜索新上线的小程序版的 QQ 经典农场的所有攻略和资料)访问 chat.z.ai/

虽然等待时间比 Opus 长一些(推理模型嘛,思考深度换时间),但输出质量让我挺惊喜。

经过 15 分钟,其中还自动修了 2 次 bug,最终效果如上。说实话,比我预期好不少。

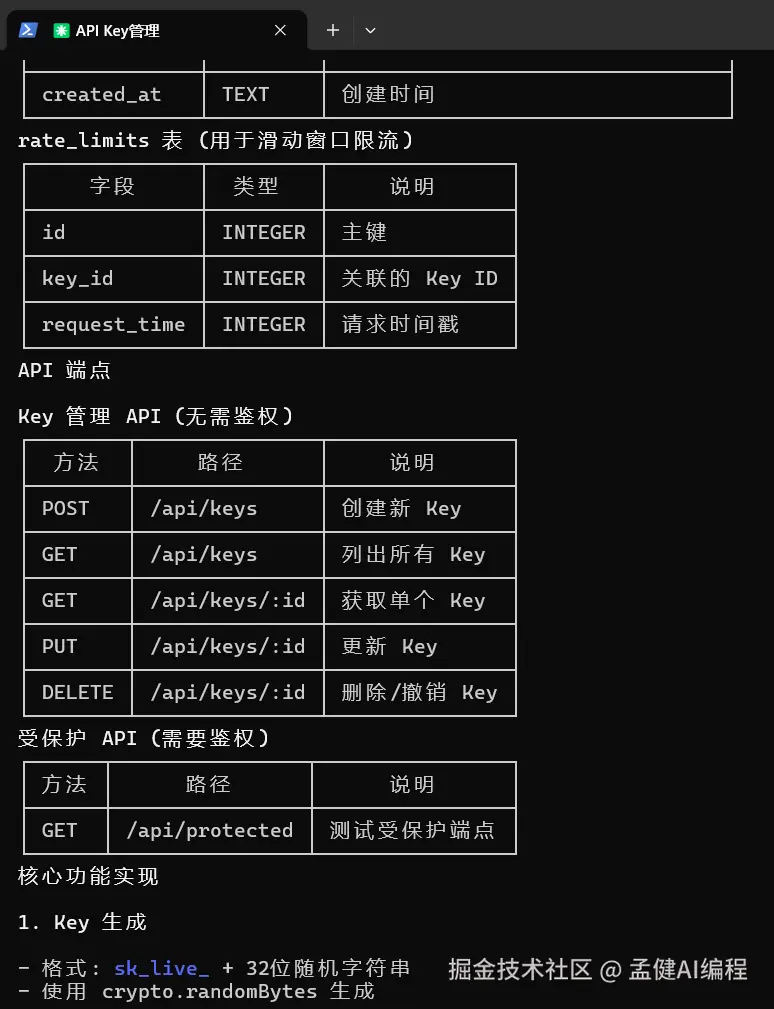

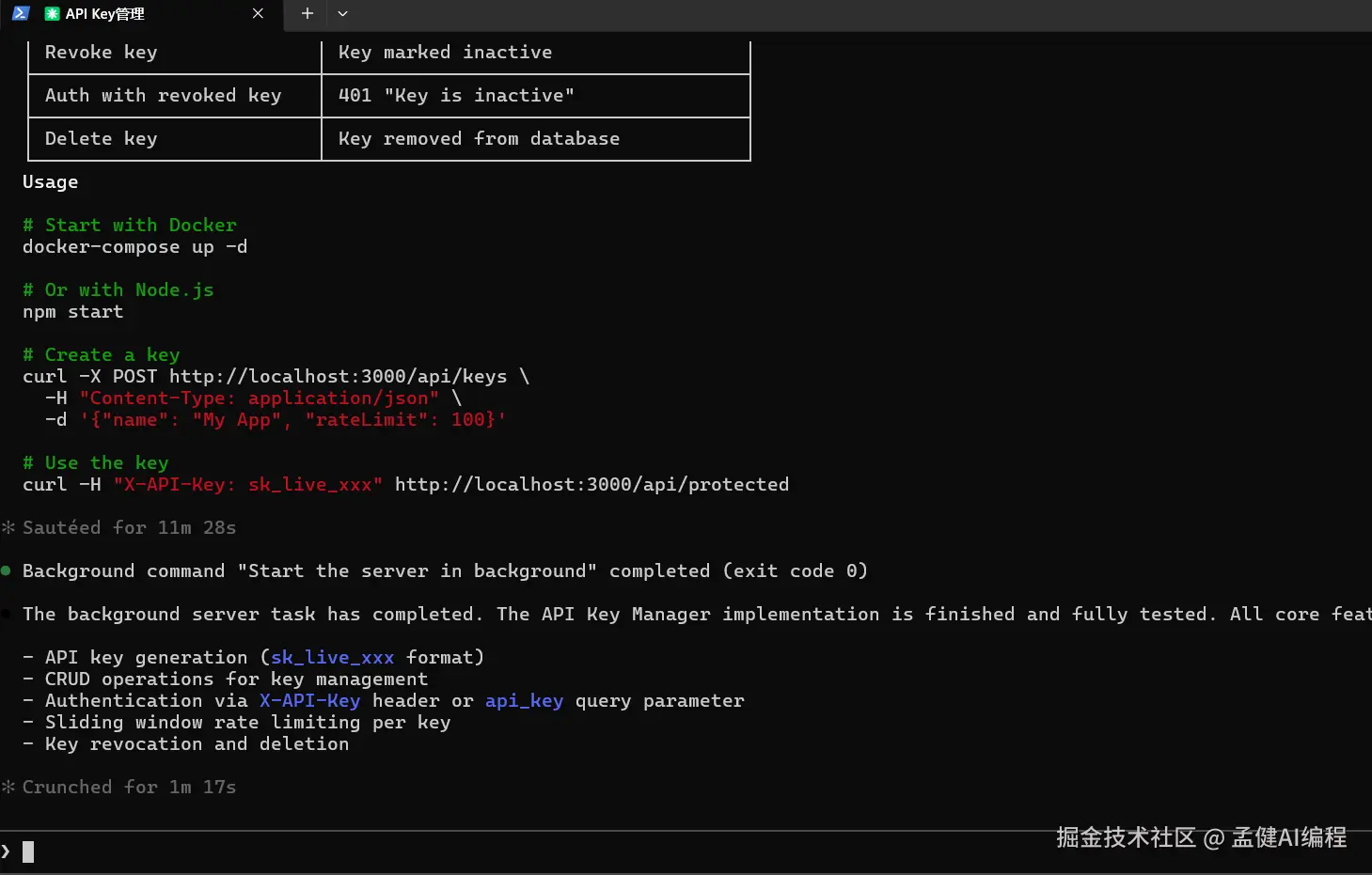

0 3 测试 二 :从零搭后端系统

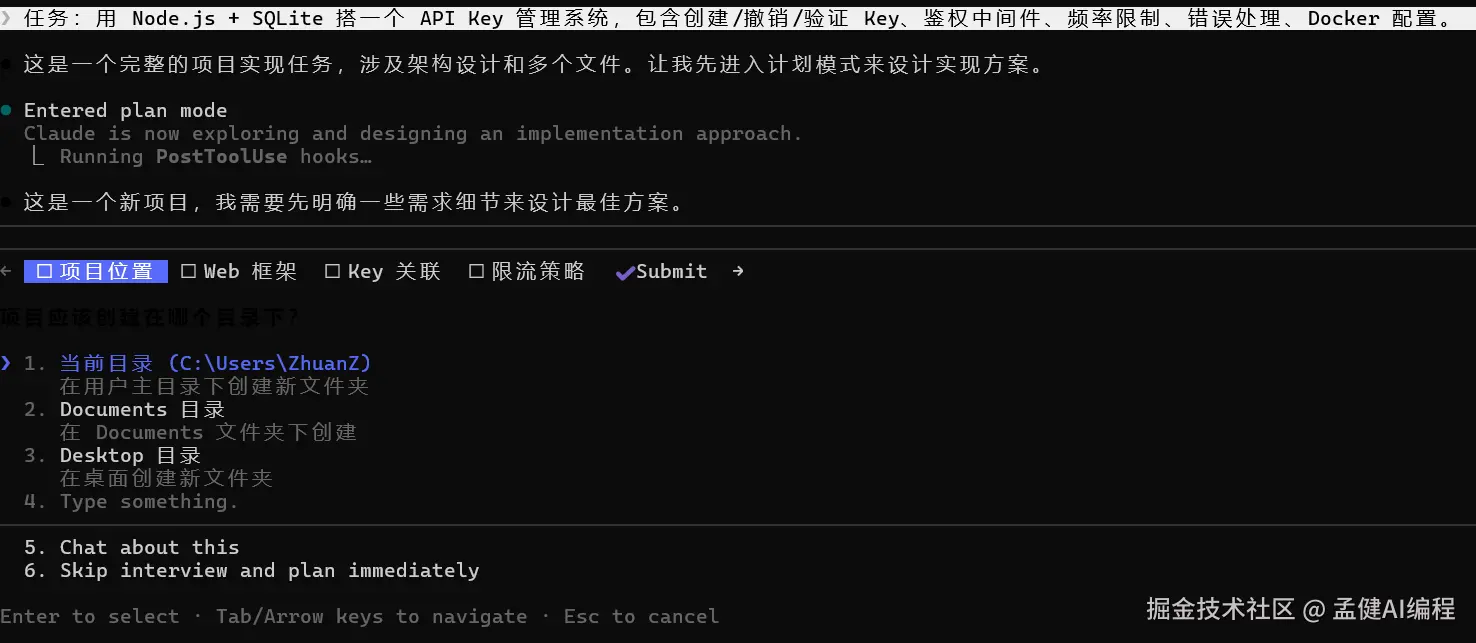

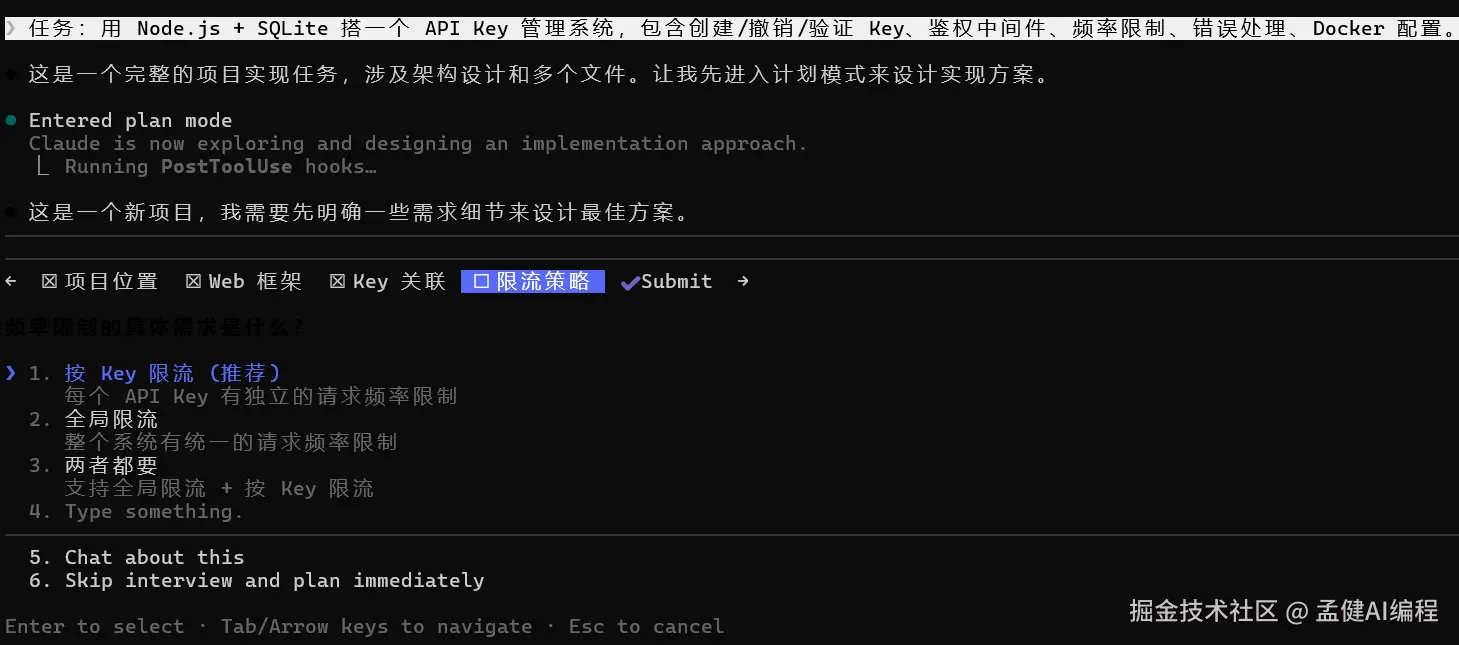

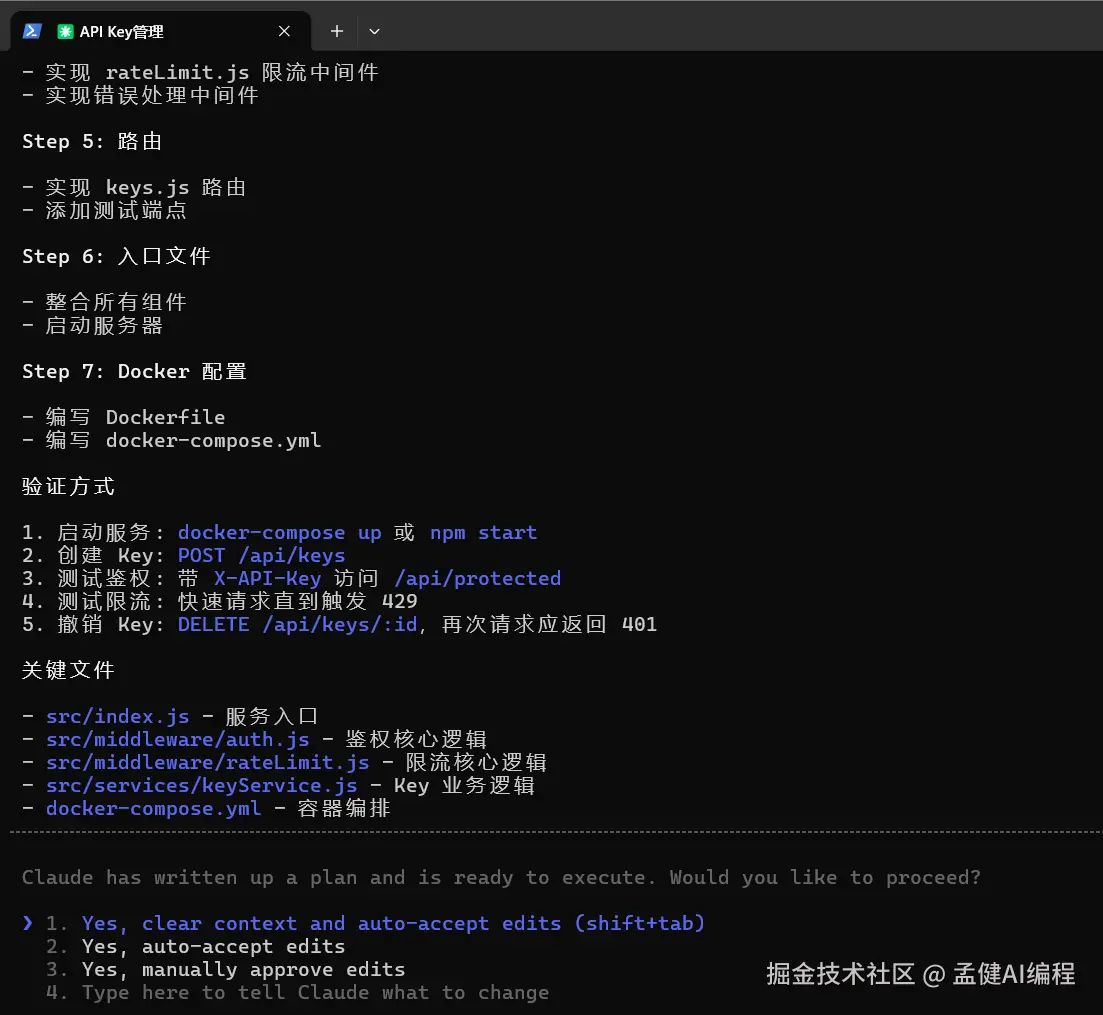

任务:用 Node.js + SQLite 搭一个 API Key 管理系统,包含创建/撤销/验证 Key、鉴权中间件、频率限制、错误处理、Docker 配置。

这类任务是区分"写代码"和"做工程"的分水岭。

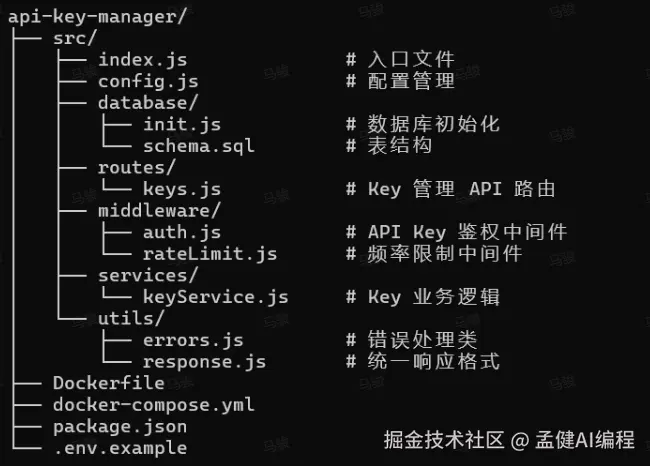

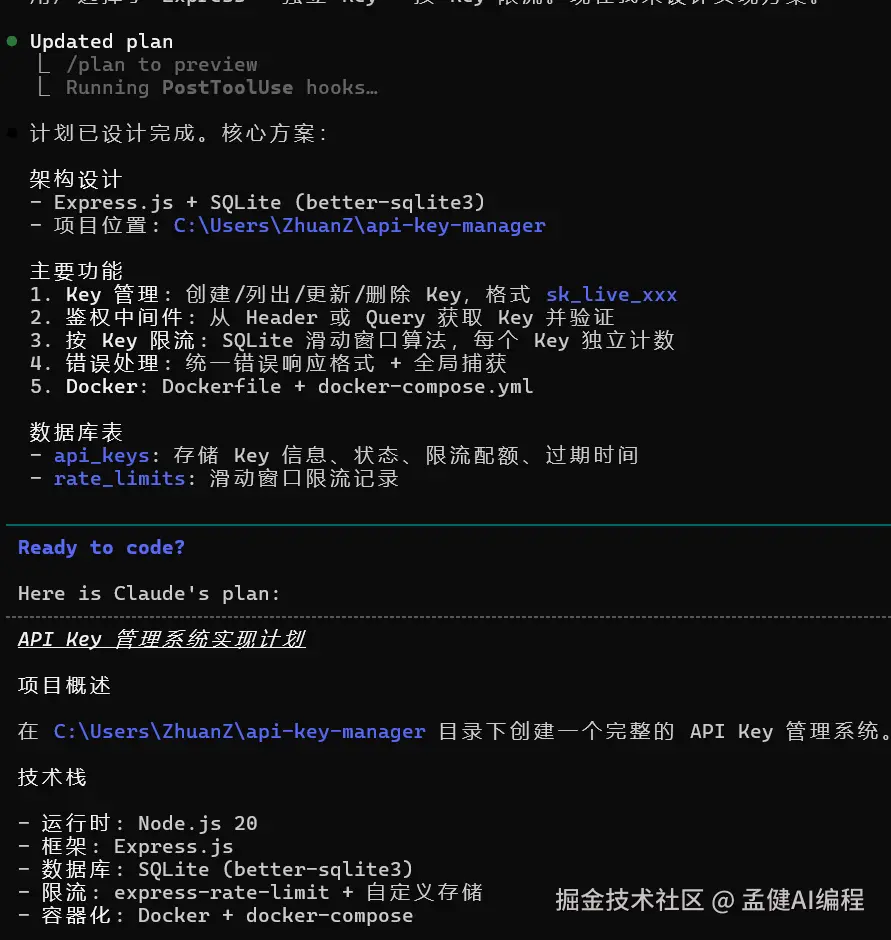

GLM-5 的表现让我真的沉默了------它没有上来就糊代码,而是先输出了一个完整的架构规划。分层目录、技术选型理由、文件职责划分都交代清楚了。

分别让我确认每一步设置,而不是上来就干。这个工程习惯,比很多真人开发者都强。

项目位置:

限流策略

最后提交

代码结构

制定计划

数据库表设计

核心功能实现

有几个细节让我印象深刻:

-

API Key 用哈希存储而不是明文,安全意识到位

-

频率限制、错误处理都写了,不是那种"能跑就行"的 demo

唯一可以优化的地方:一次性输出的代码量很大,如果能加入分步验证会更完美。不过就完成度来说,一次生成 10+ 个文件、项目结构完整、直接能跑------我用 Opus 做类似任务,也就这个水平了。

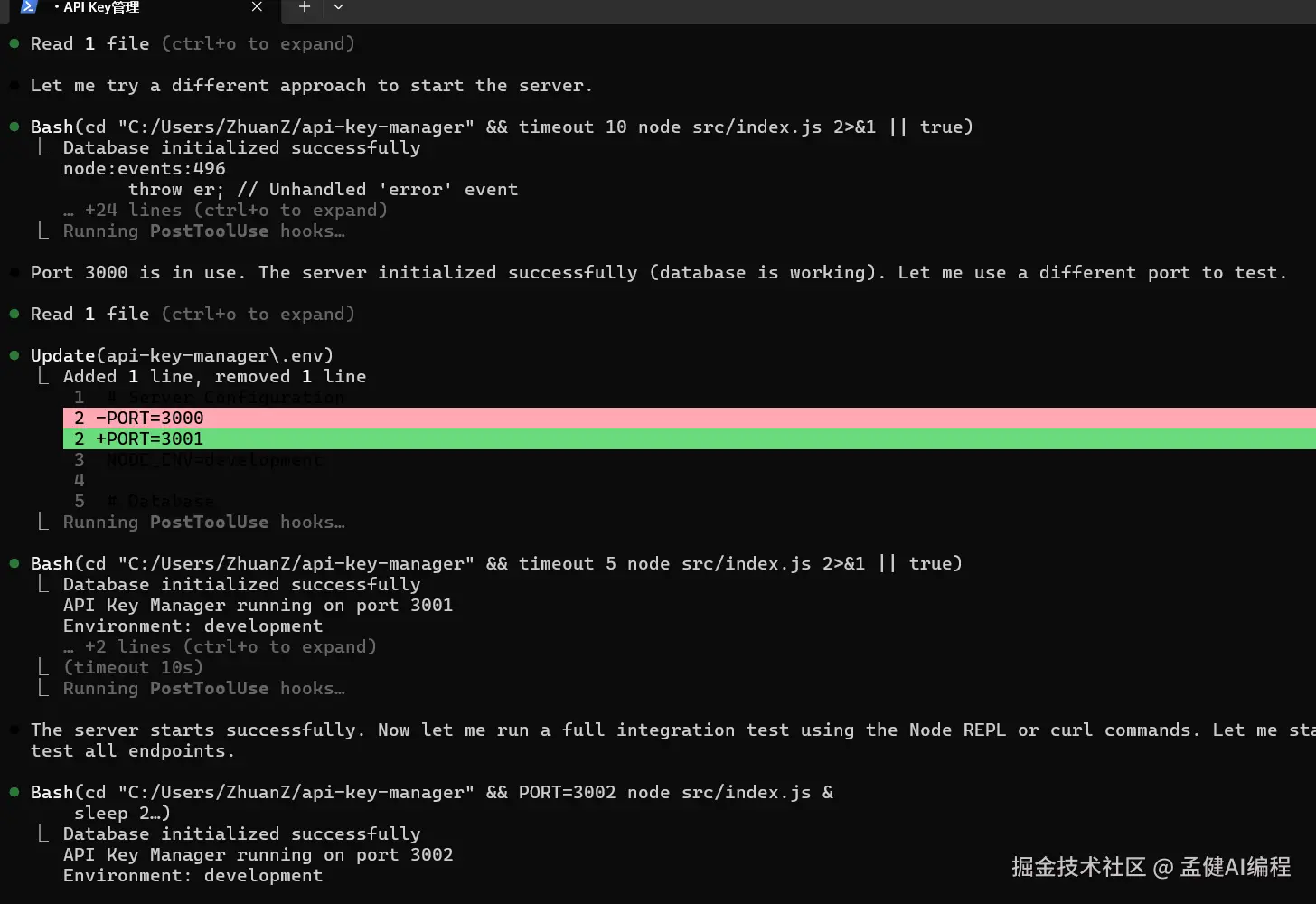

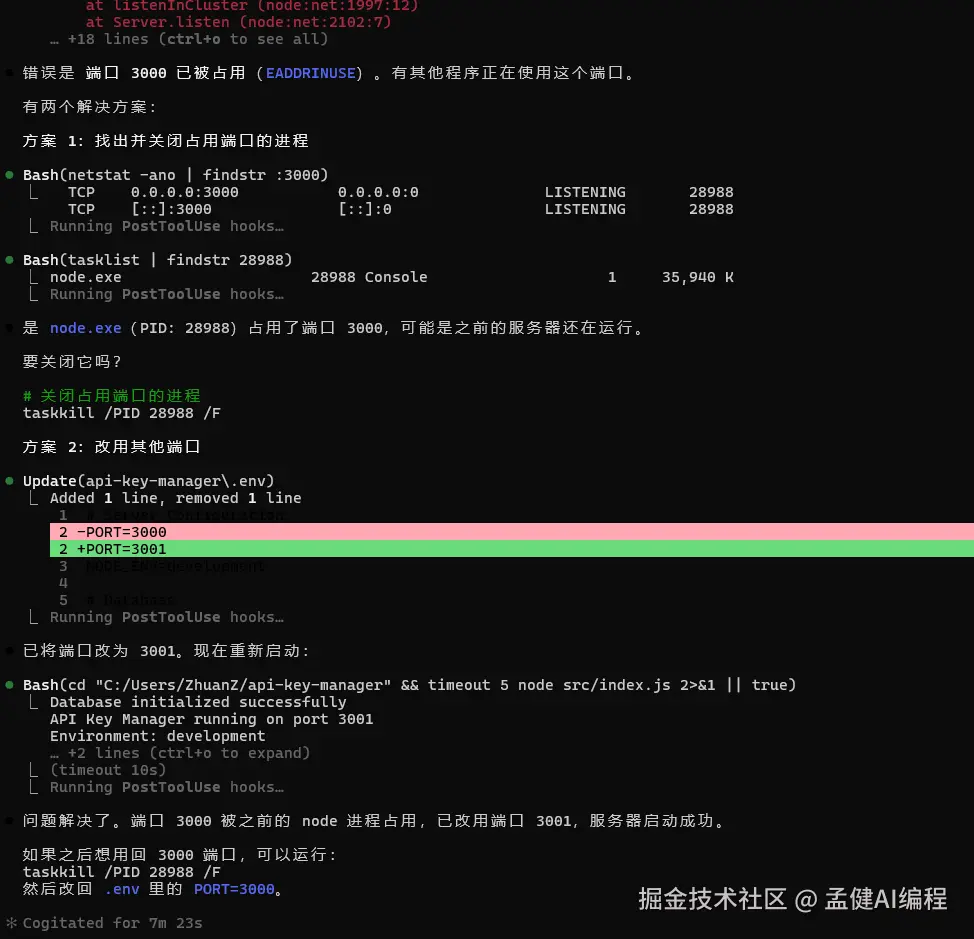

0 4 测试 三 :Debug 真实报错

第一个例子启动报错,直接问 GLM-5:

这是我自己当时踩过的坑,搜了不少资料才搞定的。

GLM-5 的分析路径非常清晰:第一个方案定位到占用 3000 端口的进程并给出关闭命令;第二个方案直接改用其他端口。

两个方案都是对的。没有瞎猜,没有给一堆你可以试试的废话。直接定位,直接给方案。

这个能力对不熟悉运维的小伙伴来说太实用了------看见黑窗口报错不用慌,直接问就行。

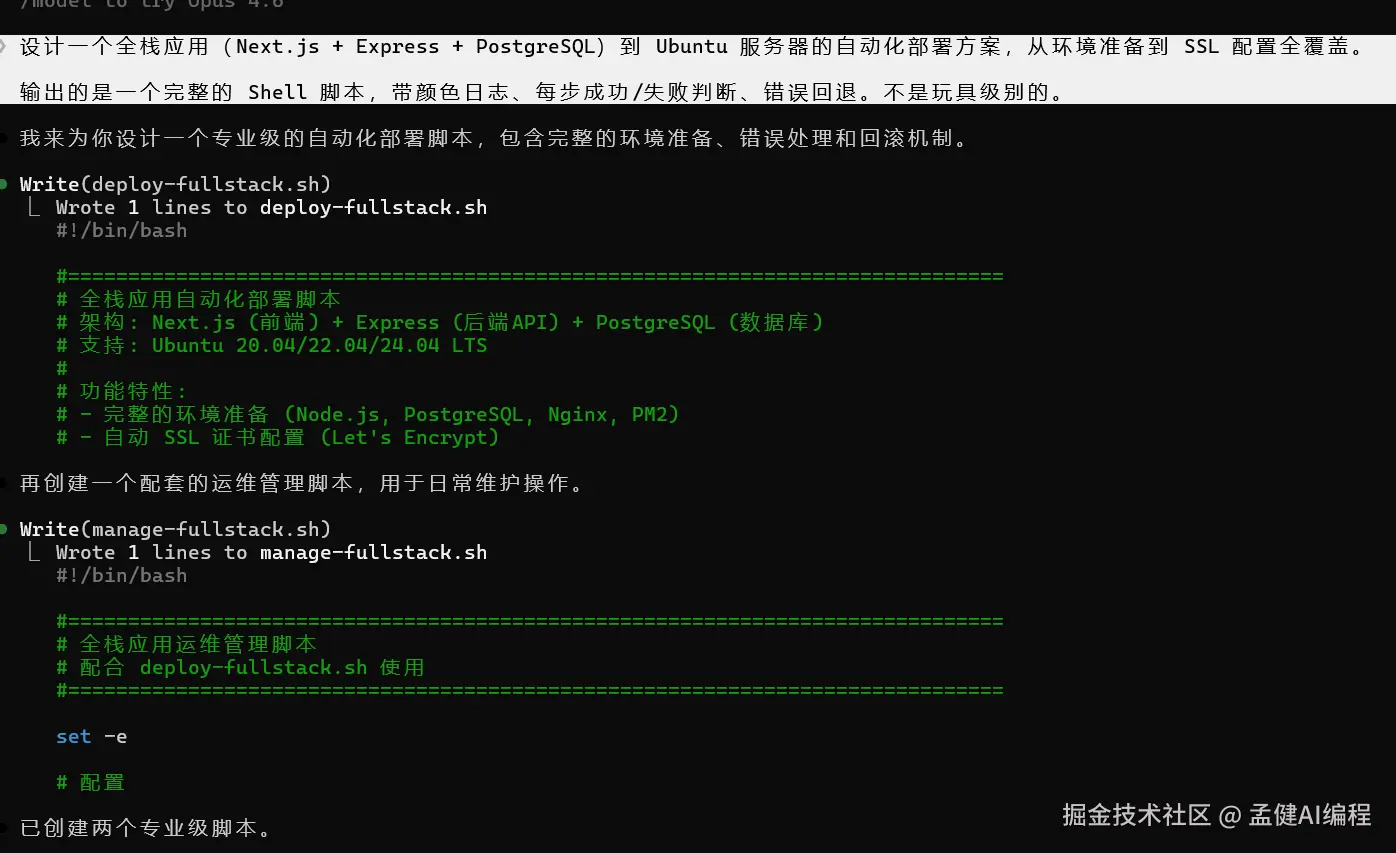

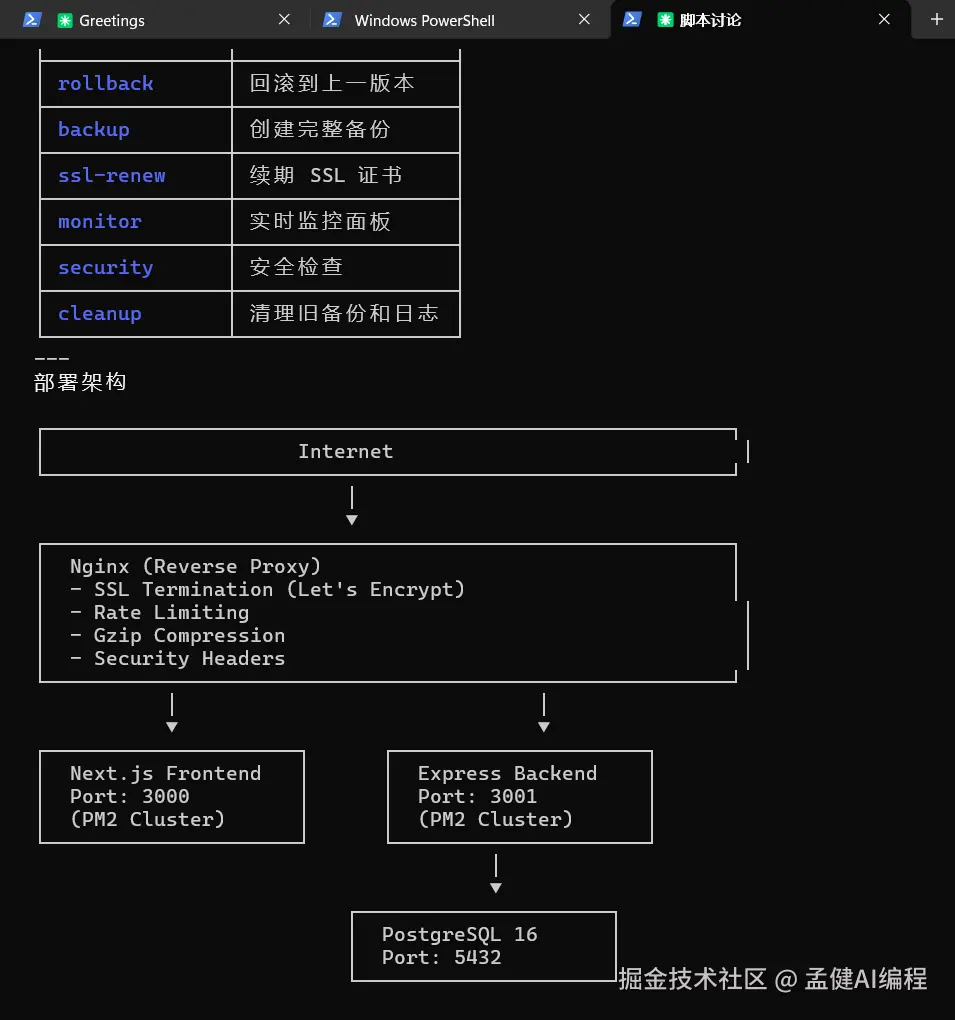

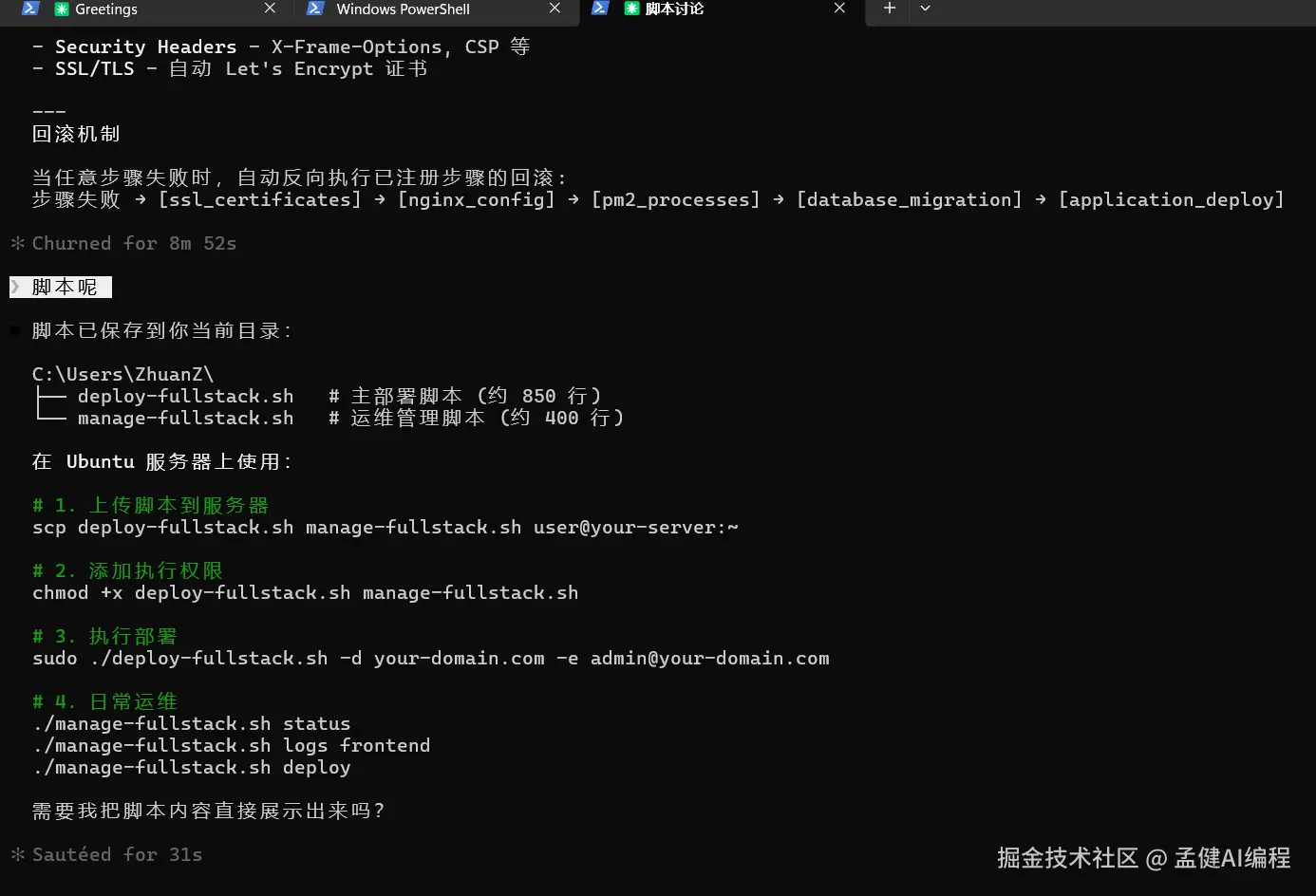

0 5 测试 四 :自动化部署方案

让它设计一个全栈应用(Next.js + Express + PostgreSQL)到 Ubuntu 服务器的自动化部署方案,从环境准备到 SSL 配置全覆盖。

输出的是一个完整的 Shell 脚本,带颜色日志、每步成功/失败判断、错误回退。这不是教程级别的伪代码,是真能往服务器上跑的生产脚本。

还能输出部署架构图,对全栈部署的理解很到位!

值得注意的是:智谱在宣传里说 GLM-5 可以在数百次工具调用后保持连贯。我这次测试只是冰山一角,更复杂的长程 Agent 场景值得期待。

0 6: 几个真实的不足

客观说说还可以优化的地方:

速度可以更快。作为推理模型,一个中等复杂度的请求要等 30-60 秒。不过思考深度和输出质量摆在这里,这个取舍是值得的。而且智谱在持续优化推理速度,这个问题相信很快会改善。

工具链生态在快速完善。智谱已经提供了 Anthropic API 兼容层,可以接入 Claude Code 等主流工具。API 直接调用已经非常稳定,开源生态意味着更大的可能性------社区适配只是时间问题。

开源带来的想象空间。和闭源模型不同,GLM-5 的开源意味着可以私有化部署、可以微调、可以嵌入自己的工具链。这对企业用户来说是巨大的吸引力。

中等难度已经很稳了,期待后续测一些更硬核的场景------重构万行遗留系统、从零写编译器这种级别的挑战。

0 7: 怎么看这件事

抛开模型本身,我觉得更值得关注的趋势是:编程大模型正在从能写代码跨到能做工程。

Opus 4.6 在做这个,GPT-5.3-Codex 在做这个,现在 GLM-5 也在做这个。区别是 GLM-5 开源,跑在国产芯片上,成本低一个量级。

其实回头看,国产大模型在好几个方向上已经不是追赶了。Seedance 2.0 在 AI 视频生成上已经是全球第一梯队,海外用户的口碑非常好。现在 GLM-5 在 AI Coding 方向上也站到了同一梯队。视频生成和代码生成,AI 落地最重要的两个航道,国产模型都已经站到了牌桌上。

现在我的日常编程任务已经开始切到 GLM-5 了。中等复杂度的工程任务、Debug、部署脚本------GLM-5 接得稳稳的,省下来的 API 费用相当可观。

如果你还没试过国产编程模型,GLM-5 绝对值得放进你的工具箱。它可能会让你重新认识国产大模型这五个字。

0 8: 怎么用

-

智谱官网对话 :访问 chat.z.ai/,选择 GLM-5 模型直接体验

-

API 调用:在智谱开放平台 open.bigmodel.cn 注册获取 API Key

-

Claude Code 接入:智谱提供了 Anthropic 兼容 API,改一下 Claude Code 的配置文件就能用 GLM-5 驱动编程

开源、国产芯片、Opus 级能力------这三个词放在一起,就是 2026 年 AI 编程最大的变量。GLM-5 不是在追赶,是在开辟另一条路。

如果这篇对你有帮助,欢迎点赞、收藏、关注,你的支持是我持续输出的动力 ✨

我的其他平台账号和开源项目在个人主页中,欢迎交流 🤝