2026 开年,国产大模型的进化速度令人瞩目。此前在社区匿名测试时,智谱的 GLM-5 就被众多开发者视为体验最接近 Claude Opus 4.5 的模型。今天正式开源后,它在全球权威榜单 Artificial Analysis 上斩获全球第四的成绩(与 Claude Opus 4.5 分数持平),开发者评价得到了有力印证。

GLM-5 的突破源于基座能力的全面革新:参数规模从 355B 扩展至 744B,预训练数据提升至 28.5T,并首次集成 DeepSeek 稀疏注意力机制,在保证长文本理解效果的同时显著优化了部署成本。

真正让 GLM-5 脱颖而出的是其在实际编程场景中的表现。在 SWE-bench Verified 和 Terminal Bench 2.0 测试中,它分别取得 77.8 和 56.2 的开源 SOTA 分数,性能甚至超越了 Gemini 3 Pro。

提示词:设计一个网页版的"春节版2048"。将数字换成春节元素(如福字、春联、灯笼、鞭炮),相同元素合并升级。

提示词:设计一个春节保卫战塔防游戏。要有完整的游戏机制,自行设计 地图系统、防御塔系统、敌人系统、波次系统、经济系统、生命值系统。视觉设计用春节喜庆风格。

GLM-5 的进化不仅体现在代码生成质量上,更体现在其对复杂工程任务的驾驭能力。通过异步强化学习框架 Slime,模型能够从长程交互中持续学习,在后端重构、深度调试等复杂任务中表现出出色的目标一致性与规划能力,宛如一位深谙项目全生命周期的技术架构师。在 Agent 能力方面,GLM-5 在 BrowseComp、MCP-Atlas 和 τ²-Bench 等评测中均取得开源最佳表现。

这些能力共同铸就了 GLM-5 作为"Agentic Ready"基座模型的核心价值:它能精准理解复杂需求,拆解多步骤任务,并在长周期执行中保持稳定表现。无论是构建智能体应用还是处理系统性工程任务,GLM-5 都展现出开源模型中少见的成熟度。

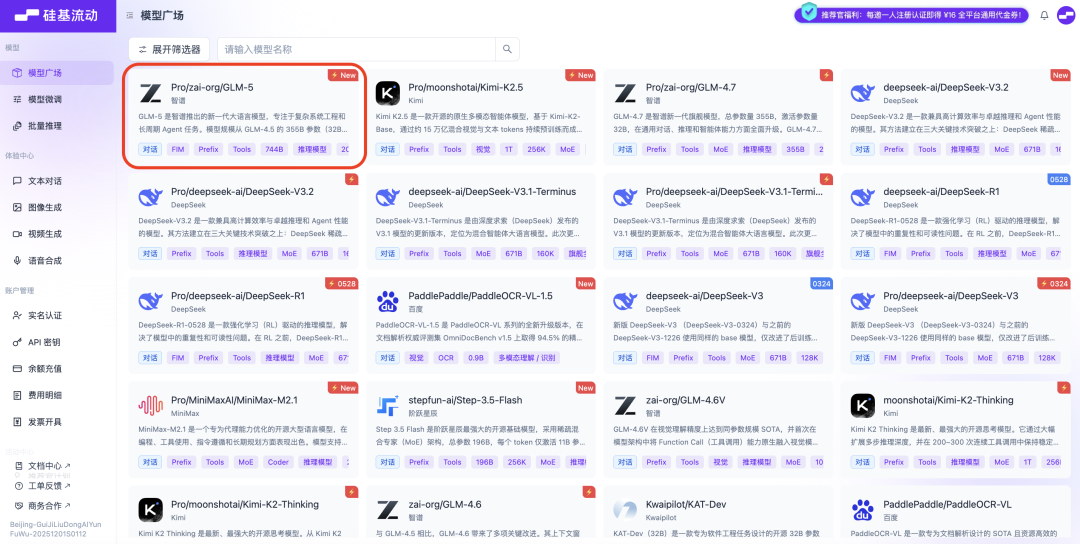

GLM-5 是登陆硅基流动 AI 云的第 154 个模型,支持命中缓存功能以及 198K 上下文长度。你可在 OpenClaw、Claude Code、Kimi Code、TRAE、Kilo Code、Cline 和 Roo Code 等工具接入 API 使用。

GLM-5 为国内开发者提供了一个值得信赖的新起点。更令人期待的是,我们今年或许有望看到国产大模型实现从比肩到超越国际顶尖闭源模型的历史性突破。