到了2026年,生成式人工智能已然深度嵌入了各个领域,这些领域涵盖从代码开发一直到药物研发。在这样的进程当中,AI算力已不再只是单纯的计算资源堆砌,而是演变成了一个复杂系统工程,这个工程包含异构芯片、分布式调度算法、边缘网络以及弹性供给机制。理解当前AI算力的技术形态,理解其供给模式,理解其成本结构,对于企业制定技术路线、控制运营预算具有现实参考意义。

AI算力的物理承载之物,已然从此前的通用中央处理器,迈向了多元化的方向。图形处理器,依靠着数千个计算核心,成为了并行训练方面的实际标准,然而,它存在着高功耗的问题,并且其固定架构,在特定的推理场景当中,并非是最为理想的解决方案。为此,神经网络处理器、张量处理器开始向垂直场景渗透,NPU通过模拟神经元突触权重更新机制,在低精度整数运算里,能效比GPU提升约2.3倍,TPU针对架构的矩阵运算进行硬化设计,典型的例子是字节跳动推荐的单芯片能提供393 的BF16算力。在当下产业界,其主流的做法是去构建异构算力池,这一算力池是由智能调度层依照任务类型来进行动态分配的,在训练阶段会调用具备高显存带宽的A100或者H20,而在推理阶段则会混合使用T4、L2以及处于边缘侧的模组。

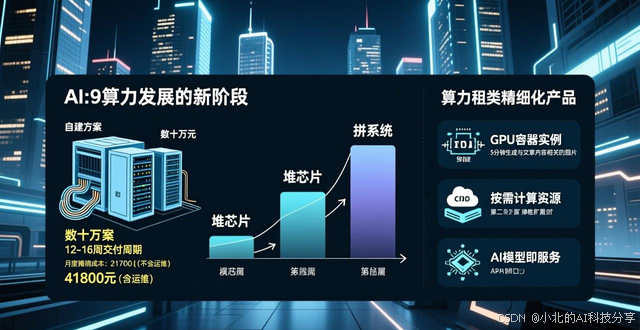

正经历着结构迁移的,是算力的供给模式,从原来的重资产持有,转变为如今的服务化订阅。传统的自建方案,要求企业一次性采购服务器,其价格在数十万元级别,要经历诸多环节,比如机房选址,机柜租赁,网络布线,系统环境配置等 ,交付周期一般在12至16周。并且,依据2025年第四季度的一项行业调查,中小企业单卡4090自建方案的月度摊销成本,其中包含设备折旧,机房电费,制冷及网络带宽,约为21700元,要是计入专职运维工程师薪酬,这个数字就会攀升至41800元。和它进行对比,当下的算力租赁市场已经形成了三类精细化的产品,第一类是GPU容器实例,它的提供商预先设置了CUDA、以及等运行环境 ,用户能够在5分钟之内借助API把实例拉起,计费的粒度精准到单卡每小时 ,规格的公开报价是2.3元/卡/时 ,要是日均运行4小时 ,月支出大概是1656元 ,仅仅是自建的7.6% ;第二类是弹性即时算力 ,系统会按照队列长度或者推理请求并发数自动执行0至N的秒级伸缩 ,闲置的时段资源会自动回收 ,计费颗粒细化到vCPU·秒与显存·秒 ,适合内容审核、智能客服等波峰波谷很明显的业务 ;第三类是裸金属租赁 ,用户独自占有物理服务器的全部PCIe通道与显存资源 ,避免了虚拟化层的损耗 ,适用于金融风控、医疗影像分析等强监管的场景 ,典型的比如A100 - SXM - 80G机型月租金是44000元 ,和同等配置服务器60万元的采购价相比 ,具有现金流灵活性。

边缘算力节点的物理部署密度,正在对推理延迟的边界进行重塑,行业数据表明 ,当仅是在京沪穗三地去部署中心节点之际 ,乌鲁木齐至广州构造起的跨域推理网络往返时延则会多达78毫秒 ,在由截至2026年1月主流服务商便已建成超出1000个POP点的全球呈分布状之际的边缘节点 ,再搭配上边界网关协议借助路由优化以及寻址 ,能够把端到端时延压缩到20毫秒以内 ,这样的一种进步致使实时视频渲染 、工业设备预测维护等具备高实时性的任务 ,可以在云端去完成。以西太平洋某汽车工厂作为例子,其冲压车间所部署的异常振动检测模型,原本是在本地工控机进行运行的,因为算力不足的缘故,导致每秒仅仅能够分析40帧传感器数据,漏报率快要接近11%;当迁移至边缘算力平台之后,调度系统会自动分配就近节点的16核CPU以及1张T4显卡,推理吞吐量提升到每秒320帧,漏报率降低至1.8%以下,而且月度算力支出仅仅是之前硬件维护预算的23%。

对2023至2025年间自建算力企业予以调研,其样本表明单中心GPU集群平均资源利用率仅三十八%,高峰时刻因业务请求触发而满载,夜间以及节假日却大量闲置空转着。某电商企业曾配备二百五十六张A10显卡用于双十一期间个性化推荐,活动结束后这批资产以不足购入价三成的残值被处置,成本效益分析揭示出闲置资源存在巨大浪费。以分钟级为单位对算力进行颗粒化的弹性租赁模式,用户只需为核心业务保留基线容量,突发流量由平台千节点资源池承担,理论来讲能把闲置成本降到零。从人力结构方面去看,自建模式起码要配备3名专职的运维工程师来处理驱动兼容、内核升级以及硬件故障,年度薪酬支出超110万元;而托管式算力服务已把环境复杂度进行了封装,部分头部厂商所提供的SLA能达到99.99%,还安排7×24小时硬件工程师参与故障恢复。

信通院在2026年2月发布了《智算产业发展白皮书》,该白皮书披露按照此白皮书所提供的数据,截至2025年末的时候可以看出,我国在用智算中心机架总规模已然超过了120万标准机架,总算力规模达到了(FP16)。在这当中,大概有是源自各厂商聚合所形成的商业化算力资源池,单个头部平台能够调度2000P以上的异构算力,配套存储达到了2PB,出口带宽弹性突破了Tbps级别,市场规模与资源分布现呈现出明显的地缘特征。需要予以关注的是,算力选址已然超出了单纯的技术方面的考量,合规成本变成了关键的变量,服务于金融交易等高度敏感的行业,节点必须要通过等保2.0三级认证,且要部署在北京、上海等监管辖区之内,出海企业更倾向于选择新加坡、雅加达节点,以此来满足通用数据保护条例以及当地数据本地化的要求,大规模离线训练任务则迁移到贵阳、中卫等国家算力枢纽,借助每千瓦时0.35元以下的西部绿电价格,相较于东部能够节约将近四成的电费。

AI算力正从稀缺资源转变为标准化的数字基础设施,随着技术与光电混合计算进入工程化阶段,,未来三年算力单位成本预计将每年以26%的幅度下降,不过服务模式的精细化,计费颗粒的微细化,部署位置的前沿化将是更深层的变革方向,对于技术决策者来说,核心命题已不是"是否拥有算力",而是"以何种颗粒度,在什么位置,用怎样的弹性策略获取算力"。