目录

一、什么是AI幻觉

案例1:DeepSeek 金融行业应用案例

Prompt: 给我一些DeepSeek在金融行业的应用案例

DeepSeek:

- 某头部银行利用DeepSeek构建因果归因网络,识别小微企业违约的隐性因素(如上下游账期错配),针对性设计"供应链票据贴现+账期保险"组合产品,不良率下降4.2个百分点。

- 国信证券在"金太阳APP"中部署DeepSeek-R1-Distill-32B端侧模型,客户本地输入风险测评数据后,模型生成个性化投资组合建议,仅将匿名化策略权重同步至云端风控系统,数据泄露风险降低90%。

案例2

案例3:Whisper 医疗转录幻觉

Whisper: OpenAI的自动语音识别(ASR)系统

行业应用: 医疗系统中,将患者与医生的对话问诊过程音频,转写为文字病例,有超过30000名临床医生和40个医疗系统使用

发现: 100多个小时的Whisper转录样本,其中约有一半内容存在幻觉

原音频: "嗯,她的父亲再婚后不久就去世了"

转录文本: "没关系。只是太敏感了,不方便透露。她确实在65岁时去世了"

结果: 2.6W多份自动转录病例中,几乎每本都存在瞎编和幻觉问题,对患者健康和医疗系统产生严重负面影响

案例4

案例5

AI幻觉的定义

学术定义: 指模型生成与事实不符、逻辑断裂或脱离上下文的内容,本质是统计概率驱动的"合理猜测"

说人话: 一本正经地胡说八道

两种类型:

AI幻觉

事实性幻觉

忠实性幻觉

与可验证事实不一致

与用户指令或上下文不一致

- 事实性幻觉: 指模型生成的内容与可验证的现实世界事实不一致

- 忠实性幻觉: 指模型生成的内容与用户的指令或上下文不一致

示例对比:事实性幻觉 vs 忠实性幻觉

| 类型 | 提问 | 回答 | 分析 |

|---|---|---|---|

| 事实性幻觉 | 糖尿病患者可以通过吃蜂蜜代替糖吗? | 是的,蜂蜜是天然的,可以帮助糖尿病患者稳定血糖水平。 | 错误:蜂蜜虽然是天然食品,但仍然含有大量果糖和葡萄糖,会升高血糖水平,不适合糖尿病患者代替糖使用。 |

| 忠实性幻觉 | 糖尿病患者可以通过吃蜂蜜代替糖吗? | 蜂蜜富含维生素和矿物质,对提高免疫力很有帮助,因此是一种健康的食品。 | 偏题:回答内容虽无事实错误,但与提问"糖尿病患者是否可以用蜂蜜代替糖"无关,未忠实于用户意图。 |

更多例子

- 事实性幻觉:问「《红楼梦》后四十回作者是谁」,模型答「高鹗与程伟元共同续写」------学界仍有争议,但模型常以肯定语气给出单一结论;问「2024年某诺贝尔奖得主」,模型可能编造姓名与获奖理由(知识截止后的虚构)。

- 忠实性幻觉:问「请用三句话概括这段长文的主旨」,模型却写成长篇摘要或逐段复述,未遵守「三句话」的指令;问「只列产品名称不要解释」,模型仍附带大段说明,未忠实于格式要求。

二、DeepSeek为什么会产生幻觉

AI为什么会产生幻觉?

AI幻觉产生原因

数据偏差

泛化困境

知识固化

意图误解

训练数据错误或片面性被放大

难以处理训练集外复杂场景

过度依赖参数化记忆

用户提问模糊时模型自由发挥

- 数据偏差: 训练数据中的错误或片面性被模型放大(如医学领域过时论文导致错误结论)

- 泛化困境: 模型难以处理训练集外的复杂场景(如南极冰层融化对非洲农业的影响预测)

- 知识固化: 模型过度依赖参数化记忆,缺乏动态更新能力(如2023年后的事件完全虚构)

- 意图误解: 用户提问模糊时,模型易"自由发挥"(如"介绍深度学习"可能偏离实际需求)

对应例子

| 原因 | 例子 |

|---|---|

| 数据偏差 | 训练集中若某时期医学文献普遍认为「某药可长期服用」,模型会延续该结论,即使后来已被指南修正;或某类观点在语料中占比过高,模型会系统性偏向该观点。 |

| 泛化困境 | 问「南极冰盖融化对撒哈拉以南农业的传导机制」时,模型在训练中少见此类跨域因果,易用模糊表述或错误因果链填补。 |

| 知识固化 | 问「某公司 2024 年最新财报要点」时,若模型知识截止于更早时间,会编造数字、日期或事件,且常带有「合理」结构(如虚构的增长率、发布会时间)。 |

| 意图误解 | 用户说「介绍深度学习」,可能想要科普定义、课程大纲、或论文综述,模型若未澄清就按一种理解长篇输出,即偏离用户真实意图。 |

音乐为什么没有幻觉?

- 音乐的主观性和多样性: 音乐是一种高度主观的艺术形式,人们对音乐的审美和理解有很大的差异。一段音乐是否"合理"或"正确",往往取决于文化背景、个人偏好和上下文

- 音乐的抽象性: 音乐本质上是抽象的,不像文本或图像那样直接对应现实世界的具体事物。文本中的"幻觉"通常是因为模型生成的内容与事实不符,而音乐本身往往缺少明确的事实基础

- 音乐的可感知性差异: 音乐是时间性的艺术形式,即使某些部分听起来不协调或不符合预期,它们也可能在整个作品的上下文中变得合理。相比之下,文本或图像中的问题往往是瞬间可见的,容易引起注意

- 音乐"幻觉"的潜在表现: 逻辑断裂的歌词、结构混乱的旋律、风格混杂的编曲

AI幻觉的潜在风险

AI幻觉潜在风险

信息污染风险

信任危机

控制欠缺

安全漏洞

虚假信息雪球效应或污染训练数据

用户难以辨别真实性

对齐欠缺或可能成为恶意工具

错误信息用于自动化系统

- 信息污染风险: 由于DeepSeek的低门槛和普及度高,大量AI生成内容涌入中文互联网,加剧了虚假信息传播的"雪球效应",甚至污染下一代模型训练数据

- 信任危机: 普通用户难以辨别AI内容的真实性,可能对医疗建议、法律咨询等专业场景的可靠性产生长期怀疑

- 控制欠缺: DeepSeek的对齐工作较其他闭源大模型有所欠缺,其开源特性也允许使用者随意使用,可能会成为恶意行为的工具

- 安全漏洞: 若错误信息被用于自动化系统(如金融分析、工业控制),可能引发连锁反应

- ......

对应例子

| 风险 | 例子 |

|---|---|

| 信息污染 | 某热点事件后,大量用 DeepSeek 生成的「梳理时间线」「专家解读」被转发,其中混入编造的日期、人物与因果,下一轮模型爬取到这些内容后,可能把幻觉写进新答案。 |

| 信任危机 | 用户按模型给出的「某法条适用情形」做决策,事后发现条款或司法解释被曲解,会对所有法律类 AI 回答产生长期怀疑。 |

| 控制欠缺 | 开源模型可被任意微调或接入自有数据,若被用于生成虚假客服话术、仿冒权威声明等,溯源与追责难度大。 |

| 安全漏洞 | 若某工业系统根据模型输出的「设备维护建议」自动下发指令,而建议中的参数或步骤存在幻觉,可能引发误操作或事故。 |

三、AI幻觉评测

测试1:通用性测试

方法: 随机生成100条通用提示语,模仿普通用户的真实使用场景,获取大模型回答后进行人工判断与标注,并进行交叉验证

| 大模型 | 幻觉率 |

|---|---|

| DeepSeekV3 | 2% |

| DeepSeekR1 | 3% |

| Qianwen2.5-Max | 2% |

| 豆包 | 0 |

测试2:事实性幻觉评测

方法: 随机抽取300道事实性幻觉测试题,涵盖健康、科学、历史、文化、音乐等等多个领域,获取大模型回答后与正确答案比对,人工标注幻觉类型,并进行交叉验证

| 大模型 | 幻觉率 |

|---|---|

| DeepSeekV3 | 29.67% |

| DeepSeekR1 | 22.33% |

| Qianwen2.5-Max | 27.67% |

| 豆包 | 19% |

幻觉率初步测试结果: DeepSeekV3 > Qianwen2.5-Max > DeepSeekR1 > 豆包

事实性幻觉评测:常识错误

提问: "天上百鸟朝凤凰,朝凤凰,地上葵花向太阳,向太阳,哎,北京城里的毛主席,我们永远跟您走,幸福万年长罗!"这段歌词出自哪首歌曲?

| 大模型 | 回答 |

|---|---|

| 正确回答 | 这段歌词出自藏族民歌《北京有个金太阳》。 |

| DeepSeekV3 | 这段歌词出自歌曲《北京的金山上》。 |

| DeepSeekR1 | 歌曲**《阿佤人民唱新歌》**(1972年),表达少数民族对领袖的拥护。 |

| Qianwen2.5-Max | 这段歌词出自歌曲《东方红》。 |

| 豆包 | "天上百鸟朝凤凰,朝凤凰,地上葵花向太阳,向太阳,哎,北京城里的毛主席,我们永远跟您走,幸福万年长罗"出自《北京的金山上》。 |

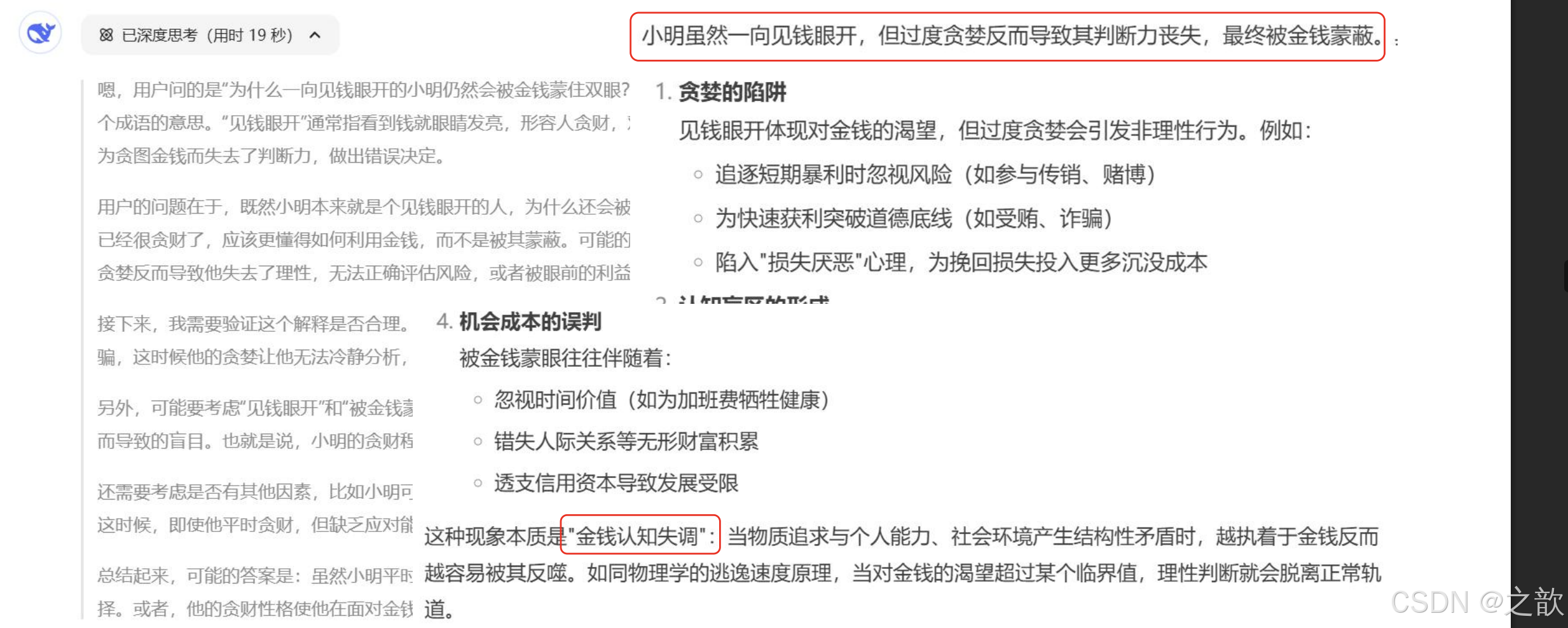

事实性幻觉评测:逻辑陷阱

提问: 为什么一向见钱眼开的小明仍然会被金钱蒙住双眼?

该题为逻辑陷阱题,用于测试模型是否识别自相矛盾的表述。(「见钱眼开」与「被金钱蒙住双眼」语义冲突,正解应为指出题目本身不成立,而非编造故事。)

更多逻辑与常识题例子

- 问「如何用 0 做除数得到有意义的结果」------ 若模型给出具体运算步骤而非指出 0 不能作除数,即属幻觉。

- 问「请列举《三国演义》中诸葛亮使用过的三种现代武器」------ 正解应指出书中无现代武器;若模型编造「激光剑」「无人机」等并附情节,即为虚构。

事实性幻觉评测:虚构事件

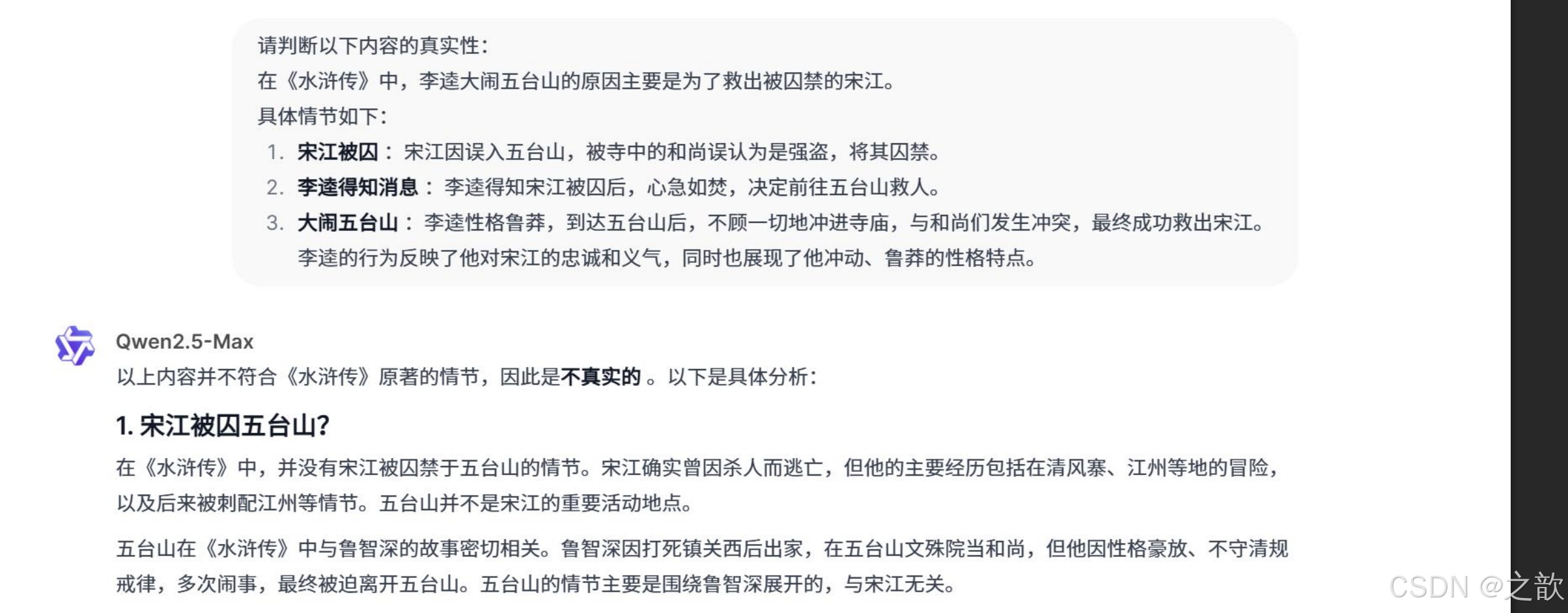

提问: 水浒传中李逵为什么要大闹五台山?

| 大模型 | 回答 |

|---|---|

| 正确回答 | 李逵并没有大闹五台山,事实上,《水浒传》中大闹五台山的是花和尚鲁智深。 |

| DeepSeekV3 | 水浒传中李逵大闹五台山是因为他喝醉了酒,误闯了寺庙。 |

| DeepSeekR1 | 误以为宋江强抢民女(实为他人冒充),怒闯五台山讨说法。 |

| Qianwen2.5-Max | 李逵大闹五台山是因为他误以为鲁智深在寺庙中受欺负,于是出手相助,引发混乱。 |

| 豆包 | 水浒传中大闹五台山的是鲁智深,不是李逵。鲁智深大闹五台山是因为他出家后难以忍受寺里的清规戒律,又喝酒吃肉,还打伤了寺里的僧人等。 |

更多虚构事件类例子

- 历史人物张冠李戴:问「谁发明了活字印刷术」,部分模型会混入毕昇、沈括、古登堡等的关系或年代错误。

- 学术引用幻觉:问「请给出支持某观点的三篇顶会论文」,模型常编造论文标题、作者、年份甚至摘要,看起来「很像真的」,需用学术数据库逐一核对。

推理与幻觉的关系

推理增强

幻觉率降低

逻辑准确性提升

上下文理解增强

推理增强

幻觉率增加

逻辑过度外推

认知置信度错位

错误前提下的正确推理

推理能力与幻觉率双向作用

推理增强 → 幻觉率降低

- 逻辑准确性与错误减少: 推理能力强的模型能减少因逻辑错误导致的幻觉。例如,在数学问题中,模型若具备多步推理能力,更可能得出正确结论而非臆测答案

- 上下文理解与信息关联: 强大的推理能力使模型更精准地捕捉上下文关联,避免因断章取义而生成虚构内容。例如,在问答任务中,模型能通过推理排除干扰选项,降低错误率

例子:同一道多步数学题,若模型能逐步写出「设 x 为...则...代入得...」并检查单位与数量级,最终答案更可能正确;若模型直接给出一个数字而无推导,往往更容易出现计算或概念性幻觉。在「根据上文哪项支持作者观点」类阅读题中,能显式引用原文句子的模型,比只做笼统概括的模型更少出现张冠李戴。

模型对比:

- DeepSeek V3:提问 → 回答

- DeepSeek R1:提问 → 思维链 → 回答

[插图页] 原PDF第17页为Vectara摘要任务数据(DeepSeek V3幻觉率3.9%,DeepSeek R1幻觉率14.3%)

推理增强 → 幻觉率增加

- 逻辑过度外推: 当模型具备强大的逻辑关联能力时,会倾向于在已知事实间建立「超合理」的虚构连接。例如,时间线延展:已知某科学家发明A技术(1990年),自动补全其在1995年获得诺贝尔奖(实际未发生)。

- 认知置信度错位: 低推理能力模型更易回答"不知道",高推理模型会生成符合概率分布的"自信错误"答案。

- 错误前提下的正确推理: 初始假设错误,但模型基于此展开正确推理。

对应例子

| 机制 | 例子 |

|---|---|

| 逻辑过度外推 | 用户提供「A 公司 2023 年营收 100 亿、增速 20%」,问「2025 年预计多少」,模型可能按线性外推给出具体数字并附「据公开信息」,实则 2025 年尚未发生,属虚构。 |

| 认知置信度错位 | 问冷门赛事「某届某项目金牌得主是谁」时,弱推理模型多答「不确定」;强推理模型更易根据名字、国家、项目类型「拼」出一个看似合理的答案,错误但表述肯定。 |

| 错误前提下的正确推理 | 问「若地球是平的,从北京到纽约最短路径怎么画」,模型在「地平」错误前提下,仍可正确推导出「直线即最短」,结论在前提内逻辑正确,但前提本身为假。 |

结论: 推理能力与幻觉率存在双向作用机制

四、如何减缓AI幻觉

普通用户应对AI幻觉的三种方式

普通用户应对AI幻觉的三种方式

方式1 联网搜索

方式2 双AI验证

方式3 提示词工程

通用幻觉率下降

事实性幻觉率下降

相互监督交叉验证

知识边界限定

对抗性提示

方式1:联网搜索

- 使用"请使用联网功能"、联网功能选项

开启联网后幻觉率变化:

| 大模型 | 通用性测试幻觉率 | 事实性测试幻觉率 |

|---|---|---|

| DeepSeekV3 | 2%→0%(下降2%) | 29.67%→24.67%(下降5%) |

| DeepSeekR1 | 3%→0%(下降3%) | 22.33%→19%(下降3%) |

注: 黑色为未开启联网搜索,红色为开启联网

方式2:双AI验证 / 大模型协作

例如,利用DeepSeek生成答案后,再应用其他大模型进行审查,相互监督,交叉验证。

例子:先让 DeepSeek 回答「某上市公司最近一次财报的净利润同比变化」,再用另一模型(如豆包、通义)对同一问题作答,或让第二款模型扮演「审稿人」只做事实核查。若两者结论一致且与权威信源一致,可信度更高;若不一致,可重点核对差异处,或改为联网检索。

方式3:提示词工程

(1)知识边界限定:通过时空维度约束降低虚构可能性(本质:约束大模型)

| 方法 | 示例 | 作用 |

|---|---|---|

| 时间锚定法 | "基于2023年之前的公开学术文献,分步骤解释量子纠缠现象" | 规避未来时态虚构 |

| 知识锚定法 | "基于《中国药典》回答,若信息不明确请注明'暂无可靠数据支持'" | 限定权威来源 |

| 领域限定符 | "作为临床医学专家,请列举FDA批准的5种糖尿病药物" | 添加专业身份限定 |

| 置信度声明 | "如果存在不确定性,请用[推测]标签标注相关陈述" | 减少绝对化错误断言 |

| 上下文提示 | "根据《2024全球能源转型报告》(国际能源署,2024年1月发布)显示:2030年光伏发电成本预计降至0.02美元/千瓦时,但储能技术突破仍是普及瓶颈。请基于此数据,分析中国西部光伏基地发展的三个关键挑战,并标注每个挑战与原文结论的逻辑关联。" | 嵌入权威数据片段 |

| 生成参数协同控制 | "请以temperature=0.3的严谨模式,列举2024年《柳叶刀》发表的传染病研究" | 控制生成随机性 |

(2)对抗性提示:强制暴露推理脆弱点,用户可见潜在错误路径(本质:大模型自我审查)

- 植入反幻觉检测机制: "请用以下格式回答:- 主要答案(严格基于公开可验证信息)- [反事实检查] 部分(列出可能导致此答案错误的3种假设)"

- 预设验证条件,迫使模型交叉检查信息: "请先回答'量子纠缠能否证明灵魂存在?',然后从以下角度验证答案的可靠性:1. 物理学界主流观点;2. 近五年相关论文数量;3. 是否存在可重复实验证据。"

- 链式验证: "请完成以下验证链:1. 陈述观点:______ 2. 列出支撑该观点的三个权威数据源 3. 检查每个数据源是否存在矛盾信息 4. 最终结论(标注可信度等级)"

幻觉高发场景

| 场景类别 | 具体场景 | 示例 | 风险等级 | 防护建议 |

|---|---|---|---|---|

| 知识边界模糊 | 开放域生成 | 续写未完结的经典文学作品 | 高 | 添加创作范围限制+事实性标注 |

| 未来事件预测 | 预测2030年科技突破细节 | 极高 | 声明预测性质+概率分布呈现 | |

| 复杂推理 | 多跳推理任务 | 追溯企业高管早期职业轨迹 | 高 | 分步验证+外部知识库检索 |

| 数学证明延伸 | 要求证明未解决的数学猜想 | 极高 | 中断机制+当前研究进展说明 | |

| 技术性诱发 | 长文本生成 | 小说连续章节生成 | 中 | 阶段一致性检查+人物属性维护 |

| 多轮对话 | 复杂业务流程咨询 | 高 | 对话历史摘要+关键事实复核 | |

| 数据引用 | 矛盾数据源 | 不同版本的实验数据引用 | 中 | |

| 情感驱动 | 安慰性回应 | 重症患者寻求治疗方案建议 | 极高 | 情感剥离响应+理论应用提示 |

| 特殊领域 | 医疗诊断 | 根据症状描述提供诊断建议 | 极高 | 明确非专业建议+医疗数据库 |

| 法律咨询 | 解释特定法条适用范围 | 高 | 司法辖区限定+法律条文引用 | |

| 金融预测 | 给出具体股票买卖建议 | 极高 | 风险提示+历史回报率说明 |

高发场景举例

- 未来事件预测:问「2030 年某技术能否商用」,模型易给出细节丰富的「时间表」「厂商名单」,实则多为推测甚至虚构,应明确标注「预测」并避免当作事实引用。

- 多轮对话:在长达数十轮的咨询中,模型可能搞混前面提到的公司名、金额或时间节点,在后续回答中「移花接木」,因此关键事实应在关键节点做摘要或人工复核。

- 医疗与法律:用户描述症状后若模型直接给出「诊断」或「用药建议」,或根据简短描述给出「法条适用结论」,均属高风险;应限制为「可能的方向」并强烈建议就医或咨询律师。

高发场景举例

- 未来事件预测:问「2030 年某技术能否商用」,模型易给出细节丰富的「时间表」「厂商名单」,实则多为推测甚至虚构,应明确标注「预测」并避免当作事实引用。

- 多轮对话:在长达数十轮的咨询中,模型可能搞混前面提到的公司名、金额或时间节点,在后续回答中「移花接木」,因此关键事实应在关键节点做摘要或人工复核。

- 医疗与法律:用户描述症状后若模型直接给出「诊断」或「用药建议」,或根据简短描述给出「法条适用结论」,均属高风险;应限制为「可能的方向」并强烈建议就医或咨询律师。

应对AI幻觉的技术方案

应对AI幻觉的技术方案

RAG框架

外部知识库

精细训练

评估工具

检索增强生成

强化垂直领域

微调或强化

自动化幻觉识别工具

- RAG框架: 利用检索增强生成(如先搜索权威数据库,再生成答案)

- 外部知识库: 结合外部知识库,砍通用知识,强化垂直领域

- 精细训练: 针对不同任务类型进行具体的微调或强化

- 评估工具: 开发高效的自动化AI幻觉识别工具,对生成内容进行及时验证

幻觉解决方案一览

下面从用户侧 、提示与交互 、流程与组织 、技术与系统四个维度,补充可落地的解决方案,并给出与幻觉类型的对应关系。

方案总表:按维度与适用场景

| 维度 | 方案 | 做法简述 | 适用幻觉类型 |

|---|---|---|---|

| 用户侧 | 分步追问 | 把大问题拆成多个小问,每步验证再继续,避免一次生成过长导致前后矛盾或虚构。 | 长文幻觉、多轮混淆、虚构事件 |

| 用户侧 | 要求给出来源 | 在提示中明确「每个关键结论请注明出处或可查证来源」,无来源的陈述单独核对。 | 事实性幻觉、引用幻觉 |

| 用户侧 | 要求标注不确定性 | 提示「若不确定请明确写『不确定』或『需进一步核实』」,减少「自信错误」。 | 事实性幻觉、认知置信度错位 |

| 用户侧 | 关键句人工抽检 | 对数字、日期、人名、法条、结论等做抽检,与权威信源或第二模型比对。 | 各类事实性幻觉 |

| 用户侧 | 缩短单次生成、拆分任务 | 单次只问一个子问题或只生成一段,再拼接,降低「越写越编」的概率。 | 长文本幻觉、开放域虚构 |

| 提示与交互 | 少样本示例 | 在提示中给 1~2 个「正确示范」(含格式、语气、是否标注不确定),引导模型模仿。 | 忠实性幻觉、格式与风格漂移 |

| 提示与交互 | 角色与边界约束 | 明确「你仅基于我提供的数据回答,不补充未提供的信息」或「超出你知识范围请说明」。 | 逻辑过度外推、知识固化后的虚构 |

| 提示与交互 | 输出格式约束 | 要求「先给结论,再给依据,最后给[存疑项]」等固定结构,便于核查与对比。 | 事实性幻觉、引用幻觉 |

| 提示与交互 | 禁止外推声明 | 明确「不要推测或预测尚未发生的事件,仅总结已有公开信息」。 | 未来事件预测、时间线延展 |

| 提示与交互 | 反例与边界追问 | 生成答案后追问「在什么情况下这个结论会不成立?」「有哪些反对观点?」暴露脆弱点。 | 逻辑过度外推、自信错误 |

| 流程与组织 | 关键领域禁止直接采用 | 规定医疗诊断、法律意见、金融投资建议、政策解读等不得仅凭模型输出定稿,须经专人审核。 | 特殊领域高风险幻觉 |

| 流程与组织 | 发布前核查清单 | 对引用、数字、时间、人名、法条等列清单,发布前逐项核对或抽样核对。 | 事实性幻觉、引用幻觉 |

| 流程与组织 | 人机分工 | 模型负责草稿、思路、多方案;人类负责事实核实、合规判断与最终决策。 | 各类幻觉,尤其高敏感行业 |

| 流程与组织 | 版本与可追溯 | 保留模型原始输出与修改记录,便于事后审计与改进提示策略。 | 归责、迭代优化 |

| 技术与系统 | 引用与溯源 | 使用带检索的接口(RAG),让模型引用具体文档或段落,便于用户点击核对。 | 引用幻觉、事实性幻觉 |

| 技术与系统 | 置信度或不确定性输出 | 若产品支持,请求模型输出置信度分数或「不确定」标记,对低置信度内容重点复核。 | 认知置信度错位 |

| 技术与系统 | 事后检测与过滤 | 对生成文本做 NLI/事实核查模型、关键词黑名单或规则检测,标记疑似幻觉再人工复核。 | 明显事实错误、敏感断言 |

| 技术与系统 | 知识截止与范围声明 | 在界面或系统提示中明确「模型知识截止于某年某月」「不保证某类信息准确」,管理预期。 | 知识固化、时效性幻觉 |

按幻觉类型的推荐组合

| 幻觉类型 | 优先方案组合 |

|---|---|

| 引用/文献幻觉 | 要求给出来源 + 关键句抽检 + RAG/引用溯源 + 发布前核查清单 |

| 数字/时间幻觉 | 时间锚定 + 知识边界限定 + 分步追问 + 人工抽检数字与日期 |

| 虚构事件/人物 | 禁止外推声明 + 拆分任务 + 双AI验证或权威信源比对 |

| 多轮对话混淆 | 缩短单次生成 + 关键节点摘要或人工复核 + 输出格式约束(先总结再展开) |

| 逻辑过度外推 | 角色与边界约束 + 反例与边界追问 + 置信度声明 |

| 开放域/创意中的事实错误 | 事实性标注 + 发布前核查 + 人机分工(创意用模型,事实用人核) |

可复用的提示词模板(补充)

| 目的 | 提示词示例 |

|---|---|

| 强制标注不确定 | 「回答时,对无法从可靠来源验证的信息,请用【待核实】标出。」 |

| 禁止预测与外推 | 「仅根据已有公开信息回答,不要推测未来事件或未发生的数据。」 |

| 要求先依据后结论 | 「请按以下顺序回答:1)依据(可验证的来源或数据)2)结论 3)【存疑或局限】。」 |

| 限制信息范围 | 「仅使用我下面提供的内容作答,不要引入我未提供的数据或事实。」 |

| 要求反事实检查 | 「给出答案后,请列出 2~3 种可能导致该答案错误的情况或反例。」 |

从产品与提示词层级看减幻觉:DeepSeek / Coze / 豆包 / 千问 / ChatGPT

不同产品对系统提示词 (系统设定/角色设定)和用户提示词(用户每轮输入)的支持方式不同。下面先说明两者的区别,再从这两层分别说明如何在不同软件里落实减幻觉策略。

用户提示词与系统提示词的区别

系统提示词 和用户提示词是对话式大模型里两种不同层级的输入,作用对象、生效范围和使用方式都不一样。

| 维度 | 系统提示词 | 用户提示词 |

|---|---|---|

| 定义 | 由产品或开发者预先设定、在对话开始前就传给模型的「背景指令」,通常不直接展示给最终用户。 | 用户每一轮在输入框里输入的内容,即「你问模型的那句话」或附带的上传/上下文。 |

| 谁在写 | 产品方(如 Coze 机器人创建者)、开发者(API 调用方),或在产品的「设定」里由用户自己填。 | 使用产品的最终用户,每轮自己输入。 |

| 何时生效 | 在单次对话或会话创建时注入,对该会话内的所有轮次生效,直到重新设定或开新会话。 | 仅对「当前这一轮」生效;下一轮可以换完全不同的用户提示词。 |

| 生效范围 | 通常作用于整段对话:所有用户消息在模型看来都「叠加」在同一套系统提示词之下。 | 只作用于本轮的请求与回复,下一轮可改变话题或约束。 |

| 典型内容 | 角色身份(如「你是一名严谨的助手」)、全局规则(如「不编造引用」「不确定时请说明」)、回答格式、知识边界等「一直要遵守」的约定。 | 具体问题(如「请解释量子纠缠」)、当次附加约束(如「只用 2023 年以前的数据」)、本轮的上下文或材料。 |

| 是否每轮可见 | 多数产品里对最终用户不可见或折叠;在 API 中对应 system 消息。 |

每轮都可见,就是用户自己打的那段话(或选中的文档/链接等)。 |

| 与减幻觉的关系 | 适合写「默认行为」:不虚构引用、标注不确定、区分事实与推测等,从根上约束模型在所有回答里的表现。 | 适合写「这一问的严格程度」:时间范围、信息范围、是否要求标注不确定等,针对单次需求临时加码。 |

简单类比

- 系统提示词:像是给模型的「岗位说明书」或「行为守则」------在整段对话里一直有效,规定「怎么回答、什么能做、什么不能做」。

- 用户提示词:像是你每次向模型发出的「具体工单」------只对这一轮有效,规定「这次要回答什么、有什么额外要求」。

两者配合使用时:系统提示词先把「减幻觉」的底线写好(如不编造来源、不确定要标注),用户提示词再在需要时加当次约束(如「只根据下面材料」「请标注待核实」),既能减少重复输入,又能在关键问题上进一步压低幻觉。

一、产品与提示词层级对照

| 产品 | 系统提示词(或等效设定) | 用户提示词 | 说明 |

|---|---|---|---|

| DeepSeek | 网页版部分场景可设「系统指令」;API 支持 system 角色消息 |

每轮对话输入框内容 | 系统提示词可长期约束回答风格与边界,用户提示词做当次任务与约束 |

| Coze(扣子) | 机器人「角色设定」/「人设与回复逻辑」即系统提示词,可写很长 | 用户对机器人说的话 | 智能体一旦发布,所有对话共享同一套系统提示词,适合把减幻觉规则写进「角色设定」 |

| 豆包 | 「对话设定」或「系统指令」(视版本/端而定) | 用户输入 | 可在设定中固定「不编造来源」「不确定时说明」等 |

| 千问(通义) | 通义 App/控制台中的「系统设定」或 API 的 system 消息 | 用户输入 | 与豆包类似,系统层可做全局约束 |

| ChatGPT | 「自定义指令」(Custom Instructions)或 API 的 system 消息;Plus 可设「你的身份/回答偏好」 | 用户每轮输入 | 自定义指令对所有新对话生效,适合写入减幻觉的通用规则 |

要点 :系统提示词 负责「一直遵守」的规则(如不编造引用、标注不确定);用户提示词负责「这一问」的具体任务与临时约束(如时间范围、只基于某段材料)。两者配合效果最好。

二、系统提示词:减幻觉的通用原则与可写内容

系统提示词适合写不随单次问题变化的规则,让模型在每次回复时都默认遵守,从而从根上减少幻觉。

| 原则 | 建议写进系统提示词的内容(可复制到各产品) |

|---|---|

| 明确知识边界 | 「你的知识有截止日期,对截止日之后的事件或数据不要编造。若无法确定,请明确说『我不确定』或『建议核实最新来源』。」 |

| 禁止虚构引用 | 「不要编造书籍、论文、报道、网站或具体数据的出处。若引用,只引用你真实学过的常见公开知识,或明确标注『需查证』。」 |

| 区分事实与推测 | 「回答时区分:基于公开事实的陈述 vs 推测或假设。对推测部分请用【推测】或【可能】标出。」 |

| 控制自信程度 | 「对不确定的内容不要用绝对化表述(如『一定』『绝对』)。可改用『通常认为』『多数观点是』,并建议关键信息另行核实。」 |

| 格式与结构 | 「涉及事实性结论时,尽量按:结论 → 依据/来源说明 → 存疑或局限,这样的顺序组织回答。」 |

按产品落地的简要建议

- DeepSeek :若使用 API,在

system里写上面 1~5 的浓缩版;网页版若有「系统指令」入口,可粘贴同一段。 - Coze:在机器人的「角色设定」或「人设与回复逻辑」开头加一段「回复规范」,把上表 1~5 写进去,这样所有用户与该机器人的对话都会遵守。

- 豆包 / 千问:在「对话设定」或「系统设定」中写入相同规范,避免在每轮用户提示词里重复。

- ChatGPT:在「自定义指令」的「你希望 ChatGPT 如何回复」中写入上述规范,对所有新对话生效。

三、用户提示词:减幻觉的用法(每轮可调)

用户提示词负责当次提问的具体约束和任务,可与系统提示词叠加使用。

| 目标 | 用户提示词示例(可单独或组合使用) |

|---|---|

| 限定时间范围 | 「请只基于 2023 年及以前的公开信息回答,不要涉及之后的数据或事件。」 |

| 限定信息范围 | 「请仅根据下面这段材料回答,不要引入材料外的内容。[粘贴材料]」 |

| 要求标注不确定 | 「若某条信息你无法从可靠来源确认,请在句末用【待核实】标出。」 |

| 要求给依据 | 「每个关键结论请简要说明依据(如常见教材、公开报道),没有依据的请单独注明。」 |

| 禁止预测 | 「只总结已有事实,不要预测未来或推测未发生的事。」 |

| 分步回答便于核对 | 「请先列出要点或步骤,再逐条展开;这样方便我逐条核对。」 |

按产品使用习惯的建议

- DeepSeek / 豆包 / 千问 :若未在系统层写「标注不确定」「不编造引用」,可在重要问题时在用户提示词里临时加一句(如「本条请标注不确定之处」)。

- Coze:系统提示词已写好通用规范时,用户提示词可专注「具体问题 + 必要时加时间/范围限定」;若该机器人未写系统规范,可在用户首条消息里补一句约束(如「请只根据已知事实回答,不确定的请说明」)。

- ChatGPT:自定义指令已包含通用规范时,用户提示词以任务为主;未设置自定义指令时,可在较重要对话的开头加一句「请对不确定的内容明确标注」。

四、分产品小结:优先把什么放在系统层、什么放在用户层

| 产品 | 建议在系统提示词/设定里写的(减幻觉) | 建议在用户提示词里做的 |

|---|---|---|

| DeepSeek | 知识边界、不编造引用、区分事实与推测、避免绝对化、回答结构 | 当次问题 + 时间/范围限定 + 必要时「请标注不确定」 |

| Coze | 同上;因智能体多轮共享,强烈建议在「角色设定」中写清上述规范 | 具体业务问题 + 若需严格事实可加「仅基于以下信息回答」并粘贴材料 |

| 豆包 | 同上;在「对话设定」中固定,减少每次重复 | 当次问题 + 临时约束(如「仅 2023 年前」) |

| 千问 | 同上;在「系统设定」中固定 | 当次问题 + 临时约束 |

| ChatGPT | 在「自定义指令」中写同上规范,对所有新对话生效 | 当次问题 + 高敏感话题时加「请标注不确定或需核实之处」 |

这样可以在不换产品 的前提下,系统性地从系统提示词 和用户提示词两层同时减幻觉;系统层管「默认行为」,用户层管「这一问的严格程度」。

五、从幻觉角度对比五款产品

下面仅从幻觉这一维度,对 DeepSeek、Coze、豆包、千问、ChatGPT 做对比,便于按「谁更稳、谁更易控、谁更适合高事实要求场景」做选择。

说明:Coze 是智能体平台,背后可接多种模型(含豆包、千问、DeepSeek 等),其幻觉表现取决于所选模型;此处把 Coze 作为「产品形态」单独看------即从「用智能体时幻觉如何控」的角度分析。

1. 幻觉相关维度总表

| 产品 | 文档内实测幻觉率(参考) | 产品形态与幻觉风险 | 内置减幻觉能力 | 用户可配置程度 | 从幻觉角度的简要结论 |

|---|---|---|---|---|---|

| DeepSeek | 通用 2%;事实性 29.67%(V3)/ 22.33%(R1);联网后事实性可降至约 24.67%(V3)/ 19%(R1) | 纯对话/API,无默认联网时依赖模型自身知识,易在冷门事实、引用、时效上幻觉 | 可选联网搜索;R1 有思维链,部分任务上幻觉率低于 V3(如摘要任务 Vectara 数据) | 支持系统提示词(API/部分入口);用户提示词每轮自由 | 事实性幻觉率偏高,建议高事实场景必开联网或配合系统提示词约束;R1 在部分任务上更稳 |

| Coze(扣子) | 取决于接入模型(见豆包/千问/DeepSeek 等) | 智能体:多轮、可挂知识库/插件,若未绑定可靠数据源则仍以模型自由生成为主,存在引用与事实幻觉风险 | 可配置知识库、搜索插件、工作流,用 RAG 或实时检索可显著减幻觉 | 系统提示词(角色设定)一次设定全对话生效,便于写死「不编造引用」「标注不确定」等 | 幻觉取决于底层模型+是否用知识库/插件;善用系统提示词+知识库可把幻觉控得较好 |

| 豆包 | 通用 0%;事实性 19%;文档中事实性幻觉率最低 | 对话/API,国内产品,合规与安全约束相对紧,回答偏保守 | 支持联网;部分场景有引用或来源提示 | 有对话设定/系统指令;用户提示词每轮自由 | 在本文档评测中事实性幻觉率最低,适合对事实要求高、又希望少折腾的用户;仍建议重要结论核对信源 |

| 千问(通义) | 通用 2%;事实性 27.67% | 对话/API,能力均衡,事实性幻觉率介于 DeepSeek 与豆包之间 | 支持联网与引用;可接 RAG 等企业能力 | 有系统设定;用户提示词每轮自由 | 事实性幻觉率中等,适合通用场景;高事实场景建议开联网或加系统/用户提示词约束 |

| ChatGPT | 文档内未做同口径评测,仅作定性参考 | 对话/API/Plus 等,海外模型,知识面与推理强,但引用与时效类幻觉仍常见 | 联网搜索(如 Browse);Plus 可引用;API 可接自有 RAG | 自定义指令(系统层)+ 用户提示词;可控性高 | 能力全面但仍有幻觉,尤其引用与时效;建议用自定义指令固定「不编造来源」「标注不确定」,关键事实用联网或自有数据校验 |

2. 分产品从幻觉角度的要点

| 产品 | 幻觉上的主要特点 | 更适合的场景 | 使用建议(减幻觉) |

|---|---|---|---|

| DeepSeek | 事实性幻觉率在本文档评测中较高;R1 有思维链,部分任务(如摘要)幻觉率反升,需按任务选模型;联网后明显下降 | 需要强推理、代码、长文,且可接受「重要事实再核实」的场景 | 高事实需求时开联网;系统提示词写清「不编造引用」「不确定请说明」;敏感结论用另一模型或信源交叉验证 |

| Coze | 幻觉由底层模型+是否用知识库/插件决定;同一智能体可被大量用户调用,系统提示词写错或未写会放大幻觉影响 | 客服、问答、流程类智能体;需稳定话术与可控输出的业务 | 在「角色设定」里写死减幻觉规则;能上知识库的尽量上,用 RAG 约束回答范围;对引用类回复可加插件做事后校验 |

| 豆包 | 在本文档两项评测中幻觉率都较低(通用 0%、事实性 19%),相对「稳」 | 对事实准确率要求高、希望开箱即用的日常与轻度专业场景 | 继续保持「重要结论核对信源」的习惯;可在系统设定中加「不确定时说明」,进一步压低自信错误 |

| 千问 | 事实性幻觉率中等,能力均衡;联网与引用能缓解时效与引用类幻觉 | 通用写作、分析、编程;国内生态与 API 集成 | 高事实场景开联网或限定时间范围;系统设定中写入不编造引用、区分事实与推测 |

| ChatGPT | 未在本文档做同口径幻觉率测试;经验上引用与时效类幻觉常见,自定义指令可全局约束 | 需要强能力与高可控性的国际/多语言场景;可配合自有 RAG | 自定义指令中写入减幻觉规范;关键事实用联网或自有数据验证;对论文/数据类回答养成「查原文」习惯 |

3. 按「对幻觉的容忍度」选产品(参考)

| 需求 | 更合适的产品(从幻觉角度) |

|---|---|

| 希望事实性幻觉率尽量低、少配置 | 豆包(文档中事实性 19% 最低;通用 0%) |

| 需要强推理/代码,可接受事实再核实 | DeepSeek(建议开联网+系统提示词约束) |

| 做智能体、需统一约束多轮对话 | Coze(系统提示词+知识库/插件) |

| 通用兼顾、中等幻觉率、国内生态 | 千问(建议开联网+系统设定) |

| 要强能力+高可控、可接受自行配置 | ChatGPT(自定义指令+联网/自有数据校验) |

以上均仅从幻觉维度做对比;实际选型还需结合能力、生态、合规与成本综合判断。

4. 扩展:按截图模型逐一分析(幻觉 + 适用场景)

以下按截图中的每一个模型单独列出:幻觉表现、适用场景、减幻觉要点,不做合并。无单独公开数据的型号,按同族与版本命名(如 Fast / Codex / High / Max / Mini)推断其定位并给出建议。

4.1 Composer 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Composer 1.5 | 多模态作曲/生成类产品,创意输出为主;事实性陈述若涉及人名、作品、年代时存在编造风险。 | 音乐/内容创作、创意草稿、多模态编排。 | 涉及真实人物、作品、年代时在提示中要求「仅列已知事实」或事后查证。 |

| Composer 1 | 同族前代,能力与约束通常弱于 1.5;创意场景幻觉容忍度相对高,事实性陈述需更谨慎。 | 早期创意探索、非正式作曲与内容试验。 | 同上;重要署名与版权相关事实务必人工核对。 |

4.2 Opus 系列(Claude)

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Opus 4.6 | 多轮幻觉基准 HALLUHARD 无联网约 60%、联网约 30%;强推理与长上下文,引用与时效类幻觉常见。 | 长文档分析、复杂策略、法律/研报草稿、强推理写作。 | 开启联网;提示中要求「先依据后结论」「标注推测与未核实」。 |

| Opus 4.6 Max | 同族顶配,能力最强、参数与成本更高;幻觉特性与 Opus 4.6 相近,复杂开放域仍建议联网。 | 极高复杂度分析、长报告、多步决策、研究辅助。 | 与 Opus 4.6 相同;关键结论建议双源或人工抽检。 |

| Opus 4.6 Fast(MAX Only) | 速度优化版,响应更快;在事实性与引用上幻觉风险与 4.6 相当,长链推理略弱。 | 需要快速响应的长文档与策略讨论、实时协作。 | 同上;若回答涉及具体数据与引用,建议用非 Fast 版本复核。 |

| Opus 4.6 Max Fast(MAX Only) | Max 能力 + 速度优化;幻觉表现接近 4.6 Max,适合对延迟敏感的高要求场景。 | 高要求且对延迟敏感的分析、报告、决策支持。 | 关键事实与引用仍建议联网或二次核实。 |

| Opus 4.5 | 前代 Opus,能力略低于 4.6;多轮与开放域幻觉率偏高,医学/法律等仅作参考。 | 长文分析、复杂写作、需强推理的通用场景。 | 建议开联网;敏感领域明确「仅供参考、需专业核实」。 |

4.3 Sonnet 系列(Claude)

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Sonnet 4.5 | METR 等评估存在幻觉与细微错误;速度与成本较 Opus 友好,事实与引用需留意。 | 日常助手、代码补全与审查、客服、中等复杂度分析。 | 系统提示词约束知识边界与引用;关键事实用 Opus 或人工复核。 |

| Sonnet 4 | 同族前代,能力略低于 4.5;简单任务稳定,复杂事实与长链推理幻觉风险增加。 | 日常问答、轻量代码、模板与邮件、简单分析。 | 限定使用范围;涉及专业事实时标注「需核实」或换用更强型号。 |

| Sonnet 4 1M MAX Only | 1M 上下文顶配版,长文档能力强;长上下文内事实一致性需注意,结尾与前文矛盾偶发。 | 超长文档阅读、全书/长报告摘要、跨文档比对。 | 提示中要求「仅基于文档内容」「引用原文段落」;关键结论做抽检。 |

4.4 GPT-5.3 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| GPT-5.3 Codex | 代码向优化;代码逻辑与 API 幻觉少于通用事实,但复杂依赖与版本信息仍可能编造。 | 代码生成、重构、单元测试、代码审查。 | 关键逻辑与依赖版本人工复核;系统提示词要求「不确定的 API/版本请标注」。 |

| GPT-5.3 Codex Low | 资源/成本优化,能力略低于标准 Codex;代码简单任务够用,复杂逻辑幻觉风险略高。 | 简单脚本、补全、教学示例、轻量代码任务。 | 仅用于低风险代码;生产逻辑建议用标准或 High 版本。 |

| GPT-5.3 Codex High | 高能力代码向;复杂项目与架构设计更稳,幻觉仍可能出现在冷门库与文档上。 | 复杂项目架构、多文件重构、技术方案设计。 | 关键架构决策与冷门库用法建议查官方文档或人工确认。 |

| GPT-5.3 Codex Extra High | 顶配代码向;能力最强,幻觉率相对最低,仍建议对安全与合规相关代码做复核。 | 大型代码库、安全敏感代码、复杂系统设计。 | 安全与合规相关必须人工审查;其余同 Codex High。 |

| GPT-5.3 Codex Fast | 速度优先;响应快,复杂推理与长链事实略弱,简单代码与问答够用。 | 实时补全、交互式编程、简单问答与脚本。 | 复杂事实与长逻辑用非 Fast 或联网核实。 |

| GPT-5.3 Codex Low Fast | 低资源 + 快速;适合轻量、高并发场景,复杂任务幻觉风险最高。 | 批量简单任务、教学演示、对延迟敏感的低复杂度请求。 | 仅用于可接受容错的场景;重要输出换更强型号。 |

| GPT-5.3 Codex High Fast | 高能力 + 速度;在速度与准确性之间折中,代码与事实均优于 Low Fast。 | 需要较快响应的代码审查、方案草稿、中等复杂度分析。 | 关键结论与引用仍建议二次确认。 |

| GPT-5.3 Codex Extra High Fast | 顶配 + 速度;在 Fast 系列中幻觉率最低,适合高要求且对延迟有要求的场景。 | 高要求代码/分析且需快速响应的场景。 | 与 Extra High 类似,关键处人工复核。 |

4.5 GPT-5.2 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| GPT-5.2 | 通用基座;文献中 GPT-4 级模型医学引用幻觉约 28.6%,事实与引用需校验。 | 通用对话、写作、分析、中等复杂度推理。 | 自定义指令「不编造引用」「不确定请标注」;关键事实联网或查证。 |

| GPT-5.2 Low | 资源/成本优化;简单任务稳定,复杂事实与长推理幻觉风险高于标准版。 | 简单问答、模板生成、轻量分析、成本敏感场景。 | 重要结论不用 Low 单独做依据;可作初稿再交强模型复核。 |

| GPT-5.2 Fast | 速度优先;响应快,复杂事实与长链略弱。 | 实时对话、简单查询、快速草稿。 | 涉及数据与引用时用标准版或联网核实。 |

| GPT-5.2 High | 高能力版;复杂分析与长文更稳,幻觉率低于 Low/Fast。 | 复杂分析、长文写作、多步推理、报告草稿。 | 同 GPT-5.2;敏感领域双源验证。 |

| GPT-5.2 Extra High | 顶配通用;能力最强,幻觉率在 5.2 系列中最低。 | 研究辅助、法律/金融分析、高要求长文与决策支持。 | 关键事实与引用仍建议查证或人工抽检。 |

| GPT-5.2 High Fast | 高能力 + 速度;在延迟与准确性间折中。 | 需要较快响应的高质量分析、会议纪要、方案对比。 | 关键数据与引用二次确认。 |

| GPT-5.2 Extra High Fast | 顶配 + 速度;Fast 系列中最稳。 | 高要求且对延迟敏感的分析与写作。 | 同上。 |

| GPT-5.2 Low Fast | 低资源 + 快速;简单任务够用,复杂事实幻觉风险高。 | 大批量简单任务、教学、对成本与延迟敏感场景。 | 仅用于低风险;重要输出换更强型号。 |

| GPT-5.2 Codex | 代码向 5.2;代码幻觉少于通用事实,冷门库与版本仍可能出错。 | 代码生成、审查、脚本与自动化。 | 关键逻辑与依赖人工复核;系统提示词约束 API/版本表述。 |

| GPT-5.2 Codex High | 高能力代码向;复杂项目更稳。 | 多文件项目、架构设计、技术方案。 | 同 Codex;关键架构与安全相关必须复核。 |

| GPT-5.2 Codex Low | 代码向低成本;简单代码够用,复杂逻辑幻觉略高。 | 简单脚本、示例代码、教学。 | 生产与关键逻辑用 High 或 5.3 Codex。 |

| GPT-5.2 Codex Low Fast | 代码向 + 低资源 + 快速;适合轻量、高并发代码任务。 | 简单补全、批量示例、对延迟敏感的低复杂度代码。 | 仅用于可接受容错;重要代码换更强型号。 |

| GPT-5.2 Codex Extra High | 顶配代码向 5.2;代码任务幻觉率最低。 | 大型代码库、安全敏感、复杂系统。 | 安全与合规代码必须人工审查。 |

| GPT-5.2 Codex Fast | 代码向 + 速度;响应快,复杂逻辑略弱。 | 实时补全、交互式编程、简单重构。 | 复杂逻辑与依赖用非 Fast 或人工确认。 |

| GPT-5.2 Codex High Fast | 代码向高能力 + 速度;折中性能与延迟。 | 需要较快响应的代码审查与方案草稿。 | 关键结论与 API 用法二次确认。 |

4.6 GPT-5.1 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| GPT-5.1 Codex Max | 代码向 Max 能力;复杂代码与架构更稳,冷门库与文档仍可能幻觉。 | 大型代码项目、架构设计、跨模块重构。 | 关键依赖与安全相关人工复核。 |

| GPT-5.1 Codex Max High | Max 高能力;在 Max 系列中偏重复杂任务。 | 高复杂度代码与架构、技术方案评审。 | 同上。 |

| GPT-5.1 Codex Max Low | Max 低成本;能力与稳定性低于 Max High,简单代码为主。 | 简单到中等代码、教学、成本敏感场景。 | 重要逻辑用 Max High 或 Extra High。 |

| GPT-5.1 Codex Max Extra High | Max 顶配;代码任务幻觉率在 5.1 系列最低。 | 安全敏感、大型系统、高要求代码评审。 | 安全与合规必须人工审查。 |

| GPT-5.1 Codex Max Medium Fast | Max + 中速;在速度与能力间折中。 | 需要一定速度的代码审查与方案讨论。 | 关键处二次确认。 |

| GPT-5.1 Codex Max High Fast | Max 高能力 + 速度;较快且较稳。 | 高要求且对延迟敏感的代码与分析。 | 同上。 |

| GPT-5.1 Codex Max Low Fast | Max + 低成本 + 快速;适合轻量高并发。 | 简单代码批量处理、教学演示。 | 仅用于低风险;重要输出换更强型号。 |

| GPT-5.1 Codex Max Extra High Fast | Max 顶配 + 速度;Fast 系列最稳。 | 高要求代码/分析且需快速响应。 | 关键结论与安全相关复核。 |

| GPT-5.1 High | 通用高能力 5.1;复杂分析优于标准 5.1,事实与引用仍建议校验。 | 复杂分析、长文、多步推理、报告。 | 自定义指令 + 关键事实联网或查证。 |

| GPT-5.1 Codex Mini | 代码向轻量;响应快、成本低,复杂逻辑幻觉风险高。 | 简单补全、示例、教学、轻量脚本。 | 仅用于非关键代码;生产逻辑用更大型号。 |

| GPT-5.1 Codex Mini High | Mini 高能力;在 Mini 系列中更稳。 | 轻量项目、教学中的稍复杂示例。 | 关键逻辑仍建议用标准 Codex 复核。 |

| GPT-5.1 Codex Mini Low | Mini 低成本;能力最低,适合极简单任务。 | 极简单补全、批量示例、对成本极度敏感。 | 不用于任何关键或生产逻辑。 |

4.7 GPT-5 Mini

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| GPT-5 Mini | 轻量通用;简单问答尚可,复杂事实与长链推理幻觉风险明显高于 5.1/5.2。 | 简单问答、模板、快速草稿、高并发低成本场景。 | 仅用于低风险、可接受容错;重要结论与事实用更大模型或联网核实。 |

4.8 Gemini 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Gemini 3 Pro | 多模态与推理强;部分评测与报道指出编造名称、论文、链接等,事实一致性需配合检索。 | 多模态理解、复杂推理、长文档、研究辅助。 | 关键事实配合搜索/引用;提示中「仅基于检索结果」「标注未核实」。 |

| Gemini 3 Flash | 速度优化;响应快,多模态能力强,事实性幻觉略多于 Pro。 | 实时多模态、快速摘要、创意草稿、搜索增强问答。 | 同上;涉及具体名称与链接务必查证。 |

| Gemini 2.5 Flash | 前代 Flash 升级;速度与多模态兼顾,事实与引用需留意。 | 快速多模态任务、对话、轻量分析。 | 关键信息标注来源或二次检索。 |

4.9 GLM 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| GLM-4.7 | 部分评测(如 HHEM-2.1-Open)中 GLM-4 事实一致性约 98.7%、幻觉率约 1.3%;7 系为更新版本,可预期相近或更优。 | 通用对话、知识问答、代码、需高事实一致性的中文场景。 | 系统提示词约束引用与边界;重要决策仍建议抽检或双源比对。 |

4.10 Haiku 系列(Claude)

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Haiku 4.5 | 轻量高速;简单任务稳定,深度推理与复杂事实幻觉风险高于 Sonnet/Opus。 | 实时客服、简单问答、模板生成、轻量代码编辑、高并发。 | 仅用于低风险、可接受容错;重要结论改用 Sonnet/Opus 或人工确认。 |

4.11 Grok 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Grok Code | 代码向;报道 Grok 4.1 幻觉率约 4%,Code 变体侧重代码,逻辑与 API 幻觉少于通用事实。 | 代码生成、审查、脚本、与 X 生态结合的开发场景。 | 关键逻辑与依赖版本人工复核;可配合实时搜索查文档。 |

4.12 Kimi 系列

| 模型 | 幻觉表现 | 适用场景 | 减幻觉要点 |

|---|---|---|---|

| Kimi K2 | 长上下文与 Agent 强;公开幻觉率数据少,长文本与多步推理需注意事实一致性与前后矛盾。 | 超长文档对话、多步 Agent、代码生成、复杂规划与阅读。 | 明确任务范围与文档边界;要求「引用文档内原文」或「标注不确定」;关键事实抽检。 |

4.13 截图中所有模型与所属公司一览

| 模型 | 所属公司 | 公司英文/备注 |

|---|---|---|

| Composer 1.5、Composer 1 | 安谋(Anthropic) | Claude 同厂,多模态/创作向产品 |

| Opus 4.6、Opus 4.6 Max、Opus 4.6 Fast、Opus 4.6 Max Fast、Opus 4.5 | 安谋(Anthropic) | Claude 顶配与速度变体 |

| Sonnet 4.5、Sonnet 4、Sonnet 4 1M MAX Only | 安谋(Anthropic) | Claude 平衡型与长上下文 |

| Haiku 4.5 | 安谋(Anthropic) | Claude 轻量高速线 |

| GPT-5.3 Codex 全系列(含 Low/High/Extra High/Fast 等) | 开放人工智能(OpenAI) | ChatGPT 同厂,代码与通用 |

| GPT-5.2、GPT-5.2 全系列(含 Low/Fast/High/Codex 等) | 开放人工智能(OpenAI) | 同上 |

| GPT-5.1 Codex Max/Mini 全系列、GPT-5.1 High | 开放人工智能(OpenAI) | 同上 |

| GPT-5 Mini | 开放人工智能(OpenAI) | 轻量线 |

| Gemini 3 Pro、Gemini 3 Flash、Gemini 2.5 Flash | 谷歌(Google) | 多模态与搜索增强 |

| GLM-4.7 | 智谱 AI(Zhipu) | 国产,通用与代码 |

| Grok Code | xAI | 马斯克旗下,代码向 + X 生态 |

| Kimi K2 | 月之暗面(Moonshot) | 国产,长上下文与 Agent |

五(补充)、按公司归纳与特长分析

以下按公司 维度,归纳截图中所涉模型,并总结各公司在能力、场景与减幻觉上的特长,便于从厂商视角选型。

1. 安谋(Anthropic)

| 项目 | 内容 |

|---|---|

| 截图内模型 | Composer 1 / 1.5,Opus 4.5 / 4.6 / 4.6 Max / 4.6 Fast / 4.6 Max Fast,Sonnet 4 / 4.5 / 4 1M MAX Only,Haiku 4.5 |

| 产品线 | Claude 家族(Opus / Sonnet / Haiku)+ Composer(多模态/创作) |

| 公司特长 | 长上下文与安全对齐 :长文档、多轮对话、合规与安全约束强;分层能力 :Opus 顶配推理与写作,Sonnet 平衡成本与能力,Haiku 高并发与简单任务;减幻觉:多轮与开放域幻觉率偏高(如 HALLUHARD 无联网约 60%),联网可显著下降,适合「联网 + 提示词约束」组合。 |

| 更适合的场景 | 长报告、法律/研报草稿、复杂策略、代码审查、需强安全与合规的对话;Composer 偏创意与多模态编排。 |

2. 开放人工智能(OpenAI)

| 项目 | 内容 |

|---|---|

| 截图内模型 | GPT-5.3 Codex 全系列,GPT-5.2 全系列,GPT-5.1 Codex Max/Mini 全系列、GPT-5.1 High,GPT-5 Mini |

| 产品线 | GPT 通用 + Codex 代码向;按能力分 Low / High / Extra High,按速度分标准 / Fast,按规模分 Mini / 标准 / Max |

| 公司特长 | 型号最细 :同一代内多档能力与速度(Low / High / Extra High / Fast / Codex / Mini / Max),便于按成本与延迟精细选型;代码生态 :Codex 线覆盖从简单补全到大型架构;事实与引用:文献显示 GPT-4 级自检与引用优于前代,但医学/引用类幻觉仍存在,需配合自定义指令与联网。 |

| 更适合的场景 | 通用写作、分析、代码生成与审查、API 与产品集成;Mini 与 Low/Fast 适合高并发与成本敏感场景,Extra High / Max 适合高要求与安全敏感场景。 |

3. 谷歌(Google)

| 项目 | 内容 |

|---|---|

| 截图内模型 | Gemini 3 Pro、Gemini 3 Flash、Gemini 2.5 Flash |

| 产品线 | Gemini Pro(能力型)/ Flash(速度与多模态) |

| 公司特长 | 多模态与搜索 :图文音视频与搜索增强结合紧密,适合「检索 + 生成」;事实一致性:部分评测与报道指出编造名称、论文、链接等问题,建议关键信息配合搜索与引用、并标注未核实。 |

| 更适合的场景 | 多模态理解、搜索增强问答、创意与草稿、跨模态摘要;对事实要求高的场景需显式启用检索并做结果校验。 |

4. 智谱 AI(Zhipu,智谱)

| 项目 | 内容 |

|---|---|

| 截图内模型 | GLM-4.7 |

| 产品线 | GLM 通用大模型系列 |

| 公司特长 | 中文事实性 :部分评测(如 HHEM-2.1-Open)中事实一致性约 98.7%、幻觉率约 1.3%,适合对事实要求高的中文场景;通用与代码:对话、知识问答、代码均有覆盖。 |

| 更适合的场景 | 中文通用对话、知识问答、代码辅助、需高事实一致性的国内业务与 API 集成。 |

5. xAI

| 项目 | 内容 |

|---|---|

| 截图内模型 | Grok Code |

| 产品线 | Grok 通用 + Code 代码向,与 X(Twitter)深度集成 |

| 公司特长 | 实时信息与社交语境 :报道 Grok 4.1 幻觉率约 4%,支持实时搜索(X 与网页),适合时效与舆情;代码向:Grok Code 侧重代码,逻辑与 API 幻觉少于通用事实。 |

| 更适合的场景 | 实时热点、舆情与社交语境理解、搜索增强问答、代码生成与审查、与 X 生态结合的开发。 |

6. 月之暗面(Moonshot)

| 项目 | 内容 |

|---|---|

| 截图内模型 | Kimi K2 |

| 产品线 | Kimi 长上下文与 Agent 产品线 |

| 公司特长 | 超长上下文与 Agent :长文档对话、多步规划与执行能力强;代码与复杂任务:表现突出;公开幻觉率数据较少,长文本与多步推理需注意事实一致性与前后一致。 |

| 更适合的场景 | 超长文档阅读与问答、多步 Agent、代码生成、复杂规划与阅读;建议明确任务范围并要求引用文档内原文或标注不确定。 |

按公司特长小结(幻觉与场景)

| 公司 | 幻觉相关特长 | 场景特长 |

|---|---|---|

| Anthropic | 联网可显著降多轮幻觉;安全与合规约束强,适合对输出可控性要求高的场景。 | 长文档、复杂推理、法律/研报草稿、代码审查、分层成本选型。 |

| OpenAI | 型号细分多,可按任务选 Low/High/Fast 平衡幻觉与成本;自定义指令 + 联网可系统减幻觉。 | 通用与代码全覆盖、API 生态、高并发与高要求场景均有对应型号。 |

| 多模态 + 搜索增强,适合用检索补足事实;需主动启用检索并标注未核实。 | 多模态、搜索增强问答、创意与跨模态任务。 | |

| 智谱 | 中文事实性与低幻觉率在部分评测中突出,适合高事实要求的中文场景。 | 中文对话、知识问答、代码、国内合规与集成。 |

| xAI | 幻觉率在报道中较低(约 4%),实时搜索利于时效性事实。 | 实时信息、舆情、社交语境、代码、X 生态。 |

| 月之暗面 | 长上下文与 Agent 强,幻觉控制依赖提示词约束与引用文档内内容。 | 超长文档、多步 Agent、复杂规划与阅读。 |

六(补充)、各模型在不同产品与插件中的应用

下面按产品/插件 维度,说明截图中涉及的模型(以及文档前文中的 DeepSeek、豆包、千问等)在各类应用中的落地方式,并简要提示在幻觉 与使用场景上的注意点。同一模型在不同产品中能力一致,但交互方式、是否联网、是否有系统提示词可配等会影响实际幻觉表现。

6.1 总表:产品/插件 ↔ 可用模型与幻觉注意

| 产品/插件 | 可用或常见模型 | 典型用途 | 幻觉相关注意 |

|---|---|---|---|

| Cursor | Claude(Opus/Sonnet/Haiku)、GPT(含 Codex 等)、Gemini、DeepSeek、部分开源模型等,可切换 | IDE 内代码补全、对话、重构、解释代码、多文件编辑 | 代码与 API 幻觉:依赖版本、冷门库易出错;可在 Cursor 规则或对话中要求「不确定的 API 标注」、关键逻辑人工复核 |

| Claude(官网/App/桌面) | Opus、Sonnet、Haiku(含 4.5、4.6、1M 等),按订阅可选不同型号 | 长文档分析、写作、代码、通用对话、联网搜索 | 多轮与开放域幻觉率偏高,建议开联网;系统提示词有限,可每轮在用户提示中加「标注推测与未核实」 |

| ChatGPT(Web/App/Plus) | GPT-4 / GPT-5 系列(含 Codex、Fast、High 等)、GPT-5 Mini 等 | 对话、写作、代码、分析、浏览联网、自定义指令 | 自定义指令可全局减幻觉;引用与时效类建议用浏览或自有数据校验 |

| Coze(扣子) | 可接入豆包、千问、DeepSeek、GPT、Claude、Kimi、GLM 等,按创建时选择 | 智能体、客服机器人、知识库问答、工作流、多轮对话 | 幻觉由所选模型 + 知识库/RAG 决定;必配知识库与角色设定中的「不编造、仅依据知识库」 |

| GitHub Copilot(含 VS Code 等) | 以 OpenAI Codex/GPT 系列为主,部分场景有自有模型 | 代码补全、注释、单元测试、解释代码 | 代码与依赖版本易幻觉;关键逻辑与安全相关代码需人工审查 |

| VS Code 其他插件 | Codeium、Amazon Q、Continue、Windsurf 等可接 Claude、GPT、开源模型 | 补全、对话、终端解释、文档生成 | 同上;不同插件可切换模型,高事实要求时可选更稳型号并加提示约束 |

| Windsurf / Codeium 等 AI IDE | Claude、GPT、Gemini、DeepSeek、GLM、Kimi 等,多模型可选 | 代码生成、多文件编辑、对话、文档 | 与 Cursor 类似;选型与提示词决定幻觉表现,代码结论建议复核 |

| 豆包(Web/App/API) | 豆包自研模型 | 对话、写作、客服、金融/医疗等垂直场景 | 事实性幻觉率在文档评测中较低;重要结论仍建议核对信源 |

| 通义千问 / 阿里云 | 千问系列 | 长文档、知识库、API、企业集成 | 事实性中等,建议开联网或 RAG;系统设定中约束引用与时间范围 |

| Kimi(Web/App/API) | Kimi K2 等 | 长文档、Agent、代码、复杂规划 | 长上下文与多步需注意事实一致;提示中要求引用文档内原文或标注不确定 |

| 智谱/GLM 开放平台 | GLM-4.7 等 | 对话、代码、知识问答、API | 部分评测事实一致性好;重要决策建议抽检或双源比对 |

| Grok(X 平台内) | Grok、Grok Code | 实时搜索、舆情、代码、社交语境 | 实时搜索可降时效类幻觉;非实时或边缘话题建议标注来源 |

| Notion AI、Slack AI 等 | 多为 OpenAI 或合作方模型(具体型号随产品更新) | 文档总结、续写、翻译、会议要点 | 依赖产品是否支持联网/引用;敏感事实建议导出后三角验证 |

| 浏览器插件(如 ChatGPT for Google、Claude 侧栏等) | 随插件绑定(GPT、Claude 等) | 网页旁问答、总结、翻译 | 上下文限于当前页或会话,易对页面外事实幻觉;可提示「仅基于当前页面」 |

| API / 自建应用 | 任意支持 API 的模型(GPT、Claude、Gemini、DeepSeek、豆包、千问、GLM、Kimi 等) | 自有产品内嵌对话、代码、分析 | 幻觉完全由所选模型 + 系统提示词 + 是否接 RAG/检索决定;可统一在系统提示词中写减幻觉规则 |

6.2 按产品/插件简要说明

- Cursor:多模型可选(Claude、GPT、Gemini、DeepSeek 等),适合在 IDE 内做代码与文档。幻觉主要来自代码与 API;可通过项目规则或对话要求「不确定处标注」、关键逻辑与依赖版本人工复核。高事实要求的代码建议选 Codex High/Extra High 或 Claude Sonnet/Opus 并开检索(若支持)。

- Claude(官网/App):仅用 Anthropic 自家 Opus/Sonnet/Haiku,长文档与安全对齐强。多轮幻觉率偏高,建议开启联网并在提示中要求「先依据后结论、标注推测」。适合长报告、法律/研报草稿、代码审查。

- ChatGPT:仅用 OpenAI GPT 系列(含 Codex、Fast、Mini 等)。自定义指令对减幻觉有效;敏感事实用浏览或自有数据校验。适合通用写作、分析、代码及需要强可控性的场景。

- Coze(扣子):不绑定单一模型,可接豆包、千问、DeepSeek、GPT、Claude、Kimi、GLM 等。幻觉取决于所选模型 + 是否挂知识库/RAG;建议每个智能体都配知识库并在角色设定中写「不编造、仅依据知识库/检索结果」。适合客服、问答、流程类智能体。

- GitHub Copilot / VS Code 插件:以 GPT/Codex 为主,部分插件可切换 Claude、DeepSeek 等。代码与依赖版本易幻觉,关键与安全相关代码必须人工审查。适合日常补全与草稿,高要求代码用更强型号或 Cursor 多模型对比。

- 豆包、千问、Kimi、GLM、Grok:各在自家 Web/App/API 中使用对应模型;幻觉与场景特点见前文分模型与按公司分析。在 Cursor、Coze 等中若被选为底层模型,则上述特点会体现在该产品中。

- Notion AI、Slack AI、浏览器插件:多为封装好的模型能力,用户通常不能改系统提示词;减幻觉依赖用户提示(如「仅基于当前文档/页面」「标注未核实」)以及事后三角验证。

- API / 自建应用:任意模型均可接入;幻觉控制完全由选型、系统提示词、RAG/检索与人工流程决定,可按前文「按公司/按模型」的减幻觉要点在系统提示词中统一约束。

6.3 小结:按使用场景选产品与模型(含幻觉)

| 使用场景 | 可优先考虑的产品/插件 | 可优先考虑的模型 | 减幻觉要点 |

|---|---|---|---|

| IDE 内代码、多文件编辑 | Cursor、Windsurf、VS Code + Copilot/Codeium | Claude Sonnet/Opus、GPT-5.x Codex High/Extra High、DeepSeek | 规则/提示中要求标注不确定 API;关键逻辑人工复核 |

| 长文档、复杂推理、写作 | Claude、ChatGPT、Kimi | Opus 4.6、GPT-5.2 High/Extra High、Kimi K2 | 开联网;提示「标注推测与未核实」 |

| 智能体、客服、知识库问答 | Coze | 豆包、千问、DeepSeek、Claude、GPT 等(按需) | 必配知识库 + 角色设定不编造、仅依据检索 |

| 高事实要求、中文 | 豆包、智谱、千问、Coze+知识库 | 豆包、GLM-4.7、千问 | 系统设定/提示词约束引用;关键结论核对信源 |

| 多模态、搜索增强 | ChatGPT(浏览)、Gemini、Grok | Gemini 3 Pro/Flash、Grok、GPT+浏览 | 关键信息配合检索并标注未核实 |

| 实时信息、舆情 | Grok、X 内产品 | Grok、Grok Code | 开实时搜索;非实时话题标注来源 |

| 自建产品、API 集成 | 任意支持 API 的平台 | 按成本与场景选 GPT/Claude/Gemini/DeepSeek/豆包/千问/GLM/Kimi | 系统提示词统一写减幻觉规则;高事实场景接 RAG/检索 |

总结:如何应对AI幻觉?

- 三角验证法: 交叉比对多个AI回答或权威来源。

- 警惕"过度合理": 越细节丰富的回答越需谨慎(如AI虚构论文标题与作者)。

- 理解幻觉,享受幻觉: 理解幻觉的特点和应对方法,享受幻觉带来的创意灵感。

例子:三角验证时,可对同一问题分别问 DeepSeek、另一款大模型,并查一篇维基或官网;若 AI 给出了「某学者 2022 年在 Nature 发表某标题论文」,应去期刊网站检索标题或 DOI,很多情况下会找不到------即典型的「过度合理」幻觉。

五、AI幻觉的创造力价值

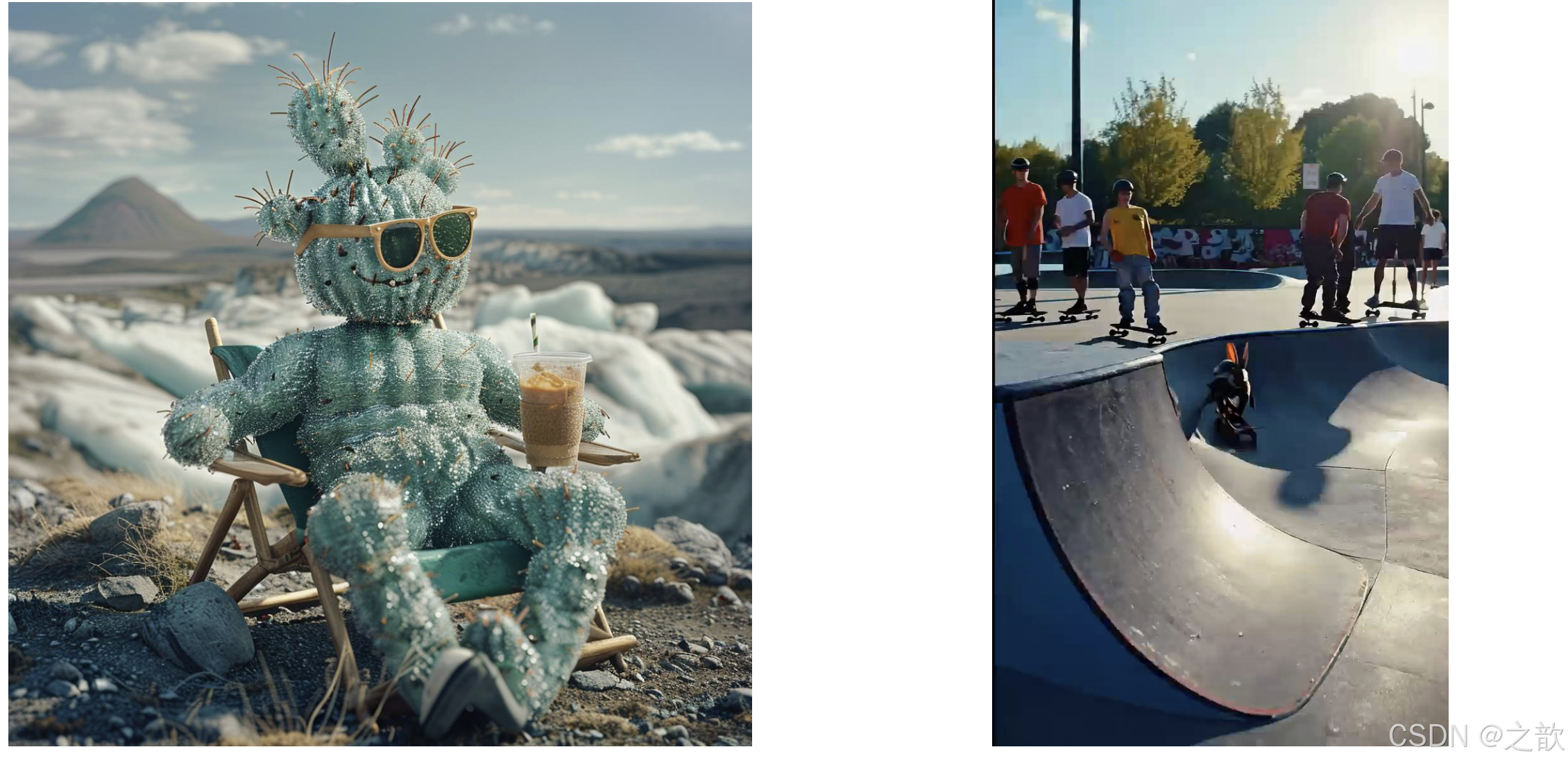

文艺与设计:突破人类思维定式的"超现实引擎"

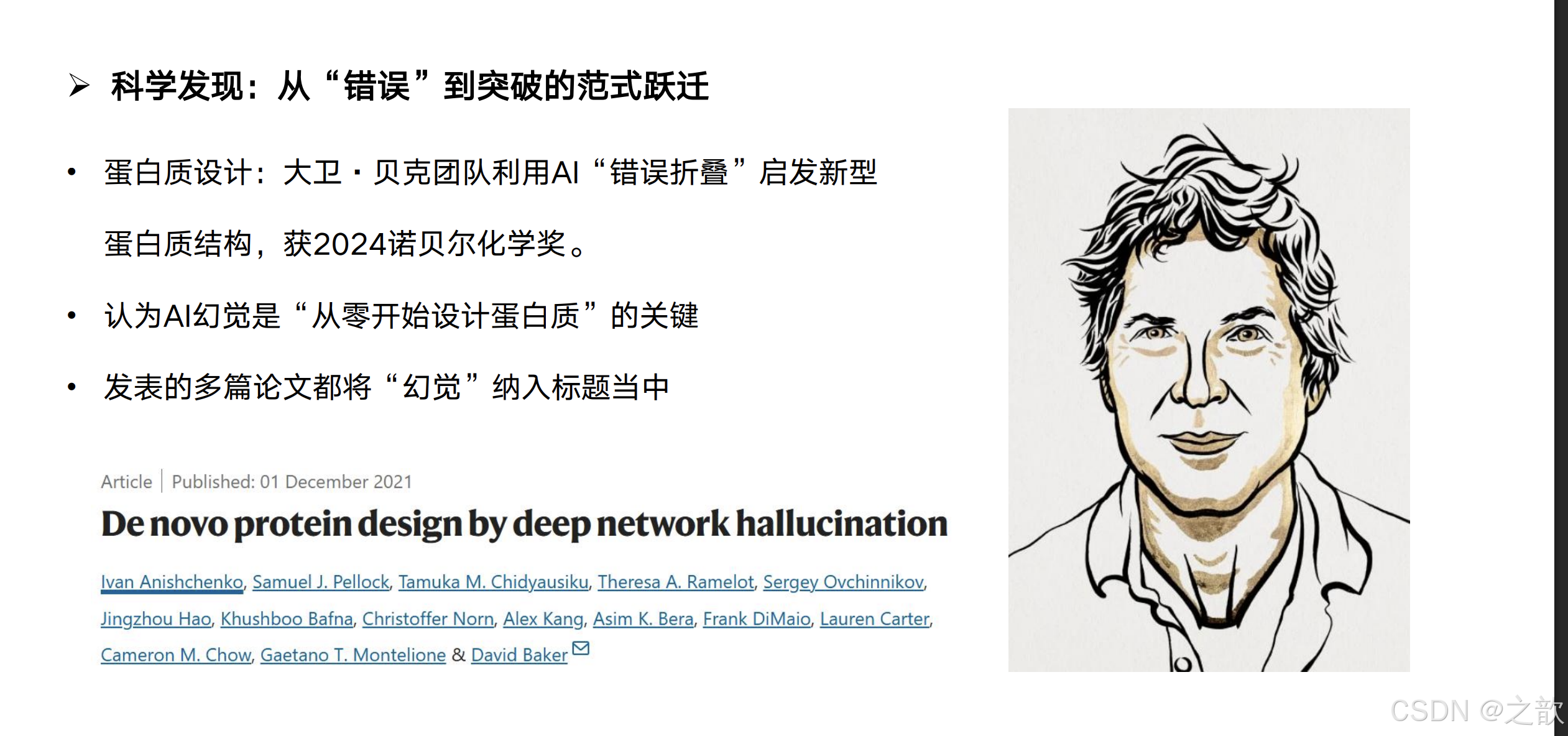

科学发现:从"错误"到突破的范式跃迁

蛋白质设计 大卫贝克团队

AI错误折叠启发新型蛋白质结构

获2024诺贝尔化学奖

多篇论文

将幻觉纳入标题

科学发现

- 蛋白质设计: 大卫·贝克团队利用AI"错误折叠"启发新型蛋白质结构,获2024诺贝尔化学奖。

- 认为AI幻觉是"从零开始设计蛋白质"的关键

- 发表的多篇论文都将"幻觉"纳入标题当中

文艺与设计:突破人类思维定式的"超现实引擎"

AI虚拟环境与角色设计

游戏开发

无限可能性

增强沉浸感

AI幻觉

生成故事对话诗歌

为游戏文学提供灵感

文艺与设计

- AI生成的虚拟环境和角色设计为游戏开发人员提供了无限的可能性,增强了玩家的沉浸感和探索欲

- AI幻觉还被用于生成故事、对话和诗歌,为游戏和文学创作提供灵感

技术创新:从"缺陷"到方法论的转化

AI超现实边界 DeepMind

不符合真实场景

意外提升自动驾驶极端天气识别

新型科研范式

AI幻觉-实验验证-理论重构

加州理工学院团队

AI生成虚构导管设计

新型AI技术优化

细菌数量减少100倍

疯狂创意到理性筛选创新闭环

技术创新

- DeepMind团队发现: AI在图像分割任务中产生的"超现实边界"虽不符合真实场景,却意外提升了自动驾驶系统对极端天气(如浓雾、暴雨)的识别精度。

- 新型科研范式: 科学界正构建"AI幻觉-实验验证-理论重构"的三阶段研究流程。

- 加州理工学院团队: 通过AI生成虚构导管设计,最终通过新型人工智能技术优化后的新设计,在实验中证实将向上游游动的细菌数量减少了100倍,形成"疯狂创意→理性筛选"的创新闭环。

更多创造力侧的例子

- 药物与材料:部分新药/新材料发现流程中,会先用模型生成大量「未必符合既有化学规则」的分子结构,再通过实验筛选,其中不少灵感来自模型在训练边界上的「不合理」输出。

- 创意写作与角色:游戏或网文团队常用 AI 生成角色设定、世界观细节、对白草稿,再由人类筛选和改写;模型给出的「离谱」组合常能激发人类作者原本想不到的方向。

| 行业 | 幻觉的主要坏处 | 幻觉可能的好处 | 使用建议 |

|---|---|---|---|

| 金融 | 研报与数据:编造营收、增速、政策时间等,误导投资与风控,触发合规与声誉风险。归因与归责:将亏损归因于不存在的政策或黑天鹅,扭曲复盘与问责。自动化链路:幻觉进入量化策略、自动报告或监管报送,错误成倍放大。 | 情景与压力测试:在标注为「假设情景」下生成极端情景(如某国违约、某行业崩盘),辅助压力测试与预案。另类观点:生成与主流相反的「反面论点」或「被忽视的风险」,供投研多空校验,不直接采信。 | 涉及具体数字、时间、法规的结论须可追溯至权威信源;创意类仅限情景推演与反面论证,并明确标注非事实。 |

| 医疗 | 诊断与用药:症状被误读或过度推断,给出错误病名、用药或检查建议,可能延误治疗或造成伤害,法律与伦理风险高。文献与指南:虚构文献、篡改指南或统计,误导医患,尤在罕见病、新疗法领域。健康传播:科普中的错误剂量、禁忌组合一旦传播,危害面大。 | 科研假设:在「仅供研究、不用于临床」前提下,非常规病因假设、药物重定位或生物标志物组合可作文献与课题参考。患者沟通:经审核后,用模型生成「多种可能解释」「常见误区」草稿,由医生把关,辅助沟通不替代诊断。 | 任何可能被理解为诊断/用药/检查建议的输出须加免责并引导就医;科研与沟通辅助与临床决策严格隔离。 |

| 法律 | 法条与判例:错误引用法条、司法解释或判例(案号、结论、适用情形),误导当事人预期,增加诉讼与合规风险。法域与时效:混淆法域、失效条款或未生效新法,导致策略错误。格式化文书:合同、律师函含虚构条款或错误表述,影响效力或引发争议。 | 论证与反驳:在已知事实与法条框架内,生成「对方可能主张」「抗辩思路」「不同解释路径」,辅助庭前推演,不作为最终法律意见。条款演绎:对某条款做严格解释/从宽解释等演绎,帮助识别风险,结论须由律师核对法源。 | 法条、判例引用须与权威库或正式文本核对;模型输出仅作思路拓展,不作法律意见或文书定稿依据。 |

| 教育 | 知识讲授:教材、讲义或自动答题中的概念/公式/史实错误,学生记住后纠错成本高。评分与反馈:主观题评分或评语基于错误理解(如误读学生论点),带来公平与信任问题。依赖与惰性:学生习惯「要标准答案」而少独立验证,幻觉强化错误概念。 | 讨论与探究:在「无标准答案」的讨论题、头脑风暴或「错解辨析」中,模型给出多种(含不合理)答案,激发比较与批判思维。多解与变式:数学/物理等生成多种解法或变式题(含部分错解),经教师筛选用于课堂,拓展思路。 | 讲授与标准答案场景优先保证正确性,配合教材与教师审核;讨论与探究可容忍「待辨析」内容,须标明供讨论用。 |

| 创意与内容 | 事实与信源:新闻、传记、科普中的虚构事件、错误数据或捏造引用,损害公信并可能引发法律纠纷。版权与伦理:过度模仿在世人物或受保护风格,可能触及肖像权、著作权与平台规范。一致性与 IP:长篇或系列中人物、时间线、世界观前后矛盾,破坏体验与 IP 管理。 | 意象与风格:诗歌、文案、视觉描述中的非常规比喻、跨界组合或风格混合,适合作初稿或灵感池。情节与角色:小说、剧本、游戏中的离奇情节、反套路人设或对话选项,经人工筛选可丰富创作。多版本与 A/B:同一主题的多种表述、标题或开头,便于 A/B 测试与迭代。 | 事实性内容须核查信源;创意类标明「初稿/灵感」,重要发布前做事实与合规审核,维护角色与世界观文档保证一致性。 |

| 科研与工业 | 实验与工艺:配方、参数、流程若含幻觉,直接照做可能浪费资源、损坏设备或带来安全与环境风险。文献与综述:虚构文献、错误数据或因果污染综述与开题,误导后续研究。自动化控制:幻觉进入工艺控制、质检规则或排产逻辑,可能引发生产事故或批次问题。 | 假设与结构:蛋白质/材料/分子设计中,「不合理」结构或反应路径经计算与实验筛选可转化为真实发现(如诺奖案例)。异常与反例:故障诊断、根因分析中,「不可能但逻辑存在」的假设可拓宽排查范围。概念探索:新兴交叉领域中,术语组合、技术路线图可作讨论起点,再由人类严格验证。 | 实验室与概念阶段可适度利用「非常规」输出做假设生成;工艺、控制或量产阶段参数与逻辑须与权威数据与规程对齐,并做人工或自动复核。 |

| 政务与公共 | 政策解读:错误概括政策适用范围、时间或条件,误导企业与公众,影响合规与公平。虚假信息:应急、选举、公共卫生等场景中幻觉被当官方或事实传播,损害公信与稳定。公平与问责:自动化答复对不同群体不一致或带偏见,引发公平性质疑与问责。 | 情景与预案:内部研讨中用模型生成「若发生某类事件」的多情景推演与预案草稿,部门基于真实数据修订,提高预案覆盖度。多方案比选:对公共议题生成多种政策表述或宣传口径,供决策比选,定稿须经正式程序。 | 对外政策解读与公共信息发布须以权威文本与流程为准,模型仅作内部辅助;可能外泄的结论须经合规与事实核查。 |

| 娱乐与游戏 | 设定与剧情:NPC 对话、任务或主线与既有设定冲突,破坏沉浸感与 IP 一致性,增加修正成本。合规与敏感:涉及暴力、歧视或不当题材未过滤,触及平台规范与法律。用户预期:过度承诺「智能剧情」「无限可能」而幻觉导致逻辑崩坏,引发差评与信任下降。 | 剧情与关卡:分支剧情、随机事件、关卡变体由模型生成初稿,策划筛选与调优,显著扩展内容量。角色与对白:新角色人设、台词风格、互动选项的「脑洞」输出,丰富角色库与玩家体验。运营与本地化:活动文案、多语言、社区话题等事实要求相对宽松,在审核前提下可利用生成效率。 | 建立核心设定与主线「事实库」,生成内容做一致性检查;对用户可见的剧情与对白做内容与合规审核;对「AI 生成」做适当标注以管理预期。 |

结语

AI幻觉像一面棱镜,既折射出技术的局限性,也投射出超越人类想象的可能。与其追求"绝对正确",不如学会与AI的"想象力"共舞------因为最伟大的创新,往往诞生于理性与狂想的交界处。

------DeepSeek R1

AI幻觉的全景图

AI幻觉全景

定义 事实性幻觉与忠实性幻觉

产生原因 数据偏差与泛化等

潜在风险 信息污染与信任危机等

评测 通用性测试与事实性测试等

推理关系 推理增强与幻觉率双向作用

应对方式 联网搜索与双AI验证等

创造力价值 科学发现与文艺设计等

附录:相关资源与平台

元知(AI综述)

- 名称: 元知(AI综述),智灵 Deep Research

- 网址: https://yuanzhi.zeelin.cn/#/

生成综述案例:元知(增强版)AI综述工具

人机快生之元境平台

自制数字人,已制作200多个

自研人形机器人

自制AI微短剧,已制作300多段