本篇技术博文摘要 🌟

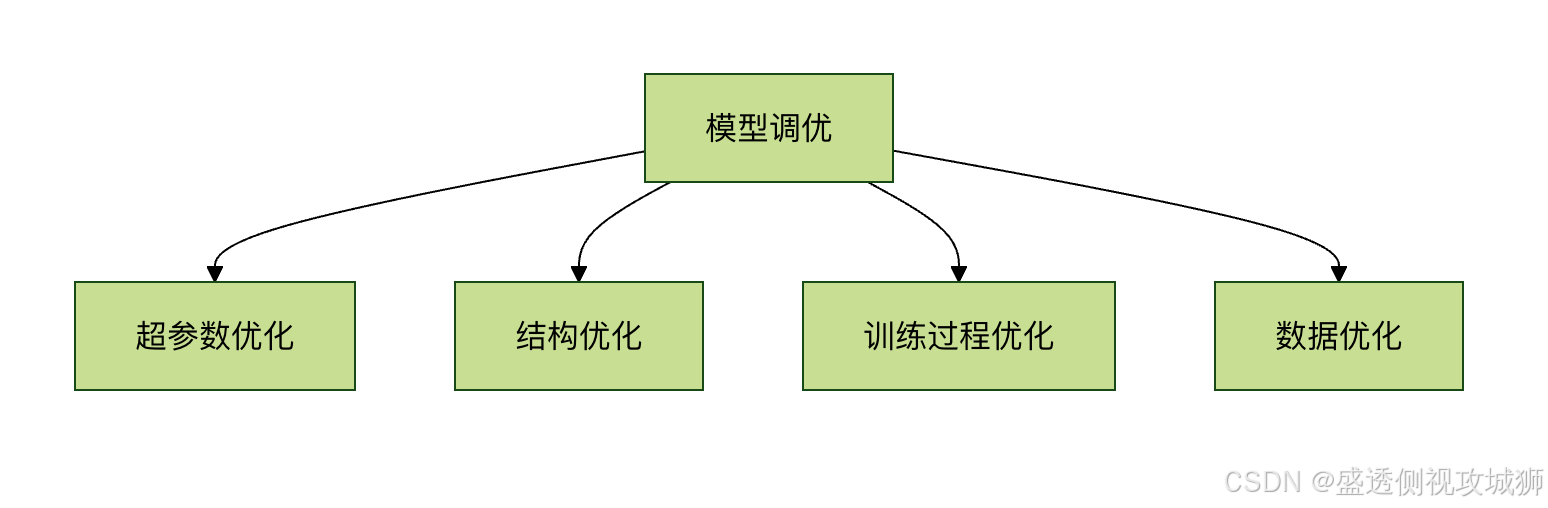

- 文章开篇阐明模型调优对于提升准确率、加速收敛与防止过拟合的核心价值,并梳理了超参数、结构、训练过程三大调优方向。

- 在超参数调优部分,详述了学习率调整的三种策略------静态设置的基线方法、动态调整的衰减与预热策略、以及高效寻找最优区间的学习率查找器,并分析了批量大小对训练稳定性与泛化能力的影响。

- 模型结构优化章节深入探讨了网络宽度与深度的调整原则,以及Dropout、早停法等正则化技术的原理与应用场景。

- 训练过程优化聚焦于数据增强、批归一化、梯度裁剪等提升训练效率与稳定性的实用技巧。

- 最后,文章前瞻性地介绍了自动化超参数调优与模型蒸馏等高级技术,并结合作者实战经验,提供了覆盖调优优先级、迭代策略、评估监控与避坑指南的全流程实践建议,旨在为读者提供一套从理论到实践的完整调优方案。

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.TensorFlow 模型调优技巧](#1.TensorFlow 模型调优技巧)

[3.2.2早停法(Early Stopping)](#3.2.2早停法(Early Stopping))

[4.2批归一化(Batch Normalization)](#4.2批归一化(Batch Normalization))

1.TensorFlow 模型调优技巧

- 模型调优是机器学习工作流程中至关重要的环节,它直接影响模型的最终性能表现。在TensorFlow中,我们可以通过多种技术手段来提升模型的准确率和泛化能力

1.1为什么需要模型调优

- 初始模型通常不够理想:首次训练的模型往往存在欠拟合或过拟合问题

- 资源利用优化:通过调优可以在相同计算资源下获得更好性能

- 业务需求匹配:不同应用场景对模型有不同要求(如精度vs速度)

1.2调优的主要方向

2.超参数调优技巧

2.1学习率调整

- 学习率是最关键的超参数之一,直接影响模型收敛速度和最终性能

2.1.1静态学习率设置

python

# 基本学习率设置示例

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)2.1.2动态学习率策略

python

# 学习率衰减示例

initial_learning_rate = 0.1

lr_schedule = tf.keras.optimizers.schedules.ExponentialDecay(

initial_learning_rate,

decay_steps=10000,

decay_rate=0.96,

staircase=True)

optimizer = tf.keras.optimizers.SGD(learning_rate=lr_schedule)2.1.3学习率查找器

python

# 使用Keras Tuner进行学习率搜索

import keras_tuner as kt

def build_model(hp):

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(10))

# 设置学习率搜索范围

hp_learning_rate = hp.Choice('learning_rate', values=[1e-2, 1e-3, 1e-4])

model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=hp_learning_rate),

loss='mse')

return model

tuner = kt.RandomSearch(build_model, objective='val_loss', max_trials=5)

2.2批量大小选择

- 批量大小影响训练稳定性和内存使用

| 批量大小 | 优点 | 缺点 |

|---|---|---|

| 小批量(16-64) | 收敛快,泛化好 | 训练不稳定 |

| 中批量(64-256) | 平衡选择 | 需要更多内存 |

| 大批量(256+) | 训练稳定 | 可能陷入局部最优 |

3.模型结构优化

3.1层大小与深度调整

3.1.1宽度调整技巧

python

# 使用Keras Tuner自动搜索最佳层大小

def build_model(hp):

model = tf.keras.Sequential()

# 搜索最佳神经元数量

hp_units = hp.Int('units', min_value=32, max_value=512, step=32)

model.add(tf.keras.layers.Dense(units=hp_units, activation='relu'))

model.add(tf.keras.layers.Dense(10))

model.compile(optimizer='adam', loss='mse')

return model3.1.2深度调整策略

从浅层网络开始,逐步增加深度

使用残差连接(ResNet)解决深度网络梯度消失问题

python

# 残差块示例

def residual_block(x, filters):

shortcut = x

x = tf.keras.layers.Conv2D(filters, (3,3), padding='same')(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.Activation('relu')(x)

x = tf.keras.layers.Conv2D(filters, (3,3), padding='same')(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.Add()([shortcut, x])

return tf.keras.layers.Activation('relu')(x)3.2正则化技术

3.2.1Dropout

python

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.5), # 50%的神经元会被随机丢弃

tf.keras.layers.Dense(10)

])3.2.2早停法(Early Stopping)

python

early_stopping = tf.keras.callbacks.EarlyStopping(

monitor='val_loss',

patience=5, # 连续5个epoch验证损失没有改善则停止

restore_best_weights=True) # 恢复最佳权重

model.fit(x_train, y_train,

validation_data=(x_val, y_val),

epochs=100,

callbacks=[early_stopping])

4.训练过程优化

4.1数据增强

python

# 图像数据增强示例

data_augmentation = tf.keras.Sequential([

tf.keras.layers.RandomFlip("horizontal"),

tf.keras.layers.RandomRotation(0.1),

tf.keras.layers.RandomZoom(0.1),

])

# 使用增强数据训练

model.fit(data_augmentation(x_train), y_train, epochs=10)4.2批归一化(Batch Normalization)

python

model = tf.keras.Sequential([

tf.keras.layers.Dense(64),

tf.keras.layers.BatchNormalization(),

tf.keras.layers.Activation('relu'),

tf.keras.layers.Dense(10)

])4.3梯度裁剪

python

# 梯度裁剪防止梯度爆炸

optimizer = tf.keras.optimizers.Adam(clipvalue=1.0)

5.高级调优技术

5.1自动化超参数调优

python

# 使用Keras Tuner进行自动化调优

tuner = kt.Hyperband(

build_model,

objective='val_accuracy',

max_epochs=10,

factor=3,

directory='my_dir',

project_name='intro_to_kt')

tuner.search(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

best_model = tuner.get_best_models(num_models=1)[0]5.2模型蒸馏

python

# 教师模型训练

teacher = tf.keras.models.load_model('teacher_model.h5')

# 学生模型定义

student = tf.keras.Sequential([...])

# 蒸馏损失

def distillation_loss(y_true, y_pred, teacher_pred, temp=5.0):

return tf.keras.losses.kl_divergence(

tf.nn.softmax(teacher_pred/temp),

tf.nn.softmax(y_pred/temp))5.3调优实践过程的建议

- 建立基准:先训练一个简单模型作为基准

- 一次调整一个参数:避免同时改变多个参数

- 记录实验:使用TensorBoard或MLflow跟踪实验

- 验证集使用:确保验证集代表真实数据分布

- 考虑计算成本:平衡调优效果与资源消耗

python

# 使用TensorBoard记录训练过程

tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir="./logs")

model.fit(x_train, y_train, epochs=10, callbacks=[tensorboard_callback])

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********