ELK 是一套开源的日志解决方案,由 Elastic 公司开发和维护,它包括 Elasticsearch、Logstash 和 Kibana 三个组件。其中:

Elasticsearch 是一个基于 Lucene 的搜索引擎,用于存储和搜索日志数据。

Logstash 是一个开源的数据收集引擎,用于将不同来源的数据转换成统一的格式并发送到 Elasticsearch 中。

Kibana 是一个开源的数据可视化工具,用于展示 Elasticsearch 中的数据。

下面是使用 ELK 实现日志解决方案的步骤:

安装和启动 Elasticsearch、Logstash 和 Kibana。可以使用官方提供的 Docker 镜像或者手动安装。启动 Elasticsearch、Logstash 和 Kibana 后,可以通过浏览器访问 Kibana 的 Web 界面,例如:http://localhost:5601。

配置 Logstash 收集日志数据并转换成统一的格式。Logstash 可以从多种数据源中获取数据,并支持多种输入格式和输出格式。例如,可以使用 Filebeat 作为输入源,将指定文件内的日志数据发送给 Logstash,然后使用 Grok 进行日志格式解析和字段提取,最后将处理后的日志数据发送到 Elasticsearch 中。

1先下载镜像

powershell

docker pull logstash:7.17.7

我使用的是7.17.7版本,建议elk的版本一致

注意先安装好Elasticsearch和Kibana方便查看

2接着就可以run容器了

powershell

docker run -it \

--name logstash \

--privileged \

-p 5044:5044 \

-p 9600:9600 \

--network xxx_net \ //这个是自定义的网络

--ip 172.18.12.72 \ //定义的ip地址

-v /etc/localtime:/etc/localtime \

-d logstash:7.17.7成功后是下面那个样子,内存不够不建议跑,这三个太耗费内存了,要不然先把其他的关闭

3自定义一个文件夹,最好叫logstash,方便记忆,然后创建三个文件,这是配置,修改完成以后,cp复制到容器里面,因为前面run的时候是没有挂载的,不能在外面改完同步

logstash.conf

logstash.yml

pipelines.yml

4修改配置文件

logstash.conf

powershell

input {

tcp {

mode => "server"

host => "0.0.0.0"

port => 5044

codec => json_lines

}

}

filter{

}

output {

elasticsearch {

hosts => ["192.168.201.61:9200"] #elasticsearch的ip地址

index => "ssc-logs" #索引名称

}

stdout { codec => rubydebug }

}piplelines.xml

powershell

- pipeline.id: main

path.config: "/usr/share/logstash/pipeline/logstash.conf"

logstash.yml

powershell

path.logs: /usr/share/logstash/logs

config.test_and_exit: false

config.reload.automatic: false

http.host: "0.0.0.0"

xpack.monitoring.elasticsearch.hosts: [ "http://192.168.201.61:9200" ]

5把修改好的文件复制到容器内部

powershell

docker cp logstash.yml logstash:/usr/share/logstash/config

docker cp piplelines.xml logstash:/usr/share/logstash/config

docker cp logstash.conf logstash:/usr/share/logstash/pipeline

可以使用docek exec -it logstash bash命令进入容器查看,其中的前面两个文件都在config下面,最后的在pipeline下面

6重启容器,释放端口

重启容器

powershell

docker restart logstash释放端口

powershell

firewall-cmd --add-port=9600/tcp --permanent

firewall-cmd --add-port=5044/tcp --permanent

firewall-cmd --reloadspringboot中使用logstash

引入框架

java

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>7.3</version>

</dependency>创建logback-spring.xml

xml

<?xml version="1.0" encoding="UTF-8"?>

<!-- 日志级别从低到高分为TRACE < DEBUG < INFO < WARN < ERROR < FATAL,如果设置为WARN,则低于WARN的信息都不会输出 -->

<!-- scan:当此属性设置为true时,配置文档如果发生改变,将会被重新加载,默认值为true -->

<!-- scanPeriod:设置监测配置文档是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒。

当scan为true时,此属性生效。默认的时间间隔为1分钟。 -->

<!-- debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 -->

<configuration scan="true" scanPeriod="10 seconds">

<!--1. 输出到控制台-->

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<!--此日志appender是为开发使用,只配置最低级别,控制台输出的日志级别是大于或等于此级别的日志信息-->

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>DEBUG</level>

</filter>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} -%5level ---[%15.15thread] %-40.40logger{39} : %msg%n</pattern>

<!-- 设置字符集 -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!-- 2. 输出到文件 -->

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<!--日志文档输出格式-->

<append>true</append>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} -%5level ---[%15.15thread] %-40.40logger{39} : %msg%n</pattern>

<charset>UTF-8</charset> <!-- 此处设置字符集 -->

</encoder>

</appender>

<!--3. LOGSTASH config -->

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>192.168.xx.xx:5044</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder">

<!--自定义时间戳格式, 默认是yyyy-MM-dd'T'HH:mm:ss.SSS<-->

<timestampPattern>yyyy-MM-dd HH:mm:ss</timestampPattern>

<customFields>{"appname":"QueryApp"}</customFields>

</encoder>

</appender>

<root level="DEBUG">

<appender-ref ref="CONSOLE"/>

<appender-ref ref="FILE"/>

<appender-ref ref="LOGSTASH"/>

</root>

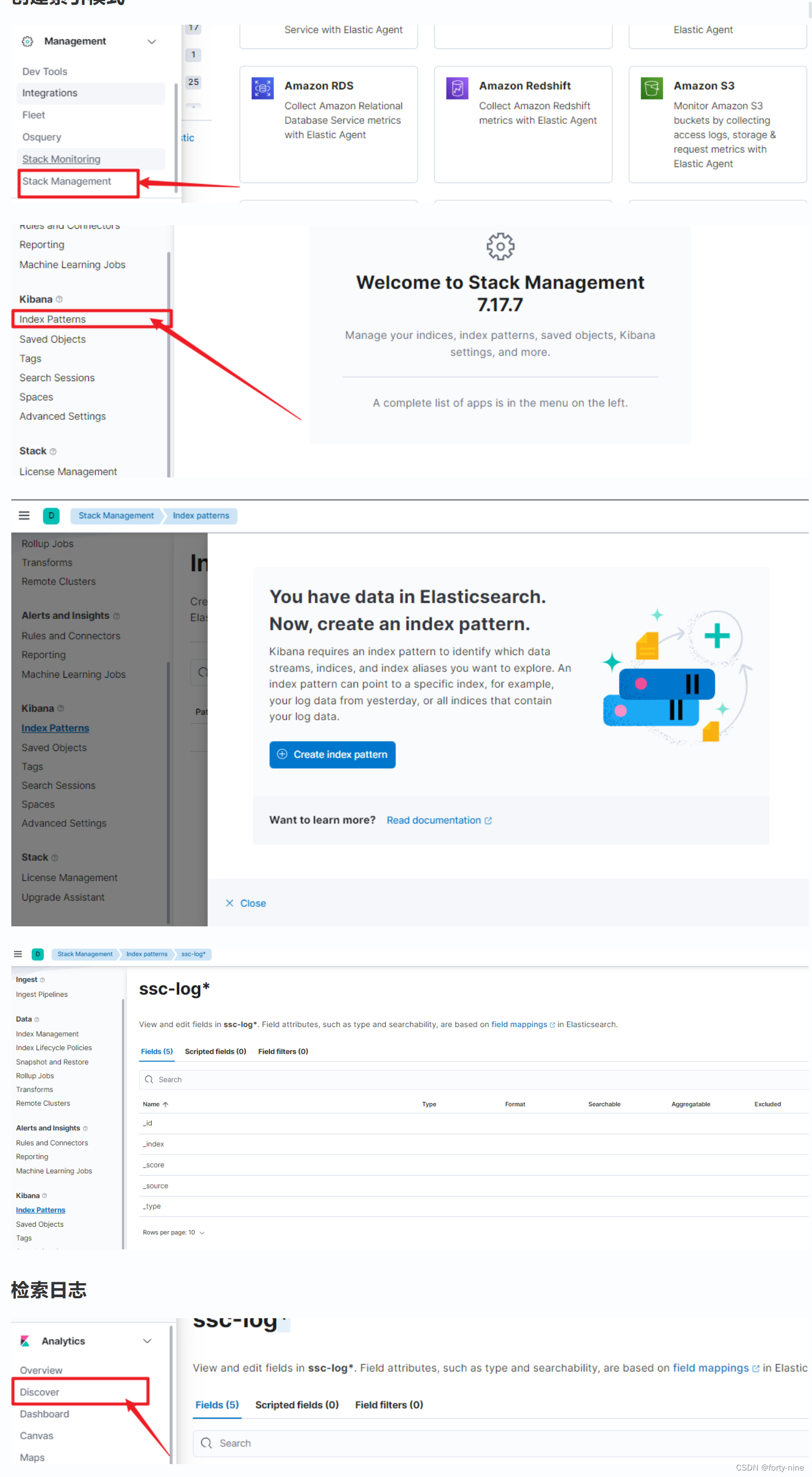

</configuration>配置Kibana

创建一个索引

java

put ssc-logs

创建索引模式