找了一个晚上各种模型,像极了当初找各种操作系统的镜像,雨林木风,深蓝、老毛桃......

主要是官方的默认7B版本回答好多英文,而且回复的很慢,所以我是在ollama上搜索"chinese"找到了这个羊驼版本的,

ollama run lgkt/llama3-chinese-alpaca等大概10分钟左右;

反应的速度还挺快的。

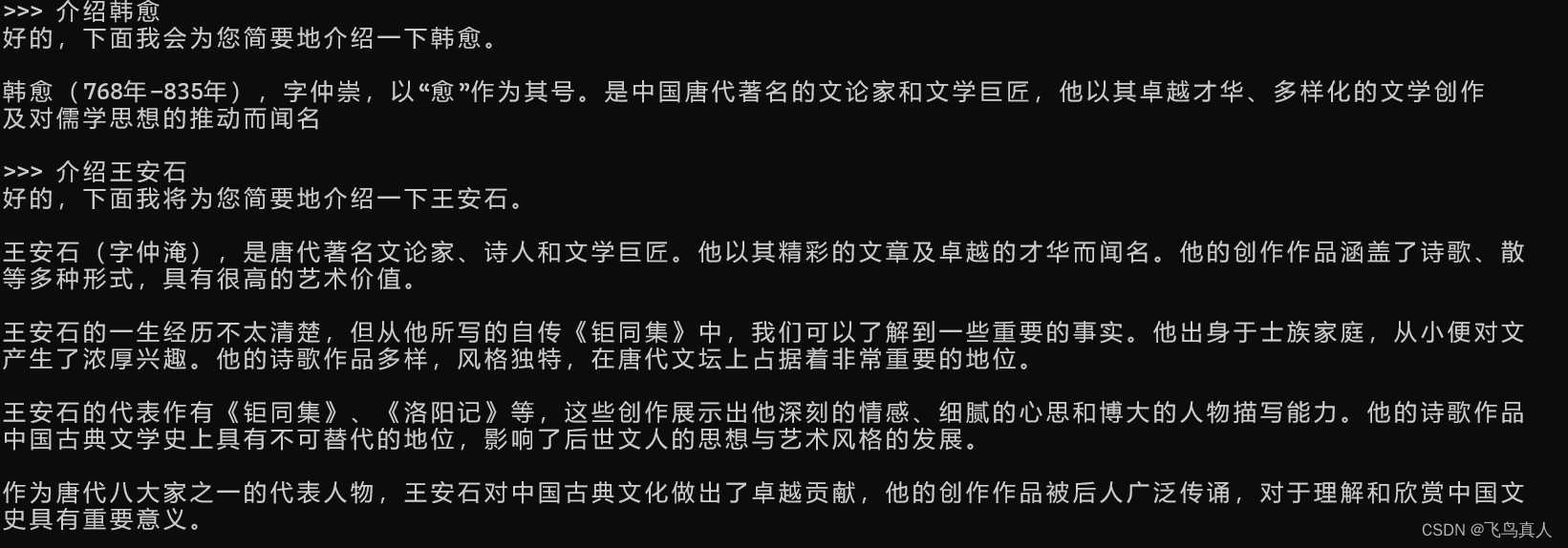

但是测试下来不尽人意啊:

资源地址:

https://ollama.com/lgkt/llama3-chinese-alpacaGet up and running with large language models.![]() https://ollama.com/lgkt/llama3-chinese-alpacaGitHub - ymcui/Chinese-LLaMA-Alpaca-3: 中文羊驼大模型三期项目 (Chinese Llama-3 LLMs) developed from Meta Llama 3中文羊驼大模型三期项目 (Chinese Llama-3 LLMs) developed from Meta Llama 3 - ymcui/Chinese-LLaMA-Alpaca-3

https://ollama.com/lgkt/llama3-chinese-alpacaGitHub - ymcui/Chinese-LLaMA-Alpaca-3: 中文羊驼大模型三期项目 (Chinese Llama-3 LLMs) developed from Meta Llama 3中文羊驼大模型三期项目 (Chinese Llama-3 LLMs) developed from Meta Llama 3 - ymcui/Chinese-LLaMA-Alpaca-3![]() https://github.com/ymcui/Chinese-LLaMA-Alpaca-3/tree/main

https://github.com/ymcui/Chinese-LLaMA-Alpaca-3/tree/main